Opera 공개 오늘은 약 150개의 서로 다른 모델 계열에서 비롯된 50개의 로컬 LLM(대형 언어 모델) 변형에 대한 실험적 지원을 통합하려는 계획입니다. 이 기능은 먼저 개발자 스트림의 Opera One에 도입될 예정입니다. 150개 이상의 제품군에서 나온 50개 모델 사용자가 선택할 수 있는 것입니다.

여기에는 비 쿠나 그리고 야마 각각 Google과 Meta에서 제공됩니다. 이는 이 기능이 Opera의 AI 기능 드롭 프로그램을 통해 소비자에게 제공되고 이러한 AI 기능 몇 가지에 대한 조기 액세스를 제공한다는 것을 의미합니다. 해당 모델은 브라우저를 통해 컴퓨터에서 실행되며 Ollama 오픈 소스 프레임워크로 실행됩니다. 현재 제공되는 모든 모델은 Ollama 라이브러리에서 선택되었지만 회사는 장래에 다른 소스의 일부 모델도 포함할 수 있기를 바라고 있습니다.

이들 각각은 로컬 PC에 2GB 이상의 공간이 필요합니다., 회사에 따르면. 따라서 공간이 부족하지 않도록 여유 공간을 현명하게 사용하십시오. 흥미롭게도 Opera는 모델 형식으로 다운로드되는 경우 데이터를 저장하려고 시도하지 않습니다.

Quora의 HuggingFace 및 PoE와 같은 웹사이트에서 온라인으로 다른 모델을 확인할 수도 있으므로 실제로 로컬 모델 테스트 요구 사항에 적합합니다.

이제 대규모 언어 모델은 사용자 장치에서 직접 데이터 처리를 지원하므로 정보를 외부 서버로부터 비공개로 유지하면서 생성적 AI를 사용할 수 있습니다. Opera는 새로운 AI 기능 드롭 프로그램의 일환으로 Opera One 개발자 채널을 통해 현지 LLM에 대한 이 혁신적인 접근 방식을 도입할 계획을 발표했습니다. 이 이니셔티브는 초기 사용자에게 브라우저 AI 기능의 최신 버전을 즉각적이고 정기적으로 사용해 볼 수 있는 기회를 제공합니다. 오늘부터 Opera One Developer 사용자는 데이터 처리를 위해 선호하는 모델을 자유롭게 선택할 수 있습니다.

Opera에 내장된 LLM을 어떻게 시험해 볼 수 있나요?

이러한 모델에 참여하려면 사용자는 다음을 수행해야 합니다. 최신 Opera Developer 버전으로 업그레이드 과 일련의 단계를 실행 이 흥미로운 기능을 활성화하려면:

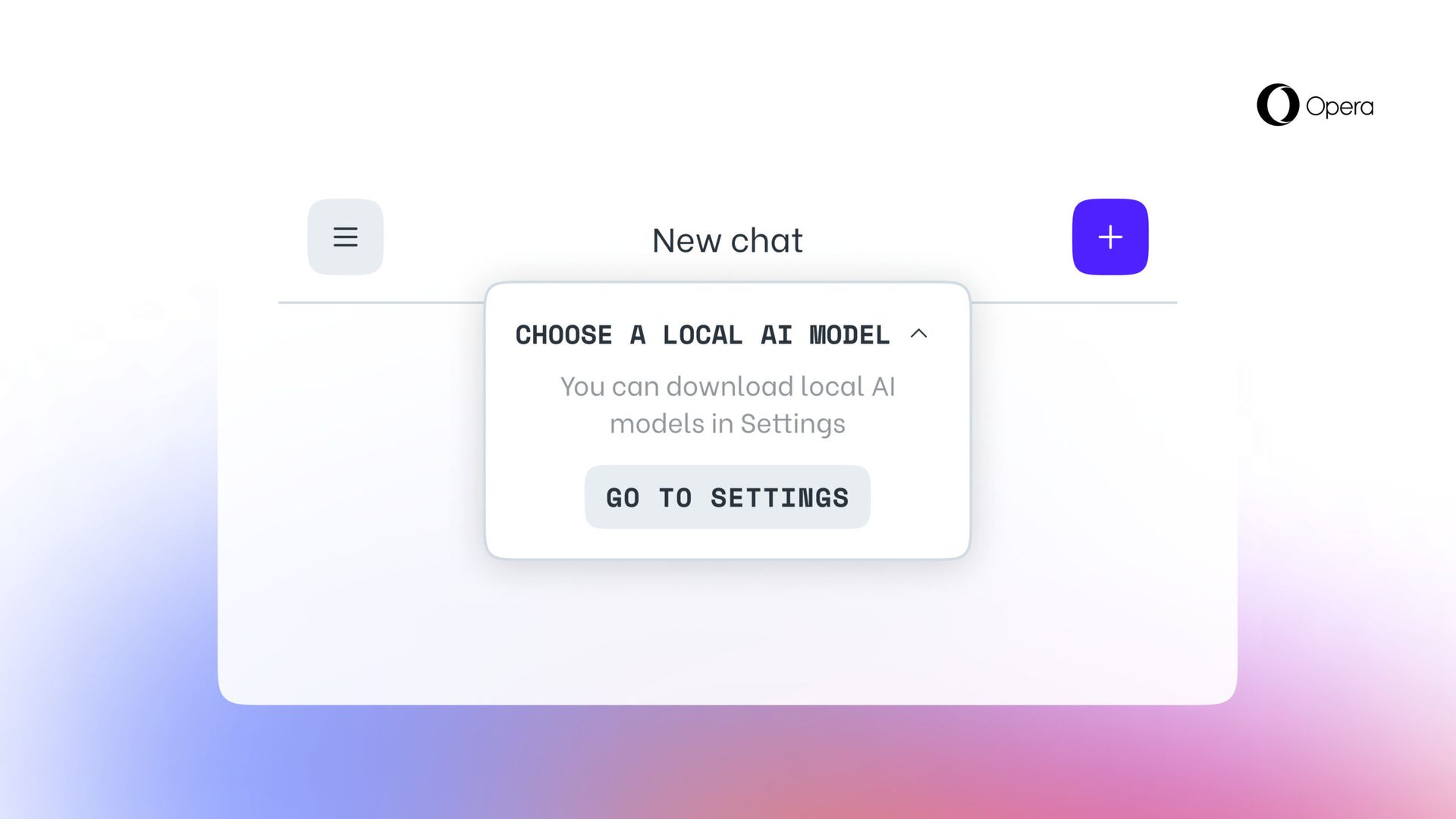

- 이전에 했던 것처럼 Aria Chat 사이드바에 액세스하세요. 채팅 상단에는 '라는 라벨이 붙은 드롭다운 메뉴가 있습니다.로컬 모드를 선택하세요."

- "선택설정으로 바로 가기” 이 메뉴에서.

- 이 영역에서는 다음을 수행할 수 있습니다. 다운로드할 모델을 탐색하고 결정하세요.

- 더 작고 빠른 옵션을 원하면 다음과 같은 모델을 다운로드하는 것이 좋습니다. GEMMA:2B-INSTRUCT-Q4_K_M 오른쪽에 있는 다운로드 아이콘을 클릭하면 됩니다.

- 다운로드가 완료되면, 새 채팅 세션을 시작하려면 왼쪽 상단에 있는 메뉴 버튼을 클릭하세요.

- 다시 한 번 채팅 상단에 '라는 문구가 표시된 드롭다운 메뉴가 표시됩니다.로컬 모드 선택” 방금 설치한 모델을 선택할 수 있습니다.

- 채팅에 프롬프트를 입력하세요, 로컬에서 호스팅되는 모델이 응답합니다.

참가자는 자신의 장치에 다운로드할 로컬 LLM을 선택합니다. 이 접근 방식에는 다음이 필요합니다. 2~10GB의 저장 공간 각 버전마다 Opera에 내장된 브라우저 AI인 Aria를 사용하는 것에 대한 대안을 제공합니다. 이 설정은 사용자가 AI와 새로운 상호 작용을 시작하거나 Aria를 다시 활성화하기로 선택할 때까지 그대로 유지됩니다.

주요 이미지 크레딧 : Opera

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://dataconomy.com/2024/04/03/opera-unveils-built-in-llms-that-run-locally/