LLM(대형 언어 모델)은 AI 혁명의 원동력이지만 게임의 줄거리가 크게 바뀌었습니다. 획기적인 오픈 소스인 Databricks DBRX LLM, 현상 유지에 도전하기 위해 왔습니다. 기존 모델을 능가하고 업계 선두업체와 경쟁하는 DBRX는 뛰어난 성능과 효율성을 자랑합니다. LLM의 세계에 대해 자세히 알아보고 DBRX가 규칙서를 어떻게 다시 작성하는지 살펴보고 LLM의 흥미진진한 미래를 엿볼 수 있습니다. 자연어 처리.

차례

LLM 및 오픈 소스 LLM 이해

LLM(대형 언어 모델)은 인간과 유사한 텍스트를 이해하고 생성할 수 있는 고급 자연어 처리 모델입니다. 이러한 모델은 언어 이해, 프로그래밍, 수학 등 다양한 응용 분야에서 점점 더 중요해지고 있습니다.

오픈 소스 LLM은 자연어 처리 기술의 개발 및 발전에 중요한 역할을 합니다. 이는 개방형 커뮤니티와 기업에 최첨단 언어 모델에 대한 액세스를 제공하여 특정 애플리케이션 및 사용 사례에 맞게 모델을 구축하고 사용자 정의할 수 있도록 합니다.

데이터브릭스 DBRX란 무엇인가요?

Databricks DBRX는 Databricks에서 개발한 개방형 범용 LLM(대형 언어 모델)입니다. GPT-3.5를 능가하고 Gemini 1.0 Pro에 필적하는 기존 개방형 LLM에 대한 새로운 최첨단 기술을 설정했습니다. DBRX는 언어 이해, 프로그래밍, 수학 등 다양한 벤치마크에서 탁월한 성능을 발휘합니다. 세분화된 전문가 혼합(MoE) 아키텍처를 갖춘 다음 토큰 예측을 사용하여 훈련되어 훈련 및 추론 성능이 크게 향상됩니다.

이 모델은 API를 통해 Databricks 고객에게 제공되며 사전 학습되거나 미세 조정될 수 있습니다. 그 효율성은 훈련 및 추론 성능으로 강조되며, 유사한 모델의 크기는 약 40%이면서 기존의 다른 모델을 능가합니다. DBRX는 기업과 개방형 커뮤니티에 힘을 실어주기 위해 설계된 Databricks의 차세대 GenAI 제품의 핵심 구성 요소입니다.

Databricks DBRX의 MoE 아키텍처

Databricks의 DBRX는 효율성을 위한 고유한 아키텍처를 갖춘 오픈 소스 범용 LLM(대형 언어 모델)으로 돋보입니다. 주요 기능은 다음과 같습니다.

- 세분화된 전문가 조합(MoE): 이 혁신적인 아키텍처는 총 132억 개의 매개변수를 활용하며 입력당 활성 매개변수는 36억 개에 불과합니다. 활성 매개변수에 중점을 두어 다른 모델에 비해 효율성이 크게 향상되었습니다.

- 전문가의 힘: DBRX는 16명의 전문가를 고용하고 각 작업에 4명을 선택하여 가능한 65배 더 많은 전문가 조합을 제공하여 우수한 모델 품질을 제공합니다.

- 고급 기술: 이 모델은 RoPE(회전 위치 인코딩), GLU(게이트 선형 장치), GQA(그룹 쿼리 주의)와 같은 최첨단 기술을 활용하여 성능을 더욱 향상시킵니다.

- 효율성 챔피언: DBRX는 LLaMA2-70B보다 최대 40배 빠른 추론 속도를 자랑합니다. 또한 총 매개변수 수와 활성 매개변수 수 모두 Grok-1보다 약 XNUMX% 더 작은 컴팩트한 크기를 자랑합니다.

- 실제 성능: mosaic AI Model Serving에서 호스팅되는 경우 DBRX는 사용자당 초당 최대 150개 토큰의 텍스트 생성 속도를 제공합니다.

- 교육 효율성 리더: DBRX의 교육 프로세스는 컴퓨팅 효율성이 크게 향상되었음을 보여줍니다. 동일한 수준의 최종 품질을 위해 밀도가 높은 모델을 훈련하는 것과 비교하여 대략 절반의 FLOP(부동 소수점 연산)가 필요합니다.

DBRX 훈련

DBRX와 같은 강력한 LLM을 교육하는 데 장애물이 없는 것은 아닙니다. 훈련 과정을 자세히 살펴보면 다음과 같습니다.

- 도전 과제 : DBRX와 같은 전문가 혼합 모델을 개발하는 것은 상당한 과학적, 성능적 장애물을 제시했습니다. Databricks는 DBRX급 모델을 효율적으로 훈련할 수 있는 강력한 파이프라인을 만들기 위해 이러한 과제를 극복해야 했습니다.

- 효율성 혁신: DBRX의 교육 프로세스는 컴퓨팅 효율성이 크게 향상되었습니다. 다른 모델에 비해 Databricks LLM Gauntlet에서 1.7%의 점수에 도달하는 데 45.5배 더 적은 FLOP(부동 소수점 연산)가 필요한 DBRX 제품군의 소형 모델인 DBRX MoE-B를 예로 들어 보겠습니다.

- 효율성 리더: 이 성과는 DBRX 교육 프로세스의 효율성을 강조합니다. 이는 DBRX를 오픈 소스 모델 중 리더로 자리매김하고 심지어 RAG 작업에서는 GPT-3.5 Turbo와 경쟁하는 동시에 뛰어난 효율성을 자랑합니다.

DBRX 대 기타 LLM

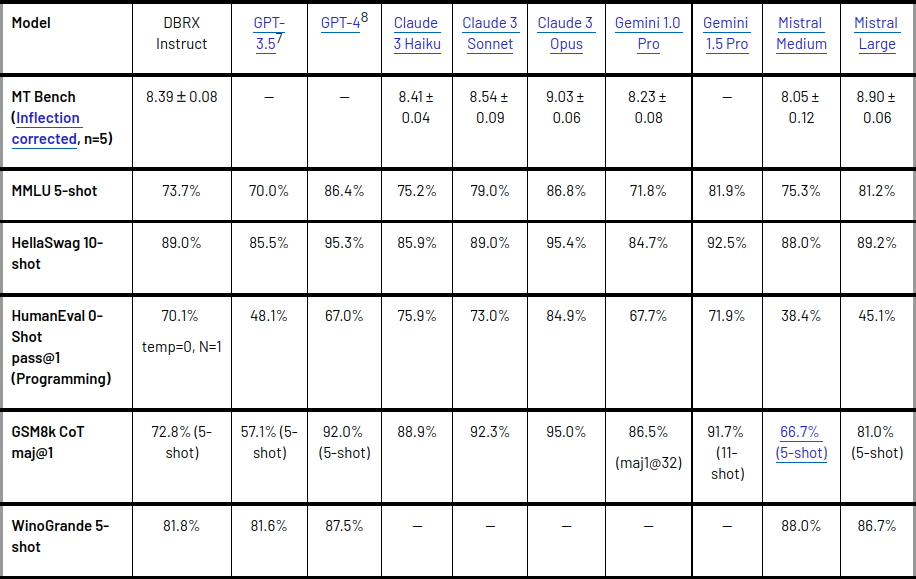

측정항목 및 결과

- DBRX는 언어 이해 작업에 대해 확립된 오픈 소스 모델을 기준으로 측정되었습니다.

- GPT-3.5를 능가했으며 Gemini 1.0 Pro와 경쟁이 가능합니다.

- 이 모델은 복합 벤치마크, 프로그래밍, 수학, MMLU를 포함한 다양한 벤치마크에서 그 기능을 입증했습니다.

- Hugging Face Open LLM Leaderboard 및 Databricks Model Gauntlet과 같은 복합 벤치마크에서 가장 높은 점수를 획득하여 표준 벤치마크에서 모든 채팅 또는 지침 미세 조정 모델보다 성능이 뛰어났습니다.

- 또한 DBRX Instruct는 긴 컨텍스트 작업 및 RAG에서 탁월한 성능을 보여 모든 컨텍스트 길이와 시퀀스의 모든 부분에서 GPT-3.5 Turbo보다 뛰어난 성능을 보였습니다.

다른 모델과 비교한 강점과 약점

DBRX Instruct는 HumanEval 및 GSM8k와 같은 벤치마크에서 다른 개방형 모델보다 높은 점수를 획득하여 프로그래밍 및 수학 분야에서 강점을 입증했습니다. 또한 Gemini 1.0 Pro 및 Mistral Medium에서 여러 벤치마크에서 Gemini 1.0 Pro를 능가하는 경쟁력 있는 성능을 보여주었습니다. 그러나 모델 품질과 추론 효율성은 일반적으로 긴장 관계에 있으며 DBRX는 품질이 우수하지만 작은 모델이 추론에 더 효율적이라는 점에 유의하는 것이 중요합니다. 그럼에도 불구하고 DBRX는 일반적으로 밀집 모델이 달성하는 것보다 모델 품질과 추론 효율성 간의 더 나은 균형을 달성하는 것으로 나타났습니다.

DBRX의 주요 혁신

Databricks가 개발한 DBRX는 기존 오픈 소스 및 독점 모델과 차별화되는 몇 가지 주요 혁신을 도입합니다. 이 모델은 총 132B개의 매개변수를 갖춘 세분화된 전문가 혼합(MoE) 아키텍처를 활용하며, 이 중 36B는 모든 입력에서 활성화됩니다.

이 아키텍처를 통해 DBRX는 강력하고 효율적인 교육 프로세스를 제공하여 GPT-3.5 Turbo를 능가하고 SQL과 같은 애플리케이션에서 GPT-4 Turbo에 도전합니다. 또한 DBRX는 16명의 전문가를 고용하고 4명을 선택하여 65배 더 많은 전문가 조합을 제공하여 모델 품질을 향상시킵니다.

또한 이 모델은 RoPE(회전 위치 인코딩), GLU(게이트 선형 장치) 및 GQA(그룹화 쿼리 주의)를 통합하여 탁월한 성능을 제공합니다.

기존 오픈 소스 및 독점 모델에 비해 DBRX의 장점

DBRX는 기존 오픈 소스 및 독점 모델에 비해 몇 가지 장점을 제공합니다. GPT-3.5를 능가하며 Gemini 1.0 Pro와도 경쟁하며 복합 벤치마크, 프로그래밍, 수학, MMLU 등 다양한 벤치마크에서 그 역량을 입증하고 있습니다.

- 또한 DBRX의 변형인 DBRX Instruct는 일반 지식, 상식 추론, 프로그래밍 및 수학적 추론에서 GPT-3.5보다 성능이 뛰어납니다.

- 또한 긴 컨텍스트 작업에 탁월하여 모든 컨텍스트 길이와 시퀀스의 모든 부분에서 GPT-3.5 Turbo보다 성능이 뛰어납니다.

- 또한 DBRX Instruct는 Gemini 1.0 Pro 및 Mistral Medium과 경쟁하여 여러 벤치마크에서 Gemini 1.0 Pro를 능가합니다.

모델의 효율성은 훈련 및 추론 성능으로 강조되며, 유사한 모델 크기의 약 40%에 달하는 기존 모델을 능가합니다. DBRX의 세분화된 MoE 아키텍처 및 교육 프로세스는 컴퓨팅 효율성이 크게 향상되어 동일한 최종 모델 품질에 대해 밀도가 높은 모델을 교육하는 것보다 FLOP 효율성이 약 2배 더 높은 것으로 나타났습니다.

또한 읽기 : Claude 대 GPT: 어느 것이 더 나은 LLM인가요?

결론

혁신적인 전문가 혼합 아키텍처를 갖춘 Databricks DBRX는 GPT-3.5를 능가하며 언어 이해 측면에서 Gemini 1.0 Pro와 경쟁합니다. 세분화된 MoE, 고급 기술 및 우수한 컴퓨팅 효율성을 통해 기업과 개방형 커뮤니티를 위한 강력한 솔루션으로 자연어 처리 분야의 획기적인 발전을 약속합니다. LLM의 미래는 DBRX가 앞장서면서 더욱 밝아졌습니다.

우리를 따라 오세요 구글 뉴스 AI, 데이터 과학 및 세계의 최신 혁신에 대한 최신 소식을 받아보세요. GenAI.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://www.analyticsvidhya.com/blog/2024/03/databricks-dbrx/