강화 학습은 에이전트가 경험을 통해 복잡한 환경과 상호 작용하는 방법을 학습하는 기계 학습의 한 분야입니다.

체스나 바둑과 같은 복잡한 보드 게임에서 인간의 능력을 능가하는 AI 에이전트에서 자율 탐색에 이르기까지 강화 학습에는 흥미롭고 다양한 응용 프로그램이 있습니다.

강화 학습 분야의 놀라운 혁신에는 DeepMind의 에이전트가 포함됩니다. 알파 고 제로 바둑에서 인간 챔피언도 이길 수 있고 알파 폴드 복잡한 3차원 단백질 구조를 예측할 수 있습니다.

이 가이드는 강화 학습 패러다임을 소개합니다. 강화 학습 프레임워크를 이해하기 위해 간단하지만 동기를 부여하는 실제 사례를 살펴보겠습니다.

강화 학습 프레임워크의 구성 요소를 정의하는 것으로 시작하겠습니다.

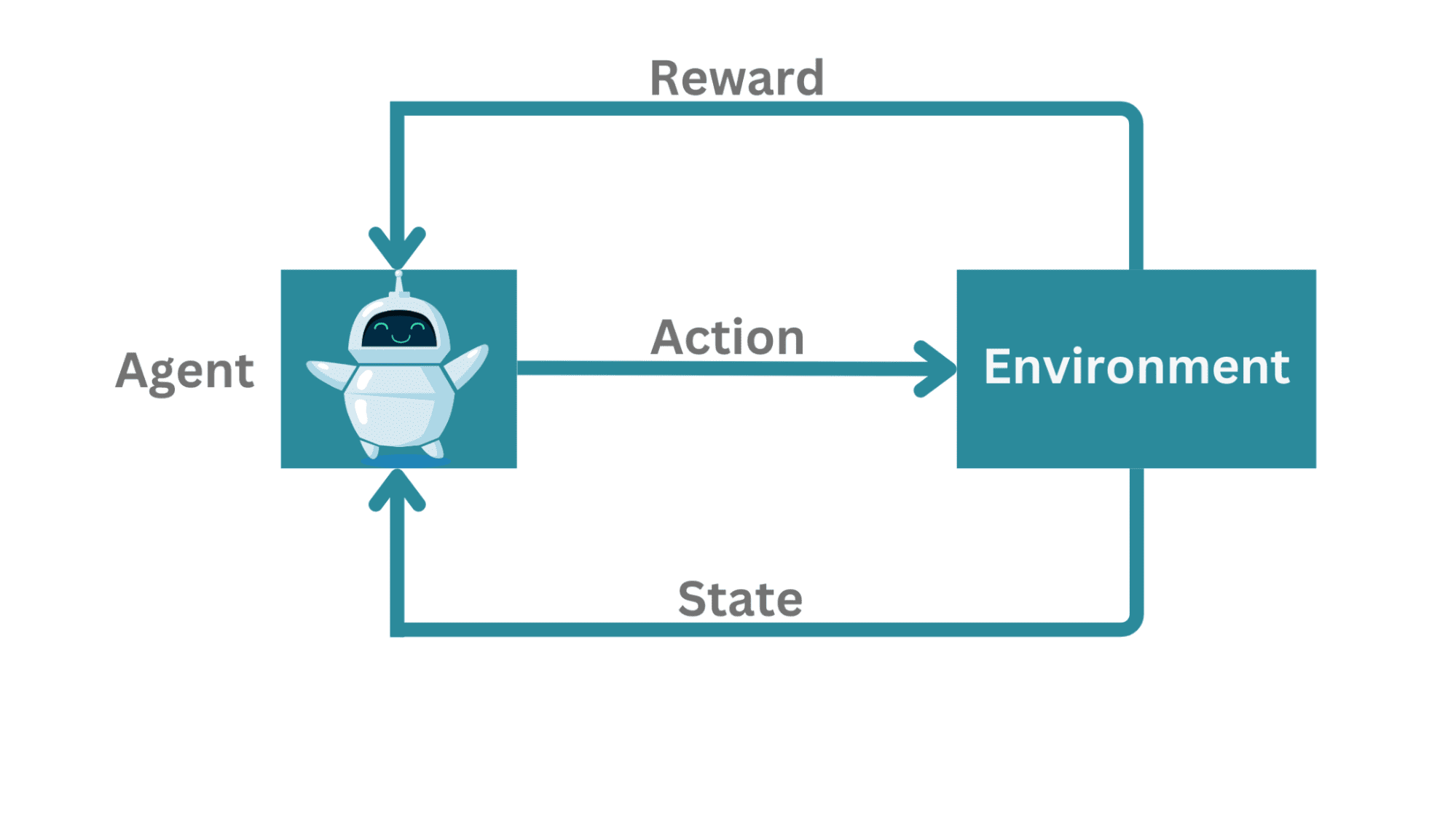

강화 학습 프레임워크 | 작성자 이미지

일반적인 강화 학습 프레임워크에서:

- 거기에 대리인 와 상호 작용하는 법 배우기 환경.

- 대리인은 그것을 측정할 수 있습니다 상태, 가져 가라. 행위, 때때로 보상.

이 설정의 실제 예: 에이전트는 상대와 대결하거나(예: 체스 게임) 복잡한 환경을 탐색하려고 시도할 수 있습니다.

매우 단순화된 예로서 미로에 있는 쥐를 생각해 보십시오. 여기서 대리인은 지원 상대와 대결하는 것이 아니라 오히려 출구로 가는 길을 알아내려고 합니다. 출구로 이어지는 경로가 둘 이상인 경우 미로에서 나가는 최단 경로를 선호할 수 있습니다.

미로의 마우스 | 작성자 이미지

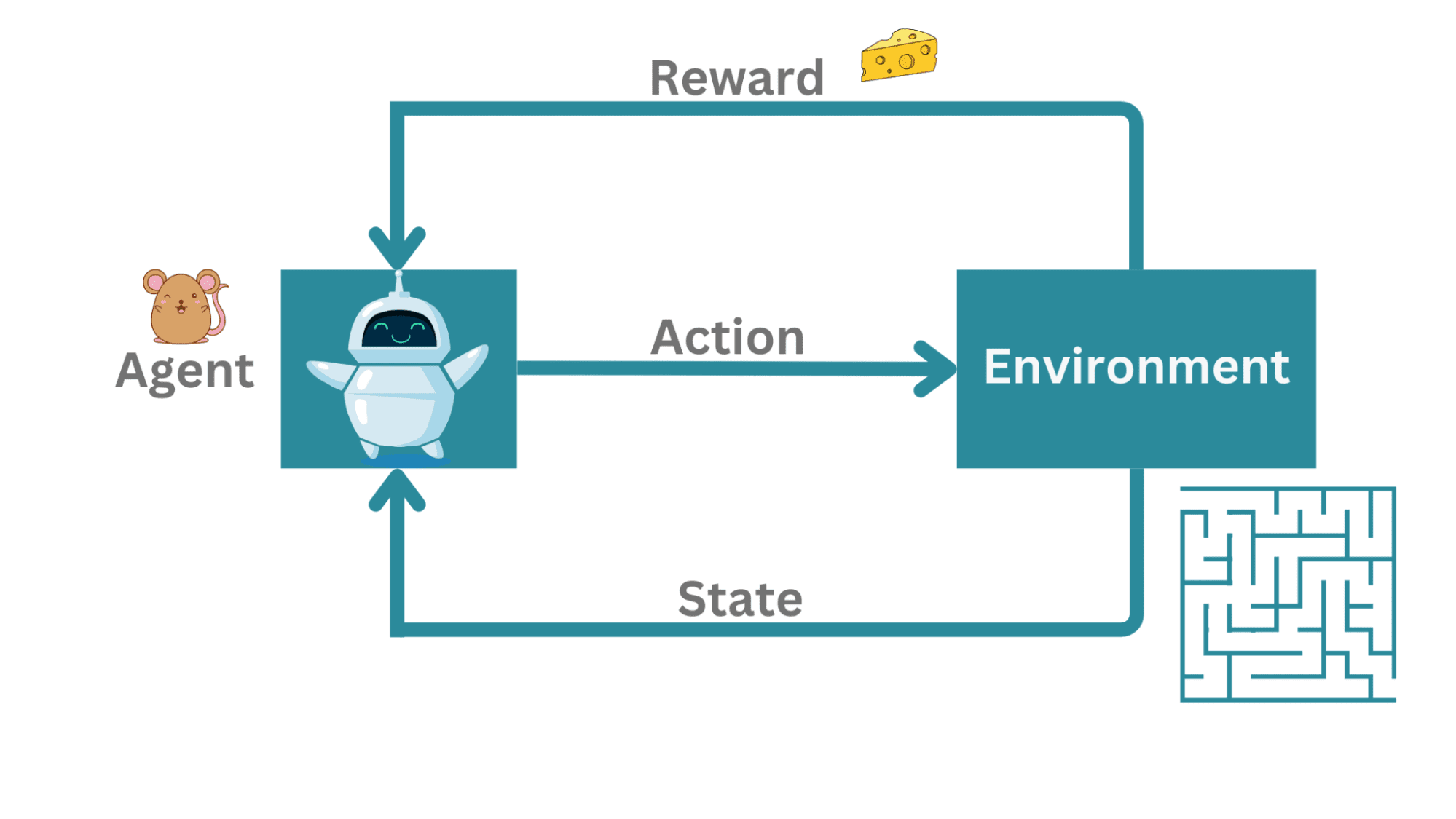

이 예에서 마우스 이다 대리인 를 탐색하려고 환경 어느 것이 미로. 그만큼 동작 다음은 미로 내에서 마우스의 움직임입니다. 미로에서 출구까지 성공적으로 이동하면 치즈 조각 등 보상.

예 | 작성자 이미지

작업 시퀀스는 이산 시간 단계(예: t = 1, 2, 3,…)로 발생합니다. 언제든지 단계 t, 마우스는 미로에서 현재 상태만 측정할 수 있습니다. 아직 전체 미로를 알지 못합니다.

따라서 에이전트(마우스)는 자신의 상태를 측정합니다. 성 시간 단계에서 환경에서 t, 유효한 조치를 취함 에 그리고 상태로 이동 s_(t + 1).

상태 | 작성자 이미지

강화 학습은 어떻게 다른가요?

마우스(에이전트)가 어떻게 미로를 빠져나오는지 알아내야 합니다. 시행 착오. 이제 마우스가 미로의 벽 중 하나에 부딪히면 돌아가는 길을 찾고 출구로 가는 다른 경로를 새겨야 합니다.

이것이 지도 학습 환경이라면 모든 이동 후 에이전트는 해당 작업이 올바른지 여부를 알게 되고 보상으로 이어질 것입니다. 감독 학습은 교사로부터 배우는 것과 같습니다.

선생님은 미리 말해주지만 평론가는 공연이 끝난 후에 항상 당신의 공연이 얼마나 좋았는지 또는 나빴는지 알려줍니다. 이러한 이유로 강화 학습은 영어로 학습이라고도 합니다. 비평가의 존재.

터미널 상태 및 에피소드

마우스가 출구에 도달하면 터미널 상태. 더 이상 탐색할 수 없음을 의미합니다.

그리고 초기 상태에서 종료 상태까지 일련의 동작을 에피소드라고 합니다. 모든 학습 문제의 경우 에이전트가 탐색하는 방법을 배우려면 여러 에피소드가 필요합니다. 여기에서 에이전트(마우스)가 출구로 이어지는 일련의 동작을 학습하고 이어서 치즈 조각을 받으려면 많은 에피소드가 필요합니다.

조밀하고 희박한 보상

에이전트가 올바른 조치를 취하거나 올바른 일련의 조치를 취할 때마다 보상. 이 경우 마우스는 미로(환경)를 통해 출구로 가는 유효한 경로를 에칭한 것에 대한 보상으로 치즈 한 조각을 받습니다.

이 예에서 마우스는 마지막에, 즉 출구에 도달했을 때에만 치즈 한 조각을 받습니다. 부족한 그리고 지연된 보상.

보상이 더 자주 발생하면 밀집한 보상 시스템.

돌이켜보면 에이전트가 보상을 받게 된 행동이나 일련의 행동을 파악해야 합니다(사소한 일이 아닙니다). 이것은 일반적으로 학점 할당 문제.

환경은 종종 결정론적이지 않고 확률론적이며 정책도 마찬가지입니다. 주어진 상태 성, 에이전트는 조치를 취하고 다른 상태로 이동합니다. s_(t+1) 특정 확률로.

정책은 가능한 상태 집합에서 작업으로의 매핑을 정의하는 데 도움이 됩니다. 다음과 같은 질문에 답하는 데 도움이 됩니다.

- 예상 보상을 극대화하기 위해 취해야 할 조치는 무엇입니까?

- 또는 더 좋은 방법은 다음과 같습니다. 상태가 주어졌을 때 예상 보상을 최대화하기 위해 에이전트가 취할 수 있는 최선의 조치는 무엇입니까?

에이전트를 다음과 같이 생각할 수 있습니다. 정책 제정 파이:

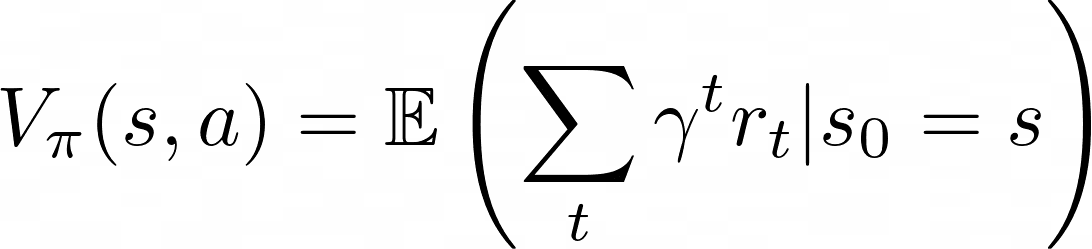

또 다른 관련되고 유용한 개념은 가치 함수입니다. 그만큼 가치 함수 다음과 같이 지정됩니다.

이것은 정책 π가 주어진 상태에 있는 것의 가치를 의미합니다. 수량은 에이전트가 상태에서 시작하고 이후에 정책 π를 제정하는 경우 미래에 예상되는 보상을 나타냅니다.

요약하자면, 강화 학습의 목표는 예상되는 미래 보상을 최대화하기 위해 정책을 최적화하는 것입니다. 따라서 π를 풀기 위한 최적화 문제로 생각할 수 있습니다.

할인 요인

새로운 수량 ɣ가 있음을 주목하십시오. 그것은 무엇을 의미합니까? ɣ는 할인 요인, 0과 1 사이의 수량. 향후 보상이 할인됨을 의미합니다(읽기: 지금이 훨씬 나중보다 크기 때문).

미로에 있는 쥐의 음식 루프 예제로 돌아가서: 쥐가 작은 치즈 조각으로 A 출구로 가는 경로를 알아낼 수 있다면 계속 반복하면서 치즈 조각을 모을 수 있습니다. 하지만 미로에 더 큰 치즈 조각(더 큰 보상)이 있는 또 다른 출구 B가 있다면 어떨까요?

마우스가 유지되는 한 착취 이 현재 전략 없이 탐험 새로운 전략을 사용하면 출구 B에서 더 큰 치즈 조각으로 얻는 훨씬 더 큰 보상을 얻지 못할 것입니다.

탐사 대 착취 | 작성자 이미지

그러나 불확실성 새로운 전략과 미래 보상을 탐색하는 것과 관련된 것이 더 큽니다. 그렇다면 우리는 어떻게 착취하고 탐색합니까? 현재 전략을 활용하는 것과 잠재적으로 더 나은 보상이 있는 새로운 전략을 탐색하는 것 사이의 이러한 절충을 탐색 대 착취 절충.

한 가지 가능한 접근 방식은 ε-탐욕스러운 검색. 가능한 모든 조치 세트가 주어지면 ε-탐욕스러운 검색 확률로 가능한 작업 중 하나를 탐색합니다. ε 현재 전략을 확률 1로 활용하면서 – ε.

지금까지 살펴본 내용을 요약해 보겠습니다. 강화 학습 프레임워크의 구성 요소에 대해 배웠습니다.

- 에이전트는 환경과 상호 작용하고, 현재 상태를 측정하고, 조치를 취하고, 긍정적 강화로 보상을 받습니다. 프레임워크는 확률적입니다.

- 그런 다음 가치 함수와 정책을 살펴보고 최적화 문제가 예상되는 미래 보상을 최대화하는 최적의 정책을 찾는 것으로 귀결되는 경우가 종종 있습니다.

이제 강화 학습 환경을 탐색하기에 충분할 만큼 배웠습니다. 여기서 어디로 가야합니까? 이 가이드에서는 강화 학습 알고리즘에 대해 다루지 않았으므로 몇 가지 기본 알고리즘을 탐색할 수 있습니다.

- 그러나 대부분의 경우 환경을 완벽하게 모델링할 수 없습니다. 이 경우 다음과 같은 모델 없는 알고리즘을 살펴볼 수 있습니다. Q- 학습 상태-행동 쌍을 최적화합니다.

강화 학습에 대한 이해를 높이고 싶다면, David Silver의 강화 학습 강의 YouTube 및 Hugging Face의 심층 강화 학습 과정 볼 수있는 좋은 자료입니다.

발라 프리야 C 인도 출신의 개발자이자 테크니컬 라이터입니다. 그녀는 수학, 프로그래밍, 데이터 과학 및 콘텐츠 제작의 교차점에서 일하는 것을 좋아합니다. 그녀의 관심 분야와 전문 분야는 DevOps, 데이터 과학 및 자연어 처리입니다. 그녀는 읽기, 쓰기, 코딩, 커피를 즐깁니다! 현재 그녀는 자습서, 사용 방법 가이드, 의견 등을 작성하여 개발자 커뮤니티와 지식을 배우고 공유하는 작업을 하고 있습니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 자동차 / EV, 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- BlockOffsets. 환경 오프셋 소유권 현대화. 여기에서 액세스하십시오.

- 출처: https://www.kdnuggets.com/2023/07/reinforcement-learning-teaching-computers-make-optimal-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=reinforcement-learning-teaching-computers-to-make-optimal-decisions