개요

실시간 AI 시스템은 빠른 추론에 크게 의존합니다. OpenAI, Google, Azure와 같은 업계 리더의 추론 API를 사용하면 신속한 의사 결정이 가능합니다. Groq의 언어 처리 장치(LPU) 기술은 AI 처리 효율성을 향상시키는 뛰어난 솔루션입니다. 이 기사에서는 Groq의 혁신적인 기술, AI 추론 속도에 미치는 영향, Groq API를 사용하여 이를 활용하는 방법을 자세히 살펴봅니다.

학습 목표

- Groq의 LPU(언어 처리 장치) 기술과 이것이 AI 추론 속도에 미치는 영향을 이해합니다.

- 실시간, 지연 시간이 짧은 AI 처리 작업을 위해 Groq의 API 엔드포인트를 활용하는 방법을 알아보세요.

- 자연어 이해 및 생성을 위해 Mixtral-8x7b-Instruct-v0.1 및 Llama-70b와 같은 Groq 지원 모델의 기능을 살펴보세요.

- Groq의 LPU 시스템을 다른 추론 API와 비교 및 대조하여 속도, 효율성, 확장성과 같은 요소를 검토합니다.

이 기사는 데이터 과학 블로그.

차례

그로크(Groq)란 무엇인가?

2016 년에 설립 된, 그로크 캘리포니아에 본사를 둔 AI 솔루션 스타트업으로 Mountain View에 본사를 두고 있습니다. 초저지연 AI 추론 전문 기업 그로크(Groq)는 AI 컴퓨팅 성능을 대폭 향상시켰다. Groq는 AI 기술 분야의 저명한 참가자로서 자사의 이름을 상표로 등록하고 AI에 대한 접근을 민주화하기 위해 노력하는 글로벌 팀을 구성했습니다.

언어 처리 장치

혁신적인 기술인 Groq의 언어 처리 장치(LPU)는 특히 LLM(대형 언어 모델)의 AI 컴퓨팅 성능을 향상시키는 것을 목표로 합니다. Groq LPU 시스템은 탁월한 추론 성능으로 지연 시간이 짧은 실시간 경험을 제공하기 위해 노력합니다. Groq는 Meta AI의 Llama-300 2B 모델에서 사용자당 초당 70개 이상의 토큰을 달성하여 새로운 업계 벤치마크를 설정했습니다.

Groq LPU 시스템은 AI 지원 기술에 필수적인 초저지연 기능을 자랑합니다. 순차 및 컴퓨팅 집약적인 GenAI 언어 처리를 위해 특별히 설계된 이 제품은 기존 GPU 솔루션보다 성능이 뛰어나 자연어 생성 및 이해와 같은 작업에 대한 효율적인 처리를 보장합니다.

LPU 시스템의 일부인 Groq의 1세대 GroqChip은 속도, 효율성, 정확성 및 비용 효율성에 최적화된 텐서 스트리밍 아키텍처를 갖추고 있습니다. 이 칩은 기존 솔루션을 능가하여 사용자당 초당 토큰으로 측정된 기본 LLM 속도에서 새로운 기록을 세웠습니다. Groq는 XNUMX년 이내에 XNUMX만 개의 AI 추론 칩을 배포할 계획을 통해 AI 가속화 기술 발전에 대한 의지를 보여줍니다.

요약하면, Groq의 언어 처리 장치 시스템은 AI 컴퓨팅 기술의 중요한 발전을 나타내며 AI 혁신을 주도하는 동시에 대규모 언어 모델에 탁월한 성능과 효율성을 제공합니다.

또한 읽기 : AWS SageMaker에서 ML 모델 구축

Groq 시작하기

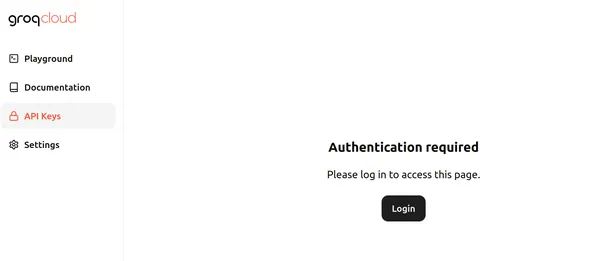

현재 Groq는 Groq LPU(언어 처리 장치)에서 실행되는 대규모 언어 모델에 무료로 사용할 수 있는 API 엔드포인트를 제공하고 있습니다. 시작하려면 다음을 방문하세요. 페이지 그리고 로그인을 클릭하세요. 페이지는 아래와 같습니다.

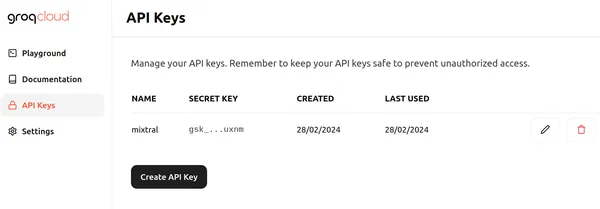

로그인을 클릭하고 적절한 방법 중 하나를 선택하여 Groq에 로그인하세요. 그런 다음 API 키 생성 버튼을 클릭하여 아래와 같은 새 API를 생성할 수 있습니다.

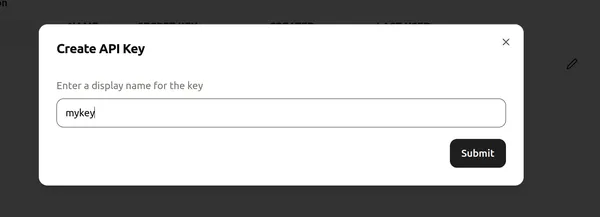

그런 다음 API 키에 이름을 지정하고 "제출"을 클릭하여 새 API 키를 생성합니다. 이제 코드 편집기/Colab으로 이동하여 Groq 사용을 시작하는 데 필요한 라이브러리를 설치하세요.

!pip install groq이 명령은 Groq 라이브러리를 설치하여 Groq LPU에서 실행되는 대형 언어 모델을 추론할 수 있게 해줍니다.

이제 코드를 진행해 보겠습니다.

코드 구현

# Importing Necessary Libraries

import os

from groq import Groq

# Instantiation of Groq Client

client = Groq(

api_key=os.environ.get("GROQ_API_KEY"),

)이 코드 조각은 Groq API와 상호 작용하기 위한 Groq 클라이언트 개체를 설정합니다. GROQ_API_KEY라는 환경 변수에서 API 키를 검색하여 시작하고 이를 api_key 인수에 전달합니다. 그 후 API 키는 Groq 클라이언트 개체를 초기화하여 Groq 서버 내의 대형 언어 모델에 대한 API 호출을 활성화합니다.

LLM 정의

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What are Black Holes?",

}

],

model="mixtral-8x7b-32768",

)

print(llm.choices[0].message.content)- 첫 번째 줄은 llm 개체를 초기화하여 OpenAI Chat Completion API와 유사한 대규모 언어 모델과의 상호 작용을 활성화합니다.

- 후속 코드는 메시지 변수에 저장된 LLM으로 보낼 메시지 목록을 구성합니다.

- 첫 번째 메시지는 역할을 "시스템"으로 할당하고 5세 어린이에게 하듯이 주제를 설명하기 위해 LLM의 원하는 동작을 정의합니다.

- 두 번째 메시지는 역할을 "사용자"로 지정하고 블랙홀에 대한 질문을 포함합니다.

- 다음 줄은 응답 생성에 사용할 LLM을 지정하며 Groq API를 통해 액세스할 수 있는 8k 컨텍스트 Mixtral-7x32768b-Instruct-v32 대규모 언어 모델인 "mixtral-8x7b-0.1"로 설정됩니다.

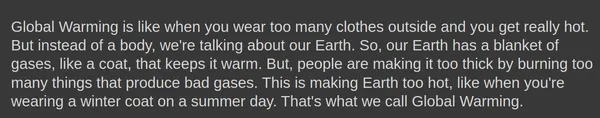

- 이 코드의 출력은 5세 어린이의 이해에 적합한 방식으로 블랙홀을 설명하는 LLM의 응답입니다.

- 출력에 액세스하는 방법은 OpenAI 엔드포인트 작업과 유사한 접근 방식을 따릅니다.

산출

아래는 Mixtral-8x7b-Instruct-v0.1 대규모 언어 모델에서 생성된 출력을 보여줍니다.

XNUMXD덴탈의 완성.생성() 객체는 다음과 같은 추가 매개변수를 취할 수도 있습니다. 온도, top_p및 max_tokens.

응답 생성

다음 매개변수를 사용하여 응답을 생성해 보겠습니다.

llm = client.chat.completions.create(

messages=[

{

"role": "system",

"content": "You are a helpful AI Assistant. You explain ever

topic the user asks as if you are explaining it to a 5 year old"

},

{

"role": "user",

"content": "What is Global Warming?",

}

],

model="mixtral-8x7b-32768",

temperature = 1,

top_p = 1,

max_tokens = 256,

)- 온도: 응답의 무작위성을 제어합니다. 온도가 낮을수록 더 예측 가능한 출력이 생성되고, 온도가 높을수록 더 다양하고 때로는 더 창의적인 출력이 생성됩니다.

- max_tokens: 모델이 단일 응답으로 처리할 수 있는 최대 토큰 수입니다. 이 제한은 계산 효율성과 리소스 관리를 보장합니다.

- top_p: 가능성이 가장 높은 상위 p개의 토큰의 확률 분포에서 다음 토큰을 선택하는 텍스트 생성 방법입니다. 이는 생성 중 탐색과 활용의 균형을 유지합니다.

산출

Groq 엔드포인트에서 생성된 응답을 스트리밍하는 옵션도 있습니다. 우리는 단지 스트림=참 에서 옵션 완성.생성() 응답 스트리밍을 시작하는 모델의 객체입니다.

랭체인의 그로크

Groq은 LangChain과도 호환됩니다. LangChain에서 Groq 사용을 시작하려면 라이브러리를 다운로드하세요:

!pip install langchain-groq위의 내용은 LangChain 호환성을 위해 Groq 라이브러리를 설치합니다. 이제 코드에서 시도해 보겠습니다.

# Import the necessary libraries.

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

# Initialize a ChatGroq object with a temperature of 0 and the "mixtral-8x7b-32768" model.

llm = ChatGroq(temperature=0, model_name="mixtral-8x7b-32768")위의 코드는 다음을 수행합니다.

- llm이라는 새 ChatGroq 개체를 만듭니다.

- 설정 온도 매개변수를 0으로 설정하면 응답이 더 예측 가능해야 함을 나타냅니다.

- 설정 모델명 매개변수를 “mixtral-8x7b-32768", 사용할 언어 모델 지정

# AI 도우미의 기능을 소개하는 시스템 메시지를 정의합니다.

# Define the system message introducing the AI assistant's capabilities.

system = "You are an expert Coding Assistant."

# Define a placeholder for the user's input.

human = "{text}"

# Create a chat prompt consisting of the system and human messages.

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# Invoke the chat chain with the user's input.

chain = prompt | llm

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# Print the Response.

print(response.content)- 이 코드는 ChatPromptTemplate 클래스를 사용하여 채팅 프롬프트를 생성합니다.

- 프롬프트는 두 개의 메시지로 구성됩니다. 하나는 "시스템"(AI 보조자)에서, 다른 하나는 "인간"(사용자)에서 전송됩니다.

- 시스템 메시지는 AI 도우미를 전문 코딩 도우미로 제시합니다.

- 사람의 메시지는 사용자 입력을 위한 자리 표시자 역할을 합니다.

- llm 메소드는 llm 체인을 호출하여 제공된 프롬프트와 사용자 입력을 기반으로 응답을 생성합니다.

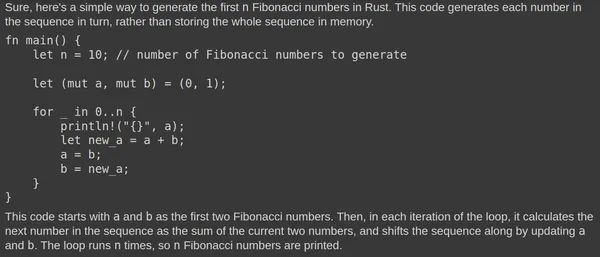

산출

Mixtral Large Language Model에서 생성된 출력은 다음과 같습니다.

Mixtral LLM은 지속적으로 관련 응답을 생성합니다. Rust Playground에서 코드를 테스트하면 해당 기능이 확인됩니다. 빠른 응답은 기본 언어 처리 장치(LPU)에 기인합니다.

Groq 대 기타 추론 API

Groq의 LPU(언어 처리 장치) 시스템은 OpenAI 및 Azure에서 제공하는 것과 같은 다른 추론 API를 능가하는 LLM(대형 언어 모델)에 대한 매우 빠른 추론 속도를 제공하는 것을 목표로 합니다. LLM에 최적화된 Groq의 LPU 시스템은 AI 지원 기술에 중요한 초저지연 기능을 제공합니다. 컴퓨팅 밀도 및 메모리 대역폭을 포함하여 LLM의 주요 병목 현상을 해결하여 텍스트 시퀀스를 더 빠르게 생성할 수 있습니다.

다른 추론 API와 비교하여 Groq의 LPU 시스템은 다른 최고의 클라우드 기반 제공업체에 비해 Anyscale의 LLMPerf Leaderboard에서 최대 18배 더 빠른 추론 성능을 생성할 수 있어 더 빠릅니다. Groq의 LPU 시스템은 또한 단일 코어 아키텍처와 대규모 배포에서 유지되는 동기식 네트워킹을 통해 LLM의 자동 컴파일과 즉각적인 메모리 액세스를 가능하게 하여 더욱 효율적입니다.

위 이미지는 70B 모델에 대한 벤치마크를 표시합니다. 출력 토큰 처리량을 계산하려면 초당 반환된 출력 토큰 수의 평균을 계산해야 합니다. 각 LLM 추론 공급자는 150개의 요청을 처리하여 결과를 수집하며, 평균 출력 토큰 처리량은 이러한 요청을 사용하여 계산됩니다. LLM 추론 공급자의 성능이 향상되면 출력 토큰의 처리량이 높아집니다. Groq의 초당 출력 토큰이 표시된 많은 클라우드 제공업체보다 우수한 것은 분명합니다.

결론

결론적으로, Groq의 언어 처리 장치(LPU) 시스템은 AI 컴퓨팅 영역에서 혁신적인 기술로 두각을 나타내며, LLM(대형 언어 모델) 처리에 전례 없는 속도와 효율성을 제공하고 AI 분야의 혁신을 주도합니다. 초저 지연 시간 기능과 최적화된 아키텍처를 활용하여 Groq는 추론 속도에 대한 새로운 벤치마크를 설정하고 기존 GPU 솔루션 및 기타 업계 최고의 추론 API를 능가합니다. AI에 대한 액세스를 민주화하겠다는 약속과 실시간, 저지연 경험에 중점을 둔 Groq는 AI 가속 기술의 환경을 재편할 준비가 되어 있습니다.

주요 요점

- Groq의 LPU(언어 처리 장치) 시스템은 AI 추론, 특히 LLM(대형 언어 모델)에 대해 비교할 수 없는 속도와 효율성을 제공하여 지연 시간이 짧은 실시간 환경을 지원합니다.

- GroqChip을 탑재한 Groq의 LPU 시스템은 AI 지원 기술에 필수적인 초저지연 기능을 자랑하며 기존 GPU 솔루션보다 성능이 뛰어납니다.

- Groq는 1년 이내에 XNUMX만 개의 AI 추론 칩을 배포할 계획을 통해 AI 가속화 기술을 발전시키고 AI에 대한 액세스를 민주화하기 위한 헌신을 보여줍니다.

- Groq는 Groq LPU에서 실행되는 대규모 언어 모델을 위한 무료 API 엔드포인트를 제공하여 개발자가 자신의 프로젝트에 통합할 수 있도록 해줍니다.

- Groq의 LangChain 및 LlamaIndex 호환성은 유용성을 더욱 확장하여 언어 처리 작업에서 Groq 기술을 활용하려는 개발자에게 원활한 통합을 제공합니다.

자주 묻는 질문

A. Groq는 AI 컴퓨팅 성능 혁신을 목표로 특히 LLM(대형 언어 모델)을 위한 초저 지연 AI 추론을 전문으로 합니다.

A. GroqChip을 갖춘 Groq의 LPU 시스템은 GenAI 언어 처리의 컴퓨팅 집약적인 특성에 맞게 특별히 맞춤 제작되었으며 기존 GPU 솔루션에 비해 뛰어난 속도, 효율성 및 정확성을 제공합니다.

A. Groq는 Mixtral-8x7b-Instruct-v0.1 및 Llama-70b를 포함하여 AI 추론을 위한 다양한 모델을 지원합니다.

A. 예, Groq는 LangChain 및 LlamaIndex와 호환되어 유용성을 확장하고 언어 처리 작업에 Groq 기술을 활용하려는 개발자에게 원활한 통합을 제공합니다.

A. Groq의 LPU 시스템은 속도와 효율성 측면에서 다른 추론 API를 능가하며, Anyscale의 LLMPerf 리더보드 벤치마크에서 입증된 바와 같이 최대 18배 더 빠른 추론 속도와 뛰어난 성능을 제공합니다.

이 기사에 표시된 미디어는 Analytics Vidhya의 소유가 아니며 작성자의 재량에 따라 사용됩니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://www.analyticsvidhya.com/blog/2024/03/getting-started-with-groq-api/