Siamo nella Grande Accelerazione – una singolarità, non nel senso Kurzweiliano della S maiuscola di robot in ascesa, ma in quello descritto da Foucault: un periodo di tempo in cui il cambiamento è così diffuso, e così fondamentale, che non si può propriamente discernere come sarà l’altro lato di quel cambiamento.

Abbiamo già affrontato le singolarità:

- L’ascesa dell’agricoltura (che ha creato risorse in surplus e ci ha dato le classi accademiche e mercantili).

- L'invenzione della stampa (che ha democratizzato la conoscenza e l'ha resa meno malleabile, dandoci l'idea di una fonte di verità oltre i nostri sensi).

- Il motore a vapore (che consente alle macchine di eseguire compiti fisici).

- Software per computer (che ci consente di dare alle macchine istruzioni da seguire).

- Internet e gli smartphone (che ci collegano tutti gli uni agli altri in modo interattivo).

Questa singolarità è, nella sua forma più semplice, quella abbiamo inventato un nuovo tipo di software.

Il vecchio tipo di software

Il vecchio tipo di software – quello attualmente presente sui telefoni e sui computer – ha cambiato le nostre vite in modi che le renderebbero quasi irriconoscibili per qualcuno degli anni ’1970. L’umanità ha avuto 50 anni per adattarsi al software perché ha iniziato lentamente con gli accademici, poi con gli hobbisti, con i modem dial-up e la posta elettronica aziendale. Ma anche con mezzo secolo di tempo per adeguarsi, la nostra civiltà fatica ad affrontarne le conseguenze.

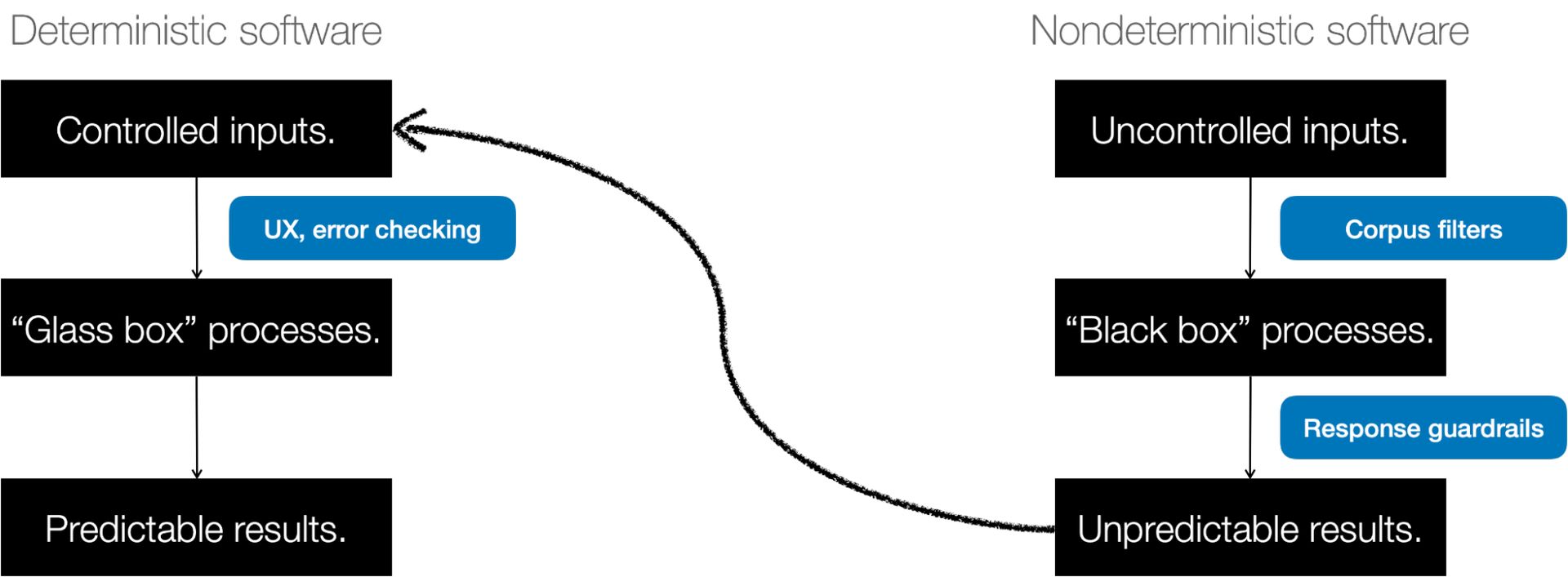

Il software con cui hai familiarità oggi (quello che invia messaggi, somma numeri, registra qualcosa in un calendario o addirittura alimenta una videochiamata) è deterministico. Questo significa fa quello che ti aspetti. Quando il risultato è inaspettato, si parla di bug.

Dal software deterministico all’intelligenza artificiale

Esempi precedenti di “macchine pensanti” includevano la cibernetica (circuiti di feedback come i piloti automatici) e i sistemi esperti (alberi decisionali per i medici). Ma questi erano ancora prevedibili e comprensibili. Hanno semplicemente seguito un sacco di regole.

Negli anni ’1980 abbiamo tentato un approccio diverso. Abbiamo strutturato il software in modo che si comporti come il cervello, dotandolo di “neuroni”. E poi lasciamo che si configuri da solo sulla base di esempi. Nel 1980, un giovane ricercatore di nome Yann LeCun lo provò sulla classificazione delle immagini.

Ora è il capo dell'intelligenza artificiale a Meta.

Poi l’intelligenza artificiale è entrata in una sorta di ibernazione. Si stavano facendo progressi, ma erano lenti e avvenivano nelle aule del mondo accademico. Sono emersi il deep learning, TensorFlow e altre tecnologie, principalmente per alimentare motori di ricerca, raccomandazioni e pubblicità. Ma l’intelligenza artificiale è una cosa che è accaduta dietro le quinte, nei servizi pubblicitari, nelle mappe e nel riconoscimento vocale.

Nel 2017, alcuni ricercatori hanno pubblicato un articolo fondamentale intitolato “L’attenzione è tutto ciò di cui hai bisogno”. All’epoca gli autori lavoravano presso Google, ma da allora molti si sono trasferiti in aziende come OpenAI. L'articolo descriveva un modo molto più semplice per lasciare che il software si configurasse da solo prestando attenzione alle parti del linguaggio che contavano di più.

Uno dei primi usi di questo era la traduzione. Se si alimenta un algoritmo con abbastanza testo in inglese e francese, può capire come tradurre dall'uno all'altro comprendendo le relazioni tra le parole di ciascuna lingua. Ma l’approccio di base ci ha permesso di addestrare il software sul testo recuperato da Internet.

Da lì, il progresso è stato piuttosto rapido. Nel 2021, abbiamo capito come creare un "modello di istruzione" che utilizzava un processo chiamato Supervised Fine Tuning (SFT) per far sì che l'IA conversazionale seguisse le istruzioni. Nel 2022, abbiamo chiesto agli esseri umani di valutare le risposte alle nostre istruzioni (chiamato Messa a punto supervisionata modificata) e alla fine del 2022 abbiamo aggiunto qualcosa chiamato Apprendimento per rinforzo sul feedback umano, che ci ha fornito GPT-3.5 e ChatGPT. Le IA ora possono fornire feedback ad altre IA.

In ogni caso, entro il 2024, gli esseri umani saranno l’input su cui le cose vengono addestrate e forniranno il feedback sulla qualità dell’output utilizzato per migliorarla.

Quando l'inaspettato è una caratteristica, non un bug

Il risultato è un nuovo tipo di software. Per farlo funzionare, per prima cosa raccogliamo montagne di dati e li utilizziamo per addestrare un enorme modello matematico. Quindi, inseriamo un prompt nel modello e questo prevede la risposta che desideriamo (molte persone non se ne rendono conto una volta addestrata un’intelligenza artificiale, lo stesso input fornisce ogni volta lo stesso output – quello che ritiene sia “migliore”.). Ma noi vogliamo creatività, quindi aggiungiamo una perturbazione, chiamata temperatura, che dice all’IA quanta casualità iniettare nelle sue risposte.

Non possiamo prevedere in anticipo cosa farà il modello. E introduciamo intenzionalmente la casualità per ottenere risposte diverse ogni volta. Il punto centrale di questo nuovo software è essere imprevedibile. Essere non deterministico. Fa cose inaspettate.

In passato, si inserisce qualcosa nell'applicazione e questo segue una serie di istruzioni scritte da esseri umani ed emerge un risultato atteso. Ora, inserisci qualcosa in un'intelligenza artificiale e segue una serie di istruzioni che it scritto, e dall'altra parte emerge un risultato inaspettato. E il risultato inaspettato non è un bug, è una funzionalità.

Adozione incredibilmente rapida

Stiamo adottando questo secondo tipo di software molto più rapidamente del primo, per diverse ragioni

- Rende il proprio manuale utente: Anche se siamo tutti entusiasti della bontà dei risultati, spesso trascuriamo quanto bene possa rispondere a input semplici. Questo è il primo software senza curva di apprendimento: dirà letteralmente a chiunque sappia scrivere o parlare come usarlo. È il primo software che crea la propria documentazione.

- Tutti possono provarlo: Grazie alla connettività onnipresente tramite telefoni cellulari e banda larga e al modello SaaS del software ospitato, molte persone possono accedervi. Non è più necessario acquistare e installare software. Chiunque abbia un browser può provarlo.

- L'hardware è ovunque: Le GPU dei giochi, i chip della serie M di Apple e il cloud computing rendono le immense risorse di calcolo estremamente facili da distribuire.

- I costi sono diminuiti. Molto: alcuni progressi algoritmici hanno ridotto il costo dell’intelligenza artificiale di diversi ordini di grandezza. Il costo per classificare un miliardo di immagini è sceso da 10,000 dollari nel 2021 a 0.03 dollari nel 2023, una tariffa giornaliera 450 volte più economica.

- Viviamo online: gli esseri umani trascorrono online in media sei ore al giorno e gran parte di tale interazione (e-mail, chat, SMS, blog) è basata sul testo. Nel mondo online, un essere umano è in gran parte indistinguibile da un algoritmo, quindi esistono molti modi semplici per collegare l’output dell’intelligenza artificiale ai feed e agli schermi che le persone consumano. Il COVID-19 ha accelerato il lavoro a distanza e, con esso, l’insinuazione di testi e algoritmi nelle nostre vite.

Cosa può fare il software non deterministico

Il software non deterministico può fare molte cose, alcune delle quali stiamo iniziando a realizzare solo ora.

- È generativo. Può creare cose nuove. Lo stiamo vedendo nelle immagini (Stable Diffusion, Dall-e) e nella musica (Google MusicLM) e persino nella finanza, nella genomica e nel rilevamento delle risorse. Ma il luogo che sta ottenendo l’attenzione più diffusa è nei chatbot come quelli di OpenAI, Google, Perplexity e altri.

- È bravo con la creatività, ma lo è inventa cose. Ciò significa che gli stiamo assegnando lavori “divertenti” come l’arte, la prosa e la musica per i quali non esiste una “risposta giusta”. Significa anche un’ondata di disinformazione e una crisi epistemica per l’umanità.

- Ancora ha bisogno di molto input umano per filtrare l'output in qualcosa di utilizzabile. In effetti, molti passaggi nella produzione di un’intelligenza artificiale conversazionale coinvolgono gli esseri umani che le forniscono esempi di buone risposte o valutano le risposte fornite.

- Poiché spesso è sbagliato, bisogna poter incolpare qualcuno. L'umano che decide cosa fare con il suo output è responsabile delle conseguenze.

- It può ragionare in modi che non pensavamo dovesse essere in grado di fare. Non capiamo perché ciò avvenga.

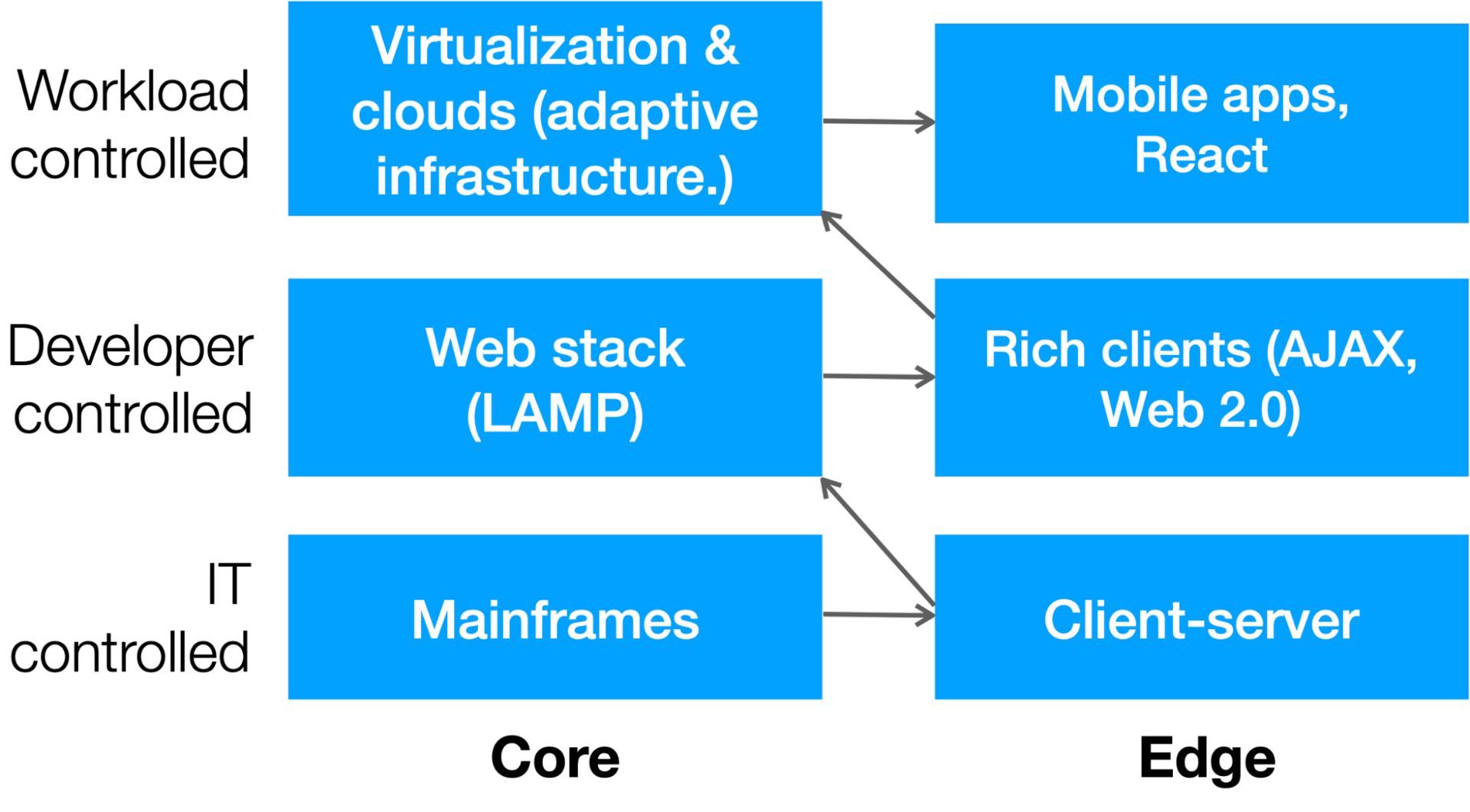

Il pendolo e la democratizzazione dell'IT

Anche se, per definizione, è difficile prevedere l'altro lato di una singolarità, possiamo fare alcune ipotesi plausibili su come cambierà la tecnologia dell'informazione (IT). Il settore IT ha subito due grandi cambiamenti nel corso dell’ultimo secolo:

- Un pendolo costante, oscilla dalla centralizzazione dei mainframe alla natura distribuita dei client web.

- Si tratta di una graduale democratizzazione delle risorse, dai tempi in cui l'informatica era rara, preziosa e custodita dall'IT a un'era in cui gli sviluppatori, e poi gli stessi carichi di lavoro, potevano distribuire le risorse secondo necessità.

Questo diagramma mostra questo spostamento:

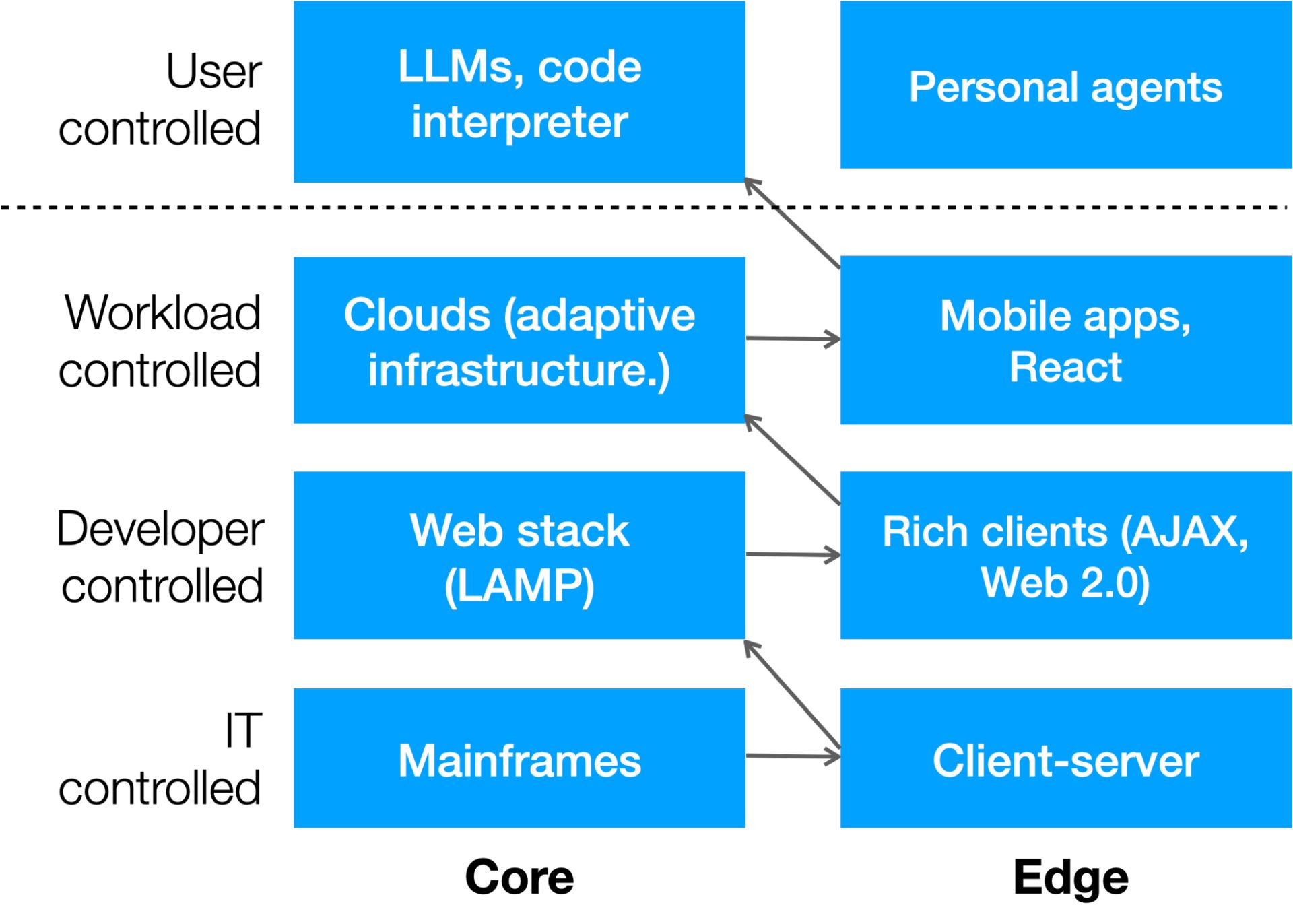

C'è un altro livello che si sta verificando grazie all'intelligenza artificiale: l'elaborazione controllata dall'utente. Stiamo già vedendo strumenti no-code e low-code come Unqork, Bubble, Webflow, Zapier e altri che semplificano la creazione di app da parte degli utenti, ma ciò che è molto più interessante è quando il prompt dell'intelligenza artificiale di un utente avvia il codice. Lo vediamo nell'interprete di codice ChatGPT di OpenAI, che scriverà e quindi eseguirà app per elaborare i dati.

È probabile che ci sarà un'altra oscillazione del pendolo verso il limite nei prossimi anni quando aziende come Apple entreranno nella mischia (che hanno integrato una potente elaborazione AI nei loro chipset nostrani in previsione di questo giorno). Ecco come appare il livello successivo di elaborazione:

Costruire una seconda pila

Un’altra previsione che possiamo fare sull’IT nell’era non deterministica è che le aziende avranno due stack.

- Uno sarà deterministico, eseguendo compiti prevedibili.

- Uno sarà non deterministico, generando risultati inaspettati.

Forse la cosa più interessante è che il secondo stack (non deterministico) sarà in grado di scrivere codice che il primo stack (deterministico) potrà eseguire – presto, meglio di quanto possano fare gli umani.

Il prossimo decennio vedrà una corsa alla creazione di secondi stack in ogni organizzazione. Ogni azienda sarà giudicata in base al valore del suo corpus, alle informazioni proprietarie e agli aggiornamenti in tempo reale che utilizza per ottenere i migliori risultati dalla sua intelligenza artificiale. Ogni stack avrà requisiti hardware, architetture, governance, interfacce utente e strutture di costo diversi.

Non possiamo prevedere come l’intelligenza artificiale rimodellerà l’umanità. Ma possiamo fare ipotesi plausibili su come cambierà l’IT aziendale, e coloro che si adatteranno rapidamente saranno più pronti a trarre vantaggio da ciò che verrà dopo.

Alistar Croll è autore di numerosi libri su tecnologia, business e società, incluso il bestseller Lean Analytics. È il fondatore e copresidente di FWD50, la principale conferenza mondiale sull'innovazione del settore pubblico, ed è stato visiting executive presso la Harvard Business School, dove ha contribuito a creare il curriculum per Data Science e Critical Thinking. È il presidente della conferenza di Universo di dati 2024.

Incontra l'autore su Data Universe

Unisciti all'autore, Alistair Croll, su Universo di dati, che si svolgerà dal 10 all'11 aprile 2024 a New York, dove presiederà il lancio inaugurale di una nuova conferenza indipendente dal marchio, sui dati e sull'intelligenza artificiale, progettata per l'intera comunità globale di dati e intelligenza artificiale.

Riunendo TUTTO: Data Universe accoglie professionisti dei dati di tutti i livelli di competenza e ruolo, nonché uomini d'affari, dirigenti e partner di settore per interagire con gli approfondimenti più attuali e pertinenti forniti da esperti su dati, analisi, ML e intelligenza artificiale esplorati in tutti i settori , per aiutarti a evolvere insieme alle norme, agli strumenti, alle tecniche e alle aspettative in rapida evoluzione che trasformano il futuro del business e della società. Unisciti a noi al North Javits Center di New York, questo aprile, per far parte del futuro dei dati e dell'intelligenza artificiale.

INFORMS è felice di essere un partner strategico di Data Universe 2024 e presenterà quattro sessioni durante la conferenza.

Credito immagine in primo piano: Growtika/Unsplash

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://dataconomy.com/2024/04/04/building-the-second-stack/