Introduzione

Negli ultimi anni, il campo dell’intelligenza artificiale (AI) ha assistito a un notevole aumento nello sviluppo di modelli di intelligenza artificiale generativa. Questi modelli possono generare testo simile a quello umano, immagini e persino audio, spingendo oltre i confini di ciò che una volta si riteneva impossibile. Tra questi modelli, il Generative Pre-trained Transformer (GPT) si distingue come una svolta pionieristica nell’elaborazione del linguaggio naturale (NLP). Esploriamo l'intricata architettura dei GPT e scopriamo come gestiscono con facilità le attività di intelligenza artificiale generativa e PNL.

Sommario

L’ascesa dei modelli di intelligenza artificiale generativa

I modelli di intelligenza artificiale generativa sono una classe di machine learning modelli in grado di creare nuovi dati, come testo, immagini o audio, da zero. Questi modelli vengono addestrati su grandi quantità di dati esistenti, consentendo loro di apprendere i modelli e le strutture sottostanti. Una volta addestrati, possono generare contenuti nuovi e originali che imitano le caratteristiche dei dati di addestramento.

L’ascesa dei modelli di intelligenza artificiale generativa è stata alimentata dai progressi nelle tecniche di deep learning, in particolare nelle reti neurali. Apprendimento approfondito gli algoritmi si sono dimostrati straordinariamente efficaci nel catturare modelli complessi nei dati, rendendoli adatti per attività generative. Con l’aumento della potenza computazionale e dell’accesso a grandi set di dati, i ricercatori sono stati in grado di addestrare modelli generativi sempre più sofisticati.

I misteri del GPT

I modelli GPT sono un tipo di modello linguistico di grandi dimensioni (LLM) che sfrutta la potenza di reti neurali per comprendere e generare testo simile a quello umano. Questi modelli sono “generativi” perché possono produrre testo nuovo e coerente basato sui modelli appresi da enormi set di dati. Sono “pre-addestrati” perché subiscono una fase iniziale di addestramento su grandi quantità di dati testuali. Ciò consente loro di acquisire un'ampia base di conoscenze prima di essere perfezionati per compiti specifici.

L'architettura "trasformatore" è l'innovazione principale che ha spinto i modelli GPT a livelli di prestazioni senza precedenti. Trasformatori sono un tipo di rete neurale progettata per gestire dati sequenziali, come il testo, in modo più efficace rispetto ai modelli tradizionali. Impiegano un nuovo meccanismo di attenzione che consente al modello di valutare l’importanza delle diverse parti dell’input durante la generazione dell’output. Ciò gli consente di acquisire dipendenze a lungo raggio e produrre testo più coerente e contestualmente rilevante.

Analisi dell'architettura GPT

L'architettura GPT è una potente combinazione di tre componenti chiave: le sue capacità generative, l'approccio pre-formazione e la rete neurale del trasformatore. Ciascuno di questi pilastri svolge un ruolo cruciale nel consentire ai modelli GPT di raggiungere le loro straordinarie prestazioni nei compiti di PNL.

I tre pilastri: generativo, pre-addestrato e trasformatore

L'aspetto "generativo" dei modelli GPT si riferisce alla loro capacità di generare testo nuovo e coerente basato sui modelli appresi da grandi quantità di dati di addestramento. I modelli linguistici tradizionali si concentrano principalmente sulla comprensione e sull’analisi del testo. A differenza di loro, i modelli GPT sono progettati per produrre output di testo simili a quelli umani, rendendoli altamente versatili per una varietà di applicazioni.

La componente “pre-addestrata” dei modelli GPT prevede una fase di addestramento iniziale in cui il modello viene esposto a un enorme corpus di dati di testo. Durante questa fase di pre-addestramento, il modello impara a catturare i modelli, le strutture e le relazioni sottostanti all'interno dei dati. Ciò aiuta a costruire in modo efficace un’ampia base di conoscenze. La fase di pre-addestramento è fondamentale in quanto consente al modello di acquisire una comprensione generale del linguaggio prima di essere messo a punto.

L'architettura del "trasformatore" è la spina dorsale della rete neurale dei modelli GPT. I trasformatori sono modelli di deep learning progettati specificamente per gestire dati sequenziali, come il testo, in modo più efficace rispetto ai modelli tradizionali. Impiegano un nuovo meccanismo di attenzione che consente al modello di valutare l’importanza delle diverse parti dell’input durante la generazione dell’output. Ciò gli consente di acquisire dipendenze a lungo raggio e produrre testo più coerente e contestualmente rilevante.

Come i GPT producono frasi coerenti

I modelli GPT generano testo prevedendo la parola o il token successivo in una sequenza basata sul contesto fornito dalle parole o dai token precedenti. Questo processo è ottenuto attraverso una serie di calcoli all'interno dell'architettura del trasformatore. Si inizia con la tokenizzazione del testo di input e la sua trasformazione in rappresentazioni numeriche (incorporamenti). Questi incorporamenti passano quindi attraverso più strati del trasformatore. In questo caso, il meccanismo dell’attenzione consente al modello di catturare le relazioni tra le diverse parti dell’input e generare output contestualmente rilevanti.

L'output del modello è a distribuzione di probabilità sull'intero vocabolario, indicando la probabilità che ogni parola o segno sia il successivo nella sequenza. Durante l'inferenza, il modello campiona da questa distribuzione per generare il token successivo, che viene aggiunto alla sequenza di input. Questo processo si ripete finché non viene raggiunta la lunghezza di output desiderata o finché non viene soddisfatta una condizione di arresto.

Sfruttare enormi set di dati per prestazioni migliori

Uno dei principali vantaggi dei modelli GPT è la loro capacità di sfruttare enormi set di dati durante la fase di pre-addestramento. Questi set di dati possono essere costituiti da miliardi di parole provenienti da varie fonti, come libri, articoli, siti Web e social media. Ciò fornisce al modello un’esposizione diversificata e completa al linguaggio naturale.

Durante il pre-addestramento, il modello deve prevedere la parola o il token successivo nella sequenza, in modo simile al processo di generazione del testo. Tuttavia, invece di generare nuovo testo, il modello impara a catturare i modelli e le relazioni sottostanti all'interno dei dati di training. Questa fase di pre-addestramento è impegnativa dal punto di vista computazionale ma cruciale. Permette al modello di sviluppare un’ampia comprensione del linguaggio, che può poi essere messa a punto per compiti specifici.

Sfruttando enormi set di dati durante la fase di pre-formazione, i modelli GPT possono acquisire una vasta base di conoscenze. Possono anche sviluppare una profonda comprensione delle strutture linguistiche, delle espressioni idiomatiche e delle sfumature contestuali. Questa ampia formazione preliminare fornisce una solida base per il modello. Consente al modello di funzionare bene su un'ampia gamma di attività a valle con una messa a punto relativamente piccola e specifica dell'attività.

La rete neurale dietro la magia

L'architettura del trasformatore è l'innovazione principale che alimenta i modelli GPT e ha rivoluzionato il campo della PNL. A differenza del tradizionale reti neurali ricorrenti (RNN), che elaborano sequenzialmente dati sequenziali, i trasformatori utilizzano un nuovo meccanismo di attenzione che consente loro di catturare dipendenze a lungo raggio ed elaborare in modo efficiente sequenze di input in parallelo.

L'architettura del trasformatore è costituita da più strati, ciascuno comprendente due componenti principali: il meccanismo di attenzione multi-testa e la rete neurale feed-forward. Il meccanismo di attenzione è responsabile della ponderazione dell'importanza delle diverse parti della sequenza di input durante la generazione dell'output, consentendo al modello di catturare il contesto e le relazioni tra elementi distanti nella sequenza.

Gli strati della rete neurale feed-forward sono responsabili dell'ulteriore elaborazione e perfezionamento dell'output del meccanismo di attenzione, consentendo al modello di apprendere rappresentazioni più complesse dei dati di input.

Il meccanismo di elaborazione e attenzione parallelizzato dell'architettura del trasformatore si è dimostrato altamente efficace nella gestione di lunghe sequenze e nell'acquisizione di dipendenze a lungo raggio, che sono cruciali per le attività di PNL. Questa architettura ha consentito ai modelli GPT di raggiungere prestazioni all'avanguardia. Ha anche influenzato lo sviluppo di altri modelli basati su trasformatori in vari settori, come la visione artificiale e il riconoscimento vocale.

All'interno del trasformatore

L'architettura del trasformatore è il componente principale che consente ai modelli GPT di raggiungere le loro straordinarie prestazioni nelle attività di PNL. Diamo uno sguardo più da vicino ai passaggi chiave coinvolti nell'elaborazione dei dati di testo da parte del trasformatore.

Tokenizzazione: scomporre il testo in blocchi digeribili

Prima che il trasformatore possa elaborare il testo, i dati di input devono essere suddivisi in unità più piccole chiamate token. tokenizzazione è il processo di suddivisione del testo in questi token, che possono essere parole, sottoparole o anche singoli caratteri. Questo passaggio è cruciale perché consente al trasformatore di gestire sequenze di varia lunghezza e di rappresentare in modo efficace parole rare o fuori dal vocabolario. Il processo di tokenizzazione in genere coinvolge tecniche come la segmentazione delle parole, la gestione della punteggiatura e la gestione dei caratteri speciali.

Incorporamenti di parole: mappatura di parole su vettori numerici

Una volta che il testo è stato tokenizzato, ogni token viene mappato su una rappresentazione vettoriale numerica chiamata incorporamento di parole. Questi incorporamenti di parole sono vettori densi che catturano informazioni semantiche e sintattiche sulle parole che rappresentano. Il trasformatore utilizza questi incorporamenti come input, consentendogli di elaborare dati di testo in un formato numerico che può essere manipolato in modo efficiente dalla sua architettura di rete neurale. Gli incorporamenti di parole vengono appresi durante il processo di addestramento, in cui parole con significati simili tendono ad avere rappresentazioni vettoriali simili, consentendo al modello di catturare relazioni semantiche e contesto.

Il meccanismo dell'attenzione: il cuore del trasformatore

Il meccanismo di attenzione è l'innovazione chiave che distingue i trasformatori dalle tradizionali architetture di rete neurale. Consente al modello di concentrarsi selettivamente su parti rilevanti della sequenza di input durante la generazione di output, catturando in modo efficace le dipendenze e il contesto a lungo termine. IL meccanismo di attenzione funziona calcolando i punteggi di attenzione che rappresentano l'importanza di ciascun elemento di input per un dato elemento di output, quindi utilizzando questi punteggi per ponderare le corrispondenti rappresentazioni di input. Questo meccanismo consente al trasformatore di elaborare in modo efficace sequenze di varia lunghezza e di catturare relazioni tra elementi distanti nell'input, il che è fondamentale per attività come la traduzione automatica e la generazione del linguaggio.

Percettroni multistrato: miglioramento delle rappresentazioni vettoriali

Oltre al meccanismo di attenzione, incorporano anche i trasformatori percettroni multistrato (MLP), che sono reti neurali feed-forward. Questi MLP vengono utilizzati per elaborare e perfezionare ulteriormente le rappresentazioni vettoriali prodotte dal meccanismo di attenzione, consentendo al modello di catturare modelli e relazioni più complessi nei dati. Gli MLP prendono come input l'output del meccanismo di attenzione e applicano una serie di trasformazioni lineari e funzioni di attivazione non lineare per migliorare le rappresentazioni vettoriali. Questo passaggio è fondamentale affinché il modello possa apprendere caratteristiche e rappresentazioni di livello superiore utili per l'attività a valle.

Addestramento di un modello GPT

L'addestramento di un modello GPT è un processo complesso e ad alta intensità di calcolo che coinvolge diversi componenti e tecniche chiave.

Backpropagation: l'algoritmo che rende i GPT più intelligenti

Al centro dell'addestramento dei modelli GPT c'è l'algoritmo di backpropagation, che è una tecnica ampiamente utilizzata nel deep learning per aggiornare i pesi e i parametri del modello in base agli errori commessi durante l'addestramento. Durante retropropagazione, le previsioni del modello vengono confrontate con le etichette di verità di base e gli errori vengono propagati all'indietro attraverso la rete per regolare i pesi e ridurre al minimo l'errore complessivo. Questo processo prevede il calcolo dei gradienti della funzione di perdita rispetto ai parametri del modello e l'aggiornamento dei parametri nella direzione che minimizza la perdita. La backpropagation è una componente essenziale del processo di formazione, poiché consente al modello di imparare dai propri errori e migliorare gradualmente le proprie prestazioni.

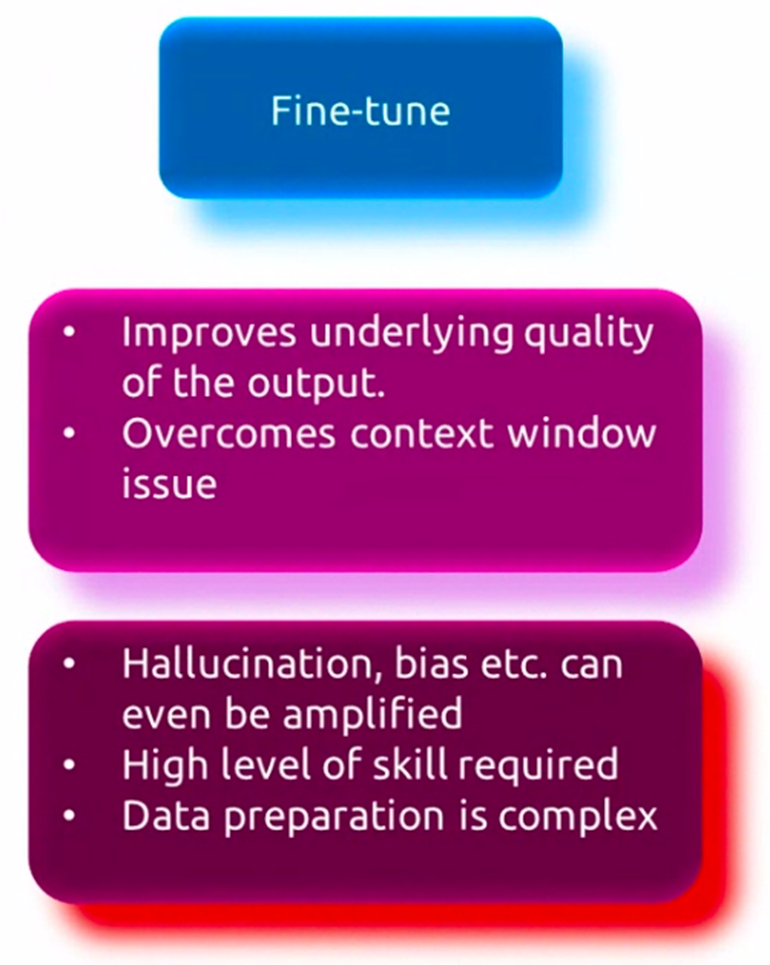

Messa a punto controllata

Sebbene i modelli GPT siano pre-addestrati su enormi set di dati per acquisire un'ampia comprensione del linguaggio, spesso devono essere ottimizzati su dati specifici dell'attività per funzionare bene su applicazioni specifiche. Questo processo, noto come ottimizzazione supervisionata, prevede un ulteriore addestramento del modello preaddestrato su un set di dati più piccolo pertinente all'attività di destinazione, ad esempio la risposta alle domande, il riepilogo del testo o la traduzione automatica. Durante ritocchi, i pesi del modello vengono adeguati per catturare meglio i modelli e le sfumature specifici del compito da svolgere, pur mantenendo la conoscenza linguistica generale acquisita durante la pre-formazione. Questo processo di messa a punto consente al modello di specializzarsi e adattarsi ai requisiti specifici dell'attività target, con conseguente miglioramento delle prestazioni.

Pre-addestramento senza supervisione

Prima della messa a punto, i modelli GPT vengono sottoposti a una fase iniziale di pre-addestramento senza supervisione, in cui vengono esposti a grandi quantità di dati di testo provenienti da varie fonti, come libri, articoli e siti Web. Durante questa fase, il modello impara a catturare i modelli e le relazioni sottostanti nei dati prevedendo la parola o il token successivo in una sequenza, un processo noto come modellazione del linguaggio. Questo pre-addestramento non supervisionato consente al modello di sviluppare un'ampia comprensione del linguaggio, inclusa la sintassi, la semantica e il contesto. Il modello viene addestrato su un enorme corpus di dati di testo, consentendogli di apprendere da una vasta gamma di argomenti, stili e domini. Questa fase di pre-addestramento senza supervisione è impegnativa dal punto di vista computazionale ma cruciale, poiché fornisce al modello una solida base per la successiva messa a punto di compiti specifici.

Applicazioni GPT e casi d'uso

I modelli GPT hanno mostrato una notevole versatilità e sono stati applicati a un’ampia gamma di compiti e applicazioni di PNL. Esploriamo alcuni dei casi d'uso chiave di questi potenti modelli linguistici.

Rompere le barriere linguistiche

Una delle prime e più importanti applicazioni dei modelli GPT è nel campo della traduzione automatica. Sfruttando la loro capacità di comprendere e generare testo simile a quello umano, i modelli GPT possono essere addestrati a tradurre tra lingue diverse con elevata precisione e fluidità. Questi modelli possono catturare le sfumature e le complessità del linguaggio, consentendo loro di produrre traduzioni che non solo sono accurate ma mantengono anche il significato e il contesto previsti del testo originale.

Riepilogo del testo

Con la quantità sempre crescente di dati testuali disponibili, la capacità di riassumere documenti o articoli lunghi in sintesi concise e significative è diventato sempre più importante. I modelli GPT si sono rivelati efficaci in questo compito, poiché possono analizzare e comprendere il contesto e i punti chiave di un determinato testo, quindi generare un riassunto condensato che cattura l'essenza del contenuto originale. Questa applicazione ha numerosi casi d'uso, che vanno dal riepilogo di articoli di notizie e documenti di ricerca alla generazione di report concisi e riepiloghi esecutivi.

Chatbot e intelligenza artificiale conversazionale

Una delle applicazioni più visibili e ampiamente adottate dei modelli GPT è nello sviluppo di chatbot e AI conversazionale sistemi. Questi modelli possono impegnarsi in un dialogo simile a quello umano, comprendendo e rispondendo alle domande e agli input degli utenti in modo naturale e contestualmente appropriato. I chatbot basati su GPT vengono utilizzati in vari settori, come il servizio clienti, l'e-commerce e l'assistenza sanitaria, per fornire assistenza personalizzata ed efficiente agli utenti.

Il potenziale immaginativo dei GPT

Sebbene i modelli GPT siano stati inizialmente progettati per compiti di comprensione e generazione del linguaggio, la loro capacità di produrre testi coerenti e fantasiosi ha aperto nuove possibilità nel regno della scrittura creativa. Questi modelli possono essere perfezionati per generare storie, poesie, copioni e persino testi di canzoni, offrendo a scrittori e artisti un potente strumento per esplorare nuove strade creative. Inoltre, i modelli GPT possono assistere nel processo di scrittura suggerendo sviluppi della trama e descrizioni dei personaggi e persino generando interi passaggi basati su suggerimenti o schemi.

Il futuro dei GPT e dell’intelligenza artificiale generativa

Per quanto promettenti siano stati i modelli GPT, ci sono ancora limiti e sfide da superare, nonché considerazioni etiche da affrontare. Inoltre, il campo dell’intelligenza artificiale generativa è in rapida evoluzione, con nuove tendenze e ricerche all’avanguardia che plasmano il futuro di questi modelli.

Limitazioni e sfide degli attuali modelli GPT

Nonostante le loro impressionanti capacità, gli attuali modelli GPT presentano alcune limitazioni. Una delle sfide principali è la loro incapacità di comprendere veramente il significato sottostante e il contesto del testo che generano. Sebbene possano produrre testi coerenti e fluenti, a volte possono generare informazioni prive di senso o sostanzialmente errate, soprattutto quando si tratta di argomenti complessi o specializzati. Inoltre, questi modelli possono mostrare distorsioni presenti nei dati di addestramento, sollevando preoccupazioni sull’equità e sui risultati potenzialmente dannosi.

Considerazioni etiche e sviluppo responsabile dell'intelligenza artificiale

Man mano che i modelli GPT diventano più potenti e diffusi, è fondamentale affrontare considerazioni etiche e garantire lo sviluppo e l’implementazione responsabili di queste tecnologie. Questioni come la privacy, la sicurezza e il potenziale uso improprio o applicazioni dannose devono essere esaminate attentamente. I ricercatori e gli sviluppatori devono lavorare per sviluppare linee guida etiche, quadri di governance e solide garanzie per mitigare i rischi potenziali e garantire l’uso sicuro e vantaggioso dei modelli GPT.

Tendenze emergenti e ricerca all’avanguardia

Il campo dell’intelligenza artificiale generativa è in rapida evoluzione, con i ricercatori che esplorano nuove architetture, metodi di formazione e applicazioni. Una delle tendenze emergenti è modelli multimodali in grado di elaborare e generare dati attraverso diverse modalità (testo, immagini, audio, ecc.). Gli approcci di apprendimento per rinforzo per la generazione del linguaggio sono un altro. L'integrazione dei modelli GPT con altre tecnologie AI, come visione computerizzata ed robotica è ancora un'altra tendenza. Inoltre, sono in corso ricerche per migliorare l'interpretabilità, la controllabilità e la robustezza di questi modelli. I ricercatori stanno anche esplorando il loro potenziale in settori quali la scoperta scientifica, l’istruzione e l’assistenza sanitaria.

Conclusione

I modelli GPT hanno rivoluzionato il campo della PNL. Hanno dimostrato notevoli capacità in compiti quali la traduzione linguistica, il riepilogo del testo, l’intelligenza artificiale conversazionale e la scrittura creativa. Al centro di questi modelli c’è l’architettura del trasformatore. Ciò impiega un nuovo meccanismo di attenzione per catturare le dipendenze e il contesto a lungo raggio nei dati di testo. L'addestramento dei modelli GPT prevede un processo complesso di pre-addestramento non supervisionato su enormi set di dati, seguito da una messa a punto supervisionata per compiti specifici.

Sebbene i modelli GPT abbiano ottenuto risultati impressionanti, ci sono ancora limiti e sfide da superare. Ciò include la mancanza di vera comprensione, potenziali pregiudizi e preoccupazioni etiche. Inoltre, il campo dell’intelligenza artificiale generativa è in rapida evoluzione, con i ricercatori che esplorano nuove architetture, applicazioni e tecniche per ampliare i confini di questi modelli.

Poiché i modelli GPT continuano ad avanzare, è fondamentale affrontare considerazioni etiche e sviluppare pratiche di intelligenza artificiale responsabili. È anche importante esplorare le tendenze emergenti e la ricerca all’avanguardia per sfruttare tutto il potenziale di questi potenti modelli. Nel frattempo, dobbiamo garantire il loro utilizzo sicuro e vantaggioso mitigando i rischi potenziali.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/