Introduzione

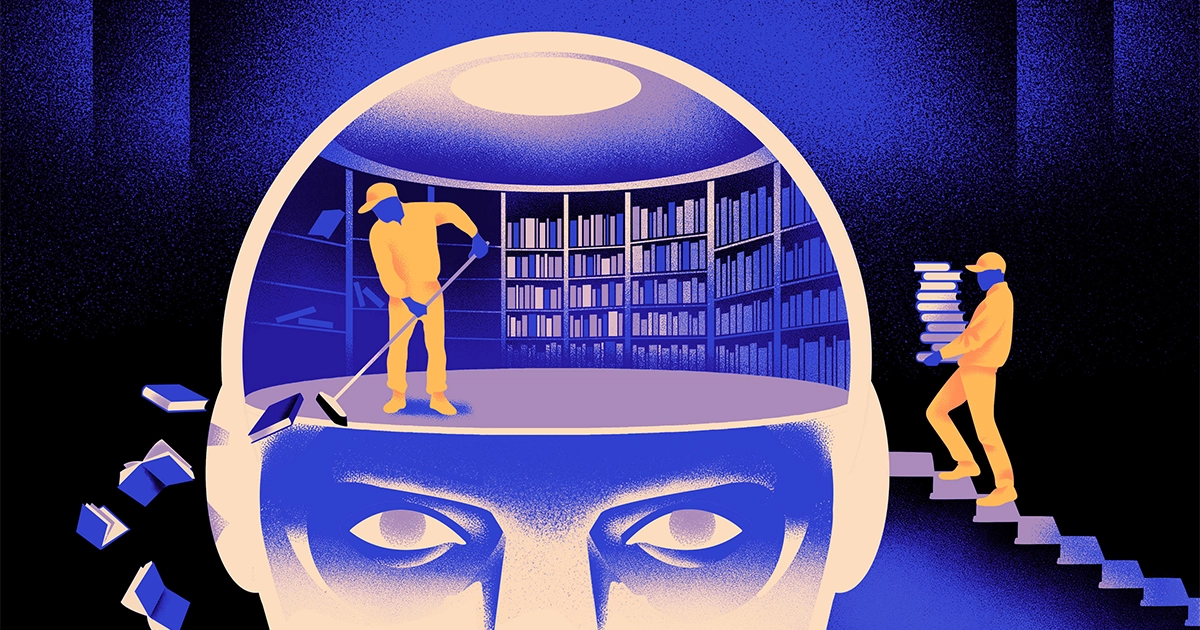

Un team di informatici ha creato un file tipo più agile e flessibile del modello di apprendimento automatico. Il trucco: deve periodicamente dimenticare ciò che sa. E anche se questo nuovo approccio non sostituirà gli enormi modelli che stanno alla base delle app più grandi, potrebbe rivelare di più su come questi programmi comprendono il linguaggio.

La nuova ricerca segna “un progresso significativo nel campo”, ha affermato Jea Kwon, un ingegnere di intelligenza artificiale presso l'Institute for Basic Science in Corea del Sud.

I motori linguistici AI in uso oggi sono per lo più alimentati da reti neurali artificiali. Ogni “neurone” nella rete è una funzione matematica che riceve segnali da altri neuroni simili, esegue alcuni calcoli e invia segnali attraverso più strati di neuroni. Inizialmente il flusso di informazioni è più o meno casuale, ma attraverso l’addestramento il flusso di informazioni tra i neuroni migliora man mano che la rete si adatta ai dati di addestramento. Se un ricercatore di intelligenza artificiale volesse creare un modello bilingue, ad esempio, addestrerebbe il modello con una grande pila di testo di entrambe le lingue, che regolerebbe le connessioni tra i neuroni in modo tale da mettere in relazione il testo in una lingua con equivalenti parole nell'altro.

Ma questo processo di formazione richiede molta potenza di calcolo. Se il modello non funziona molto bene, o se le esigenze dell'utente cambiano in seguito, è difficile adattarlo. "Supponiamo che tu abbia un modello con 100 lingue, ma immagini che la lingua che desideri non sia coperta", ha detto Mikel Artetxe, coautore della nuova ricerca e fondatore della startup AI Reka. "Potresti ricominciare da capo, ma non è l'ideale."

Artetxe e i suoi colleghi hanno cercato di aggirare queste limitazioni. Alcuni anni fa, Artetxe e altri hanno addestrato una rete neurale in una lingua, quindi hanno cancellato ciò che sapeva sugli elementi costitutivi delle parole, chiamati token. Questi vengono memorizzati nel primo strato della rete neurale, chiamato strato di incorporamento. Hanno lasciato intatti tutti gli altri strati del modello. Dopo aver cancellato i token della prima lingua, hanno riqualificato il modello sulla seconda lingua, che ha riempito il livello di incorporamento con nuovi token di quella lingua.

Anche se il modello conteneva informazioni non corrispondenti, la riqualificazione ha funzionato: il modello è riuscito ad apprendere ed elaborare la nuova lingua. I ricercatori hanno ipotizzato che mentre il livello di incorporamento memorizzava informazioni specifiche sulle parole usate nella lingua, i livelli più profondi della rete memorizzavano informazioni più astratte sui concetti alla base del linguaggio umano, che poi aiutavano il modello ad apprendere la seconda lingua.

“Viviamo nello stesso mondo. Concettualizziamo le stesse cose con parole diverse” in lingue diverse, ha detto Yihong Chen, l'autore principale del recente articolo. “Ecco perché nel modello è presente lo stesso ragionamento di alto livello. Una mela è qualcosa di dolce e succoso, non solo una parola”.

Introduzione

Sebbene questo approccio basato sull’oblio fosse un modo efficace per aggiungere una nuova lingua a un modello già addestrato, la riqualificazione era ancora impegnativa: richiedeva molti dati linguistici e potenza di elaborazione. Chen ha suggerito una modifica: invece di eseguire l'addestramento, cancellare il livello di incorporamento e quindi riqualificarlo, dovrebbero reimpostare periodicamente il livello di incorporamento durante il ciclo iniziale di addestramento. "In questo modo, l'intero modello si abitua al ripristino", ha detto Artetxe. "Ciò significa che quando vuoi estendere il modello a un'altra lingua, è più semplice, perché è quello che hai fatto."

I ricercatori hanno preso un modello linguistico comunemente usato chiamato Roberta, lo hanno addestrato utilizzando la loro tecnica dell'oblio periodico e lo hanno confrontato con le prestazioni dello stesso modello quando è stato addestrato con l'approccio standard del non-dimenticamento. Il modello dell’oblio ha avuto risultati leggermente peggiori di quello convenzionale, ricevendo un punteggio di 85.1 rispetto a 86.1 su una misura comune di accuratezza del linguaggio. Quindi hanno riqualificato i modelli su altri linguaggi, utilizzando set di dati molto più piccoli di soli 5 milioni di token, anziché i 70 miliardi utilizzati durante il primo addestramento. L'accuratezza del modello standard è scesa in media a 53.3, ma il modello dell'oblio è scesa solo a 62.7.

Il modello dell’oblio funzionava molto meglio anche se il team imponeva limiti computazionali durante la riqualificazione. Quando i ricercatori hanno ridotto la durata dell’allenamento da 125,000 a soli 5,000, la precisione del modello dell’oblio è scesa in media a 57.8, mentre il modello standard è crollato a 37.2, che non è migliore delle ipotesi casuali.

Introduzione

Il team ha concluso che l’oblio periodico sembra rendere il modello più efficace nell’apprendimento delle lingue in generale. "Poiché [loro] continuano a dimenticare e a reimparare durante la formazione, insegnare alla rete qualcosa di nuovo in seguito diventa più facile", ha detto Eugenio Nikishin, ricercatore presso Mila, un centro di ricerca sul deep learning in Quebec. Ciò suggerisce che quando i modelli linguistici comprendono una lingua, lo fanno a un livello più profondo rispetto al semplice significato delle singole parole.

L’approccio è simile a come funziona il nostro cervello. “La memoria umana in generale non è molto brava a memorizzare con precisione grandi quantità di informazioni dettagliate. Invece, gli esseri umani tendono a ricordare l’essenza delle nostre esperienze, astraendo ed estrapolando”, ha detto Beniamino Levi, neuroscienziato dell'Università di San Francisco. “Abilitare l’intelligenza artificiale con processi più simili a quelli umani, come l’oblio adattivo, è un modo per ottenere prestazioni più flessibili”.

Oltre a ciò che potrebbe dire su come funziona la comprensione, Artetxe spera che modelli linguistici più flessibili possano anche aiutare a portare le ultime scoperte dell’intelligenza artificiale a più lingue. Sebbene i modelli di intelligenza artificiale siano bravi a gestire lo spagnolo e l'inglese, due lingue con ampi materiali di formazione, i modelli non sono altrettanto bravi con il basco nativo, la lingua locale specifica della Spagna nordorientale. "La maggior parte dei modelli delle grandi aziende tecnologiche non lo fanno bene", ha detto. “La strada da percorrere è adattare i modelli esistenti al basco”.

Chen attende anche con ansia un mondo in cui sbocciano più fiori di intelligenza artificiale. “Sto pensando a una situazione in cui il mondo non abbia bisogno di un unico grande modello linguistico. Ne abbiamo così tanti", ha detto. “Se esiste una fabbrica che produce modelli linguistici, è necessario questo tipo di tecnologia. Ha un modello base che può adattarsi rapidamente a nuovi domini”.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/