Questo post è stato scritto in collaborazione con Sherwin Chu di Alida.

Alida aiuta i marchi più grandi del mondo a creare comunità di ricerca altamente coinvolte per raccogliere feedback che alimentano una migliore esperienza dei clienti e l'innovazione dei prodotti.

I clienti di Alida ricevono decine di migliaia di risposte coinvolte per un singolo sondaggio, pertanto il team di Alida ha scelto di sfruttare il machine learning (ML) per servire i propri clienti su larga scala. Tuttavia, quando hanno utilizzato i tradizionali modelli di elaborazione del linguaggio naturale (NLP), hanno scoperto che queste soluzioni faticavano a comprendere appieno il feedback sfumato riscontrato nelle risposte ai sondaggi a risposta aperta. I modelli spesso catturavano solo argomenti e sentiment a livello superficiale e trascuravano il contesto cruciale che avrebbe consentito approfondimenti più accurati e significativi.

In questo post impariamo come funziona il modello Claude Instant di Anthropic Roccia Amazzonica ha consentito al team di Alida di creare rapidamente un servizio scalabile che determina in modo più accurato l'argomento e il sentiment all'interno delle risposte ai sondaggi complessi. Il nuovo servizio ha ottenuto un miglioramento di 4-6 volte nell'affermazione degli argomenti raggruppando strettamente diverse dozzine di argomenti chiave rispetto a centinaia di parole chiave NLP rumorose.

Amazon Bedrock è un servizio completamente gestito che offre una scelta di Foundation Model (FM) ad alte prestazioni di aziende leader nel settore dell'intelligenza artificiale, come AI21 Labs, Anthropic, Cohere, Meta, Stability AI e Amazon tramite un'unica API, insieme a un'ampia insieme di funzionalità necessarie per creare applicazioni di intelligenza artificiale generativa con sicurezza, privacy e intelligenza artificiale responsabile.

L'utilizzo di Amazon Bedrock ha consentito ad Alida di portare il proprio servizio sul mercato più velocemente che se avesse utilizzato altri provider o fornitori di machine learning (ML).

La sfida

I sondaggi con una combinazione di domande a scelta multipla e a risposta aperta consentono ai ricercatori di mercato di ottenere una visione più olistica acquisendo dati sia quantitativi che qualitativi.

Le domande a scelta multipla sono facili da analizzare su larga scala, ma mancano di sfumature e profondità. L'impostazione delle opzioni di risposta può anche portare a distorcere o innescare le risposte dei partecipanti.

Le domande aperte del sondaggio consentono agli intervistati di fornire contesto e feedback imprevisti. Questi dati qualitativi approfondiscono la comprensione dei ricercatori oltre ciò che le domande a scelta multipla possono catturare da sole. La sfida con il testo in formato libero è che può portare a risposte complesse e sfumate che sono difficili da comprendere appieno per la PNL tradizionale. Per esempio:

“Recentemente ho sperimentato alcune difficoltà della vita ed ero davvero giù e deluso. Quando sono entrato, il personale è stato sempre molto gentile con me. Mi ha aiutato a superare alcuni momenti difficili!”

I metodi tradizionali della PNL identificheranno gli argomenti come “difficoltà”, “deluso”, “personale gentile” e “superare momenti difficili”. Non è in grado di distinguere tra le attuali esperienze di vita negative complessive del rispondente e le specifiche esperienze positive di negozio.

La soluzione esistente di Alida elabora automaticamente grandi volumi di risposte aperte, ma l'azienda desiderava che i clienti acquisissero una migliore comprensione contestuale e un'inferenza di argomento di alto livello.

Roccia Amazzonica

Prima dell'introduzione dei LLM, la via da seguire per Alida per migliorare la soluzione a modello unico esistente era lavorare a stretto contatto con esperti del settore e sviluppare, formare e perfezionare nuovi modelli specificamente per ciascuno dei settori verticali in cui operavano i clienti di Alida. Questo è stato uno sforzo dispendioso in termini di tempo e costi.

Una delle scoperte che rendono gli LLM così potenti è l’uso di meccanismi di attenzione. Gli LLM utilizzano meccanismi di autoattenzione che analizzano le relazioni tra le parole in un dato prompt. Ciò consente ai LLM di gestire meglio l'argomento e il sentimento nell'esempio precedente e presenta una nuova entusiasmante tecnologia che può essere utilizzata per affrontare la sfida.

Con Amazon Bedrock, team e individui possono iniziare immediatamente a utilizzare modelli di base senza doversi preoccupare del provisioning dell'infrastruttura o dell'impostazione e della configurazione di framework ML. Puoi iniziare con i seguenti passaggi:

- Verifica che il tuo utente o ruolo disponga dell'autorizzazione per creare o modificare le risorse Amazon Bedrock. Per i dettagli, vedere Esempi di policy basate sull'identità per Amazon Bedrock

- Accedi a Roccia Amazzonica console.

- Sulla Accesso al modello pagina, rivedi l'EULA e abilita i FM che desideri nel tuo account.

- Inizia a interagire con gli FM tramite i seguenti metodi:

Il gruppo dirigente di Alida era ansioso di essere uno dei primi ad adottare Amazon Bedrock perché ne riconosceva la capacità di aiutare i propri team a portare sul mercato nuove soluzioni generative basate sull'intelligenza artificiale più rapidamente.

Vincy William, Senior Director of Engineering di Alida e a capo del team responsabile della creazione del servizio di analisi degli argomenti e del sentiment, afferma:

“I LLM forniscono un grande salto nell’analisi qualitativa e fanno cose (su una scala che è) umanamente impossibile da fare. Amazon Bedrock rappresenta un punto di svolta, poiché ci consente di sfruttare gli LLM senza alcuna complessità."

Il team di ingegneri ha sperimentato la facilità immediata di iniziare a utilizzare Amazon Bedrock. Potrebbero scegliere tra vari modelli di base e iniziare a concentrarsi su una progettazione tempestiva invece di dedicare tempo al corretto dimensionamento, provisioning, distribuzione e configurazione delle risorse per eseguire i modelli.

Panoramica della soluzione

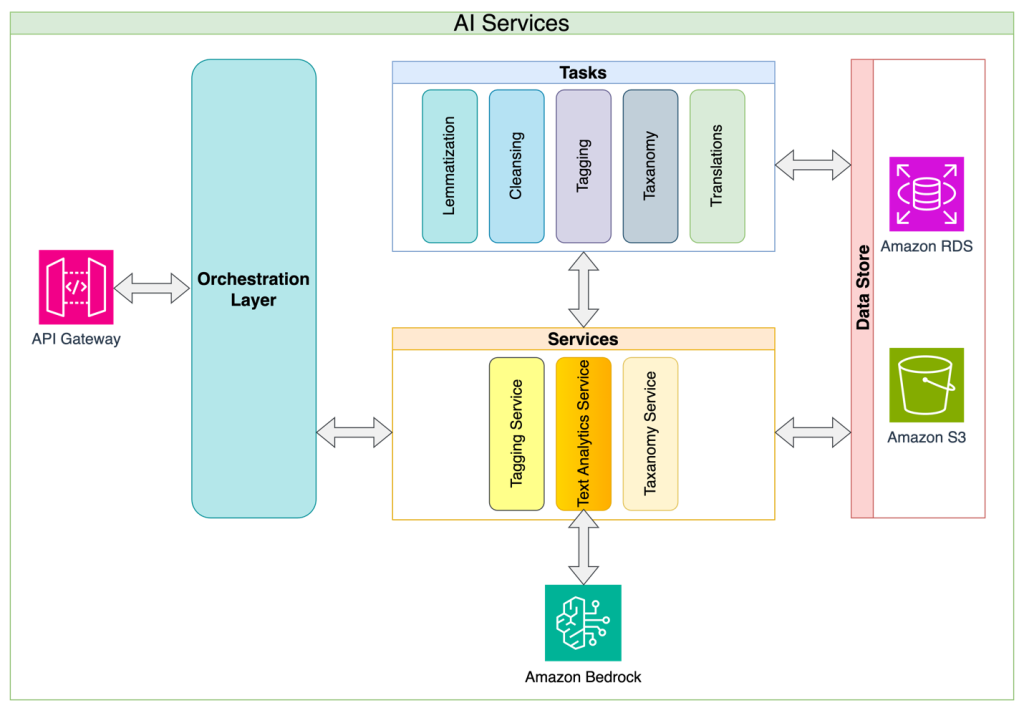

Sherwin Chu, Chief Architect di Alida, ha condiviso l'approccio all'architettura dei microservizi di Alida. Alida ha creato la classificazione di argomenti e sentiment come servizio con l'analisi delle risposte ai sondaggi come prima applicazione. Con questo approccio, le sfide comuni dell'implementazione LLM, come la complessità della gestione dei prompt, dei limiti dei token, dei vincoli delle richieste e dei nuovi tentativi, vengono eliminate e la soluzione consente alle applicazioni che utilizzano di avere un'API semplice e stabile con cui lavorare. Questo approccio a livello di astrazione consente inoltre ai proprietari dei servizi di migliorare continuamente i dettagli di implementazione interna e ridurre al minimo le modifiche dannose per le API. Infine, l’approccio al servizio consente a un unico punto di implementare qualsiasi policy di governance e sicurezza dei dati che si evolve man mano che la governance dell’IA matura nell’organizzazione.

Il diagramma seguente illustra l'architettura e il flusso della soluzione.

Alida ha valutato i LLM di vari fornitori e ha trovato Claude Instant di Anthropic il giusto equilibrio tra costi e prestazioni. Lavorando a stretto contatto con il team di ingegneri tempestivi, Chu ha sostenuto l'implementazione di una strategia di concatenamento rapido invece di un approccio rapido monolitico.

Il concatenamento rapido consente di effettuare le seguenti operazioni:

- Suddividi il tuo obiettivo in passaggi più piccoli e logici

- Crea un prompt per ogni passaggio

- Fornire le istruzioni in sequenza al LLM

Ciò crea ulteriori punti di ispezione, che presentano i seguenti vantaggi:

- È semplice valutare sistematicamente le modifiche apportate al prompt di input

- È possibile implementare un tracciamento e un monitoraggio più dettagliati della precisione e delle prestazioni in ogni passaggio

Le considerazioni chiave di questa strategia includono l'aumento del numero di richieste presentate al LLM e il conseguente aumento del tempo complessivo necessario per completare l'obiettivo. Per il caso d'uso di Alida, hanno scelto di raggruppare una raccolta di risposte aperte in un unico prompt per LLM per compensare questi effetti.

PNL contro LLM

La soluzione NLP esistente di Alida si basa su algoritmi di clustering e classificazione statistica per analizzare le risposte ai sondaggi a risposta aperta. Quando è stato applicato al feedback campione per l'app mobile di un bar, ha estratto argomenti basati su modelli di parole ma mancava di una vera comprensione. La tabella seguente include alcuni esempi di confronto tra le risposte PNL e le risposte LLM.

| Risposta al sondaggio | PNL tradizionale esistente | Amazon Bedrock con Claude Instant | |

| Argomento | Argomento | Sentiment | |

| Ordino quasi esclusivamente i miei drink tramite l'app per comodità ed è meno imbarazzante ordinare bevande super personalizzate lol. E adoro guadagnare premi! | ['app bc convenienza', 'bevanda', 'premio'] | Comodità di ordinazione mobile | positivo |

| L'app funziona abbastanza bene, l'unica lamentela che ho è che non posso aggiungere l'importo che desidero alla mia carta regalo. Perché deve essere specificamente $ 10 per ricaricarlo?! | ['reclamo', 'app', 'buono regalo', 'numero soldi'] | Velocità di evasione degli ordini da dispositivo mobile | negativo. |

I risultati di esempio mostrano come la soluzione esistente sia stata in grado di estrarre parole chiave pertinenti, ma non sia in grado di ottenere un'assegnazione di gruppi di argomenti più generalizzata.

Al contrario, utilizzando Amazon Bedrock e Anthropic Claude Instant, il LLM con formazione in contesto è in grado di assegnare le risposte ad argomenti predefiniti e assegnare sentiment.

Oltre a fornire risposte migliori ai clienti di Alida, per questo particolare caso d'uso, perseguire una soluzione utilizzando un LLM rispetto ai tradizionali metodi di PNL ha consentito di risparmiare una grande quantità di tempo e fatica nella formazione e nel mantenimento di un modello adatto. La tabella seguente mette a confronto la formazione di un modello di PNL tradizionale con la formazione nel contesto di un LLM.

| . | Requisito dei dati | Processo di formazione | Adattabilità del modello |

| Formare un modello di PNL tradizionale | Migliaia di esempi etichettati come esseri umani |

Combinazione di ingegneria delle funzionalità automatizzata e manuale. Cicli di formazione e valutazione iterativi. |

Tempi di consegna più lenti a causa della necessità di riqualificare il modello |

| Formazione in contesto di LLM | Diversi esempi |

Addestrato al volo all'interno del prompt. Limitato dalla dimensione della finestra di contesto. |

Iterazioni più veloci modificando il prompt. Conservazione limitata a causa delle dimensioni della finestra di contesto. |

Conclusione

L'utilizzo da parte di Alida del modello Claude Instant di Anthropic su Amazon Bedrock dimostra le potenti capacità dei LLM per l'analisi delle risposte ai sondaggi a risposta aperta. Alida è stata in grado di creare un servizio superiore che era 4-6 volte più preciso nell'analisi degli argomenti rispetto al servizio basato sulla PNL. Inoltre, l'utilizzo del prompt engineering in contesto per gli LLM ha ridotto significativamente i tempi di sviluppo, poiché non era necessario curare migliaia di punti dati etichettati da persone per addestrare un modello NLP tradizionale. Ciò consente infine ad Alida di fornire ai propri clienti informazioni più approfondite in tempi più brevi!

Se sei pronto per iniziare a creare il tuo modello di innovazione di base con Amazon Bedrock, dai un'occhiata a questo link Configura Amazon Bedrock. Se sei interessato a leggere altre interessanti applicazioni Amazon Bedrock, consulta la sezione specifica di Amazon Bedrock del blog di AWS Machine Learning.

Circa gli autori

Kinman Lam è un Solution Architect ISV/DNB per AWS. Ha 17 anni di esperienza nella creazione e crescita di aziende tecnologiche nei settori smartphone, geolocalizzazione, IoT e software open source. In AWS, utilizza la sua esperienza per aiutare le aziende a costruire infrastrutture solide per soddisfare le crescenti richieste delle aziende in crescita, lanciare nuovi prodotti e servizi, entrare in nuovi mercati e soddisfare i propri clienti.

Kinman Lam è un Solution Architect ISV/DNB per AWS. Ha 17 anni di esperienza nella creazione e crescita di aziende tecnologiche nei settori smartphone, geolocalizzazione, IoT e software open source. In AWS, utilizza la sua esperienza per aiutare le aziende a costruire infrastrutture solide per soddisfare le crescenti richieste delle aziende in crescita, lanciare nuovi prodotti e servizi, entrare in nuovi mercati e soddisfare i propri clienti.

Sherwin Chu è Chief Architect presso Alida e aiuta i team di prodotto nella direzione architettonica, nella scelta della tecnologia e nella risoluzione di problemi complessi. È un esperto ingegnere informatico, architetto e leader con oltre 20 anni nel settore SaaS per vari settori. Ha realizzato e gestito numerosi sistemi B2B e B2C su AWS e GCP.

Sherwin Chu è Chief Architect presso Alida e aiuta i team di prodotto nella direzione architettonica, nella scelta della tecnologia e nella risoluzione di problemi complessi. È un esperto ingegnere informatico, architetto e leader con oltre 20 anni nel settore SaaS per vari settori. Ha realizzato e gestito numerosi sistemi B2B e B2C su AWS e GCP.

Marco Roy è Principal Machine Learning Architect per AWS e aiuta i clienti a progettare e realizzare soluzioni AI/ML e IA generativa. Dall'inizio del 2023 il suo focus è stato guidare le iniziative di architettura delle soluzioni per il lancio di Amazon Bedrock, l'offerta di intelligenza artificiale generativa di punta di AWS per i costruttori. Il lavoro di Mark copre un'ampia gamma di casi d'uso, con un interesse primario per l'intelligenza artificiale generativa, gli agenti e la scalabilità del machine learning in tutta l'azienda. Ha aiutato aziende nei settori assicurativo, dei servizi finanziari, dei media e dell'intrattenimento, della sanità, dei servizi pubblici e dell'industria manifatturiera. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 anni nei servizi finanziari. Mark possiede sei certificazioni AWS, inclusa la certificazione ML Specialty.

Marco Roy è Principal Machine Learning Architect per AWS e aiuta i clienti a progettare e realizzare soluzioni AI/ML e IA generativa. Dall'inizio del 2023 il suo focus è stato guidare le iniziative di architettura delle soluzioni per il lancio di Amazon Bedrock, l'offerta di intelligenza artificiale generativa di punta di AWS per i costruttori. Il lavoro di Mark copre un'ampia gamma di casi d'uso, con un interesse primario per l'intelligenza artificiale generativa, gli agenti e la scalabilità del machine learning in tutta l'azienda. Ha aiutato aziende nei settori assicurativo, dei servizi finanziari, dei media e dell'intrattenimento, della sanità, dei servizi pubblici e dell'industria manifatturiera. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 anni nei servizi finanziari. Mark possiede sei certificazioni AWS, inclusa la certificazione ML Specialty.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/alida-gains-deeper-understanding-of-customer-feedback-with-amazon-bedrock/