परिचय

हाल के वर्षों में, कृत्रिम बुद्धिमत्ता (एआई) के क्षेत्र में जेनेरिक एआई मॉडल के विकास में उल्लेखनीय वृद्धि देखी गई है। ये मॉडल कर सकते हैं मानव जैसा पाठ उत्पन्न करें, छवियां, और यहां तक कि ऑडियो भी, उस चीज़ की सीमाओं को तोड़ रहा है जिसे कभी असंभव माना जाता था। इन मॉडलों में, जेनेरेटिव प्री-ट्रेंड ट्रांसफार्मर (जीपीटी) प्राकृतिक भाषा प्रसंस्करण (एनएलपी) में अग्रणी सफलता के रूप में सामने आता है। आइए जीपीटी की जटिल वास्तुकला का पता लगाएं और जानें कि वे जेनरेटिव एआई और एनएलपी कार्यों को आसानी से कैसे संभालते हैं।

विषय - सूची

जनरेटिव एआई मॉडल का उदय

जेनरेटिव एआई मॉडल का एक वर्ग है यंत्र अधिगम ऐसे मॉडल जो स्क्रैच से नया डेटा, जैसे टेक्स्ट, चित्र या ऑडियो बना सकते हैं। इन मॉडलों को बड़ी मात्रा में मौजूदा डेटा पर प्रशिक्षित किया जाता है, जिससे उन्हें अंतर्निहित पैटर्न और संरचनाओं को सीखने की अनुमति मिलती है। एक बार प्रशिक्षित होने के बाद, वे नई, मूल सामग्री तैयार कर सकते हैं जो प्रशिक्षण डेटा की विशेषताओं की नकल करती है।

जेनेरिक एआई मॉडल के उदय को गहन शिक्षण तकनीकों, विशेष रूप से तंत्रिका नेटवर्क में प्रगति से बढ़ावा मिला है। ध्यान लगा के पढ़ना या सीखना एल्गोरिदम डेटा में जटिल पैटर्न को कैप्चर करने में उल्लेखनीय रूप से प्रभावी साबित हुए हैं, जिससे वे जेनरेटिव कार्यों के लिए उपयुक्त बन गए हैं। जैसे-जैसे कम्प्यूटेशनल शक्ति और बड़े डेटासेट तक पहुंच बढ़ी है, शोधकर्ता तेजी से परिष्कृत जेनरेटर मॉडल को प्रशिक्षित करने में सक्षम हो गए हैं।

जीपीटी के रहस्य

जीपीटी मॉडल एक प्रकार का बड़ा भाषा मॉडल (एलएलएम) है जो की शक्ति का लाभ उठाता है तंत्रिका जाल मानव-समान पाठ को समझने और उत्पन्न करने के लिए। ये मॉडल "जनरेटिव" हैं क्योंकि वे बड़े पैमाने पर डेटासेट से सीखे गए पैटर्न के आधार पर नए, सुसंगत पाठ का उत्पादन कर सकते हैं। वे "पूर्व-प्रशिक्षित" होते हैं क्योंकि वे बड़ी मात्रा में टेक्स्ट डेटा पर प्रारंभिक प्रशिक्षण चरण से गुजरते हैं। यह उन्हें विशिष्ट कार्यों के लिए तैयार होने से पहले एक व्यापक ज्ञान आधार प्राप्त करने की अनुमति देता है।

"ट्रांसफार्मर" आर्किटेक्चर मुख्य नवाचार है जिसने जीपीटी मॉडल को प्रदर्शन के अभूतपूर्व स्तर तक पहुंचाया है। ट्रान्सफ़ॉर्मर एक प्रकार का तंत्रिका नेटवर्क है जिसे पाठ जैसे अनुक्रमिक डेटा को पारंपरिक मॉडल की तुलना में अधिक प्रभावी ढंग से संभालने के लिए डिज़ाइन किया गया है। वे एक नवीन ध्यान तंत्र का उपयोग करते हैं जो मॉडल को आउटपुट उत्पन्न करते समय इनपुट के विभिन्न हिस्सों के महत्व को मापने की अनुमति देता है। यह इसे लंबी दूरी की निर्भरता को पकड़ने और अधिक सुसंगत और प्रासंगिक रूप से प्रासंगिक पाठ तैयार करने में सक्षम बनाता है।

जीपीटी आर्किटेक्चर का विच्छेदन

जीपीटी आर्किटेक्चर तीन प्रमुख घटकों का एक शक्तिशाली संयोजन है: इसकी उत्पादक क्षमताएं, पूर्व-प्रशिक्षण दृष्टिकोण और ट्रांसफार्मर तंत्रिका नेटवर्क। इनमें से प्रत्येक स्तंभ जीपीटी मॉडल को एनएलपी कार्यों में उनके उल्लेखनीय प्रदर्शन को प्राप्त करने में सक्षम बनाने में महत्वपूर्ण भूमिका निभाता है।

तीन स्तंभ: उत्पादक, पूर्व-प्रशिक्षित और ट्रांसफार्मर

जीपीटी मॉडल का "जनरेटिव" पहलू विशाल मात्रा में प्रशिक्षण डेटा से सीखे गए पैटर्न के आधार पर नए, सुसंगत पाठ उत्पन्न करने की उनकी क्षमता को संदर्भित करता है। पारंपरिक भाषा मॉडल मुख्य रूप से पाठ को समझने और उसका विश्लेषण करने पर ध्यान केंद्रित करते हैं। उनके विपरीत, जीपीटी मॉडल मानव-जैसे टेक्स्ट आउटपुट उत्पन्न करने के लिए डिज़ाइन किए गए हैं, जो उन्हें विभिन्न अनुप्रयोगों के लिए अत्यधिक बहुमुखी बनाते हैं।

जीपीटी मॉडल के "पूर्व-प्रशिक्षित" घटक में एक प्रारंभिक प्रशिक्षण चरण शामिल होता है जहां मॉडल को टेक्स्ट डेटा के विशाल संग्रह के संपर्क में लाया जाता है। इस पूर्व-प्रशिक्षण चरण के दौरान, मॉडल डेटा के भीतर अंतर्निहित पैटर्न, संरचनाओं और संबंधों को पकड़ना सीखता है। इससे उसे प्रभावी ढंग से व्यापक ज्ञान आधार बनाने में मदद मिलती है। पूर्व-प्रशिक्षण चरण महत्वपूर्ण है क्योंकि यह मॉडल को ठीक होने से पहले भाषा की सामान्य समझ हासिल करने की अनुमति देता है।

"ट्रांसफार्मर" आर्किटेक्चर जीपीटी मॉडल की तंत्रिका नेटवर्क रीढ़ है। ट्रांसफॉर्मर गहन शिक्षण मॉडल हैं जो विशेष रूप से पारंपरिक मॉडल की तुलना में पाठ जैसे अनुक्रमिक डेटा को अधिक प्रभावी ढंग से संभालने के लिए डिज़ाइन किए गए हैं। वे एक नवीन ध्यान तंत्र का उपयोग करते हैं जो मॉडल को आउटपुट उत्पन्न करते समय इनपुट के विभिन्न हिस्सों के महत्व को मापने की अनुमति देता है। यह इसे लंबी दूरी की निर्भरता को पकड़ने और अधिक सुसंगत और प्रासंगिक रूप से प्रासंगिक पाठ तैयार करने में सक्षम बनाता है।

जीपीटी कैसे सुसंगत वाक्य बनाते हैं

जीपीटी मॉडल पिछले शब्दों या टोकन द्वारा प्रदान किए गए संदर्भ के आधार पर अनुक्रम में अगले शब्द या टोकन की भविष्यवाणी करके पाठ उत्पन्न करते हैं। यह प्रक्रिया ट्रांसफार्मर आर्किटेक्चर के भीतर गणनाओं की एक श्रृंखला के माध्यम से प्राप्त की जाती है। इसकी शुरुआत इनपुट टेक्स्ट को टोकनाइज़ करने और उसे संख्यात्मक अभ्यावेदन (एम्बेडिंग) में बदलने से होती है। फिर ये एंबेडिंग्स ट्रांसफार्मर की कई परतों से होकर गुजरती हैं। यहां, ध्यान तंत्र मॉडल को इनपुट के विभिन्न हिस्सों के बीच संबंधों को पकड़ने और प्रासंगिक रूप से प्रासंगिक आउटपुट उत्पन्न करने की अनुमति देता है।

मॉडल का आउटपुट है a संभावना वितरण संपूर्ण शब्दावली पर, प्रत्येक शब्द या टोकन के अनुक्रम में अगला होने की संभावना को दर्शाता है। अनुमान के दौरान, मॉडल अगले टोकन उत्पन्न करने के लिए इस वितरण से नमूने लेता है, जिसे इनपुट अनुक्रम में जोड़ा जाता है। यह प्रक्रिया तब तक दोहराई जाती है जब तक वांछित आउटपुट लंबाई तक नहीं पहुंच जाती या रुकने की स्थिति पूरी नहीं हो जाती।

बेहतर प्रदर्शन के लिए विशाल डेटासेट का लाभ उठाना

जीपीटी मॉडल के प्रमुख लाभों में से एक पूर्व-प्रशिक्षण चरण के दौरान बड़े पैमाने पर डेटासेट का लाभ उठाने की उनकी क्षमता है। इन डेटासेट में पुस्तकों, लेखों, वेबसाइटों और सोशल मीडिया जैसे विभिन्न स्रोतों से अरबों शब्द शामिल हो सकते हैं। यह मॉडल को प्राकृतिक भाषा का विविध और व्यापक अनुभव प्रदान करता है।

पूर्व-प्रशिक्षण के दौरान, मॉडल को टेक्स्ट-जनरेशन प्रक्रिया के समान, अनुक्रम में अगले शब्द या टोकन की भविष्यवाणी करनी होती है। हालाँकि, नया पाठ उत्पन्न करने के बजाय, मॉडल प्रशिक्षण डेटा के भीतर अंतर्निहित पैटर्न और संबंधों को पकड़ना सीखता है। यह पूर्व-प्रशिक्षण चरण कम्प्यूटेशनल रूप से गहन लेकिन महत्वपूर्ण है। यह मॉडल को भाषा की व्यापक समझ विकसित करने की अनुमति देता है, जिसे बाद में विशिष्ट कार्यों के लिए ठीक किया जा सकता है।

पूर्व-प्रशिक्षण के दौरान बड़े पैमाने पर डेटासेट का लाभ उठाकर, जीपीटी मॉडल एक विशाल ज्ञान आधार प्राप्त कर सकते हैं। वे भाषा संरचनाओं, मुहावरेदार अभिव्यक्तियों और प्रासंगिक बारीकियों की गहरी समझ भी विकसित कर सकते हैं। यह व्यापक पूर्व-प्रशिक्षण मॉडल के लिए एक मजबूत आधार प्रदान करता है। यह मॉडल को अपेक्षाकृत कम कार्य-विशिष्ट फ़ाइन-ट्यूनिंग के साथ डाउनस्ट्रीम कार्यों की एक विस्तृत श्रृंखला पर अच्छा प्रदर्शन करने में सक्षम बनाता है।

जादू के पीछे तंत्रिका नेटवर्क

ट्रांसफॉर्मर आर्किटेक्चर मुख्य नवाचार है जो जीपीटी मॉडल को शक्ति प्रदान करता है और इसने एनएलपी के क्षेत्र में क्रांति ला दी है। पारंपरिक के विपरीत आवर्तक तंत्रिका नेटवर्क (आरएनएन), जो क्रमिक रूप से अनुक्रमिक डेटा को संसाधित करते हैं, ट्रांसफार्मर एक उपन्यास ध्यान तंत्र को नियोजित करते हैं जो उन्हें लंबी दूरी की निर्भरता को पकड़ने और समानांतर में इनपुट अनुक्रमों को कुशलतापूर्वक संसाधित करने की अनुमति देता है।

ट्रांसफॉर्मर आर्किटेक्चर में कई परतें होती हैं, जिनमें से प्रत्येक में दो मुख्य घटक होते हैं: मल्टी-हेड अटेंशन मैकेनिज्म और फीड-फॉरवर्ड न्यूरल नेटवर्क। ध्यान तंत्र आउटपुट उत्पन्न करते समय इनपुट अनुक्रम के विभिन्न हिस्सों के महत्व को महत्व देने के लिए जिम्मेदार है, जो मॉडल को अनुक्रम में दूर के तत्वों के बीच संदर्भ और संबंधों को पकड़ने में सक्षम बनाता है।

फ़ीड-फ़ॉरवर्ड न्यूरल नेटवर्क परतें ध्यान तंत्र के आउटपुट को आगे संसाधित करने और परिष्कृत करने के लिए ज़िम्मेदार हैं, जिससे मॉडल को इनपुट डेटा के अधिक जटिल प्रतिनिधित्व सीखने की अनुमति मिलती है।

ट्रांसफॉर्मर आर्किटेक्चर की समानांतर प्रसंस्करण और ध्यान तंत्र लंबे अनुक्रमों को संभालने और लंबी दूरी की निर्भरता को पकड़ने में अत्यधिक प्रभावी साबित हुई है, जो एनएलपी कार्यों के लिए महत्वपूर्ण हैं। इस आर्किटेक्चर ने GPT मॉडल को अत्याधुनिक प्रदर्शन प्राप्त करने में सक्षम बनाया है। इसने कंप्यूटर विज़न और वाक् पहचान जैसे विभिन्न डोमेन में अन्य ट्रांसफार्मर-आधारित मॉडल के विकास को भी प्रभावित किया है।

ट्रांसफार्मर के अंदर

ट्रांसफार्मर आर्किटेक्चर मुख्य घटक है जो जीपीटी मॉडल को एनएलपी कार्यों में उनके उल्लेखनीय प्रदर्शन को प्राप्त करने में सक्षम बनाता है। आइए ट्रांसफॉर्मर द्वारा टेक्स्ट डेटा के प्रसंस्करण में शामिल प्रमुख चरणों पर करीब से नज़र डालें।

टोकनाइजेशन: पाठ को सुपाच्य टुकड़ों में तोड़ना

इससे पहले कि ट्रांसफार्मर पाठ को संसाधित कर सके, इनपुट डेटा को छोटी इकाइयों में विभाजित करने की आवश्यकता होती है जिन्हें टोकन कहा जाता है। tokenization पाठ को इन टोकन में विभाजित करने की प्रक्रिया है, जो शब्द, उपशब्द या यहां तक कि व्यक्तिगत वर्ण भी हो सकते हैं। यह कदम महत्वपूर्ण है क्योंकि यह ट्रांसफार्मर को अलग-अलग लंबाई के अनुक्रमों को संभालने और दुर्लभ या शब्दावली से बाहर के शब्दों को प्रभावी ढंग से प्रस्तुत करने की अनुमति देता है। टोकनाइजेशन प्रक्रिया में आम तौर पर शब्द विभाजन, विराम चिह्न को संभालना और विशेष वर्णों से निपटने जैसी तकनीकें शामिल होती हैं।

शब्द एंबेडिंग्स: शब्दों को संख्यात्मक वेक्टर में मैप करना

एक बार जब पाठ को टोकन कर दिया जाता है, तो प्रत्येक टोकन को संख्यात्मक वेक्टर प्रतिनिधित्व में मैप किया जाता है जिसे शब्द एम्बेडिंग कहा जाता है। ये शब्द एम्बेडिंग घने वैक्टर हैं जो उन शब्दों के बारे में अर्थपूर्ण और वाक्यात्मक जानकारी प्राप्त करते हैं जिनका वे प्रतिनिधित्व करते हैं। ट्रांसफार्मर इन एम्बेडिंग को इनपुट के रूप में उपयोग करता है, जिससे यह टेक्स्ट डेटा को संख्यात्मक प्रारूप में संसाधित करने की अनुमति देता है जिसे इसके तंत्रिका नेटवर्क आर्किटेक्चर द्वारा कुशलतापूर्वक हेरफेर किया जा सकता है। शब्द एम्बेडिंग को प्रशिक्षण प्रक्रिया के दौरान सीखा जाता है, जहां समान अर्थ वाले शब्दों में समान वेक्टर प्रतिनिधित्व होते हैं, जो मॉडल को अर्थपूर्ण संबंधों और संदर्भ को पकड़ने में सक्षम बनाता है।

ध्यान तंत्र: ट्रांसफार्मर का हृदय

ध्यान तंत्र प्रमुख नवाचार है जो ट्रांसफार्मर को पारंपरिक तंत्रिका नेटवर्क आर्किटेक्चर से अलग करता है। यह मॉडल को आउटपुट उत्पन्न करते समय इनपुट अनुक्रम के प्रासंगिक भागों पर चुनिंदा रूप से ध्यान केंद्रित करने, लंबी दूरी की निर्भरता और संदर्भ को प्रभावी ढंग से कैप्चर करने की अनुमति देता है। ध्यान तंत्र ध्यान स्कोर की गणना करके काम करता है जो किसी दिए गए आउटपुट तत्व के लिए प्रत्येक इनपुट तत्व के महत्व को दर्शाता है, और फिर इन स्कोर का उपयोग संबंधित इनपुट प्रतिनिधित्व को वजन देने के लिए करता है। यह तंत्र ट्रांसफार्मर को अलग-अलग लंबाई के अनुक्रमों को प्रभावी ढंग से संसाधित करने और इनपुट में दूर के तत्वों के बीच संबंधों को पकड़ने में सक्षम बनाता है, जो मशीन अनुवाद और भाषा निर्माण जैसे कार्यों के लिए महत्वपूर्ण है।

मल्टी-लेयर परसेप्ट्रॉन: वेक्टर प्रतिनिधित्व को बढ़ाना

ध्यान तंत्र के अलावा, ट्रांसफार्मर भी शामिल हैं मल्टी-लेयर परसेप्ट्रॉन (एमएलपी), जो फ़ीड-फ़ॉरवर्ड न्यूरल नेटवर्क हैं। इन एमएलपी का उपयोग ध्यान तंत्र द्वारा उत्पादित वेक्टर अभ्यावेदन को आगे बढ़ाने और परिष्कृत करने के लिए किया जाता है, जिससे मॉडल को डेटा में अधिक जटिल पैटर्न और संबंधों को पकड़ने की अनुमति मिलती है। एमएलपी ध्यान तंत्र के आउटपुट को इनपुट के रूप में लेते हैं और वेक्टर प्रतिनिधित्व को बढ़ाने के लिए रैखिक परिवर्तनों और गैर-रेखीय सक्रियण कार्यों की एक श्रृंखला लागू करते हैं। यह कदम मॉडल के लिए उच्च-स्तरीय सुविधाओं और अभ्यावेदन को सीखने के लिए महत्वपूर्ण है जो डाउनस्ट्रीम कार्य के लिए सहायक हैं।

जीपीटी मॉडल का प्रशिक्षण

जीपीटी मॉडल का प्रशिक्षण एक जटिल और कम्प्यूटेशनल रूप से गहन प्रक्रिया है जिसमें कई प्रमुख घटक और तकनीकें शामिल हैं।

बैकप्रॉपैगेशन: एल्गोरिदम जो जीपीटी को अधिक स्मार्ट बनाता है

जीपीटी मॉडल के प्रशिक्षण के मूल में बैकप्रॉपैगेशन एल्गोरिदम है, जो प्रशिक्षण के दौरान होने वाली त्रुटियों के आधार पर मॉडल के वजन और मापदंडों को अपडेट करने के लिए गहन शिक्षण में व्यापक रूप से उपयोग की जाने वाली तकनीक है। दौरान बैकप्रोगैगेशन, मॉडल की भविष्यवाणियों की तुलना जमीनी सच्चाई लेबल से की जाती है, और वजन को समायोजित करने और समग्र त्रुटि को कम करने के लिए त्रुटियों को नेटवर्क के माध्यम से पीछे की ओर प्रचारित किया जाता है। इस प्रक्रिया में मॉडल के मापदंडों के संबंध में हानि फ़ंक्शन के ग्रेडिएंट की गणना करना और मापदंडों को उस दिशा में अपडेट करना शामिल है जो नुकसान को कम करता है। बैकप्रॉपैगेशन प्रशिक्षण प्रक्रिया का एक अनिवार्य घटक है, क्योंकि यह मॉडल को अपनी गलतियों से सीखने और धीरे-धीरे अपने प्रदर्शन में सुधार करने की अनुमति देता है।

सुपरवाइज्ड फाइन-ट्यूनिंग

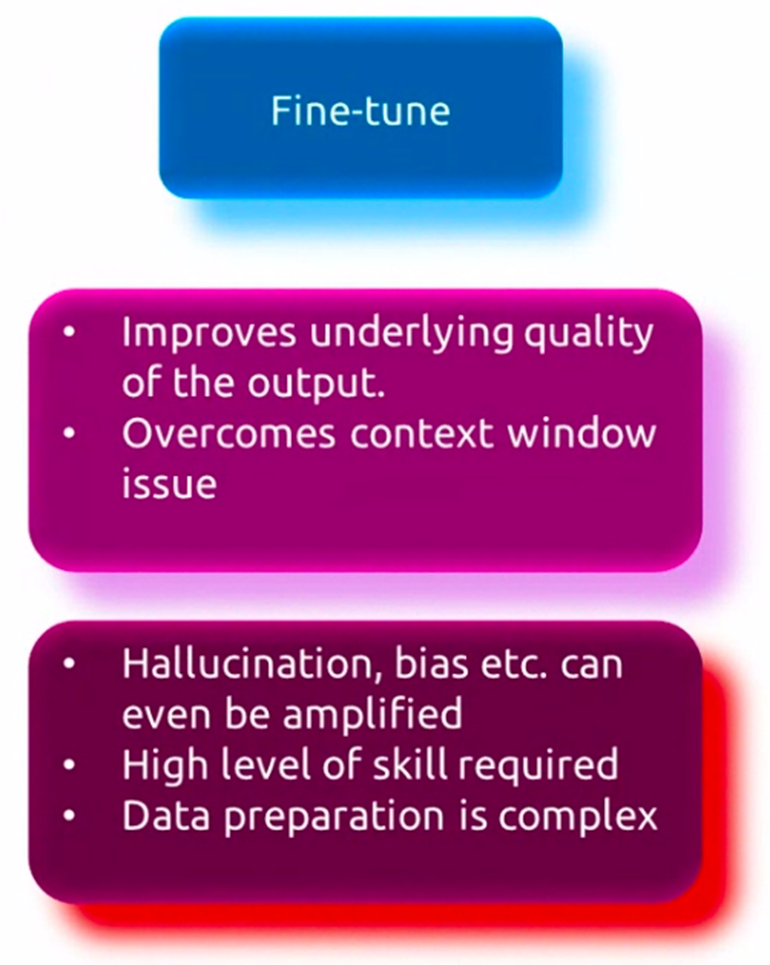

जबकि GPT मॉडल को भाषा की व्यापक समझ हासिल करने के लिए बड़े पैमाने पर डेटासेट पर पूर्व-प्रशिक्षित किया जाता है, विशिष्ट अनुप्रयोगों पर अच्छा प्रदर्शन करने के लिए उन्हें अक्सर कार्य-विशिष्ट डेटा पर ठीक करने की आवश्यकता होती है। इस प्रक्रिया को, जिसे पर्यवेक्षित फाइन-ट्यूनिंग के रूप में जाना जाता है, इसमें छोटे डेटासेट पर पूर्व-प्रशिक्षित मॉडल को आगे प्रशिक्षित करना शामिल है जो लक्ष्य कार्य के लिए प्रासंगिक है, जैसे कि प्रश्न उत्तर देना, पाठ सारांश या मशीन अनुवाद। दौरान फ़ाइन ट्यूनिंग, पूर्व-प्रशिक्षण के दौरान प्राप्त सामान्य भाषा ज्ञान को बरकरार रखते हुए, कार्य के लिए विशिष्ट पैटर्न और बारीकियों को बेहतर ढंग से पकड़ने के लिए मॉडल के वजन को समायोजित किया जाता है। यह फाइन-ट्यूनिंग प्रक्रिया मॉडल को लक्ष्य कार्य की विशिष्ट आवश्यकताओं के लिए विशेषज्ञता और अनुकूलन करने की अनुमति देती है, जिसके परिणामस्वरूप प्रदर्शन में सुधार होता है।

बिना पर्यवेक्षित पूर्व प्रशिक्षण

फाइन-ट्यूनिंग से पहले, जीपीटी मॉडल एक प्रारंभिक अप्रकाशित पूर्व-प्रशिक्षण चरण से गुजरते हैं, जहां उन्हें पुस्तकों, लेखों और वेबसाइटों जैसे विभिन्न स्रोतों से बड़ी मात्रा में टेक्स्ट डेटा के संपर्क में लाया जाता है। इस चरण के दौरान, मॉडल अनुक्रम में अगले शब्द या टोकन की भविष्यवाणी करके डेटा में अंतर्निहित पैटर्न और संबंधों को पकड़ना सीखता है, इस प्रक्रिया को भाषा मॉडलिंग के रूप में जाना जाता है। यह अप्रशिक्षित पूर्व-प्रशिक्षण मॉडल को वाक्यविन्यास, शब्दार्थ और संदर्भ सहित भाषा की व्यापक समझ विकसित करने की अनुमति देता है। मॉडल को टेक्स्ट डेटा के विशाल संग्रह पर प्रशिक्षित किया गया है, जो इसे विभिन्न प्रकार के विषयों, शैलियों और डोमेन से सीखने में सक्षम बनाता है। यह अपर्यवेक्षित पूर्व-प्रशिक्षण चरण कम्प्यूटेशनल रूप से गहन लेकिन महत्वपूर्ण है, क्योंकि यह मॉडल को विशिष्ट कार्यों पर बाद के फाइन-ट्यूनिंग के लिए एक मजबूत आधार प्रदान करता है।

जीपीटी अनुप्रयोग और उपयोग के मामले

जीपीटी मॉडल ने उल्लेखनीय बहुमुखी प्रतिभा दिखाई है और इसे एनएलपी कार्यों और अनुप्रयोगों की एक विस्तृत श्रृंखला में लागू किया गया है। आइए इन शक्तिशाली भाषा मॉडलों के कुछ प्रमुख उपयोग मामलों का पता लगाएं।

भाषा बाधाओं को तोड़ना

GPT मॉडल का सबसे पहला और सबसे प्रमुख अनुप्रयोग मशीनी अनुवाद के क्षेत्र में है। मानव-जैसे पाठ को समझने और उत्पन्न करने की उनकी क्षमता का लाभ उठाकर, जीपीटी मॉडल को उच्च सटीकता और प्रवाह के साथ विभिन्न भाषाओं के बीच अनुवाद करने के लिए प्रशिक्षित किया जा सकता है। ये मॉडल भाषा की बारीकियों और जटिलताओं को पकड़ सकते हैं, जिससे वे ऐसे अनुवाद तैयार करने में सक्षम होते हैं जो न केवल सटीक होते हैं बल्कि मूल पाठ के इच्छित अर्थ और संदर्भ को भी बनाए रखते हैं।

पाठ का सारांश

उपलब्ध पाठ्य डेटा की लगातार बढ़ती मात्रा के साथ, करने की क्षमता संक्षेप में प्रस्तुत करना संक्षिप्त और सार्थक सारांश में लंबे दस्तावेज़ या लेख तेजी से महत्वपूर्ण हो गए हैं। जीपीटी मॉडल इस कार्य में प्रभावी साबित हुए हैं, क्योंकि वे किसी दिए गए पाठ के संदर्भ और मुख्य बिंदुओं का विश्लेषण और समझ सकते हैं, और फिर एक संक्षिप्त सारांश उत्पन्न कर सकते हैं जो मूल सामग्री के सार को पकड़ लेता है। इस एप्लिकेशन के पास कई उपयोग के मामले हैं, जिनमें समाचार लेखों और शोध पत्रों को सारांशित करने से लेकर संक्षिप्त रिपोर्ट और कार्यकारी सारांश तैयार करना शामिल है।

चैटबॉट्स और कन्वर्सेशनल एआई

जीपीटी मॉडल के सबसे दृश्यमान और व्यापक रूप से अपनाए गए अनुप्रयोगों में से एक चैटबॉट्स का विकास है संवादी ऐ सिस्टम. ये मॉडल मानव-जैसे संवाद में संलग्न हो सकते हैं, उपयोगकर्ता के प्रश्नों और इनपुट को प्राकृतिक और प्रासंगिक रूप से उचित तरीके से समझ और जवाब दे सकते हैं। उपयोगकर्ताओं को व्यक्तिगत और कुशल सहायता प्रदान करने के लिए ग्राहक सेवा, ई-कॉमर्स और स्वास्थ्य सेवा जैसे विभिन्न उद्योगों में जीपीटी-संचालित चैटबॉट का उपयोग किया जा रहा है।

जीपीटी की कल्पनाशील क्षमता

जबकि जीपीटी मॉडल शुरू में भाषा समझ और पीढ़ी के कार्यों के लिए डिज़ाइन किए गए थे, सुसंगत और कल्पनाशील पाठ तैयार करने की उनकी क्षमता ने रचनात्मक लेखन के क्षेत्र में नई संभावनाएं खोल दी हैं। इन मॉडलों को कहानियां, कविताएं, स्क्रिप्ट और यहां तक कि गाने के बोल तैयार करने के लिए ठीक किया जा सकता है, जो लेखकों और कलाकारों को नए रचनात्मक रास्ते तलाशने के लिए एक शक्तिशाली उपकरण प्रदान करता है। इसके अतिरिक्त, जीपीटी मॉडल कथानक के विकास और चरित्र विवरण का सुझाव देकर और यहां तक कि संकेतों या रूपरेखाओं के आधार पर संपूर्ण मार्ग तैयार करके लेखन प्रक्रिया में सहायता कर सकते हैं।

जीपीटी और जेनरेटिव एआई का भविष्य

जीपीटी मॉडल जितने आशाजनक रहे हैं, अभी भी सीमाएँ और चुनौतियाँ हैं जिन पर काबू पाना है, साथ ही नैतिक विचारों का भी समाधान करना है। इसके अतिरिक्त, जेनेरिक एआई का क्षेत्र तेजी से विकसित हो रहा है, नए रुझान और अत्याधुनिक शोध इन मॉडलों के भविष्य को आकार दे रहे हैं।

वर्तमान GPT मॉडल की सीमाएँ और चुनौतियाँ

अपनी प्रभावशाली क्षमताओं के बावजूद, वर्तमान GPT मॉडल की कुछ सीमाएँ हैं। मुख्य चुनौतियों में से एक उनके द्वारा उत्पन्न पाठ के अंतर्निहित अर्थ और संदर्भ को सही मायने में समझने में असमर्थता है। हालाँकि वे सुसंगत और धाराप्रवाह पाठ तैयार कर सकते हैं, लेकिन कभी-कभी वे निरर्थक या तथ्यात्मक रूप से गलत जानकारी उत्पन्न कर सकते हैं, खासकर जटिल या विशेष विषयों से निपटते समय। इसके अतिरिक्त, ये मॉडल अपने प्रशिक्षण डेटा में मौजूद पूर्वाग्रहों को प्रदर्शित कर सकते हैं, जिससे निष्पक्षता और संभावित रूप से हानिकारक आउटपुट के बारे में चिंताएं बढ़ सकती हैं।

नैतिक विचार और जिम्मेदार एआई विकास

जैसे-जैसे जीपीटी मॉडल अधिक शक्तिशाली और व्यापक होते जा रहे हैं, नैतिक विचारों को संबोधित करना और इन प्रौद्योगिकियों का जिम्मेदार विकास और तैनाती सुनिश्चित करना महत्वपूर्ण है। गोपनीयता, सुरक्षा और दुरुपयोग या दुर्भावनापूर्ण एप्लिकेशन की संभावना जैसे मुद्दों की सावधानीपूर्वक जांच की जानी चाहिए। शोधकर्ताओं और डेवलपर्स को संभावित जोखिमों को कम करने और जीपीटी मॉडल के सुरक्षित और लाभकारी उपयोग को सुनिश्चित करने के लिए नैतिक दिशानिर्देश, शासन ढांचे और मजबूत सुरक्षा उपायों को विकसित करने की दिशा में काम करना चाहिए।

उभरते रुझान और अत्याधुनिक अनुसंधान

जेनेरिक एआई का क्षेत्र तेजी से विकसित हो रहा है, जिसमें शोधकर्ता नई वास्तुकला, प्रशिक्षण विधियों और अनुप्रयोगों की खोज कर रहे हैं। उभरते रुझानों में से एक है बहु-मॉडल मॉडल जो विभिन्न तौर-तरीकों (पाठ, चित्र, ऑडियो, आदि) में डेटा को संसाधित और उत्पन्न कर सकता है। भाषा निर्माण के लिए सुदृढीकरण सीखने का दृष्टिकोण एक और है। अन्य AI प्रौद्योगिकियों के साथ GPT मॉडल का एकीकरण, जैसे कंप्यूटर दृष्टि और रोबोटिक्स यह एक और प्रवृत्ति है. इसके अतिरिक्त, इन मॉडलों की व्याख्या, नियंत्रणीयता और मजबूती में सुधार पर शोध किया जा रहा है। शोधकर्ता वैज्ञानिक खोज, शिक्षा और स्वास्थ्य देखभाल जैसे क्षेत्रों में भी अपनी क्षमता तलाश रहे हैं।

निष्कर्ष

जीपीटी मॉडल ने एनएलपी के क्षेत्र में क्रांति ला दी है। उन्होंने भाषा अनुवाद, पाठ सारांश, संवादात्मक एआई और रचनात्मक लेखन जैसे कार्यों में उल्लेखनीय क्षमताओं का प्रदर्शन किया है। इन मॉडलों के मूल में ट्रांसफार्मर वास्तुकला है। यह पाठ डेटा में लंबी दूरी की निर्भरता और संदर्भ को पकड़ने के लिए एक उपन्यास ध्यान तंत्र को नियोजित करता है। जीपीटी मॉडल के प्रशिक्षण में बड़े पैमाने पर डेटासेट पर बिना पर्यवेक्षित पूर्व-प्रशिक्षण की एक जटिल प्रक्रिया शामिल होती है, जिसके बाद विशिष्ट कार्यों के लिए पर्यवेक्षित फाइन-ट्यूनिंग की जाती है।

हालाँकि GPT मॉडल ने प्रभावशाली परिणाम हासिल किए हैं, फिर भी कुछ सीमाएँ और चुनौतियाँ हैं जिन पर काबू पाना बाकी है। इसमें सच्ची समझ की कमी, संभावित पूर्वाग्रह और नैतिक चिंताएँ शामिल हैं। इसके अतिरिक्त, जेनेरिक एआई का क्षेत्र तेजी से विकसित हो रहा है, शोधकर्ताओं ने इन मॉडलों की सीमाओं को आगे बढ़ाने के लिए नए आर्किटेक्चर, अनुप्रयोगों और तकनीकों की खोज की है।

जैसे-जैसे जीपीटी मॉडल आगे बढ़ रहे हैं, नैतिक विचारों को संबोधित करना और जिम्मेदार एआई प्रथाओं को विकसित करना महत्वपूर्ण है। इन शक्तिशाली मॉडलों की पूरी क्षमता का दोहन करने के लिए उभरते रुझानों और अत्याधुनिक अनुसंधान का पता लगाना भी महत्वपूर्ण है। इस बीच, हमें संभावित जोखिमों को कम करके उनका सुरक्षित और लाभकारी उपयोग सुनिश्चित करना चाहिए।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/