Nous sommes dans la Grande Accélération – une singularité, non pas dans le sens majuscule kurzweilien des robots qui s’élèvent, mais dans celui que Foucault a décrit : Une période de temps où le changement est si répandu et si fondamental qu’on ne peut pas correctement discernez à quoi ressemblera l’autre côté de ce changement.

Nous avons déjà traversé des singularités :

- L'essor de l'agriculture (qui a créé des ressources excédentaires et nous a donné les classes académiques et marchandes).

- L’invention de l’imprimerie (qui a démocratisé le savoir et l’a rendu moins malléable, nous donnant l’idée d’une source de vérité au-delà de nos propres sens).

- La machine à vapeur (qui permet aux machines d'effectuer des tâches physiques).

- Logiciel informatique (qui permet de donner aux machines les instructions à suivre).

- Internet et les smartphones (qui nous connectent tous les uns aux autres de manière interactive).

Cette singularité est, dans sa forme la plus simple, que nous avons inventé un nouveau type de logiciel.

L'ancien type de logiciel

L’ancien type de logiciel – celui actuellement installé sur vos téléphones et ordinateurs – a changé nos vies d’une manière qui les rendrait presque méconnaissables pour quelqu’un des années 1970. L'humanité a eu 50 ans pour s'adapter aux logiciels, car ils ont commencé lentement avec les universitaires, puis les amateurs, avec les modems commutés et la messagerie électronique d'entreprise. Mais même avec un demi-siècle pour s’adapter, notre civilisation a du mal à faire face à ses conséquences.

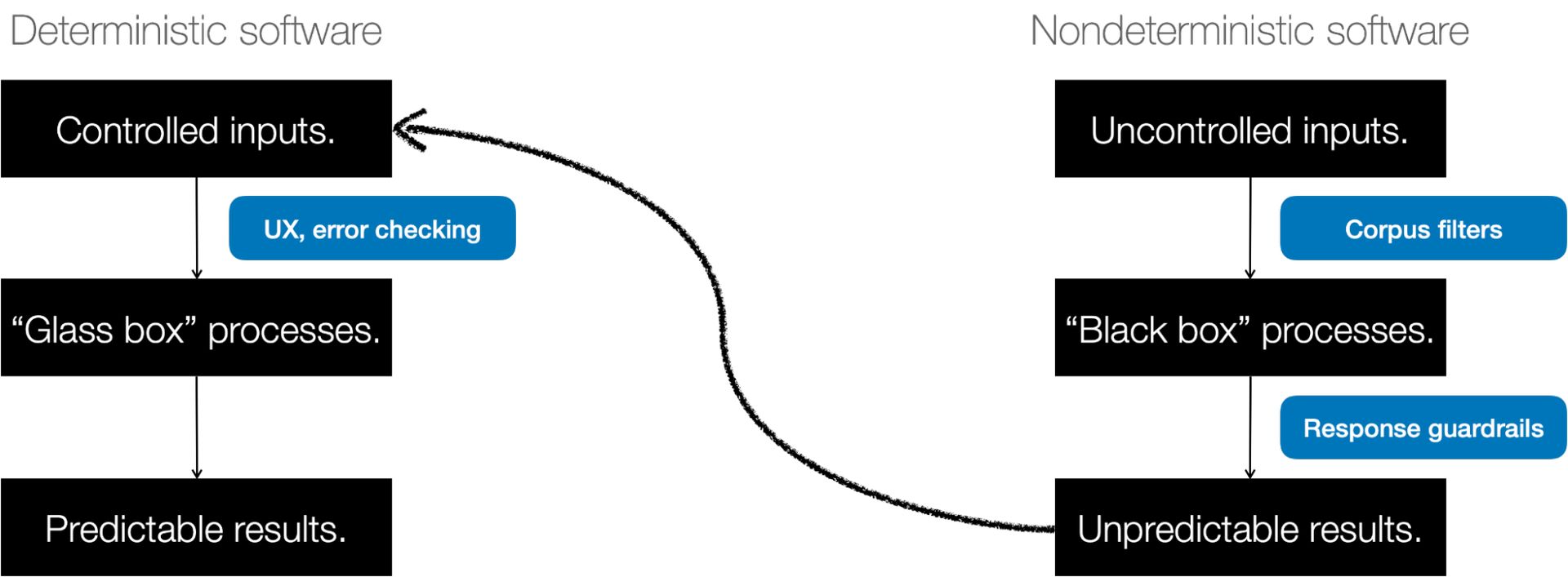

Le logiciel que vous connaissez aujourd'hui – celui qui envoie des messages, additionne des chiffres, réserve quelque chose dans un calendrier, ou même alimente un appel vidéo – est déterministe. Cela signifie il fait ce que tu attends. Lorsque le résultat est inattendu, cela s’appelle un bug.

Du logiciel déterministe à l’IA

Des exemples antérieurs de « machines pensantes » incluaient la cybernétique (boucles de rétroaction comme les pilotes automatiques) et les systèmes experts (arbres de décision pour les médecins). Mais ces événements restaient prévisibles et compréhensibles. Ils ont juste suivi beaucoup de règles.

Dans les années 1980, nous avons essayé une approche différente. Nous avons structuré les logiciels pour qu’ils se comportent comme le cerveau, en lui donnant des « neurones ». Et puis on le laisse se configurer à partir d'exemples. En 1980, un jeune chercheur nommé Yann LeCun s'y est essayé sur la classification d'images.

Il est désormais responsable de l'IA chez Meta.

L’IA est alors entrée dans une sorte d’hibernation. Des progrès étaient réalisés, mais ils étaient lents et se produisaient dans les couloirs du monde universitaire. L'apprentissage profond, TensorFlow et d'autres technologies ont émergé, principalement pour alimenter les moteurs de recherche, les recommandations et la publicité. Mais l’IA s’est développée en coulisses, dans les services publicitaires, les cartes et la reconnaissance vocale.

En 2017, certains chercheurs ont publié un article fondateur intitulé « L’attention est tout ce dont vous avez besoin ». À l’époque, les auteurs travaillaient chez Google, mais beaucoup ont depuis rejoint des entreprises comme OpenAI. L'article décrit une manière beaucoup plus simple de laisser le logiciel se configurer lui-même en prêtant attention aux parties du langage qui comptent le plus.

L’une des premières utilisations de cela a été la traduction. Si vous alimentez un algorithme avec suffisamment de texte anglais et français, il peut comprendre comment traduire de l’un à l’autre en comprenant les relations entre les mots de chaque langue. Mais l’approche de base nous a permis de former des logiciels sur du texte récupéré sur Internet.

À partir de là, les progrès ont été assez rapides. En 2021, nous avons découvert comment créer un « modèle d'instruction » qui utilisait un processus appelé Supervised Fine Tuning (SFT) pour que l'IA conversationnelle suive les instructions. En 2022, nous avons demandé à des humains d'évaluer les réponses à nos instructions (appelé Modified Supervised Fine Tuning), et fin 2022, nous avons ajouté quelque chose appelé Reinforcement Learning on Human Feedback, qui nous a donné GPT-3.5 et ChatGPT. Les IA peuvent désormais donner des commentaires à d’autres IA.

Quoi qu’il en soit, d’ici 2024, les humains seront l’intrant sur lequel les choses sont formées et fourniront le feedback sur la qualité des résultats qui sera utilisé pour l’améliorer.

Quand l'inattendu est une fonctionnalité, pas un bug

Le résultat est un nouveau type de logiciel. Pour que cela fonctionne, nous rassemblons d’abord des tonnes de données et les utilisons pour former un modèle mathématique massif. Ensuite, nous entrons une invite dans le modèle et celui-ci prédit la réponse souhaitée (beaucoup de gens ne réalisent pas que une fois qu’une IA est entraînée, la même entrée donne le même résultat – celui qu’elle considère comme le « meilleur » – à chaque fois). Mais nous voulons de la créativité, c'est pourquoi nous ajoutons une perturbation, appelée température, qui indique à l'IA le degré d'aléa qu'elle doit injecter dans ses réponses.

Nous ne pouvons pas prédire à l’avance ce que fera le modèle. Et nous introduisons intentionnellement le caractère aléatoire pour obtenir des réponses variables à chaque fois. Tout l’intérêt de ce nouveau logiciel est d’être imprévisible. Être non déterministe. Cela fait des choses inattendues.

Dans le passé, vous mettiez quelque chose dans l'application et celle-ci suivait un ensemble d'instructions écrites par des humains et un résultat attendu émergeait. Maintenant, vous mettez quelque chose dans une IA et cela suit un ensemble d'instructions qui it a écrit, et un résultat inattendu émerge de l’autre côté. Et le résultat inattendu n’est pas un bug, c’est une fonctionnalité.

Adoption incroyablement rapide

Nous adoptons ce deuxième type de logiciel bien plus rapidement que le premier, pour plusieurs raisons

- Il crée son propre manuel d'utilisation: Bien que nous soyons tous enthousiasmés par la qualité des résultats, nous oublions souvent à quel point il peut répondre à des entrées simples. Il s’agit du premier logiciel sans courbe d’apprentissage – il dira littéralement à toute personne sachant taper ou parler comment l’utiliser. C'est le premier logiciel qui crée sa propre documentation.

- Tout le monde peut l'essayer: Grâce à la connectivité omniprésente via les téléphones mobiles et le haut débit, ainsi qu'au modèle SaaS de logiciels hébergés, de nombreuses personnes y ont accès. Vous n'avez plus besoin d'acheter et d'installer de logiciel. Toute personne disposant d'un navigateur peut l'essayer.

- Le matériel est partout: Les GPU issus des jeux, les puces de la série M d'Apple et le cloud computing facilitent grandement le déploiement d'immenses ressources informatiques.

- Les coûts ont baissé. Beaucoup: Certaines avancées algorithmiques ont réduit le coût de l’IA de plusieurs ordres de grandeur. Le coût de la classification d’un milliard d’images est passé de 10,000 2021 dollars en 0.03 à 2023 dollar en 450, soit un tarif XNUMX fois moins cher par jour.

- Nous vivons en ligne: Les humains sont en ligne en moyenne six heures par jour, et une grande partie de ces interactions (e-mails, forums de discussion, SMS, blogs) sont basées sur du texte. Dans le monde en ligne, un humain est en grande partie impossible à distinguer d’un algorithme. Il existe donc de nombreux moyens simples de connecter la sortie de l’IA aux flux et aux écrans que les gens consomment. Le COVID-19 a accéléré le travail à distance et, avec lui, l’insinuation du texte et des algorithmes dans nos vies.

Ce que les logiciels non déterministes peuvent faire

Les logiciels non déterministes peuvent faire beaucoup de choses, dont certaines que nous commençons seulement à réaliser.

- Il est génératif. Cela peut créer de nouvelles choses. Nous le voyons dans les images (Stable Diffusion, Dall-e) et la musique (Google MusicLM) et même dans la finance, la génomique et la détection des ressources. Mais ce sont les chatbots comme ceux d’OpenAI, Google, Perplexity et autres qui retiennent le plus l’attention.

- C'est bon en créativité mais invente des trucs. Cela signifie que nous lui confions des tâches « amusantes » comme l'art, la prose et la musique pour lesquelles il n'y a pas de « bonne réponse ». Cela signifie également un flot de désinformation et une crise épistémique pour l’humanité.

- C'est encore nécessite beaucoup d'apport humain pour filtrer la sortie en quelque chose d'utilisable. En fait, de nombreuses étapes de production d’une IA conversationnelle impliquent que des humains lui donnent des exemples de bonnes réponses ou évaluent les réponses qu’elle donne.

- Parce que c’est souvent faux, il faut pouvoir blâmer quelqu’un. L'humain qui décide quoi faire de sa production est responsable des conséquences.

- It peut raisonner d'une manière que nous ne pensions pas qu'il devrait pouvoir faire. Nous ne comprenons pas pourquoi.

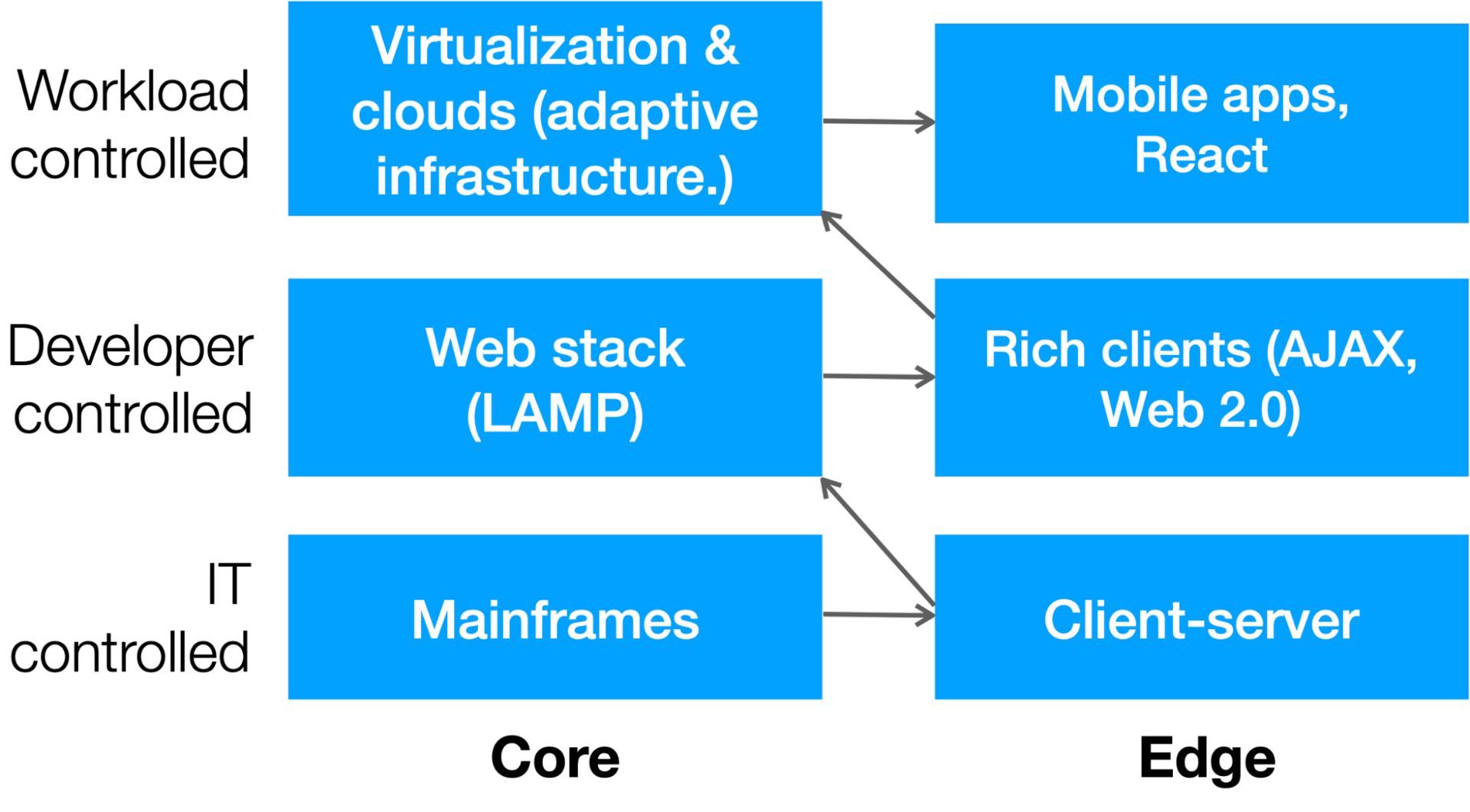

Le balancier et la démocratisation de l’informatique

Bien que, par définition, il soit difficile de prédire l’autre côté d’une singularité, nous pouvons émettre des hypothèses éclairées sur l’évolution des technologies de l’information (TI). Le secteur informatique a connu deux changements majeurs au cours du siècle dernier :

- Balancier constant, il oscille depuis la centralisation des mainframes vers la nature distribuée des clients Web.

- Il s'agit d'une démocratisation progressive des ressources, depuis l'époque où l'informatique était rare, précieuse et gardée par l'informatique jusqu'à une époque où les développeurs, puis les charges de travail elles-mêmes, pouvaient déployer des ressources selon leurs besoins.

Ce diagramme montre ce changement :

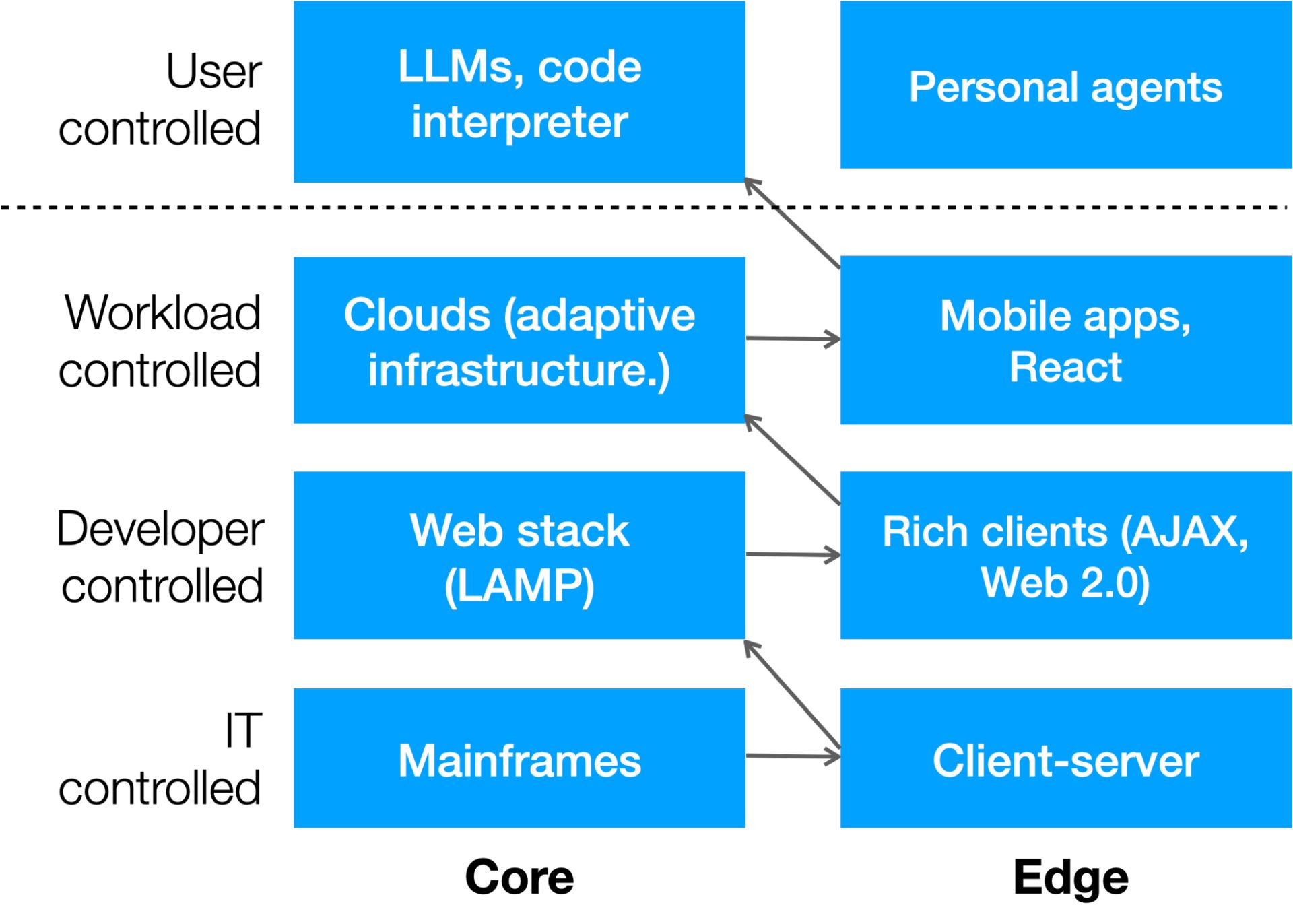

Il y a un autre niveau qui se produit grâce à l'IA : l'informatique contrôlée par l'utilisateur. Nous voyons déjà des outils sans code et low-code tels que Unqork, Bubble, Webflow, Zapier et d'autres qui facilitent la création d'applications par les utilisateurs, mais ce qui est bien plus intéressant, c'est lorsque l'invite IA d'un utilisateur lance le code. Nous le voyons dans l'interpréteur de code ChatGPT d'OpenAI, qui écrira puis exécutera des applications pour traiter les données.

Il est probable qu'il y aura un autre mouvement de pendule dans les années à venir, alors que des entreprises comme Apple entreront dans la mêlée (qui ont intégré un traitement d'IA important dans leurs chipsets locaux en prévision de ce jour). Voici à quoi ressemble la prochaine couche informatique :

Construire une deuxième pile

Une autre prédiction que nous pouvons faire à propos de l’informatique à l’ère du non-déterminisme est que les entreprises disposeront de deux piles.

- L’un sera déterministe et exécutera des tâches prévisibles.

- L’un sera non déterministe, générant des résultats inattendus.

Le plus intéressant peut-être est que la deuxième pile (non déterministe) sera capable d'écrire du code que la première pile (déterministe) pourra exécuter – bientôt, mieux que les humains.

La décennie à venir verra une ruée vers la création de deuxièmes piles dans chaque organisation. Chaque entreprise sera jugée sur la valeur de son corpus, des informations exclusives et des mises à jour en temps réel qu'elle utilise pour tirer les meilleurs résultats de son IA. Chaque pile aura des exigences matérielles, des architectures, une gouvernance, des interfaces utilisateur et des structures de coûts différentes.

Nous ne pouvons pas prédire comment l’IA va remodeler l’humanité. Mais nous pouvons faire des hypothèses éclairées sur la façon dont cela va changer l’informatique d’entreprise, et ceux qui s’adaptent rapidement seront les mieux placés pour tirer parti de ce qui viendra ensuite.

Alistair Croll est l'auteur de plusieurs livres sur la technologie, les affaires et la société, dont le best-seller Lean Analytics. Il est le fondateur et coprésident de FWD50, la principale conférence mondiale sur l'innovation dans le secteur public, et a été directeur invité à la Harvard Business School, où il a contribué à la création du programme de science des données et de pensée critique. Il est président de la conférence de Univers de données 2024.

Rencontrez l'auteur sur Data Universe

Rejoignez l'auteur, Alistair Croll, à Univers de données, qui aura lieu les 10 et 11 avril 2024 à New York, où il présidera le lancement inaugural d'une nouvelle conférence indépendante de la marque sur les données et l'IA, conçue pour l'ensemble de la communauté mondiale des données et de l'IA.

Rassembler TOUT – Data Universe accueille les professionnels des données de tous niveaux et rôles, ainsi que les hommes d'affaires, les dirigeants et les partenaires de l'industrie pour interagir avec les informations les plus récentes et les plus pertinentes dirigées par des experts sur les données, l'analyse, le ML et l'IA explorées dans tous les secteurs. , pour vous aider à évoluer parallèlement à l'évolution rapide des normes, des outils, des techniques et des attentes qui transforment l'avenir de l'entreprise et de la société. Rejoignez-nous au North Javits Center à New York, en avril, pour faire partie de l'avenir des données et de l'IA.

INFORMS est heureux d'être un partenaire stratégique de Data Universe 2024 et présentera quatre séances pendant la conférence.

Crédit d'image en vedette: Growtika/Unsplash

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://dataconomy.com/2024/04/04/building-the-second-stack/