Das chinesische Institut für Hochenergiephysik (IHEP) in Peking leistet Pionierarbeit bei innovativen Ansätzen im Bereich Quantencomputing und Quantenmaschinelles Lernen, um im Rahmen seines Teilchenphysikprogramms neue Forschungswege zu eröffnen Hideki Okawa, Weidong Li und Jun Cao erklären

Das Institut für Hochenergiephysik (IHEP), Teil der Chinesischen Akademie der Wissenschaften, ist das größte Labor für Grundlagenwissenschaften in China. Es beherbergt ein multidisziplinäres Forschungsprogramm, das Elementarteilchenphysik, Astrophysik sowie die Planung, Konstruktion und den Bau großer Beschleunigerprojekte umfasst – darunter die China Spallation Neutron Source, die 2018 in Betrieb genommen wurde, und die High Energy Photon Source, die demnächst folgen wird 2025 online.

Während die Investitionen in die experimentelle Infrastruktur des IHEP in den letzten 20 Jahren dramatisch angestiegen sind, ist die Entwicklung und Anwendung von Quantenmaschinenlern- und Quantencomputertechnologien nun bereit, ähnlich weitreichende Ergebnisse im Rahmen des IHEP-Forschungsprogramms zu erzielen.

Große Wissenschaft, Quantenlösungen

In der Hochenergiephysik trifft „Big Science“ auf „Big Data“. Die Entdeckung neuer Teilchen und die Erforschung grundlegender Naturgesetze sind Unternehmungen, die unglaubliche Datenmengen produzieren. Der Large Hadron Collider (LHC) am CERN erzeugt Petabyte (1015 Während seiner Versuchsdurchläufe werden mehrere Bytes an Daten erzeugt – alles muss mit Hilfe von Grid Computing verarbeitet und analysiert werden, einer verteilten Infrastruktur, die Rechenressourcen weltweit vernetzt.

Auf diese Weise ermöglicht das Worldwide LHC Computing Grid einer Gemeinschaft von Tausenden von Physikern nahezu in Echtzeit Zugriff auf LHC-Daten. Dieses hochentwickelte Rechengitter war von grundlegender Bedeutung für die bahnbrechende Entdeckung des Higgs-Bosons am CERN im Jahr 2012 sowie für unzählige andere Fortschritte zur weiteren Untersuchung des Standardmodells der Teilchenphysik.

Ein weiterer Wendepunkt zeichnet sich jedoch ab, wenn es um die Speicherung, Analyse und Nutzung großer Datenmengen in der Hochenergiephysik geht. Der High-Luminosity Large Hadron Collider (HL-LHC), der voraussichtlich 2029 in Betrieb gehen wird, wird zu einem „Rechenproblem“ führen, da die integrierte Leuchtkraft der Maschine proportional zur Anzahl der Teilchenkollisionen ist, die in einer bestimmten Zeitspanne auftreten , wird gegenüber dem Designwert des LHC um den Faktor 10 zunehmen – ebenso wie die durch die HL-LHC-Experimente erzeugten Datenströme.

CERN QTI: Nutzung der großen Wissenschaft zur Beschleunigung der Quanteninnovation

Kurzfristig wird eine neu gestaltete „Rechenbasis“ benötigt, um den steigenden Datenanforderungen des HL-LHC gerecht zu werden – eine Basis, die die groß angelegte Nutzung von Grafikverarbeitungseinheiten für massiv parallele Simulation, Datenaufzeichnung und Wiederverarbeitung erfordert sowie klassische Anwendungen des maschinellen Lernens. Das CERN hat seinerseits auch eine mittel- und langfristige Roadmap erstellt, die die Gemeinschaften der Hochenergiephysik und der Quantentechnologie über die CERN Quantum Technology Initiative (QTI) zusammenbringt – in Anerkennung dessen, dass ein weiterer Sprung in der Rechenleistung in Sicht ist mit der Anwendung von Quantencomputing- und Quantennetzwerktechnologien.

Zurück zu den Quantengrundlagen

Quantencomputer nutzen, wie der Name schon sagt, die Grundprinzipien der Quantenmechanik. Ähnlich wie klassische Computer, die auf Binärbits basieren, die entweder den Wert 0 oder 1 annehmen, nutzen Quantencomputer Quantenbinärbits, jedoch als Überlagerung der Zustände 0 und 1. Diese Überlagerung, gepaart mit der Quantenverschränkung (Korrelationen zwischen Quantenbits), ermöglicht es Quantencomputern im Prinzip, einige Arten von Berechnungen deutlich schneller durchzuführen als klassische Maschinen – zum Beispiel Quantensimulationen, die in verschiedenen Bereichen der Quantenchemie und molekularen Reaktionskinetik angewendet werden.

Während die Möglichkeiten für die Wissenschaft und die Wirtschaft im Allgemeinen verlockend erscheinen, ist eines der großen technischen Probleme, die mit Quantencomputern in der Anfangsphase verbunden sind, ihre Anfälligkeit gegenüber Umgebungslärm. Qubits werden allzu leicht gestört, beispielsweise durch ihre Wechselwirkungen mit dem Erdmagnetfeld oder elektromagnetischen Streufeldern von Mobiltelefonen und WLAN-Netzwerken. Auch Wechselwirkungen mit kosmischer Strahlung können problematisch sein, ebenso wie Interferenzen zwischen benachbarten Qubits.

Die ideale Lösung – eine Strategie namens Fehlerkorrektur – besteht darin, die gleichen Informationen über mehrere Qubits hinweg zu speichern, sodass Fehler erkannt und korrigiert werden, wenn eines oder mehrere der Qubits durch Rauschen beeinträchtigt werden. Das Problem bei diesen sogenannten fehlertoleranten Quantencomputern besteht darin, dass sie eine große Anzahl von Qubits (im Millionenbereich) benötigen – etwas, das in kleinen Quantenarchitekturen der aktuellen Generation nicht umsetzbar ist.

Stattdessen können die Designer der heutigen Noisy Intermediate-Scale Quantum (NISQ)-Computer entweder die Rauscheffekte so akzeptieren, wie sie sind, oder die Fehler teilweise algorithmisch beheben – also ohne die Anzahl der Qubits zu erhöhen – in einem Prozess, der als Fehlerminderung bezeichnet wird. Es ist bekannt, dass mehrere Algorithmen kleinen Quantencomputern Widerstandsfähigkeit gegen Rauschen verleihen, sodass in bestimmten Anwendungen der Hochenergiephysik trotz der inhärenten Einschränkungen von Quantencomputern der aktuellen Generation ein „Quantenvorteil“ beobachtet werden kann.

Eine dieser Forschungsrichtungen am IHEP konzentriert sich auf die Quantensimulation und wendet Ideen an, die ursprünglich von Richard Feynman zum Einsatz von Quantengeräten zur Simulation der zeitlichen Entwicklung von Quantensystemen vorgebracht wurden – beispielsweise in der Gitterquantenchromodynamik (QCD). Im Kontext beschreibt das Standardmodell alle grundlegenden Wechselwirkungen zwischen den Elementarteilchen mit Ausnahme der Gravitationskraft – also die Verknüpfung der elektromagnetischen, schwachen und starken Kräfte. Auf diese Weise umfasst das Modell zwei Sätze sogenannter Quanten-Eichfeldtheorien: das Glashow-Weinberg-Salam-Modell (das eine einheitliche Beschreibung der elektromagnetischen und schwachen Kräfte liefert) und das QCD-Modell (für die starken Kräfte).

Generell ist es so, dass die Quanten-Eichfeld-Theorien nicht analytisch gelöst werden können, da die meisten Vorhersagen für Experimente aus Näherungsverfahren mit kontinuierlicher Verbesserung (auch als Störung bezeichnet) abgeleitet werden. Derzeit arbeiten IHEP-Mitarbeiter daran, Eichfelder mit Quantenschaltkreisen unter vereinfachten Bedingungen direkt zu simulieren (z. B. in reduzierten Raum-Zeit-Dimensionen oder unter Verwendung endlicher Gruppen oder anderer algebraischer Methoden). Solche Ansätze sind mit aktuellen Iterationen von NISQ-Computern kompatibel und stellen eine grundlegende Arbeit für eine vollständigere Implementierung von Lattice QCD in naher Zukunft dar.

Der QuIHEP-Quantensimulator

Als Erweiterung seines ehrgeizigen Quanten-F&E-Programms hat das IHEP QuIHEP eingerichtet, eine Quantencomputer-Simulatorplattform, die es Wissenschaftlern und Studenten ermöglicht, Quantenalgorithmen für Forschungsstudien in der Hochenergiephysik zu entwickeln und zu optimieren.

Zur Verdeutlichung: Quantensimulatoren sind klassische Computer-Frameworks, die versuchen, oder zu emulieren "simulieren" das Verhalten von Quantencomputern. Quantensimulation hingegen nutzt tatsächliche Quantencomputer-Hardware, um die zeitliche Entwicklung eines Quantensystems zu simulieren – z. B. die Gitter-QCD-Studien am IHEP (siehe Haupttext).

Damit bietet QuIHEP eine benutzerfreundliche und interaktive Entwicklungsumgebung, die vorhandene Hochleistungsrechnercluster nutzt, um bis zu etwa 40 Qubits zu simulieren. Die Plattform bietet eine Composer-Schnittstelle für Bildung und Einführung (um beispielsweise zu demonstrieren, wie Quantenschaltkreise visuell aufgebaut sind). Die Entwicklungsumgebung basiert auf der Open-Source-Software Jupyter und ist mit einem IHEP-Benutzerauthentifizierungssystem kombiniert.

Kurzfristig wird sich QuIHEP mit verteilten Quantencomputerressourcen in ganz China verbinden, um eine harmonisierte Forschungsinfrastruktur aufzubauen. Das Ziel: die Zusammenarbeit zwischen Industrie und Wissenschaft sowie die Aus- und Weiterbildung in der Quantenwissenschaft und -technik zu unterstützen.

Maschinelles Lernen: der Quantenweg

Ein weiteres Thema der Quantenforschung am IHEP ist das maschinelle Quantenlernen, das in vier verschiedene Ansätze eingeteilt werden kann: CC, CQ, QC, QQ (mit C – klassisch; Q – Quantum). Der erste Buchstabe entspricht jeweils dem Datentyp und der zweite Buchstabe dem Typ des Computers, auf dem der Algorithmus ausgeführt wird. Das CC-Schema nutzt beispielsweise vollständig klassische Daten und klassische Computer, führt jedoch quanteninspirierte Algorithmen aus.

Der vielversprechendste Anwendungsfall, der am IHEP verfolgt wird, betrifft jedoch die CQ-Kategorie des maschinellen Lernens, bei der der klassische Datentyp in Quantencomputern abgebildet und trainiert wird. Die Motivation hierbei ist, dass Quantencomputer durch die Nutzung der Grundlagen der Quantenmechanik – des großen Hilbert-Raums, der Superposition und der Verschränkung – in der Lage sein werden, effektiver aus großen Datensätzen zu lernen, um die daraus resultierenden Methoden des maschinellen Lernens zu optimieren.

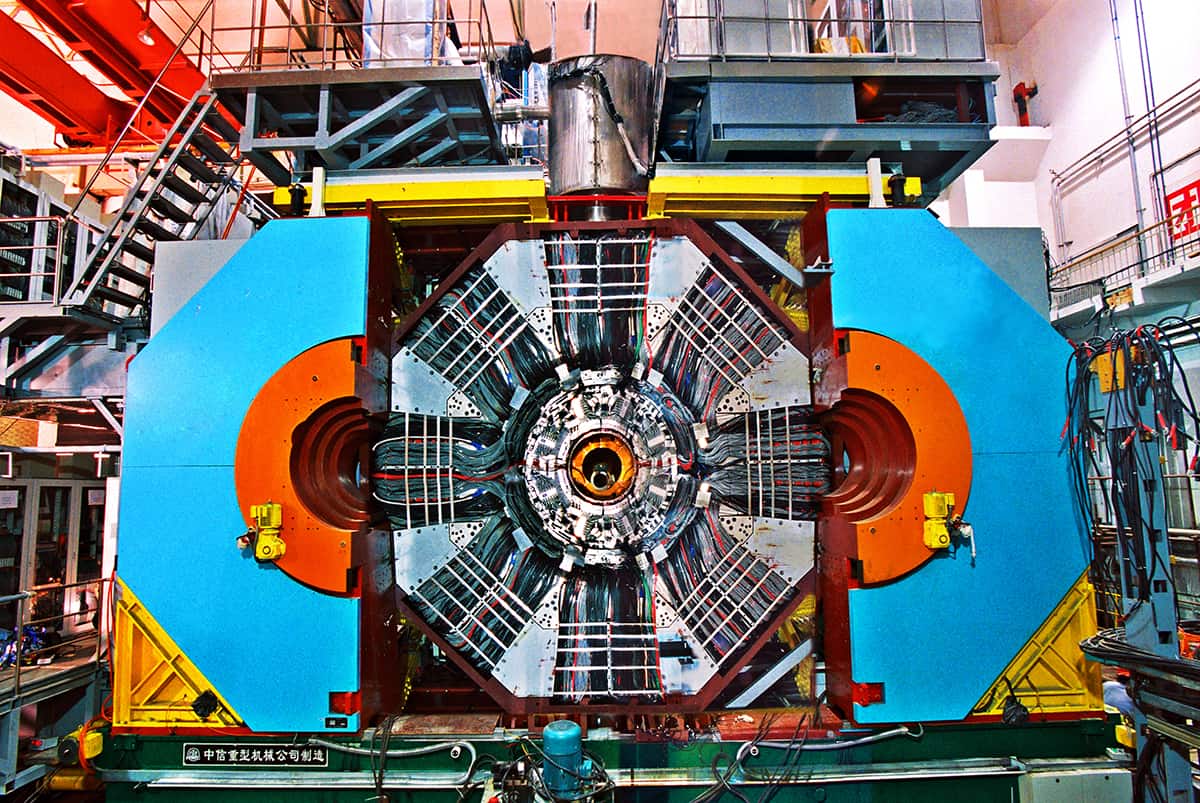

Um das Potenzial für Quantenvorteile zu verstehen, arbeiten IHEP-Wissenschaftler derzeit an der „Wiederentdeckung“ des exotischen Teilchens Zc(3900) unter Verwendung von Quantenmaschinellem Lernen. Zur Hintergrundgeschichte: Zc(3900) ist ein exotisches subatomares Teilchen, das aus Quarks (den Bausteinen von Protonen und Neutronen) besteht und vermutlich der erste experimentell beobachtete Tetraquark-Zustand ist – eine Beobachtung, die dabei unser Verständnis der QCD vertiefte. Das Teilchen wurde 2013 vom Beijing Spectrometer (BESIII)-Detektor am Beijing Electron-Positron Collider (BEPCII) entdeckt, mit unabhängiger Beobachtung durch das Belle-Experiment im japanischen Teilchenphysiklabor KEK.

Die Testbed-Innovationen von QUANT-NET: Das Quantennetzwerk neu denken

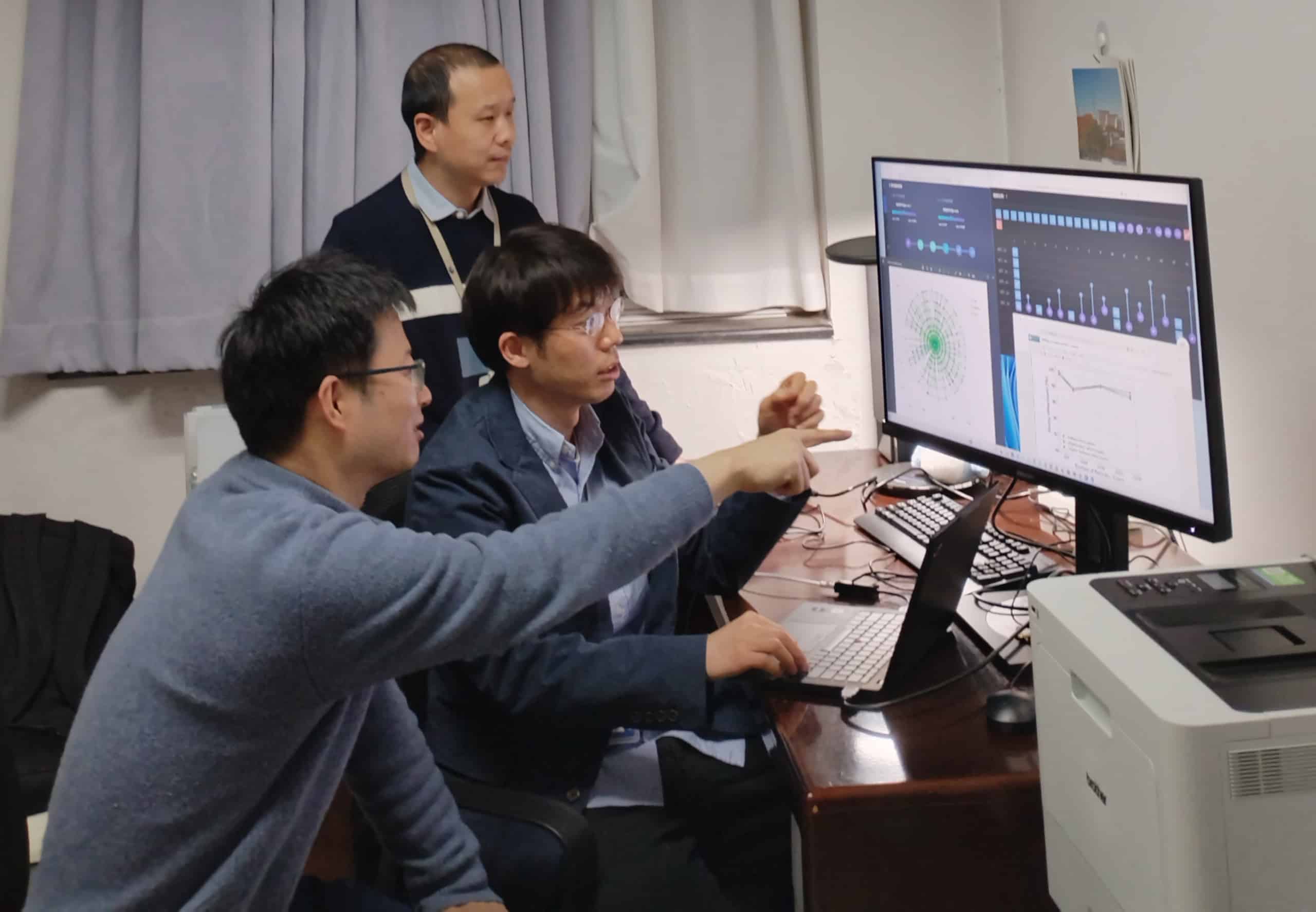

Im Rahmen dieser Forschungs- und Entwicklungsstudie setzte ein Team unter der Leitung von Jiaheng Zou vom IHEP und unter Beteiligung von Kollegen der Shandong-Universität und der Universität Jinan den sogenannten Quantum Support Vector Machine-Algorithmus (eine Quantenvariante eines klassischen Algorithmus) für das Training ein mit simulierten Signalen von Zc(3900) und zufällig ausgewählte Ereignisse aus den realen BESIII-Daten als Hintergrund.

Beim Einsatz des Quanten-Machine-Learning-Ansatzes ist die Leistung im Vergleich zu klassischen Systemen des maschinellen Lernens konkurrenzfähig – allerdings vor allem mit einem kleineren Trainingsdatensatz und weniger Datenfunktionen. Derzeit laufen Untersuchungen zum Nachweis einer verbesserten Signalempfindlichkeit durch Quantencomputer. Diese Arbeit könnte letztendlich den Weg zur Entdeckung neuer exotischer Teilchen in zukünftigen Experimenten weisen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://physicsworld.com/a/ihep-seeks-quantum-opportunities-to-fast-track-fundamental-science/