Einleitung

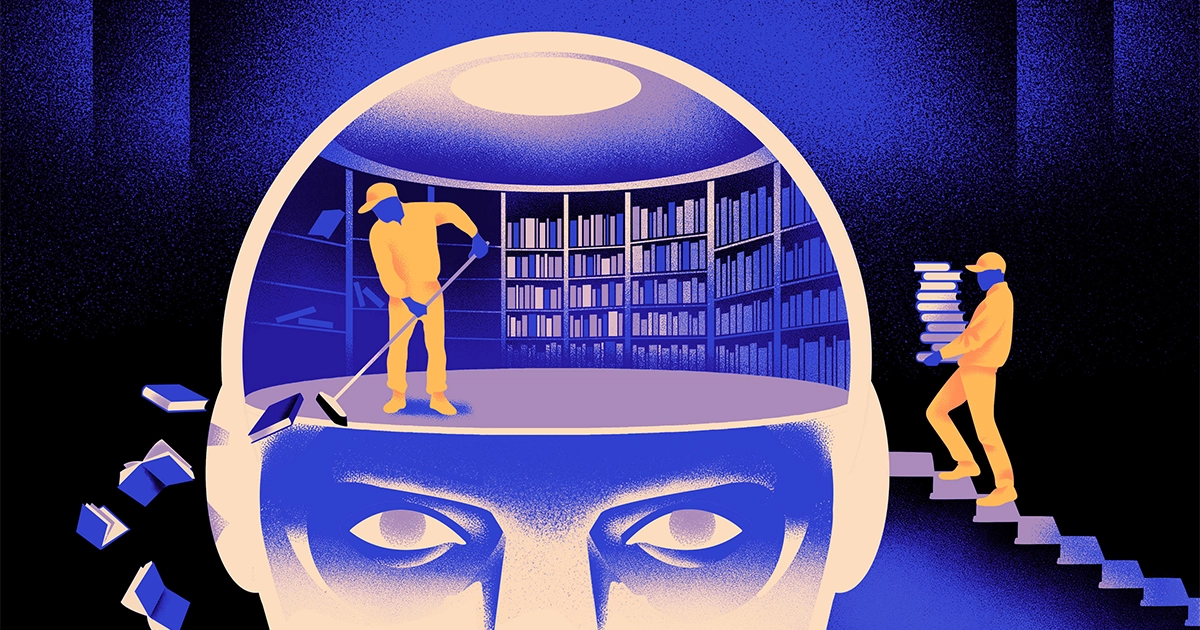

Ein Team von Informatikern hat eine erstellt flinkerer, flexiblerer Typ des maschinellen Lernmodells. Der Trick: Es muss regelmäßig vergessen, was es weiß. Und obwohl dieser neue Ansatz die riesigen Modelle, die den größten Apps zugrunde liegen, nicht verdrängen wird, könnte er mehr darüber verraten, wie diese Programme Sprache verstehen.

Die neue Forschung stellt „einen bedeutenden Fortschritt auf diesem Gebiet“ dar, sagte er Jea Kwon, ein KI-Ingenieur am Institute for Basic Science in Südkorea.

Die heute verwendeten KI-Sprach-Engines basieren größtenteils auf künstliche neurale Netzwerke. Jedes „Neuron“ im Netzwerk ist eine mathematische Funktion, die Signale von anderen Neuronen empfängt, einige Berechnungen durchführt und Signale über mehrere Neuronenschichten weiterleitet. Anfangs ist der Informationsfluss mehr oder weniger zufällig, aber durch Training verbessert sich der Informationsfluss zwischen Neuronen, da sich das Netzwerk an die Trainingsdaten anpasst. Wenn ein KI-Forscher beispielsweise ein zweisprachiges Modell erstellen möchte, trainiert er das Modell mit einem großen Stapel Text aus beiden Sprachen, wodurch die Verbindungen zwischen Neuronen so angepasst werden, dass der Text in einer Sprache mit dem Äquivalent in Beziehung gesetzt wird Wörter im anderen.

Dieser Trainingsprozess erfordert jedoch viel Rechenleistung. Wenn das Modell nicht sehr gut funktioniert oder sich die Bedürfnisse des Benutzers später ändern, ist es schwierig, es anzupassen. „Angenommen, Sie haben ein Modell mit 100 Sprachen, aber stellen Sie sich vor, dass eine gewünschte Sprache nicht abgedeckt ist“, sagte er Mikel Artexxe, Co-Autor der neuen Studie und Gründer des KI-Startups Reka. „Man könnte von vorne anfangen, aber das ist nicht ideal.“

Artetxe und seine Kollegen haben versucht, diese Einschränkungen zu umgehen. Vor einigen Jahren, Artetxe und andere trainierten ein neuronales Netzwerk in einer Sprache und löschten dann alles, was es über die Bausteine von Wörtern, sogenannte Token, wusste. Diese werden in der ersten Schicht des neuronalen Netzwerks, der sogenannten Einbettungsschicht, gespeichert. Sie ließen alle anderen Schichten des Modells in Ruhe. Nachdem sie die Token der ersten Sprache gelöscht hatten, trainierten sie das Modell auf der zweiten Sprache neu, wodurch die Einbettungsschicht mit neuen Token aus dieser Sprache gefüllt wurde.

Obwohl das Modell nicht übereinstimmende Informationen enthielt, funktionierte die Umschulung: Das Modell konnte die neue Sprache lernen und verarbeiten. Die Forscher vermuteten, dass die Einbettungsschicht zwar spezifische Informationen zu den in der Sprache verwendeten Wörtern speicherte, die tieferen Ebenen des Netzwerks jedoch abstraktere Informationen über die Konzepte hinter menschlichen Sprachen speicherten, die dem Modell dann beim Erlernen der zweiten Sprache halfen.

„Wir leben in der gleichen Welt. „Wir konzipieren die gleichen Dinge mit unterschiedlichen Wörtern“ in verschiedenen Sprachen, sagte er Yihong Chen, der Hauptautor des aktuellen Artikels. „Deshalb gibt es im Modell dieselben übergeordneten Argumente. Ein Apfel ist etwas Süßes und Saftiges, nicht nur ein Wort.“

Einleitung

Während dieser Vergessensansatz eine effektive Möglichkeit war, einem bereits trainierten Modell eine neue Sprache hinzuzufügen, war die Neuschulung dennoch anspruchsvoll – sie erforderte viele linguistische Daten und Rechenleistung. Chen schlug eine Optimierung vor: Anstatt zu trainieren, die Einbettungsschicht zu löschen und dann erneut zu trainieren, sollten sie die Einbettungsschicht während der ersten Trainingsrunde regelmäßig zurücksetzen. „Auf diese Weise gewöhnt sich das gesamte Modell an das Zurücksetzen“, sagte Artetxe. „Das heißt, wenn Sie das Modell auf eine andere Sprache erweitern möchten, ist es einfacher, weil Sie das getan haben.“

Die Forscher verwendeten ein häufig verwendetes Sprachmodell namens Roberta, trainierten es mit ihrer Technik des periodischen Vergessens und verglichen es mit der Leistung desselben Modells, als es mit dem Standardansatz des Nicht-Vergessens trainiert wurde. Das Vergessensmodell schnitt etwas schlechter ab als das herkömmliche Modell und erreichte einen Wert von 85.1 im Vergleich zu 86.1 bei einem gängigen Maß für Sprachgenauigkeit. Dann trainierten sie die Modelle in anderen Sprachen neu und verwendeten dabei viel kleinere Datensätze von nur 5 Millionen Token statt der 70 Milliarden, die sie beim ersten Training verwendeten. Die Genauigkeit des Standardmodells sank im Durchschnitt auf 53.3, die des Vergessensmodells jedoch nur auf 62.7.

Das Vergessensmodell schnitt auch viel besser ab, wenn das Team beim erneuten Training Rechengrenzen festlegte. Als die Forscher die Trainingslänge von 125,000 Schritten auf nur 5,000 reduzierten, verringerte sich die Genauigkeit des Vergessensmodells auf durchschnittlich 57.8, während das Standardmodell auf 37.2 sank, was nicht besser ist als zufällige Schätzungen.

Einleitung

Das Team kam zu dem Schluss, dass periodisches Vergessen das Modell beim Erlernen von Sprachen im Allgemeinen zu verbessern scheint. „Da [sie] während des Trainings immer wieder vergessen und neu lernen, wird es einfacher, dem Netzwerk später etwas Neues beizubringen“, sagte er Evgenii Nikishin, ein Forscher bei Mila, einem Deep-Learning-Forschungszentrum in Quebec. Dies deutet darauf hin, dass Sprachmodelle eine Sprache verstehen, wenn sie dies auf einer tieferen Ebene tun, als nur auf der Bedeutung einzelner Wörter.

Der Ansatz ähnelt der Funktionsweise unseres eigenen Gehirns. „Das menschliche Gedächtnis ist im Allgemeinen nicht sehr gut darin, große Mengen detaillierter Informationen genau zu speichern. Stattdessen neigen Menschen dazu, sich an den Kern unserer Erfahrungen zu erinnern, sie zu abstrahieren und zu extrapolieren“, sagte er Benjamin Levi, ein Neurowissenschaftler an der University of San Francisco. „Die Aktivierung von KI mit menschenähnlicheren Prozessen wie dem adaptiven Vergessen ist eine Möglichkeit, ihnen eine flexiblere Leistung zu ermöglichen.“

Artetxe hofft, dass flexiblere vergessene Sprachmodelle zusätzlich zu dem, was es darüber sagen könnte, wie das Verstehen funktioniert, auch dazu beitragen könnten, die neuesten KI-Durchbrüche auf mehr Sprachen zu übertragen. Obwohl KI-Modelle gut mit Spanisch und Englisch umgehen können, zwei Sprachen mit umfangreichen Schulungsmaterialien, sind die Modelle mit seiner Muttersprache Baskisch, der lokalen Sprache im Nordosten Spaniens, nicht so gut. „Die meisten Modelle großer Technologieunternehmen machen das nicht gut“, sagte er. „Die Anpassung vorhandener Modelle an das Baskische ist der richtige Weg.“

Chen freut sich auch auf eine Welt, in der mehr KI-Blumen blühen. „Ich denke an eine Situation, in der die Welt kein großes Sprachmodell braucht. Wir haben so viele“, sagte sie. „Wenn es eine Fabrik gibt, die Sprachmodelle herstellt, braucht man diese Art von Technologie. Es verfügt über ein Basismodell, das sich schnell an neue Domänen anpassen lässt.“

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/