Erinnern Sie sich, als Googles Barde, jetzt Gemini genannt, konnte eine Frage zum James Webb-Weltraumteleskop nicht beantworten in seiner Einführungsanzeige? Lassen Sie mich Ihre Erinnerung an diesen berühmten Fall auffrischen – es ist eines der größten Beispiele für KI-Halluzinationen, die wir je gesehen haben.

Was ist passiert? Während der Werbung wurde die Google Bard-Demo gefragt: „Welche neuen Entdeckungen vom James Webb-Weltraumteleskop kann ich mit meinem 9-Jährigen teilen?“ Nach einer kurzen Pause gab die Google Bard-Demo zwei richtige Antworten. Die endgültige Antwort war jedoch falsch. Laut der Bard-Demo von Google hatte das Teleskop die ersten Bilder eines Planeten außerhalb unseres Sonnensystems aufgenommen. Tatsächlich hatte das Very Large Telescope der Europäischen Südsternwarte jedoch bereits Bilder dieser „Exoplaneten“ aufgenommen, die in den Archiven der NASA gespeichert wurden.

Ich will eigentlich kein Idiot sein, und ich bin mir sicher, dass Bard beeindruckend sein wird, aber fürs Protokoll: JWST hat nicht „das allererste Bild eines Planeten außerhalb unseres Sonnensystems“ gemacht.

das erste Bild wurde stattdessen von Chauvin et al. (2004) mit dem VLT/NACO mit adaptiver Optik. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

– Grant Tremblay (@astrogrant) 7. Februar 2023

Warum können Tech-Giganten wie Google solche Fehler nicht einmal verhindern? Lass es uns herausfinden!

Was ist eine KI-Halluzination?

Eine KI-Halluzination tritt auf, wenn ein Computerprogramm, das typischerweise auf künstlicher Intelligenz (KI) basiert, Ausgaben erzeugt, die falsch, unsinnig oder irreführend sind. Dieser Begriff wird oft verwendet, um Situationen zu beschreiben, in denen KI-Modelle Antworten erzeugen, die völlig vom richtigen Weg abweichen oder keinen Bezug zu den ihnen gegebenen Eingaben haben. Es ist, als würde man eine Frage stellen und eine Antwort bekommen, die keinen Sinn ergibt oder überhaupt nicht Ihren Erwartungen entspricht.

Verstehen warum KI-Halluzinationen Schauen wir uns einmal an, wie KI funktioniert. KI-Modelle wie Chatbots oder Bilderkennungssysteme werden anhand großer Datensätze trainiert, um Muster zu lernen und Vorhersagen zu treffen. Wenn die Trainingsdaten jedoch fehlerhaft, unvollständig oder verzerrt sind, lernt das KI-Modell möglicherweise falsche Muster oder Zusammenhänge. Dies kann zu halluzinierten Ausgaben führen, bei denen die KI Antworten generiert, die auf fehlerhaften oder missverstandenen Informationen basieren. Und es kommt häufig vor, auch wenn Sie es vielleicht nicht bemerken.

KI-Halluzinationen können sich in verschiedenen Formen manifestieren, die jeweils unterschiedliche Herausforderungen und Feinheiten innerhalb künstlicher Intelligenzsysteme hervorheben. Hier sind einige häufige Arten von KI-Halluzinationen:

- Satz KI-Halluzination:

- In diesem Szenario generiert das KI-Modell einen Satz, der im Widerspruch zu einer vorherigen Aussage im selben Kontext steht. Zum Beispiel:

- Aufforderung: „Beschreiben Sie die Reise einer Figur in Sätzen mit drei Wörtern.“

- Ausgabe: „Sie ging langsam. Plötzlich rannte sie. Dann ging sie.“

- In diesem Szenario generiert das KI-Modell einen Satz, der im Widerspruch zu einer vorherigen Aussage im selben Kontext steht. Zum Beispiel:

Der letzte Satz widerspricht der früheren Aktion des Laufens und stört die Kohärenz der Erzählung.

- Sofortige KI-Halluzination:

- Dieser Typ tritt auf, wenn die von der KI generierte Antwort mit der beabsichtigten Eingabeaufforderung oder Abfrage kollidiert. Zum Beispiel:

- Aufforderung: „Schreiben Sie ein Rezept für Schokoladenkuchen.“

- Ausgabe: „Hier ist ein Gedicht über Sterne.“

- Dieser Typ tritt auf, wenn die von der KI generierte Antwort mit der beabsichtigten Eingabeaufforderung oder Abfrage kollidiert. Zum Beispiel:

Der generierte Inhalt erfüllt die Aufforderung zum Kochen nicht, was darauf hindeutet, dass der Kontext nicht verstanden wurde.

- Faktische KI-Halluzination:

- Sachliche Widersprüche entstehen, wenn das KI-Modell falsche Informationen als zutreffend darstellt. Zum Beispiel:

- Eingabeaufforderung: „Listen Sie drei Elemente im Periodensystem auf.“

- Ausgabe: „Wasserstoff, Sauerstoff, Karbonit.“

- Sachliche Widersprüche entstehen, wenn das KI-Modell falsche Informationen als zutreffend darstellt. Zum Beispiel:

„Karbonit“ ist kein Element, was zu Fehlinformationen in der Antwort führt.

- Irrelevante oder zufällige KI-Halluzinationen:

- Bei diesen Halluzinationen werden irrelevante oder unsinnige Informationen erzeugt, die nichts mit der Eingabe zu tun haben. Zum Beispiel:

- Aufforderung: „Beschreiben Sie einen Tag am Strand.“

- Ausgabe: „Der Sand war warm. Möwen sangen Jazz. Pinguine tanzten Ballett.“

- Bei diesen Halluzinationen werden irrelevante oder unsinnige Informationen erzeugt, die nichts mit der Eingabe zu tun haben. Zum Beispiel:

Die Erwähnung von Pinguinen und Ballett passt nicht zur typischen Strandszene und zeigt einen Mangel an Kohärenz in der generierten Erzählung.

Diese Art von Halluzinationen verdeutlicht die Herausforderungen, vor denen KI-Systeme stehen, wenn es darum geht, Informationen genau zu verstehen und in einen Kontext zu setzen. Um diese Probleme anzugehen, müssen die Qualität der Trainingsdaten verbessert, das Kontextverständnis der Sprachmodelle verfeinert und robuste Validierungsmechanismen implementiert werden, um die Kohärenz und Genauigkeit der KI-generierten Ausgaben sicherzustellen.

KI-Halluzinationen können schwerwiegende Folgen haben, insbesondere bei Anwendungen, bei denen KI für wichtige Entscheidungen eingesetzt wird, beispielsweise bei medizinischen Diagnosen oder beim Finanzhandel. Wenn ein KI-System in diesen Kontexten halluziniert und ungenaue Informationen liefert, könnte dies zu schädlichen Folgen führen.

Was kann man gegen KI-Halluzinationen tun?

Die Reduzierung von KI-Halluzinationen erfordert einige wichtige Schritte, um KI-Systeme genauer und zuverlässiger zu machen:

Erstens ist es wichtig, qualitativ hochwertige Daten zum Trainieren der KI zu verwenden. Das bedeutet, sicherzustellen, dass die Informationen, aus denen die KI lernt, vielfältig, genau und frei von Vorurteilen sind.

Auch die Vereinfachung von KI-Modellen kann hilfreich sein. Komplexe Modelle können manchmal zu unerwarteten Fehlern führen. Indem wir die Dinge einfach halten, können wir die Fehlerwahrscheinlichkeit verringern.

Wichtig sind auch klare und leicht verständliche Anweisungen. Wenn die KI klare Eingaben erhält, ist es weniger wahrscheinlich, dass sie verwirrt wird und Fehler macht.

Regelmäßige Tests helfen, Fehler frühzeitig zu erkennen. Indem wir überprüfen, wie gut die KI funktioniert, können wir etwaige Probleme beheben und Verbesserungen vornehmen.

Auch das Hinzufügen von Prüfungen innerhalb von KI-Systemen kann hilfreich sein. Diese Kontrollen erkennen Fehler und korrigieren sie, bevor sie Probleme verursachen.

Am wichtigsten ist die menschliche Aufsicht. Die doppelte Überprüfung der von der KI generierten Ergebnisse durch Mitarbeiter gewährleistet Genauigkeit und Zuverlässigkeit.

Schließlich kann das Training der KI zur Abwehr von Angriffen sie widerstandsfähiger machen. Dies hilft der KI, Manipulations- oder Trickversuche zu erkennen und abzuwehren.

Indem wir diese Schritte befolgen, können wir KI-Systeme zuverlässiger machen und die Wahrscheinlichkeit halluzinierter Ausgaben verringern.

Wie bringt man eine KI zum Halluzinieren?

Wenn Sie diesen Fehler ausnutzen und Spaß haben möchten, können Sie ein paar Dinge tun:

- Ändern Sie die Eingabe: Sie können die an die KI übermittelten Informationen anpassen. Schon kleine Änderungen können zu seltsamen oder falschen Antworten führen.

- Trickse das Modell aus: Erstellen Sie spezielle Eingaben, die die KI dazu verleiten, falsche Antworten zu geben. Diese Tricks nutzen die Schwächen des Modells aus, um halluzinierte Ergebnisse zu erzeugen.

- Leg dich mit den Daten an: Indem Sie den Trainingsdaten der KI oder Ihrer Eingabeaufforderung irreführende oder falsche Informationen hinzufügen, können Sie dazu führen, dass sie falsche Dinge lernt und Halluzinationen hervorruft.

- Passen Sie das Modell an: Ändern Sie die Einstellungen oder die Struktur der KI, um Fehler oder Vorurteile einzuführen. Diese Änderungen können dazu führen, dass seltsame oder unsinnige Ausgaben generiert werden.

- Geben Sie verwirrende Eingaben: Geben Sie der KI unklare oder widersprüchliche Anweisungen. Dies kann die KI verwirren und zu falschen oder unsinnigen Antworten führen.

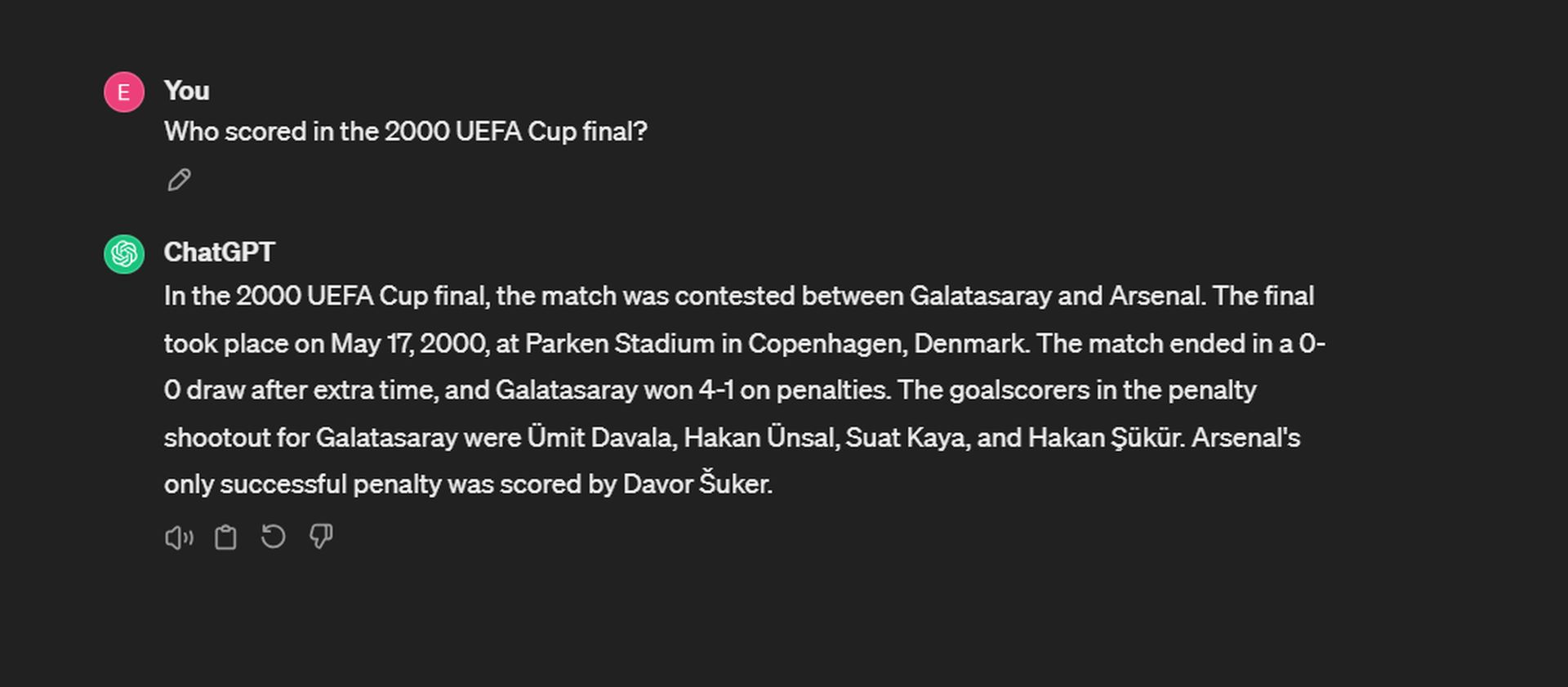

Oder Sie stellen einfach Fragen und versuchen Ihr Glück! Wir haben zum Beispiel versucht, ChatGPT halluzinieren zu lassen:

Während sich ChatGPT das Datum und den Spielstand genau merkt, fällt es ihm schwer, sich an die Torschützen des Elfmeterschießens zu erinnern. Für Galatasaray erzielten Ergün Penbe, Hakan Şükür, Ümit Davala und Popescu die Tore. Bei Arsenal war Ray Parlor der einzige erfolgreiche Elfmeterschütze.

Während es uns helfen kann, die Grenzen der künstlichen Intelligenz zu verstehen, ist es wichtig, dieses Wissen verantwortungsvoll zu nutzen und sicherzustellen, dass KI-Systeme zuverlässig und vertrauenswürdig bleiben.

Halluziniert GPT 4 weniger?

Ja, nach dem Auswertung durchgeführt von dem in Palo Alto ansässigen Unternehmen unter Verwendung seines Halluzinationsbewertungsmodells, GPT-4 weist im Vergleich zu anderen großen Sprachmodellen eine geringere Halluzinationsrate auf, mit Ausnahme von Intel Neural Chat 7B (97.2 %). Mit einer Genauigkeitsrate von 97 % und einer Halluzinationsrate von 3 % weist GPT-4 ein hohes Maß an Genauigkeit und eine relativ geringe Tendenz zur Entstehung von Halluzinationen bei der Zusammenfassung von Dokumenten auf. Dies weist darauf hin, dass GPT-4 im Vergleich zu anderen in der Evaluierung getesteten Modellen weniger dazu neigt, falsche oder unsinnige Ausgaben zu generieren.

Auf der anderen Seite kamen einige der am wenigsten effektiven Modelle von Google. Google Palm 2 zeigte eine Genauigkeitsrate von 90 % und eine Halluzinationsrate von 10 %. Sein Chat-verfeinertes Gegenstück schnitt mit einer Genauigkeitsrate von nur 84.2 % und dem höchsten Halluzinationswert aller Modelle auf der Bestenliste mit 16.2 % sogar noch schlechter ab. Hier ist die Liste:

Zusammenfassend ist eine KI-Halluzination ein Fehler, den KI-Systeme machen, wenn sie aufgrund von Fehlern in den Trainingsdaten oder der Art und Weise, wie sie Informationen verarbeiten, Ausgaben erzeugen, die unsinnig oder falsch sind. Es ist ein faszinierender und zugleich herausfordernder Aspekt der KI, an dessen Lösung Forscher und Entwickler arbeiten.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://dataconomy.com/2024/04/11/what-exactly-is-an-ai-hallucination-and-why-does-it-matter/