CCC unterstützte drei wissenschaftliche Sitzungen auf der diesjährigen AAAS-Jahreskonferenz. Falls Sie nicht persönlich teilnehmen konnten, werden wir jede Sitzung noch einmal zusammenfassen. Diese Woche werden wir die Höhepunkte der Sitzung zusammenfassen: „Generative KI in der Wissenschaft: Versprechen und Fallstricke.“ Im ersten Teil fassen wir die Einleitung und den Vortrag von Dr. Rebecca Willett zusammen.

Das erste AAAS-Panel des CCC auf der Jahrestagung 2024 fand am Freitag, dem 16. Februar, dem zweiten Tag der Konferenz, statt. Das Panel wird von CCC-Mitarbeitern moderiert Dr. Matthew Turk, Präsident des Toyota Technological Institute in Chicago, bestand aus Experten, die künstliche Intelligenz in verschiedenen wissenschaftlichen Bereichen anwenden. Dr. Rebecca Willett, Professorin für Statistik und Informatik an der University of Chicago, konzentrierte sich in ihrem Vortrag darauf, wie generative Modelle in den Wissenschaften eingesetzt werden können und warum Standardmodelle für die Anwendung in der wissenschaftlichen Forschung nicht ausreichen. Dr. Markus Bühler, Professor für Ingenieurwissenschaften am Massachusetts Institute of Technology, sprach über generative Modelle in der Materialwissenschaft und Duncan Watson-Parris, Assistenzprofessor am Scripps Institution of Oceanography und am Halıcıoğlu Data Science Institute der UC San Diego, diskutierte, wie generative Modelle beim Studium der Klimawissenschaften eingesetzt werden können.

Dr. Turk, ein Experte für Computer Vision und Mensch-Computer-Interaktion, begann das Panel mit der Unterscheidung zwischen generativer KI und jeglicher KI. „Im Mittelpunkt generativer KI-Anwendungen stehen generative Modelle, die aus tiefen neuronalen Netzen bestehen, die die Struktur ihrer umfangreichen Trainingsdaten lernen und dann auf der Grundlage des Gelernten neue Daten generieren.“

Dr. Turk wies auch auf weit verbreitete Bedenken hinsichtlich generativer Systeme hin, die sowohl auf Ausfälle der Systeme selbst zurückzuführen seien, etwa solche, die nicht existierende Rechtsdokumente zitieren, als auch auf deren Nutzung durch böswillige Akteure zur Generierung gefälschter Inhalte, etwa gefälschter Audio- oder Audioinhalte Videos von Politikern oder Prominenten.

„Konkret“, sagte Dr. Turk, „wird sich diese Sitzung auf den Einsatz generativer KI in der Wissenschaft konzentrieren, sowohl als transformative Kraft bei der Verfolgung der Wissenschaft als auch als potenzielles Risiko einer Störung.“

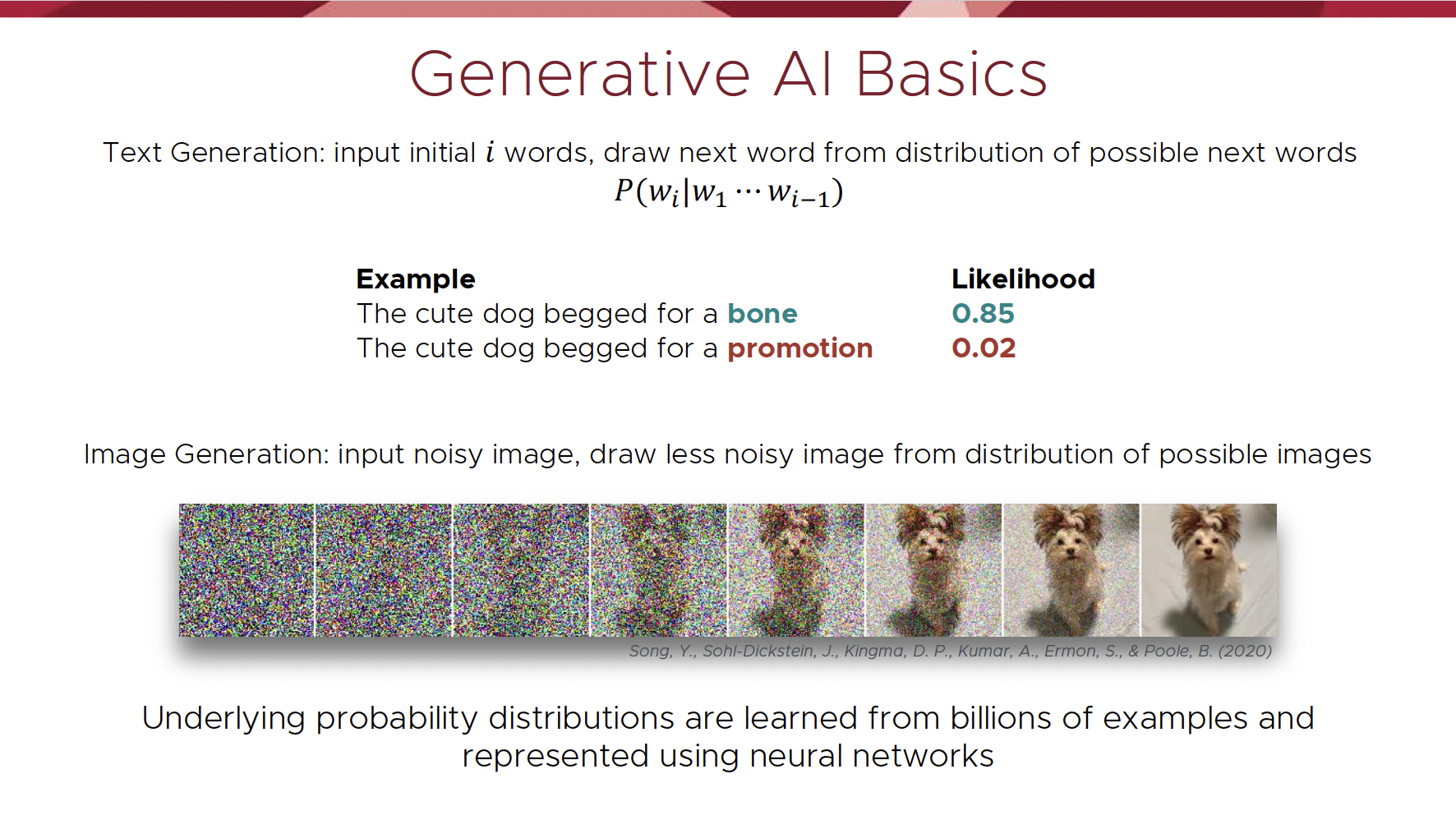

Dr. Rebecca Willett begann ihren Vortrag mit der Darstellung, wie generative KI zur Unterstützung des wissenschaftlichen Entdeckungsprozesses eingesetzt werden kann. Sie konzentrierte sich zunächst auf die Funktionsweise generativer Modelle. Das folgende Bild von Dr. Willetts Folien zeigt, wie ein Sprachmodell wie ChatGPT die Wahrscheinlichkeit des Auftretens eines Wortes bei gegebener vorheriger Wortmenge bewertet und wie ein Bildgenerierungsmodell wie DALL-E 2 ein Bild generiert aus einer gegebenen Eingabeaufforderung mithilfe von Wahrscheinlichkeitsverteilungen, die während des Trainings aus Milliarden von Bildern gelernt wurden.

„Unter Verwendung dieses Prinzips der Wahrscheinlichkeitsverteilung, das allen generativen Modellen zugrunde liegt, können diese Modelle auf Moonshot-Ideen in den Wissenschaften angewendet werden, wie etwa die Generierung möglicher Klimaszenarien unter Berücksichtigung des aktuellen Klimas und potenzieller Richtlinien oder die Generierung neuer Mikrobiome mit gezielter Funktionalität, wie z eines, das beim Abbau von Kunststoffen besonders wirksam ist“, sagt Dr. Willett.

Es reicht jedoch nicht aus, für die wissenschaftliche Forschung handelsübliche generative Tools wie ChatGPT oder DALL-E 2 zu verwenden. Diese Werkzeuge wurden in einem Umfeld entwickelt, das sich stark von dem Kontext unterscheidet, in dem Wissenschaftler tätig sind. Ein offensichtlicher Unterschied zwischen einem generativen Standardmodell und einem wissenschaftlichen Modell sind die Daten. In der Wissenschaft gibt es oft nur sehr wenige Daten, auf denen sich Hypothesen stützen lassen. Wissenschaftliche Daten stammen typischerweise aus Simulationen und Experimenten, die oft teuer und zeitaufwändig sind. Aufgrund dieser Einschränkungen müssen Wissenschaftler sorgfältig auswählen, welche Experimente durchgeführt werden sollen und wie die Effizienz und der Nutzen dieser Systeme maximiert werden können. Im Gegensatz dazu legen Standardmodelle viel weniger Wert darauf, woher die Daten stammen, als vielmehr auf die Maximierung der Datenmenge, mit der sie arbeiten können. In der Wissenschaft sind die Genauigkeit von Datensätzen und deren Herkunft unglaublich wichtig, da Wissenschaftler ihre Forschung mit belastbaren empirischen Beweisen begründen müssen.

„Außerdem verfolgen wir in den Naturwissenschaften andere Ziele als nur die Produktion plausibler Dinge“, sagt Dr. Willett. „Wir müssen verstehen, wie Dinge außerhalb des Bereichs dessen funktionieren, was wir bisher beobachtet haben.“ Dieser Ansatz steht im Widerspruch zu generativen KI-Modellen, die Daten als repräsentativ für das gesamte Spektrum wahrscheinlicher Beobachtungen behandeln. Durch die Einbeziehung physikalischer Modelle und Einschränkungen in die generative KI wird sichergestellt, dass physikalische Phänomene besser dargestellt werden.

Wissenschaftliche Modelle müssen auch in der Lage sein, seltene Ereignisse zu erfassen. „Wir können viele seltene Ereignisse getrost ignorieren, wenn wir ChatGPT trainieren, aber im Gegensatz dazu sind seltene Ereignisse oft das, was uns im wissenschaftlichen Kontext am meisten interessiert, etwa in einem Klimamodell, das seltene Wetterereignisse vorhersagt.“ Wenn wir ein generatives Modell verwenden, das seltene Ereignisse vermeidet und beispielsweise niemals einen Hurrikan vorhersagt, dann wird dieses Modell in der Praxis keinen großen Nutzen haben.“

Eine damit verbundene Herausforderung besteht in der Entwicklung generativer KI-Modelle für chaotische Prozesse, die empfindlich auf Anfangsbedingungen reagieren. Dr. Willett zeigte das Video unten, das zwei Teilchen zeigt, die sich gemäß den Lorenz-63-Gleichungen im Raum bewegen. Diese Gleichungen sind deterministisch und nicht zufällig, aber bei zwei leicht unterschiedlichen Startorten können Sie sehen, dass sich die beiden Teilchen zu jedem Zeitpunkt an sehr unterschiedlichen Orten befinden können. Die Entwicklung generativer KI-Modelle, die den genauen Verlauf solcher Prozesse vorhersagen, die in der Klimawissenschaft, bei Turbulenzen und in der Netzwerkdynamik auftreten, ist grundsätzlich schwierig, aber neuartige Ansätze zur generativen Modellierung können sicherstellen, dass generierte Prozesse wichtige statistische Merkmale mit echten wissenschaftlichen Daten teilen.

[Eingebetteten Inhalt]

Abschließend ging Dr. Willett auf die Tatsache ein, dass wissenschaftliche Daten häufig einen enormen Bereich räumlicher und zeitlicher Skalen abdecken. In der Materialwissenschaft beispielsweise untersuchen Forscher Materialien im Nanometerbereich von Monomeren bis hin zu Großsystemen wie einem ganzen Flugzeug. „Dieser Skalenbereich unterscheidet sich stark von den Daten, die in Standardmodellen verwendet werden, und wir müssen darüber nachdenken, wie wir diese generativen Modelle so aufbauen, dass diese Interaktionen zwischen den Skalen genau beeinflusst werden.“

„Generative Modelle sind die Zukunft der Wissenschaft“, sagt Dr. Willett, „aber um sicherzustellen, dass sie effektiv genutzt werden, müssen wir grundlegende Fortschritte in der KI machen und über das Einbinden von Daten in ChatGPT hinausgehen.“

Vielen Dank fürs Lesen. Bitte schalten Sie morgen ein, um die Zusammenfassung von Dr. Markus Buehlers Präsentation zum Thema „Generative KI in der Mechanobiologie“ zu lesen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://feeds.feedblitz.com/~/873922907/0/cccblog~CCC-AAAS-Generative-AI-in-Science-Promises-and-Pitfalls-Recap-Part-One/