Marley Stevens hat gepostet ein Video auf TikTok letztes Semester, das sie als öffentliche Ankündigung für jeden College-Studenten bezeichnete. Ihre Botschaft: Verwenden Sie keine Software zur Grammatikprüfung, wenn Ihr Professor Ihre Arbeit möglicherweise durch ein KI-Erkennungssystem laufen lässt.

Stevens ist Studentin an der University of North Georgia und äußerte sich ungewöhnlich öffentlich zu dem, was sie als „Debakel“ bezeichnete, bei dem ihr vorgeworfen wurde, mithilfe von KI einen Aufsatz geschrieben zu haben, den sie ihrer Meinung nach selbst verfasst hatte, ohne dabei die Standardgrammatik zu verwenden. und Rechtschreibprüfungsfunktionen von Grammarly, die sie als Erweiterung in ihrem Webbrowser installiert hat.

Das erste Warnvideo, das sie gepostet hat, wurde mehr als 5.5 Millionen Mal angesehen, und seitdem hat sie mehr als 25 Folgevideos erstellt, in denen sie auf Kommentare von Followern reagiert und ihren Streit mit der Hochschule über das Problem dokumentiert – einschließlich der Weitergabe von Bildern von E-Mails, die an sie gesendet wurden von akademischen Dekanen und Bildern ihrer studentischen Arbeit, um zu versuchen, ihren Fall zu beweisen – um das Bewusstsein für die ihrer Meinung nach fehlerhaften KI-Erkennungstools zu schärfen, die zunehmend von Hochschulen sanktioniert und von Professoren verwendet werden.

Stevens sagt, dass ein Professor in einem Strafjustizkurs, den sie letztes Jahr belegte, ihr eine Null auf einer Arbeit gegeben habe, weil er sagte, dass das KI-Erkennungssystem in Turnitin sie als von Robotern geschrieben gekennzeichnet habe. Stevens besteht darauf, dass die Arbeit vollständig ihre eigene ist und dass sie weder ChatGPT noch einen anderen Chatbot verwendet hat, um irgendeinen Teil ihrer Arbeit zu verfassen.

@m.stevens03 #granmerly #ai #künstliche Intelligenz #fyp #pssa ♬ Originalton – Marley Stevens

Aufgrund der Null auf dem Papier sei ihre Abschlussnote in der Klasse so niedrig gesunken, dass sie sich nicht für die Prüfung qualifizieren konnte HOPE-Stipendium, was von den Schülern einen Notendurchschnitt von 3.0 verlangt. Und sie sagt, die Universität habe sie wegen Verstoßes gegen ihre Richtlinien zu akademischem Fehlverhalten auf Bewährung geschickt und sie müsse 105 US-Dollar zahlen, um an einem Seminar über Betrug teilzunehmen.

Die Universität lehnte wiederholte Anfragen von EdSurge ab, über ihre Richtlinien zur Verwendung der KI-Erkennung zu sprechen. Beamte schickten stattdessen eine Erklärung, in der es hieß, dass die Bundesgesetze zum Schutz der Privatsphäre von Studierenden es ihnen verbieten, sich zu einzelnen Betrugsvorfällen zu äußern, und dass: „Unsere Fakultät kommuniziert spezifische Richtlinien zum Einsatz von KI für verschiedene Kurse, und diese Richtlinien sind in den Lehrplänen enthalten.“ Auch der unangemessene Einsatz von KI wird in unserem Artikel thematisiert Verhaltenskodex für Studenten"

Der Abschnitt dieses Verhaltenskodex für Studenten definiert Plagiat als: „Verwendung der Ideen oder Äußerungen einer anderen Person oder Agentur (einschließlich künstlicher Intelligenz) ohne Angabe der Quelle.“ Themen, Aufsätze, Hausarbeiten, Tests und andere ähnliche Anforderungen müssen die Arbeit des Studenten sein, der sie einreicht. Wenn direkte Zitate oder Paraphrasen verwendet werden, müssen diese angegeben werden, und wenn die Ideen anderer in die Arbeit eingearbeitet werden, müssen sie angemessen gewürdigt werden. Alle Arbeiten eines Studierenden müssen im Original vorliegen oder entsprechend den Anforderungen des Dozenten zitiert werden, andernfalls gelten sie als Plagiat. Unter Plagiaten versteht man unter anderem die Verwendung von veröffentlichten oder unveröffentlichten Werken einer anderen Person durch Paraphrase oder direktes Zitat ohne vollständige und klare Anerkennung. Dazu gehört auch die unangemeldete Verwendung von Materialien, die von einer anderen Person oder Agentur beim Verkauf von Hausarbeiten oder anderen akademischen Materialien erstellt wurden.“

Der Vorfall wirft komplexe Fragen darüber auf, wo Grenzen in Bezug auf neue KI-Tools gezogen werden sollen. Wann helfen sie lediglich auf akzeptable Weise, und wann stellt ihr Einsatz wissenschaftliches Fehlverhalten dar? Schließlich nutzen viele Menschen Autokorrekturfunktionen für Grammatik und Rechtschreibung in Systemen wie Google Docs und anderen Programmen, die beim Tippen ein Wort oder einen Satz vorschlagen. Ist das Betrug?

Und da solche Grammatikfunktionen immer robuster werden, da generative KI-Tools immer mehr zum Mainstream werden, stellt sich die Frage, ob KI-Erkennungstools möglicherweise den Unterschied zwischen akzeptabler KI-Nutzung und Betrug erkennen können?

„Andere Lehrer an derselben Universität haben mir empfohlen, [Grammarly] für Arbeiten zu verwenden“, sagte Stevens ein weiteres Video. „Wollen sie uns also sagen, dass wir keine Autokorrektur oder Rechtschreibprüfung oder so etwas verwenden können? Was sollen wir tun? Es etwa in eine Notes-App eingeben und auf diese Weise umwandeln?“

In einem Interview mit EdSurge drückte es der Student so aus:

„Meine Meinung ist, dass KI-Detektoren Müll sind und wir als Studenten nicht viel dagegen tun können“, sagt sie. „Und das ist nicht fair, weil wir all diese Arbeit machen und so viel Geld bezahlen, um aufs College zu gehen, und dann kann ein KI-Detektor Ihre gesamte College-Karriere ziemlich vermasseln.“

Drehungen und Wendungen

Unterwegs nahm die Geschichte dieses Studenten der University of North Georgia einige überraschende Wendungen.

Zum einen verschickte die Universität eine E-Mail an alle Studierenden zum Thema KI, kurz nachdem Stevens ihr erstes virales Video gepostet hatte.

In dieser E-Mail wurden die Studenten daran erinnert, sich an den akademischen Verhaltenskodex der Universität zu halten, und sie enthielt auch eine ungewöhnliche Warnung: „Bitte beachten Sie, dass einige Online-Tools, die Studenten bei Grammatik, Zeichensetzung, Satzstruktur usw. unterstützen, generative künstliche Intelligenz (KI) nutzen ); die von Turnitin markiert werden können. Eine der am häufigsten verwendeten generativen KI-Websites, die von Turnitin.com gemeldet wird, ist Grammarly. Bitte seien Sie vorsichtig, wenn Sie diese Websites in Betracht ziehen.“

Der Professor teilte der Studentin später mit, dass er ihre Arbeit auch mit einem anderen Tool, Copyleaks, überprüft habe und dass ihre Arbeit ebenfalls als von Bots geschrieben gekennzeichnet worden sei. Und sie sagt, als sie ihren Aufsatz kürzlich über Copyleaks veröffentlichte, sei die Arbeit als von Menschen geschrieben eingestuft worden. Sie schickte diesem Reporter einen Screenshot dieses Prozesses, auf dem das Tool in grüner Schrift zu dem Schluss kommt: „Das ist menschlicher Text.“

„Wenn ich es jetzt durchführe und ein anderes Ergebnis bekomme, zeigt das nur, dass diese Dinge nicht immer genau sind“, sagt sie über KI-Detektoren.

Beamte von Copyleaks antworteten nicht auf Anfragen nach Kommentaren. Stevens lehnte es ab, den vollständigen Text ihrer Arbeit zu teilen, und erklärte, sie wolle nicht, dass dieser im Internet lande, wo andere Studenten ihn kopieren könnten, was ihr möglicherweise noch mehr Ärger mit ihrer Universität bescheren könne. „Ich befinde mich bereits in der akademischen Bewährung“, sagt sie.

Stevens sagt, sie habe von Studenten im ganzen Land gehört, die sagen, dass ihnen aufgrund von KI-Erkennungssoftware auch fälschlicherweise Betrug vorgeworfen wurde.

„Eine Schülerin sagte, sie wolle Ärztin werden, wurde aber angeklagt, und dann wollte keine der Schulen sie wegen ihres Vorwurfs wegen Fehlverhaltens aufnehmen“, sagt Stevens.

Stevens sagt, sie sei überrascht gewesen, wie viel Unterstützung sie von den Leuten erhalten habe, die sich ihre Videos angesehen hätten. Ihre Follower in den sozialen Medien ermutigten sie, eine zu gründen GoFundMe Kampagne, was sie tat, um den Verlust ihres Stipendiums abzudecken und einen Anwalt zu bezahlen, der möglicherweise rechtliche Schritte gegen die Universität einleiten könnte. Bisher hat sie mehr als 6,100 US-Dollar von mehr als 90 Menschen gesammelt.

Sie war auch überrascht, als sie von Beamten von Grammarly kontaktiert wurde, die 4,000 US-Dollar an GoFundMe spendeten und sie als Studentenbotschafterin engagierten. Aus diesem Grund plant Stevens nun, drei Werbevideos für Grammarly zu drehen, für die sie jeweils ein kleines Honorar erhält.

„Derzeit versuchen wir zusammenzuarbeiten, um Hochschulen dazu zu bringen, ihre KI-Richtlinien zu überdenken“, sagt Stevens.

Für Grammarly scheint es klar zu sein, dass das Ziel darin besteht, die Erzählung gegenüber dem ersten Video von Stevens zu ändern, in dem sie sagte: „Wenn Sie einen Aufsatz, einen Aufsatz, einen Diskussionsbeitrag oder irgendetwas haben, das an TurnItIn übermittelt wird, deinstallieren Sie Grammarly jetzt.“ .“

Die Bildungsleiterin von Grammarly, Jenny Maxwell, sagt, dass sie hofft, die Botschaft darüber zu verbreiten, wie ungenau KI-Detektoren sind.

„Vielen Institutionen auf Fakultätsebene ist nicht bewusst, wie oft diese KI-Erkennungsdienste falsch sind“, sagt sie. „Wir möchten sicherstellen, dass Institutionen sich darüber im Klaren sind, wie gefährlich es sein kann, diese KI-Detektoren als einzige Quelle der Wahrheit zu nutzen.“

Es gab solche Mängel gut dokumentiert, und mehrere Forscher haben gesagt, dass Professoren die Tools nicht verwenden sollten. Sogar Turnitin hat öffentlich erklärt, dass sein KI-Erkennungstool ist nicht immer zuverlässig.

Annie Chechitelli, Chief Product Officer von Turnitin, sagt, dass die KI-Erkennungstools den Tests des Unternehmens zufolge eine Falsch-Positiv-Rate von etwa 1 Prozent aufweisen und dass man daran arbeitet, diese so niedrig wie möglich zu halten.

„Wir lassen wahrscheinlich etwa 15 Prozent [des Bot-geschriebenen Textes] unmarkiert durchgehen“, sagt sie. „Wir würden lieber unsere Genauigkeit verringern, als unsere Falsch-Positiv-Rate zu erhöhen.“

Chechitelli betont, dass Pädagogen das Erkennungssystem von Turnitin als Ausgangspunkt für ein Gespräch mit einem Studenten nutzen sollten und nicht als endgültige Entscheidung über die akademische Integrität der Arbeit des Studenten. Und sie sagt, dass dies auch der Rat des Unternehmens für sein Plagiatserkennungssystem gewesen sei.

„Wir mussten den Lehrern unbedingt beibringen, dass dies kein Beweis dafür ist, dass der Schüler betrogen hat“, sagt sie. „Wir haben immer gesagt, dass der Lehrer eine Entscheidung treffen muss.“

Chechitelli räumt ein, dass KI die Lehrkräfte bei diesem Gespräch jedoch vor eine größere Herausforderung stellt. In Fällen, in denen das Turnitin-Tool Plagiate erkennt, verweist das System auf Quellmaterial, das der Schüler möglicherweise kopiert hat. Im Fall der KI-Erkennung gibt es kein eindeutiges Quellmaterial, auf das man achten könnte, da Tools wie ChatGPT jedes Mal, wenn ein Benutzer eine Eingabeaufforderung eingibt, unterschiedliche Antworten ausspucken, wodurch es viel schwieriger wird, nachzuweisen, dass ein Bot die Quelle ist.

Der Turnitin-Beamte sagt, dass bei den internen Tests des Unternehmens herkömmliche Tools zur Grammatikprüfung keine Alarme auslösten.

Maxwell von Grammarly weist darauf hin, dass selbst wenn ein KI-Erkennungssystem in 98 Prozent der Fälle richtig ist, dies bedeutet, dass es beispielsweise 2 Prozent der Arbeiten fälschlicherweise markiert. Und da an einer einzelnen Universität jedes Jahr 50,000 studentische Arbeiten eingereicht werden können, bedeutet das, dass, wenn alle Professoren ein KI-Erkennungssystem verwenden würden, 1,000 Arbeiten fälschlicherweise als Fälle von Betrug eingestuft würden.

Befürchtet Maxwell, dass Hochschulen von der Verwendung ihres Produkts abraten könnten? Schließlich hat die University of North Georgia kürzlich Grammarly von einer Liste empfohlener Ressourcen gestrichen, nachdem die TikTok-Videos von Stevens viral gingen, sie hat es aber später wieder hinzugefügt.

„Wir haben uns mit der University of North Georgia getroffen und sie sagten, das habe nichts mit Grammarly zu tun“, sagt Maxwell. „Wir freuen uns, dass immer mehr Professoren und Studenten den gegenteiligen Standpunkt vertreten und sagen: ‚Dies ist die neue Arbeitswelt und wir müssen herausfinden, wie wir diese Tools angemessen einsetzen.‘ Man kann die Zahnpasta nicht zurück in die Tube geben.“

Für Tricia Bertram Gallant, Direktorin des Academic Integrity Office an der University of California San Diego und nationale Expertin für Betrug, geht es im Fall dieses Studenten nicht um die Technologie. Sie sagt, die größere Frage sei, ob Hochschulen wirksame Systeme für den Umgang mit Anklagen wegen akademischen Fehlverhaltens hätten.

„Ich bezweifle sehr, dass einem Schüler allein aufgrund einer Grammatik- und Rechtschreibprüfung Betrug vorgeworfen wird“, sagt sie, „aber wenn das wahr ist, sind nicht die KI-Chatbots das Problem, sondern die Richtlinien und der Prozess.“

„Wenn ein Fakultätsmitglied ein Werkzeug benutzen, einen Studenten beschuldigen und ihm eine Null geben kann und es erledigt ist, ist das ein Problem“, sagt sie. „Das ist kein Werkzeugproblem.“

Sie sagt, dass sich KI-Tools konzeptionell nicht von anderen Methoden unterscheiden, mit denen Schüler jahrelang betrogen haben, wie zum Beispiel Sie beauftragen andere Studenten, ihre Arbeiten für sie zu schreiben.

„Es kommt mir seltsam vor, wenn Hochschulen eine ganz eigene Richtlinie für den Einsatz von KI entwickeln“, sagt sie. „Wir haben in unserer Richtlinie lediglich das Wort ‚Maschine‘ hinzugefügt“, fügt sie hinzu und weist darauf hin, dass die Richtlinie zur akademischen Integrität jetzt ausdrücklich verbietet, eine Maschine für Arbeiten zu verwenden, die für den Studenten bestimmt sind.

Sie schlägt vor, dass Studierende darauf achten sollten, Aufzeichnungen darüber zu führen, wie sie die ihnen helfenden Tools verwenden, auch wenn ein Professor den Einsatz von KI für die Aufgabe zulässt. „Sie sollten sicherstellen, dass sie ihren Chat-Verlauf behalten“ in ChatGPT, sagt sie, „damit ein Gespräch über ihren Prozess geführt werden kann“, falls später Fragen aufgeworfen werden.

Eine sich schnell verändernde Landschaft

Während es schon seit Jahren Grammatik- und Rechtschreibprüfungen gibt, fügen viele von ihnen jetzt neue KI-Funktionen hinzu, die es Professoren erschweren, zu verstehen, ob Studierende hinter der Arbeit, die sie abgeben, nachgedacht haben.

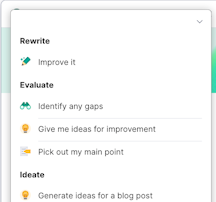

Zum Beispiel verfügt Grammarly jetzt über neue Optionen, die meisten davon in einer kostenpflichtigen Version, die Stevens nicht abonniert hat und die generative KI nutzen, um Dinge wie „Beim Brainstorming von Themen für eine Aufgabe zu helfen“ oder „einen Forschungsplan zu erstellen“ als eine aktuelle Pressemitteilung von der Firma sagte es.

Maxwell von Grammarly sagt, dass das Unternehmen versucht, diese neuen Funktionen sorgfältig einzuführen und Schutzmaßnahmen einzubauen, um zu verhindern, dass Schüler den Bot einfach bitten, ihre Arbeit für sie zu erledigen. Und sie sagt, dass Schulen die generativen KI-Funktionen deaktivieren können, wenn sie das Tool übernehmen. „Ich bin Mutter eines 14-Jährigen“, sagt sie und fügt hinzu, dass jüngere Schüler, die noch die Grundlagen lernen, andere Bedürfnisse haben als ältere Lernende.

Chechitelli von Turnitin sagt, es sei ein Problem für Studenten, dass Grammarly und andere Produktivitätstools jetzt ChatGPT integrieren und weit mehr tun, als nur die Syntax des Schreibens zu korrigieren. Das liegt daran, dass die Schüler ihrer Meinung nach die neuen Funktionen und ihre Auswirkungen möglicherweise nicht verstehen.

„Eines Tages melden sie sich an und haben neue Möglichkeiten, und zwar andere“, sagt sie. „Ich finde es verwirrend.“

Für den Turnitin-Leiter ist die wichtigste Botschaft für Pädagogen heute die Transparenz darüber, welche Hilfe KI gegebenenfalls leistet.

„Mein Rat wäre, sorgfältig über die Tools nachzudenken, die Sie verwenden, und sicherzustellen, dass Sie den Lehrern die Entwicklung Ihrer Aufgaben zeigen oder Fragen beantworten können“, sagt sie.

Gallant, der nationale Experte für akademische Integrität, sagt, dass Professoren sich der wachsenden Zahl generativer KI-Tools bewusst sein müssen, zu denen Studenten Zugang haben.

„Grammatik geht weit über Grammatik und Rechtschreibprüfung hinaus“, sagt sie. „Grammatik ist wie jedes andere Werkzeug – es kann ethisch oder unethisch verwendet werden. Es kommt darauf an, wie sie verwendet werden oder wie ihre Verwendung verschleiert wird.“

Gallant sagt, dass sogar Professoren bei ihren eigenen Schriften und Veröffentlichungen in Fachzeitschriften an diese ethischen Grenzen stoßen. Sie sagt, sie habe von Professoren gehört, die ChatGPT beim Verfassen von Zeitschriftenartikeln verwenden und dann „vergessen, Beiträge herauszunehmen, wenn die KI Ideen vorgeschlagen hat“.

Die Leichtigkeit, mit der diese neuen generativen KI-Tools gut formatierte Texte ausspucken können, habe etwas Verführerisches, fügt sie hinzu, und das könne Menschen denken lassen, sie würden Arbeit erledigen, obwohl sie lediglich eine Eingabeaufforderung in eine Maschine eingeben.

„Es gibt diesen Mangel an Selbstregulierung – bei allen Menschen, aber insbesondere bei Anfängern und jungen Menschen – zwischen dem Zeitpunkt, an dem sie mir hilft, und dem Zeitpunkt, an dem sie die Arbeit für mich erledigt“, sagt Gallant.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.edsurge.com/news/2024-04-04-can-using-a-grammar-checker-set-off-ai-detection-software