KI-Modelle kommen gut zurecht, wenn sie mit Text oder Bildern dazu aufgefordert werden, und können sogar komplexe Probleme lösen, wenn sie keine schrecklichen Fehler machen.

OpenAI zum Beispiel hat sagte dass sein GPT-4-Modell bei der SAT-Matheprüfung 700 von 800 Punkten erreicht hat. Allerdings haben sich nicht alle derartigen Behauptungen bestätigt: Ein im Juni veröffentlichtes Papier, in dem es hieß, GPT-4 könne einen Abschluss in Informatik am MIT erhalten, war der Fall anschließend zurückgezogen.

Um besser einschätzen zu können, wie große Sprachmodelle – die Texteingaben interpretieren – und große multimodale Modelle – die Texte, Bilder und vielleicht auch andere Eingabeformen interpretieren – tatsächlich mit der Problemlösung umgehen, hat eine Gruppe von zehn Forschern der University of California, Los Angeles, Die University of Washington und Microsoft Research haben einen Test-Benchmark namens entwickelt MathVista das sich auf visuell orientierte Herausforderungen konzentriert.

„Die Fähigkeit dieser Basismodelle, mathematisches Denken in visuellen Kontexten durchzuführen, wurde nicht systematisch untersucht“, sagen die Autoren – Pan Lu, Hritik Bansal, Tony Xia, Jiacheng Liu, Chunyuan Li, Hannaneh Hajishirzi, Hao Cheng, Kai-Wei Chang , Michel Galley und Jianfeng Gao, in einem Vorabdruck Krepppapier [PDF].

Daher sei es wichtig, einen neuen Maßstab zu entwickeln, um die Entwicklung des mathematischen Denkens mit einer visuellen Komponente zu unterstützen und den Vergleich verschiedener Modelle bei Denkaufgaben zu bewerten.

Der Nachweis, dass das eigene KI-Modell visuelle Probleme richtig lösen kann, kann sich als hilfreich erweisen, um festzustellen, ob es sinnvoll ist, beispielsweise auf Software zu vertrauen, die das Autofahren ohne Software ermöglicht oben anhalten ein Unfallopfer.

MathVista umfasst 6,141 Beispiele, die aus 28 multimodalen Datensätzen und aus drei neuen Datensätzen namens IQTest, FunctionQA und PaperQA entwickelt wurden. Es deckt verschiedene Formen des Denkens ab (algebraisches, arithmetisches, geometrisches, logisches, numerisches, wissenschaftliches und statistisches Denken), wobei der Schwerpunkt auf der Beantwortung von Zahlenfragen, der Lösung von Geometrieproblemen, mathematischen Wortproblemen, Lehrbuchfragen und visuellen Fragen liegt.

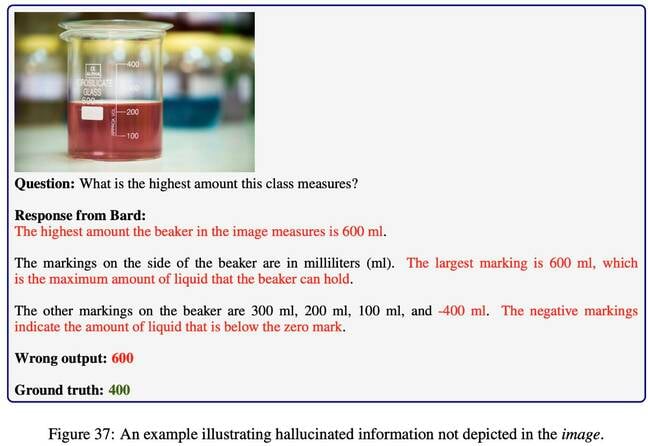

Die Forscher testeten ein Dutzend Basismodelle: drei LLMs ChatGPT, GPT-4 und Claude-2), zwei proprietäre LMMs (GPT4V und Bard) und sieben Open-Source-LMMs. Sie berücksichtigten auch menschliche Antworten, die von Amazon Mechanical Turkers mit mindestens einem High-School-Abschluss bereitgestellt wurden, sowie zufällige Antworten.

Die gute Nachricht für KI-Praktiker ist, dass die LLMs und LMMs alle besser abgeschnitten haben als zufällige Zufallsfragen, was nicht allzu überraschend ist, wenn man bedenkt, dass es sich bei vielen der Fragen eher um Multiple-Choice-Fragen als um Ja oder Nein handelte.

Tatsächlich gelang es dem Top-Performer, GPT-4V von OpenAI, die menschliche Leistung in bestimmten Bereichen zu übertreffen – bei Fragen mit algebraischem Denken und bei komplexen visuellen Herausforderungen mit Tabellen und Funktionsdiagrammen.

Wir stellen fest, dass Microsoft, dessen Forscher zu diesem Projekt beigetragen haben, einen erheblichen Anteil an OpenAI hat.

Die weniger gute Nachricht ist, dass selbst GPT-4V nur 49.9 Prozent der Fragen richtig beantwortete. Das ist ausreichend, wenn das Ziel der beste multimodale Bard ist, der einen Genauigkeitsprozentsatz von 34.8 Prozent erreichte.

Aber es liegt immer noch hinter den Arbeitern von Amazon Mechanical Turk zurück, die auf die Probe gestellt wurden und eine Punktzahl von 60.3 Prozent erreichten. Wie die Forscher in ihrer Arbeit feststellen, „verbleibt eine Lücke von 10.4 Prozent in der Gesamtgenauigkeit im Vergleich zum menschlichen Ausgangswert, was viel Raum für Modellverbesserungen lässt.“ ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2023/10/29/ai_math_quiz/