Bild vom Autor

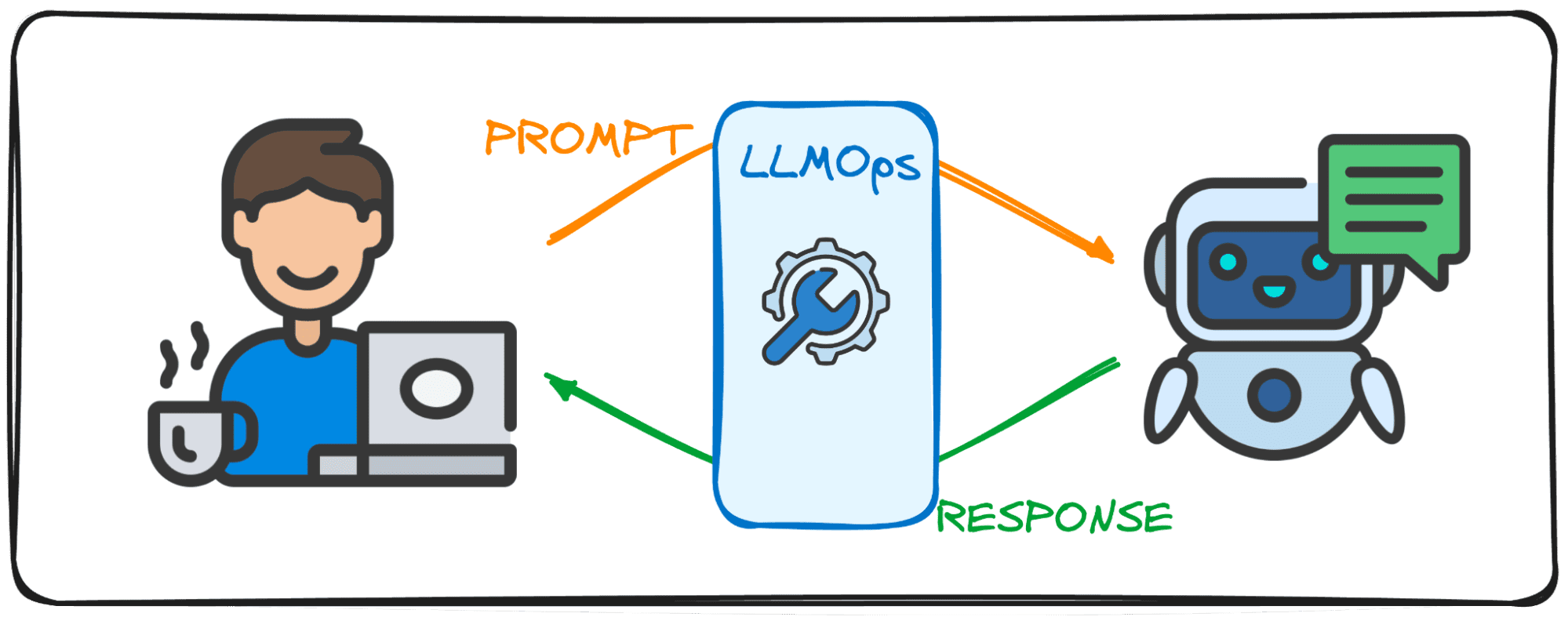

Large Language Models (LLMs) sind eine neue Art künstlicher Intelligenz, die auf riesigen Textdatenmengen trainiert wird. Ihre Hauptfähigkeit besteht darin, als Reaktion auf eine Vielzahl von Aufforderungen und Anfragen menschenähnliche Texte zu generieren.

Ich wette, Sie haben bereits einige Erfahrungen mit beliebten LLM-Lösungen wie ChatGPT oder Google Gemini gemacht.

Aber haben Sie sich jemals gefragt, wie diese leistungsstarken Modelle so blitzschnelle Reaktionen liefern?

Die Antwort liegt in einem Spezialgebiet namens LLMOps.

Bevor wir tiefer eintauchen, versuchen wir uns die Bedeutung dieses Bereichs vorzustellen.

Stellen Sie sich vor, Sie führen ein Gespräch mit einem Freund. Das Normale, was Sie erwarten würden, ist, dass Sie auf eine Frage sofort eine Antwort erhalten und der Dialog mühelos verläuft.

Recht?

Diesen reibungslosen Austausch erwarten Nutzer auch bei der Interaktion mit Large Language Models (LLMs). Stellen Sie sich vor, Sie chatten mit ChatGPT und müssen jedes Mal, wenn wir eine Aufforderung senden, ein paar Minuten warten. Niemand würde es verwenden, zumindest ich nicht mit Sicherheit.

Aus diesem Grund streben LLMs an, diesen Gesprächsfluss und diese Effektivität in ihren digitalen Lösungen mit dem LLMOps-Bereich zu erreichen. Dieser Leitfaden soll Ihr Begleiter bei Ihren ersten Schritten in diesem brandneuen Bereich sein.

LLMOps, die Abkürzung für Large Language Model Operations, ist die Magie hinter den Kulissen, die dafür sorgt, dass LLMs effizient und zuverlässig funktionieren. Es stellt eine Weiterentwicklung der bekannten MLOps dar und wurde speziell für die Bewältigung der einzigartigen Herausforderungen von LLMs entwickelt.

Während sich MLOps auf die Verwaltung des Lebenszyklus allgemeiner Modelle des maschinellen Lernens konzentriert, befasst sich LLMOps speziell mit den LLM-spezifischen Anforderungen.

Bei der Verwendung von Modellen von Entitäten wie OpenAI oder Anthropic über Webschnittstellen oder APIs arbeiten LLMOps im Hintergrund und machen diese Modelle als Dienste zugänglich. Bei der Bereitstellung eines Modells für eine spezielle Anwendung liegt die Verantwortung von LLMOps jedoch bei uns.

Stellen Sie sich das also wie einen Moderator vor, der sich um den Ablauf einer Debatte kümmert. So wie der Moderator dafür sorgt, dass das Gespräch reibungslos verläuft und auf das Thema der Debatte abgestimmt ist, wobei er stets darauf achtet, dass es keine bösen Worte gibt und versucht, Fake News zu vermeiden, stellt LLMOps sicher, dass LLMs mit Höchstleistung arbeiten, nahtlose Benutzererlebnisse liefern und die Sicherheit der LLMs überprüfen Ausgabe.

Das Erstellen von Anwendungen mit Large Language Models (LLMs) bringt andere Herausforderungen mit sich als beim herkömmlichen maschinellen Lernen. Um diese zu bewältigen, wurden innovative Managementtools und -methoden entwickelt, aus denen das LLMOps-Framework hervorgegangen ist.

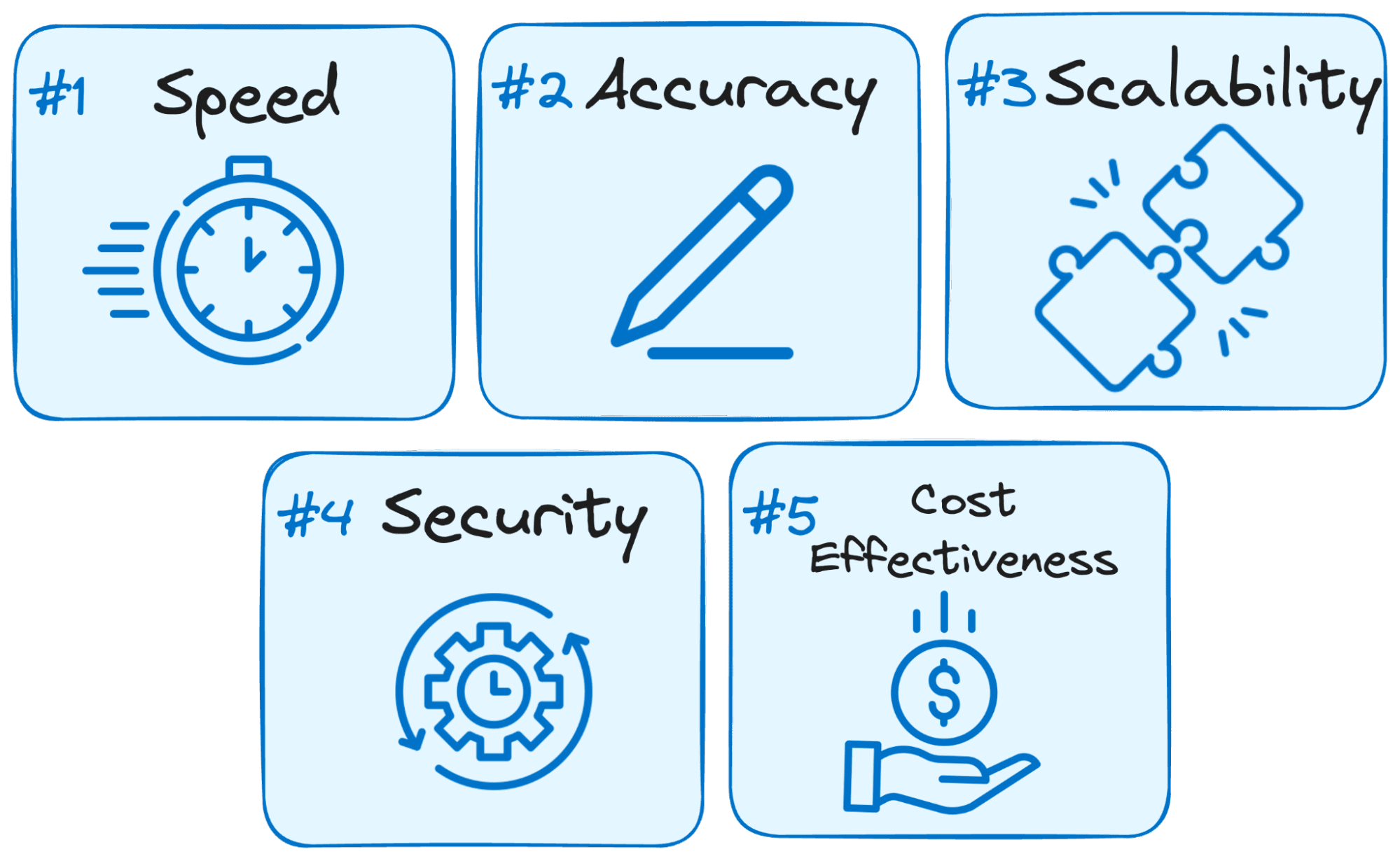

Aus diesem Grund ist LLMOps für den Erfolg jeder LLM-basierten Anwendung von entscheidender Bedeutung:

Bild vom Autor

- Geschwindigkeit ist der Schlüssel: Benutzer erwarten bei der Interaktion mit LLMs sofortige Antworten. LLMOps optimiert den Prozess, um die Latenz zu minimieren und sicherzustellen, dass Sie innerhalb eines angemessenen Zeitrahmens Antworten erhalten.

- Genauigkeit ist wichtig: LLMOps implementiert verschiedene Prüfungen und Kontrollen, um die Genauigkeit und Relevanz der LLM-Antworten zu gewährleisten.

- Skalierbarkeit für Wachstum: Wenn Ihre LLM-Anwendung an Zugkraft gewinnt, hilft Ihnen LLMOps dabei, Ressourcen effizient zu skalieren, um steigende Benutzerlasten zu bewältigen.

- Sicherheit steht an erster Stelle: LLMOps schützt die Integrität des LLM-Systems und schützt sensible Daten durch die Durchsetzung robuster Sicherheitsmaßnahmen.

- Kosteneffektivität: Der Betrieb von LLMs kann aufgrund ihres erheblichen Ressourcenbedarfs finanziell anspruchsvoll sein. LLMOps bringt wirtschaftliche Methoden ins Spiel, um die Ressourcennutzung effizient zu maximieren und sicherzustellen, dass Spitzenleistung nicht geopfert wird.

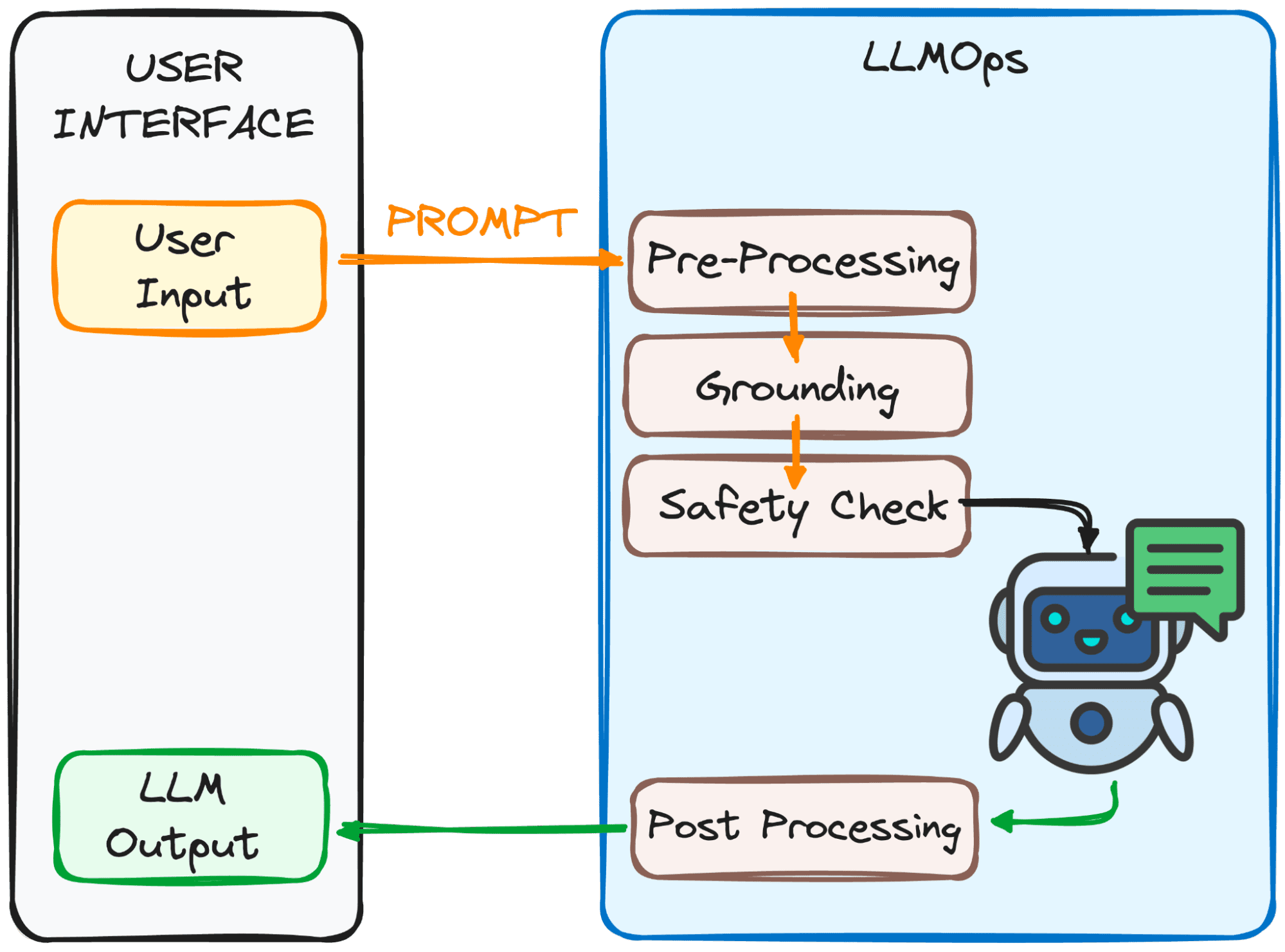

LLMOps stellt sicher, dass Ihre Eingabeaufforderung für das LLM bereit ist und die Antwort so schnell wie möglich bei Ihnen eintrifft. Das ist allerdings gar nicht so einfach.

Dieser Prozess umfasst mehrere Schritte, hauptsächlich 4, die im Bild unten zu sehen sind.

Bild vom Autor

Das Ziel dieser Schritte?

Um die Eingabeaufforderung für das Modell klar und verständlich zu machen.

Hier ist eine Aufschlüsselung dieser Schritte:

1. Vorverarbeitung

Die Eingabeaufforderung durchläuft einen ersten Verarbeitungsschritt. Zunächst wird es in kleinere Stücke (Tokens) zerlegt. Anschließend werden etwaige Tippfehler oder seltsame Zeichen bereinigt und der Text einheitlich formatiert.

Schließlich werden die Token in numerische Daten eingebettet, damit der LLM sie versteht.

2. Erdung

Bevor das Modell unsere Eingabeaufforderung verarbeitet, müssen wir sicherstellen, dass das Modell das Gesamtbild versteht. Dies kann die Bezugnahme auf frühere Gespräche, die Sie mit dem LLM geführt haben, oder die Verwendung externer Informationen beinhalten.

Darüber hinaus identifiziert das System wichtige Dinge, die in der Eingabeaufforderung erwähnt werden (z. B. Namen oder Orte), um die Antwort noch relevanter zu machen.

3. Sicherheitscheck:

Ebenso wie Sicherheitsregeln am Set stellt LLMOps sicher, dass die Eingabeaufforderung ordnungsgemäß verwendet wird. Das System prüft auf Dinge wie vertrauliche Informationen oder potenziell anstößige Inhalte.

Erst nach bestandener Prüfung ist das Prompt bereit für den Hauptakt – das LLM!

Jetzt haben wir unsere Eingabeaufforderung für die Verarbeitung durch das LLM bereit. Allerdings muss auch die Ausgabe analysiert und verarbeitet werden. Bevor Sie es also sehen, werden im vierten Schritt noch ein paar Anpassungen vorgenommen:

3. Nachbearbeitung

Erinnern Sie sich an den Code, in den die Eingabeaufforderung umgewandelt wurde? Die Antwort muss wieder in für Menschen lesbaren Text übersetzt werden. Anschließend optimiert das System die Antwort hinsichtlich Grammatik, Stil und Klarheit.

All diese Schritte erfolgen nahtlos dank LLMOps, dem unsichtbaren Crewmitglied, das für ein reibungsloses LLM-Erlebnis sorgt.

Beeindruckend, oder?

Hier sind einige der wesentlichen Bausteine eines gut konzipierten LLMOps-Setups:

- Auswahl des richtigen LLM: Mit einer großen Auswahl an verfügbaren LLM-Modellen hilft Ihnen LLMOps bei der Auswahl des Modells, das am besten zu Ihren spezifischen Bedürfnissen und Ressourcen passt.

- Feinabstimmung für Spezifität: Mit LLMOps können Sie vorhandene Modelle verfeinern oder Ihre eigenen Modelle trainieren und sie so an Ihren individuellen Anwendungsfall anpassen.

- Schnelles Engineering: LLMOps stattet Sie mit Techniken aus, um effektive Eingabeaufforderungen zu erstellen, die den LLM zum gewünschten Ergebnis führen.

- Bereitstellung und Überwachung: LLMOps rationalisiert den Bereitstellungsprozess und überwacht kontinuierlich die Leistung des LLM, um eine optimale Funktionalität sicherzustellen.

- Sicherheitsmaßnahmen: LLMOps legt großen Wert auf Datensicherheit, indem es robuste Maßnahmen zum Schutz sensibler Informationen implementiert.

Während sich die LLM-Technologie weiterentwickelt, werden LLMOps bei den kommenden technologischen Entwicklungen eine entscheidende Rolle spielen. Der größte Teil des Erfolgs der neuesten beliebten Lösungen wie ChatGPT oder Google Gemini ist ihre Fähigkeit, nicht nur alle Anfragen zu beantworten, sondern auch ein gutes Benutzererlebnis zu bieten.

Aus diesem Grund wird LLMOps durch die Gewährleistung eines effizienten, zuverlässigen und sicheren Betriebs den Weg für noch innovativere und transformativere LLM-Anwendungen in verschiedenen Branchen ebnen, die noch mehr Menschen erreichen werden.

Mit einem soliden Verständnis von LLMOps sind Sie gut gerüstet, um die Leistungsfähigkeit dieser LLMs zu nutzen und bahnbrechende Anwendungen zu erstellen.

Josef Ferrer ist ein Analyseingenieur aus Barcelona. Er hat einen Abschluss in Physik-Ingenieurwesen und arbeitet derzeit im Bereich der Datenwissenschaft für die menschliche Mobilität. Er ist nebenberuflich als Content-Ersteller tätig und konzentriert sich auf Datenwissenschaft und -technologie. Josep schreibt über alles, was mit KI zu tun hat, und behandelt die Anwendung der anhaltenden Explosion in diesem Bereich.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions