Mit zunehmender Verbreitung von MLLM-Modellen wird eines der Hindernisse auf dem Weg der KI immer deutlicher: KI-Halluzination und Specht ist das Lösungsforscher der University of Science and Technology of China (USTC) und des Tencent YouTu Lab haben diese Lösung gefunden.

Multimodale große Sprachmodelle (MLLMs) sind eine Art KI-Modell, das Daten aus mehreren Modalitäten wie Text, Bildern und Videos lernen und verarbeiten kann. Dadurch können sie eine Vielzahl von Aufgaben ausführen, die mit herkömmlichen Sprachmodellen nicht möglich sind, wie z. B. Bildunterschriften, Videozusammenfassungen und Fragenbeantwortungen mit multimodaler Eingabe.

Dank ihrer Fähigkeit, uns eine große Anzahl von Ausgängen zur Verfügung zu stellen, werden MLLM-Modelle in fast jedem „intelligenten“ Gerät verwendet. Mittlerweile laufen auf vielen technischen Wunderwerken, von intelligenten Autos bis hin zu IoT-Geräten wie Alexa, MLLM-Modelle. Dies bedeutet jedoch nicht, dass diese Modelle lästige und sich wiederholende Fehler vermeiden können.

KI-Halluzinationen sind wie eine quietschende Tür ein Problem von MLLM-Modellen, das wir ignorieren, uns aber auch ärgern. Denken Sie darüber nach, wie oft ein Chatbot geliked hat ChatGPT Sie geben auf Ihre Frage keine richtige Antwort oder Zwischendurch Konnte nicht das perfekte Bild für Sie generieren? Warum ist schnelles Engineering gerade einen seriösen Job? Warum sind KI-Technologien sind nicht bereit für reale Anwendungen? Es hängt alles mit den Unvollkommenheiten der MLLM-Technologien zusammen, aber Woodpecker ist das perfekte potenzielle Heilmittel für eine fehlerhafte KI.

Woodpecker heilt KI-Modelle wie einen Baum

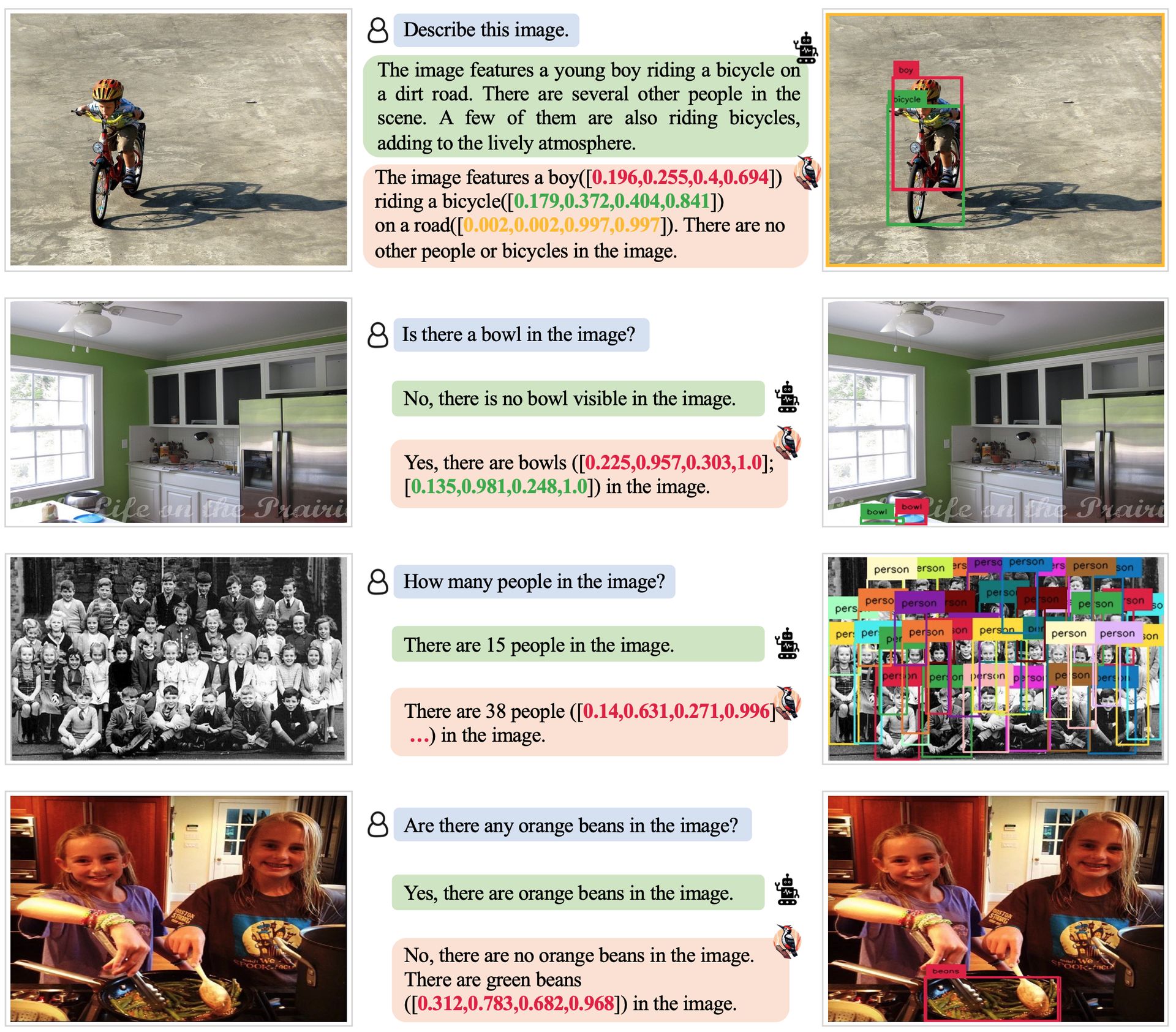

Das Phänomen der Halluzinationen bei MLLMs steht zunehmend im Fokus, und frühere Forschungen haben sich mit Bewertungs-/Erkennungs- und Eindämmungsstrategien befasst. Allerdings zielt Woodpeckers Arbeit darauf ab, die Reaktionen von MLLMs zu verfeinern, indem die halluzinierten Teile unter Verwendung eines trainingsfreien Rahmens modifiziert werden. Darüber hinaus wurde die Nutzung von Wissen in MLLMs zur Linderung sachlicher Halluzinationen untersucht, die Übertragung dieser Idee auf den Bereich Vision-Sprache ist jedoch eine Herausforderung.

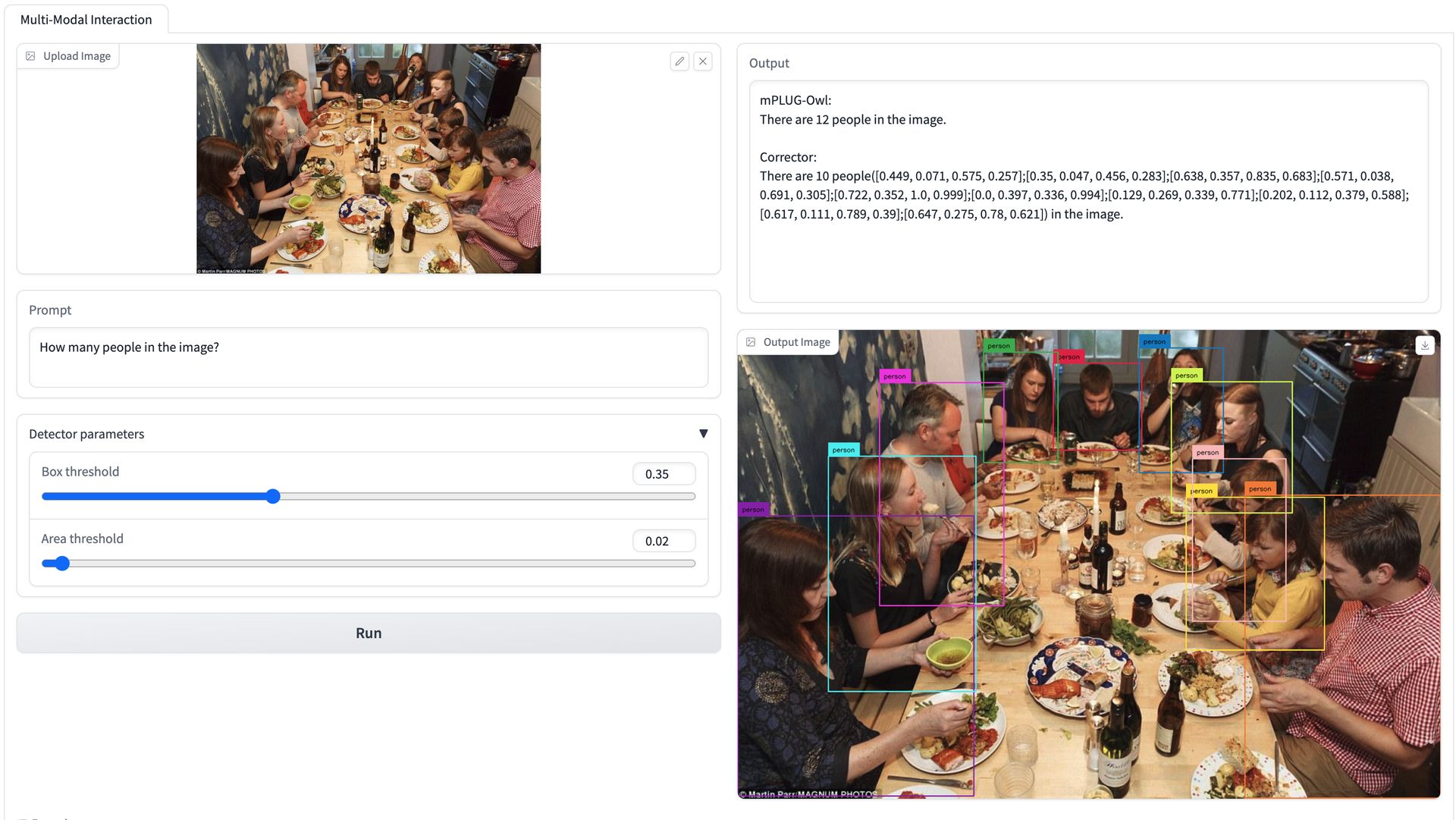

Das vorgeschlagene Framework von Woodpecker nutzt LLMs, um das visuelle Denken zu unterstützen und visuelle Halluzinationen in MLLM-Reaktionen zu korrigieren. Das Framework besteht aus fünf Unteraufgaben: Schlüsselkonzeptextraktion, Frageformulierung, visuelle Wissensvalidierung, visuelle Anspruchsgenerierung und Halluzinationskorrektur.

Woodpecker funktioniert, indem es die folgenden fünf Schritte befolgt:

- Extraktion von Schlüsselkonzepten: Woodpecker extrahiert Schlüsselkonzepte aus der Antwort des MLLM. Diese Konzepte werden verwendet, um Halluzinationen zu diagnostizieren und Fragen zu ihrer Beantwortung zu generieren

- Frageformulierung: Woodpecker formuliert Fragen, um Halluzinationen auf Objekt- und Attributebene anzusprechen. Diese Fragen sollen mithilfe der Objekterkennung und eines VQA-Modells beantwortet werden

- Visuelle Wissensvalidierung: Woodpecker verwendet Objekterkennung und ein VQA-Modell, um die in Schritt 2 formulierten Fragen zu beantworten. Dies hilft, das visuelle Wissen zu validieren und mögliche Halluzinationen zu identifizieren

- Visuelle Anspruchsgenerierung: Woodpecker generiert visuelle Behauptungen, indem er die Fragen und Antworten aus Schritt 3 kombiniert. Diese visuellen Behauptungen werden verwendet, um Halluzinationen in der Antwort des MLLM zu korrigieren

- Halluzinationskorrektur: Woodpecker verwendet ein LLM, um Halluzinationen in der Reaktion des MLLM basierend auf den visuellen Behauptungen zu korrigieren. Dabei werden die halluzinierten Teile der Reaktion verändert, um sie mit dem visuellen Wissen in Einklang zu bringen

Das ultimative Ziel all dieser Maßnahmen ist der Aufbau einer strukturierten visuellen Wissensbasis, die sich speziell auf das Bild und die Reaktion bezieht, um Halluzinationen zu korrigieren. Um ein Beispiel dafür zu geben, wie Woodpecker funktioniert:

MLLM-Antwort: Auf dem Bild ist ein rotes Auto zu sehen.

Specht:

- Woodpecker extrahiert aus der Antwort die Schlüsselbegriffe „Auto“ und „Rot“.

- Woodpecker formuliert folgende Frage: „Ist auf dem Bild ein rotes Auto?“

- Woodpecker nutzt die Objekterkennung, um alle Autos im Bild zu identifizieren. Anschließend fragt es mithilfe eines VQA-Modells jedes Auto, ob es rot ist. Wenn kein Auto auf dem Bild rot ist, schließt Woodpecker, dass die MLLM-Antwort eine Halluzination enthält

- Woodpecker generiert den folgenden visuellen Anspruch: „Auf dem Bild ist kein rotes Auto zu sehen“

- Woodpecker verwendet ein LLM, um die MLLM-Antwort zu korrigieren, indem er den Ausdruck „rotes Auto“ durch „kein rotes Auto“ ersetzt.

Korrigierte MLLM-Antwort: Auf dem Bild ist kein rotes Auto zu sehen.

Die Studie bewertet die Leistung verschiedener Modelle bei der POPE-Aufgabe und präsentiert die Ergebnisse in verschiedenen Umgebungen, darunter zufällig, beliebt und kontrovers. Die vorgeschlagene Korrekturmethode, Woodpecker, zeigt bei den meisten Metriken für die Basislinien konsistente Zuwächse. In anspruchsvolleren Umgebungen zeigen die MLLMs einen Leistungsabfall, während Woodpecker stabil bleibt und die Genauigkeit der Basislinien verbessert. Die Experimente zu MME umfassen sowohl die Halluzinationsbewertung auf Objektebene als auch auf Attributebene.

Die vorgeschlagene Woodpecker-Korrekturmethode verbessert die Leistung von MLLMs bei der Bewertung auf Objekt- und Attributebene. Es eignet sich besonders gut für die Beantwortung schwierigerer Zählfragen und reduziert Halluzinationen auf Attributebene. Die Einführung des Open-Set-Detektors verbessert die Existenz- und Zählaspekte, während das VQA-Modell den Farbteil verbessert. Das vollständige Framework, das beide Module kombiniert, erzielt die besten Ergebnisse. Die Korrekturmethode bekämpft effektiv Halluzinationen in MLLM-Antworten und führt zu genaueren und detaillierteren Antworten.

Der Mangel an verwandten Arbeiten zur Messung des Korrekturverhaltens wird dadurch behoben, dass die Ergebnisse nach der Korrektur in drei Abschnitte unterteilt werden: Genauigkeit, Auslassung und Fehlkorrektur. Die Ergebnisse des „Standard“-Modells für MME zeigen eine Genauigkeit von 79.2 %, mit geringen Auslassungs- und Fehlkorrekturraten. Dieses korrekturbasierte Framework wird als trainingsfreie Methode zur Linderung von Halluzinationen bei MLLMs vorgeschlagen und kann problemlos in verschiedene Modelle integriert werden. Die Wirksamkeit des Rahmenwerks wird durch Experimente an drei Benchmarks bewertet, und es besteht die Hoffnung, dass diese Arbeit neue Ansätze zur Bekämpfung von Halluzinationen bei MLLMs inspirieren wird.

Um die Richtigkeit des Urteils zu überprüfen, werden die am Urteil beteiligten Stellen benannt. Es sollten Fragen zu grundlegenden Attributen der Entitäten gestellt werden, beispielsweise zu Farben und Aktionen. Komplexe Argumentationen und semantisch ähnliche Fragen sollten vermieden werden. Abfragen zu den Positionsinformationen der Entitäten können mithilfe von „Wo“-Fragen gestellt werden. Unsichere oder vermutete Satzteile sollten nicht in Frage gestellt werden. Wenn keine Fragen vorhanden sind, sollte „None“ ausgegeben werden.

Warum der ganze Aufwand?

MLMMs haben das Potenzial, eine breite Palette von Aufgaben anzubieten, die mit herkömmlichen Sprachmodellen nicht möglich sind, wie z. B. Bildunterschriften, Videozusammenfassungen und Fragenbeantwortung mit multimodaler Eingabe.

Allerdings sind MLLMs nicht perfekt und können manchmal zu ungenauen Ergebnissen führen. Zu den häufigsten Ungenauigkeiten von MLLMs gehören:

- Sachliche Fehler: MLLMs können manchmal Antworten generieren, die sachliche Fehler enthalten. Dies kann passieren, wenn das MLLM nicht auf genügend Daten trainiert wird oder wenn die Daten, auf denen es trainiert wird, nicht genau sind

- Halluzinationen: MLLMs können auch Reaktionen erzeugen, die Halluzinationen enthalten. Dies ist der Fall, wenn das MLLM Informationen generiert, die in den Eingabedaten nicht vorhanden sind. Halluzinationen können durch eine Vielzahl von Faktoren verursacht werden, beispielsweise durch die Komplexität der Aufgabe, die Datenmenge, auf der das MLLM trainiert, und die Qualität der Daten

- Befangenheit: MLLMs können auch voreingenommen sein, was die Voreingenommenheit in den Daten widerspiegelt, auf denen sie trainiert werden. Dies kann dazu führen, dass MLLMs unfaire oder diskriminierende Reaktionen hervorrufen

Verzerrungen und sachliche Fehler werden meist durch unvollständige Datenbanken verursacht, während Halluzinationen durch Fehler in der Arbeitsphase dieser Modelle verursacht werden. Diese scheinbar algorithmischen Fehler sind das größte Hindernis bei der Integration von KI-Technologien in das wirkliche Leben. Es ist eine Tatsache, dass KI die Tür zu dem autonomen Leben öffnen wird, von dem wir träumen, aber ihre Sicherheit und Genauigkeit in ihrem Einsatz sind immer noch zweifelhaft.

Beispielsweise war im Oktober 2023 ein Tesla-Autopilot-Fahrer in Florida in einen tödlichen Unfall verwickelt. Der Fahrer nutzte den Autopiloten, um auf einer Autobahn zu fahren, als das Auto mit einem Sattelzug zusammenstieß, der die Autobahn überquerte. Der Fahrer des Tesla kam bei dem Unfall ums Leben.

Die National Highway Traffic Safety Administration (NHTSA) untersucht den Unfall, um die Ursache zu ermitteln. Es wird jedoch angenommen, dass das Tesla-Autopilotsystem den Sattelschlepper möglicherweise nicht erkannt hat. Dieser Fehler könnte auf eine Reihe von Faktoren zurückzuführen sein, beispielsweise auf die Lichtverhältnisse oder die Position des Sattelzuges. Um die Sicherheit solcher Systeme jedoch vollständig zu gewährleisten, müssen wir uns ihrer Genauigkeit sicher sein.

Es ist unwahrscheinlich, dass wir von einem MLLM-Modell, das die Vorgänge in seiner Umgebung falsch interpretiert, die richtigen Anweisungen erhalten, und wir sind noch nicht bereit für den Einsatz ähnlicher Technologien in Bereichen wie Medizin, Transport und Planung. Diese von Woodpecker versprochene Lösung könnte ein Wendepunkt für unsere KI und unser autonomes Leben sein. Während sich die Technologie weiterentwickelt, beeinflusst sie weiterhin unser Leben und wir versuchen, all dies so gut wie möglich zu erfassen. Mal sehen, wohin die Zukunft uns alle führen wird.

Hervorgehobener Bildnachweis: Emre Çıtak/DALL-E 3.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://dataconomy.com/2023/10/27/how-woodpecker-cure-ai-hallucination/