ChatGPT, DALL-E , Stable Diffusion und andere generative KIs haben die Welt im Sturm erobert. Sie schaffen fabelhafte Poesie und Bilder. Sie dringen in jeden Winkel unserer Welt ein, vom Marketing über das Verfassen juristischer Schriftsätze bis hin zur Arzneimittelentwicklung. Sie scheinen das Aushängeschild einer Erfolgsgeschichte der Mensch-Maschine-Geist-Verschmelzung zu sein.

Aber unter der Haube sieht es weniger rosig aus. Diese Systeme sind riesige Energiefresser und erfordern Rechenzentren, die Tausende Tonnen Kohlenstoffemissionen ausstoßen – was das ohnehin schon volatile Klima noch weiter belastet – und Milliarden von Dollar verschlingen. Da die neuronalen Netze immer ausgefeilter und häufiger eingesetzt werden, wird der Energieverbrauch wahrscheinlich noch weiter ansteigen.

Es wurde viel Tinte über generative KIs verschüttet Carbon Footprint. Sein Energiebedarf könnte sein Untergang sein und die Entwicklung behindern, wenn es weiter wächst. Unter Verwendung aktueller Hardware wird die generative KI „erwartungsgemäß bald ins Stocken geraten, wenn sie weiterhin auf Standard-Computerhardware angewiesen ist“. sagte Dr. Hechen Wang von Intel Labs.

Es ist höchste Zeit, nachhaltige KI aufzubauen.

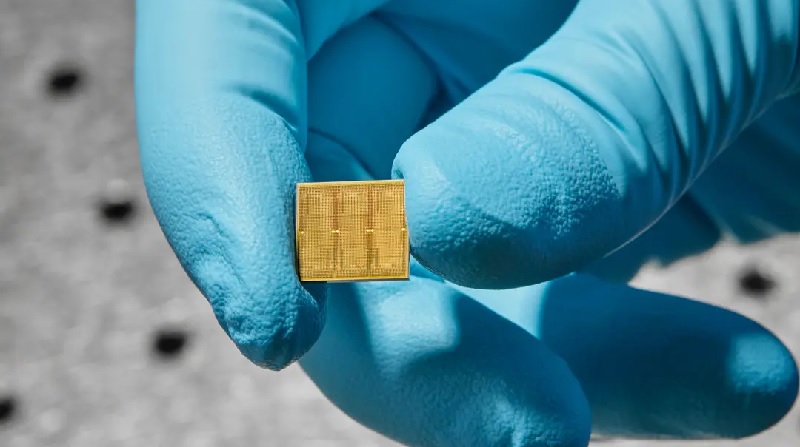

Diese Woche eine Studie von IBM hat einen praktischen Schritt in diese Richtung getan. Sie entwickelten einen 14-Nanometer-Analogchip mit 35 Millionen Speichereinheiten. Im Gegensatz zu aktuellen Chips erfolgt die Berechnung direkt in diesen Einheiten, wodurch die Notwendigkeit entfällt, Daten hin und her zu übertragen – was wiederum Energie spart.

Der Datentransfer kann den Energieverbrauch um das 3- bis 10,000-fache über den für die eigentliche Berechnung erforderlichen Wert hinaus erhöhen, sagte Wang.

Der Chip war hocheffizient, als er mit zwei Spracherkennungsaufgaben konfrontiert wurde. Eines davon, Google Speech Commands, ist klein, aber praktisch. Hier kommt es auf Geschwindigkeit an. Das andere, Librispeech, ist ein Mammutsystem, das dabei hilft, Sprache in Text umzuwandeln, was die Fähigkeit des Chips, riesige Datenmengen zu verarbeiten, auf die Probe stellt.

Im Vergleich zu herkömmlichen Computern arbeitete der Chip genauso genau, erledigte die Arbeit jedoch schneller und mit weitaus weniger Energie, da er weniger als ein Zehntel dessen verbrauchte, was normalerweise für einige Aufgaben erforderlich wäre.

„Dies sind unseres Wissens die ersten Demonstrationen kommerziell relevanter Genauigkeitsniveaus an einem kommerziell relevanten Modell … mit Effizienz und massiver Parallelität“ für einen analogen Chip, sagte das Team.

Brainy Bytes

Dies ist kaum der erste analoge Chip. Allerdings drängt es die Idee des neuromorphen Computings in den Bereich der Praktikabilität – ein Chip, der eines Tages Ihr Telefon, Ihr Smart Home und andere Geräte mit einer Effizienz antreiben könnte, die der des Gehirns nahe kommt.

Ähm, was? Gehen wir zurück.

Aktuelle Computer basieren auf dem Von Neumann Architektur. Stellen Sie sich das wie ein Haus mit mehreren Räumen vor. Die eine, die Zentraleinheit (CPU), analysiert Daten. Ein anderer speichert Speicher.

Für jede Berechnung muss der Computer Daten zwischen diesen beiden Räumen hin- und herschicken, was Zeit und Energie kostet und die Effizienz verringert.

Im Gegensatz dazu kombiniert das Gehirn sowohl Berechnung als auch Gedächtnis in einem Studio. Seine pilzartigen Verbindungen, Synapsen genannt, bilden beide neuronale Netzwerke und speichern Erinnerungen am selben Ort. Synapsen sind äußerst flexibel und passen die Stärke ihrer Verbindung mit anderen Neuronen basierend auf gespeicherten Erinnerungen und neuen Erkenntnissen an – eine Eigenschaft, die als „Gewichte“ bezeichnet wird. Unser Gehirn passt sich schnell an eine sich ständig verändernde Umgebung an, indem es diese synaptischen Gewichte anpasst.

IBM war beim Design führend Analoge Chips diese Nachahmung Gehirnberechnung. Ein Durchbruch kam im Jahr 2016, als sie einen Chip einführten, der auf einem faszinierenden Material basiert, das normalerweise in wiederbeschreibbaren CDs zu finden ist. Das Material ändert seinen physikalischen Zustand und verändert seine Form von einer klebrigen Suppe zu kristallähnlichen Strukturen, wenn es mit Elektrizität beaufschlagt wird – ähnlich einer digitalen 0 und 1.

Hier ist der Clou: Der Chip kann auch in einem Hybridzustand existieren. Mit anderen Worten: Ähnlich wie eine biologische Synapse kann die künstliche Synapse eine Vielzahl unterschiedlicher Gewichte kodieren – nicht nur binär – und so mehrere Berechnungen akkumulieren, ohne ein einziges Datenbit verschieben zu müssen.

Jekyll und Hyde

Die neue Studie baute auf früheren Arbeiten auf und verwendete auch Phasenwechselmaterialien. Die Grundkomponenten sind „Speicherkacheln“. Jedes ist vollgepackt mit Tausenden von Phasenwechselmaterialien in einer Gitterstruktur. Die Kacheln kommunizieren problemlos miteinander.

Jede Kachel wird von einem programmierbaren lokalen Controller gesteuert, sodass das Team die Komponente – ähnlich einem Neuron – präzise anpassen kann. Der Chip speichert außerdem Hunderte von Befehlen nacheinander und erstellt so eine Art Blackbox, die es ihnen ermöglicht, erneut einzugreifen und die Leistung zu analysieren.

Insgesamt enthielt der Chip 35 Millionen Phasenwechsel-Speicherstrukturen. Die Verbindungen beliefen sich auf 45 Millionen Synapsen – weit entfernt vom menschlichen Gehirn, aber sehr beeindruckend auf einem 14-Nanometer-Chip.

Diese verblüffenden Zahlen stellen ein Problem für die Initialisierung des KI-Chips dar: Es gibt einfach zu viele Parameter, die man durchsuchen muss. Das Team ging das Problem mit einer Art KI-Kindergarten an, indem es synaptische Gewichte vorprogrammierte, bevor die Berechnungen begannen. (Es ist ein bisschen so, als würde man eine neue gusseiserne Pfanne einbrennen, bevor man damit kocht.)

Sie „passten ihre Netzwerktrainingstechniken unter Berücksichtigung der Vorteile und Einschränkungen der Hardware an“ und legten dann die Gewichte für die optimalsten Ergebnisse fest, erklärte Wang, der nicht an der Studie beteiligt war.

Es hat funktioniert. In einem ersten Test schaffte der Chip problemlos 12.4 Billionen Operationen pro Sekunde für jedes Watt Leistung. Der Energieverbrauch sei „zehn- oder sogar hundertmal höher als bei den leistungsstärksten CPUs und GPUs“, sagte Wang.

Der Chip hat einen Kernrechenprozess, der tiefen neuronalen Netzen zugrunde liegt, mit nur wenigen klassischen Hardwarekomponenten in den Speicherkacheln auf den Punkt gebracht. Im Gegensatz dazu benötigen herkömmliche Computer Hunderte oder Tausende von Transistoren (eine Grundeinheit, die Berechnungen durchführt).

Rede von der Stadt

Als nächstes forderte das Team den Chip zu zwei Spracherkennungsaufgaben heraus. Jeder betonte eine andere Facette des Chips.

Der erste Test war die Geschwindigkeit bei einer relativ kleinen Datenbank. Verwendung der Google Speech-Befehle In der Datenbank erforderte die Aufgabe, dass der KI-Chip 12 Schlüsselwörter in einem Satz von etwa 65,000 Clips von Tausenden von Menschen erkennen musste, die 30 kurze Wörter sprachen („klein“ ist im Deep-Learning-Universum relativ). Bei Verwendung eines anerkannten Benchmarks:MLPerf— Der Chip war siebenmal schneller als in früheren Arbeiten.

Der Chip glänzte auch, wenn er mit einer großen Datenbank herausgefordert wurde. Librirede. Das Korpus enthält über 1,000 Stunden gelesene englische Sprache, die üblicherweise zum Trainieren der KI für das Parsen von Sprache und die automatische Sprach-zu-Text-Transkription verwendet wird.

Insgesamt verwendete das Team fünf Chips, um schließlich mehr als 45 Millionen Gewichte mithilfe von Daten von 140 Millionen Phasenwechselgeräten zu kodieren. Im Vergleich zu herkömmlicher Hardware war der Chip etwa 14-mal energieeffizienter – er verarbeitete fast 550 Samples pro Sekunde pro Watt Energieverbrauch – bei einer Fehlerquote von etwas über 9 Prozent.

Obwohl beeindruckend, stecken analoge Chips noch in den Kinderschuhen. Sie seien „enorm vielversprechend für die Bekämpfung der mit KI verbundenen Nachhaltigkeitsprobleme“, sagte Wang, aber der weitere Weg erfordert die Überwindung einiger weiterer Hürden.

Ein Faktor ist die Verfeinerung des Designs der Speichertechnologie selbst und ihrer umgebenden Komponenten – also der Anordnung des Chips. Der neue Chip von IBM enthält noch nicht alle benötigten Elemente. Ein nächster entscheidender Schritt besteht darin, alles auf einem einzigen Chip zu integrieren und gleichzeitig seine Wirksamkeit beizubehalten.

Auf der Softwareseite benötigen wir außerdem Algorithmen, die speziell auf analoge Chips zugeschnitten sind, und Software, die Code problemlos in eine für Maschinen verständliche Sprache übersetzt. Da diese Chips zunehmend kommerziell nutzbar werden, wird die Entwicklung dedizierter Anwendungen den Traum einer analogen Chip-Zukunft am Leben erhalten.

„Es hat Jahrzehnte gedauert, die Rechenökosysteme zu formen, in denen CPUs und GPUs so erfolgreich arbeiten“, sagte Wang. „Und es wird wahrscheinlich Jahre dauern, eine ähnliche Umgebung für analoge KI zu schaffen.“

Bild-Kredit: Ryan Lavine für IBM

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://singularityhub.com/2023/08/25/ibms-brain-inspired-analog-chip-aims-to-make-ai-more-sustainable/