In einem hektischen Wettlauf gegen eine drohende CO2-Zeitbombe kämpfen Technologieriesen mit den Auswirkungen ihrer weitläufigen Rechenzentren auf der ganzen Welt auf die Umwelt. Diese Rechenzentren, die für die Stromversorgung der heutigen digitalen Infrastruktur unerlässlich sind, haben sich zu gierigen Energieverbrauchern entwickelt, insbesondere da die Nachfrage nach künstlicher Intelligenz (KI) weiterhin sprunghaft ansteigt.

Da KI in verschiedenen Branchen immer wichtiger wird, explodiert der Energiebedarf von Rechenzentren. Dies wiederum erfordert dringende Maßnahmen zur Verringerung ihres massiven ökologischen Fußabdrucks.

Der Energiehunger von KI: Freisetzung von Rechenzentrumsemissionen

Zwischen 2010 und 2018 gab es eine Schätzung 550% Zunahme weltweit in Bezug auf die Anzahl der Rechenzentrums-Workloads und Recheninstanzen.

Rechenzentren und Übertragungsnetze tragen zusammen bis zu bei 1.5% des weltweiten Energieverbrauchs. Sie stoßen eine Menge Kohlendioxid aus, die mit dem Jahresausstoß Brasiliens vergleichbar ist.

Hyperscaler mögen Google, Microsoft und Amazon haben sich zu ehrgeizigen Klimazielen verpflichtet und streben eine Dekarbonisierung ihrer Betriebe an. Hyperscaler sind große, hochoptimierte und effiziente Anlagen.

Die Verbreitung von KI stellt diese Ziele jedoch vor große Herausforderungen. Die energieintensive Natur von Grafikprozessoren (GPUs), die für das Training von KI-Modellen unerlässlich sind, erhöht die Belastung der Energieressourcen.

Nach Angaben des Internationale Energieagentur (IEA) verbraucht das Training eines einzelnen KI-Modells mehr Strom als 100 Haushalte pro Jahr.

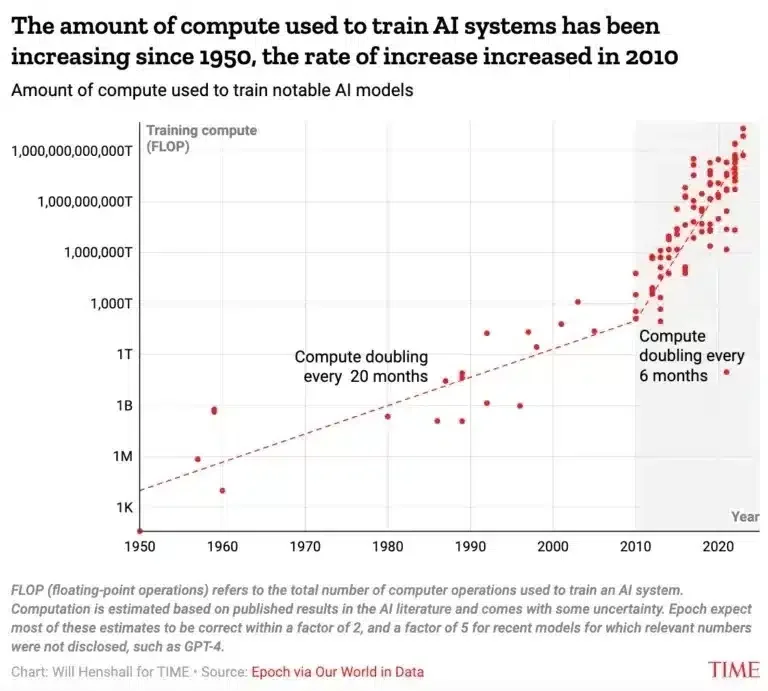

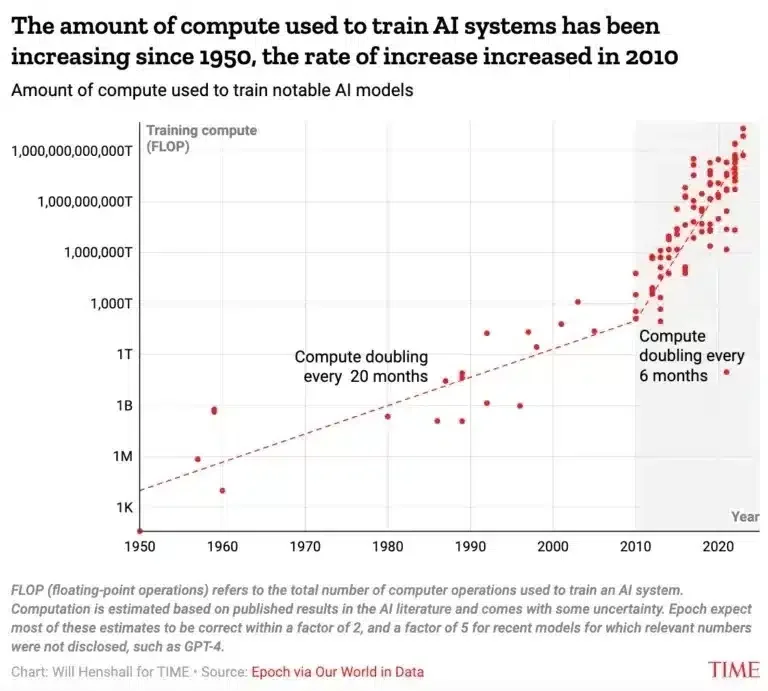

Laut einer anderen Quelle verdoppelt sich die für das KI-Training benötigte Rechenleistung alle sechs Monate. Vor fünfzig Jahren geschah das alle 6 Monate, wie aus der folgenden Grafik hervorgeht.

Noch besorgniserregender ist, dass die Rechenleistung, die für die Entwicklung von KI-Modellen verwendet wird, in etwas mehr als einem Jahrzehnt um den unglaublichen Faktor 10 Milliarden gestiegen ist. Und es würde nicht langsamer werden.

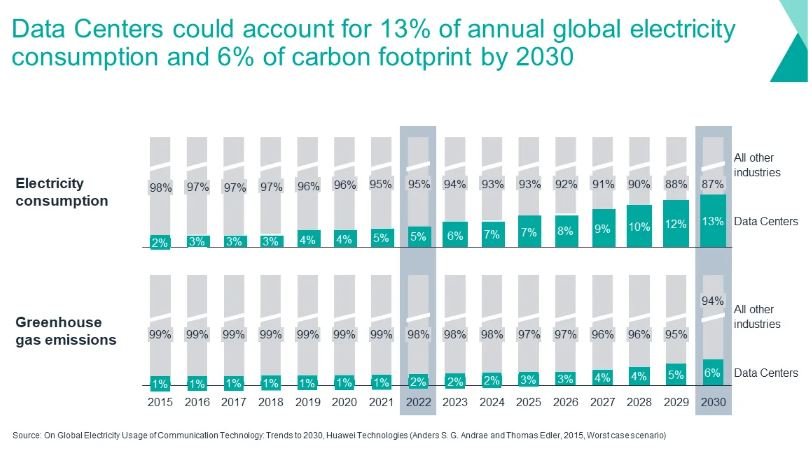

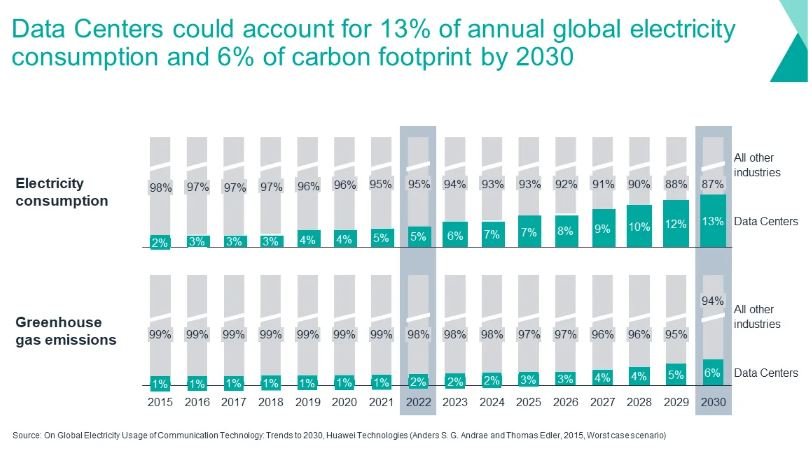

Schätzungen der Industrie gehen davon aus, dass der Stromverbrauch bis zu 100 % betragen kann 13% bis 2030, während der Anteil der globalen Kohlenstoffemissionen betragen würde 6% für das gleiche Jahr.

Die Kosten der KI: Macht und Fortschritt im Gleichgewicht

Die Klimarisiken, die durch KI-gesteuertes Computing entstehen, sind tiefgreifend Nvidia CEO Jensen Huang hebt den erheblichen Energiebedarf von KI hervor. Jensen prognostizierte eine Verdoppelung der Rechenzentrumskosten innerhalb von fünf Jahren, um dem wachsenden KI-Ökosystem gerecht zu werden.

Beispielsweise sind die Rechenkosten für das Training fortschrittlicher KI-Modelle wie GPT-3 mit 175B Parametern und möglicherweise GPT-4 vorhersehbar erheblich. Der letzte Trainingslauf von GPT-3 kostete schätzungsweise 500,000 bis 4.6 Millionen US-Dollar.

Die Schulung von GPT-4 hätte Kosten in der Größenordnung von 50 Millionen US-Dollar verursachen können. Berücksichtigt man jedoch die Rechenleistung, die für Versuch und Irrtum vor dem letzten Trainingslauf erforderlich ist, beträgt die Die Gesamtkosten für die Schulung übersteigen wahrscheinlich 100 Millionen US-Dollar.

Im Durchschnitt verbrauchen groß angelegte KI-Modelle ca 100x mehr Rechenressourcen als andere zeitgenössische KI-Modelle. Wenn der Trend zur Vergrößerung der Modellgrößen in seinem derzeitigen Tempo anhält, gehen einige Schätzungen davon aus, dass die Rechenkosten bis 2037 das gesamte BIP der Vereinigten Staaten übersteigen werden.

Laut der Informatikerin Kate Saenko ist die Entwicklung von GPT-3 abgeschlossen 550 Tonnen CO2 und verbraucht 1,287 MW Stunden Strom. Mit anderen Worten: Diese Emissionen entsprechen denen, die bei der Einnahme durch eine einzelne Person entstehen 550 Hin- und Rückflüge zwischen New York und San Francisco.

Ganz zu schweigen davon, dass diese Zahlen die Emissionen berücksichtigen, die direkt mit der Entwicklung oder Vorbereitung der KI für den Einsatz verbunden sind. Andere Emissionsquellen werden nicht berücksichtigt.

Lösungen zur Reduzierung des CO2-Fußabdrucks von Rechenzentren

Um die Emissionen von Rechenzentren zu verringern, haben die Akteure der Branche verschiedene Strategien verfolgt, darunter auch Investitionen in erneuerbare Energie und verwenden Kohlenstoffgutschriften.

Obwohl diese Initiativen einige Fortschritte gebracht haben, erfordert die zunehmende Einführung von KI zusätzliche Maßnahmen, um sinnvolle Emissionsreduzierungen zu erreichen.

Die Load-Shifting-Strategie von Google ist ein vielversprechender Ansatz zur Bewältigung dieser Herausforderung. Es synchronisiert den Rechenzentrumsbetrieb stündlich mit der Verfügbarkeit erneuerbarer Energien.

Durch den Einsatz ausgefeilter Softwarealgorithmen identifiziert Google Regionen mit überschüssiger Solar- und Windenergie im Netz und steigert den Rechenzentrumsbetrieb in diesen Gebieten strategisch.

- Die Logik hinter dem Ansatz ist einfach: Reduzieren Sie Emissionen, indem Sie die Funktionsweise von Rechenzentren auf den Kopf stellen.

Der Technologieriese hat außerdem die erste Initiative ins Leben gerufen, um den Stromverbrauch bestimmter Rechenzentren stündlich an kohlenstofffreie Quellen anzupassen. Ziel ist es, die Maschinen rund um die Uhr mit sauberer Energie zu versorgen.

Die Rechenzentren von Google werden in etwa 64 % der Zeit mit kohlenstofffreier Energie betrieben, wobei 13 regionale Standorte zu 85 % auf solche Quellen angewiesen sind und sieben Standorte weltweit die 90 %-Marke überschreiten, so Michael Terrell, der das 24/7-Projekt von Google leitet COXNUMX-freie Energiestrategie.

Cirrus Nexus überwacht aktiv die globalen Stromnetze, um Regionen mit reichlich erneuerbarer Energie zu identifizieren. Anschließend verteilen sie die Rechenlasten strategisch, um den CO2-Ausstoß zu minimieren. Durch die Nutzung erneuerbarer Energiequellen und die Optimierung des Rechenzentrumsbetriebs konnten erhebliche Reduzierungen der CO2-Emissionen erzielt werden.

Das Unternehmen konnte die Rechenemissionen für einige Arbeitslasten und die Kunden um 34 % senken. Es nutzt Cloud-Dienste von Amazon, Microsoft und Google.

Bewältigung der KI-gesteuerten Energiekrise

In den letzten Jahren haben sowohl Google als auch Amazon mit der Anpassung der Nutzungsmuster von Rechenzentren experimentiert. Sie tun dies sowohl für ihre internen Abläufe als auch für Kunden, die ihre Cloud-Dienste nutzen.

Nvidia bietet eine weitere Lösung für diese KI-bedingte Energiekrise – Green Computing beschleunigte Analysetechnologie. Es kann die Rechenkosten und den CO80-Fußabdruck um bis zu XNUMX % senken.

Die Implementierung einer Lastverlagerung erfordert die Zusammenarbeit zwischen Rechenzentrumsbetreibern, Versorgungsunternehmen und Netzbetreibern, um potenzielle Netzunterbrechungen abzumildern. Dennoch ist diese Strategie äußerst vielversprechend, wenn es darum geht, Nachhaltigkeitsziele in der Rechenzentrumsbranche voranzutreiben.

Angesichts der steigenden Nachfrage nach KI ist die Deckung des Energiebedarfs von Rechenzentren für die Reduzierung der CO2-Emissionen von größter Bedeutung. Innovative Strategien wie Lastverlagerung bieten einen Weg zur Erreichung der CO2-Neutralität und gewährleisten gleichzeitig die Zuverlässigkeit und Effizienz des Rechenzentrumsbetriebs in einer zunehmend KI-gesteuerten Landschaft.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://carboncredits.com/carbon-countdown-ais-10-billion-rise-in-power-use-explodes-data-center-emission/