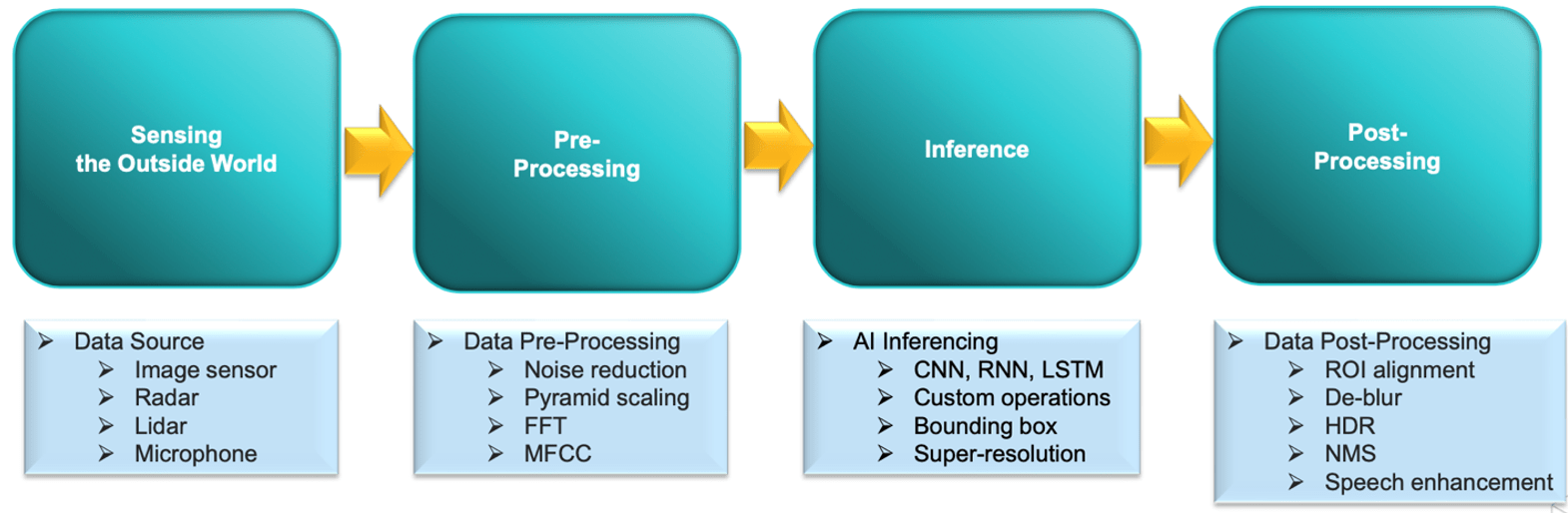

Ich habe zuvor geschrieben, dass die Debatte darüber, welche CPU die Welt regiert (Arm versus RISC-V), in modernen Systemen den Wald vor lauter Bäumen etwas verfehlt. Dies ist nirgendwo so offensichtlich wie bei intelligenter Audio- und Bildtechnik: intelligente Türklingeln, Lautsprecher, sprachaktivierte Fernbedienungen, intelligente Ohrhörer, Kollisionsvermeidung im Auto, Selbstparken und eine Million anderer Anwendungen. Nichts davon wäre möglich, indem man einfach eine CPU oder sogar eine Reihe von CPUs direkt an eine KI-Engine anschließt. CPUs spielen eine wichtige administrative Rolle, aber auf Audio und Vision basierende, auf Intelligenz basierende Systeme sind auf komplexe Signalverarbeitungspipelines rund um den KI-Kern angewiesen. Allerdings kann der Aufbau dieser Pipelines die Produktentwicklung in sehr wettbewerbsintensiven Märkten erheblich komplexer und zeitlicher gestalten.

Was ist eine KI-Pipeline?

Audio-Samples sind eindimensionale, sich kontinuierlich verändernde Signale, Bildsignale sind ähnlich, aber zweidimensional. Nach der Rauschreduzierung muss jeder mindestens in eine Form skaliert werden, die mit den Proben kompatibel ist, an denen das KI-Modell trainiert wurde. Beispielsweise kann ein Bild auf Graustufen reduziert werden, da Farbe die Trainings- und Inferenzkosten erheblich erhöht. Ein Audiosignal kann gefiltert werden, um niedrige und hohe Frequenzbänder zu eliminieren. Aus ähnlichen Gründen wird der Signalbereich angepasst und gemittelt. Alle diese Schritte können problemlos von Software erledigt werden, die auf einem DSP läuft.

Diese Ebene der Vorverarbeitung ist grundlegend. Pulin Desai (Produktmarketing und Management für Tensilica Vision, Radar, Lidar und Kommunikations-DSPs bei Cadence) stellte mir einige aktuelle Fortschritte vor, die eine höhere Genauigkeit vorantreiben. Beispielsweise nutzt die Spracherkennung eine Technik namens MFCC, um Merkmale aus der Sprache zu extrahieren, die als direkter bestimmend gelten als eine einfache Audiowelle. Ein weiteres Beispiel ist die Geräuschunterdrückung, die jetzt Intelligenz hinzufügt, um Sprachbefehle zu unterstützen, die die Sprache der Hintergrundmusik außer Kraft setzen, oder um sicherzustellen, dass Sie die Alarmsirenen nicht verpassen. Beide Fälle werden durch Signalverarbeitung gesteuert, manchmal mit einer Prise KI.

Aufstrebende Vision-Transformer mit globalen Erkennungsstärken sind jetzt heiß begehrt und gehen zu einer mehrskaligen Bilderkennung über, bei der ein Bild in eine Pyramide aus zunehmend verkleinerten Bildern mit geringerer Auflösung zerlegt wird. Es gibt weitere Vorinferenzmöglichkeiten und dann (irgendwann) wird der eigentliche Inferenzschritt (CNN, Transformer oder andere Optionen) ausgeführt. Nach der Inferenz müssen Nachbearbeitungsschritte aktiviert werden. Dazu können nicht-maximale Unterdrückung (NMS), Bildschärfung oder Sprachverbesserung gehören. Möglicherweise führt die Pipeline sogar einen zusätzlichen Inferenzschritt zur Klassifizierung aus. Es ist offensichtlich, warum ein solcher Prozess als Pipeline betrachtet wird – viele Schritte von einem ursprünglichen Bild oder Ton, meist durch Signalverarbeitung, die durch Software erfolgt, die auf DSPs läuft.

So wie sich KI-Modelle weiterentwickeln, entwickeln sich auch Pipeline-Algorithmen weiter. Für einen Produkt-OEM muss es möglich sein, diese komplexen Pipelines innerhalb von beispielsweise 18 bis 24 Monaten für die Veröffentlichung zu entwickeln und zu warten und dafür zu sorgen, dass die Produkte über eine Produktlebensdauer von 5 Jahren oder mehr wettbewerbsfähig bleiben. Um diese Ziele zu erreichen, benötigen OEMs eine Vereinfachung und Beschleunigung bei der Entwicklung und Wartung von DSP-Software.

Optimierung des Entwicklungsablaufs

Das Tensilica-Portfolio wird bereits durch ein umfangreiches Partnerschafts-Ökosystem in den Bereichen Audio, Voice und Vision unterstützt, das einen Großteil der bei der Ausfüllung einer Pipeline-Implementierung benötigten Hilfe leisten dürfte. Selbstverständlich möchten OEMs gegebenenfalls gezielt durch ihre eigenen Algorithmen differenzieren, und hier sind die jüngsten Fortschritte besonders wichtig.

Die erste und am meisten Aufmerksamkeit erregende Methode ist die automatische Vektorisierung. Sie schreiben Software für einen DSP auf die gleiche Weise, wie Sie Software für eine CPU schreiben würden, mit der Ausnahme, dass Sie die Vorteile des DSP voll ausnutzen können, um Berechnungen mit breiten Vektoren zu beschleunigen. Bisher erforderte das Schreiben von Software zur vollständigen Nutzung dieser Funktion besondere Fachkenntnisse in der manuellen Codierung für die Vektorisierung, was zu einem Engpass bei Entwicklung und Upgrades führte.

Die automatische Vektorisierung zielt darauf ab, diese Aufgabe zu automatisieren. Prakash Madhvapathy (Direktor für Produktmarketing und Management für Tensilica-Audio-/Sprach-DSPs bei Cadence) sagt mir, dass es einige Richtlinien gibt, die der Entwickler befolgen muss, um diesen Druckknopf zu erstellen, aber nach diesen Richtlinien geschriebener Code funktioniert auf einer CPU genauso gut (wenn auch langsamer). . Sie führten Versuche mit verschiedenen Industriestandardanwendungen durch und stellten fest, dass der Compiler genauso gut funktioniert wie handcodierte Software. Durch die automatische Vektorisierung wird die Entwicklung von DSP-Algorithmen somit einem breiteren Publikum zugänglich gemacht, um Entwicklungsengpässe zu reduzieren.

Die nächste wichtige Verbesserung unterstützt bei Bedarf Gleitkommazahlen mit doppelter Genauigkeit. Doppelte Präzision mag für Edge-Anwendungen wie ein Overkill erscheinen, neuere Algorithmen wie MFCC und Softmax verwenden jedoch jetzt Funktionen wie Exponentialfunktionen und Protokolle, die schnell zu einem Über-/Unterlauf von Einzelpunkt-Floats führen. Double Point trägt zur Aufrechterhaltung der Präzision bei und stellt sicher, dass ein Entwickler bei der Portierung von rechenzentrumsbasierten Softwareentwicklungsplattformen keine besondere Handhabung benötigt.

Eine weitere wichtige Verbesserung ist die Unterstützung von 40-Bit-Adressen im iDMA, die es dem System ermöglicht, bis zu 1 TB Speicher direkt zu adressieren, ohne dass der Entwickler Adressoffsets durch speziellen Code verwalten muss. Klingt nach viel Speicher für ein Edge-Gerät, aber man muss nur an Automobilanwendungen denken, um zu erkennen, dass solche Größen in einigen Anwendungen immer häufiger vorkommen. Der größere Adressbereich bietet auch mehr Vereinfachung bei der Portierung von Rechenzentrumsplattformen.

Produktverbesserungen und Verfügbarkeit

Alle bestehenden DSPs sind auf die Tensilica Unterstützung.

Cadence hat kürzlich zwei neue Tensilica-Audio-DSPs (HiFi 1s und HiFi 5s) und zwei neue Vision-DSPs (Vision 110 und Vision 130) herausgebracht, die alle auf der LX8-Plattform aufbauen. Dazu gehören mehrere Verbesserungen für Leistung und Leistung, aber ich möchte mich hier besonders auf Verbesserungen zur Vereinfachung und Beschleunigung der Softwareentwicklung konzentrieren.

Die Vision 130/100 DSPs unterstützen die Dekomprimierung im laufenden Betrieb, wie in einem erwähnt früherer Blog. Hinzu kommen höhere fmax, höhere Gleitkomma-Leistung, schnellere FFTs und Unterstützung für komplexe Gleitkomma-Typen, was insgesamt bis zu 5-fache Leistungsverbesserungen bei Standard-DSP-Benchmarks und bis zu 3.5-fache Verbesserung bei AI-Benchmarks liefert. Diese neuen Vision-Prozessoren sind ab sofort erhältlich.

Die Audio-HiFi 1s- und 5s-DSPs bieten eine bis zu 35-fache Verbesserung der XCLIB-Funktionen mit doppelter Präzision, 5–15 % Codec-Leistung durch verbesserte Verzweigungsvorhersage und bis zu 50 % verbesserte Leistung dank des L2-Cache. Diese neuen DSP-Prozessoren werden voraussichtlich im Dezember 2023 verfügbar sein. (Ich sollte übrigens hinzufügen, dass HiFi 1s, obwohl ein Audio-DSP, über genügend Kapazitäten verfügt, um auch Video-Wake-Up mit extrem geringem Stromverbrauch zu bewältigen. Ziemlich cool!)

Erfahren Sie mehr über HiFi-DSPs KLICKEN SIE HIER und Vision DSPs KLICKEN SIE HIER. Sie sollten sich auch a ansehen WHITE PAPER über die Bedeutung von DSPs in unserer schönen neuen KI-Welt.

Lesen Sie auch:

Neue STA-Funktionen von Cadence

Entwicklung effektiver Mixed-Signal-Modelle. Innovation in der Verifizierung

Behauptungssynthese durch LLM. Innovation in der Verifizierung

Teile diesen Beitrag über:

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://semiwiki.com/artificial-intelligence/337575-accelerating-development-for-audio-and-vision-ai-pipelines/