Google war ein Vorreiter in der KI-Forschung und leistete mit transformativen Technologien wie … einen wesentlichen Beitrag zur Open-Source-Community TensorFlow, BERT, T5, JAX, AlphaFold und AlphaCode. Um dieses Erbe fortzuführen, hat Google Gemma eingeführt, ein LLM, das für eine verantwortungsvolle KI-Entwicklung entwickelt wurde und die gleiche Forschung und Technologie nutzt, die die Gini-Modelle vorangetrieben hat.

Inhaltsverzeichnis

Was ist Gemma LLM?

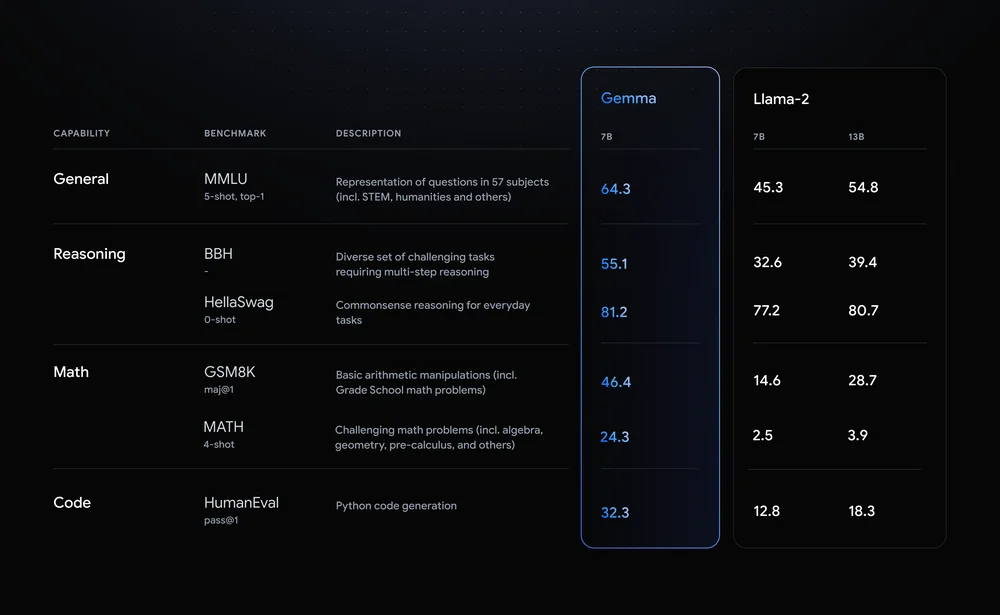

Gemma zeichnet sich durch beeindruckende Leistungskennzahlen aus. Es gibt zwei Varianten: eine mit 7 Milliarden Parametern und eine mit 2 Milliarden. Im Vergleich zu Metas LLM Llama 2 zeigt Gemma in verschiedenen Benchmarks eine überlegene Genauigkeit. Gemmas 7-Milliarden-Parameter-Modell weist beispielsweise eine allgemeine Genauigkeit von 64.3 % auf und übertrifft Lama 2 in Argumentation, Mathematik und anderen Kategorien.

Schauen wir uns einige der Funktionen von Gemma LLM an:

- Leichtbauarchitektur: Gemma gibt es in zwei Größen, den Parametern 2B und 7B, und ist damit deutlich kleiner als seine größeren Cousins. Dies bedeutet schnellere Inferenzgeschwindigkeiten und geringerer Rechenaufwand, was es ideal für PCs und sogar mobile Geräte macht.

- Open-Source-Verfügbarkeit: Im Gegensatz zu vielen Hochleistungs-LLMs sind der Code und die Parameter von Gemma frei verfügbar, was die Leistungsfähigkeit erhöht Entwicklern und Forschern ermöglicht es, zu experimentieren, sie anzupassen und zu ihrer Weiterentwicklung beizutragen.

- Auf Anweisungen abgestimmte Varianten: Über vorab trainierte Modelle hinaus bietet Gemma „anweisungsabgestimmte“ Versionen an, die für bestimmte Aufgaben wie die Beantwortung und Zusammenfassung von Fragen optimiert sind. Das steigert Leistung und Anpassungsfähigkeit für reale Anwendungen.

Gemmas Wirkung geht über technische Spezifikationen hinaus. Es demokratisiert den Zugang zu fortgeschrittenen LLMs und fördert Innovation und Zusammenarbeit innerhalb der KI-Community. Seine potenziellen Anwendungen erstrecken sich über verschiedene Bereiche, von persönliche Produktivitätstools und Chatbots bis hin zur Codegenerierung und wissenschaftlichen Forschung. Durch die Senkung der Eintrittsbarrieren verspricht Gemma, den Fortschritt in der Verarbeitung natürlicher Sprache zu beschleunigen und die Zukunft der KI zu gestalten.

Tauchen Sie tief in die Gemma-Varianten ein

Gemma, die Open-Source-LLM-Familie von Google, bietet eine vielseitige Auswahl an Modellen für unterschiedliche Bedürfnisse. Schauen wir uns die verschiedenen Größen und Versionen genauer an und erkunden wir ihre Stärken, Anwendungsfälle und technischen Details für Entwickler:

Auf die Größe kommt es an: Wählen Sie Ihre Gemma

- 2B: Dieser leichte Champion zeichnet sich durch ressourcenbeschränkte Umgebungen wie CPUs und mobile Geräte aus. Sein Speicherbedarf von etwa 1.5 GB und die schnelle Inferenzgeschwindigkeit machen es ideal für Aufgaben wie Textklassifizierung und einfache Beantwortung von Fragen.

- 7B: Die 7B-Variante schafft ein Gleichgewicht zwischen Leistung und Effizienz und glänzt mit GPUs und TPUs der Verbraucherklasse. Sein Speicherbedarf von 5 GB ermöglicht die Freigabe komplexerer Aufgaben wie Zusammenfassung und Codegenerierung.

Tuning des Motors: Basis vs. nach Anleitung abgestimmt

- Basis: Frisch aus dem Trainingsprozess bieten diese Modelle eine universelle Grundlage für verschiedene Anwendungen. Sie erfordern eine Feinabstimmung für bestimmte Aufgaben, bieten aber Flexibilität für die individuelle Anpassung.

- Anleitung abgestimmt: Diese Varianten sind auf bestimmte Anweisungen wie „Zusammenfassen“ oder „Übersetzen“ vorab trainiert und bieten eine sofort einsatzbereite Benutzerfreundlichkeit für gezielte Aufgaben. Sie opfern einen Teil der Generalisierbarkeit für eine verbesserte Leistung in ihrem vorgesehenen Bereich.

Technische Leckerbissen für Entwickler

- Speicherbedarf: 2B-Modelle benötigen etwa 1.5 GB, während 7B-Modelle etwa 5 GB Speicher benötigen. Durch Feinabstimmung kann dieser Footprint leicht vergrößert werden.

- Inferenzgeschwindigkeit: 2B-Modelle zeichnen sich durch Geschwindigkeit aus und eignen sich daher für Echtzeitanwendungen. 7B-Modelle bieten im Vergleich zu größeren LLMs eine schnellere Inferenz, erreichen jedoch möglicherweise nicht die Geschwindigkeit ihrer kleineren Geschwister.

- Framework-Kompatibilität: Beide Größen sind mit wichtigen Frameworks wie TensorFlow, PyTorch und JAX kompatibel, sodass Entwickler ihre bevorzugte Umgebung nutzen können.

Passen Sie die richtige Gemma an Ihre Bedürfnisse an

Die Wahl zwischen Größe und Abstimmung hängt von Ihren spezifischen Anforderungen ab. Für ressourcenbeschränkte Szenarien und einfache Aufgaben ist das 2B-Basismodell ein guter Ausgangspunkt. Wenn Sie Leistung und Komplexität in bestimmten Bereichen priorisieren, könnte die anweisungsoptimierte 7B-Variante Ihr Champion sein. Denken Sie daran, dass die Feinabstimmung beider Größen eine weitere Anpassung an Ihren individuellen Anwendungsfall ermöglicht.

Erinnern Sie sich: Dies ist nur ein kleiner Einblick in die Gemma-Varianten. Mit seinen vielfältigen Optionen und seinem Open-Source-Charakter ermöglicht Gemma Entwicklern, sein Potenzial für verschiedene Anwendungen zu erkunden und auszuschöpfen.

Erste Schritte mit Gemma

Gemma, Googles beeindruckende Familie von Open-Source-LLMs (Large Language Models), öffnet Entwicklern und Forschern die Möglichkeit, das Potenzial der KI direkt zu erkunden. Lassen Sie uns untersuchen, wie Sie es können Gemma installieren und ausführen, Zugriff auf vorab trainierte Modelle und Erstellen Sie Ihre eigenen Anwendungen seine vielfältigen Möglichkeiten nutzen.

Plattformunabhängig: Gemma auf CPU, GPU oder TPU

Gemma zeichnet sich durch Plattformflexibilität aus, sodass Sie es auf verschiedenen Hardwarekonfigurationen ausführen können. Für CPU-basierte Setups, die Hugging Face Transformers-Bibliothek und der Tensorflow Lite-Interpreter von Google bieten effiziente Möglichkeiten. Wenn Sie Zugriff darauf haben GPUs oder TPUsNutzen Sie die volle Leistung von TensorFlow für eine beschleunigte Leistung. Erwägen Sie für cloudbasierte Bereitstellungen Google Cloud Vertex AI für nahtlose Integration und Skalierbarkeit.

Greifen Sie auf gebrauchsfertige Modelle zu

Die vortrainierten Modelle von Gemma sind in verschiedenen Größen und Funktionen erhältlich und decken unterschiedliche Anforderungen ab. Bei der Texterstellung, Übersetzung und Beantwortung von Fragen bieten die Varianten Gemma 2B und 7B eine beeindruckende Leistung. Darüber hinaus sind auf Anweisungen abgestimmte Modelle wie Gemma 2B-FT und 7B-FT speziell für die Feinabstimmung Ihrer eigenen Datensätze konzipiert und ermöglichen so eine weitere Personalisierung.

Entdecken Sie Gemmas Fähigkeiten

Lassen Sie uns einige spannende Anwendungen erkunden, die Sie mit Gemma erstellen können:

- Fesselndes Geschichtenerzählen: Generieren Sie mithilfe von Textgenerierungsfunktionen realistische und ansprechende Erzählungen.

- Sprachübersetzung leicht gemacht: Übersetzen Sie Texte nahtlos zwischen Sprachen mit Gemmas mehrsprachigen Fähigkeiten.

- Wissen enthüllen: Implementieren Sie Frage-Antwort-Modelle, um informative und aufschlussreiche Antworten zu geben.

- Generierung kreativer Inhalte: Experimentieren Sie mit Gedichten, Skripten oder der Codegenerierung und erweitern Sie die Grenzen der kreativen KI.

Feinabstimmung und Anpassung

Die wahre Stärke von Gemma liegt in seinen Feinabstimmungsfähigkeiten. Nutzen Sie Ihre eigenen Datensätze, um das Modell an Ihre spezifischen Anforderungen anzupassen und eine beispiellose Leistung zu erzielen. Die bereitgestellten Referenzartikel bieten detaillierte Anweisungen zur Feinabstimmung und Anpassung, sodass Sie das volle Potenzial von Gemma ausschöpfen können.

Der Einstieg bei Gemma ist eine aufregende Reise. Mit seiner Zugänglichkeit, den vielfältigen Funktionen und der lebendigen Community-Unterstützung eröffnet Gemma Entwicklern und Forschern gleichermaßen eine Welt voller Möglichkeiten. Tauchen Sie also ein in die Welt der Open-Source-LLMs und entfesseln Sie die Leistungsfähigkeit von Gemma in Ihrem nächsten KI-Projekt!

Die Zukunft von Gemma

Der Open-Source-Charakter und die beeindruckende Leistung von Gemma haben in der LLM-Community für großes Aufsehen gesorgt.

Doch was steht dieser wachsenden Modellfamilie bevor?

- Fortschritte in der LLM-Landschaft: Gemmas Open-Source-Charakter fördert Zusammenarbeit und Innovation. Forscher und Entwickler auf der ganzen Welt können zu seiner Entwicklung beitragen und den Fortschritt in Bereichen wie Interpretierbarkeit, Fairness und Effizienz beschleunigen. Gemma könnte die Erforschung multimodaler LLMs anführen, die nicht nur Text, sondern auch Bilder, Audio und Video verarbeiten und generieren können.

- Optimistischer Ausblick: Mit seinem demokratisierenden Ansatz und seinen beeindruckenden Fähigkeiten stellt Gemma einen bedeutenden Schritt dar, KI für alle zugänglich und vorteilhaft zu machen. Mit fortschreitender Entwicklung können wir noch mehr bahnbrechende Anwendungen und Weiterentwicklungen erwarten. Der Open-Source-Charakter von Gemma fördert eine lebendige Community und gewährleistet so deren kontinuierliche Weiterentwicklung und ihren Einfluss auf die Zukunft von LLMs.

Zusammenfassung

Gemmas Ankunft in der LLM-Landschaft markiert einen bedeutenden Wendepunkt. Im Gegensatz zu seinen größeren, ressourcenintensiveren Cousins bietet Gemma Zugänglichkeit und Flexibilität und macht erweiterte KI-Funktionen einem breiteren Publikum zugänglich. Sein Open-Source-Charakter fördert Innovation und Zusammenarbeit, beschleunigt den Fortschritt bei der Verarbeitung natürlicher Sprache und gestaltet die Zukunft der KI.

Key Take Away

- Leicht und Open-Source: Die geringere Größe und offene Verfügbarkeit von Gemma machen es auf verschiedenen Plattformen zugänglich und ermöglichen Einzelpersonen und kleineren Organisationen, das Potenzial von KI zu erkunden.

- Vielfältige Varianten und Möglichkeiten: Mit mehreren Größen und auf Anweisungen abgestimmten Optionen erfüllt Gemma unterschiedliche Anforderungen, von der Beantwortung einfacher Fragen bis hin zur Erstellung komplexer Inhalte.

- Potenziale durch Individualisierung freisetzen: Dank der Feinabstimmungsfunktionen können Benutzer Gemma an ihre spezifischen Bedürfnisse anpassen und so neue Möglichkeiten in verschiedenen Bereichen erschließen.

- Eine lebendige Gemeinschaft und eine glänzende Zukunft: Gemmas Open-Source-Charakter fördert eine kollaborative Gemeinschaft und treibt Fortschritte in den Bereichen Interpretierbarkeit, Fairness und multimodale Fähigkeiten voran.

Wichtige Links

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/