Exclusive Im Juli gab das Weiße Haus bekannt, dass sieben große Technologieunternehmen sich zu KI-Sicherheitsmaßnahmen verpflichtet haben, einschließlich der Einführung von Wasserzeichen, um sicherzustellen, dass algorithmisch generierte Inhalte von der Arbeit tatsächlicher Menschen unterschieden werden können.

Unter diesen Riesen, Amazon, Google und OpenAI Alle haben ausdrücklich Wasserzeichen genannt – Techniken zum Hinzufügen von Informationen zu Texten und Bildern, die die Herkunft des Inhalts bestätigen – als eine Möglichkeit, sich gegen Fehlinformationen, Betrug und Deepfakes zu verteidigen, die von ihren generativen KI-Modellen erzeugt werden.

Das Ziel dabei ist, dass KI-generiertes Material subtil markiert wird, sodass es als solches erkannt und identifiziert werden kann, wenn jemand versucht, den Inhalt als von Menschen gemacht auszugeben.

Aber digitale Wasserzeichen in Bildern – das Hinzufügen von Rauschen beim Erstellen von Inhalten und das anschließende Erkennen des Vorhandenseins dieses Rauschmusters in Bilddatensätzen – bieten möglicherweise keine große Sicherheitsgarantie, warnen Wissenschaftler.

Ein Team der University of Maryland in den USA hat die Zuverlässigkeit von Wasserzeichentechniken für digitale Bilder untersucht und festgestellt, dass sie relativ leicht zu umgehen sind. Sie beschreiben ihre Erkenntnisse in einem Preprint-Artikel, der heute Abend auf ArXiv veröffentlicht werden soll: „Robustness of AI-Image Detectors: Fundamental Limits and Practical Attacks“.

Die von Google und anderen Technologiegiganten verfolgten Ansätze, die Ausgabe ihrer generativen Bilder als Verteidigungsmaßnahme mit einem Wasserzeichen zu versehen, werden nicht funktionieren

„In dieser Arbeit decken wir grundlegende und praktische Schwachstellen von Bildwasserzeichen als Abwehr gegen Deepfakes auf“, sagte Soheil Feizi, außerordentlicher Professor für Informatik an der University of Maryland, in einer E-Mail an Das Register.

„Dies zeigt, dass die aktuellen Ansätze von Google und anderen Technologiegiganten, die Ausgabe ihrer generativen Bilder mit einem Wasserzeichen zu versehen, als Verteidigung nicht funktionieren werden.“

Die Erkenntnisse der Experten der University of Maryland – Mehrdad Saberi, Vinu Sankar Sadasivan, Keivan Rezaei, Aounon Kumar, Atoosa Chegini, Wenxiao Wang und Soheil Feizi – deuten darauf hin, dass es einen grundlegenden Kompromiss zwischen der Umgehungsfehlerrate (dem Prozentsatz der mit Wasserzeichen versehenen Personen) gibt Bilder, die als nicht markiert erkannt wurden – d. h. falsch-negative Ergebnisse) und die Spoofing-Fehlerrate (der Prozentsatz nicht markierter Bilder, die als mit Wasserzeichen versehen erkannt wurden – falsch-positive Ergebnisse).

Anders ausgedrückt: Wasserzeichenerkennungssysteme können eine hohe Leistung (wenige falsch-negative Ergebnisse) oder eine hohe Robustheit (wenige falsch-positive Ergebnisse) aufweisen, jedoch nicht beides gleichzeitig.

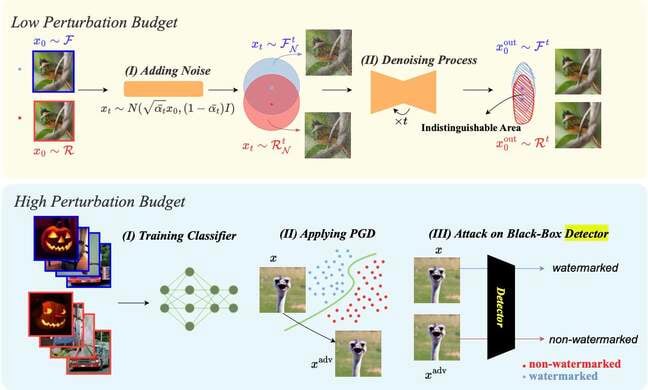

Die Autoren des Papiers haben eine Angriffstechnik für Bilder mit geringer Störung (mit nicht wahrnehmbaren Wasserzeichen) namens Diffusionsreinigung entwickelt, die ursprünglich als Abwehr vorgeschlagen wurde gegnerische Beispiele – Eingaben, die ein Modell absichtlich dazu bringen, Fehler zu machen. Dabei wird den Bildern Gaußsches Rauschen hinzugefügt und anschließend der Entrauschungsprozess von Diffusionsmodellen verwendet, um die hinzugefügten Daten zu entfernen.

Diagramm von Robustness of AI-Image Detectors: Grundlegende Grenzen und praktische Angriffe … Zum Vergrößern anklicken

Und für stark gestörte Bilder (wahrnehmbare Wasserzeichen), die dem Diffusionsreinigungsangriff nicht ausgesetzt sind, haben die Forscher einen Spoofing-Mechanismus entwickelt, der das Potenzial hat, Bilder ohne Wasserzeichen so aussehen zu lassen, als wären sie mit einem Wasserzeichen versehen. Dieses Szenario könnte nach Ansicht der Autoren negative finanzielle oder PR-Folgen für Unternehmen haben, die KI-Modelle verkaufen.

„Unser [High-Perturbation]-Angriff funktioniert, indem er Wasserzeichen-Modelle anweist, ein Bild mit weißem Rauschen mit einem Wasserzeichen zu versehen und dann dieses verrauschte Bild mit Wasserzeichen mit Bildern ohne Wasserzeichen zu mischen, um den Detektor zu täuschen und sie als mit Wasserzeichen versehen zu kennzeichnen“, erklärt das Papier.

Auf die Frage, ob es Parallelen in der immer kleiner werdenden Kluft zwischen Menschen und Maschinen beim CAPTCHA-Bildrätsel zur Erkennung von Unterschieden zwischen von Menschen und Maschinen generierten Inhalten gibt, sagten Feizi und Mehrdad Saberi, Doktorand an der University of Maryland und Hauptautor des Artikels, Maschine Lernen wird immer leistungsfähiger.

„Maschinelles Lernen schreitet unbestreitbar von Tag zu Tag voran und zeigt das Potenzial, die menschliche Leistung zu erreichen oder sogar zu übertreffen“, sagten Feizi und Saberi in einer E-Mail an Das Register.

„Dies deutet darauf hin, dass Aufgaben wie das Entschlüsseln von CAPTCHA-Bildern oder das Generieren von Text möglicherweise bereits zu den Fähigkeiten der KI gehören und mit menschlichen Fähigkeiten konkurrieren können.“

„Bei der Generierung von Bildern und Videos ähneln KI-generierte Inhalte immer mehr realen Inhalten, und die Aufgabe, sie voneinander zu unterscheiden, könnte in naher Zukunft unabhängig von der verwendeten Technik unmöglich sein. Tatsächlich zeigen wir in unserer Arbeit einen Kompromiss zwischen Robustheit und Zuverlässigkeit für klassifizierungsbasierte Deepfake-Detektoren.“

Das Register hat Google und OpenAI um einen Kommentar gebeten, aber keiner hat geantwortet.

Feizi und Saberi sagten, sie hätten keine konkrete Analyse durchgeführt Google oder die Wasserzeichen-Mechanismen von OpenAI, da keines der Unternehmen seinen Wasserzeichen-Quellcode veröffentlicht hatte.

„Aber unsere Angriffe sind in der Lage, jedes vorhandene Wasserzeichen zu durchbrechen, auf das wir gestoßen sind“, sagten sie.

„Ähnlich wie bei einigen anderen Problemen im Computer Vision (z. B. Robustheit gegenüber Gegnern) glauben wir, dass das Bildwasserzeichen in Zukunft ein Wettlauf zwischen Abwehrmaßnahmen und Angriffen sein wird. Während also in Zukunft möglicherweise neue robuste Wasserzeichenmethoden vorgeschlagen werden, werden auch neue Angriffe vorgeschlagen, um diese zu knacken.“ ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2023/10/02/watermarking_security_checks/