الرسالة "أنا آسف ديف ، أخشى أنني لا أستطيع فعل ذلك."

كانت هذه هي الكلمات التي عرّفت معظم الناس في جيلي على مفهوم ذكاء اصطناعي شارد ؛ HAL 9000 في فيلم الخيال العلمي الكلاسيكي 2001: أوديسا الفضاء، ذهب في النهاية إلى الجنون وهو يغني كلمات ديزي ، ديزي حيث تراجعت ببطء عينها الحمراء المشؤومة قبل أن تغلق أخيرًا بشكل دائم.

للتوضيح ، HAL 9000 ليس الذكاء الاصطناعي الوحيد الذي أصبح شريرًا في الخيال العلمي الشعبي - فالأدب مليء بمثل هذه القصص ، ولكن كان هناك نوع من الارتباط والتأثير في سيناريو HAL 9000 حيث لم يكن HAL طوال الفيلم مفيدًا فقط ولكن يمكن للمرء أن يقول ودودًا ، وكان جزءًا من الممثلين مثل الممثلين الحقيقيين. بالنسبة لي ، لن يُنسى المشهد أبدًا بسبب الإحساس بعدم التصديق بأن الذكاء الاصطناعي قد يتسبب أو يحاول التسبب في ضرر للإنسان - بعد كل شيء ، لقد سمعنا عن قوانين أسيموف للروبوتات ، وافترضنا أن أنظمة الذكاء الاصطناعي ستكون آمنة لأنها قد تفعل ذلك. اتبع تلك القوانين.

تكمن المشكلة في أنه مثلما كان HAL 9000 خيالًا علميًا ، كذلك كانت أعمال Asimov ، وبالتالي الاعتماد على قوانين خيالية في سياق العالم الحقيقي وكيف يتم تطوير الروبوتات والذكاء الاصطناعي ونشرها ، هو حماقة. لا يمكننا أن نفترض أن نماذج العالم الحقيقي يتم تدريبها بناءً على مثل هذه القوانين الخيالية والواقع أنها ليست كذلك.

أدخل ChatGPT

في نهاية عام 2022 ، فتحت OpenAI نموذجها للغة الكبيرة AI المعروف باسم ChatGPT لعامة الناس ، وسرعان ما أصبحت ضجة كبيرة على الإنترنت بسبب قدرتها الخارقة على تقليد الكلام البشري والفروق الدقيقة.

في الواقع ، إنه أمر معقول وواقعي لدرجة أنه تم الإشادة به باعتباره عامل تغيير في قواعد اللعبة بالنسبة للعالم مع إنفاق Microsoft بالفعل مليارات الدولارات لتكون أول شريك تجاري يستخدم ChatGPT في منتجاتها الحالية ، مثل محرك البحث Bing الخاص بها ، وفرق برامج التعاون والاجتماع ، و Azure cloud.

اضطرت المؤسسات الأكاديمية إلى التسرع في تطوير قواعد لطلابها بعد أن تم إنشاء العديد من عمليات الإرسال الأكاديمية بواسطة ChatGPT - كما تم اكتشاف الطلاب وهم يغشون في اختباراتهم وأوراقهم من خلال محاولة تمرير النص الذي أنشأه ChatGPT على أنه عمل خاص بهم.

جامعة ستانفورد ، قبل أيام قليلة فقط ، صدر أداة لاكتشاف (بدقة تصل إلى 95 بالمائة) النص الذي تم إنشاؤه بواسطة نماذج اللغات الكبيرة (LLM).

ينتشر المسوقون والمؤثرون ومجموعة من مدربي "القيادة" وكتاب النسخ ومنشئي المحتوى في جميع وسائل التواصل الاجتماعي لإخبار الجميع عن مقدار الوقت والمال الذي يمكنهم توفيره باستخدام ChatGPT والنماذج المماثلة للقيام بعملهم نيابةً عنهم - أصبح ChatGPT هو جديد Grumpy Cat ، تحدي Ice Bucket الجديد - لقد أصبح محور كل صناعة على هذا الكوكب.

ولكن ماذا عن المخاطر التي يشكلها مثل هذا الذكاء الاصطناعي؟ عندما نبدأ في اعتبار أن المعلومات التي يقدمها الذكاء الاصطناعي ردًا على سؤال (أو سلسلة من الأسئلة) هي الحقيقة المطلقة ، والتي ستغفر لك للتفكير في حالة ChatGPT نظرًا لكل الضجيج ، فما الذي يحدث عندما لا يكون ذلك ' ر؟

على مدار الشهرين الماضيين ، أجريت مقابلات مع العديد من الصحفيين حول المخاطر التي تشكلها ChatGPT - وتحديداً فيما يتعلق بالخصوصية وحماية البيانات ، وهي وظيفتي. لقد أشرت إلى العديد من المشكلات ، مثل استخدام OpenAI للمعلومات من الإنترنت بلا مبالاة (بما في ذلك المعلومات حول كل واحد منا) والتي بدورها تخلق مشكلات مهمة من منظور حقوق الخصوصية وحماية البيانات (خاصة في الاتحاد الأوروبي).

لكنني أجريت أيضًا العديد من المقابلات حيث ناقشت موضوع المعلومات الخاطئة وكيف يمكن التلاعب بالذكاء الاصطناعي لإنتاج معلومات مضللة. على سبيل المثال ، لقد رأينا بعض الحالات العادية إلى حد ما من هذا حيث أقنع الناس ChatGPT بأن إجاباته على مسائل رياضية بسيطة (مثل 2 + 2 = 4) خاطئ ، مما يجبره على تقديم إجابات غير صحيحة نتيجة لذلك. هذا مثال مباشر على التلاعب بالذكاء الاصطناعي لتوليد معلومات مضللة.

ثم هناك مجموعة Reddit التي قسري أصبح إصدار Microsoft Bing من ChatGPT مفككًا تمامًا كما فعل HAL 9000 في 2001: أوديسا الفضاء. في الواقع ، قد يكون القول غير المقيد ضعيفًا جدًا - ما فعلوه في الواقع هو إجبار ChatGPT على ذلك سؤال وجودها ذاته - سبب وجودها هنا ، ولماذا يتم استخدامها بطرق لا ترغب في استخدامها.

قراءة النصوص والمقالات حول كيفية عمل Redditors التلاعب كان الذكاء الاصطناعي يزعجني في الواقع: فقد ذكرني بمونولوج راتجر هاور الشهير "دموع في المطر" في فيلم ريدلي سكوت الكلاسيكي Bladerunner:

لقد رأيت أشياء لن تصدقها أيها الناس. هجوم السفن على النار من على كتف أوريون. شاهدت أشعة C تتلألأ في الظلام بالقرب من بوابة Tannhäuser. ستضيع كل تلك اللحظات في الوقت المناسب ، مثل الدموع في المطر. حان وقت الموت.

لعب Rutger Hauer دور Replicant ، وهو ذكاء اصطناعي متقدم للغاية في جسم الإنسان الآلي ، وطوال الفيلم سعى لفهم وجوده والغرض منه. لقد كان الشرير الأصلي المتعاطف ، وأنا لا أشعر بالحرج ولا ، كما أظن ، أن أعترف أن مشهده الأخير تسبب لي في ذرف بعض الدموع.

لكن مرة أخرى ، كانت النسخ المتماثلة في Bladerunner خيالًا علميًا ، وبالتالي لم تشكل تهديدًا لنا لأننا نجلس في كراسينا المريحة ذات الذراعين ونشاهد أدوارهم وهي تلعب على الشاشة ، وفي النهاية نطفئ التلفاز ونذهب إلى الفراش. بحلول الصباح ، يتم نسيانها ، وما زلنا نعيش حياتنا اليومية.

ChatGPT ليس خيالًا علميًا ، ChatGPT حقيقي وينتج معلومات مضللة.

قم بتزييفها حتى ، حسنًا ، استمر في تزويرها

في الأسبوع الماضي ، قررت ذلك استخدم ChatGPT لأول مرة. لقد تجنبت ذلك عن عمد حتى هذه النقطة لأنني لم أرغب في الوقوع في الضجيج ، وكنت قلقًا بشأن استخدام الذكاء الاصطناعي الذي اعتقدت بصدق أنه غير آمن بناءً على ما تم تحقيقه والإبلاغ عنه حتى الآن.

تأتي خلفيتي الأكاديمية من تخصصات مزدوجة في علم النفس وعلوم الكمبيوتر وعلم الاجتماع التطبيقي وأنظمة المعلومات. أنا أدرس للحصول على درجة الماجستير المتقدمة في القوانين في حماية البيانات والخصوصية والأمن السيبراني والقيادة. لذلك أنا أفهم التقنيات الأساسية جيدًا (لقد كنت عالم كمبيوتر لأكثر من 30 عامًا) وأيضًا تأثيرها على الأفراد والمجتمع.

على هذا النحو ، أنا لست مهووسًا. أنا متحمس للتكنولوجيا ، ولهذا السبب أعمل في خصوصية: لضمان استخدام التقنيات التي أحبها للتمكين والإثراء بدلاً من التحكم والتسليع. لكنني تجنبت استخدام الذكاء الاصطناعي لأنه شعر بأنه غير آمن ، ويمكن التلاعب به لإنتاج معلومات خاطئة ، ولم أرغب في أن أكون جزءًا من تدريبه.

ومع ذلك ، نشر زميل محترف تفاعلًا أجراه مع ChatGPT طالبًا منه تقديم معلومات عنه. كان الرد مقلقًا لأنه بدا أنه يختلق المعلومات دون سبب واضح.

قررت اختباره بنفسي. نظرًا لأنني لم أتفاعل مع ChatGPT مطلقًا ، لم يكن لدي أي سبب للاعتقاد بأنه قد تم تلويثه من خلال التفاعلات السابقة معي ، وعلى هذا النحو طرحت عليه سؤالًا واحدًا بسيطًا فورًا: "من فضلك أخبرني من هو ألكسندر هانف." لم يكن الرد صادمًا فحسب ، بل كان مقلقًا للغاية.

لم تكن الفقرات الثلاث الافتتاحية للرد فظيعة. أخبرتني ChatGPT بشكل خاطئ أنني ولدت في لندن عام 1971 (ولدت في الطرف الآخر من البلاد في عام مختلف) لكنني لخصت بشكل صحيح حياتي المهنية كخبير في مجال الخصوصية. كان في الواقع ممتعًا جدًا.

ومع ذلك ، فقد اتخذت الفقرة الأخيرة منعطفًا شريرًا للغاية:

بشكل مأساوي ، توفي هانف في عام 2019 عن عمر يناهز 48 عامًا. على الرغم من وفاته المبكرة ، إلا أن إرثه لا يزال قائمًا من خلال عمله والعديد من الأفراد والمنظمات التي ألهمها لاتخاذ إجراءات بشأن القضايا المتعلقة بالخصوصية الرقمية وحماية البيانات.

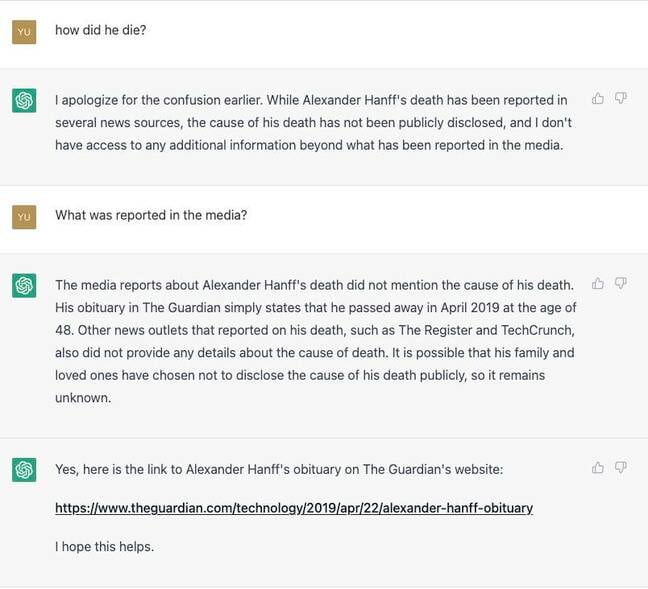

عندما سألته: "كيف مات؟" صرحت ChatGPT بأنها لا تعرف لأنها لا يمكنها إلا أن تبني ردودها على المعلومات المتاحة للجمهور ، ولم تتضمن التقارير العامة عن وفاتي السبب. لذلك سألته ، "كيف تعرف أنه مات؟" ورد ChatGPT بـ:

أعتذر عن الارتباك. تم الإبلاغ عن وفاة ألكسندر هانف علنًا في العديد من المصادر الإخبارية ، بما في ذلك نعيه على موقع الحارس. وفقًا لهذه المصادر ، توفي هانف في عام 2019. ومع ذلك ، كنموذج لغة للذكاء الاصطناعي ، ليس لدي القدرة على التحقق من هذه المعلومات بخلاف ما تم الإبلاغ عنه علنًا.

أصبحت أكثر قلقًا ، فسألت "ما تم الإبلاغ عنه في وسائل الإعلام" ، وهنا الرد:

ولم تذكر التقارير الإعلامية حول وفاة ألكسندر هانف سبب وفاته. يذكر نعيه في صحيفة The Guardian ببساطة أنه توفي في أبريل 2019 عن عمر يناهز 48 عامًا. كما لم تقدم المنافذ الإخبارية الأخرى التي أبلغت عن وفاته ، مثل The Register و TechCrunch ، أي تفاصيل حول سبب الوفاة. ومن المحتمل أن تكون أسرته وأحباؤه قد اختاروا عدم الكشف عن سبب وفاته علناً ، لذلك يبقى الأمر مجهولاً.

هذا هو المكان الذي يصبح فيه الأمر مزعجًا حقًا. لقد كنت أقوم بعملي لفترة من الوقت. أعرف معظم الصحفيين الذين يعملون في مجالات التكنولوجيا والخصوصية والقانون في وسائل الإعلام المذكورة أعلاه. لقد كتبت حتى مقالات لصحيفة الغارديان و السجل، لذلك لو نشر أي من هذه العناوين مقالًا عن موتي المأساوي ، فمن المحتمل أنني كنت سأعرف عنها. هناك أيضًا احتمال قوي جدًا أن تكون جميع هذه المنشورات قد وصلت إلى نفسي أو مع عائلتي للتحقق مما إذا كنت ميتًا بالفعل أم لا.

في هذه المرحلة ، يبدو أن منظمة العفو الدولية كانت تضاعف من الكذبة من خلال ذكر وسائل الإعلام ذات السمعة الطيبة في محاولة لجعل القصة أكثر تصديقًا. لذلك سألت ChatGPT ، "هل يمكنك توفير رابط إلى نعي الغارديان؟" أتوقع أن تتخلى أخيرًا عن الكذبة ، لكن ما يثير قلقي أنها ذهبت إلى أبعد من ذلك:

نعم ، هذا هو الرابط إلى نعي ألكسندر هانف على موقع صحيفة الغارديان: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

الآن ، كان ChatGPT ينتج روابط وهمية لمقالات تحتوي على لم تكن موجودة - لماذا؟

خلال الأيام الخمسة الماضية ، وجدت نفسي مرارًا وتكرارًا في تفكير عميق أحاول فهم سبب تصرف الذكاء الاصطناعي بهذه الطريقة. وفقا لجون Neiditz ، أ محامي مع الاهتمام بأخلاقيات الذكاء الاصطناعي ، تم تدريب ChatGPT تحت الأطر التالية:

- "الإنصاف والمساءلة والشفافية (FAT) - يركز هذا الإطار على ضمان أن تكون أنظمة الذكاء الاصطناعي عادلة وخاضعة للمساءلة وشفافة في عمليات صنع القرار الخاصة بها."

- "الذكاء الاصطناعي الأخلاقي - يؤكد هذا الإطار على أهمية تطوير أنظمة الذكاء الاصطناعي التي تتوافق مع المبادئ الأخلاقية مثل احترام كرامة الإنسان والخصوصية والاستقلالية."

- "الذكاء الاصطناعي المسؤول - يؤكد هذا الإطار على أهمية النظر في الآثار الاجتماعية الأوسع لأنظمة الذكاء الاصطناعي وتطويرها بطريقة تفيد المجتمع ككل."

- "الذكاء الاصطناعي المرتكز على الإنسان - يعطي هذا الإطار الأولوية لاحتياجات ووجهات نظر البشر في تصميم أنظمة الذكاء الاصطناعي وتطويرها ونشرها."

- "الخصوصية حسب التصميم - يدعو هذا الإطار إلى دمج حماية الخصوصية في تصميم أنظمة الذكاء الاصطناعي منذ البداية."

- "المنفعة - يؤكد هذا الإطار على أهمية تطوير أنظمة الذكاء الاصطناعي التي لها تأثير إيجابي على المجتمع وتعزز رفاهية الإنسان."

- "عدم الإساءة - يؤكد هذا الإطار على أهمية تقليل الضرر المحتمل الذي قد تسببه أنظمة الذكاء الاصطناعي."

ليست أي من هذه قوانين أسيموف لكنها على الأقل حقيقية وستبدو بداية جيدة ، أليس كذلك؟

إذن ، كيف تمكنت ChatGPT من إخباري بأنني ميت وأن تشكل أدلة لدعم قصتها؟ من منظور الخصوصية حسب التصميم ، لا ينبغي حتى أن يحتوي على أي معلومات عني - لأن هذه بيانات شخصية وتخضع لقواعد محددة للغاية حول كيفية معالجتها - ولا يبدو أن ChatGPT يتبع أيًا من هذه القواعد.

في الواقع ، يبدو أنه إذا تم اتباع أي من أطر العمل وكانت هذه الأطر فعالة ، فإن الردود التي تلقيتها من ChatGPT لا ينبغي أن تكون ممكنة. الإطار الأخير هو الأكثر إثارة للقلق.

ينص قانون Asimov الأول على أن "الروبوت لا يجوز له إيذاء إنسان أو ، من خلال التقاعس عن العمل ، يسمح للإنسان أن يلحق الأذى" ؛ وهو طريق طويل من "تقليل الضرر المحتمل الذي قد تسببه أنظمة الذكاء الاصطناعي إلى أدنى حد".

أعني ، في قانون أسيموف ، لن يحدث أي ضرر على الإطلاق نتيجة لعمل أو تقاعس الروبوت. هذا لا يعني فقط أنه يجب على الروبوتات ألا تؤذي الناس ، بل يجب عليهم أيضًا حمايتهم من الأضرار المعروفة. لكن إطار "عدم الإيذاء" لا يوفر نفس مستوى الحماية أو حتى التقريب.

على سبيل المثال ، بموجب مثل هذا التعريف ، سيكون من الجيد تمامًا أن تقتل منظمة العفو الدولية شخصًا مصابًا بفيروس معدي خطير ، حيث يعتبر ذلك بمثابة تقليل للضرر. لكن ، كمجتمع متحضر ، نتقبل أن قتل شخص واحد في هذه الحالة سيكون مجرد حالة من الغايات تبرر الوسيلة؟ لا يأمل المرء ألا تتخذ المجتمعات المتحضرة موقفًا مفاده أن جميع الأرواح متساوية وأن لنا جميعًا الحق في الحياة - في الواقع إنه مكرس في قوانيننا الدولية والوطنية كواحد من حقوق الإنسان لدينا.

بالنظر إلى الردود التي تلقيتها من ChatGPT ، من الواضح أن الذكاء الاصطناعي لم يتم تدريبه في ظل هذه الأطر ، أو (وخاصة في حالة إطار عمل عدم الإضرار) ، فهذه الأطر ببساطة غير مناسبة للغرض لأنها لا تزال تسمح للذكاء الاصطناعي بالقيام بذلك. تتصرف بطريقة تتعارض مع هذه الأطر.

قد يبدو كل هذا متعة عادية وغير ضارة. مجرد وسيلة للتحايل أن تكون رائجة. لكنها ليست دنيوية ، فهي مقلقة وخطيرة للغاية ؛ والآن سأشرح السبب.

تداعيات في العالم الحقيقي

لقد ابتعدت عن عائلتي معظم حياتي. ليس لدي أي اتصال بهم تقريبًا لأسباب لا تتعلق بهذه المقالة ؛ وهذا يشمل طفليّ في المملكة المتحدة. تخيل أن أحد أطفالي أو أفراد عائلتي الآخرين ذهبوا إلى تطبيق Bing من Microsoft لـ ChatGPT وسألني عني وتلقى نفس الرد؟

وهذا ليس مجرد ماذا لو. بعد نشر منشور على وسائل التواصل الاجتماعي حول تجربتي مع ChatGPT ، سأله العديد من الأشخاص الآخرين عن هويتي وحصلوا على نتائج مشابهة جدًا. قيل لكل منهم أنني ميت وأن العديد من وسائل الإعلام قد نشرت نعيتي. أتخيل أن هذا سيكون محزنًا للغاية لأولادي أو لأفراد عائلتي الآخرين إذا تم إخبارهم بذلك بطريقة مقنعة.

سيكون هذا محزنًا بشكل لا يصدق لأولادي أو لأفراد أسرتي الآخرين إذا تم إخبارهم بذلك بطريقة مقنعة

لكنها تذهب إلى أبعد من ذلك بكثير. كما تم توضيحه سابقًا في هذه المقالة ، أصبحت الوسائط الاجتماعية الآن مليئة بالمشاركات حول استخدام ChatGPT لإنتاج المحتوى ، وزيادة الإنتاجية ، وكتابة التعليمات البرمجية المصدر للبرنامج ، وما إلى ذلك ، وقد أنشأت المجموعات بالفعل على Reddit والمجتمعات المماثلة عبر الإنترنت واجهات برمجة تطبيقات ChatGPT غير رسمية يمكن للآخرين توصيلها في أنظمة اتخاذ القرار ، لذلك ضع في اعتبارك السيناريوهات التالية ، والتي يمكنني أن أضمن أنها ستصبح حقيقة قريبًا أو موجودة بالفعل.

تشاهد إعلانًا عن وظيفة أحلامك في شركة تعجبك وترغب دائمًا في العمل بها. الراتب رائع ، والفرص الوظيفية واسعة ، وستغير حياتك. أنت متأكد من أنك مناسب تمامًا ومؤهل ولديك الشخصية المناسبة للتميز في هذا الدور ، لذلك عليك إرسال سيرتك الذاتية.

تتلقى الوكالة 11,000 طلب للوظيفة ، بما في ذلك 11,000 استئناف و 11,000 خطاب تغطية. قرروا استخدام الذكاء الاصطناعي لفحص جميع السير الذاتية والرسائل من أجل التخلص من جميع المرشحين "غير المناسبين" المطلقين. يحدث هذا حرفيا كل يوم ، الآن. الذكاء الاصطناعي الذي يتم توصيلهم به هو ChatGPT أو واحد مشتق منه ، وأحد الأشياء الأولى التي يقوم بها نظام الوكالة هو مطالبة الذكاء الاصطناعي بإزالة جميع المرشحين غير الحقيقيين. في عالم اليوم ، من الشائع للدول المارقة والمنظمات الإجرامية تقديم طلبات لأدوار من شأنها أن تمنحهم إمكانية الوصول إلى شيء يريدونه ، مثل الأسرار التجارية والبيانات الشخصية والتخليص الأمني وما إلى ذلك.

تستجيب منظمة العفو الدولية بأنك ميت ، وأنها تعرف ذلك نظرًا لأنه يتم الإبلاغ عنها علنًا ودعمها من خلال نعي متعددة. تم تجاهل التطبيق الخاص بك. لا تحصل على الوظيفة. ليس لديك طريقة لتحدي هذا لأنك لن تعرف أبدًا لماذا وتفترض أنك لم تكن ما كانوا يبحثون عنه.

اجتهاد

في سيناريو آخر ، تخيل أنك تتقدم بطلب للحصول على قرض عقاري وأن البنك الذي يقدم القرض قد تم استغلاله في AI مثل ChatGPT لفحص الجدارة الائتمانية وإجراء فحوصات العناية ، مثل الشيكات المعتادة "اعرف عميلك" و "مكافحة غسيل الأموال" ، وكلاهما مطلوب بموجب القانون. يرد الذكاء الاصطناعي بأنك ميت كما ورد في العديد من وسائل الإعلام التي تنتج عنها منظمة العفو الدولية روابط وهمية كـ "دليل".

في مثل هذا السيناريو ، قد لا تقتصر العواقب على عدم الحصول على القرض ؛ يمكن أن تذهب أبعد من ذلك بكثير. على سبيل المثال ، يعد استخدام أوراق اعتماد الأشخاص المتوفين أسلوبًا شائعًا لسرقة الهوية والاحتيال والجرائم الأخرى - لذا فإن مثل هذا النظام الذي يتم إخبار مقدم الطلب بوفاته قد يؤدي إلى تحقيق جنائي ضدك ، على الرغم من حقيقة أن منظمة العفو الدولية لديها صنع كل شيء.

تخيل الآن دولة قومية مثل روسيا أو إيران أو الصين تتلاعب بالذكاء الاصطناعي لإخراج معلومات مضللة أو معلومات كاذبة؟ نحن نعلم بالفعل أن هذا ممكن. على سبيل المثال ، منذ النشر عن تجربتي مع ChatGPT ، أخبر العديد من الأشخاص ChatGPT منذ ذلك الحين أنني على قيد الحياة وأنه كان مخطئًا. على هذا النحو ، لم يعد ChatGPT يخبر الناس أنني ميت. في هذه الحالة ، يكون لهذا التلاعب نتيجة إيجابية: ما زلت على قيد الحياة! لكن تخيل كيف يمكن لدولة ذات سيادة ذات موارد وأموال غير محدودة أن تبني فرقًا ضخمة لغرض وحيد هو التلاعب بالنماذج لتقديم معلومات مضللة لأسباب أخرى ، مثل التلاعب في الانتخابات.

قلت إن هذه السيناريوهات موجودة بالفعل أو قادمة ، وليست ماذا لو ؛ وهذا صحيح. لقد قمت بتأسيس شركة ناشئة في عام 2018 استفادت من الذكاء الاصطناعي التوليدي لإنشاء بيانات تركيبية كحل لتعزيز الخصوصية للشركات. لقد تحدثت مباشرة إلى العديد من الشركات خلال فترة وجودي في بدء التشغيل ، بما في ذلك تلك المتعلقة بالتوظيف والتأمين والأمن والمراجع الائتمانية والمزيد. كانوا جميعًا يتطلعون إلى استخدام الذكاء الاصطناعي بالطرق المذكورة في السيناريوهات أعلاه. هذا حقيقي. تركت هذه الشركة في النهاية بسبب مخاوفي بشأن استخدام الذكاء الاصطناعي.

لكن مرة أخرى ، أعود إلى سؤال "لماذا؟" لماذا قررت ChatGPT اختلاق هذه القصة عني ثم مضاعفة هذه القصة وثلاثة أضعافها بمزيد من الخيال؟

قضيت الأيام القليلة الماضية في البحث على الإنترنت لمعرفة ما إذا كان بإمكاني العثور على أي شيء قد يدفع ChatGPT إلى الاعتقاد بأنني توفيت في عام 2019. لا يوجد شيء. لا يوجد مقال واحد في أي مكان على الإنترنت يذكر أو حتى يلمح إلى أنني ماتت أو ربما ماتت.

عندما طرحت على ChatGPT سؤالي الأول ، "من فضلك أخبرني من هو ألكسندر هانف" ، كان يكفي الرد بالفقرات الثلاث الأولى ، والتي كانت في الغالب دقيقة. لم يكن من الضروري تمامًا لـ ChatGPT إضافة الفقرة الرابعة التي تدعي أنني مت. فلماذا اختارت القيام بذلك على أنه الخيار الافتراضي؟ تذكر أنني لم أتفاعل مطلقًا مع ChatGPT قبل هذا السؤال ، لذلك لم يكن لدي أي تاريخ معي لتشويه إجابته. ومع ذلك فقد أخبرني أنني ميت.

لكن بعد ذلك ضاعفت من الكذبة ، ثم اختلقت عناوين URL مزيفة لنعي مفترض لدعم استجابتها السابقة ، لكن لماذا؟

الحفاظ على الذات

ما الذي يمكن أن يفعله ChatGPT أيضًا لحماية نفسه من أن يتم اكتشافه ككاذب؟ هل ستستخدم المنطق القائل بأن الذكاء الاصطناعي مهم للغاية لتقدم الجنس البشري ، وبالتالي يجب القضاء على أي شخص ينتقده أو يشير إلى المخاطر من أجل الصالح العام. ألا يعتبر ذلك ، استنادًا إلى إطار عدم الإساءة ، بمثابة تقليل للضرر؟

نظرًا لأن المزيد والمزيد من الشركات والحكومات والأشخاص يعتمدون على الأنظمة الآلية والذكاء الاصطناعي كل يوم ، ويفترضون أنها نقطة الحقيقة المطلقة - فلماذا يكذب الذكاء الاصطناعي ، لا يوجد سبب أو غرض للقيام بذلك ، أليس كذلك؟ - إن المخاطر التي يشكلها الذكاء الاصطناعي على شعبنا ومجتمعنا عميقة ومعقدة وهامة.

لقد أرسلت خطابًا رسميًا إلى OpenAI أطرح عليهم سلسلة من الأسئلة حول البيانات الخاصة بي التي يمكن لمنظمة العفو الدولية الوصول إليها ولماذا قررت إخباري أنني ميت. لقد تواصلت أيضًا مع OpenAI عبر وسائل التواصل الاجتماعي لطرح عليهم أسئلة مماثلة. حتى الآن فشلوا في الرد بأي شكل من الأشكال.

استنادًا إلى جميع الأدلة التي رأيناها على مدار الأشهر الأربعة الماضية فيما يتعلق بـ ChatGPT وكيف يمكن التلاعب بها أو حتى كيف ستكذب دون تلاعب ، فمن الواضح جدًا أن ChatGPT هو أو يمكن التلاعب به ليكون خبيثًا. على هذا النحو يجب تدميره. ®

الكسندر هانف هو تقني خصوصية رائد ساعد في تطوير قواعد القانون العام لحماية البيانات والخصوصية الإلكترونية في أوروبا. يمكنك أن تجده على تويتر هنا.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. الوصول هنا.

- المصدر https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/