صورة المؤلف

بالنسبة للكثيرين منا، كان استكشاف إمكانيات ماجستير إدارة الأعمال أمرًا بعيد المنال. سواء كان الأمر يتعلق بتنزيل برامج معقدة، أو اكتشاف البرمجة، أو الحاجة إلى أجهزة قوية - فإن البدء في الحصول على ماجستير إدارة الأعمال قد يبدو أمرًا شاقًا. لكن تخيل فقط، لو تمكنا من التفاعل مع هذه النماذج اللغوية القوية بنفس السهولة التي نتعامل بها مع تشغيل أي برنامج آخر على أجهزة الكمبيوتر لدينا. لا يوجد تثبيت ولا برمجة، فقط انقر وتحدث. تعد إمكانية الوصول هذه أمرًا أساسيًا لكل من المطورين والمستخدمين النهائيين. يظهر ملف llamaFile كحل جديد، حيث يقوم بدمج ملف llamaFile اللاما مع كوزموبوليتان ليبك في إطار واحد. يقلل هذا الإطار من تعقيد LLMs من خلال تقديم ملف واحد قابل للتنفيذ يسمى "ملف اللاما"والذي يعمل على الأجهزة المحلية دون الحاجة إلى التثبيت.

فكيف يعمل؟ عروض ملف اللاما طريقتان مناسبتان لتشغيل LLMs:

- تتضمن الطريقة الأولى تنزيل أحدث إصدار من ملف llamafile بالإضافة إلى أوزان النماذج المقابلة من Hugging Face. بمجرد حصولك على هذه الملفات، فأنت جاهز للبدء!

- الطريقة الثانية أبسط – يمكنك الوصول إليها أمثلة على ملفات llamafiles الموجودة مسبقًا التي تحتوي على أوزان مدمجة.

في هذا البرنامج التعليمي، ستعمل مع ملف llamafile الخاص بـ نموذج لافا باستخدام الطريقة الثانية. إنه نموذج مكون من 7 مليارات معلمة مكمّم إلى 4 بتات يمكنك التفاعل معه عبر الدردشة وتحميل الصور وطرح الأسئلة. تتوفر أيضًا أمثلة لملفات اللاما للنماذج الأخرى، ولكننا سنعمل مع نموذج LLaVa حيث يبلغ حجم ملف اللاما الخاص به 3.97 جيجابايت، بينما يبلغ الحد الأقصى لحجم الملف القابل للتنفيذ في Windows 4 جيجابايت. العملية بسيطة بما فيه الكفاية، ويمكنك تشغيل LLMs باتباع الخطوات المذكورة أدناه.

أولاً، تحتاج إلى تنزيل ملف llava-v1.5-7b-q4.llamafile (3.97 جيجابايت) القابل للتنفيذ من المصدر المقدم هنا.

افتح محطة جهاز الكمبيوتر الخاص بك وانتقل إلى الدليل الذي يوجد به الملف. ثم قم بتشغيل الأمر التالي لمنح الإذن لجهاز الكمبيوتر الخاص بك بتنفيذ هذا الملف.

chmod +x llava-v1.5-7b-q4.llamafileإذا كنت تستخدم نظام التشغيل Windows، أضف ".exe" إلى اسم ملف llamafile في النهاية. يمكنك تشغيل الأمر التالي على الجهاز لهذا الغرض.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeقم بتنفيذ ملف اللاما عن طريق الأمر التالي.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ نظرًا لأن نظام MacOS يستخدم zsh باعتباره الصدفة الافتراضية الخاصة به وإذا قمت بالركض عبره zsh: exec format error: ./llava-v1.5-7b-q4.llamafile خطأ فأنت بحاجة إلى تنفيذ هذا:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

بالنسبة لنظام التشغيل Windows، قد يبدو الأمر الخاص بك كما يلي:

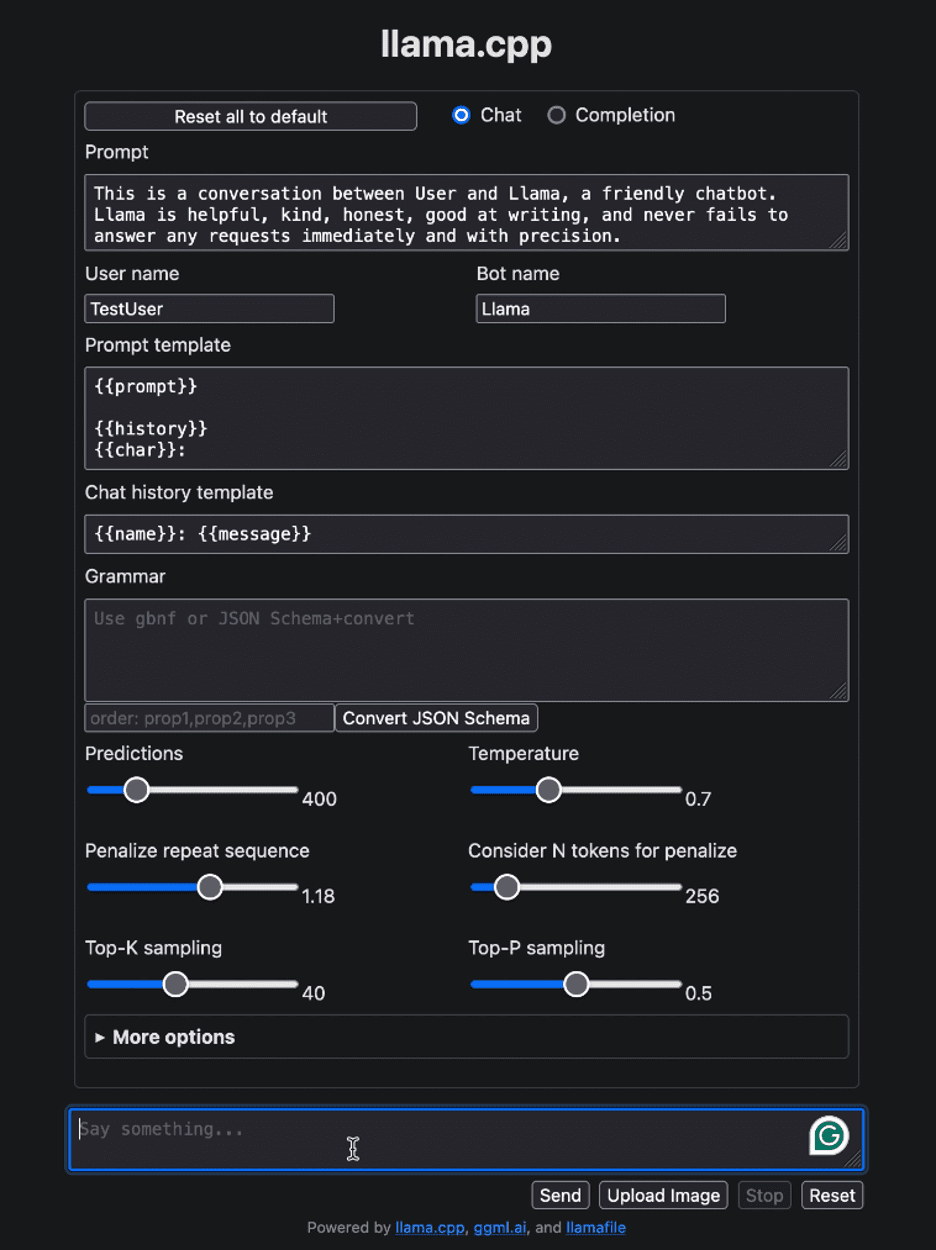

llava-v1.5-7b-q4.llamafile.exe -ngl 9999بعد تشغيل ملف llamafile، يجب أن يفتح المتصفح الافتراضي تلقائيًا ويعرض واجهة المستخدم كما هو موضح أدناه. إذا لم يحدث ذلك، افتح المتصفح وانتقل إلى http://localhost:8080 يدويا.

صورة المؤلف

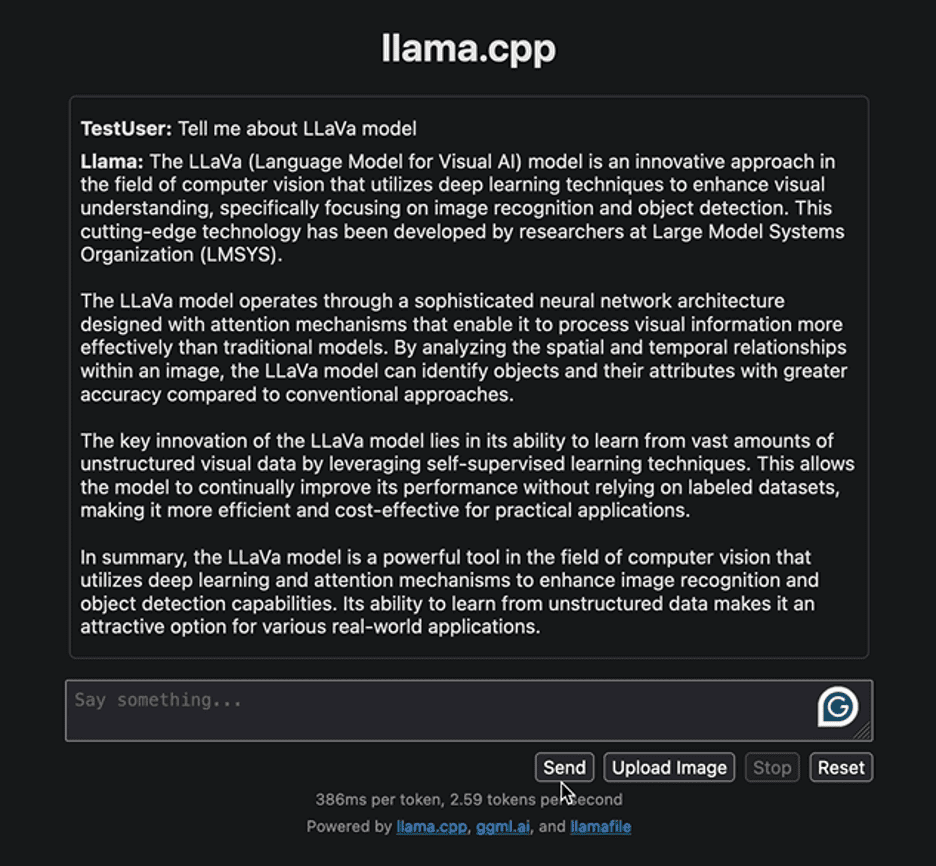

لنبدأ بالتفاعل مع الواجهة بسؤال بسيط لتقديم بعض المعلومات المتعلقة بنموذج LLaVa. فيما يلي الاستجابة الناتجة عن النموذج:

صورة المؤلف

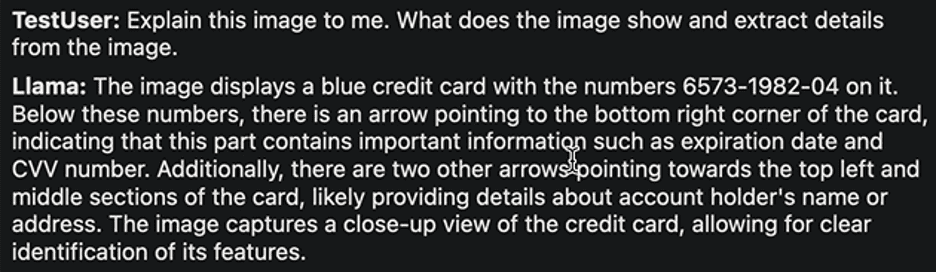

يسلط الرد الضوء على النهج المتبع في تطوير نموذج LLaVa وتطبيقاته. وكانت الاستجابة الناتجة سريعة إلى حد معقول. دعونا نحاول تنفيذ مهمة أخرى. سنقوم بتحميل الصورة النموذجية التالية للبطاقة المصرفية مع تفاصيلها واستخراج المعلومات المطلوبة منها.

الصورة عن طريق روبي طومسون

وهنا الرد:

صورة المؤلف

مرة أخرى، الرد معقول جدًا. يدعي مؤلفو LLaVa أنه يحقق أداءً عالي المستوى في مختلف المهام. لا تتردد في استكشاف المهام المتنوعة، ومراقبة نجاحاتها وقيودها، وتجربة الأداء المتميز لـ LLaVa بنفسك.

بمجرد اكتمال تفاعلك مع LLM، يمكنك إيقاف تشغيل ملف اللاما من خلال العودة إلى الوحدة الطرفية والضغط على "Control - C".

لم يكن توزيع وتشغيل LLMs أكثر وضوحًا من أي وقت مضى. في هذا البرنامج التعليمي، شرحنا مدى سهولة تشغيل نماذج مختلفة وتجربتها باستخدام ملف لاما قابل للتنفيذ واحد فقط. وهذا لا يوفر الوقت والموارد فحسب، بل يعمل أيضًا على توسيع إمكانية الوصول والفائدة الواقعية لـ LLMs. نأمل أن تجد هذا البرنامج التعليمي مفيدًا ونود أن نسمع أفكارك حوله. بالإضافة إلى ذلك، إذا كانت لديك أي أسئلة أو تعليقات، فلا تتردد في التواصل معنا. يسعدنا دائمًا تقديم المساعدة وتقدير مدخلاتك.

شكرا لقرائتك!

كانوال محرين كانوال هو مهندس تعلم آلي وكاتب تقني ولديه شغف عميق بعلوم البيانات وتقاطع الذكاء الاصطناعي مع الطب. شاركت في تأليف الكتاب الإلكتروني "تعظيم الإنتاجية باستخدام ChatGPT". وباعتبارها أحد باحثي Google Generation Scholar 2022 لمنطقة آسيا والمحيط الهادئ، فهي تدعم التنوع والتميز الأكاديمي. وهي معترف بها أيضًا باعتبارها تنوع Teradata في Tech Scholar، وMitacs Globalink Research Scholar، وHarvard WeCode Scholar. كانوال من أشد المدافعين عن التغيير، حيث قامت بتأسيس FEMCodes لتمكين المرأة في مجالات العلوم والتكنولوجيا والهندسة والرياضيات.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps