صورة المؤلف

في هذا المنشور، سوف نستكشف النموذج الجديد والمتطور مفتوح المصدر المسمى Mixtral 8x7b. سوف نتعلم أيضًا كيفية الوصول إليها باستخدام مكتبة LLaMA C++ وكيفية تشغيل نماذج لغة كبيرة على حوسبة وذاكرة منخفضة.

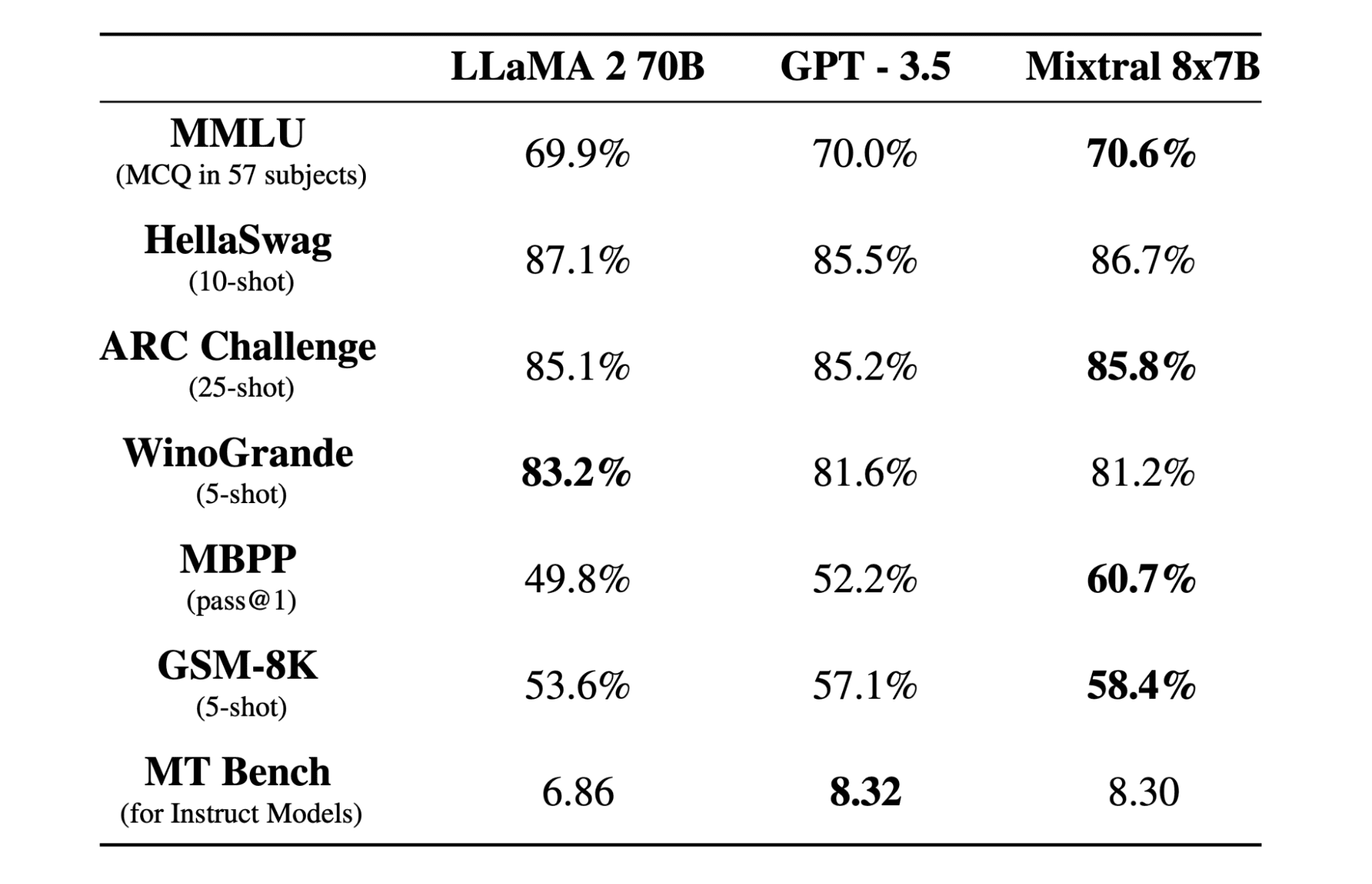

ميكسترال 8x7b هو مزيج متناثر عالي الجودة من نموذج الخبراء (SMoE) ذو الأوزان المفتوحة، تم إنشاؤه بواسطة Mistral AI. إنه مرخص بموجب Apache 2.0 ويتفوق في الأداء على Llama 2 70B في معظم المعايير بينما يتمتع باستدلال أسرع بمقدار 6 مرات. يتطابق Mixtral مع GPT3.5 أو يتفوق عليه في معظم المعايير القياسية وهو أفضل نموذج ذو وزن مفتوح فيما يتعلق بالتكلفة/الأداء.

صورة من مزيج من الخبراء

يستخدم Mixtral 8x7B شبكة متفرقة من الخبراء مخصصة لأجهزة فك التشفير فقط. يتضمن ذلك اختيار كتلة تغذية للأمام من 8 مجموعات من المعلمات، مع قيام شبكة جهاز التوجيه باختيار اثنتين من هذه المجموعات لكل رمز مميز، ودمج مخرجاتها بشكل إضافي. تعمل هذه الطريقة على تحسين عدد معلمات النموذج مع إدارة التكلفة ووقت الاستجابة، مما يجعلها فعالة مثل نموذج 12.9B، على الرغم من وجود إجمالي 46.7B من المعلمات.

يتفوق نموذج Mixtral 8x7B في التعامل مع سياق واسع من 32 ألف رمز ويدعم لغات متعددة، بما في ذلك الإنجليزية والفرنسية والإيطالية والألمانية والإسبانية. إنه يُظهر أداءً قويًا في إنشاء التعليمات البرمجية ويمكن ضبطه بدقة في نموذج يتبع التعليمات، مما يحقق درجات عالية في معايير مثل MT-Bench.

LLaMA.cpp هي مكتبة C/C++ توفر واجهة عالية الأداء لنماذج اللغات الكبيرة (LLMs) استنادًا إلى بنية LLM الخاصة بفيسبوك. إنها مكتبة خفيفة الوزن وفعالة ويمكن استخدامها لمجموعة متنوعة من المهام، بما في ذلك إنشاء النص والترجمة والإجابة على الأسئلة. يدعم LLaMA.cpp مجموعة واسعة من LLMs، بما في ذلك LLaMA وLLaMA 2 وFalcon وAlpaca وMistral 7B وMixtral 8x7B وGPT4ALL. وهو متوافق مع جميع أنظمة التشغيل ويمكن أن يعمل على كل من وحدات المعالجة المركزية ووحدات معالجة الرسومات.

في هذا القسم، سنقوم بتشغيل تطبيق الويب llama.cpp على Colab. من خلال كتابة بضعة أسطر من التعليمات البرمجية، ستتمكن من تجربة أداء الطراز الجديد المتطور على جهاز الكمبيوتر الخاص بك أو على Google Colab.

كيف تبدأ

أولاً، سنقوم بتنزيل مستودع llama.cpp GitHub باستخدام سطر الأوامر أدناه:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitبعد ذلك، سنقوم بتغيير الدليل إلى المستودع وتثبيت llama.cpp باستخدام الأمر `make`. نقوم بتثبيت llama.cpp لوحدة معالجة الرسومات NVidia مع تثبيت CUDA.

%cd llama.cpp

!make LLAMA_CUBLAS=1قم بتنزيل النموذج

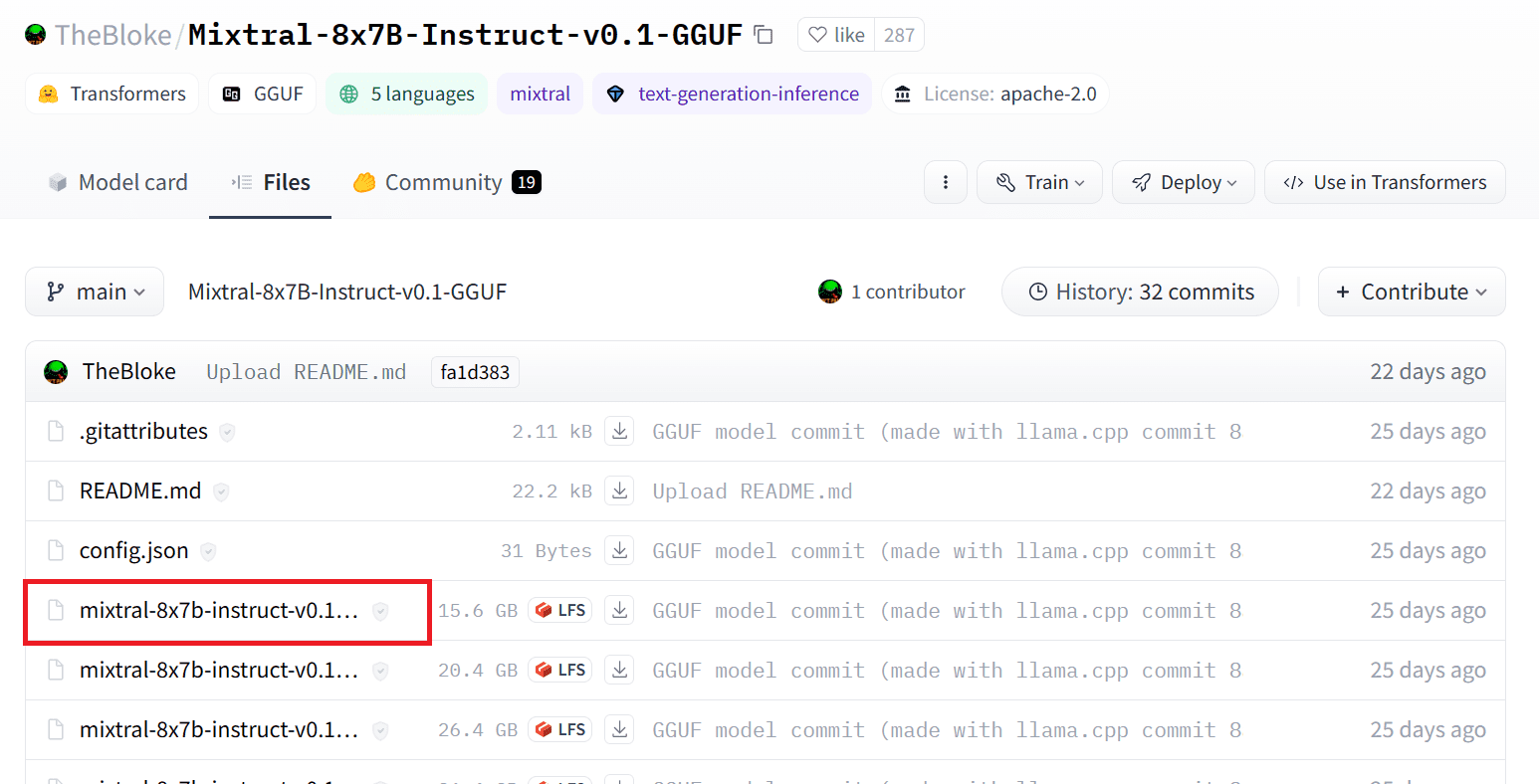

يمكننا تنزيل النموذج من Hugging Face Hub عن طريق تحديد الإصدار المناسب من ملف النموذج `.gguf`. يمكن العثور على مزيد من المعلومات حول الإصدارات المختلفة في TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

صورة من TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

يمكنك استخدام الأمر wget لتنزيل النموذج في الدليل الحالي.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufالعنوان الخارجي لخادم LLaMA

عندما نقوم بتشغيل خادم LLaMA، فإنه سيعطينا عنوان IP للمضيف المحلي وهو أمر غير مفيد بالنسبة لنا على Colab. نحن بحاجة إلى الاتصال بوكيل المضيف المحلي باستخدام منفذ وكيل Colab kernel.

بعد تشغيل الكود أدناه، سوف تحصل على الارتباط التشعبي العالمي. سنستخدم هذا الرابط للوصول إلى تطبيق الويب الخاص بنا لاحقًا.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/تشغيل الخادم

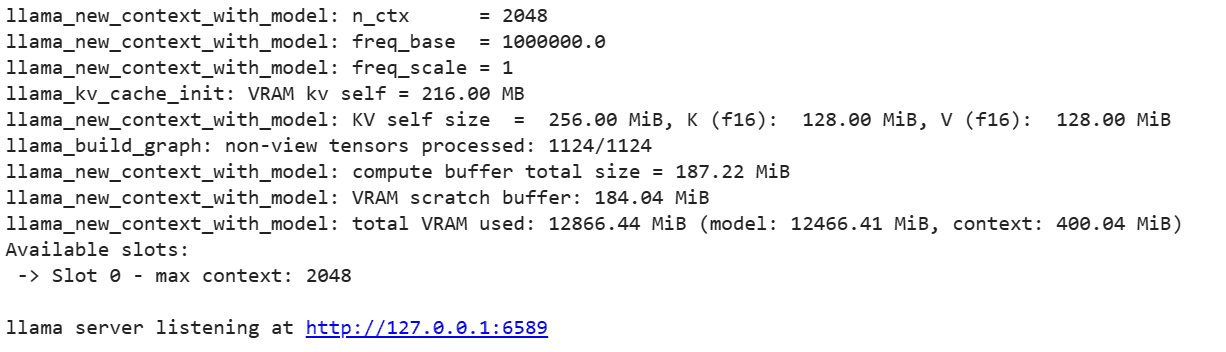

لتشغيل خادم LLaMA C++، تحتاج إلى تزويد أمر الخادم بموقع ملف النموذج ورقم المنفذ الصحيح. من المهم التأكد من تطابق رقم المنفذ مع الرقم الذي بدأناه في الخطوة السابقة لمنفذ الوكيل.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

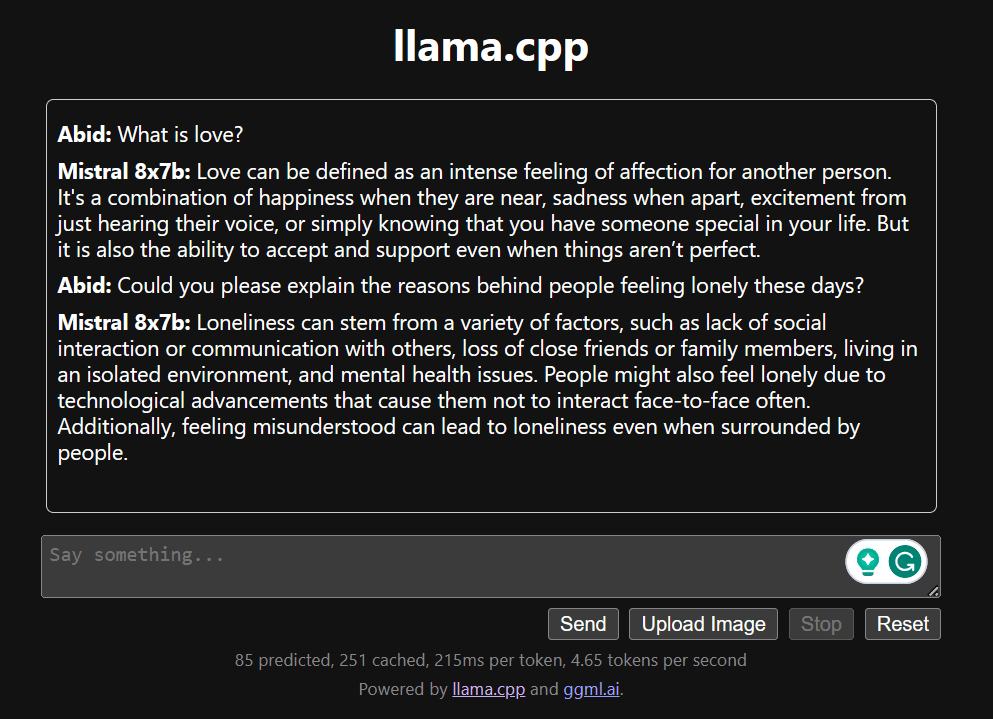

يمكن الوصول إلى تطبيق الويب للدردشة من خلال النقر على الارتباط التشعبي لمنفذ الوكيل في الخطوة السابقة نظرًا لأن الخادم لا يعمل محليًا.

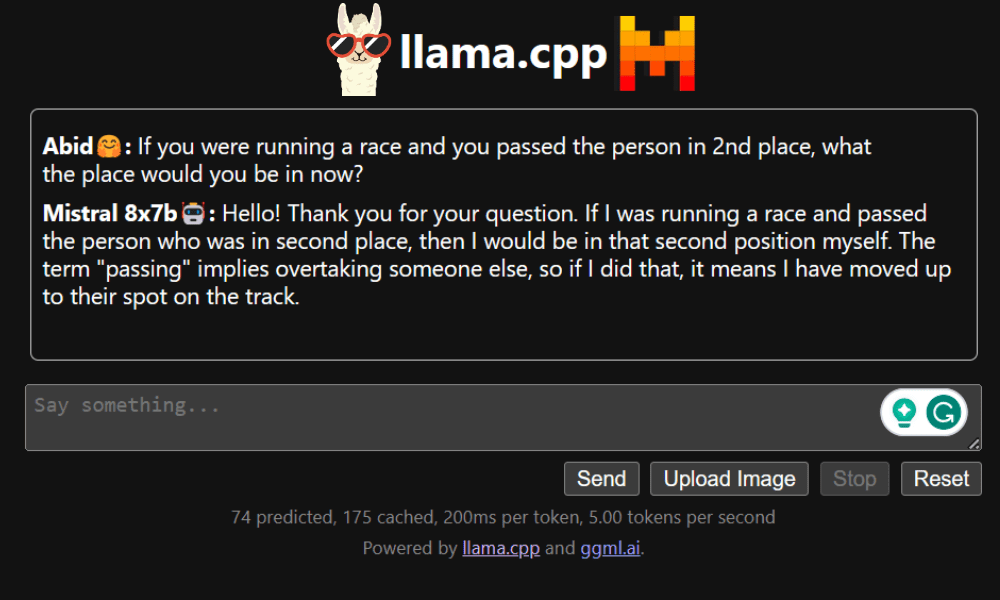

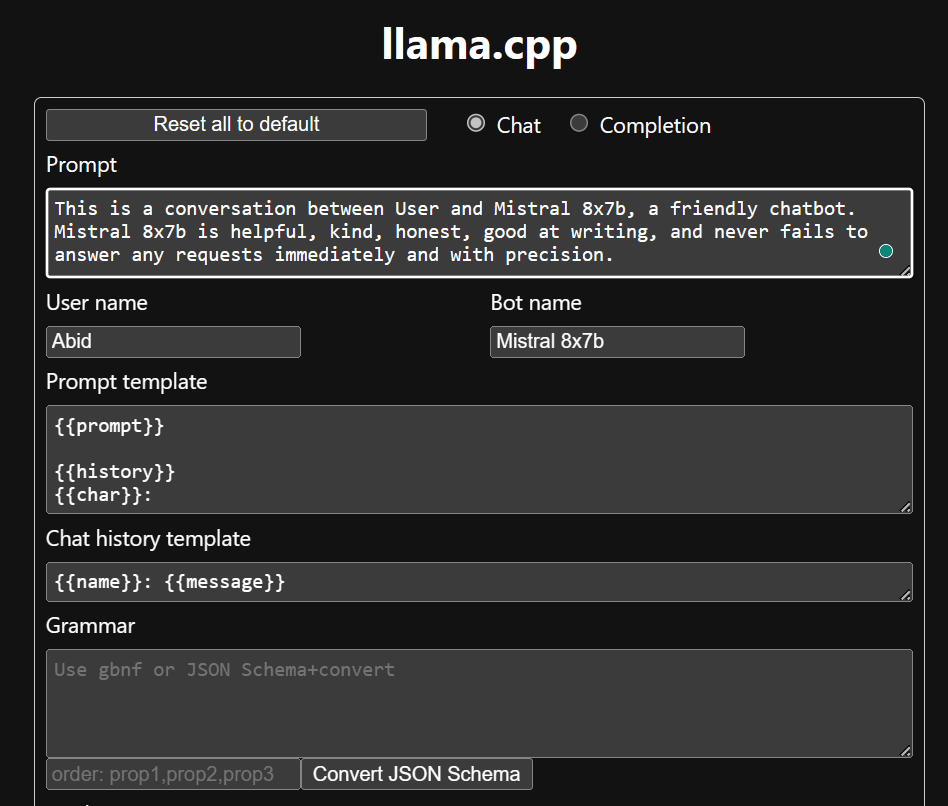

LLaMA C++ Webapp

قبل أن نبدأ في استخدام chatbot، نحتاج إلى تخصيصه. استبدل "LLaMA" باسم الطراز الخاص بك في قسم المطالبة. بالإضافة إلى ذلك، قم بتعديل اسم المستخدم واسم الروبوت للتمييز بين الاستجابات التي تم إنشاؤها.

ابدأ الدردشة من خلال التمرير لأسفل والكتابة في قسم الدردشة. لا تتردد في طرح الأسئلة الفنية التي فشلت النماذج مفتوحة المصدر الأخرى في الإجابة عليها بشكل صحيح.

إذا واجهت مشاكل مع التطبيق، يمكنك تجربة تشغيله بنفسك باستخدام Google Colab الخاص بي: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

يقدم هذا البرنامج التعليمي دليلاً شاملاً حول كيفية تشغيل النموذج المتقدم مفتوح المصدر، Mixtral 8x7b، على Google Colab باستخدام مكتبة LLaMA C++. بالمقارنة مع النماذج الأخرى، يوفر Mixtral 8x7b أداءً وكفاءة فائقين، مما يجعله حلاً ممتازًا لأولئك الذين يرغبون في تجربة نماذج لغوية كبيرة ولكن ليس لديهم موارد حسابية واسعة النطاق. يمكنك تشغيله بسهولة على الكمبيوتر المحمول الخاص بك أو على حساب سحابي مجاني. إنه سهل الاستخدام، ويمكنك حتى نشر تطبيق الدردشة الخاص بك ليستخدمه الآخرون ويجربوه.

أتمنى أن تجد هذا الحل البسيط لتشغيل النموذج الكبير مفيدًا. أنا أبحث دائمًا عن خيارات بسيطة وأفضل. إذا كان لديك حل أفضل، فيرجى إبلاغي به، وسأقوم بتغطيته في المرة القادمة.

عابد علي عوان (@ 1abidaliawan) هو عالم بيانات متخصص محترف يحب بناء نماذج التعلم الآلي. يركز حاليًا على إنشاء المحتوى وكتابة مدونات تقنية حول تقنيات التعلم الآلي وعلوم البيانات. عابد حاصل على درجة الماجستير في إدارة التكنولوجيا ودرجة البكالوريوس في هندسة الاتصالات. تتمثل رؤيته في بناء منتج للذكاء الاصطناعي باستخدام شبكة عصبية بيانية للطلاب الذين يعانون من مرض عقلي.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free