تعرف على Mixtral 8x7B من Mistral AI. إنه ذكي للغاية في التعامل مع البيانات الضخمة ويمكن أن يساعد في مهام مثل ترجمة اللغات وإنشاء التعليمات البرمجية. إن المطورين في جميع أنحاء العالم متحمسون لقدرته على تبسيط مشاريعهم وتحسين الكفاءة. بفضل تصميمه سهل الاستخدام وإمكانياته الرائعة، أصبح Mixtral 8x7B سريعًا أداة يمكن استخدامها لتطوير الذكاء الاصطناعي.

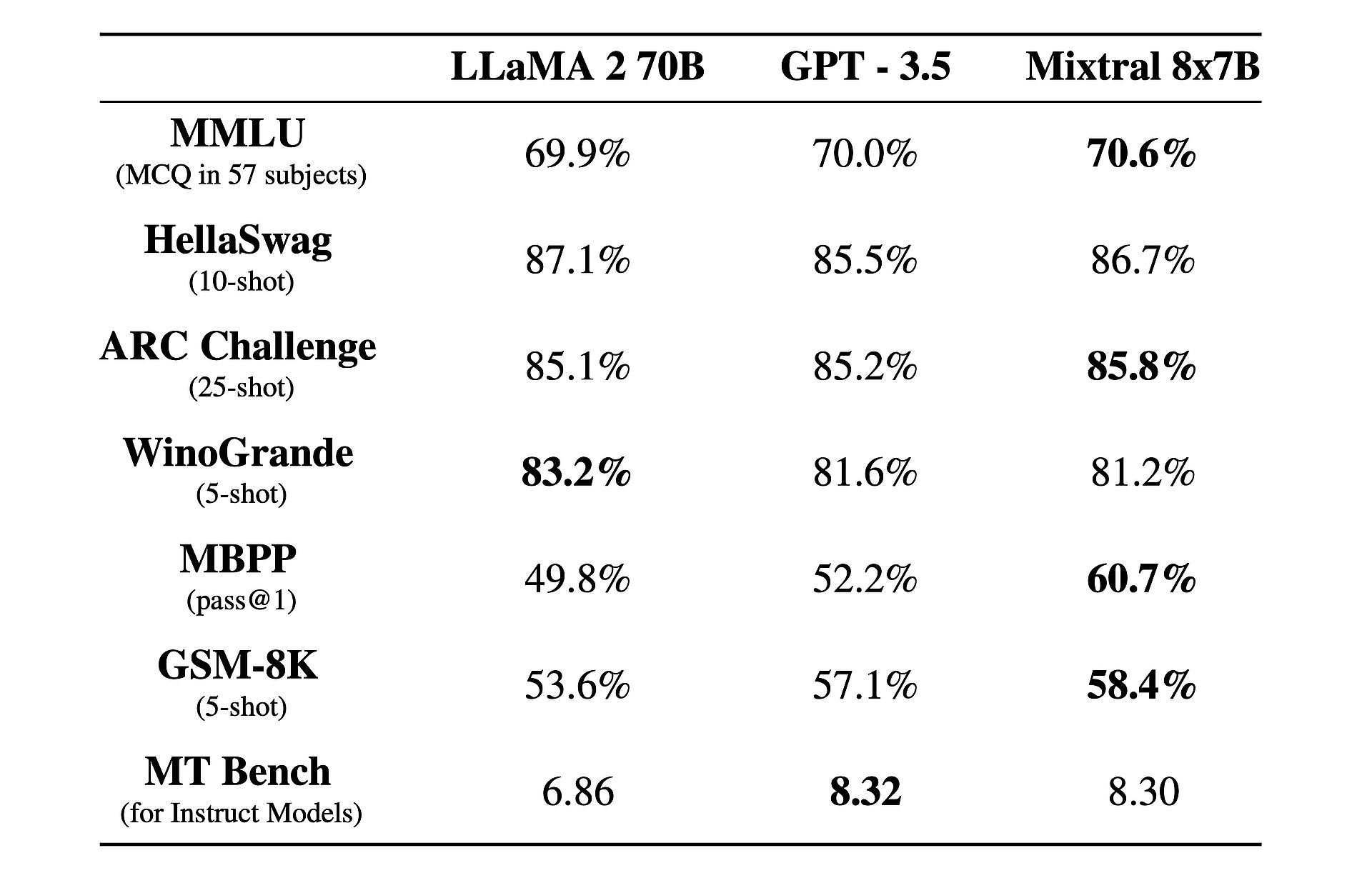

هناك أيضًا حقيقة مثيرة للاهتمام حول هذا الموضوع: إنه يعمل بشكل أفضل من GPT-3.5 و اللاما 2!

ما هو ميكسترال 8x7B؟

Mixtral 8x7B هو نموذج ذكاء اصطناعي متقدم تم تطويره بواسطة Mistral AI. ويستخدم بنية فريدة تسمى خليط الخبراء المتناثر (SMoE) لمعالجة كميات كبيرة من البيانات بكفاءة. على الرغم من تعقيده، تم تصميم Mixtral ليكون سهل الاستخدام وقابل للتكيف لمختلف المهام مثل ترجمة اللغة وإنشاء التعليمات البرمجية. فهو يتفوق على النماذج الأخرى من حيث السرعة والدقة، مما يجعله أداة قيمة للمطورين. بالإضافة إلى ذلك، فهو متوفر بموجب ترخيص Apache 2.0، مما يسمح لأي شخص باستخدامه وتعديله بحرية.

تريد معرفة المزيد؟ في جوهره، يعمل Mixtral 8x7B كنموذج لوحدة فك التشفير فقط، مما يعزز نهجًا فريدًا حيث تختار كتلة التغذية الأمامية من ثماني مجموعات متميزة من المعلمات، يشار إليها باسم "الخبراء". يتم اختيار هؤلاء الخبراء ديناميكيًا بواسطة شبكة توجيه لمعالجة كل رمز مميز، مما يعزز الكفاءة والأداء مع تقليل الحمل الحسابي.

تكمن إحدى نقاط القوة الرئيسية لدى Mixtral في قدرتها على التكيف وقابلية التوسع. يمكن لـ Capable التعامل مع سياقات تصل إلى 32,000 رمز ودعم لغات متعددة، بما في ذلك الإنجليزية والفرنسية والإيطالية والألمانية والإسبانية. يمكّن Mixtral المطورين من معالجة مجموعة واسعة من المهام بسهولة ودقة.

ما يميز Mixtral حقًا هو نسبة الأداء إلى التكلفة. مع إجمالي مذهل يبلغ 46.7 مليار معلمة، تحقق Mixtral كفاءة ملحوظة من خلال استخدام جزء صغير فقط من هذه المعلمات لكل رمز مميز، مما يؤدي إلى أوقات استدلال أسرع وتقليل النفقات الحسابية.

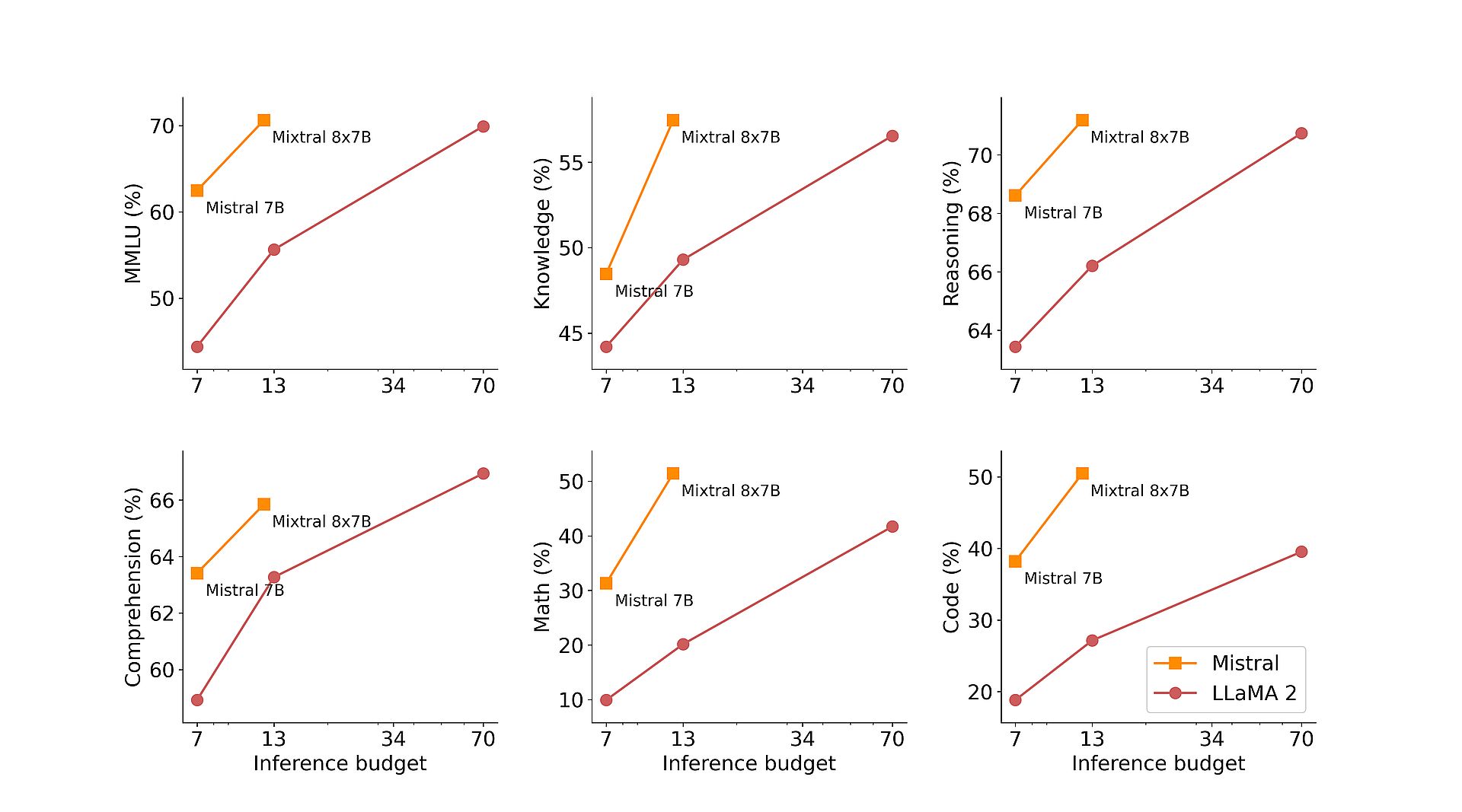

علاوة على ذلك، يضمن تدريب Mixtral المسبق على مجموعات البيانات الشاملة المستخرجة من الويب المفتوح المتانة والتنوع في تطبيقات العالم الحقيقي. سواء كان الأمر يتعلق بإنشاء التعليمات البرمجية أو ترجمة اللغة أو تحليل المشاعر، يقدم Mixtral نتائج رائعة عبر معايير مختلفة، متجاوزًا النماذج التقليدية مثل Llama 2 وحتى يتفوق على GPT3.5 في العديد من الحالات.

لتعزيز قدراتها بشكل أكبر، قدمت Mistral AI برنامج Mixtral 8x7B Instruct، وهو متغير متخصص مُحسّن للمهام التي تتبع التعليمات. بعد حصوله على درجة مثيرة للإعجاب قدرها 8.30 على MT-Bench، عزز Mixtral 8x7B Instruct مكانته كنموذج رائد مفتوح المصدر للضبط الدقيق وتحسين التفضيلات تحت الإشراف.

بالإضافة إلى براعتها التقنية، تلتزم Mistral AI بإضفاء الطابع الديمقراطي على الوصول إلى Mixtral من خلال المساهمة في مشروع vLLM، مما يتيح التكامل والنشر السلس باستخدام أدوات مفتوحة المصدر. وهذا يمكّن المطورين من تسخير قوة Mixtral عبر مجموعة واسعة من التطبيقات والمنصات، مما يدفع الابتكار والتقدم في مجال الذكاء الاصطناعي.

جروك آيوليس جروك، هو من قام بتحميص إيلون موسك مع "أسرع ماجستير في القانون"

كيفية استخدام ميكسترال 8x7B

يمكن الوصول إلى Mixtral 8x7B من خلال نقطة نهاية ميسترال الصغيرة، الموجودة في مراحل اختبار بيتاه. إذا كنت مهتمًا بالحصول على وصول مبكر إلى جميع نقاط النهاية التوليدية والتضمينية الخاصة بـ Mistral، فيمكنك تسجيل جديد الآن. من خلال التسجيل، ستكون من بين الأوائل الذين يختبرون الإمكانات الكاملة لـ Mixtral 8x7B ويستكشفون حلولها المبتكرة.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/