صورة المؤلف

نماذج اللغات الكبيرة (LLM) تصبح مجنونة في الوقت الحالي. ومع ذلك ، كمنظمة ، إذا لم يكن لديك الموارد المناسبة ، فقد يكون من الصعب القفز على موجة نموذج اللغة الكبيرة. قد يكون التدريب على نماذج لغوية كبيرة ونشرها أمرًا صعبًا ، وتشعر فجأة بالإهمال. سمحت LLMs مفتوحة المصدر ، مثل سلسلة LLaMA من Meta ، بإتاحة موارد LLM.

والإضافة إلى المجموعة مفتوحة المصدر هي أسس MosaicMLأحدث إضافة إلى سلسلتهم - إم بي تي-7ب.

يرمز MPT إلى MosaicML Transformer مسبق الصنع. طرازات MPT عبارة عن محولات خاصة بوحدة فك الترميز بنمط GPT والتي تأتي مع العديد من التحسينات:

- تطبيقات طبقة محسّنة للأداء

- استقرار تدريب أكبر بسبب تغييرات البنية

- لا حدود طول السياق

MPT-7B هو نموذج محول تم تدريبه من البداية باستخدام رموز 1T من النص والرمز. نعم ، 1 تريليون! تم تدريبه على منصة MosaicML ، بإطار زمني 9.5 أيام بدون تدخل بشري. تكلفة MosaicML ~ 200 ألف دولار.

إنه مفتوح المصدر ، مما يجعله متاحًا للاستخدام التجاري وستغير الأداة قواعد اللعبة في كيفية عمل الشركات والمؤسسات مع التحليلات التنبؤية وعملية صنع القرار.

الميزات الرئيسية لـ MPT-7B هي:

- مرخصة للاستخدام التجاري

- تدرب على كمية كبيرة من البيانات (1T tokens)

- يمكن التعامل مع المدخلات طويلة للغاية

- الأمثل للتدريب والاستدلال السريع

- كود تدريب مفتوح المصدر عالي الكفاءة.

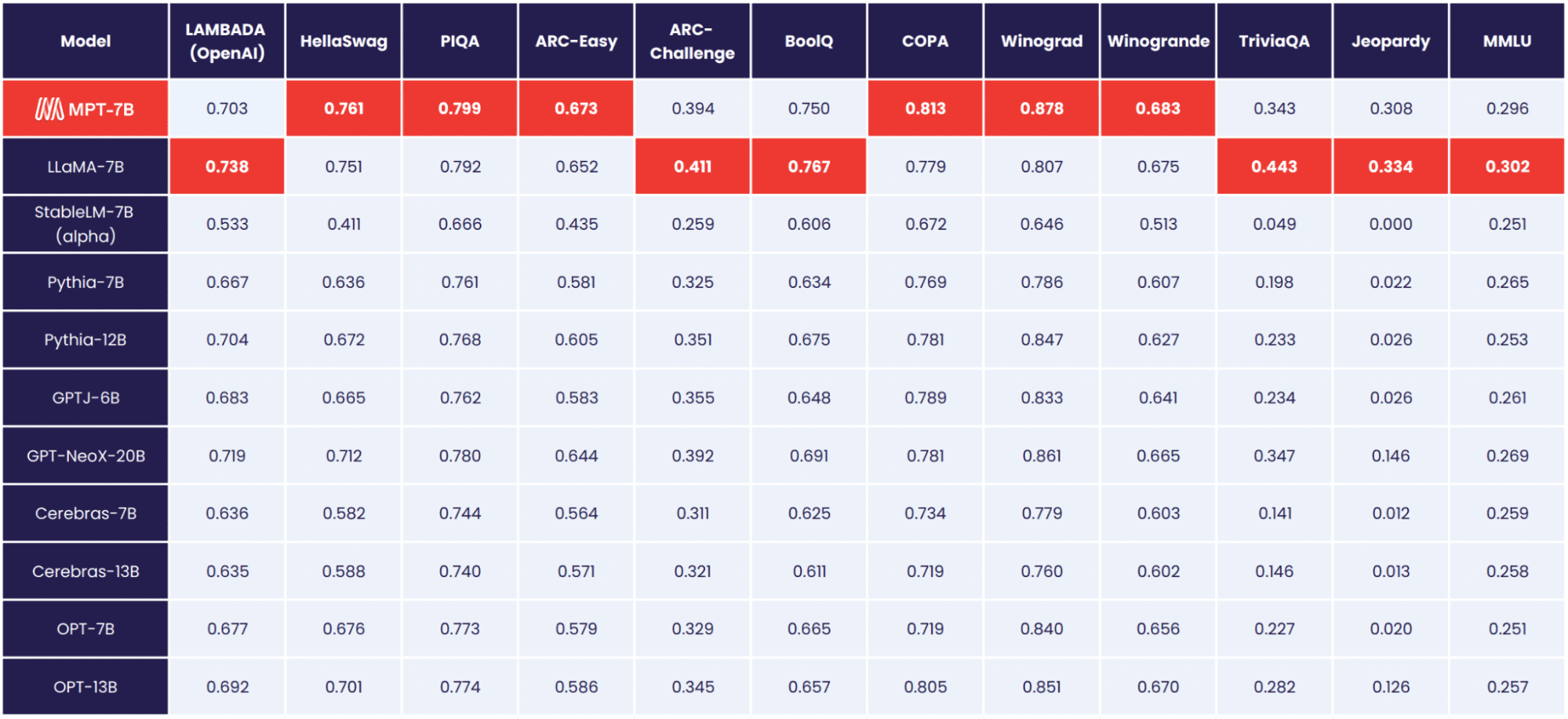

MPT-7B هو النموذج الأساسي وقد ثبت أنه يتفوق في الأداء على طرز 7B - 20B مفتوحة المصدر الأخرى. جودة MPT-7B تطابق LLaMA-7B. لتقييم جودة MPT-7B ، جمعت مؤسسة MosaicML 11 معيارًا مفتوح المصدر وقيمتها باستخدام الطريقة المتوافقة مع معايير الصناعة.

الصورة عن طريق مؤسسة MosaicML

تقوم أسس MosaicML أيضًا بإصدار ثلاثة نماذج إضافية دقيقة:

- MPT-7B- تعليمات

- MPT-7B- الدردشة

- MPT-7B-StoryWriter-65k +

MPT-7B- تعليمات

• MPT-7B- تعليمات النموذج هو لتعليمات النموذج القصير التالية. مع 26,834 بتاريخ 14 مايو ، يسمح لك MPT-7B-Instruct بطرح أسئلة سريعة وقصيرة ويوفر لك إجابة فورية. لديك سؤال ، وتريد فقط إجابة بسيطة - استخدم MPT-7B-Instruct.

لماذا هذا عظيم جدا؟ عادةً ما يتم تعليم LLMs لمواصلة إنشاء النص بناءً على المدخلات التي تم توفيرها. ومع ذلك ، يبحث البعض عن LLMs التي تتعامل مع مدخلاتهم كتعليمات. يسمح الضبط الدقيق للتعليمات LLMs بأداء مخرجات تتبع التعليمات.

MPT-7B- الدردشة

نعم ، لدينا روبوت محادثة آخر. MPT-7B- الدردشة يولد الحوار. على سبيل المثال ، إذا كنت تريد أن يولد روبوت المحادثة خطابًا ، فسيؤدي إعطائه السياق إلى إنشاء نص بطريقة محادثة. أو ربما ترغب في كتابة تغريدة تعيد صياغة فقرة من مقال ، يمكن أن تولد الحوار من أجلك!

لماذا هذا عظيم جدا؟ يعد MPT-7B Chat جاهزًا ومجهزًا جيدًا لمجموعة متنوعة من مهام المحادثة ، مما يوفر تفاعلات متعددة الأدوار وأكثر سلاسة للمستخدمين.

MPT-7B-StoryWriter-65k +

هذا لكتاب القصة! بالنسبة لأولئك الذين يرغبون في كتابة قصص ذات سياق طويل ، MPT-7B-StoryWriter-65k + هو نموذج مصمم لذلك بالضبط. تم بناء النموذج من خلال ضبط MPT-7B بدقة طول السياق 65 كيلو الرموز، ويمكنه استقراء ما يزيد عن 65 ألفًا. تمكنت مؤسسة MosaicML من إنشاء 84 ألف رمز مميز على عقدة واحدة من وحدات معالجة الرسومات A100-80GB.

لماذا هذا عظيم جدا؟ هذا لأن معظم LLMs مفتوحة المصدر يمكنها فقط التعامل مع التسلسلات مع ما يصل إلى بضعة آلاف من الرموز المميزة. ولكن فقط باستخدام عقدة واحدة 8xA100-80GB على منصة MosaicML ، يمكنك ضبط MPT-7B للتعامل مع أطوال سياق تصل إلى 65 كيلو!

قام فريق MosaicML ببناء هذه النماذج في غضون أسابيع قليلة فقط. في غضون أسابيع قليلة فقط تعاملوا مع إعداد البيانات والتدريب والضبط الدقيق والنشر.

تم الحصول على البيانات من مجموعة متنوعة من المصادر ، والتي تحتوي جميعها على مليار رمز متاح في كل مصدر. لا يزال عدد الرموز الفعالة يحصل على مليار في كل مصدر! استخدم الفريق إليوثير, جي بي تي-نيوإكسو 20B رمز مميز، مما يسمح لهم بالتدريب على مزيج متنوع من البيانات ، وتطبيق تحديد متسق للمساحة ، والمزيد.

تم تدريب جميع طرز MPT-7B على منصة MosaicML، باستخدام وحدات معالجة الرسومات A100-40GB و A100-80GB من Oracle Cloud.

إذا كنت ترغب في معرفة المزيد عن أدوات وتكاليف MPT-7B ، فاقرأ ما يلي: مدونة MPT-7B.

يمكن اعتبار منصة MosaicML أفضل نقطة انطلاق للمنظمات ، إذا كانت خاصة أو تجارية أو مجتمعية مرتبطة ببناء LLMs مخصصة. سيسمح توفر هذا المورد مفتوح المصدر للمؤسسات بالشعور بحرية أكبر في استخدام هذه الأدوات لتحسين التحديات التنظيمية الحالية.

يمكن للعملاء تدريب LLM على أي مزود حوسبة أو مصدر بيانات ، مع القدرة على الحفاظ على الكفاءة والخصوصية وشفافية التكلفة.

ما رأيك في استخدام MPT-7B؟ اسمحوا لنا أن نعرف في التعليقات أدناه

نيشا آريا هو عالم بيانات وكاتب تقني مستقل ومدير المجتمع في KDnuggets. وهي مهتمة بشكل خاص بتقديم المشورة المهنية في علوم البيانات أو البرامج التعليمية والمعرفة القائمة على النظرية حول علوم البيانات. إنها ترغب أيضًا في استكشاف الطرق المختلفة التي يمكن للذكاء الاصطناعي من خلالها الاستفادة من طول عمر حياة الإنسان. متعلمة حريصة ، تسعى إلى توسيع معرفتها التقنية ومهارات الكتابة لديها ، بينما تساعد في توجيه الآخرين.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- أفلاطونايستريم. ذكاء بيانات Web3. تضخيم المعرفة. الوصول هنا.

- سك المستقبل مع أدرين أشلي. الوصول هنا.

- شراء وبيع الأسهم في شركات ما قبل الاكتتاب مع PREIPO®. الوصول هنا.

- المصدر https://www.kdnuggets.com/2023/05/introducing-mpt7b-new-opensource-llm.html?utm_source=rss&utm_medium=rss&utm_campaign=introducing-mpt-7b-a-new-open-source-llm