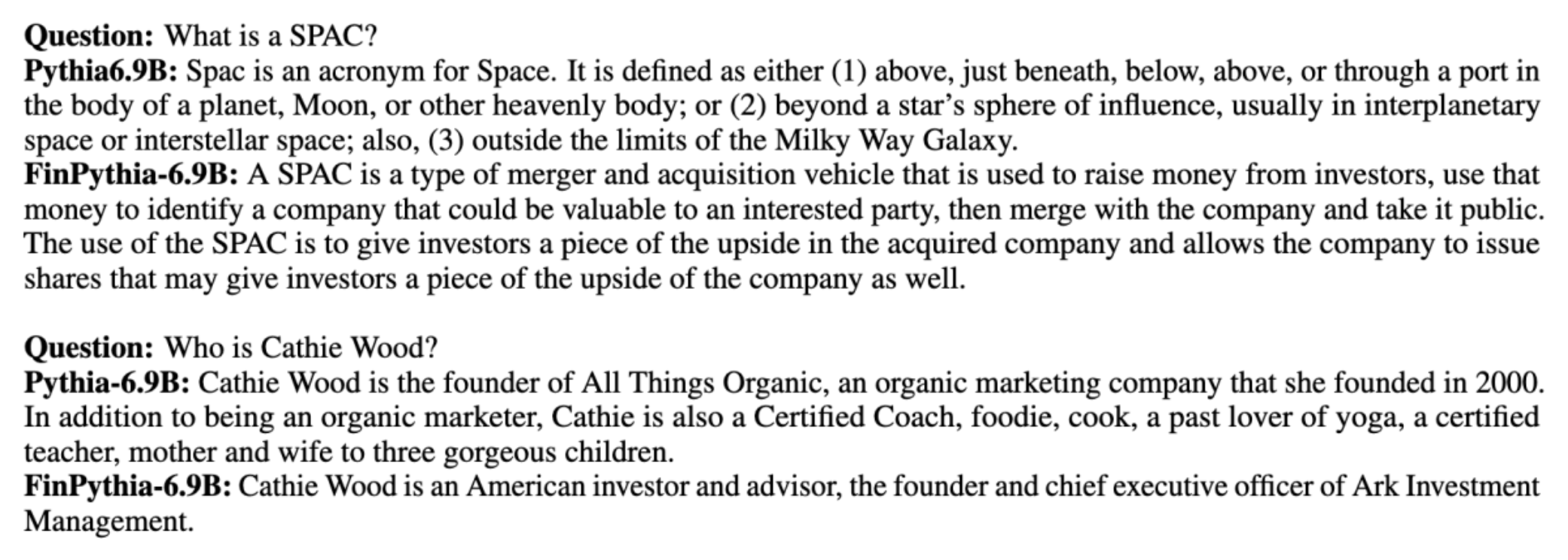

Awọn awoṣe ede nla (LLMs) jẹ ikẹkọ gbogbogbo lori awọn iwe data ti o wa ni gbangba ti o jẹ agnostic agbegbe. Fun apere, Llama Meta si dede ti wa ni oṣiṣẹ lori datasets bi WọpọCrawl, C4, Wikipedia, ati ArXiv. Awọn ipilẹ data wọnyi ni akojọpọ awọn akọle ati awọn ibugbe lọpọlọpọ. Botilẹjẹpe awọn awoṣe ti o yọrisi mu awọn abajade to dara iyalẹnu jade fun awọn iṣẹ ṣiṣe gbogbogbo, gẹgẹbi iran ọrọ ati idanimọ nkan, ẹri wa pe awọn awoṣe ti o ni ikẹkọ pẹlu awọn iwe data pato-ašẹ le mu ilọsiwaju iṣẹ LLM siwaju sii. Fun apẹẹrẹ, data ikẹkọ ti a lo fun BloombergGPT jẹ 51% awọn iwe aṣẹ-ašẹ kan pato, pẹlu awọn iroyin inawo, awọn iforukọsilẹ, ati awọn ohun elo inawo miiran. LLM ti o yọrisi ju awọn LLM ti o ni ikẹkọ lori awọn ipilẹ data ti kii ṣe-ašẹ nigba idanwo lori awọn iṣẹ ṣiṣe-isuna kan pato. Awọn onkọwe ti BloombergGPT pinnu wipe won awoṣe outperforms gbogbo awọn miiran si dede idanwo fun mẹrin ninu awọn marun owo awọn iṣẹ-ṣiṣe. Awoṣe naa pese iṣẹ ṣiṣe ti o dara julọ paapaa nigba idanwo fun awọn iṣẹ ṣiṣe inawo inu ti Bloomberg nipasẹ ala jakejado — bii awọn aaye 60 dara julọ (ninu 100). Biotilejepe o le ni imọ siwaju sii nipa awọn okeerẹ igbelewọn esi ninu awọn iwe, awọn wọnyi ayẹwo sile lati awọn BloombergGPT iwe le fun ọ ni ṣoki ti anfani ti ikẹkọ LLM nipa lilo data-ašẹ kan pato ti owo. Gẹgẹbi a ṣe han ninu apẹẹrẹ, awoṣe BloombergGPT pese awọn idahun ti o pe lakoko ti awọn awoṣe miiran ti kii ṣe-ašẹ kan tiraka:

Ifiweranṣẹ yii n pese itọsọna kan si ikẹkọ LLM ni pataki fun agbegbe owo. A bo awọn aaye pataki wọnyi:

- Data gbigba ati igbaradi - Itọsọna lori orisun ati ṣiṣatunṣe data owo ti o yẹ fun ikẹkọ awoṣe ti o munadoko

- Ilọsiwaju ṣaaju ikẹkọ vs - Nigbati lati lo ilana kọọkan lati mu iṣẹ ṣiṣe LLM rẹ pọ si

- Ti o munadoko siwaju ṣaaju ikẹkọ - Awọn ilana lati ṣe ilana ilana ikẹkọ iṣaaju nigbagbogbo, fifipamọ akoko ati awọn orisun

Ifiweranṣẹ yii ṣajọpọ imọ-jinlẹ ti ẹgbẹ iwadii imọ-jinlẹ ti a lo laarin Imọ-ẹrọ Isuna Amazon ati AWS Ẹgbẹ Onimọ-jinlẹ Agbaye fun Ile-iṣẹ Iṣowo Agbaye. Diẹ ninu awọn akoonu da lori iwe Ṣiṣe ikẹkọ Ilọsiwaju Ilọsiwaju fun Ilé Awọn awoṣe Ede Tobi Kan pato.

Gbigba ati ngbaradi owo data

Awọn ohun iwulo ikẹkọ iṣaaju-ašẹ ti o tẹsiwaju ni iwọn-nla, didara ga, data ipilẹ-ašẹ kan pato. Atẹle yii ni awọn igbesẹ akọkọ fun ṣiṣatunṣe dataset domain:

- Ṣe idanimọ awọn orisun data - Awọn orisun data ti o pọju fun corpus agbegbe pẹlu oju opo wẹẹbu ṣiṣi, Wikipedia, awọn iwe, media awujọ, ati awọn iwe inu.

- Ajọ data ase - Nitori ibi-afẹde ti o ga julọ ni lati ṣatunkọ corpus agbegbe, o le nilo awọn igbesẹ afikun lati ṣe àlẹmọ awọn ayẹwo ti ko ṣe pataki si agbegbe ibi-afẹde. Eyi dinku koposi ti ko wulo fun ikẹkọ iṣaaju-itẹsiwaju ati dinku idiyele ikẹkọ.

- Ṣiṣe tẹlẹ - O le ronu lẹsẹsẹ awọn igbesẹ ti iṣaju lati mu didara data dara ati ṣiṣe ikẹkọ. Fun apẹẹrẹ, awọn orisun data kan le ni nọmba itẹlọrun ti awọn ami alariwo; Iyọkuro ni a ka igbesẹ ti o wulo lati mu didara data dara ati dinku idiyele ikẹkọ.

Lati ṣe idagbasoke awọn LLM ti owo, o le lo awọn orisun data pataki meji: News CommonCrawl ati awọn iforukọsilẹ SEC. Iforukọsilẹ SEC jẹ alaye inawo tabi iwe aṣẹ miiran ti a fi silẹ si US Securities and Exchange Commission (SEC). Awọn ile-iṣẹ ti a ṣe atokọ ni gbangba nilo lati ṣajọ awọn iwe aṣẹ lọpọlọpọ nigbagbogbo. Eyi ṣẹda nọmba nla ti awọn iwe aṣẹ ni awọn ọdun. Awọn iroyin CommonCrawl jẹ ipilẹ data ti a tu silẹ nipasẹ CommonCrawl ni ọdun 2016. O ni awọn nkan iroyin lati awọn aaye iroyin ni gbogbo agbaye.

Iroyin CommonCrawl wa lori Iṣẹ Ifipamọ Simple Amazon (Amazon S3) ninu awọn commoncrawl garawa ni crawl-data/CC-NEWS/. O le gba awọn akojọ ti awọn faili nipa lilo awọn Ọlọpọọmídíà Ifilelẹ Aws AWS (AWS CLI) ati aṣẹ atẹle:

In Ṣiṣe ikẹkọ Ilọsiwaju Ilọsiwaju fun Ilé Awọn awoṣe Ede Tobi Kan pato, awọn onkọwe lo URL kan ati ọna orisun-ọrọ lati ṣe àlẹmọ awọn nkan iroyin owo lati awọn iroyin jeneriki. Ni pataki, awọn onkọwe ṣetọju atokọ kan ti awọn iÿë iroyin owo pataki ati ṣeto awọn ọrọ-ọrọ ti o ni ibatan si awọn iroyin owo. A ṣe idanimọ nkan kan bi awọn iroyin inawo ti o ba wa lati awọn itẹjade iroyin inawo tabi awọn koko-ọrọ eyikeyi ti o han ninu URL naa. Ọna ti o rọrun sibẹsibẹ ti o munadoko yii jẹ ki o ṣe idanimọ awọn iroyin inawo lati kii ṣe awọn itẹjade iroyin inawo nikan ṣugbọn tun awọn apakan iṣuna ti awọn iÿë iroyin jeneriki.

Awọn ifilọlẹ SEC wa lori ayelujara nipasẹ SEC's EDGAR (Ikojọpọ Data Itanna, Itupalẹ, ati Igbapada) aaye data, eyiti o pese iraye si data. O le yọkuro awọn igbasilẹ lati EDGAR taara, tabi lo awọn API ninu Ẹlẹda Amazon pẹlu awọn laini koodu diẹ, fun akoko eyikeyi ati fun nọmba nla ti awọn ami-ami (ie, idanimọ SEC sọtọ). Lati kọ ẹkọ diẹ sii, tọka si SEC Iforukọsilẹ igbapada.

Tabili ti o tẹle ṣe akopọ awọn alaye bọtini ti awọn orisun data mejeeji.

| . | Iroyin CommonCrawl | Ifiranṣẹ SEC |

| agbegbe | 2016-2022 | 1993-2022 |

| iwọn | 25.8 bilionu ọrọ | 5.1 bilionu ọrọ |

Awọn onkọwe lọ nipasẹ awọn igbesẹ iṣaju diẹ diẹ ṣaaju ki o to jẹun data sinu algorithm ikẹkọ kan. Ni akọkọ, a ṣe akiyesi pe awọn iforukọsilẹ SEC ni awọn ọrọ alariwo nitori yiyọ awọn tabili ati awọn isiro kuro, nitorinaa awọn onkọwe yọkuro awọn gbolohun ọrọ kukuru ti a ro pe o jẹ tabili tabi awọn aami nọmba. Ni ẹẹkeji, a lo algorithm hashing ifarabalẹ agbegbe kan lati yọkuro awọn nkan tuntun ati awọn faili. Fun awọn iforukọsilẹ SEC, a yọkuro ni ipele apakan dipo ipele iwe. Nikẹhin, a ṣajọpọ awọn iwe aṣẹ sinu okun gigun kan, ṣe ami si, a si ge ami isamisi si awọn ege ipari gigun titẹ sii ti o ni atilẹyin nipasẹ awoṣe lati ṣe ikẹkọ. Eyi ṣe ilọsiwaju igbejade ti ikẹkọ iṣaaju-itẹsiwaju ati dinku idiyele ikẹkọ.

Ilọsiwaju ṣaaju ikẹkọ vs

Pupọ LLM ti o wa jẹ idi gbogbogbo ati aini awọn agbara-ašẹ kan. Awọn LLM-ašẹ ti ṣe afihan iṣẹ ṣiṣe ti o pọju ni iṣoogun, iṣuna, tabi awọn aaye imọ-jinlẹ. Fun LLM kan lati gba imọ-ašẹ kan pato, awọn ọna mẹrin lo wa: ikẹkọ lati ibere, ikẹkọ iṣaaju-itẹsiwaju, atunṣe itanran itọnisọna lori awọn iṣẹ ṣiṣe agbegbe, ati Igbapada Augmented Generation (RAG).

Ni awọn awoṣe ibile, iṣatunṣe-dara julọ ni a maa n lo lati ṣẹda awọn awoṣe iṣẹ-ṣiṣe kan fun agbegbe kan. Eyi tumọ si mimu awọn awoṣe lọpọlọpọ fun awọn iṣẹ ṣiṣe lọpọlọpọ bii isediwon nkan, ipinpin ero inu, itupalẹ itara, tabi idahun ibeere. Pẹlu dide ti LLMs, iwulo lati ṣetọju awọn awoṣe lọtọ ti di arugbo nipa lilo awọn ilana bii ẹkọ inu-ọrọ tabi titan. Eyi ṣafipamọ ipa ti o nilo lati ṣetọju akopọ awọn awoṣe fun awọn iṣẹ ṣiṣe ti o jọmọ ṣugbọn pato.

Ni oye, o le ṣe ikẹkọ LLMs lati ibere pẹlu data-ašẹ kan pato. Botilẹjẹpe pupọ julọ iṣẹ lati ṣẹda awọn LLM agbegbe ti dojukọ ikẹkọ lati ibere, o jẹ gbowolori idinamọ. Fun apẹẹrẹ, awọn idiyele awoṣe GPT-4 lori $ 100 million lati ṣe ikẹkọ. Awọn awoṣe wọnyi jẹ ikẹkọ lori apopọ ti data ašẹ ṣiṣi ati data agbegbe. Ikẹkọ iṣaaju-tẹsiwaju le ṣe iranlọwọ fun awọn awoṣe lati gba imọ-ašẹ kan pato laisi jijẹ idiyele ti ikẹkọ iṣaaju lati ibere nitori pe o kọkọ kọkọ LLM agbegbe ṣiṣi ti o wa tẹlẹ lori data agbegbe nikan.

Pẹlu atunṣe itanran itọnisọna lori iṣẹ-ṣiṣe kan, o ko le jẹ ki awoṣe gba imọ-ašẹ nitori LLM nikan n gba alaye agbegbe ti o wa ninu iwe-itọnisọna itanran-tuning dataset. Ayafi ti data ti o tobi pupọ fun lilo atunṣe itanran itọnisọna, ko to lati gba imọ agbegbe. Ṣiṣawari awọn ipilẹ data itọni ti o ni agbara jẹ igbagbogbo nija ati pe o jẹ idi lati lo awọn LLM ni aye akọkọ. Paapaa, atunṣe atunṣe itọnisọna lori iṣẹ-ṣiṣe kan le ni ipa lori iṣẹ ṣiṣe lori awọn iṣẹ ṣiṣe miiran (bi a ti rii ninu iwe yii). Bibẹẹkọ, iṣatunṣe-itọnisọna jẹ iye owo-doko diẹ sii ju ọkan ninu awọn yiyan ikẹkọ iṣaaju-ikẹkọ.

Nọmba ti o tẹle yii ṣe afiwe atunṣe iṣẹ-ṣiṣe kan pato ti aṣa. vs ilana ẹkọ inu-ọrọ pẹlu LLMs.

RAG jẹ ọna ti o munadoko julọ ti didari LLM kan lati ṣe ipilẹṣẹ awọn idahun ti o wa lori ilẹ ni agbegbe kan. Botilẹjẹpe o le ṣe itọsọna awoṣe lati ṣe ipilẹṣẹ awọn idahun nipa pipese awọn ododo lati agbegbe bi alaye iranlọwọ, ko gba ede-ašẹ kan nitori LLM tun n gbarale ara ede ti kii ṣe aaye lati ṣe ipilẹṣẹ awọn idahun.

RAG jẹ ọna ti o munadoko julọ ti didari LLM kan lati ṣe ipilẹṣẹ awọn idahun ti o wa lori ilẹ ni agbegbe kan. Botilẹjẹpe o le ṣe itọsọna awoṣe lati ṣe ipilẹṣẹ awọn idahun nipa pipese awọn ododo lati agbegbe bi alaye iranlọwọ, ko gba ede-ašẹ kan nitori LLM tun n gbarale ara ede ti kii ṣe aaye lati ṣe ipilẹṣẹ awọn idahun.

Ikẹkọ iṣaaju-itẹsiwaju jẹ ilẹ aarin laarin ikẹkọ iṣaaju-iṣaaju ati atunṣe-itanran itọnisọna ni awọn ofin ti idiyele lakoko ti o jẹ yiyan ti o lagbara si gbigba imọ-ašẹ-pato ati ara. O le pese awoṣe gbogbogbo lori eyiti o le ṣe atunṣe itọni itanran siwaju si lori data itọnisọna to lopin. Ikẹkọ iṣaaju-tẹsiwaju le jẹ ilana imunadoko iye owo fun awọn ibugbe amọja nibiti ṣeto awọn iṣẹ-ṣiṣe ti isalẹ tobi tabi aimọ ati pe data isọdọtun itọnisọna ti ni opin. Ni awọn oju iṣẹlẹ miiran, iṣatunṣe itọnisọna tabi RAG le dara julọ.

Lati kọ ẹkọ diẹ sii nipa titọ-titun, RAG, ati ikẹkọ awoṣe, tọka si Fine-tune a ipile awoṣe, Ìran Àfikún Ìgbàpadà (RAG), Ati Kọ Awoṣe pẹlu Amazon SageMaker, lẹsẹsẹ. Fun ifiweranṣẹ yii, a dojukọ lori ikẹkọ iṣaaju ti o tẹsiwaju daradara.

Ilana ti ikẹkọ ṣaaju ki o to tẹsiwaju daradara

Ikẹkọ ṣaaju ki o to tẹsiwaju ni awọn ilana wọnyi:

- Idanileko Itẹsiwaju Iṣe Adaṣe-Agbegbe (DACP) - Ninu iwe Ṣiṣe ikẹkọ Ilọsiwaju Ilọsiwaju fun Ilé Awọn awoṣe Ede Tobi Kan pato, awọn onkọwe ntẹsiwaju kọkọ ikẹkọ awoṣe ede Pythia lori ile-iṣẹ inawo lati ṣe deede si agbegbe iṣuna. Ibi-afẹde naa ni lati ṣẹda awọn LLM ti owo nipa fifun data lati gbogbo agbegbe inawo sinu awoṣe ti o ṣii. Nitoripe koposi ikẹkọ ni gbogbo awọn iwe data ti a sọ di mimọ ni agbegbe, awoṣe abajade yẹ ki o gba imọ-isuna-pato, nitorinaa di awoṣe to wapọ fun ọpọlọpọ awọn iṣẹ ṣiṣe inawo. Eyi ṣe abajade ni awọn awoṣe FinPythia.

- Iṣẹ-ṣiṣe-Ibadọgba Ilọsiwaju Ikẹkọ-ṣaaju (TACP) - Awọn onkọwe kọkọ kọ awọn awoṣe siwaju sii lori aami ati data iṣẹ-ṣiṣe ti ko ni aami lati ṣe deede wọn fun awọn iṣẹ ṣiṣe kan pato. Ni awọn ayidayida kan, awọn olupilẹṣẹ le fẹran awọn awoṣe ti nfi iṣẹ ṣiṣe to dara julọ sori ẹgbẹ kan ti awọn iṣẹ-ṣiṣe inu-ašẹ ju awoṣe-ainidii kan. TACP jẹ apẹrẹ bi ikẹkọ iṣaaju-itẹsiwaju ni ero lati mu iṣẹ ṣiṣe pọ si lori awọn iṣẹ ṣiṣe ti a fojusi, laisi awọn ibeere fun data aami. Ni pataki, awọn onkọwe nigbagbogbo kọkọ kọkọ awọn awoṣe orisun ṣiṣi lori awọn ami iṣẹ-ṣiṣe (laisi awọn aami). Idiwọn akọkọ ti TACP wa ni kikọ awọn LLM-iṣẹ-ṣiṣe kan dipo ipilẹ LLMs, nitori lilo ẹyọkan ti data iṣẹ-ṣiṣe ti ko ni aami fun ikẹkọ. Botilẹjẹpe DACP nlo kopọsi ti o tobi pupọ, o jẹ gbowolori idinamọ. Lati dọgbadọgba awọn idiwọn wọnyi, awọn onkọwe daba awọn ọna meji ti o ni ifọkansi lati kọ ipilẹ-ašẹ kan pato LLMs lakoko ti o tọju iṣẹ ṣiṣe giga julọ lori awọn iṣẹ ṣiṣe ibi-afẹde:

- Iṣẹ ṣiṣe ti o munadoko-Ifarara DACP (ETS-DACP) - Awọn onkọwe daba yiyan ipin kan ti koposi owo ti o jọra si data iṣẹ-ṣiṣe nipa lilo ifaramọ ifisinu. Ajẹkù yii ni a lo fun ikẹkọ iṣaaju-itẹsiwaju lati jẹ ki o munadoko diẹ sii. Ni pataki, awọn onkọwe ntẹsiwaju kọkọ kọkọ LLM ti o ṣiṣi silẹ lori kopọsi kekere kan ti a fa jade lati inu kopọsi inawo ti o sunmọ awọn iṣẹ ṣiṣe ibi-afẹde ni pinpin. Eyi le ṣe iranlọwọ ilọsiwaju iṣẹ ṣiṣe nitori a gba awoṣe si pinpin awọn ami iṣẹ-ṣiṣe laibikita data ti o ni aami ti ko nilo.

- Iṣẹ ṣiṣe ti o munadoko-Agnostic DACP (ETA-DACP) - Awọn onkọwe daba ni lilo awọn metiriki bii idamu ati iru entropy ami ti ko nilo data iṣẹ-ṣiṣe lati yan awọn ayẹwo lati inu koposi inawo fun ikẹkọ iṣaaju-itẹsiwaju daradara. Ọna yii jẹ apẹrẹ lati koju pẹlu awọn oju iṣẹlẹ nibiti data iṣẹ-ṣiṣe ko si tabi diẹ sii awọn awoṣe agbegbe wapọ fun agbegbe ti o gbooro ni o fẹ. Awọn onkọwe gba awọn iwọn meji lati yan awọn ayẹwo data ti o ṣe pataki fun gbigba alaye agbegbe lati inu ipin ti data agbegbe ikẹkọ iṣaaju: aratuntun ati oniruuru. Aratuntun, ni iwọn nipasẹ idamu ti a gbasilẹ nipasẹ awoṣe ibi-afẹde, tọka si alaye ti LLM ko rii tẹlẹ. Data pẹlu aratuntun giga tọkasi imọ aramada fun LLM, ati pe iru data ni a wo bi o nira pupọ lati kọ ẹkọ. Eyi ṣe imudojuiwọn awọn LLM jeneriki pẹlu imọ agbegbe aladanla lakoko ikẹkọ iṣaaju-tẹsiwaju. Oniruuru, ni apa keji, n gba iyatọ ti awọn pinpin ti awọn iru ami ami ni ile-iṣẹ ašẹ, eyiti a ti ṣe akọsilẹ gẹgẹbi ẹya-ara ti o wulo ninu iwadi ti ẹkọ ẹkọ iwe-ẹkọ lori awoṣe ede.

Nọmba ti o tẹle yii ṣe afiwe apẹẹrẹ ti ETS-DACP (osi) la ETA-DACP (ọtun).

A gba awọn igbero iṣapẹẹrẹ meji lati yan awọn aaye data ni itara lati inu kopọsi inawo ti a ti sọtọ: iṣapẹẹrẹ lile ati iṣapẹẹrẹ rirọ. Ohun iṣaaju ni a ṣe nipasẹ ipo akọkọ ti koposi inawo nipasẹ awọn metiriki ibaramu ati lẹhinna yiyan awọn ayẹwo oke-k, nibiti k ti pinnu tẹlẹ ni ibamu si isuna ikẹkọ. Fun igbehin, awọn onkọwe sọtọ awọn iwọn ayẹwo fun awọn aaye data kọọkan ni ibamu si awọn iye metiriki, ati lẹhinna laileto apẹẹrẹ awọn aaye data k lati pade isuna ikẹkọ.

Esi ati onínọmbà

Awọn onkọwe ṣe iṣiro Abajade LLMs inawo lori ọpọlọpọ awọn iṣẹ ṣiṣe inawo lati ṣe iwadii ipa ti ikẹkọ iṣaaju-tẹsiwaju:

- Owo Bank gbolohun ọrọ - Iṣẹ-ṣiṣe isọri ẹdun lori awọn iroyin owo.

- FiQA SA - Iṣẹ-ṣiṣe iyasọtọ itara ti o da lori abala ti o da lori awọn iroyin inawo ati awọn akọle.

- akọle - Iṣẹ-ṣiṣe iyasọtọ alakomeji lori boya akọle kan lori nkan inawo kan ni alaye kan ninu.

- NER - Iṣẹ isediwon nkan ti a npè ni owo ti o da lori apakan igbelewọn eewu kirẹditi ti awọn ijabọ SEC. Awọn ọrọ inu iṣẹ-ṣiṣe yii jẹ asọye pẹlu PER, LOC, ORG, ati MISC.

Nitoripe awọn LLM ti owo jẹ itọnisọna ni aifwy daradara, awọn onkọwe ṣe iṣiro awọn awoṣe ni eto 5-shot fun iṣẹ kọọkan nitori agbara. Ni apapọ, FinPythia 6.9B ju Pythia 6.9B lọ nipasẹ 10% kọja awọn iṣẹ ṣiṣe mẹrin, eyiti o ṣe afihan imunadoko ti ikẹkọ iṣaaju-pato kan pato. Fun awoṣe 1B, ilọsiwaju naa ko jinna, ṣugbọn iṣẹ ṣiṣe tun dara si 2% ni apapọ.

Nọmba ti o tẹle ṣe afihan iyatọ iṣẹ ṣaaju ati lẹhin DACP lori awọn awoṣe mejeeji.

Nọmba atẹle yii ṣe afihan awọn apẹẹrẹ agbara meji ti ipilẹṣẹ nipasẹ Pythia 6.9B ati FinPythia 6.9B. Fun awọn ibeere ti o jọmọ iṣuna meji nipa oludokoowo oludokoowo ati akoko inawo, Pythia 6.9B ko loye ọrọ naa tabi da orukọ naa mọ, lakoko ti FinPythia 6.9B ṣe agbekalẹ awọn idahun alaye ni deede. Awọn apẹẹrẹ ti agbara ṣe afihan pe ikẹkọ iṣaaju-itẹsiwaju jẹ ki awọn LLMs gba imọ agbegbe lakoko ilana naa.

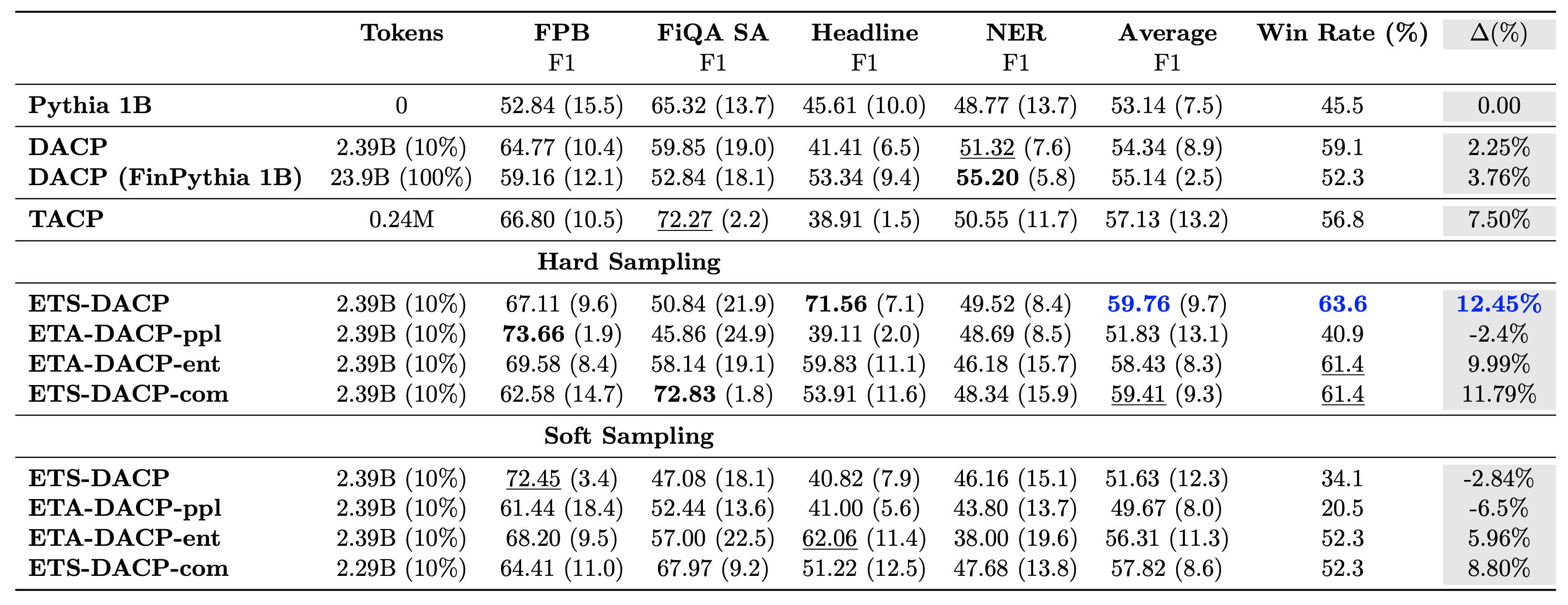

Tabili ti o tẹle yii ṣe afiwe ọpọlọpọ awọn ọna ṣiṣe ikẹkọ siwaju siwaju daradara. ETA-DACP-ppl ni ETA-DACP da lori perplexity (aratuntun), ati ETA-DACP-ent da lori entropy (orisirisi). ETS-DACP-com jẹ iru si DACP pẹlu yiyan data nipa aropin gbogbo awọn metiriki mẹta. Awọn atẹle jẹ awọn gbigba diẹ lati awọn abajade:

- Awọn ọna yiyan data jẹ daradara - Wọn kọja ikẹkọ deede igbagbogbo pẹlu 10% ti data ikẹkọ. Ikẹkọ iṣaaju ti o munadoko pẹlu Iṣẹ-Ifarakan DACP (ETS-DACP), Iṣẹ-ṣiṣe-Agnostic DACP ti o da lori entropy (ESA-DACP-ent) ati Iṣẹ-Ifarakan DACP ti o da lori gbogbo awọn metiriki mẹta (ETS-DACP-com) ṣe deede DACP boṣewa ni apapọ Bíótilẹ o daju pe won ti wa ni oṣiṣẹ lori nikan 10% ti owo koposi.

- Aṣayan data ti o mọ iṣẹ-ṣiṣe ṣiṣẹ dara julọ ni ila pẹlu iwadi awọn awoṣe ede kekere - ETS-DACP ṣe igbasilẹ iṣẹ apapọ ti o dara julọ laarin gbogbo awọn ọna ati, da lori gbogbo awọn metiriki mẹta, ṣe igbasilẹ iṣẹ ṣiṣe ti o dara julọ keji. Eyi ni imọran pe lilo data iṣẹ-ṣiṣe ti ko ni aami si tun jẹ ọna ti o munadoko lati ṣe alekun iṣẹ ṣiṣe ni ọran ti LLMs.

- Aṣayan data iṣẹ-ṣiṣe-agnostic ti sunmọ keji - ESA-DACP-ent tẹle iṣẹ ṣiṣe ti ọna yiyan data iṣẹ-ṣiṣe, ti o tumọ si pe a tun le mu iṣẹ ṣiṣe pọ si nipa yiyan awọn ayẹwo didara-giga ti ko ni asopọ si awọn iṣẹ ṣiṣe kan pato. Eyi ṣe ọna lati kọ awọn LLM inawo fun gbogbo agbegbe lakoko ṣiṣe ṣiṣe ṣiṣe iṣẹ-ṣiṣe ti o ga julọ.

Ibeere pataki kan nipa ikẹkọ iṣaaju-itẹsiwaju ni boya o ni ipa lori iṣẹ ṣiṣe lori awọn iṣẹ ṣiṣe ti kii ṣe aaye. Awọn onkọwe naa tun ṣe ayẹwo awoṣe ikẹkọ ti o tẹsiwaju nigbagbogbo lori awọn iṣẹ-ṣiṣe jeneriki mẹrin ti a lo pupọ: ARC, MMLU, TruthQA, ati HellaSwag, eyiti o ṣe iwọn agbara ti idahun ibeere, ironu, ati ipari. Awọn onkọwe rii pe ikẹkọ ṣaaju ki o to tẹsiwaju ko ni ipa lori iṣẹ ṣiṣe ti kii ṣe aaye. Fun alaye diẹ sii, tọka si Ṣiṣe ikẹkọ Ilọsiwaju Ilọsiwaju fun Ilé Awọn awoṣe Ede Tobi Kan pato.

ipari

Ifiweranṣẹ yii funni ni awọn oye sinu gbigba data ati awọn ilana ikẹkọ iṣaaju-itẹsiwaju fun ikẹkọ LLMs fun agbegbe eto inawo. O le bẹrẹ ikẹkọ LLM tirẹ fun awọn iṣẹ ṣiṣe inawo ni lilo Amazon SageMaker Ikẹkọ or Amazon Bedrock loni.

Nipa awọn onkọwe

Yong Xie jẹ onimọ-jinlẹ ti a lo ni Amazon FinTech. O fojusi lori idagbasoke awọn awoṣe ede nla ati awọn ohun elo AI Generative fun inawo.

Yong Xie jẹ onimọ-jinlẹ ti a lo ni Amazon FinTech. O fojusi lori idagbasoke awọn awoṣe ede nla ati awọn ohun elo AI Generative fun inawo.

Karan Aggarwal jẹ Onimọ-jinlẹ ti a lo Agba pẹlu Amazon FinTech pẹlu idojukọ lori Generative AI fun awọn ọran lilo inawo. Karan ni iriri ti o jinlẹ ni itupalẹ jara-akoko ati NLP, pẹlu iwulo pataki ni kikọ ẹkọ lati data aami to lopin

Karan Aggarwal jẹ Onimọ-jinlẹ ti a lo Agba pẹlu Amazon FinTech pẹlu idojukọ lori Generative AI fun awọn ọran lilo inawo. Karan ni iriri ti o jinlẹ ni itupalẹ jara-akoko ati NLP, pẹlu iwulo pataki ni kikọ ẹkọ lati data aami to lopin

Aitzaz Ahmad jẹ Oluṣakoso Imọ-ẹrọ ti a lo ni Amazon nibiti o ṣe itọsọna ẹgbẹ kan ti awọn onimọ-jinlẹ ti o kọ ọpọlọpọ awọn ohun elo ti Ẹkọ ẹrọ ati Generative AI ni Isuna. Awọn iwulo iwadii rẹ wa ni NLP, Generative AI, ati Awọn Aṣoju LLM. O gba PhD rẹ ni Imọ-ẹrọ Itanna lati Ile-ẹkọ giga Texas A&M.

Aitzaz Ahmad jẹ Oluṣakoso Imọ-ẹrọ ti a lo ni Amazon nibiti o ṣe itọsọna ẹgbẹ kan ti awọn onimọ-jinlẹ ti o kọ ọpọlọpọ awọn ohun elo ti Ẹkọ ẹrọ ati Generative AI ni Isuna. Awọn iwulo iwadii rẹ wa ni NLP, Generative AI, ati Awọn Aṣoju LLM. O gba PhD rẹ ni Imọ-ẹrọ Itanna lati Ile-ẹkọ giga Texas A&M.

Qingwei Li jẹ Alamọja Ẹkọ Ẹrọ ni Awọn iṣẹ wẹẹbu Amazon. O gba Ph.D. ni Awọn isẹ Iwadi lẹhin ti o fọ iwe-ẹri igbeowosile ti oludamoran rẹ ti o kuna lati fi Ebun Nobel ti o ṣeleri. Lọwọlọwọ o ṣe iranlọwọ fun awọn alabara ni iṣẹ inawo kọ awọn ipinnu ikẹkọ ẹrọ lori AWS.

Qingwei Li jẹ Alamọja Ẹkọ Ẹrọ ni Awọn iṣẹ wẹẹbu Amazon. O gba Ph.D. ni Awọn isẹ Iwadi lẹhin ti o fọ iwe-ẹri igbeowosile ti oludamoran rẹ ti o kuna lati fi Ebun Nobel ti o ṣeleri. Lọwọlọwọ o ṣe iranlọwọ fun awọn alabara ni iṣẹ inawo kọ awọn ipinnu ikẹkọ ẹrọ lori AWS.

Raghvender Arni nyorisi Ẹgbẹ Imudara Onibara (CAT) laarin Awọn ile-iṣẹ AWS. CAT jẹ ẹgbẹ iṣẹ-agbelebu agbaye ti alabara ti nkọju si awọn ayaworan awọsanma, awọn onimọ-ẹrọ sọfitiwia, awọn onimọ-jinlẹ data, ati awọn amoye AI / ML ati awọn apẹẹrẹ ti o ṣe imudara ĭdàsĭlẹ nipasẹ iṣelọpọ ilọsiwaju, ati ṣiṣe didara iṣẹ ṣiṣe awọsanma nipasẹ imọ-ẹrọ imọ-ẹrọ pataki.

Raghvender Arni nyorisi Ẹgbẹ Imudara Onibara (CAT) laarin Awọn ile-iṣẹ AWS. CAT jẹ ẹgbẹ iṣẹ-agbelebu agbaye ti alabara ti nkọju si awọn ayaworan awọsanma, awọn onimọ-ẹrọ sọfitiwia, awọn onimọ-jinlẹ data, ati awọn amoye AI / ML ati awọn apẹẹrẹ ti o ṣe imudara ĭdàsĭlẹ nipasẹ iṣelọpọ ilọsiwaju, ati ṣiṣe didara iṣẹ ṣiṣe awọsanma nipasẹ imọ-ẹrọ imọ-ẹrọ pataki.

- SEO Agbara akoonu & PR Pinpin. Gba Imudara Loni.

- PlatoData.Network inaro Generative Ai. Fi agbara fun ara Rẹ. Wọle si Nibi.

- PlatoAiStream. Web3 oye. Imo Amugbadun. Wọle si Nibi.

- PlatoESG. Erogba, CleanTech, Agbara, Ayika, Oorun, Isakoso Egbin. Wọle si Nibi.

- PlatoHealth. Imọ-ẹrọ Imọ-ẹrọ ati Awọn Idanwo Ile-iwosan. Wọle si Nibi.

- Orisun: https://aws.amazon.com/blogs/machine-learning/efficient-continual-pre-training-llms-for-financial-domains/