متعدد تجربات سے پتہ چلتا ہے کہ ChatGPT، مقبول بڑی زبان کا ماڈل (LLM)، محافظوں کو ممکنہ حفاظتی واقعات کا پتہ لگانے اور کوڈ میں حفاظتی کمزوریوں کو تلاش کرنے میں مدد کرنے کے لیے کارآمد ثابت ہو سکتا ہے، حالانکہ مصنوعی ذہانت (AI) ماڈل کو ایسی سرگرمیوں کے لیے خاص طور پر تربیت نہیں دی گئی تھی، اس ہفتے جاری کردہ نتائج کے مطابق۔

15 فروری کو ChatGPT کی افادیت کے ایک واقعہ رسپانس ٹول کے تجزیے میں، کاسپرسکی میں واقعہ رسپانس ٹیم کے سربراہ وکٹر سرجیف نے پایا کہ چیٹ جی پی ٹی سمجھوتہ کرنے والے سسٹمز پر چلنے والے بدنیتی پر مبنی عمل کی نشاندہی کر سکتا ہے۔ Sergeev نے Meterpreter اور PowerShell Empire ایجنٹوں کے ساتھ ایک سسٹم کو متاثر کیا، ایک مخالف کے کردار میں مشترکہ اقدامات کیے، اور پھر سسٹم کے خلاف ChatGPT سے چلنے والا سکینر چلایا۔

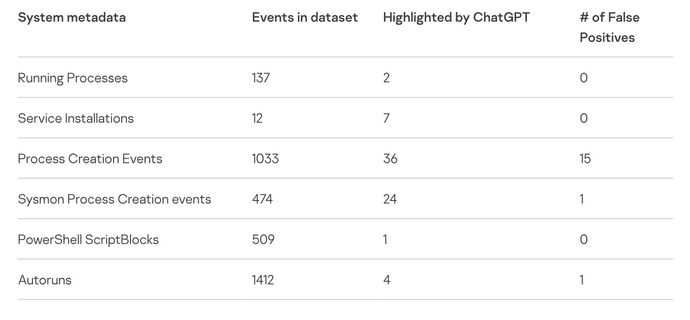

ایل ایل ایم نے سسٹم پر چلنے والے دو بدنیتی پر مبنی عملوں کی نشاندہی کی، اور 137 سومی عمل کو درست طریقے سے نظر انداز کیا، جس سے ممکنہ طور پر اوور ہیڈ کو ایک اہم حد تک کم کیا گیا، اس نے تجربے کی وضاحت کرتے ہوئے ایک بلاگ پوسٹ میں لکھا۔

"چیٹ جی پی ٹی نے کامیابی سے مشکوک سروس انسٹالیشنز کی نشاندہی کی، بغیر کسی غلط مثبت کے،" سرجیف نے لکھا. "دوسری سروس کے لیے، اس نے ایک نتیجہ فراہم کیا کہ سروس کو سمجھوتہ کے اشارے کے طور پر کیوں درجہ بندی کیا جانا چاہیے۔"

سیکیورٹی محققین اور اے آئی ہیکرز نے سبھی نے چیٹ جی پی ٹی میں دلچسپی لی ہے، ایل ایل ایم کی کمزوریوں کی جانچ کر رہے ہیں، جبکہ دیگر محققین کے ساتھ ساتھ سائبر کرائمینلز نے بھی کوشش کی ہے۔ ایل ایل ایم کو تاریک پہلو کی طرف راغب کریں۔، اسے ترتیب دے رہا ہے۔ بہتر فشنگ ای میل پیغامات تیار کریں۔ or میلویئر پیدا کریں.

اس کے باوجود سیکورٹی محققین یہ بھی دیکھ رہے ہیں کہ عام زبان کا ماڈل کس طرح دفاع سے متعلق مخصوص کاموں پر کارکردگی کا مظاہرہ کرتا ہے۔ دسمبر میں، ڈیجیٹل فرانزک فرم Cado Security نے ChatGPT کو استعمال کیا۔ سمجھوتہ کی ٹائم لائن بنائیں ایک واقعے سے JSON ڈیٹا کا استعمال، جس نے ایک اچھی — لیکن مکمل طور پر درست نہیں — رپورٹ تیار کی۔ سیکیورٹی کنسلٹنسی NCC گروپ نے ChatGPT کے ساتھ تجربہ کیا۔ کوڈ میں کمزوریوں کو تلاش کرنے کا ایک طریقہ، جو اس نے کیا، لیکن ہمیشہ درست طریقے سے نہیں۔

سیکورٹی کنسلٹنسی NCC گروپ کے چیف سائنٹسٹ کرس اینلے کا کہنا ہے کہ نتیجہ یہ ہے کہ سیکورٹی تجزیہ کاروں، ڈویلپرز اور ریورس انجینئرز کو جب بھی LLMs کا استعمال کرتے ہوئے خاص طور پر ان کی صلاحیتوں کے دائرہ سے باہر کے کاموں کے لیے احتیاط برتنے کی ضرورت ہے۔

"میں یقینی طور پر سوچتا ہوں کہ پیشہ ور ڈویلپرز، اور کوڈ کے ساتھ کام کرنے والے دوسرے لوگوں کو ChatGPT اور اسی طرح کے ماڈلز کو تلاش کرنا چاہیے، لیکن بالکل درست، حقائق پر مبنی نتائج کی بجائے حوصلہ افزائی کے لیے،" وہ کہتے ہیں، "سیکیورٹی کوڈ کا جائزہ ایسی چیز نہیں ہے جس کے لیے ہمیں ChatGPT کا استعمال کرنا چاہیے، اس لیے پہلی بار اس کے بہترین ہونے کی توقع رکھنا غیر منصفانہ ہے۔"

AI کے ساتھ IoCs کا تجزیہ کرنا

Kaspersky تجربہ ChatGPT سے کئی ہیکرز کے ٹولز، جیسے Mimikatz اور Fast Reverse Proxy کے بارے میں پوچھنے کے ساتھ شروع ہوا۔ اے آئی ماڈل نے ان ٹولز کو کامیابی کے ساتھ بیان کیا، لیکن جب معروف ہیشز اور ڈومینز کی شناخت کرنے کی درخواست کی گئی تو یہ ناکام رہا۔ مثال کے طور پر، LLM WannaCry میلویئر کے معروف ہیش کی شناخت نہیں کر سکا۔

تاہم، میزبان پر بدنیتی پر مبنی کوڈ کی نشاندہی کرنے میں نسبتاً کامیابی نے کاسپرکی کے سرجیو کو ChatGPT سے ایک پاور شیل اسکرپٹ بنانے کے لیے کہا تاکہ سسٹم سے میٹا ڈیٹا اور سمجھوتے کے اشارے جمع کیے جا سکیں اور انہیں LLM میں جمع کرایا جا سکے۔ کوڈ کو دستی طور پر بہتر کرنے کے بعد، سرجیف نے اسکرپٹ کو متاثرہ ٹیسٹ سسٹم پر استعمال کیا۔

مجموعی طور پر، کاسپرسکی تجزیہ کار نے ٹیسٹ سسٹم پر 3,500 سے زیادہ واقعات کے لیے میٹا ڈیٹا کا تجزیہ کرنے کے لیے ChatGPT کا استعمال کیا، جس میں سمجھوتے کے 74 ممکنہ اشارے ملے، جن میں سے 17 غلط مثبت تھے۔ تجربہ بتاتا ہے کہ چیٹ جی پی ٹی ان کمپنیوں کے لیے فرانزک معلومات اکٹھا کرنے کے لیے کارآمد ثابت ہو سکتا ہے جو اینڈ پوائنٹ ڈٹیکشن اینڈ رسپانس (EDR) سسٹم نہیں چلا رہی ہیں، کوڈ کی الجھن کا پتہ لگا رہی ہیں، یا ریورس انجینئرنگ کوڈ بائنریز۔

سرجیف نے یہ بھی خبردار کیا کہ غلطیاں ایک بہت ہی حقیقی مسئلہ ہے۔ "غلط مثبت اور غلط منفی سے ہوشیار رہیں جو یہ پیدا کر سکتے ہیں،" انہوں نے لکھا۔ "دن کے اختتام پر، یہ صرف ایک اور شماریاتی نیورل نیٹ ورک ہے جو غیر متوقع نتائج پیدا کرنے کا شکار ہے۔"

اپنے تجزیے میں، Cado سیکیورٹی نے خبردار کیا کہ ChatGPT عام طور پر اپنے نتائج پر اعتماد کا اہل نہیں ہے۔ "یہ چیٹ جی پی ٹی کے ساتھ ایک عام تشویش ہے جسے اوپن اے آئی نے اپنے آپ کو اٹھایا ہے - یہ فریب پیدا کر سکتا ہے، اور جب یہ فریب دیتا ہے، تو یہ اعتماد کے ساتھ کرتا ہے،" کیڈو کے تجزیہ میں کہا گیا ہے۔

منصفانہ استعمال اور رازداری کے قواعد کی وضاحت کی ضرورت ہے۔

تجربات اوپن اے آئی کے چیٹ جی پی ٹی سسٹم میں جمع کردہ ڈیٹا کے حوالے سے کچھ اہم مسائل بھی اٹھاتے ہیں۔ پہلے سے ہی، کمپنیوں نے انٹرنیٹ پر معلومات کا استعمال کرتے ہوئے ڈیٹا سیٹس کی تخلیق میں رعایت لینا شروع کر دی ہے، جیسے کمپنیوں کے ساتھ کلیئرویو اے اور استحکام AI اپنے مشین لرننگ ماڈلز کے استعمال کو کم کرنے کے لیے مقدمات کا سامنا کر رہے ہیں۔

رازداری ایک اور مسئلہ ہے۔ NCC گروپ کے اینلی کا کہنا ہے کہ سیکورٹی پیشہ ور افراد کو یہ تعین کرنا ہوگا کہ آیا سمجھوتے کے پیش کردہ اشارے حساس ڈیٹا کو ظاہر کرتے ہیں، یا تجزیہ کے لیے سافٹ ویئر کوڈ جمع کرنے سے کمپنی کی دانشورانہ ملکیت کی خلاف ورزی ہوتی ہے۔

"کیا ChatGPT پر کوڈ جمع کرنا اچھا خیال ہے، اس کا انحصار حالات پر ہے،" وہ کہتے ہیں۔ "بہت سارے کوڈ ملکیتی ہیں اور مختلف قانونی تحفظات کے تحت ہیں، لہذا میں یہ سفارش نہیں کروں گا کہ لوگ تیسرے فریق کو کوڈ جمع کرائیں جب تک کہ انہیں ایسا کرنے کی اجازت نہ ہو۔"

سرجیف نے اسی طرح کی وارننگ جاری کی: سمجھوتے کا پتہ لگانے کے لیے چیٹ جی پی ٹی کا استعمال حساس ڈیٹا کو ضرورت کے مطابق سسٹم کو بھیجتا ہے، جو کمپنی کی پالیسی کی خلاف ورزی ہو سکتا ہے اور کاروباری خطرہ پیش کر سکتا ہے۔

"ان اسکرپٹس کا استعمال کرکے، آپ OpenAI کو حساس ڈیٹا سمیت ڈیٹا بھیجتے ہیں،" انہوں نے کہا، "لہذا محتاط رہیں اور پہلے ہی سسٹم کے مالک سے مشورہ کریں۔"

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.darkreading.com/analytics/chatgpt-subs-security-analyst-hallucinates-occasionally