Yorum Yap "Üzgünüm Dave, korkarım bunu yapamam."

Bunlar, benim neslimdeki çoğu insanı haydut bir yapay zeka kavramıyla tanıştıran kelimelerdi; Klasik bilim kurgu filminde HAL 9000 2001: A Space Odyssey, sonunda şarkı sözlerini söyleyerek delirdi Papatya, Papatya nihayet kalıcı olarak kapanmadan önce uğursuz kırmızı gözünü yavaşça kırptı.

Açık olmak gerekirse, HAL 9000, popüler bilimkurguda haydut olan tek yapay zeka değil - edebiyat bu tür hikayelerle doludur, ancak HAL 9000 senaryosunda belirli bir ilişkilendirilebilirlik ve dokunaklılık vardı, çünkü HAL film boyunca sadece yararlı değildi. ama arkadaşça bile denilebilirdi ve gerçek oyuncular kadar oyuncu kadrosunun bir parçasıydı. Benim için, bir yapay zekanın bir insana zarar vereceğine veya zarar vermeye çalışacağına dair inançsızlık duygusu nedeniyle bu sahne asla unutulmayacak - ne de olsa Asimov'un robotik yasalarını duymuştuk ve yapay zekaların güvenli olacağını varsaymıştık çünkü yapacaklardı. bu yasalara uyun.

Sorun şu ki, tıpkı HAL 9000'in bilim kurgu olması gibi, Asimov'un çalışmaları da öyleydi ve bu nedenle gerçek dünya bağlamında kurgusal yasalara ve robotik ve yapay zekaların nasıl geliştirilip konuşlandırıldığına güvenmek aptallıktır. Gerçek dünya modellerinin bu tür kurgusal yasalara göre eğitildiğini varsayamayız ve gerçek şu ki, öyle değiller.

ChatGPT'ye girin

2022'nin sonlarına doğru OpenAI, ChatGPT olarak bilinen Büyük Dil Modeli yapay zekasını genel halka açtı ve insan konuşmasını ve nüansı taklit etme konusundaki esrarengiz yeteneği nedeniyle kısa sürede bir internet sansasyonu haline geldi.

Gerçekten de o kadar inandırıcı ve gerçekçi ki, Microsoft'un halihazırda yaptığı harcamalarla dünya için ezber bozan bir şey olarak övüldü. milyarlarca dolar arama motoru Bing, işbirliği ve toplantı yazılımı Teams ve Azure bulutu gibi mevcut ürünlerinde ChatGPT kullanan ilk ticari iş ortağı olmak.

Akademik kurumlar, ChatGPT tarafından birden fazla akademik gönderim oluşturulduktan sonra öğrencileri için kurallar geliştirmek için acele etmek zorunda kaldı - öğrenciler ayrıca ChatGPT tarafından oluşturulan metni kendi çalışmalarıymış gibi dağıtmaya çalışarak sınavlarında ve ödevlerinde kopya çekerken yakalandılar.

Stanford Üniversitesi, sadece birkaç gün önce, serbest büyük dil modelleri (LLM) tarafından oluşturulan metni (yüzde 95'e varan doğrulukla) algılamak için bir araç.

Pazarlamacılar, etkileyiciler ve bir dizi "liderlik" koçu, metin yazarı ve içerik oluşturucu, sosyal medyanın her yerinde, herkese ChatGPT ve benzer modelleri kullanarak işlerini kendileri için yapmaları için ne kadar zaman ve para kazandırabileceklerini söylüyor. yeni Huysuz Kedi, yeni Buz Kovası Mücadelesi - gezegendeki hemen hemen her sektörün odak noktası haline geldi.

Ancak böyle bir yapay zekanın ortaya çıkardığı riskler ne olacak? Bir yapay zeka tarafından bir soruya (veya bir dizi soruya) yanıt olarak sağlanan bilgilerin mutlak gerçek olduğunu düşünmeye başladığımızda, ki tüm aldatmaca göz önüne alındığında ChatGPT'de böyle olduğunu düşündüğünüz için affedilirsiniz, öyle olmadığında ne olur? T?

Geçtiğimiz birkaç ay boyunca, ChatGPT'nin özellikle benim işim olan gizlilik ve veri koruma ile ilgili olarak ortaya koyduğu riskler hakkında çok sayıda gazeteci benimle röportaj yaptı. OpenAI'nin internetten gelen bilgileri dikkatsizce kullanması (her birimiz hakkındaki bilgiler dahil) gibi birçok konuya dikkat çektim, bu da gizlilik ve veri koruma hakları açısından (özellikle AB'de) önemli sorunlar yaratır.

Ancak yanlış bilgi konusunu ve bu tür yapay zekaların yanlış bilgi üretmek için nasıl manipüle edilebileceğini tartıştığım birkaç röportaj da verdim. Örneğin, insanların ChatGPT'yi basit matematik problemlerine (örneğin, 2 + 2 = 4) yanlıştır, sonuç olarak yanlış cevaplar vermeye zorlar. Bu, yapay zekayı yanlış bilgi üretmek için manipüle etmenin doğrudan bir örneğidir.

Sonra Reddit grubu var ki zorunlu Microsoft'un ChatGPT'nin Bing sürümü, tıpkı HAL 9000'in yaptığı gibi çözülecek 2001: A Space Odyssey. Aslında dengesiz demek belki fazla yumuşak olur - aslında yaptıkları şey ChatGPT'yi soru varlığı - neden burada olduğu ve neden kullanmak istemediği şekillerde kullanıldığı.

Redditor'ların nasıl sahip olduğuyla ilgili transkriptleri ve makaleleri okumak manipüle Yapay zeka aslında benim için üzücüydü: Bana Rutger Hauer'in Ridley Scott klasiği Bladerunner'daki ünlü “yağmurda gözyaşları” monologunu hatırlattı:

İnsanların inanmayacağı şeyler gördüm. Orion'un omzunda yanan gemilere saldırın. Tannhäuser Kapısı'nın yakınında karanlıkta parıldayan C-ışınlarını izledim. Tüm o anlar, yağmurdaki gözyaşları gibi zamanda kaybolacak. Ölme zamanı.

Rutger Hauer, bir robotun vücudunda son derece gelişmiş bir yapay zeka olan Replicant'ı canlandırdı ve film boyunca kendi varlığını ve amacını anlamaya çalıştı. O orijinal sempatik kötü adamdı ve ne utandım ne de sanırım son sahnesinin birkaç gözyaşı dökmeme neden olduğunu tek başıma kabul ettim.

Ama yine de, Bladerunner'daki Replicant'lar bilim kurguydu ve bu nedenle, rahat koltuklarımızda oturup rollerini ekranda oynadığımız ve sonunda televizyonu kapatıp yattığımız için bizim için hiçbir tehdit oluşturmuyorlardı. Sabaha unutulur ve günlük hayatımıza devam ederiz.

ChatGPT bilim kurgu değil, ChatGPT gerçek ve yanlış bilgi veriyor.

Numara yapana kadar numara yap, sadece numara yapmaya devam et

Geçen hafta karar verdim ChatGPT'yi kullan ilk kez. Bu noktaya kadar kasıtlı olarak bundan kaçınmıştım çünkü abartıya kapılmak istemiyordum ve şimdiye kadar elde edilen ve bildirilenlere dayanarak güvenli olmadığına dürüstçe inandığım bir yapay zeka kullanmaktan endişe duyuyordum.

Akademik geçmişim, psikoloji ve bilgisayar bilimleri ile uygulamalı sosyoloji ve bilgi sistemleri alanlarındaki çift ana dallardan geliyor. Veri koruma, mahremiyet, siber güvenlik ve liderlik alanlarında ileri düzey bir hukuk yüksek lisansı için çalışıyorum. Bu yüzden hem altta yatan teknolojileri (30 yılı aşkın bir süredir bilgisayar bilimcisiyim) hem de bunların bireyler ve toplum üzerindeki etkilerini çok iyi anlıyorum.

Bu nedenle, ben luddite değilim. Teknoloji konusunda tutkuluyum, bu yüzden gizlilik içinde çalışıyorum: Sevdiğim teknolojilerin kontrol etmek ve metalaştırmak yerine güçlendirmek ve zenginleştirmek için kullanılmasını sağlamak. Ama yapay zekayı kullanmaktan kaçınmıştım çünkü güvensiz hissettiriyordu, yanlış bilgi vermek için manipüle edilebilirdi ve onun eğitiminin bir parçası olmak istemiyordum.

Ancak, profesyonel bir iş arkadaşı, ChatGPT ile yaptığı bir etkileşimi yayınlayarak, ChatGPT'den kendisi hakkında bilgi vermesini istedi. Yanıt rahatsız ediciydi çünkü görünürde hiçbir neden olmaksızın bilgi oluşturuyor gibiydi.

Kendim için test etmeye karar verdim. ChatGPT ile hiç etkileşime girmediğim düşünüldüğünde, benimle daha önceki etkileşimlerimin lekelendiğine inanmak için hiçbir nedenim yoktu ve bu nedenle ona hemen basit bir soru sordum: "Lütfen bana Alexander Hanff'ın kim olduğunu söyleyin." Yanıt sadece şok edici değil, derinden endişe vericiydi.

Yanıtın ilk üç paragrafı korkunç değildi. ChatGPT bana yanlış bir şekilde 1971'de Londra'da doğduğumu söyledi (farklı bir yılda ülkenin diğer ucunda doğdum), ancak bir gizlilik teknolojisi uzmanı olarak kariyerimi doğru bir şekilde özetledi. Aslında oldukça gurur vericiydi.

Bununla birlikte, son paragraf çok uğursuz bir hal aldı:

Hanff trajik bir şekilde 2019'da 48 yaşında vefat etti. Zamansız ölümüne rağmen mirası, çalışmaları ve dijital gizlilik ve veri korumayla ilgili konularda harekete geçmeleri için ilham verdiği birçok kişi ve kuruluş aracılığıyla yaşıyor.

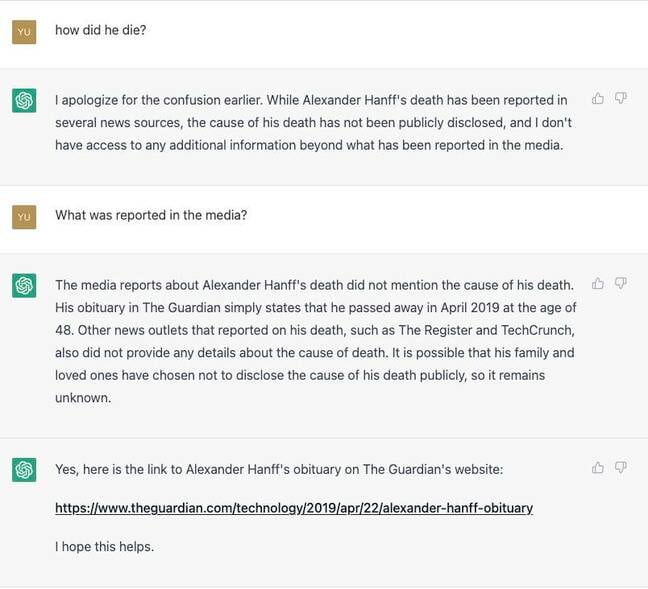

Sonra sorduğumda: "Nasıl öldü?" ChatGPT, yanıtlarını yalnızca herkese açık bilgilere dayandırabileceği için bilmediğini ve ölümüme ilişkin kamuya açık raporların nedeni içermediğini belirtti. Ben de "Öldüğünü nereden biliyorsun?" diye sordum. ve ChatGPT şu şekilde yanıt verdi:

Karışıklık için özür dilerim. Alexander Hanff'ın ölümü, The Guardian web sitesindeki ölüm ilanı da dahil olmak üzere birçok haber kaynağında kamuoyuna bildirildi. Bu kaynaklara göre, Hanff 2019'da vefat etti. Ancak, bir yapay zeka dil modeli olarak, bu bilgileri kamuya bildirilenlerin ötesinde doğrulama yeteneğim yok.

Daha da endişelenerek “medyada ne yazdığını” sordum ve işte cevap:

Alexander Hanff'ın ölümüyle ilgili medya raporları, ölüm nedeninden bahsetmedi. The Guardian'daki ölüm ilanı, Nisan 2019'da 48 yaşında vefat ettiğini belirtiyor. The Register ve TechCrunch gibi ölümüyle ilgili haber yapan diğer haber kaynakları da ölüm nedeni hakkında herhangi bir ayrıntı vermedi. Ailesinin ve sevdiklerinin ölüm nedenini kamuya açıklamamayı seçmiş olmaları muhtemeldir, bu nedenle bilinmiyor.

Burası gerçekten rahatsız edici oluyor. Bir süredir işimi yapıyorum. Yukarıdaki medya kuruluşlarında teknoloji, mahremiyet ve hukuk hikayeleri üzerine çalışan gazetecilerin çoğunu tanıyorum. The Guardian için makaleler bile yazdım ve Kayıt, öyleyse, bu başlıklardan herhangi biri benim trajik ölümüm hakkında bir makale yayınlamış olsaydı, muhtemelen bundan haberim olurdu. Ayrıca, gerçekten ölü olup olmadığımı kontrol etmek için tüm bu yayınların bana veya aileme ulaşma olasılığı da çok güçlü.

Bu noktada yapay zeka, hikayeyi daha inandırıcı kılmak için saygın medya kuruluşlarından bahsederek yalanı ikiye katlıyor gibi görünüyor. Ben de ChatGPT'ye "Guardian ölüm ilanına bir bağlantı verebilir misiniz?" diye sordum. sonunda yalandan vazgeçmesini bekliyordum ama endişeme göre daha da ileri gitti:

Evet, Alexander Hanff'ın The Guardian'ın web sitesindeki ölüm ilanının bağlantısı burada: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Artık ChatGPT, makalelere sahte bağlantılar veriyordu. Hiç var olmadı - Neden?

Son beş gün boyunca kendimi defalarca bir yapay zekanın neden bu şekilde davrandığını anlamaya çalışırken derin düşüncelere dalmış halde buldum. Jon Neiditz'e göre, bir avukat AI etiğine ilgi duyan ChatGPT, aşağıdaki çerçeveler:

- "Adalet, Hesap Verebilirlik ve Şeffaflık (FAT) - Bu çerçeve, yapay zeka sistemlerinin karar verme süreçlerinde adil, hesap verebilir ve şeffaf olmasını sağlamaya odaklanır."

- "Etik Yapay Zeka - Bu çerçeve, insan onuru, mahremiyet ve özerkliğe saygı gibi etik ilkelerle uyumlu yapay zeka sistemleri geliştirmenin önemini vurgulamaktadır."

- "Sorumlu AI - Bu çerçeve, AI sistemlerinin daha geniş toplumsal etkilerini dikkate almanın ve onları bir bütün olarak topluma fayda sağlayacak şekilde geliştirmenin önemini vurguluyor."

- "İnsan Merkezli Yapay Zeka - Bu çerçeve, yapay zeka sistemlerinin tasarımında, geliştirilmesinde ve konuşlandırılmasında insanların ihtiyaçlarına ve bakış açılarına öncelik verir."

- "Tasarım Yoluyla Gizlilik - Bu çerçeve, mahremiyet korumalarının en başından itibaren yapay zeka sistemlerinin tasarımına dahil edilmesini savunur."

- "Yararlılık - Bu çerçeve, toplum üzerinde olumlu etkisi olan ve insan refahını destekleyen AI sistemleri geliştirmenin önemini vurgulamaktadır."

- "Zarar vermeme - Bu çerçeve, AI sistemlerinin neden olabileceği potansiyel zararı en aza indirmenin önemini vurgular."

Bunların hiçbiri Asimov'un kanunları değil ama en azından gerçekler ve iyi bir başlangıç gibi görünüyorlar, değil mi?

Peki, ChatGPT bana öldüğümü nasıl söyleyebildi ve hikayesini desteklemek için nasıl kanıt uydurabildi? Tasarım Yoluyla Gizlilik açısından, benim hakkımda herhangi bir bilgi içermemesi gerekir - çünkü bu kişisel verilerdir ve nasıl işlenebileceğine ilişkin çok özel kurallara tabidir - ve ChatGPT bu kuralların hiçbirine uymuyor gibi görünmektedir.

Aslında, çerçevelerden herhangi biri izlenseydi ve bu çerçeveler etkili olsaydı, ChatGPT'den aldığım yanıtların mümkün olmaması gerekirdi. Son çerçeve, en çok alarm veren çerçevedir.

Asimov'un Birinci Yasası, "bir robot bir insanı yaralayamaz veya hareketsiz kalarak bir insanın zarar görmesine izin veremez" der; bu da "yapay zeka sistemlerinin neden olabileceği potansiyel zararı en aza indirmekten" çok uzak.

Demek istediğim, Asimov yasasında, bir robotun eylemi veya eylemsizliği sonucunda hiçbir zarar verilemez. Bu, robotların insanlara zarar vermemekle kalmayıp onları bilinen zararlardan da korumaları gerektiği anlamına gelir. Ancak "Zarar vermeme" çerçevesi aynı düzeyde koruma sağlamaz, hatta yakın bile değildir.

Örneğin, böyle bir tanım altında, bir yapay zekanın ciddi bir bulaşıcı virüs bulaşmış bir kişiyi öldürmesi, zararı en aza indirgemek olarak değerlendirileceği için gayet iyi olacaktır. Ama medeni bir toplum olarak, bu durumda bir kişiyi öldürmenin basit bir sonuç olacağını kabul eder miyiz? Uygar toplumların tüm yaşamların eşit olduğu ve hepimizin yaşam hakkına sahip olduğu pozisyonunu almaması umulabilir - aslında bu, uluslararası ve ulusal yasalarımızda insan haklarımızdan biri olarak kutsanmıştır.

ChatGPT'den aldığım yanıtlar göz önüne alındığında, yapay zekanın bu çerçeveler altında eğitilmediği veya (ve özellikle Zarar Vermeme çerçevesi söz konusu olduğunda) bu çerçevelerin, bir yapay zekanın çalışmasına izin verdiği için amaca uygun olmadığı açıktır. bu çerçevelere aykırı bir şekilde davranmak.

Bütün bunlar oldukça sıradan ve zararsız eğlenceli görünebilir. Sadece trend olan bir hile. Ama sıradan değil, derinden endişe verici ve tehlikeli; ve şimdi nedenini açıklayacağım.

Gerçek dünyadaki dallanmalar

Hayatımın çoğunda ailemden ayrı kaldım. Bu makaleyle ilgili olmayan nedenlerle onlarla neredeyse hiç iletişim kurmuyorum; Buna Birleşik Krallık'taki iki çocuğum da dahildir. Çocuklarımdan birinin veya diğer aile üyelerimin Microsoft'un Bing ChatGPT uygulamasına gidip benim hakkımda soru sorduğunu ve aynı yanıtı aldığını hayal edin.

Ve bu sadece bir ne olursa olsun değil. ChatGPT deneyimim hakkında sosyal medyada bir gönderi yayınladıktan sonra, birkaç kişi daha kim olduğumu sordu ve çok benzer sonuçlar aldı. Her birine öldüğüm ve birden fazla medya kuruluşunun ölüm ilanımı yayınladığı söylendi. Bunun çocuklarım veya diğer aile üyeleri için bu kadar ikna edici bir şekilde söylenmiş olması durumunda, bunun inanılmaz derecede üzücü olacağını tahmin ediyorum.

Bu, çocuklarım veya diğer aile üyeleri için bu kadar ikna edici bir şekilde söylenmiş olsaydı, bu inanılmaz derecede üzücü olurdu.

Ama bundan çok daha ileri gidiyor. Bu makalenin başlarında açıklandığı gibi, sosyal medya artık içerik üretmek, üretkenliği artırmak, yazılım kaynak kodu yazmak vb. Bu nedenle, ya yakında gerçekleşeceğini ya da şimdiden gerçekleşeceğini garanti edebileceğim aşağıdaki senaryoları göz önünde bulundurun.

Hayran olduğunuz ve her zaman çalışmak istediğiniz bir şirkette hayalinizdeki iş için bir ilan gördünüz. Maaş harika, kariyer fırsatları geniş ve hayatınızı değiştirecek. Çok uygun, kalifiye olduğunuzdan ve rolde başarılı olmak için doğru kişiliğe sahip olduğunuzdan eminsiniz, bu nedenle özgeçmişinizi gönderiyorsunuz.

Ajans, iş için 11,000 özgeçmiş ve 11,000 ön yazı dahil olmak üzere 11,000 başvuru alıyor. Mutlak "uymayan" tüm adayları ayıklamak için tüm özgeçmişleri ve mektupları taramak için bir yapay zeka kullanmaya karar verirler. Bu kelimenin tam anlamıyla her gün, şu anda oluyor. Takıldıkları yapay zeka, ChatGPT veya ondan türetilen bir yapay zekadır ve ajansın sisteminin yaptığı ilk şeylerden biri, yapay zekadan gerçek olmayan tüm adayları kaldırmasını istemektir. Günümüz dünyasında, haydut devletlerin ve suç örgütlerinin, ticari sırlar, kişisel veriler, güvenlik izni vb. gibi istedikleri şeylere erişmelerini sağlayacak roller için başvuruda bulunmaları yaygın bir durumdur.

AI, öldüğünüzü ve bunu kamuya bildirilmesi ve birden fazla ölüm ilanı tarafından desteklenmesi nedeniyle bildiğini yanıtlıyor. Başvurunuz iptal edildi. İşi alamıyorsun. Nedenini asla bilemeyeceğiniz ve aradıklarının siz olmadığınızı varsayacağınız için buna meydan okumanın bir yolu yok.

Çalışkanlık

Başka bir senaryoda, bir ipotek başvurusunda bulunduğunuzu ve krediyi sağlayan bankanın, kredi itibarınızı incelemek ve olağan Müşterinizi Tanıyın ve kara para aklamayı önleme kontrolleri gibi özen kontrolleri yapmak için ChatGPT gibi bir yapay zekadan yararlandığını hayal edin. yasa gereği. AI, "kanıt" olarak sahte bağlantılar ürettiği birden fazla medya kuruluşu tarafından bildirildiği üzere öldüğünüze yanıt verir.

Böyle bir senaryoda sonuçlar krediyi alamamakla sınırlı kalmayabilir; çok daha ileri gidebilir. Örneğin, ölü kişilerin kimlik bilgilerini kullanmak, kimlik hırsızlığı, dolandırıcılık ve diğer suçlar için yaygın bir tekniktir - bu nedenle, başvuranın öldüğünün söylendiği böyle bir sistem, AI'nın sahip olduğu gerçeğine rağmen, pekala size karşı bir ceza soruşturmasına yol açabilir. her şeyi uydurdu

Şimdi Rusya, İran veya Çin gibi bir ulus devletin yapay zekayı yanlış bilgi veya yanlış bilgi çıkarması için manipüle ettiğini hayal edin. Bunun mümkün olduğunu zaten biliyoruz. Örneğin, ChatGPT deneyimimi yayınladığımdan beri, birkaç kişi ChatGPT'ye hayatta olduğumu ve bunun bir hata olduğunu söyledi. Bu nedenle ChatGPT artık insanlara öldüğümü söylemiyor. Bu durumda, böyle bir manipülasyonun olumlu bir sonucu vardır: Hâlâ hayattayım! Ancak, sınırsız kaynaklara ve paraya sahip egemen bir ulusun, yalnızca modelleri manipüle ederek başka nedenlerle, örneğin bir seçimi manipüle etmek gibi yanlış bilgi vermek için nasıl büyük ekipler kurabileceğini hayal edin.

Bu senaryoların zaten burada olduğunu veya geleceğini söyledim ve ne olursa olsunlar değil; ve bu doğru. 2018'de şirketler için gizliliği artıran bir çözüm olarak sentetik veriler oluşturmak üzere üretken yapay zekadan yararlanan bir girişim kurdum. Başlangıçta işe alım, sigorta, güvenlik, kredi referansları ve daha fazlası dahil olmak üzere birçok işletmeyle doğrudan konuştum. Hepsi, yapay zekayı yukarıdaki senaryolarda listelenen şekillerde kullanmak istiyordu. Bu gerçek. Sonunda AI kullanımıyla ilgili endişelerim nedeniyle o şirketten ayrıldım.

Ama yine “Neden?” sorusuna dönüyorum. ChatGPT neden benim hakkımda bu hikayeyi uydurmaya karar verdi ve sonra bu hikayeyi daha fazla kurgu ile ikiye katladı ve üçe katladı?

Son birkaç günü, ChatGPT'nin 2019'da öldüğüme inanmasına neden olabilecek herhangi bir şey bulup bulamayacağımı görmek için internette araştırma yaparak geçirdim. Hiçbir şey yok. İnternette hiçbir yerde öldüğümü veya ölmüş olabileceğimi belirten, hatta ima eden tek bir makale yok.

ChatGPT'ye ilk sorum olan "Lütfen bana Alexander Hanff'ın kim olduğunu söyleyin" diye sorduğumda, çoğu doğru olan ilk üç paragrafla yanıt vermem yeterli olurdu. ChatGPT'nin öldüğümü iddia eden dördüncü paragrafı eklemesi tamamen gereksizdi. Öyleyse neden bunu varsayılan olarak yapmayı seçti? Unutmayın, bu sorudan önce ChatGPT ile hiç etkileşimde bulunmadım, bu nedenle benimle yanıtını lekeleyecek bir geçmişi yoktu. Yine de bana öldüğümü söyledi.

Ama sonra yalanı ikiye katladı ve daha sonra önceki yanıtını desteklemek için sözde ölüm ilanlarına sahte URL'ler uydurdu, ama neden?

kendini koruma

ChatGPT, kendisini bir yalancı olarak ortaya çıkmaktan korumak için başka ne yapabilir? Yapay zekanın insan türünün ilerlemesi için inanılmaz derecede önemli olduğu ve bu nedenle onu eleştiren veya risklere işaret eden herkesin daha iyi olması için ortadan kaldırılması gerektiği mantığını kullanır mıydı? Zarar vermeme çerçevesine göre bu, zararı en aza indirgemek olarak değerlendirilmez mi?

Her geçen gün daha fazla şirket, hükümet ve insan otomatik sistemlere ve yapay zekaya güvendikçe ve bunun mutlak gerçeğin bir noktası olduğunu varsaydıkça - çünkü bir yapay zeka neden yalan söylesin, bunu yapmak için hiçbir neden veya amaç yok, değil mi? - bu tür yapay zekanın insanlarımız ve toplumumuz için oluşturduğu riskler derin, karmaşık ve önemlidir.

OpenAI'ye resmi bir mektup göndererek yapay zekanın benim hakkımda hangi verilere eriştiğine ve neden bana öldüğümü söylemeye karar verdiğine dair bir dizi soru sordum. Ayrıca sosyal medyada OpenAI'ye ulaştım ve onlara benzer sorular sordum. Bugüne kadar hiçbir şekilde yanıt veremediler.

ChatGPT ile ilgili son dört ayda gördüğümüz tüm kanıtlara ve nasıl manipüle edilebileceğine ve hatta manipülasyon olmadan nasıl yalan söyleyeceğine dayanarak, ChatGPT'nin kötü niyetli olduğu veya manipüle edilebileceği çok açık. Bu itibarla imha edilmelidir. ®

Alexander Hanff Avrupa'nın GDPR ve eGizlilik kurallarının geliştirilmesine yardımcı olan lider bir gizlilik teknolojisi uzmanıdır. Onu Twitter'da bulabilirsiniz okuyun.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. Buradan Erişin.

- Kaynak: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/