Yazara göre resim

Büyük dil modelleri (LLM) şu anda çıldırıyor. Ancak bir kuruluş olarak doğru kaynaklara sahip değilseniz büyük dil modeli dalgasına atlamak zor olabilir. Büyük dil modellerini eğitmek ve dağıtmak zor olabilir ve aniden kendinizi dışlanmış hissedersiniz. Meta'nın LLaMA serisi gibi açık kaynaklı LLM'ler, LLM kaynaklarının kullanılabilir olmasına izin vermiştir.

Ve açık kaynak koleksiyonuna eklemek için MosaicML Temelleri' serilerine en son eklenen - MPT-7B.

MPT, MosaicML Pretrained Transformer'ın kısaltmasıdır. MPT modelleri, birçok iyileştirmeyle birlikte gelen GPT tarzı yalnızca kod çözücülü transformatörlerdir:

- Performans için optimize edilmiş katman uygulamaları

- Mimari değişiklikler nedeniyle daha fazla eğitim kararlılığı

- Bağlam uzunluğu sınırlaması yok

MPT-7B, 1T metin ve kod belirteçleri kullanılarak sıfırdan eğitilmiş bir transformatör modelidir. Evet, 1 TRİLYON! MosaicML platformunda sıfır insan müdahalesi ile 9.5 günlük bir zaman diliminde eğitildi. MosaicML Maliyeti ~200 $.

Açık kaynaklıdır, ticari kullanım için kullanılabilir hale getirir ve araç, tahmine dayalı analitik ve karar verme süreçleriyle işletmelerin ve kuruluşların nasıl çalıştığı konusunda oyunun kurallarını değiştirecektir.

MPT-7B'nin ana özellikleri şunlardır:

- Ticari kullanım için lisanslı

- Büyük miktarda veri (1T belirteçleri) üzerinde eğitildi

- Son derece uzun girişleri işleyebilir

- Hızlı eğitim ve çıkarım için optimize edilmiştir

- Son derece verimli açık kaynaklı eğitim kodu.

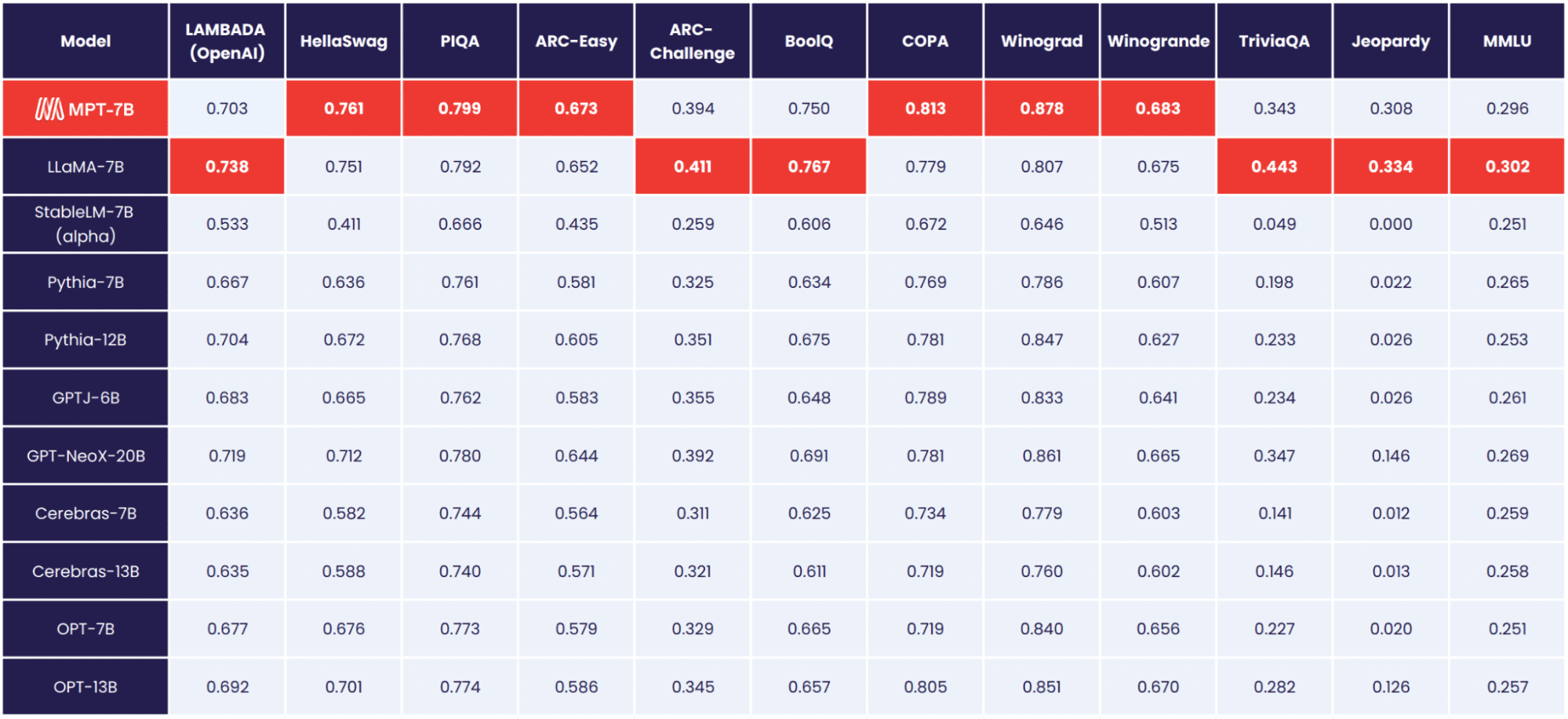

MPT-7B temel modeldir ve diğer açık kaynaklı 7B – 20B modellerinden daha iyi performans gösterdiği gösterilmiştir. MPT-7B'nin kalitesi LLaMA-7B'ye uygundur. MosaicML Foundation, MPT-7B'nin kalitesini değerlendirmek için 11 açık kaynak kıyaslaması oluşturdu ve bunları endüstri standardı bir şekilde değerlendirdi.

Image MosaicML Vakfı

MosaicML temelleri ayrıca ince ayarlı üç ek model daha yayınlıyor:

- MPT-7B-Talimat

- MPT-7B-Sohbet

- MPT-7B-Öykü Yazarı-65k+

MPT-7B-Talimat

The MPT-7B-Talimat model aşağıdaki kısa biçimli talimat içindir. 26,834 Mayıs tarihli 14 adet MPT-7B-Instruct ile hızlı ve kısa sorular sorabilir ve anında yanıt alabilirsiniz. Bir sorunuz varsa ve sadece basit bir yanıt istiyorsanız, MPT-7B-Instruct'ı kullanın.

Bu neden bu kadar harika? Tipik olarak LLM'lere, sağlanan girdiye dayalı olarak metin oluşturmaya devam etmeleri öğretilir. Bununla birlikte, bazıları girdilerini bir talimat olarak ele alan LLM'ler arıyor. Talimat ince ayarı, LLM'lerin talimat izleyen çıktılar gerçekleştirmesine izin verir.

MPT-7B-Sohbet

Evet, başka bir chatbot'umuz var. MPT-7B-Sohbet diyalog oluşturur. Örneğin, chatbot'un bir konuşma oluşturmasını istiyorsanız, ona bağlam vererek, konuşma tarzında bir metin üretecektir. Ya da belki bir makaleden bir paragrafı başka sözcüklerle ifade eden bir tweet yazmak istiyorsunuz, bu sizin için bir diyalog oluşturabilir!

Bu neden bu kadar harika? MPT-7B Chat, çeşitli konuşma görevleri için hazır ve iyi donanımlı olup, kullanıcılar için daha sorunsuz, ilgi çekici çok yönlü etkileşimler sunar.

MPT-7B-Öykü Yazarı-65k+

Bu hikaye yazarları için! Uzun bir bağlamı olan hikayeler yazmak isteyenler için, MPT-7B-Öykü Yazarı-65k+ tam da bunun için tasarlanmış bir model. Model, MPT-7B'de ince ayar yapılarak oluşturuldu. 65k token içerik uzunluğuve 65 jetonun ötesinde tahminde bulunabilir. MosaicML Foundation, tek bir A84-100GB GPU düğümünde 80 bin jeton üretebildi.

Bu neden bu kadar harika? Bunun nedeni, çoğu açık kaynaklı LLM'nin yalnızca birkaç bin belirteç içeren dizileri işleyebilmesidir. Ancak MosaicML platformunda tek bir 8xA100-80GB düğümü kullanarak, MPT-7B'de 65k'ye kadar bağlam uzunluklarını işleyecek ince ayar yapabilirsiniz!

MosaicML ekibi bu modelleri yalnızca birkaç hafta içinde oluşturdu. Yalnızca birkaç hafta içinde veri hazırlama, eğitim, ince ayar ve dağıtımla ilgilendiler.

Veriler, her kaynakta bir milyar token bulunan çeşitli kaynaklardan elde edildi. Etkili belirteçlerin sayısı hala her kaynakta bir milyar var! Kullanılan takım EleutherAI'ler, GPT-NeoX, ve 20B belirteci, çeşitli veri karışımları üzerinde eğitim almalarına, tutarlı alan sınırlaması uygulamalarına ve daha fazlasına olanak tanır.

Tüm MPT-7B modelleri, MosaicML platformu, Oracle Cloud'dan A100-40GB ve A100-80GB GPU'ları kullanarak.

MPT-7B'nin araçları ve maliyetleri hakkında daha fazla bilgi edinmek isterseniz, aşağıdakileri okuyun: MPT-7B Blogu.

MosaicML platformu, özel LLM'ler oluşturmakla ilgili özel, ticari veya toplulukla ilgili kuruluşlar için en iyi başlangıç noktası olarak kabul edilebilir. Bu açık kaynak kaynağa sahip olmak, kuruluşların mevcut kurumsal zorlukları iyileştirmek için bu araçları kullanma konusunda kendilerini daha özgür hissetmelerini sağlayacaktır.

Müşteriler, verimliliği, gizliliği ve maliyet şeffaflığını sürdürürken, herhangi bir bilgi işlem sağlayıcısı veya veri kaynağı üzerinde LLM'leri eğitebilir.

MPT-7B'yi ne için kullanacağınızı düşünüyorsunuz? Aşağıdaki yorumlarda bize bildirin

Nişa Arya KDnuggets'ta bir Veri Bilimcisi, Serbest Teknik Yazar ve Topluluk Yöneticisidir. Veri Bilimi kariyer tavsiyesi veya eğitimleri ve Veri Bilimi hakkında teoriye dayalı bilgi sağlamakla özellikle ilgileniyor. Ayrıca, Yapay Zekanın insan yaşamının uzun ömürlülüğüne fayda sağladığı/sağlayabileceği farklı yolları keşfetmek istiyor. Başkalarına rehberlik ederken teknoloji bilgisini ve yazma becerilerini genişletmeye çalışan hevesli bir öğrenci.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Adryenn Ashley ile Geleceği Basmak. Buradan Erişin.

- PREIPO® ile PRE-IPO Şirketlerinde Hisse Al ve Sat. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/2023/05/introducing-mpt7b-new-opensource-llm.html?utm_source=rss&utm_medium=rss&utm_campaign=introducing-mpt-7b-a-new-open-source-llm