Mistral AI'dan Mixtral 8x7B'yi tanıyın. Büyük verilerle baş etme konusunda son derece akıllıdır ve dilleri çevirmek ve kod oluşturmak gibi görevlerde yardımcı olabilir. Dünyanın dört bir yanındaki geliştiriciler, projelerini kolaylaştırma ve verimliliği artırma potansiyeli konusunda heyecan duyuyor. Kullanıcı dostu tasarımı ve etkileyici yetenekleriyle Mixtral 8x7B, hızla yapay zeka geliştirme için başvurulan bir araç haline geliyor.

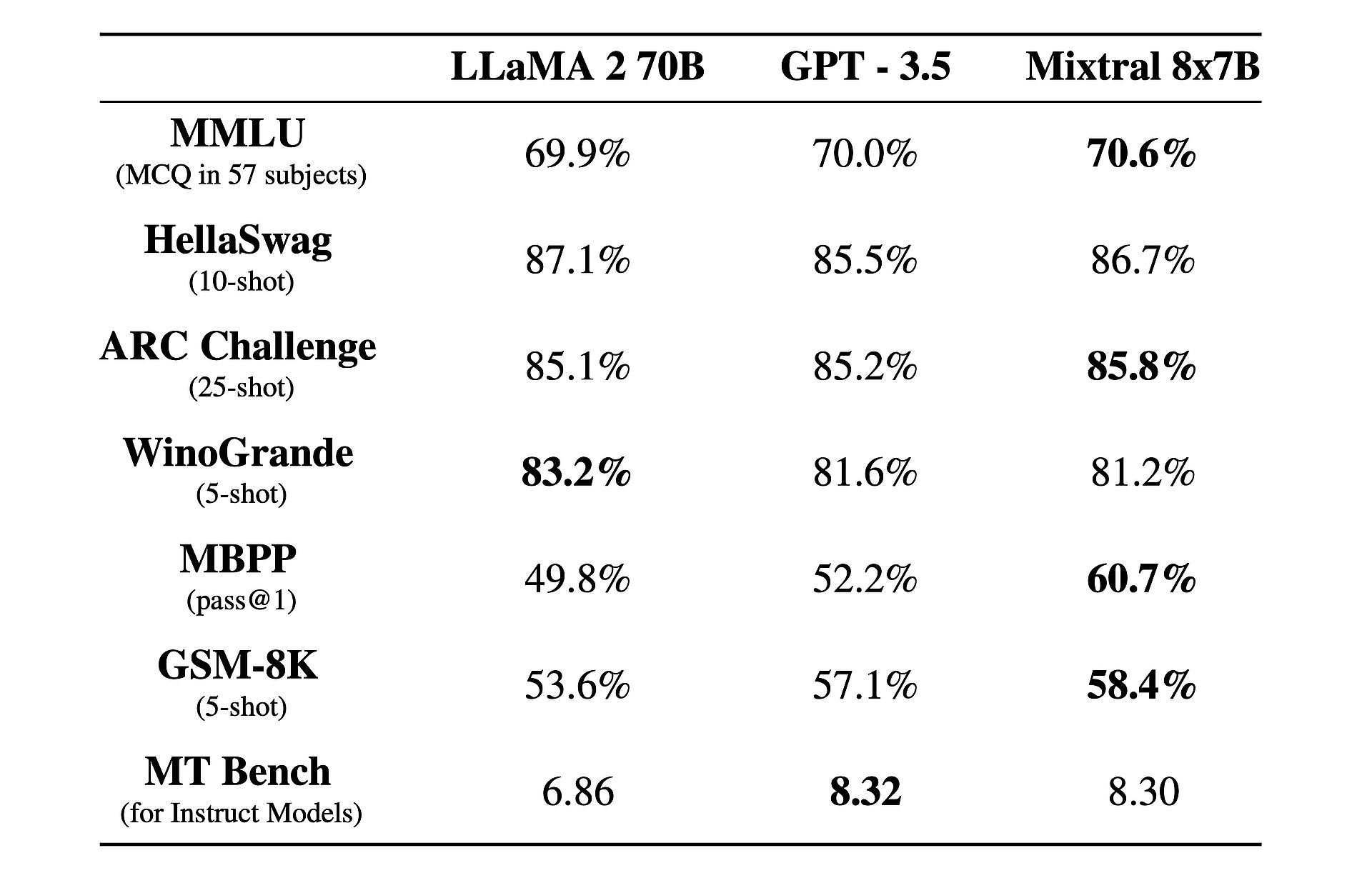

Ayrıca bununla ilgili ilginç bir gerçek var: Şundan daha iyi performans gösteriyor: GPT 3.5 ve Llama 2!

Mixtral 8x7B nedir?

Mixtral 8x7B, Mistral AI tarafından geliştirilen gelişmiş bir yapay zeka modelidir. Büyük miktarlarda veriyi verimli bir şekilde işlemek için seyrek uzman karışımı (SMoE) adı verilen benzersiz bir mimari kullanır. Karmaşıklığına rağmen Mixtral, dil çevirisi ve kod oluşturma gibi çeşitli görevlere uyarlanabilecek ve kullanımı kolay olacak şekilde tasarlanmıştır. Hız ve doğruluk açısından diğer modellerden daha iyi performans göstererek geliştiriciler için değerli bir araç haline geliyor. Ayrıca Apache 2.0 lisansı altında mevcuttur ve herkesin özgürce kullanmasına ve değiştirmesine olanak tanır.

Daha fazla bilgi edinmek ister misiniz? Özünde Mixtral 8x7B, yalnızca kod çözücüye yönelik bir model olarak çalışır ve ileri besleme bloğunun "uzmanlar" olarak adlandırılan sekiz farklı parametre grubundan seçim yaptığı benzersiz bir yaklaşımdan yararlanır. Bu uzmanlar, her bir belirteci işlemek için bir yönlendirici ağı tarafından dinamik olarak seçilir, böylece hesaplama yükü en aza indirilirken verimlilik ve performans artırılır.

Mixtral'in en önemli güçlü yönlerinden biri uyarlanabilirliği ve ölçeklenebilirliğidir. Capable, 32,000 jetona kadar bağlamları işleyebilir ve İngilizce, Fransızca, İtalyanca, Almanca ve İspanyolca dahil olmak üzere birden fazla dili destekleyebilir. Mixtral, geliştiricilerin çok çeşitli görevleri kolaylıkla ve hassas bir şekilde ele almalarına olanak tanır.

Mixtral'ı gerçekten diğerlerinden ayıran şey performans-maliyet oranıdır. Şaşırtıcı bir toplam 46.7 milyar parametreyle Mixtral, token başına bu parametrelerin yalnızca bir kısmını kullanarak olağanüstü bir verimlilik elde ediyor, bu da daha hızlı çıkarım süreleri ve daha düşük hesaplama masrafları sağlıyor.

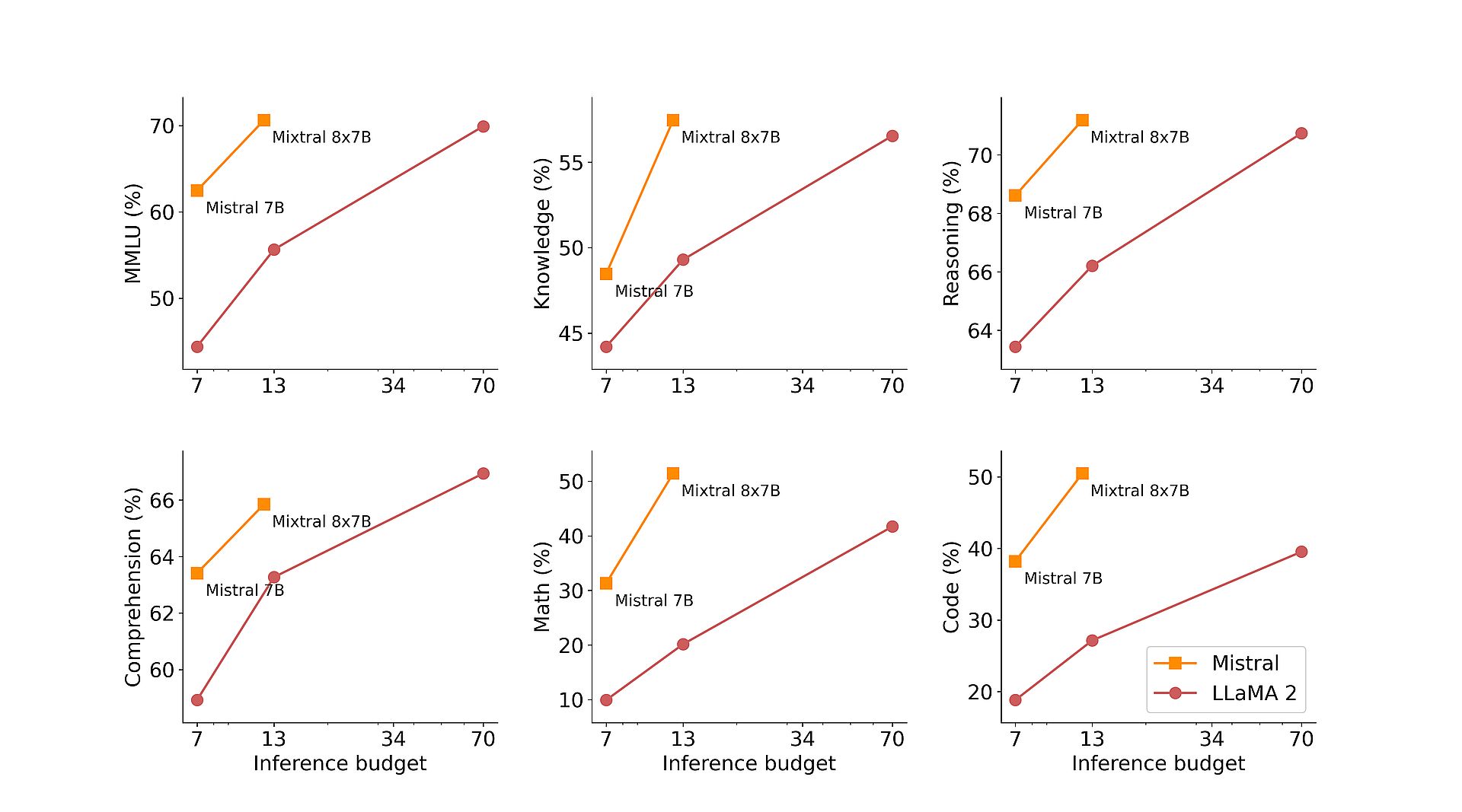

Üstelik Mixtral'in açık webden çıkarılan kapsamlı veri kümeleri üzerindeki ön eğitimi, gerçek dünya uygulamalarında sağlamlık ve çok yönlülük sağlar. İster kod oluşturma, ister dil çevirisi veya duyarlılık analizi olsun, Mixtral çeşitli karşılaştırmalarda olağanüstü sonuçlar sunarak Llama 2 gibi geleneksel modelleri geride bırakıyor ve hatta birçok durumda GPT3.5'ten daha iyi performans gösteriyor.

Mistral AI, yeteneklerini daha da geliştirmek amacıyla, talimat takip eden görevler için optimize edilmiş özel bir varyant olan Mixtral 8x7B Instruct'ı piyasaya sürdü. MT-Bench'te 8.30 gibi etkileyici bir puana ulaşan Mixtral 8x7B Instruct, denetimli ince ayar ve tercih optimizasyonu için lider açık kaynaklı model olarak konumunu sağlamlaştırıyor.

Mistral AI, teknik becerisine ek olarak vLLM projesine katkıda bulunarak Mixtral'e erişimi demokratikleştirmeye ve açık kaynaklı araçlarla sorunsuz entegrasyon ve dağıtıma olanak sağlamaya kararlıdır. Bu, geliştiricilere Mixtral'in gücünden geniş bir uygulama ve platform yelpazesinde yararlanma olanağı vererek yapay zeka alanında inovasyonu ve ilerlemeyi teşvik ediyor.

Groq AIGrok değil, Elon Musk'u "en hızlı LLM" ile kızdırıyor

Mixtral 8x7B nasıl kullanılır?

Mixtral 8x7B'ye Mistral'in mistral-small uç noktası üzerinden erişilebilir. beta test aşamasıe. Mistral'in tüm üretken ve yerleşik uç noktalarına erken erişim kazanmakla ilgileniyorsanız, kayıt olmak Şimdi. Kaydolarak Mixtral 8x7B'nin tüm özelliklerini deneyimleyen ve yenilikçi çözümlerini keşfeden ilk kişiler arasında olacaksınız.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/