Giriş

Son yıllarda yapay zeka (AI) alanı, üretken yapay zeka modellerinin geliştirilmesinde dikkate değer bir artışa tanık oldu. Bu modeller şunları yapabilir: insan benzeri metinler oluştur, görüntüler ve hatta ses, bir zamanlar imkansız olduğu düşünülen şeylerin sınırlarını zorluyor. Bu modeller arasında Üretken Ön Eğitimli Transformatör (GPT), doğal dil işlemede (NLP) öncü bir atılım olarak öne çıkıyor. GPT'lerin karmaşık mimarisini keşfedelim ve üretken yapay zeka ve NLP görevlerini nasıl kolaylıkla yerine getirdiklerini öğrenelim.

İçindekiler

Üretken Yapay Zeka Modellerinin Yükselişi

Üretken yapay zeka modelleri bir sınıftır makine öğrenme sıfırdan metin, resim veya ses gibi yeni veriler oluşturabilen modeller. Bu modeller, mevcut büyük miktardaki veriler üzerinde eğitilir ve temel kalıpları ve yapıları öğrenmelerine olanak tanır. Eğitildikten sonra, eğitim verilerinin özelliklerini taklit eden yeni, orijinal içerik üretebilirler.

Üretken yapay zeka modellerinin yükselişi, özellikle sinir ağlarında olmak üzere derin öğrenme tekniklerindeki ilerlemelerden kaynaklandı. Derin öğrenme Algoritmaların verilerdeki karmaşık kalıpları yakalamada son derece etkili olduğu kanıtlanmıştır ve bu da onları üretken görevler için çok uygun hale getirir. Hesaplama gücü ve büyük veri kümelerine erişim arttıkça, araştırmacılar giderek daha karmaşık hale gelen üretken modelleri eğitebilir hale geldi.

GPT'nin Gizemleri

GPT modelleri, GPT modellerinin gücünden yararlanan bir tür büyük dil modelidir (LLM). nöral ağlar insan benzeri metinleri anlamak ve oluşturmak için. Bu modeller "üretkendir" çünkü devasa veri kümelerinden öğrenilen kalıplara dayalı yeni, tutarlı metinler üretebilirler. Çok miktarda metin verisi üzerinde bir başlangıç eğitim aşamasından geçtikleri için "ön eğitimlidirler". Bu, belirli görevler için ince ayar yapılmadan önce geniş bir bilgi tabanı edinmelerine olanak tanır.

"Transformatör" mimarisi, GPT modellerini benzeri görülmemiş performans seviyelerine taşıyan temel yeniliktir. Transformers metin gibi sıralı verileri geleneksel modellere göre daha etkili bir şekilde işlemek için tasarlanmış bir tür sinir ağıdır. Modelin, çıktı üretirken girdinin farklı bölümlerinin önemini tartmasına olanak tanıyan yeni bir dikkat mekanizması kullanırlar. Bu, uzun vadeli bağımlılıkları yakalamasına ve daha tutarlı ve bağlamsal olarak daha uygun metinler üretmesine olanak tanır.

GPT Mimarisinin İncelenmesi

GPT mimarisi üç temel bileşenin güçlü bir birleşimidir: üretken yetenekleri, eğitim öncesi yaklaşımı ve dönüştürücü sinir ağı. Bu sütunların her biri, GPT modellerinin NLP görevlerinde olağanüstü performansa ulaşmasını sağlamada çok önemli bir rol oynar.

Üç Sütun: Üretken, Önceden Eğitimli ve Dönüştürücü

GPT modellerinin "üretken" yönü, büyük miktardaki eğitim verilerinden öğrendikleri kalıplara dayalı olarak yeni, tutarlı metinler oluşturma yeteneklerini ifade eder. Geleneksel dil modelleri öncelikle metni anlamaya ve analiz etmeye odaklanır. Bunlardan farklı olarak GPT modelleri, insan benzeri metin çıktıları üretecek şekilde tasarlanmıştır ve bu da onları çeşitli uygulamalar için oldukça çok yönlü hale getirir.

GPT modellerinin "önceden eğitilmiş" bileşeni, modelin büyük miktarda metin verisine maruz bırakıldığı bir başlangıç eğitim aşamasını içerir. Bu eğitim öncesi aşamada model, verilerdeki temel kalıpları, yapıları ve ilişkileri yakalamayı öğrenir. Bu, etkili bir şekilde geniş bir bilgi tabanı oluşturmasına yardımcı olur. Ön eğitim aşaması, modelin ince ayar yapılmadan önce genel bir dil anlayışı kazanmasına olanak tanıdığı için çok önemlidir.

“Transformatör” mimarisi GPT modellerinin sinir ağı omurgasıdır. Transformatörler, metin gibi sıralı verileri geleneksel modellerden daha etkili bir şekilde işlemek için özel olarak tasarlanmış derin öğrenme modelleridir. Modelin, çıktı üretirken girdinin farklı bölümlerinin önemini tartmasına olanak tanıyan yeni bir dikkat mekanizması kullanırlar. Bu, uzun vadeli bağımlılıkları yakalamasına ve daha tutarlı ve bağlamsal olarak daha uygun metinler üretmesine olanak tanır.

GPT'ler Nasıl Tutarlı Cümleler Üretir?

GPT modelleri, önceki sözcüklerin veya simgelerin sağladığı bağlama dayalı olarak sonraki sözcüğü veya simgeyi sırayla tahmin ederek metin üretir. Bu süreç, transformatör mimarisi içindeki bir dizi hesaplama yoluyla gerçekleştirilir. Giriş metninin simgeleştirilmesi ve sayısal temsillere (gömmeler) dönüştürülmesiyle başlar. Bu gömmeler daha sonra transformatörün birden fazla katmanından geçer. Burada dikkat mekanizması, modelin girdinin farklı bölümleri arasındaki ilişkileri yakalamasına ve bağlamsal olarak uygun çıktı üretmesine olanak tanır.

Modelin çıktısı bir olasılık dağılımı tüm kelime dağarcığı üzerinde, her kelimenin veya belirtecin dizideki bir sonraki olma olasılığını gösterir. Çıkarım sırasında model, giriş dizisine eklenen bir sonraki jetonu oluşturmak için bu dağıtımdan örnekler alır. Bu işlem, istenen çıkış uzunluğuna ulaşılana veya bir durma koşulu karşılanana kadar tekrarlanır.

Daha İyi Performans İçin Devasa Veri Kümelerinden Yararlanma

GPT modellerinin en önemli avantajlarından biri, eğitim öncesi aşamada çok büyük veri kümelerinden yararlanabilme yetenekleridir. Bu veri kümeleri kitap, makale, web sitesi ve sosyal medya gibi çeşitli kaynaklardan elde edilen milyarlarca kelimeden oluşabilir. Bu, modele doğal dilin çeşitli ve kapsamlı bir şekilde sunulmasını sağlar.

Ön eğitim sırasında modelin, metin oluşturma sürecine benzer şekilde dizideki bir sonraki kelimeyi veya simgeyi tahmin etmesi gerekir. Ancak model, yeni metin oluşturmak yerine eğitim verilerinin altında yatan kalıpları ve ilişkileri yakalamayı öğrenir. Bu ön eğitim aşaması hesaplama açısından yoğundur ancak çok önemlidir. Modelin, daha sonra belirli görevler için ince ayar yapılabilecek geniş bir dil anlayışı geliştirmesine olanak tanır.

GPT modelleri, ön eğitim sırasında çok büyük veri kümelerinden yararlanarak geniş bir bilgi tabanı elde edebilir. Ayrıca dil yapılarına, deyimsel ifadelere ve bağlamsal nüanslara ilişkin derinlemesine bir anlayış geliştirebilirler. Bu kapsamlı ön eğitim, model için güçlü bir temel sağlar. Modelin, nispeten az göreve özel ince ayar ile geniş bir yelpazedeki aşağı yönlü görevlerde iyi performans göstermesini sağlar.

Sihrin Arkasındaki Sinir Ağı

Transformatör mimarisi, GPT modellerine güç veren ve NLP alanında devrim yaratan temel yeniliktir. Gelenekselden farklı olarak tekrarlayan sinir ağları Sıralı verileri sırayla işleyen (RNN'ler), transformatörler, uzun vadeli bağımlılıkları yakalamalarına ve girdi dizilerini paralel olarak verimli bir şekilde işlemelerine olanak tanıyan yeni bir dikkat mekanizması kullanır.

Transformatör mimarisi, her biri iki ana bileşenden oluşan çok sayıda katmandan oluşur: çok kafalı dikkat mekanizması ve ileri beslemeli sinir ağı. Dikkat mekanizması, çıktı üretirken girdi dizisinin farklı bölümlerinin öneminin ağırlıklandırılmasından sorumludur ve modelin dizideki uzak öğeler arasındaki bağlamı ve ilişkileri yakalamasını sağlar.

İleri beslemeli sinir ağı katmanları, dikkat mekanizmasının çıktısının daha fazla işlenmesinden ve iyileştirilmesinden sorumludur ve modelin girdi verilerinin daha karmaşık temsillerini öğrenmesine olanak tanır.

Transformatör mimarisinin paralelleştirilmiş işleme ve dikkat mekanizmasının, NLP görevleri için çok önemli olan uzun dizileri yönetmede ve uzun menzilli bağımlılıkları yakalamada oldukça etkili olduğu kanıtlanmıştır. Bu mimari, GPT modellerinin en gelişmiş performansa ulaşmasını sağlamıştır. Ayrıca bilgisayarlı görme ve konuşma tanıma gibi çeşitli alanlardaki diğer transformatör tabanlı modellerin gelişimini de etkilemiştir.

Transformatörün İçinde

Transformatör mimarisi, GPT modellerinin NLP görevlerinde olağanüstü performansa ulaşmasını sağlayan temel bileşendir. Transformatörün metin verilerini işlemesinde yer alan önemli adımlara daha yakından bakalım.

Tokenizasyon: Metni Sindirilebilir Parçalara Ayırmak

Transformatörün metni işleyebilmesi için önce giriş verilerinin jeton adı verilen daha küçük birimlere bölünmesi gerekir. dizgeciklere metni kelimeler, alt kelimeler ve hatta tek tek karakterler olabilen bu belirteçlere bölme işlemidir. Bu adım çok önemlidir çünkü dönüştürücünün değişen uzunluklardaki dizileri işlemesine ve nadir veya sözlük dışı kelimeleri etkili bir şekilde temsil etmesine olanak tanır. Belirteçleştirme süreci tipik olarak sözcük bölümlendirme, noktalama işaretlerini yönetme ve özel karakterlerle ilgilenme gibi teknikleri içerir.

Kelime Gömmeleri: Kelimeleri Sayısal Vektörlerle Eşleştirme

Metin simgeleştirildiğinde, her simge, kelime yerleştirme adı verilen sayısal bir vektör temsiliyle eşlenir. Bu sözcük yerleştirmeleri, temsil ettikleri sözcüklerle ilgili anlamsal ve sözdizimsel bilgileri yakalayan yoğun vektörlerdir. Transformatör bu yerleştirmeleri girdi olarak kullanarak metin verilerini sinir ağı mimarisi tarafından verimli bir şekilde yönetilebilecek sayısal formatta işlemesine olanak tanır. Kelime yerleştirmeler, benzer anlamlara sahip kelimelerin benzer vektör temsillerine sahip olma eğiliminde olduğu eğitim süreci sırasında öğrenilir ve modelin anlamsal ilişkileri ve bağlamı yakalamasını sağlar.

Dikkat Mekanizması: Transformatörün Kalbi

Dikkat mekanizması, transformatörleri geleneksel sinir ağı mimarilerinden ayıran temel yeniliktir. Modelin, çıktı üretirken girdi dizisinin ilgili bölümlerine seçici olarak odaklanmasına, uzun vadeli bağımlılıkları ve bağlamı etkili bir şekilde yakalamasına olanak tanır. dikkat mekanizması Belirli bir çıktı öğesi için her bir girdi öğesinin önemini temsil eden dikkat puanlarını hesaplayarak ve ardından bu puanları karşılık gelen girdi temsillerini ağırlıklandırmak için kullanarak çalışır. Bu mekanizma, transformatörün değişen uzunluklardaki dizileri etkili bir şekilde işlemesine ve makine çevirisi ve dil üretimi gibi görevler için çok önemli olan girdideki uzak öğeler arasındaki ilişkileri yakalamasına olanak tanır.

Çok Katmanlı Algılayıcılar: Vektör Gösterimlerini Geliştirme

Transformatörler dikkat mekanizmasının yanı sıra aynı zamanda çok katmanlı algılayıcılar (MLP'ler) ileri beslemeli sinir ağlarıdır. Bu MLP'ler, dikkat mekanizması tarafından üretilen vektör temsillerini daha fazla işlemek ve iyileştirmek için kullanılır ve modelin verilerdeki daha karmaşık kalıpları ve ilişkileri yakalamasına olanak tanır. MLP'ler, dikkat mekanizmasının çıktısını girdi olarak alır ve vektör temsillerini geliştirmek için bir dizi doğrusal dönüşüm ve doğrusal olmayan aktivasyon fonksiyonu uygular. Bu adım, modelin alt görev için yararlı olan üst düzey özellikleri ve temsilleri öğrenmesi açısından çok önemlidir.

GPT Modeli Eğitimi

Bir GPT modelinin eğitimi, çeşitli temel bileşenleri ve teknikleri içeren karmaşık ve hesaplama açısından yoğun bir süreçtir.

Geriye Yayılım: GPT'leri Daha Akıllı Hale Getiren Algoritma

GPT modellerinin eğitiminin temelinde, eğitim sırasında yaptığı hatalara göre modelin ağırlıklarını ve parametrelerini güncellemek için derin öğrenmede yaygın olarak kullanılan bir teknik olan geri yayılım algoritması bulunur. Sırasında geri yayılım, modelin tahminleri temel doğruluk etiketleriyle karşılaştırılır ve ağırlıkları ayarlamak ve genel hatayı en aza indirmek için hatalar ağ üzerinden geriye doğru yayılır. Bu süreç, modelin parametrelerine göre kayıp fonksiyonunun gradyanlarının hesaplanmasını ve parametrelerin kaybı en aza indirecek yönde güncellenmesini içerir. Geri yayılım, modelin hatalarından ders almasına ve performansını kademeli olarak geliştirmesine olanak tanıdığı için eğitim sürecinin önemli bir bileşenidir.

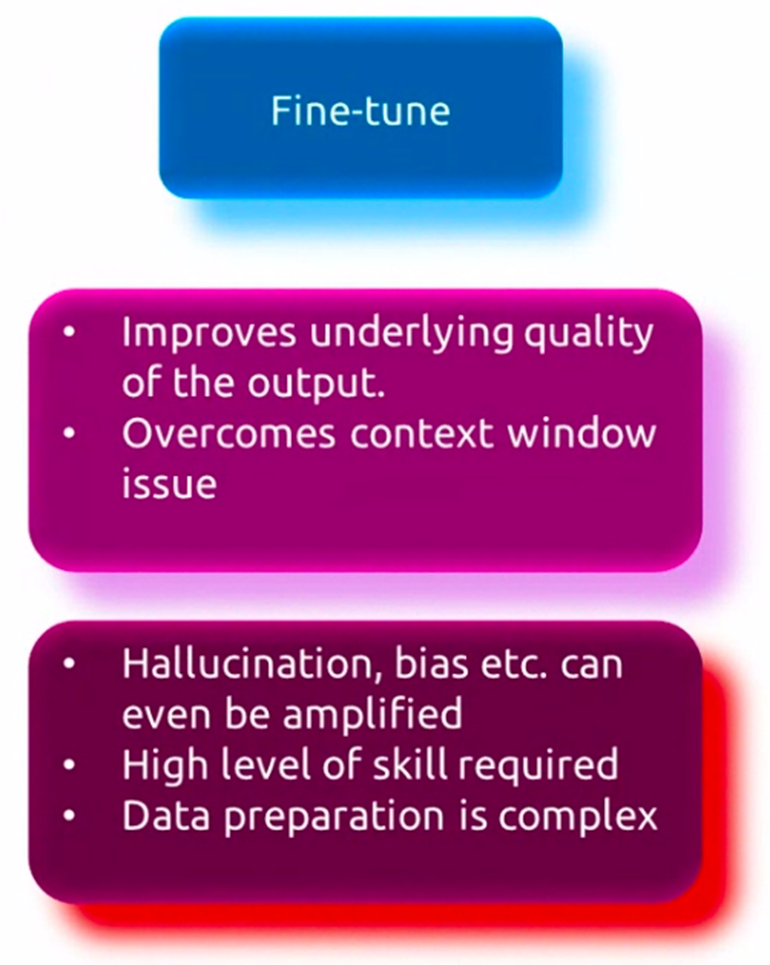

Denetimli İnce Ayar

GPT modelleri, geniş bir dil anlayışı elde etmek için çok büyük veri kümeleri üzerinde önceden eğitilmiş olsa da, belirli uygulamalarda iyi performans gösterebilmeleri için genellikle göreve özgü veriler üzerinde ince ayar yapılması gerekir. Denetimli ince ayar olarak bilinen bu süreç, önceden eğitilmiş modelin, soru yanıtlama, metin özetleme veya makine çevirisi gibi hedef görevle ilgili daha küçük bir veri kümesi üzerinde daha fazla eğitilmesini içerir. Sırasında ince ayar, modelin ağırlıkları, bir yandan ön eğitim sırasında edinilen genel dil bilgisini korurken, bir yandan da eldeki göreve özgü kalıpları ve nüansları daha iyi yakalayacak şekilde ayarlanır. Bu ince ayar süreci, modelin uzmanlaşmasına ve hedef görevin özel gereksinimlerine uyum sağlamasına olanak tanıyarak performansın artmasına neden olur.

Denetimsiz Ön Eğitim

GPT modelleri, ince ayar yapmadan önce, denetimsiz bir ön eğitim aşamasından geçer; burada kitaplar, makaleler ve web siteleri gibi çeşitli kaynaklardan gelen büyük miktarda metin verisine maruz kalırlar. Bu aşamada model, dil modelleme olarak bilinen bir süreçle, bir dizideki bir sonraki kelimeyi veya belirteci tahmin ederek verilerdeki temel kalıpları ve ilişkileri yakalamayı öğrenir. Bu denetimsiz ön eğitim, modelin sözdizimi, anlambilim ve bağlam dahil olmak üzere geniş bir dil anlayışı geliştirmesine olanak tanır. Model, çok çeşitli konulardan, tarzlardan ve alanlardan öğrenmesine olanak tanıyan devasa bir metin verisi külliyatı üzerinde eğitilmiştir. Bu denetimsiz ön eğitim aşaması, hesaplama açısından yoğun ancak çok önemlidir çünkü modele, belirli görevlerde daha sonra ince ayar yapılması için güçlü bir temel sağlar.

GPT Uygulamaları ve Kullanım Örnekleri

GPT modelleri olağanüstü çok yönlülük göstermiştir ve çok çeşitli NLP görev ve uygulamalarına uygulanmıştır. Bu güçlü dil modellerinin temel kullanım örneklerinden bazılarını inceleyelim.

Dil Engellerini Aşmak

GPT modellerinin en eski ve en öne çıkan uygulamalarından biri makine çevirisi alanındadır. GPT modelleri, insan benzeri metinleri anlama ve üretme yeteneklerinden yararlanılarak, farklı diller arasında yüksek doğruluk ve akıcılıkla çeviri yapmak üzere eğitilebilir. Bu modeller dilin nüanslarını ve karmaşıklıklarını yakalayarak yalnızca doğru olan değil aynı zamanda orijinal metnin amaçlanan anlamını ve bağlamını koruyan çeviriler üretmelerine olanak tanır.

Metin Özetleme

Mevcut metinsel veri miktarının giderek artmasıyla birlikte, özetlemek Uzun belgeleri veya makaleleri kısa ve anlamlı özetlere dönüştürmek giderek daha önemli hale geldi. Belirli bir metnin bağlamını ve önemli noktalarını analiz edip anlayabildikleri ve ardından orijinal içeriğin özünü yakalayan yoğunlaştırılmış bir özet oluşturabildikleri için GPT modellerinin bu görevde etkili olduğu kanıtlanmıştır. Bu uygulamanın, haber makalelerini ve araştırma makalelerini özetlemekten kısa raporlar ve yönetici özetleri oluşturmaya kadar çok sayıda kullanım durumu vardır.

Sohbet Robotları ve Konuşmaya Dayalı Yapay Zeka

GPT modellerinin en görünür ve yaygın olarak benimsenen uygulamalarından biri, sohbet robotlarının ve konuşma yapay zekası sistemler. Bu modeller, insan benzeri diyalog kurarak kullanıcı sorgularını ve girdilerini doğal ve bağlamsal olarak uygun bir şekilde anlayıp yanıtlayabilir. GPT destekli sohbet robotları, kullanıcılara kişiselleştirilmiş ve etkili yardım sağlamak için müşteri hizmetleri, e-ticaret ve sağlık hizmetleri gibi çeşitli sektörlerde kullanılıyor.

GPT'lerin Hayal Gücü Potansiyeli

GPT modelleri başlangıçta dil anlama ve oluşturma görevleri için tasarlanmış olsa da, tutarlı ve yaratıcı metinler üretme yetenekleri, yaratıcı yazma alanında yeni olanakların kapısını açmıştır. Bu modeller hikayeler, şiirler, senaryolar ve hatta şarkı sözleri oluşturmak için ince ayar yapılabilir ve yazarların ve sanatçıların yeni yaratıcı yolları keşfetmeleri için güçlü bir araç sunar. Ek olarak, GPT modelleri olay örgüsü geliştirmeleri ve karakter açıklamaları önererek ve hatta yönlendirmelere veya ana hatlara dayalı olarak tüm pasajları oluşturarak yazma sürecine yardımcı olabilir.

GPT'lerin ve Üretken Yapay Zekanın Geleceği

GPT modelleri her ne kadar umut verici olsa da hâlâ aşılması gereken sınırlamalar ve zorlukların yanı sıra ele alınması gereken etik konular da mevcut. Ek olarak, üretken yapay zeka alanı, yeni trendler ve son teknoloji araştırmaların bu modellerin geleceğini şekillendirmesiyle hızla gelişiyor.

Mevcut GPT Modellerinin Sınırlamaları ve Zorlukları

Etkileyici yeteneklerine rağmen mevcut GPT modellerinin bazı sınırlamaları vardır. Temel zorluklardan biri, ürettikleri metnin altında yatan anlamı ve bağlamı gerçekten anlayamamalarıdır. Tutarlı ve akıcı metinler üretebilseler de, özellikle karmaşık veya özel konularla uğraşırken bazen anlamsız veya aslında yanlış bilgiler üretebilirler. Ek olarak, bu modeller eğitim verilerinde mevcut önyargıları sergileyerek adalet ve potansiyel olarak zararlı çıktılarla ilgili endişeleri artırabilir.

Etik Hususlar ve Sorumlu Yapay Zeka Geliştirme

GPT modelleri daha güçlü ve yaygın hale geldikçe, etik hususların ele alınması ve bu teknolojilerin sorumlu bir şekilde geliştirilmesi ve yaygınlaştırılmasının sağlanması hayati önem taşımaktadır. Gizlilik, güvenlik ve kötüye kullanım veya kötü amaçlı uygulama potansiyeli gibi konular dikkatle incelenmelidir. Araştırmacılar ve geliştiriciler, potansiyel riskleri azaltmak ve GPT modellerinin güvenli ve faydalı kullanımını sağlamak için etik kurallar, yönetişim çerçeveleri ve sağlam güvenlik önlemleri geliştirmeye yönelik çalışmalıdır.

Yükselen Trendler ve Son Teknoloji Araştırmalar

Üretken yapay zeka alanı, araştırmacıların yeni mimarileri, eğitim yöntemlerini ve uygulamaları keşfetmesiyle hızla gelişiyor. Ortaya çıkan trendlerden biri de çok modlu modeller Farklı yöntemlerde (metin, resim, ses vb.) veri işleyebilen ve üretebilen. Dil üretimine yönelik pekiştirmeli öğrenme yaklaşımları bir diğeridir. GPT modellerinin diğer yapay zeka teknolojileriyle entegrasyonu (ör. Bilgisayar görüşü ve robotik bu da başka bir trend. Ayrıca bu modellerin yorumlanabilirliğini, kontrol edilebilirliğini ve sağlamlığını geliştirmeye yönelik araştırmalar yürütülmektedir. Araştırmacılar ayrıca bilimsel keşif, eğitim ve sağlık gibi alanlardaki potansiyellerini de araştırıyorlar.

Sonuç

GPT modelleri NLP alanında devrim yarattı. Dil çevirisi, metin özetleme, konuşmaya dayalı yapay zeka ve yaratıcı yazma gibi görevlerde dikkate değer yetenekler sergilediler. Bu modellerin temelinde transformatör mimarisi bulunmaktadır. Bu, metin verilerindeki uzun vadeli bağımlılıkları ve bağlamı yakalamak için yeni bir dikkat mekanizması kullanır. GPT modellerinin eğitimi, büyük veri kümeleri üzerinde denetimsiz ön eğitimden oluşan karmaşık bir süreci ve ardından belirli görevler için denetimli ince ayarları içerir.

GPT modelleri etkileyici sonuçlar elde etse de hâlâ aşılması gereken sınırlamalar ve zorluklar var. Bu, gerçek anlayış eksikliğini, potansiyel önyargıları ve etik kaygıları içerir. Ayrıca üretken yapay zeka alanı, araştırmacıların bu modellerin sınırlarını zorlamak için yeni mimariler, uygulamalar ve teknikler keşfetmesiyle hızla gelişiyor.

GPT modelleri gelişmeye devam ettikçe etik hususların ele alınması ve sorumlu yapay zeka uygulamalarının geliştirilmesi büyük önem taşımaktadır. Bu güçlü modellerin tüm potansiyelinden yararlanmak için yeni ortaya çıkan trendleri ve en son araştırmaları keşfetmek de önemlidir. Bu arada potansiyel riskleri azaltarak güvenli ve faydalı kullanımlarını sağlamalıyız.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.analyticsvidhya.com/blog/2024/04/what-is-gpt-you-wont-believe-whats-inside/