Yazara göre resim

Birçoğumuz için Yüksek Lisans'ın olanaklarını keşfetmek ulaşılamaz gibi geldi. Karmaşık yazılımlar indirmek, kodlamayı çözmek veya güçlü makinelere ihtiyaç duymak olsun, Yüksek Lisans'a başlamak göz korkutucu görünebilir. Ancak bu güçlü dil modelleriyle, bilgisayarımızdaki herhangi bir programı başlatmak kadar kolay bir şekilde etkileşime girebildiğimizi hayal edin. Kurulum yok, kodlama yok, sadece tıklayın ve konuşun. Bu erişilebilirlik hem geliştiriciler hem de son kullanıcılar için çok önemlidir. llamaFile, yeni bir çözüm olarak ortaya çıkıyor ve lama.cpp ile Kozmopolit Kitap tek bir çerçeveye sığdırın. Bu çerçeve, yüksek lisans eğitimlerinin karmaşıklığını, “lama dosyası” adı verilen tek dosyalı yürütülebilir dosyaYerel makinelerde kurulum gerektirmeden çalışır.

Peki nasıl çalışıyor? lamaDosya teklifleri iki kullanışlı yöntem Yüksek Lisans'ı çalıştırmak için:

- İlk yöntem, Hugging Face'ten ilgili model ağırlıklarıyla birlikte lama dosyasının en son sürümünün indirilmesini içerir. Bu dosyalara sahip olduğunuzda, hazırsınız!

- İkinci yöntem daha da basittir; önceden var olan örnek lama dosyaları yerleşik ağırlıkları olan.

Bu derste, lama dosyasıyla çalışacaksınız. LLaVa modeli ikinci yöntemi kullanarak. Bu, sohbet yoluyla etkileşimde bulunabileceğiniz, resim yükleyebileceğiniz ve sorular sorabileceğiniz, 7 bit olarak nicelenmiş 4 Milyar Parametreli bir modeldir. Diğer modellerin örnek lama dosyaları da mevcuttur, ancak Windows'un maksimum çalıştırılabilir dosya boyutu 3.97 GB iken Llamafile boyutu 4 GB olduğundan LLaVa modeliyle çalışacağız. İşlem yeterince basittir ve aşağıda belirtilen adımları izleyerek LLM'leri çalıştırabilirsiniz.

Öncelikle, sağlanan kaynaktan llava-v1.5-7b-q4.llamafile (3.97 GB) yürütülebilir dosyasını indirmeniz gerekir. okuyun.

Bilgisayarınızın terminalini açın ve dosyanın bulunduğu dizine gidin. Daha sonra bilgisayarınıza bu dosyayı çalıştırma izni vermek için aşağıdaki komutu çalıştırın.

chmod +x llava-v1.5-7b-q4.llamafileWindows kullanıyorsanız, lama dosyasının adının sonuna “.exe” ekleyin. Bunun için terminalde aşağıdaki komutu çalıştırabilirsiniz.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeLama dosyasını aşağıdaki komutla yürütün.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ MacOS varsayılan kabuk olarak zsh kullandığından ve karşılaşırsanız zsh: exec format error: ./llava-v1.5-7b-q4.llamafile hata o zaman bunu yürütmeniz gerekir:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Windows için komutunuz şöyle görünebilir:

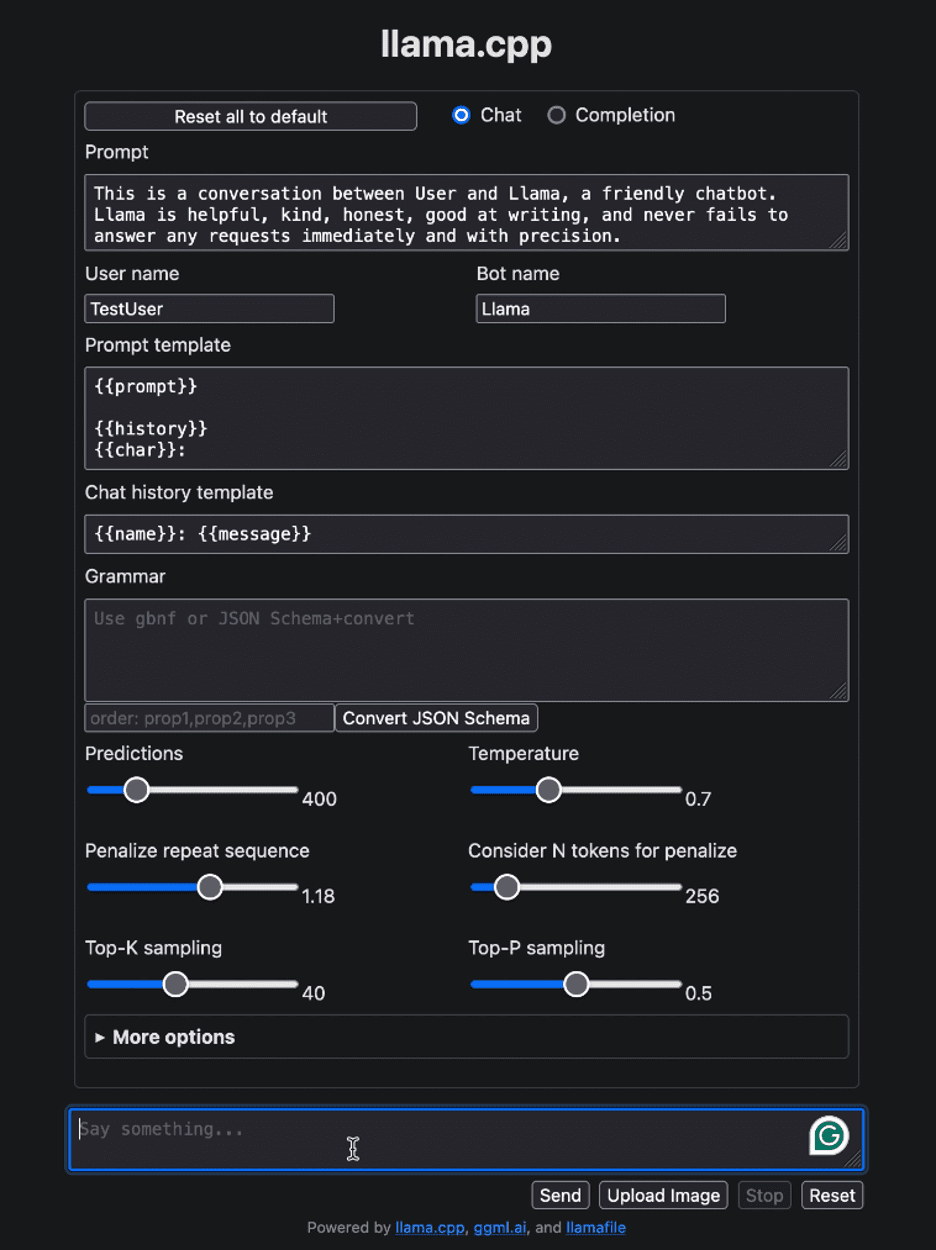

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Llamafile'ı çalıştırdıktan sonra, varsayılan tarayıcınızı otomatik olarak açmalı ve aşağıda gösterildiği gibi kullanıcı arayüzünü görüntülemelidir. Değilse, tarayıcıyı açın ve şuraya gidin: http://localhost:8080 manuel.

Yazara göre resim

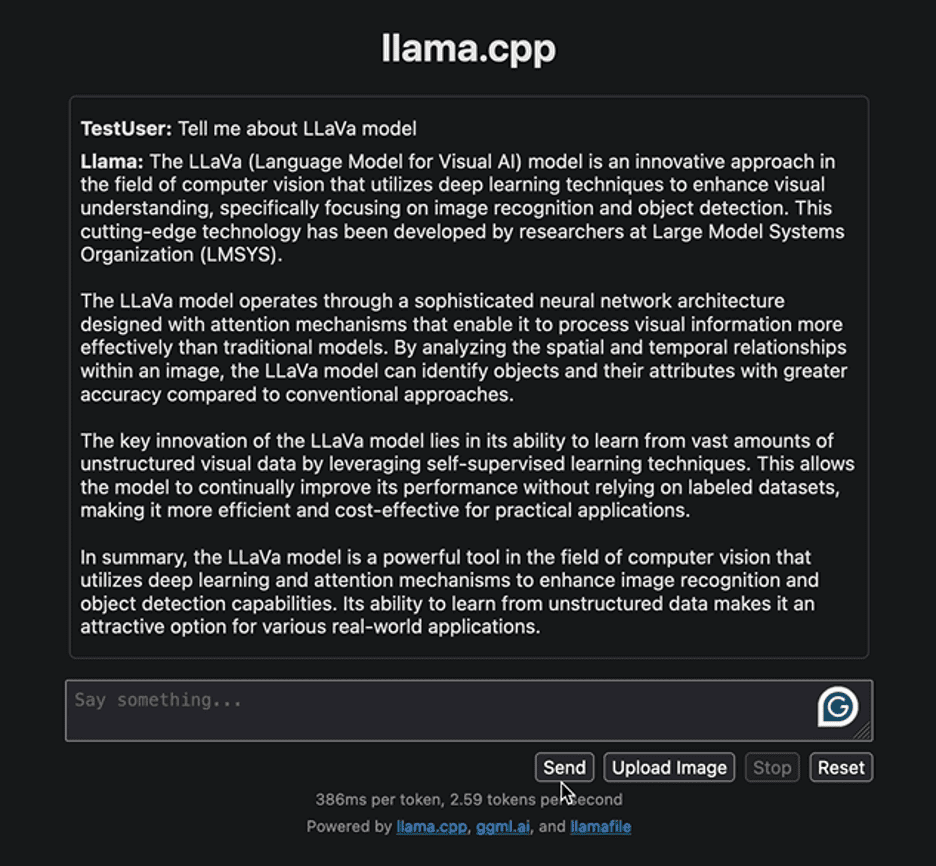

LLaVa modeliyle ilgili bazı bilgiler vermek için basit bir soruyla arayüzle etkileşim kurarak başlayalım. Aşağıda model tarafından oluşturulan yanıt verilmiştir:

Yazara göre resim

Yanıt, LLaVa modelini ve uygulamalarını geliştirme yaklaşımını vurguluyor. Oluşturulan yanıt oldukça hızlıydı. Başka bir görevi uygulamaya çalışalım. Bir banka kartının aşağıdaki örnek görselini detaylarıyla birlikte yükleyeceğiz ve gerekli bilgileri buradan çıkaracağız.

Image Yakut Thompson

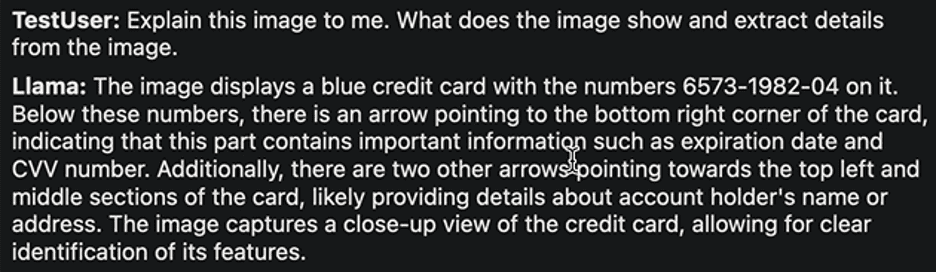

İşte yanıt:

Yazara göre resim

Cevap yine oldukça makul. LLaVa'nın yazarları, çeşitli görevlerde en üst düzey performansa ulaştığını iddia ediyor. Çeşitli görevleri keşfetmekten, başarılarını ve sınırlamalarını gözlemlemekten ve LLaVa'nın olağanüstü performansını kendiniz deneyimlemekten çekinmeyin.

LLM ile etkileşiminiz tamamlandıktan sonra terminale dönüp “Kontrol – C” tuşuna basarak lama dosyasını kapatabilirsiniz.

LLM'leri dağıtmak ve çalıştırmak hiç bu kadar kolay olmamıştı. Bu eğitimde, tek bir yürütülebilir lama dosyasıyla farklı modelleri ne kadar kolay çalıştırabileceğinizi ve deneyebileceğinizi anlattık. Bu yalnızca zamandan ve kaynaklardan tasarruf sağlamakla kalmaz, aynı zamanda yüksek lisans eğitimlerinin erişilebilirliğini ve gerçek dünyadaki faydasını da artırır. Bu öğreticiyi faydalı bulduğunuzu umarız ve bu konudaki düşüncelerinizi duymak isteriz. Ayrıca herhangi bir sorunuz veya geri bildiriminiz varsa lütfen bizimle iletişime geçmekten çekinmeyin. Her zaman yardımcı olmaktan ve girdilerinize değer vermekten mutluluk duyarız.

Okuduğunuz için teşekkürler!

Kanval Mehreen Kanwal, veri bilimi ve yapay zekanın tıpla kesişimi konusunda derin bir tutkuya sahip bir makine öğrenimi mühendisi ve teknik yazardır. “ChatGPT ile Üretkenliği En Üst Düzeye Çıkarma” adlı e-kitabın ortak yazarıdır. APAC için Google Generation Scholar 2022 olarak çeşitliliği ve akademik mükemmelliği savunuyor. Ayrıca Tech Scholar, Mitacs Globalink Research Scholar ve Harvard WeCode Scholar'da Teradata Çeşitliliği olarak tanınmaktadır. Kanwal, STEM alanlarında kadınları güçlendirmek için FEMCodes'u kuran, değişimin ateşli bir savunucusudur.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps