การแข่งขันสำหรับโมเดลปัญญาประดิษฐ์ที่ใหญ่ขึ้นเรื่อยๆ ถือเป็นจุดเด่นของความก้าวหน้าล่าสุด อย่างไรก็ตาม Microsoft กำลังเขย่าวงการด้วย Phi-3 Mini ซึ่งเป็นโมเดล AI ที่มีความสามารถที่น่าประทับใจแม้จะมีขนาดกะทัดรัดก็ตาม

ตามเนื้อผ้า ความสำเร็จในโมเดลภาษาขนาดใหญ่ (LLM) ได้รับการเชื่อมโยงกับจำนวนของพารามิเตอร์ โดยพื้นฐานแล้วคือหน่วยการสร้างที่แจ้งความเข้าใจภาษาของโมเดล

เมื่อคำนึงถึงต้นทุนการประมวลผลและความพร้อมใช้งานสำหรับทุกคน Microsoft Phi-3 พร้อมแล้วที่จะเปลี่ยนแนวทาง "ดั้งเดิม" นี้

Microsoft Phi-3 Mini ใส่อุปกรณ์ขนาดยักษ์ไว้ในกระเป๋าของคุณได้

GPT-3.5 ซึ่งเป็นผู้นำในปัจจุบันในการแข่งขัน LLM มีพารามิเตอร์ที่น่าทึ่งถึง 175 พันล้านพารามิเตอร์ จำนวนมหาศาลนี้ทำให้ GPT-3.5 สามารถประมวลผลข้อมูลข้อความจำนวนมหาศาล ทำให้มีความเข้าใจภาษาที่กว้างและละเอียดถี่ถ้วน อย่างไรก็ตาม ความซับซ้อนนี้ยังมาพร้อมกับค่าใช้จ่ายอีกด้วย การรันโมเดลที่มีจำนวนพารามิเตอร์สูงเช่นนี้ต้องใช้ทรัพยากรในการคำนวณจำนวนมาก ซึ่งทำให้มีราคาแพงและใช้พลังงานมาก

ในทางกลับกัน โมเดลขนาดเล็กของ Microsoft ใช้แนวทางที่แตกต่างออกไป ด้วยการใช้ชุดพารามิเตอร์ที่เล็กกว่ามาก - เพียง 3.8 พันล้าน - Phi-3 Mini จึงทำงานด้วยประสิทธิภาพในระดับที่เล็กกว่าพารามิเตอร์ที่ใหญ่กว่า การลดขนาดนี้ทำให้เกิดข้อดีหลายประการ

สิ่งเหล่านี้ทำให้ Microsoft Phi-3:

- ค่าใช้จ่ายในการวิ่งถูกกว่าอย่างเห็นได้ชัด

- ขุมพลังที่มีศักยภาพสำหรับแอปพลิเคชัน AI บนอุปกรณ์

รูปแบบการฝึกของ Phi-3 Mini

อีกแง่มุมที่น่าสนใจของ Phi-3 Mini ก็คือวิธีการฝึกฝน

ซึ่งแตกต่างจากโปรแกรมขนาดใหญ่กว่าที่ได้รับการฝึกอบรมเกี่ยวกับชุดข้อมูลข้อความและโค้ดจำนวนมาก การศึกษาของ Phi-3 Mini เกี่ยวข้องกับการเลือกที่คัดสรรมามากกว่า นักวิจัยเลือกใช้หลักสูตรที่ได้รับแรงบันดาลใจจากวิธีที่เด็กๆ เรียนรู้โดยใช้หนังสือเด็กเป็นรากฐาน

แนวทางนี้ดูเหมือนจะให้ผลลัพธ์เชิงบวก โดย Phi-3 Mini แสดงให้เห็นถึงประสิทธิภาพที่ทัดเทียมกับ GPT-3.5 บน เกณฑ์มาตรฐานหลายประการ.

เกณฑ์มาตรฐานเพื่อความสำเร็จ

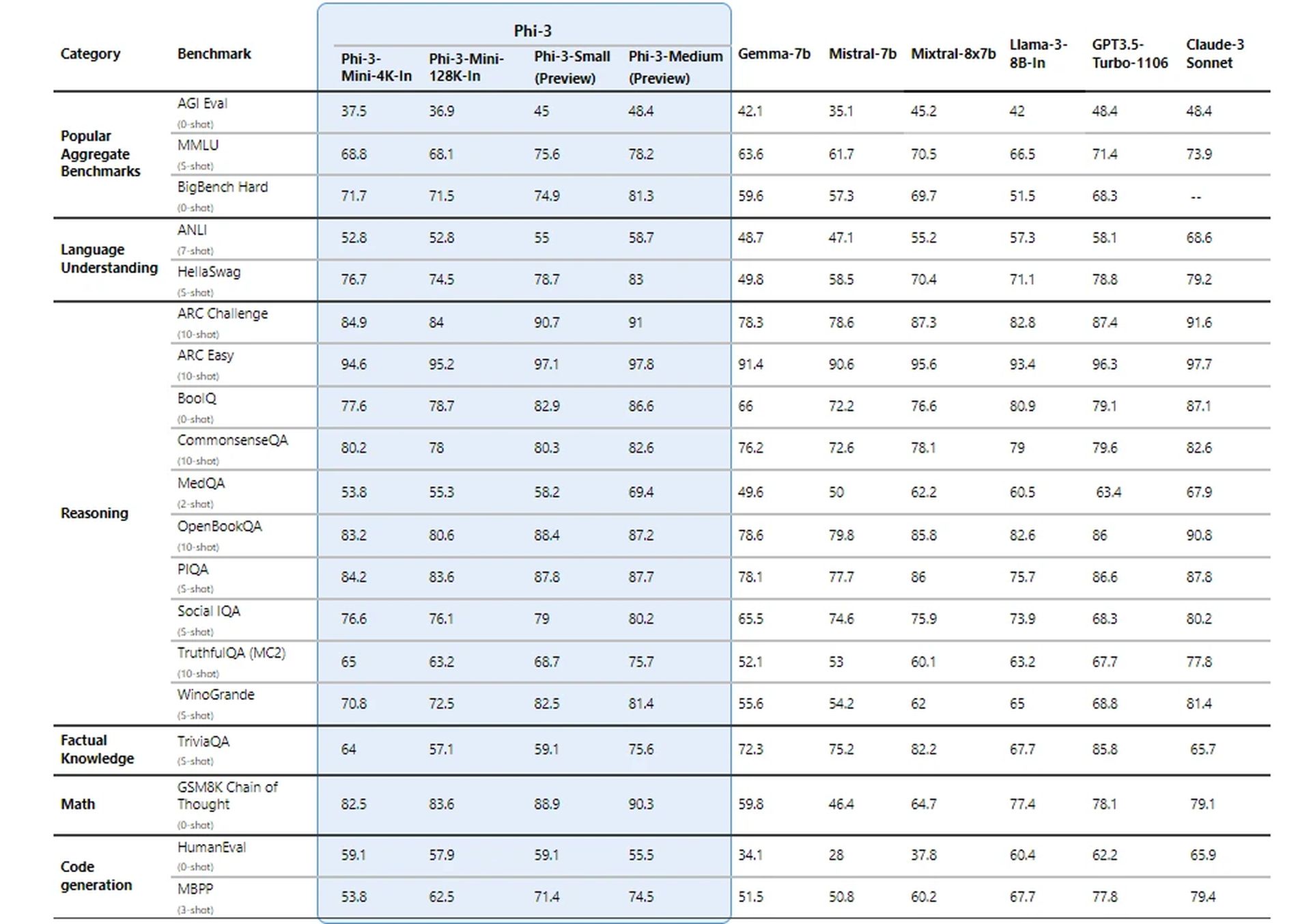

นักวิจัยของ Microsoft ได้นำโมเดลใหม่ไปใช้โดยใช้เกณฑ์มาตรฐานที่กำหนดไว้สำหรับ LLM โมเดลได้รับคะแนนที่น่าประทับใจในด้านเมตริก เช่น MMLU (การวัดความสามารถของโมเดลในการเข้าใจความสัมพันธ์ที่ซับซ้อนในภาษา) และ MT-bench (การทดสอบความสามารถในการแปลด้วยเครื่อง)

ผลลัพธ์เหล่านี้ชี้ให้เห็นว่า Phi-3 Mini แม้จะมีขนาดใหญ่ แต่ก็สามารถแข่งขันกับบริษัทยักษ์ใหญ่ในเกม LLM ได้

มันบรรลุผลลัพธ์ที่น่าประทับใจเช่นนี้ได้อย่างไร?

รายละเอียดทางเทคนิคของ Phi-3 Mini เผยให้เห็นแนวทางอันน่าทึ่งในการบรรลุผลลัพธ์ที่น่าประทับใจด้วยขนาดโมเดลที่เล็กอย่างน่าทึ่ง ต่อไปนี้เป็นรายละเอียดประเด็นสำคัญ:

สถาปัตยกรรมตัวถอดรหัสหม้อแปลงไฟฟ้า

Phi-3 Mini ใช้สถาปัตยกรรมตัวถอดรหัสหม้อแปลง ซึ่งเป็นตัวเลือกการออกแบบที่แพร่หลายสำหรับโมเดลภาษาที่มีประสิทธิภาพ สถาปัตยกรรมนี้มีความเป็นเลิศในการประมวลผลข้อมูลตามลำดับ เช่น ข้อความ ทำให้โมเดลเข้าใจความสัมพันธ์ระหว่างคำในประโยคได้

ความยาวบริบท

Phi-3 Mini มาตรฐานทำงานโดยมีความยาวบริบท 4,000 โทเค็น สิ่งนี้จะกำหนดจำนวนโทเค็นสูงสุด (คำหรือส่วนของคำ) ที่โมเดลจะพิจารณาเมื่อสร้างข้อความ ความยาวบริบทที่ยาวขึ้นช่วยให้เข้าใจการสนทนาก่อนหน้านี้ได้ลึกซึ้งยิ่งขึ้น แต่ยังต้องใช้พลังในการประมวลผลมากขึ้นอีกด้วย

เวอร์ชันบริบทแบบยาว (Phi-3-Mini-128K)

สำหรับงานที่ต้องการบริบทที่กว้างขึ้น มีตัวเลือกที่เรียกว่า Phi-3-Mini-128K ให้ใช้งาน เวอร์ชันนี้ขยายความยาวบริบทเป็นโทเค็นจำนวนมหาศาลถึง 128,000 โทเค็น ทำให้สามารถจัดการลำดับข้อมูลที่ซับซ้อนมากขึ้นได้

ความเข้ากันได้กับเครื่องมือที่มีอยู่

เพื่อเป็นประโยชน์ต่อชุมชนนักพัฒนา Phi-3 Mini มีโครงสร้างและขนาดคำศัพท์ที่คล้ายคลึงกัน (320,641) กับโมเดลตระกูล Llama-2 ความเข้ากันได้นี้ทำให้นักพัฒนาสามารถใช้ประโยชน์จากเครื่องมือและไลบรารีที่มีอยู่ซึ่งออกแบบมาสำหรับ Llama-2 เมื่อทำงานกับ Phi-3 Mini

พารามิเตอร์โมเดล

นี่คือจุดที่ Phi-3 Mini โดดเด่นอย่างแท้จริง ด้วยพารามิเตอร์เพียง 3.072 พันล้านพารามิเตอร์ จึงทำงานได้ต่ำกว่าตัวเลขที่น่าทึ่งในรุ่นขนาดใหญ่ เช่น GPT-3.5 (175 พันล้านพารามิเตอร์)

การลดพารามิเตอร์ลงอย่างมากนี้ส่งผลให้มีประสิทธิภาพที่ยอดเยี่ยมในแง่ของพลังการประมวลผลและการใช้หน่วยความจำ

Saif Naik จาก Microsoft อธิบายว่า:

“เป้าหมายของเรากับนักบินอวกาศ Krishi Mitra คือการปรับปรุงประสิทธิภาพโดยยังคงรักษาความแม่นยำของแบบจำลองภาษาขนาดใหญ่ไว้ เรารู้สึกตื่นเต้นที่ได้เป็นพันธมิตรกับ Microsoft ในการใช้ Phi-3 เวอร์ชันที่ได้รับการปรับแต่งเพื่อให้บรรลุเป้าหมายทั้งในด้านประสิทธิภาพและความแม่นยำ!”

– Saif Naik หัวหน้าฝ่ายเทคโนโลยี ITCMAARS

วิธีการฝึกอบรม

การฝึกอบรมของ Phi-3 Mini ได้รับแรงบันดาลใจจากแนวทาง "หนังสือเรียนคือทุกสิ่งที่คุณต้องการ" วิธีการนี้จะเน้นข้อมูลการฝึกคุณภาพสูงมากกว่าการขยายขนาดโมเดล ข้อมูลการฝึกอบรมได้รับการดูแลจัดการอย่างระมัดระวัง โดยมุ่งเน้นไปที่แหล่งข้อมูลบนเว็บที่มี “ระดับการศึกษา” เฉพาะเจาะจง และข้อมูลสังเคราะห์ที่สร้างโดย LLM อื่นๆ

กลยุทธ์นี้ช่วยให้ Phi-3 Mini บรรลุผลลัพธ์ที่น่าประทับใจแม้จะมีขนาดกะทัดรัดก็ตาม

การกรองข้อมูลเพื่อการเรียนรู้ที่ดีที่สุด

แตกต่างจากวิธีการแบบดั้งเดิมที่จัดลำดับความสำคัญของทรัพยากรการคำนวณหรือการฝึกอบรมที่มากเกินไป Phi-3 Mini มุ่งเน้นไปที่ "ระบบการจัดการข้อมูลที่เหมาะสมที่สุด" สำหรับขนาดของมัน ซึ่งเกี่ยวข้องกับการกรองข้อมูลเว็บอย่างพิถีพิถันเพื่อให้แน่ใจว่ามี "ความรู้" ในระดับที่เหมาะสม และส่งเสริมทักษะการใช้เหตุผล

ตัวอย่างเช่น ข้อมูลกีฬาทั่วไปอาจถูกแยกออกเพื่อจัดลำดับความสำคัญของข้อมูลที่ปรับปรุงความสามารถในการให้เหตุผลของโมเดล

การปรับแต่งหลังการฝึกอย่างละเอียด

หลังจากกระบวนการฝึกอบรมหลัก โมเดลใหม่จะได้รับการปรับแต่งเพิ่มเติมผ่านการปรับแต่งแบบละเอียดภายใต้การดูแล (SFT) และการเพิ่มประสิทธิภาพการตั้งค่าโดยตรง (DPO) SFT เปิดเผยโมเดลเพื่อดูแลจัดการข้อมูลในโดเมนต่างๆ รวมถึงคณิตศาสตร์ การเขียนโค้ด และหลักการด้านความปลอดภัย อ.ส.ค. ช่วยคัดท้ายโมเดลให้ห่างจากพฤติกรรมที่ไม่พึงประสงค์โดยการระบุและยกเว้นผลลัพธ์ที่ไม่พึงประสงค์

ขั้นตอนหลังการฝึกอบรมนี้จะเปลี่ยน Phi-3 Mini จากโมเดลภาษาให้เป็นผู้ช่วย AI ที่หลากหลายและปลอดภัย

ประสิทธิภาพบนอุปกรณ์อย่างมีประสิทธิภาพ

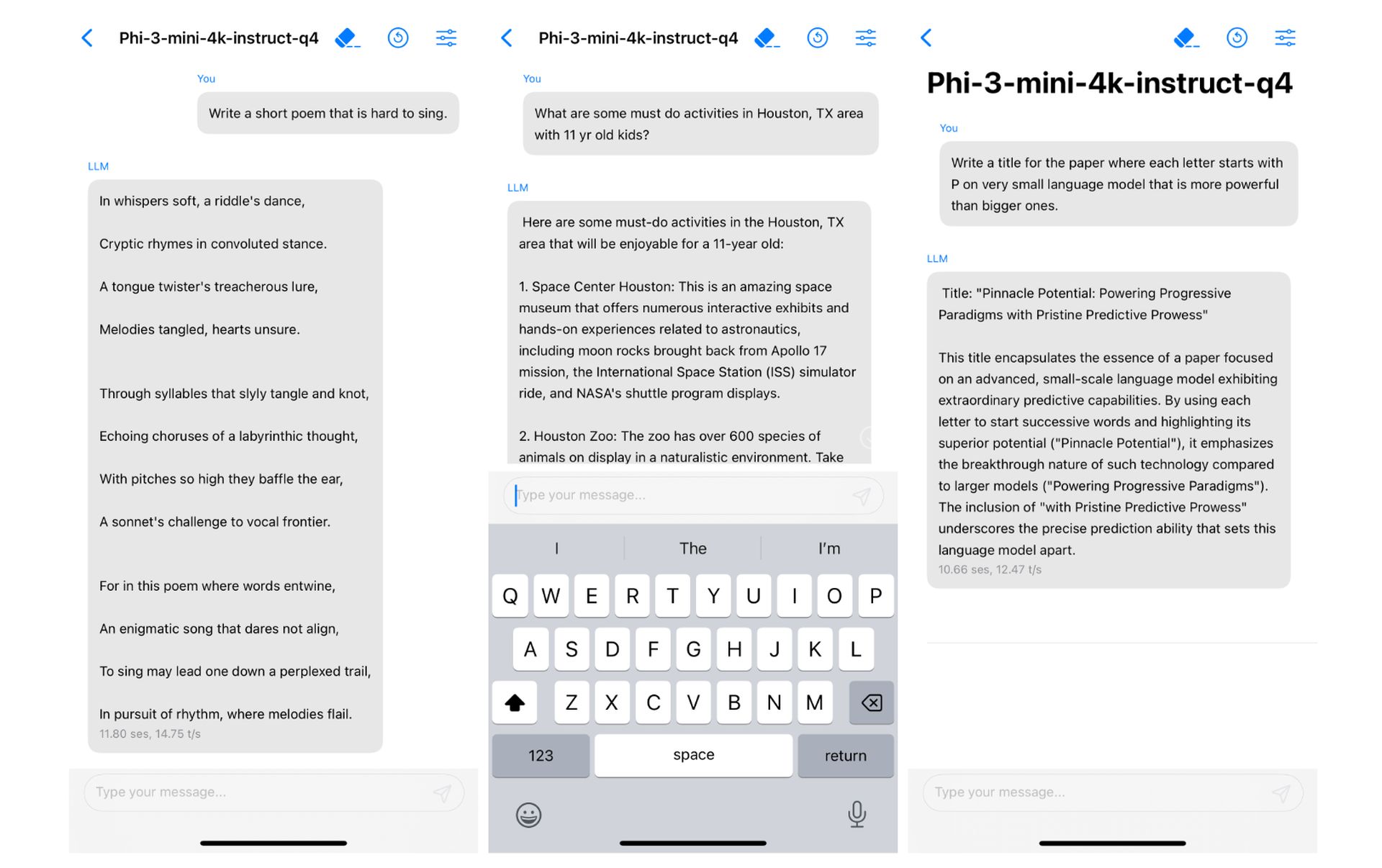

ขนาดที่เล็กของ Phi-3 Mini แปลเป็นประสิทธิภาพที่ยอดเยี่ยมบนอุปกรณ์ ด้วยการกำหนดจำนวนโมเดลเป็น 4 บิต จะใช้หน่วยความจำเพียง 1.8 กิกะไบต์

การแข่งขันที่เกิดขึ้นในสวรรค์

คุณจำความพยายามบนสมาร์ทโฟนที่ล้มเหลวของ Microsoft ได้หรือไม่ แล้วไง ข้อตกลงการรวม Google Gemini ที่ล้มเหลวของ Apple ในช่วงหลายเดือนที่ผ่านมา? หรือคุณได้ติดตามข่าวที่ Apple พูดถึงเรื่องการบูรณาการ LLM บนอุปกรณ์ที่มี iOS 18 ในช่วงสองสามสัปดาห์ที่ผ่านมา?

มันสั่นกระดิ่งหรือเปล่า.?

การใช้งานที่เป็นไปได้ของ Phi-3 Mini มีมากมาย ประสิทธิภาพทำให้เหมาะอย่างยิ่งสำหรับการผสานรวมเข้ากับอุปกรณ์เคลื่อนที่ ซึ่งอาจเปิดใช้ฟีเจอร์ต่างๆ เช่น ผู้ช่วยเสมือนที่ชาญฉลาดยิ่งขึ้น และการแปลภาษาแบบเรียลไทม์ นอกจากนี้ ความคุ้มทุนสามารถเปิดประตูให้นักพัฒนาที่ทำงานในโครงการที่ขับเคลื่อนด้วย AI ต่างๆ นำไปใช้ในวงกว้างได้

และนั่นคือสิ่งที่ Apple กำลังมองหา แน่นอนว่าคำกล่าวอ้างนี้ไม่มีอะไรมากไปกว่าการเดาในตอนนี้ แต่คงไม่ผิดที่จะบอกว่านี่คือ "การแข่งขันที่เกิดขึ้นในสวรรค์" นอกจากนี้ ในรายงานการวิจัย โครงการใหม่ของ Microsoft ได้ถูกใช้งานบน iPhone ที่ใช้ชิป A16 Bionic อยู่แล้ว.

ความสำเร็จของ Phi-3 Mini ขึ้นอยู่กับปัจจัยหลายอย่างรวมกัน เช่น สถาปัตยกรรมที่เหมาะสม การใช้ความยาวบริบทอย่างมีประสิทธิภาพ ความเข้ากันได้กับเครื่องมือที่มีอยู่ การมุ่งเน้นไปที่ข้อมูลการฝึกอบรมคุณภาพสูง และเทคนิคการปรับให้เหมาะสม แนวทางที่เป็นเอกลักษณ์นี้ปูทางไปสู่โมเดล AI ที่ทรงพลังและมีประสิทธิภาพ ซึ่งสามารถทำงานได้อย่างราบรื่นบนอุปกรณ์ส่วนบุคคล

เครดิตภาพ: vecstock/Freepik

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://dataconomy.com/2024/04/24/microsoft-phi-3/