Tekma za vse večje modele umetne inteligence je bila značilnost nedavnega napredka. Vendar Microsoft pretresa stvari s Phi-3 Mini, modelom AI, ki se ponaša z impresivnimi zmogljivostmi kljub svoji kompaktni velikosti.

Tradicionalno je bil uspeh velikih jezikovnih modelov (LLM) povezan s številom parametrov – v bistvu gradnikov, ki določajo razumevanje jezika s strani modela.

Ob upoštevanju računalniških stroškov in razpoložljivosti za vse je Microsoft Phi-3 tu, da spremeni ta »tradicionalni« pristop.

Microsoft Phi-3 Mini spravi velikana v vaše žepe

GPT-3.5, trenutno vodilni v dirki za LLM, se ponaša z osupljivimi 175 milijardami parametrov. To ogromno število omogoča GPT-3.5 obdelavo ogromnih količin besedilnih podatkov, kar mu daje široko in niansirano razumevanje jezika. Vendar pa ta kompleksnost prinaša tudi stroške. Izvajanje modela s tako velikim številom parametrov zahteva znatna računalniška sredstva, zaradi česar je drago in požrešno.

Microsoftov mini model pa ima drugačen pristop. Z uporabo veliko manjšega nabora parametrov – zgolj 3.8 milijarde – Phi-3 Mini deluje s stopnjo učinkovitosti, ki pritlikava njegove večje primerke. To zmanjšanje velikosti pomeni številne prednosti.

Vse to tvori Microsoft Phi-3:

- Bistveno cenejši za uporabo

- Potencialna elektrarna za aplikacije AI v napravi

Režim treninga Phi-3 Mini

Še en zanimiv vidik Phi-3 Mini je njegova metoda usposabljanja.

Za razliko od svojih večjih sorodnikov, ki so bili usposobljeni za obsežne podatkovne nize besedila in kode, je izobraževanje Phi-3 Mini vključevalo bolj kuriran izbor. Raziskovalci so se odločili za kurikulum, ki ga je navdihnilo, kako se otroci učijo – z uporabo otroških knjig kot temelja.

Zdi se, da je ta pristop prinesel pozitivne rezultate, pri čemer je Phi-3 Mini pokazal zmogljivost, primerljivo z GPT-3.5 na več meril uspešnosti.

Primerjava uspeha

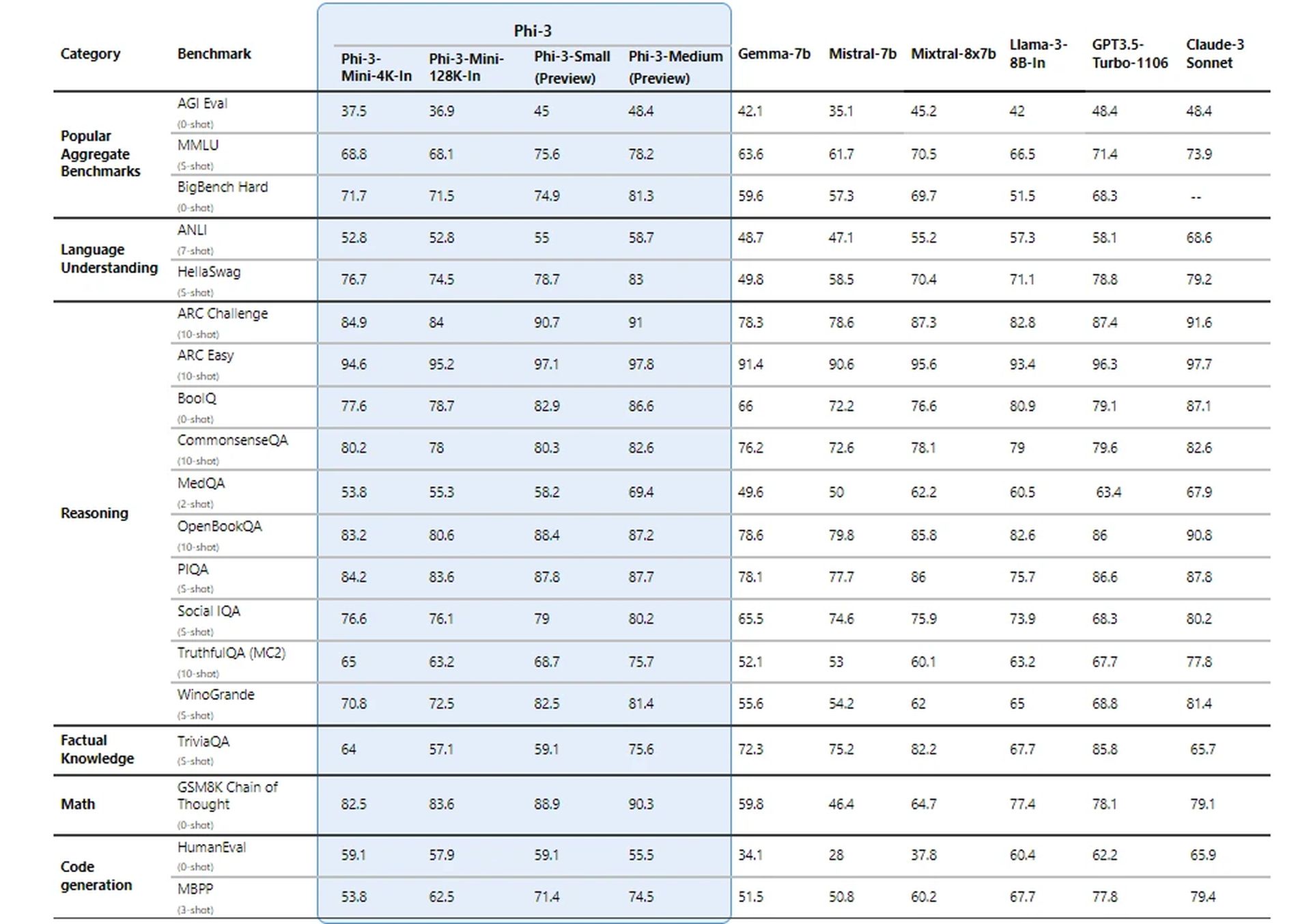

Microsoftovi raziskovalci so svoj novi model preizkusili z uporabo uveljavljenih meril uspešnosti za LLM. Model je dosegel impresivne rezultate pri metrikah, kot sta MMLU (merilo sposobnosti modela za razumevanje zapletenih odnosov v jeziku) in MT-bench (preizkus zmožnosti strojnega prevajanja).

Ti rezultati kažejo, da se Phi-3 Mini kljub svoji velikosti lahko kosa z velikimi imeni v igri LLM.

Kako doseže tako impresivne rezultate?

Tehnične podrobnosti Phi-3 Mini razkrivajo fascinanten pristop k doseganju impresivnih rezultatov z izjemno majhno velikostjo modela. Tukaj je razčlenitev ključnih vidikov:

Arhitektura transformatorskega dekoderja

Phi-3 Mini uporablja arhitekturo transformatorskega dekoderja, ki je prevladujoča izbira zasnove za učinkovite jezikovne modele. Ta arhitektura je odlična pri obdelavi zaporednih podatkov, kot je besedilo, kar modelu omogoča razumevanje odnosov med besedami v stavku.

Dolžina konteksta

Standardni Phi-3 Mini deluje z dolžino konteksta 4,000 žetonov. To določa največje število žetonov (besed ali delov besed), ki jih model upošteva pri generiranju besedila. Daljša dolžina konteksta omogoča globlje razumevanje predhodnega pogovora, vendar zahteva tudi več procesorske moči.

Različica z dolgim kontekstom (Phi-3-Mini-128K)

Za naloge, ki zahtevajo širši kontekst, je na voljo različica Phi-3-Mini-128K. Ta različica razširi dolžino konteksta na neverjetnih 128,000 žetonov, kar ji omogoča obdelavo bolj zapletenih zaporedij informacij.

Združljivost z obstoječimi orodji

V korist skupnosti razvijalcev si Phi-3 Mini deli podobno strukturo in velikost besedišča (320,641) kot družina modelov Llama-2. Ta združljivost omogoča razvijalcem, da pri delu s Phi-2 Mini izkoristijo obstoječa orodja in knjižnice, oblikovane za Llama-3.

Parametri modela

Tukaj Phi-3 Mini resnično blesti. Z le 3.072 milijarde parametrov deluje daleč pod osupljivimi številkami, ki jih vidimo v večjih modelih, kot je GPT-3.5 (175 milijard parametrov).

To znatno zmanjšanje parametrov pomeni izjemno učinkovitost v smislu procesorske moči in uporabe pomnilnika.

Microsoftov Saif Naik pojasnjuje:

»Naš cilj s kopilotom Krishi Mitra je izboljšati učinkovitost in hkrati ohraniti natančnost velikega jezikovnega modela. Navdušeni smo, da sodelujemo z Microsoftom pri uporabi natančno nastavljenih različic Phi-3 za izpolnitev obeh naših ciljev – učinkovitosti in natančnosti!«

– Saif Naik, vodja tehnologije, ITCMAARS

Metodologija usposabljanja

Vadba Phi-3 Mini črpa navdih iz pristopa »Učbeniki so vse, kar potrebujete«. Ta metoda poudarja visokokakovostne podatke o usposabljanju namesto preprostega povečevanja velikosti modela. Podatki o usposabljanju so skrbno kurirani, pri čemer se osredotočajo na spletne vire s posebno "izobrazbeno stopnjo" in sintetične podatke, ki so jih ustvarili drugi LLM.

Ta strategija omogoča, da Phi-3 Mini kljub kompaktni velikosti doseže impresivne rezultate.

Filtriranje podatkov za optimalno učenje

Za razliko od tradicionalnih pristopov, ki dajejo prednost bodisi računalniškim virom ali prekomernemu usposabljanju, se Phi-3 Mini osredotoča na »podatkovni optimalen režim« za svojo velikost. To vključuje natančno filtriranje spletnih podatkov, da se zagotovi, da vsebujejo pravo raven "znanja" in spodbujajo sposobnosti razmišljanja.

Na primer, splošni športni podatki bi lahko bili izključeni, da bi dali prednost informacijam, ki izboljšajo sposobnost razmišljanja modela.

Natančna nastavitev po treningu

Po osrednjem procesu usposabljanja je novi model podvržen dodatnim izboljšavam z nadzorovano fino nastavitvijo (SFT) in neposredno optimizacijo preferenc (DPO). SFT izpostavlja model kuriranim podatkom na različnih področjih, vključno z matematiko, kodiranjem in varnostnimi načeli. DPO pomaga usmerjati model stran od neželenega vedenja tako, da prepozna in izključi nezaželene rezultate.

Ta faza po usposabljanju spremeni Phi-3 Mini iz jezikovnega modela v vsestranskega in varnega pomočnika z umetno inteligenco.

Učinkovito delovanje v napravi

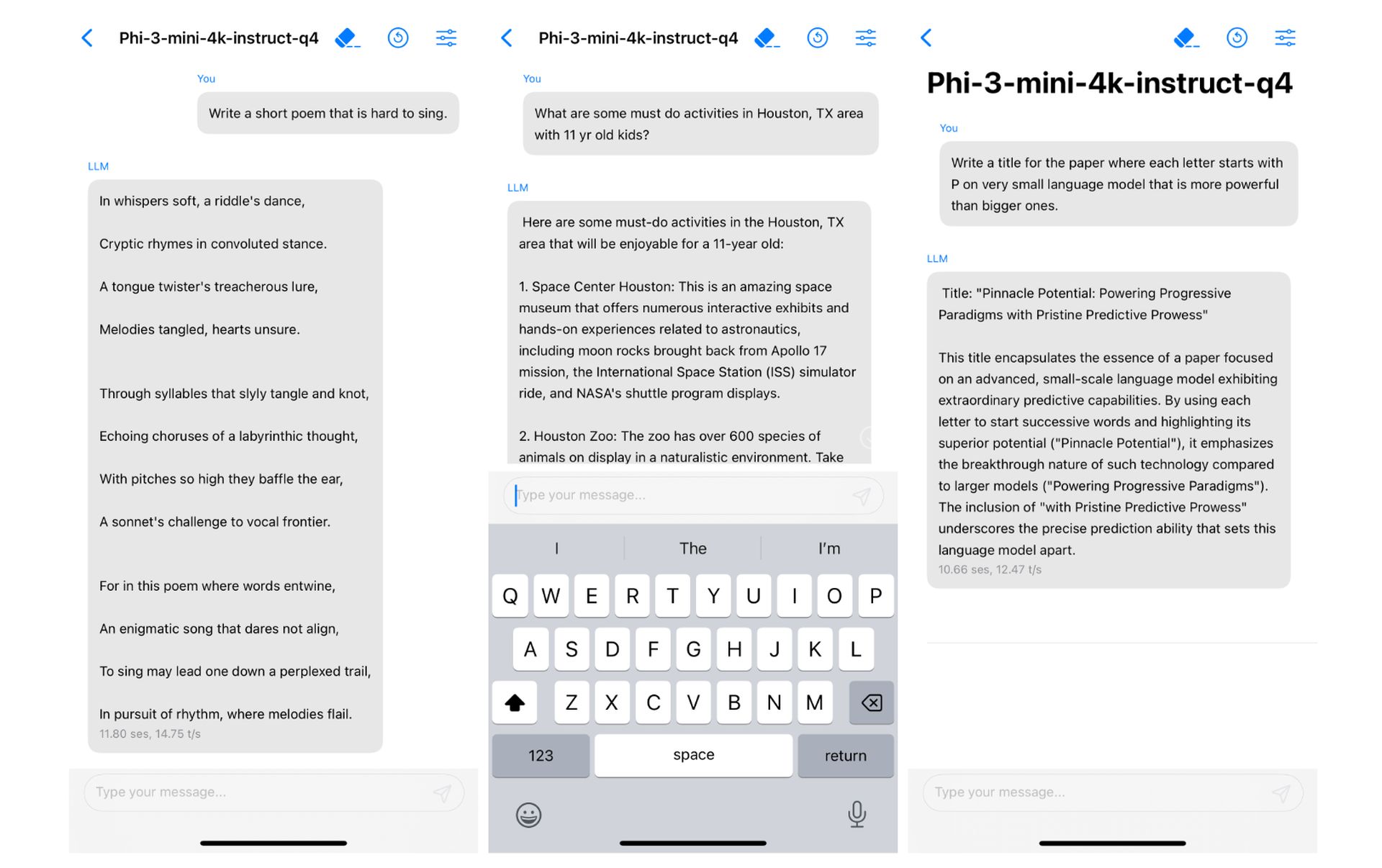

Majhna velikost Phi-3 Mini pomeni izjemno zmogljivost v napravi. S kvantizacijo modela na 4 bite zasede le 1.8 gigabajtov pomnilnika.

Tekma v nebesih

Se spomnite neuspelih Microsoftovih poskusov s pametnimi telefoni? Kaj pa o Applovi neuspešni dogovori o integraciji Google Gemini v zadnjih mesecih? Ali pa ste spremljali novice o tem, da je Apple glasno govoril o integraciji LLM v napravi z iOS 18 v zadnjih nekaj tednih?

Ali zazvoni?

Možnosti uporabe Phi-3 Mini so ogromne. Zaradi svoje učinkovitosti je idealen za integracijo v mobilne naprave, saj lahko omogoča funkcije, kot so pametnejši virtualni pomočniki in jezikovno prevajanje v realnem času. Poleg tega bi lahko njegova stroškovna učinkovitost odprla vrata za širšo uporabo s strani razvijalcev, ki delajo na različnih projektih, ki jih poganja AI.

In točno to je iskal Apple. Seveda je ta trditev zaenkrat le ugibanje, a ne bi bilo narobe, če bi rekli, da gre za “nebeško sklenjeno tekmo”. Poleg tega je v raziskovalni nalogi Microsoftov nov projekt se že izvaja na iPhonu z izvornim čipom A16 Bionic.

Uspeh Phi-3 Mini je odvisen od kombinacije dejavnikov – dobro prilagojene arhitekture, učinkovite uporabe dolžine konteksta, združljivosti z obstoječimi orodji, osredotočenosti na visokokakovostne podatke o usposabljanju in tehnik optimizacije. Ta edinstven pristop utira pot zmogljivim in učinkovitim modelom AI, ki lahko nemoteno delujejo na osebnih napravah.

Zasluga predstavljene slike: vecstock/Freepik

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://dataconomy.com/2024/04/24/microsoft-phi-3/