Введение

Мировой финансовый кризис 2007 года оказал долгосрочное влияние на экономику многих стран. В эпическом финансово-экономическом коллапсе многие потеряли работу, сбережения и многое другое. Когда слишком большой риск ограничивается очень немногими игроками, это считается заметным провалом системы управления рисками. После мирового финансового кризиса резко возросла популярность таких терминов, как «банкротство», «дефолт» и «финансовые затруднения». Процесс прогнозирования бедствия/дефолта/банкротства в настоящее время считается важным инструментом для принятия финансовых решений и основным фактором кредитного риска. Великая депрессия 1932 г., Суэцкий кризис 1956 г., международный долговой кризис 1982 г. и последняя рецессия 2007 г. подтолкнули мир к тому, чтобы как можно раньше попытаться выяснить прогноз падения.

Источник: Изображение предоставлено пикисуперзвезда on Freepik

Прогнозирование финансовых затруднений и банкротства — это одно из приложений, которому в последние годы уделяется большое внимание благодаря ажиотажу вокруг финансовых технологий (FinTech) и продолжающемуся быстрому развитию ИИ. Финансовые учреждения могут использовать кредитные рейтинги, чтобы решить, предоставлять ли кредит заемщику, что увеличивает вероятность того, что заемщики с рискованным кредитом будут отклонены в своих запросах. В дополнение к трудностям, вызванным одновременно зашумленными и крайне несбалансированными данными, в настоящее время необходимо провести новые реформы регулирования, такие как Общее регулирование защиты данных (ВВП). Регулирующие органы ожидают, что интерпретируемость модели гарантирует, что алгоритмические выводы будут понятными и непротиворечивыми. Поскольку пандемия COVID-19 боль на финансовых рынках требуется лучшее понимание кредитования, чтобы избежать ситуации, подобной 2007 году.

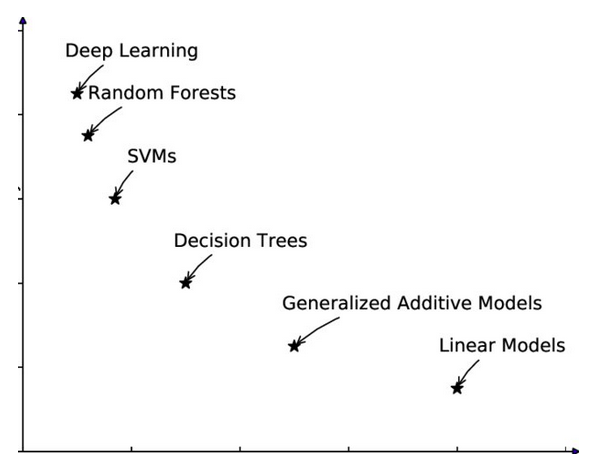

Баланс: интерпретируемость и точность

Модели кредитного скоринга или модели прогнозирования банкротства, которые предсказывают, вернет ли физическое лицо деньги кредитору или компания подаст заявление о банкротстве, должны обеспечивать высокую точность и интерпретируемость. Два моих друга из одного университета в США, с примерно одинаковой зарплатой, таким же возрастом и многими другими эквивалентными параметрами, подали заявку на жилищный кредит. Одному кредит одобрили, другому отказали. Вы не думаете, что отвергнутый заслуживает ответа? Что делать, если корпорация подала заявку на кредит для расширения, но банк решил не предлагать кредит?

Интерпретация

С ростом нескольких релевантных независимых переменных (оценка настроений из финансовой отчетности и коэффициентов), возникла очевидная трудность интерпретации. В прошлом было достаточно минимального количества независимых переменных и базовой модели, чтобы модель можно было легко интерпретировать. В результате исследования, направленные на выбор наиболее значимых переменных и моделирование неплатежеспособности на основе выбранных признаков и простой статистической модели, приобрели большую популярность. Использование алгоритмов машинного обучения — еще один метод работы с функциями, количество которых не всегда ограничено.

Источник: Изображение предоставлено Го и др. (2019) – Исследования Gate

точность

Традиционный метод, основанный на выборе признаков, и подход, основанный на машинном обучении, имеют свои преимущества и недостатки. Подходы, основанные на выборе признаков, легко интерпретируются поскольку они используют небольшое количество переменных, которые были выбраны как важные для предсказания события, банкротства/дефолта, в контексте этой статьи. Подходы, основанные на выборе признаков, часто используют базовую модель прогнозирования, такую как многомерная функция. Однако точность намного ниже по сравнению с моделями на основе машинного обучения. Напротив, хотя подходы, основанные на машинном обучении, достигают большей точности, такие модели слишком сложны, чтобы их можно было легко понять.

Объяснимый ИИ для людей — XAI

Источник: изображение Калифорнийского технологического института.

Объяснимый искусственный интеллект (XAI) пытается упростить модели черного ящика и сделать их более интерпретируемыми. Это позволяет людям понимать и доверять выходным данным алгоритма машинного обучения. Он описывает точность, прозрачность и результаты модели принятия решений на основе ИИ. Столь необходимая объяснимость и прозрачность помогают организациямподхода ИИ по-другому. Успех машинного обучения вызвал поток приложений ИИ. Однако неспособность машины объяснить свои действия людям ограничивает эффективность этих систем. По мере развития ИИ люди изо всех сил пытаются понять и отследить результаты алгоритма.

Источник: изображение от Freepik на Freepik

При представлении модели на основе ML методы XAI могут использоваться для аудита модели и проверки ее темпов, чтобы увидеть, может ли она последовательно давать точные результаты в различных случаях использования, связанных с кредитным скорингом и прогнозированием бедствия. Эти методы, например, оценивают правила прогнозирования модели на соответствие предыдущей информации о бизнес-проблема, что может помочь выявить проблемы, которые могут снизить точность модели при применении к данным вне выборки. Проблемы в наборе данных, которые используются для обучения модели, такие как неполный или предвзятый представление интересующей совокупности или условий обучения, которые приводят к неправильному обучению модели правилам прогнозирования, могут быть обнаружены с помощью методов XAI.

После пандемии XAI предприняла огромные шаги для решения проблем бизнеса, связанных с кредитованием:

- Изюминка Технология на основе искусственного интеллекта позволяет кредиторам настраивать модели для обеспечения справедливости, снижая влияние дискриминационных кредитных данных без ущерба для производительности.

- FICO публично заявила о своем намерении дополнить понимание человеческой области машинным интеллектом, чтобы обеспечить быструю разработку высокопредсказуемых и объяснимых моделей оценки кредитного риска.

- Орколус освобождает кредиторов от предвзятых наборов данных и помогает им более эффективно анализировать финансовые данные. Программное обеспечение Ocrolus анализирует банковские выписки, платежные квитанции, налоговые документы, ипотечные формы, счета-фактуры и другие документы, чтобы определить право на получение ипотечного кредита, бизнеса, потребительского кредита, кредитного скоринга и KYC.

- Underwrite.ai использовали нелинейное алгоритмическое моделирование для оценки кредитного риска в областях с минимальным использованием кредитного бюро или без него.

- Temenos запустила прозрачные модели XAI, поставляемые в виде SaaS, чтобы помочь банкам и кредитным союзам ускорить цифровую регистрацию и обработку кредитов, чтобы решить проблемы пост-ковидной индустрии кредитования.

Модели: современные против обычных

Современные методы применения моделей машинного обучения к кредитному скорингу для прогнозирования дефолтов в финансовом секторе, несомненно, привели к большая прогностическая эффективность чем классические модели, такие как логистическая регрессия. Новые цифровые технологии способствовали внедрению моделей машинного обучения, позволяя финансовым учреждениям приобретать и использовать большие наборы данных включает в себя множество функций и наблюдений для обучения модели. Подходы машинного обучения, в отличие от традиционных моделей, таких как логит-модель, могут экспериментально обнаруживать нелинейности в связях между переменной результата и ее предикторами, а также эффекты взаимодействия между последними. В результате, когда набор обучающих данных достаточно велик, считается, что модели машинного обучения превосходят классические статистические модели, регулярно используемые при оценке кредитоспособности. В результате более высокая точность прогнозирования дефолта может принести пользу кредитным учреждениям за счет меньшего количества кредитных убытков и сбережений, связанных с регулятивным капиталом.

Роль регуляторов

Финансовые регуляторы недавно выразили решительную поддержку тому, чтобы финансовые учреждения использовали как традиционные модели, так и модели машинного обучения одновременно, а людям было поручено обрабатывать любые существенные несоответствия. Большинство финансовых регуляторов не ограничивают, где и как кредитные учреждения могут использовать черные ящики. Все-таки Германия Федеральный орган финансового надзора рекомендовал учреждениям рассмотреть преимущества использования более сложной модели и зафиксировать, почему они выбрали интерпретируемые альтернативы. По словам многих политиков, универсального метода оценки затрат и выгод не существует. Они предлагают, чтобы банки рассмотрели обоснование модели, контекст развертывания и цель, прежде чем внедрять ее. Запатентованная работа была проведена компанией Equifax, которая использует нейронные сети для анализа потребительского кредитного риска и предлагает коды причин, которые помогают предприятиям выполнять нормативные обязательства.

Источник: изображение от Freepik на Freepik

Полезная информация для клиентов

Методы XAI для моделей, связанных с кредитованием, легко учитывают бинарные решения потребителей, включая «одалживать» и «не одалживать». Объяснения, предоставляемые методами XAI, могут не учитывать важные аспекты кредитования, такие как процентная ставка, график погашения, изменения кредитного лимита или предпочтения клиента в отношении кредита. Однако финансовые учреждения, использующие XAI, должны будут информировать клиентов, почему их заявки на получение кредита были отклонены, и как улучшить свои учетные данные. Представьте, что клиенту предлагается повысить свою зарплату или образовательную квалификацию или его просят вовремя оплачивать счета по кредитной карте в течение нескольких месяцев, чтобы получить одобрение кредита. Это не что иное, как полезная информация, которую клиент может использовать и повторно подать заявку на кредит.

Успех нелинейный или нет?

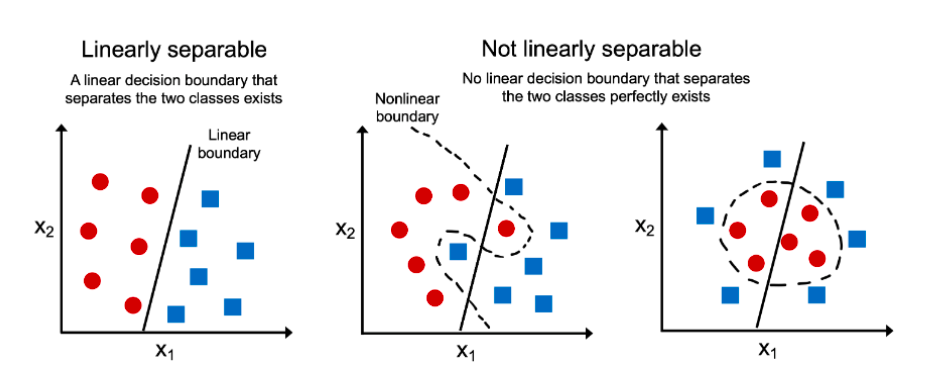

В настоящее время многочисленные финансовые учреждения проводят расследование по своей сути интерпретируемые алгоритмы, такие как линейная регрессия, логистическая регрессия, объяснимое повышение градиента и нейронные сети. Постоянно возникает желание исследовать новые методы разработки моделей, которые прозрачны по своей структуре и не требуют постфактум объяснений. Объяснение готовых моделей постфактум это другая часть истории. Глубокая нейронная сеть, скажем, с 200 слоями или моделью черного ящика передает входные данные алгоритму объяснения, который дополнительно разбивает сложную модель на более мелкие и простые части, которые легче понять. Эти более простые выходные данные также будут состоять из списка функций и параметров, которые важны для бизнес-задачи. В обоих приведенных выше сценариях компромисс между высокой точностью и интерпретируемостью это потребность часа.

Источник: Изображение Аджитеша Кумара на Витафлюкс

SHAP (аддитивное объяснение Шепли) и LIME (локальные интерпретируемые объяснения, не зависящие от модели) являются широко используемыми подходами к объяснимости. SHAP использует значения Шепли для оценки влияния характеристик модели. Значения Шепли учитывают все возможные прогнозы с использованием всех входных данных. Тщательный подход SHAP обеспечивает согласованность и локальную корректность. С другой стороны, LIME строит разреженные линейные модели вокруг каждого прогноза, чтобы описать, как модель черного ящика работает локально.

Что более важно, что важнее: точная модель или модель, которую легко понять как компаниям, так и клиентам? Если данные линейно разделимы, мы можем создать по своей сути интерпретируемый и точная модель. Но если данные сложны и границы решений не являются прямыми, нам, возможно, придется взглянуть на сложную модель, чтобы убедиться, что она верна, а затем подумать о апостериорных объяснениях.

Заключение

В идеальном мире объяснимость помогает людям понять, как работает модель и когда ее использовать. Кредитные учреждения, регулирующие органы и правительство должны сотрудничать для разработки руководств по ИИ, защищающих интересы клиентов. Если разные группы не прояснят цели объяснимости, ИИ будет служить интересам немногих, как во время глобального финансового кризиса 2007 года. Хорошо спроектированное решение XAI учитывает потребности заинтересованных сторон и настраивает объяснение. Алгоритмы искусственного интеллекта и машинного обучения уже произвели революцию в работе кредитные учреждения. Вот некоторые из ключевых выводов о XAI:

- Точность/производительность моделей по сравнению с интерпретируемостью. XAI стремится сделать модели ИИ более интуитивно понятными и понятными без ущерба для точности/производительности.

- Внедрение и масштабирование XAI. Необъяснимость долгое время мешала кредитным учреждениям в полной мере использовать ИИ. Однако XAI помог учреждениям не только с плавной адаптацией, но и с персонализацией.

- Ответственный AITransparency — как кредитная модель достигла результата и с использованием каких параметров.

- Информативность (предоставление людям новой информации, помогающей им принимать решения) и оценка неопределенности (выяснение степени неопределенности результата) (количественное определение надежности прогноза).

Похожие страницы:

- SEO-контент и PR-распределение. Получите усиление сегодня.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. Доступ здесь.

- Источник: https://www.analyticsvidhya.com/blog/2022/12/xai-accuracy-vs-interpretability-for-credit-related-model/