После успешного запуск «Code Llama 70B» В январе Meta выпустила последнюю версию своего мощного LLM-проекта с открытым исходным кодом Llama 3 в инфраструктуре Amazon AWS.

В электронном письме TechStartups Amazon сообщил, что «Meta Llama 3 теперь доступна через Amazon SageMaker JumpStart». Эта последняя версия следует по стопам своей предшественницы, Llama 2, которая была доступна на Amazon SageMaker JumpStart и Коренная порода Амазонки с предыдущего года.

Обладая двумя размерами параметров — 8 байт и 70 байт с длиной контекста 8 КБ — Llama 3 обещает удовлетворить разнообразные варианты использования с улучшениями в рассуждениях, генерации кода и следовании инструкциям. В архитектуре Llama 3 используется конструкция преобразователя только для декодера в сочетании с новым токенизатором, что приводит к повышению производительности модели, инкапсулированной в размер 128 КБ.

«Llama 3 поставляется с двумя размерами параметров — 8 байт и 70 байт с длиной контекста 8 КБ — которые могут поддерживать широкий спектр вариантов использования с улучшениями в рассуждениях, генерации кода и следовании инструкциям», — пишет Amazon.

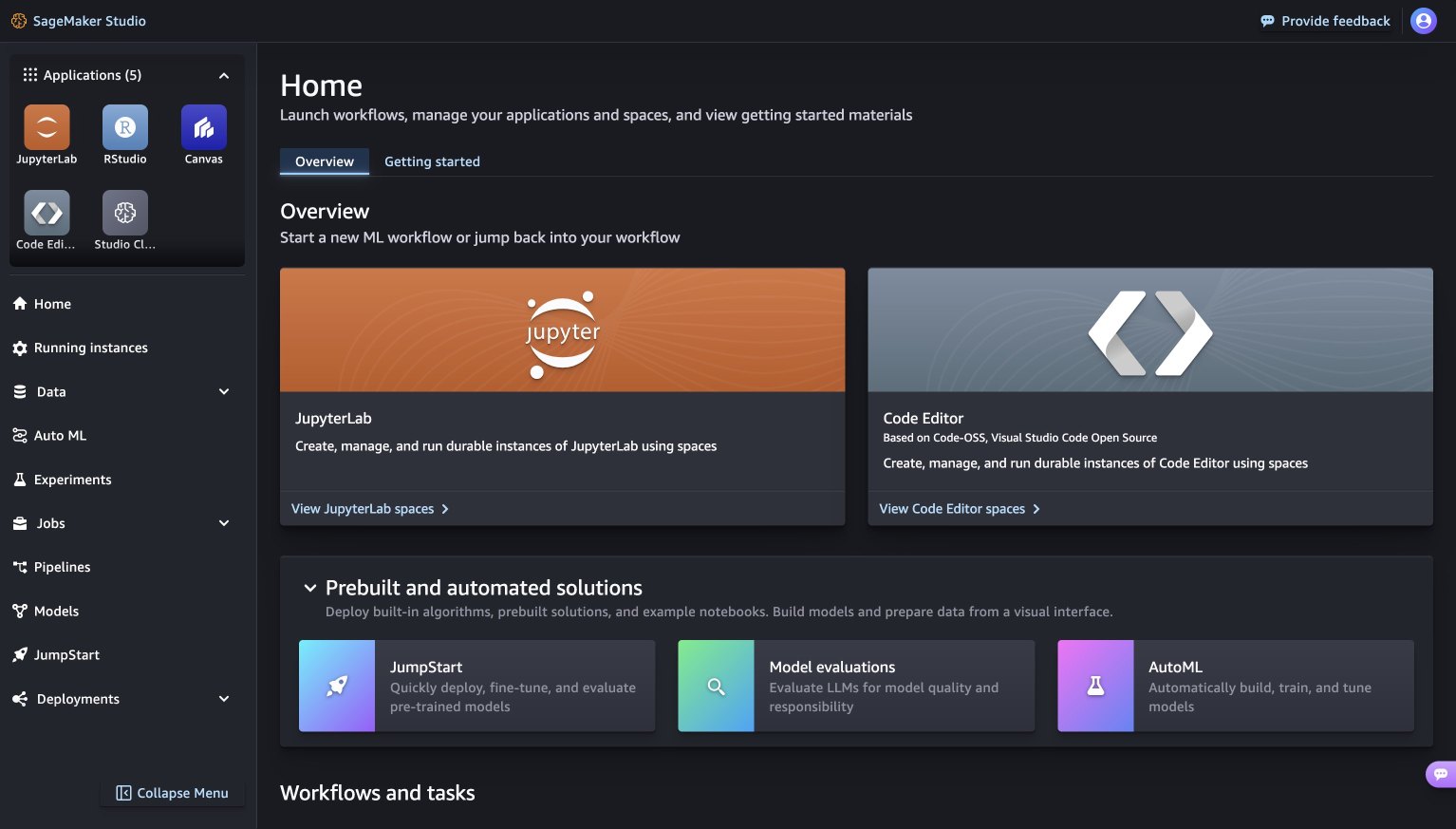

Если вы используете SageMaker Studio, вы сразу же найдете SageMaker JumpStart, предлагающий множество полезных вещей, таких как предварительно обученные модели, блокноты и готовые решения. Просто зайдите в раздел «Готовые и автоматизированные решения», и все готово!

AWS SageMaker JumpStart (Источник: Amazon AWS)

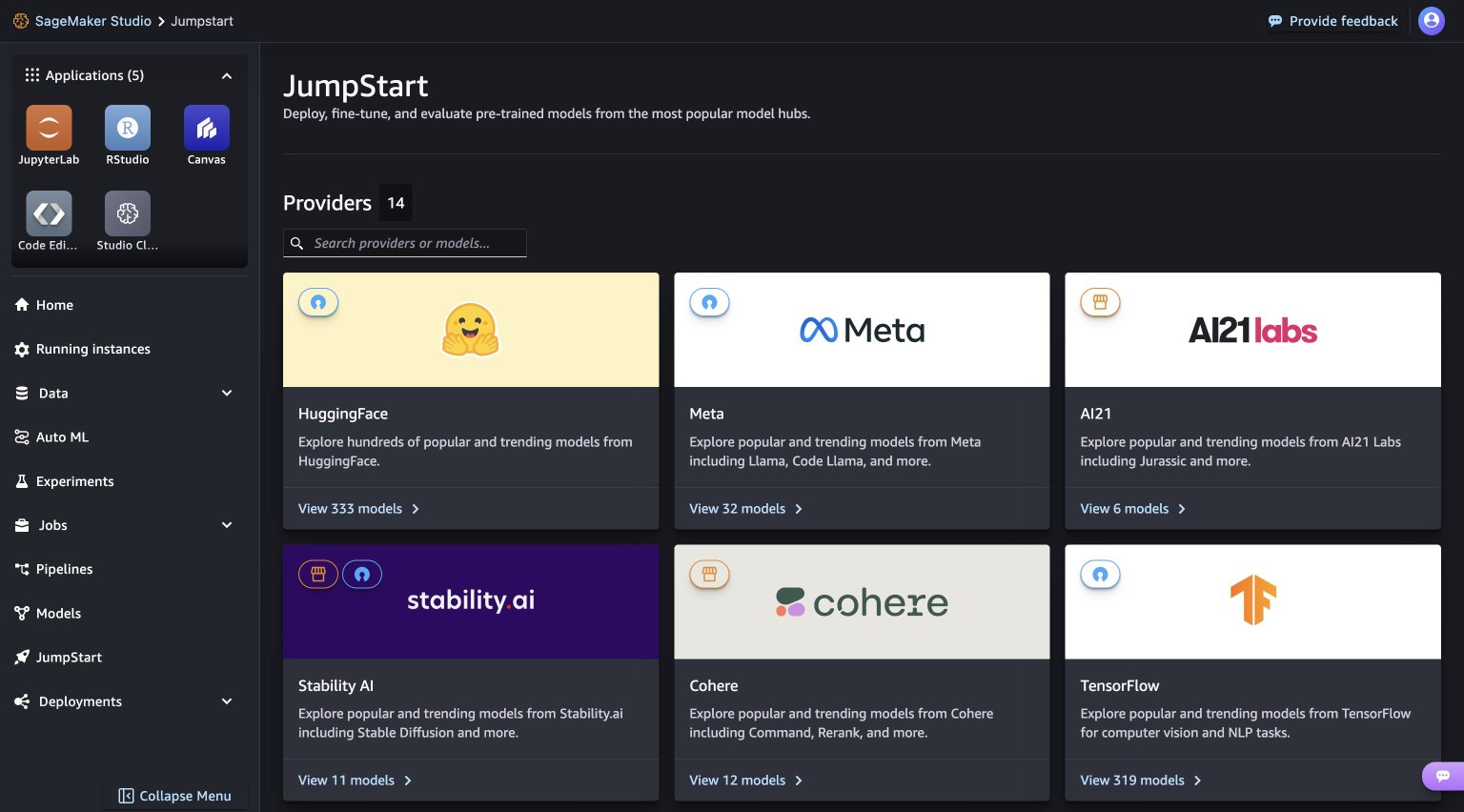

Когда вы попадаете на страницу SageMaker JumpStart, найти разные модели довольно просто. Просто просмотрите хабы, которые по сути представляют собой разделы, названные в честь людей, предоставляющих модели. Например, если вы ищете модели Llama 3, зайдите в мета-хаб. И если вы не заметите их сразу, не беспокойтесь — просто попробуйте обновить версию SageMaker Studio, выключив ее и перезапустив. Это должно делать свое дело!

AWS JumpStart (Источник: Amazon AWS)

Более того, Meta усовершенствовала процедуры постобучения, чтобы значительно сократить количество ложных отказов, улучшить согласованность и увеличить разнообразие ответов модели. Теперь пользователи могут использовать совокупные преимущества возможностей Llama 3 и элементов управления MLOps, используя такие функции Amazon SageMaker, как SageMaker Pipelines, SageMaker Debugger или журналы контейнеров. Кроме того, модель будет развернута в безопасных пределах AWS под контролем VPC, что усилит меры безопасности данных.

В настоящее время AWS является единственным поставщиком облачных услуг, предоставляющим клиентам доступ к наиболее востребованным и передовым базовым моделям. Amazon Bedrock последовательно лидирует в обеспечении доступности следующих популярных моделей:

- Amazon Bedrock является ведущим и эксклюзивным управляемым сервисом, предлагающим все доступные модели Anthropic Claude 3 — Opus, Sonnet и Haiku.

- AWS внедрила на Amazon Bedrock все модели Mistral AI, включая Mistral Large.

- Amazon Bedrock инициировала доступность Meta Llama 2 через управляемый API.

Функционируя как полностью управляемый сервис, Amazon Bedrock служит местом назначения для широкого выбора высокопроизводительных базовых моделей от таких титанов отрасли, как AI21 Labs, Amazon, Anthropic, Cohere, Meta, Mistral AI и Stability AI. доступны через единый API. Более того, он предоставляет комплексный набор возможностей, включающий агентов, ограждения, базы знаний и оценку моделей, что дает организациям возможность создавать генеративные приложения ИИ с упором на безопасность, конфиденциальность и ответственный ИИ. Поскольку десятки тысяч организаций по всему миру полагаются на Amazon Bedrock, компания укрепила свой статус ключевого игрока в сфере генеративных приложений искусственного интеллекта.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://techstartups.com/2024/04/18/meta-launches-its-llama-3-open-source-llm-on-amazon-aws/