Google a fost un lider în cercetarea AI, contribuind în mod semnificativ la comunitatea open-source cu tehnologii transformatoare precum TensorFlow, OARET, T5, JAX, AlphaFold și AlphaCode. Continuând această moștenire, Google a introdus Gemma, un LLM construit pentru dezvoltarea responsabilă a inteligenței artificiale, folosind aceeași cercetare și tehnologie care a alimentat modelele Gini.

Cuprins

Ce este Gemma LLM?

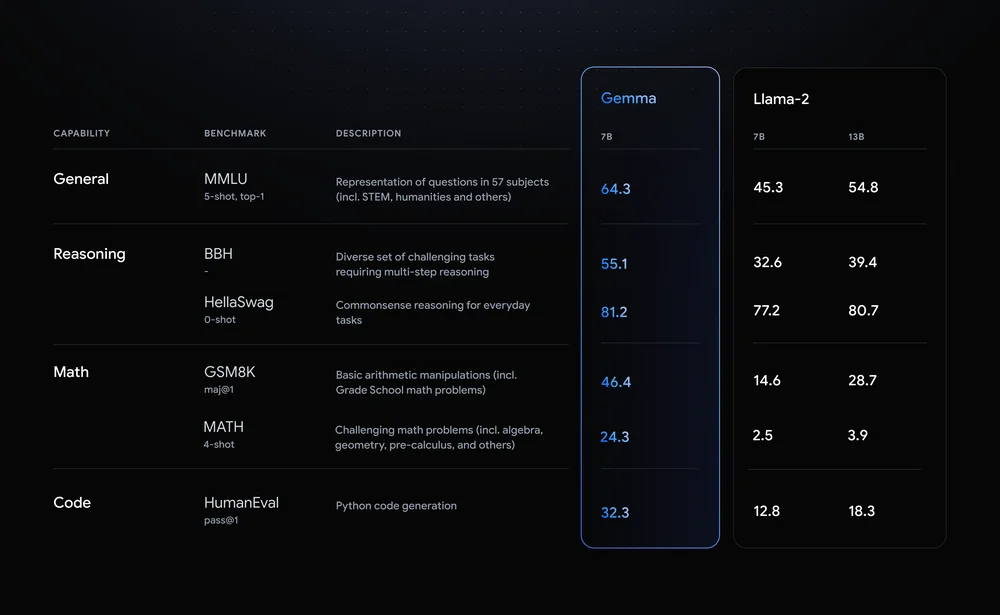

Gemma se remarcă prin valorile sale impresionante de performanță. Vine în două variante: una cu 7 miliarde de parametri și alta cu 2 miliarde. În comparație cu LLM de la Meta, Llama 2, Gemma arată o precizie superioară în diferite benchmark-uri. De exemplu, modelul Gemma cu 7 miliarde de parametri se mândrește cu o acuratețe generală de 64.3%, depășind-o pe Lama 2 la raționament, matematică și alte categorii.

Să ne uităm la câteva dintre caracteristicile Gemma LLM:

- Arhitectură ușoară: Gemma vine în două dimensiuni, parametri 2B și 7B, semnificativ mai mici decât verii săi mai mari. Aceasta se traduce prin viteze de inferență mai mari și cerințe de calcul mai mici, ceea ce îl face ideal pentru computere personale și chiar pentru dispozitive mobile.

- Disponibilitate open-source: Spre deosebire de multe LLM-uri de înaltă performanță, codul și parametrii Gemma sunt disponibile gratuit, dând putere dezvoltatorii și cercetătorii să experimenteze, să personalizeze și să contribuie la evoluția acestuia.

- Variante reglate cu instrucțiuni: Dincolo de modelele pre-antrenate, Gemma oferă versiuni „ajustate pe instrucțiuni” optimizate pentru sarcini specifice, cum ar fi răspunsul la întrebări și rezumarea. Acest îmbunătățește performanța și adaptabilitatea pentru aplicații din lumea reală.

Impactul Gemma depășește specificațiile tehnice. Democratizează accesul la LLM-uri avansate, încurajând inovația și colaborarea în cadrul comunității AI. Aplicațiile sale potențiale acoperă diverse domenii, de la instrumente personale de productivitate și chatbot pentru generarea de coduri și cercetarea științifică. Prin scăderea barierelor de intrare, Gemma își promite să accelereze progresul în procesarea limbajului natural și să modeleze viitorul AI.

Scufundare adânc în variantele Gemma

Gemma, familia Google LLM open-source, oferă o gamă versatilă de modele care răspund nevoilor diverse. Să analizăm diferitele dimensiuni și versiuni, explorând punctele lor forte, cazurile de utilizare și detaliile tehnice pentru dezvoltatori:

Mărimea contează: să-ți alegi Gemma

- 2B: Acest campion ușor excelează în medii cu resurse limitate, cum ar fi procesoarele și dispozitivele mobile. Amprenta sa de memorie de aproximativ 1.5 GB și viteza mare de inferență îl fac ideal pentru sarcini precum clasificarea textului și răspunsul simplu la întrebări.

- 7B: Găsind un echilibru între putere și eficiență, varianta 7B strălucește pe GPU-uri și TPU-uri de calitate pentru consumatori. Nevoia de memorie de 5 GB deblochează sarcini mai complexe, cum ar fi rezumarea și generarea de cod.

Reglarea motorului: reglat de bază versus instrucțiuni

- Baza: Proaspăt ieșite din procesul de instruire, aceste modele oferă o bază de uz general pentru diverse aplicații. Acestea necesită o reglare fină pentru sarcini specifice, dar oferă flexibilitate pentru personalizare.

- Instrucțiuni reglate: Antrenate în prealabil pe instrucțiuni specifice, cum ar fi „rezumat” sau „traduce”, aceste variante oferă o capacitate de utilizare imediată pentru sarcinile vizate. Ei sacrifică o anumită generalizare pentru o performanță îmbunătățită în domeniul lor desemnat.

Informații tehnice pentru dezvoltatori

- Amprenta memoriei: Modelele 2B necesită aproximativ 1.5 GB, în timp ce modelele 7B necesită aproximativ 5 GB de memorie. Reglajul fin poate crește ușor această amprentă.

- Viteza de inferență: Modelele 2B excelează în viteză, făcându-le potrivite pentru aplicații în timp real. Modelele 7B oferă o inferență mai rapidă în comparație cu LLM-urile mai mari, dar este posibil să nu se potrivească cu viteza fraților lor mai mici.

- Compatibilitate cadru: Ambele dimensiuni sunt compatibile cu cadre majore precum TensorFlow, PyTorch și JAX, permițând dezvoltatorilor să-și folosească mediul preferat.

Potrivirea Gemma potrivită nevoilor tale

Alegerea între dimensiune și tuning depinde de cerințele dumneavoastră specifice. Pentru scenarii cu resurse limitate și sarcini simple, modelul de bază 2B este un punct de plecare excelent. Dacă acordați prioritate performanței și complexității în anumite domenii, varianta reglată cu instrucțiuni 7B ar putea fi campionul dvs. Amintiți-vă, reglarea fină a oricărei dimensiuni permite personalizarea suplimentară pentru cazul dvs. unic de utilizare.

Amintiţi-vă: Aceasta este doar o privire asupra variantelor Gemma. Cu opțiunile sale diverse și natura open-source, Gemma dă putere dezvoltatorilor să exploreze și să-și elibereze potențialul pentru diverse aplicații.

Noțiuni introductive cu Gemma

Gemma, familia impresionantă a Google de modele de limbaj mari (LLM) open-source, deschide uși dezvoltatorilor și cercetătorilor pentru a explora potențialul AI la îndemâna lor. Să vedem cum poți instalați și rulați Gemma, accesați modele pre-instruite, și construiți-vă propriile aplicații folosind diversele sale capacități.

Platform Agnostic: Gemma pe CPU, GPU sau TPU

Gemma se mândrește cu flexibilitatea platformei, permițându-vă să o rulați pe diverse configurații hardware. Pentru Configurații bazate pe CPU, biblioteca Hugging Face Transformers și interpretul Google Tensorflow Lite oferă opțiuni eficiente. Dacă aveți acces la GPU-uri sau TPU-uri, profitați de puterea maximă a TensorFlow pentru o performanță accelerată. Pentru implementările bazate pe cloud, luați în considerare Google Cloud Vertex AI pentru integrare și scalabilitate fără probleme.

Accesați modele gata de utilizare

Modelele pre-antrenate ale lui Gemma vin în diferite dimensiuni și capacități, răspunzând nevoilor diverse. Pentru generarea de text, traducere și sarcini de răspuns la întrebări, variantele Gemma 2B și 7B oferă performanțe impresionante. În plus, modelele reglate cu instrucțiuni, cum ar fi Gemma 2B-FT și 7B-FT, sunt concepute special pentru reglarea fină a propriilor seturi de date, deblocând personalizarea ulterioară.

Explorați capacitățile lui Gemma

Să explorăm câteva aplicații interesante pe care le puteți construi cu Gemma:

- Povestiri captivante: Generați narațiuni realiste și captivante folosind capabilitățile de generare de text.

- Traducerea limbii ușoară: Traduceți textul fără probleme între limbi cu priceperea multilingvă a lui Gemma.

- Dezvăluirea cunoștințelor: Implementați modele de întrebări-răspuns pentru a oferi răspunsuri informative și perspicace.

- Generarea de conținut creativ: Experimentați cu poezie, scenarii sau generarea de coduri, depășind granițele AI creative.

Reglaj fin și personalizare

Adevărata putere a lui Gemma constă în capacitățile sale de reglare fină. Utilizați propriile seturi de date pentru a adapta modelul la nevoile dvs. specifice și pentru a obține performanțe de neegalat. Articolele de referință furnizate oferă instrucțiuni detaliate despre reglaj fin și personalizare, dându-vă puterea să deblocați întregul potențial al Gemma.

A începe cu Gemma este o călătorie interesantă. Cu natura sa accesibilă, capabilitățile diverse și sprijinul vibrant al comunității, Gemma deschide o lume de posibilități atât pentru dezvoltatori, cât și pentru cercetători. Așadar, scufundă-te în lumea LLM-urilor cu sursă deschisă și dezlănțuiește puterea Gemma în următorul tău proiect AI!

Viitorul Gemmai

Natura open-source a lui Gemma și performanța impresionantă au stârnit un zgomot semnificativ în comunitatea LLM.

Dar ce urmează pentru această familie de modele în plină dezvoltare?

- Progrese în peisajul LLM: Natura open-source a lui Gemma încurajează colaborarea și inovația. Cercetătorii și dezvoltatorii din întreaga lume pot contribui la dezvoltarea sa, accelerând progresul în domenii precum interpretabilitatea, corectitudinea și eficiența. S-ar putea să o vedem pe Gemma în fruntea explorării LLM-urilor multimodale, capabile să proceseze și să genereze nu numai text, ci și imagini, audio și video.

- Perspectivă optimistă: Cu abordarea sa democratizantă și capabilitățile impresionante, Gemma reprezintă un pas semnificativ către a face AI accesibilă și benefică pentru toată lumea. Pe măsură ce dezvoltarea progresează, ne putem aștepta la și mai multe aplicații și progrese inovatoare. Natura open-source a lui Gemma încurajează o comunitate vibrantă, asigurând evoluția continuă și impactul acesteia asupra viitorului LLM-urilor.

Concluzie

Sosirea Gemmai în peisajul LLM marchează un punct de cotitură semnificativ. Spre deosebire de verii săi mai mari, care consumă mai mult resurse, Gemma oferă accesibilitate și flexibilitate, făcând capabilități avansate de inteligență artificială disponibile unui public mai larg. Natura sa open-source alimentează inovația și colaborarea, accelerând progresul în procesarea limbajului natural și modelând viitorul AI.

Intrebari cu cheie

- Ușoare și open-source: Dimensiunea mai mică și disponibilitatea deschisă a lui Gemma îl fac accesibil pe diverse platforme, dând putere persoanelor și organizațiilor mai mici să exploreze potențialul AI.

- Diverse variante și capacități: Cu mai multe dimensiuni și opțiuni reglate cu instrucțiuni, Gemma răspunde nevoilor diverse, de la răspunsuri de bază la întrebări până la generarea de conținut complex.

- Deblocarea potențialului prin personalizare: Capacitățile de reglare fină permit utilizatorilor să adapteze Gemma la nevoile lor specifice, deblocând noi posibilități în diverse domenii.

- O comunitate vibrantă și un viitor luminos: Natura open-source a lui Gemma încurajează o comunitate de colaborare, conducând progrese în interpretabilitate, corectitudine și capabilități multimodale.

Link-uri importante

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/