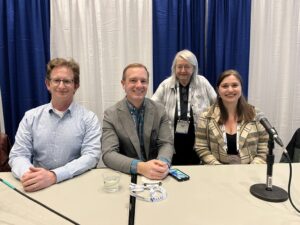

CCC wsparło trzy sesje naukowe podczas tegorocznej Dorocznej Konferencji AAAS, a jeśli nie mogli Państwo uczestniczyć osobiście, podsumujemy każdą sesję. W tym tygodniu podsumujemy najważniejsze wystąpienia panelistów z sesji: „Modele wielkojęzyczne: pomocni asystenci, romantyczni partnerzy czy oszuści?” Panel ten, moderowany przez Doktor Maria Gini, członek Rady CCC oraz profesor informatyki i inżynierii na Uniwersytecie w Minnesocie Doktor Ece Kamar, dyrektor zarządzający AI Frontiers w Microsoft Research, Doktor Hal Daume III, profesor informatyki na Uniwersytecie Maryland i Doktor Jonathan May, profesor informatyki w Instytucie Nauk Informacyjnych Uniwersytetu Południowej Kalifornii.

Modele wielkojęzyczne są dziś w centrum dyskusji w społeczeństwie i jury nie może się doczekać, czy sprostają otaczającemu je szumowi. Paneliści tej sesji AAAS zajęli się możliwościami, wyzwaniami i potencjałem LLM.

Pierwszym panelistą był dr Ece Kamar (Microsoft Research). Opisała obecny stan sztucznej inteligencji jako „przejście fazowe”. Jako osoba, która widziała zmiany w sztucznej inteligencji w przemyśle i wykładniczy rozwój modeli głębokiego uczenia się, który według niewielu osób przewidywał, że będzie kontynuowany do 2024 r., zapewniła wyjątkową perspektywę.

Wzrost był spowodowany wzrostem ilości danych, na których szkolone są LLM, oraz większą architekturą zwaną transformatorami. Ciekawym spostrzeżeniem, którym dr Kamar podzielił się na wykresie, jest to, że modele skalują się tak szybko, ponieważ początkowo zostały przeszkolone do określonego zadania; zadanie, które mogliby rzetelnie wykonać. ChatGPT wykazało, że jeśli skalowanie będzie wystarczająco duże, łącznie z liczbą parametrów uwzględnianych przez model, modele będą mogły rozpocząć wykonywanie zadań z wydajnością podobną do modelu, który został przeszkolony do wykonywania tych samych zadań.

Oto definicja przejścia fazowego LLM: modele nie muszą już być specjalnie szkolone do konkretnego zadania, ale można je ogólnie przeszkolić, a następnie wykonywać wiele zadań. I nic nie wskazuje na to, aby rozwój tych zdolności miał wyhamować.

Doktor Kamar miała wcześniejszy dostęp do GPT-4 i podczas długiego testowania go była pod wrażeniem jego znaczących ulepszeń wynikających ze skali i danych, a także faktu, że mógł on synchronicznie wykonywać różne zadania.

Jaka przyszłość czeka te LLM? Dr Kamar przewiduje, że LLM wykroczą poza język ludzki i nauczą się języka maszynowego oraz będą w stanie tłumaczyć między obydwoma językami. Zwiększyłoby to możliwości modalności w zakresie danych wejściowych i wyjściowych, co mogłoby doprowadzić do powstania modeli umożliwiających nie tylko generowanie języka, ale także działań i przewidywań w zakresie zachowań.

Następnie dr Kamar rozwinął kwestię znaczących przejść fazowych zachodzących w informatyce. Obecnie systemy są opracowywane w bardzo różny sposób, a rozwój ten będzie wymagał stworzenia nowego paradygmatu obliczeniowego, którego obecnie mamy zaledwie zarys. Sposób, w jaki współdziałamy z komputerami, będzie wyglądał zupełnie inaczej w nadchodzących latach, co będzie wymagało ponownego przemyślenia interakcji człowiek-komputer (HCI).

Kolejną zmianą jest sposób, w jaki ludzie będą pracować w przyszłości. Firma Microsoft przeprowadziła badania, które wykazały, że produktywność pracowników może się podwoić pod względem liczby linii kodu napisanych przy wsparciu sztucznej inteligencji. To niesamowity wyczyn, ale sposób, w jaki działa ta technologia i skąd pochodzi jej inteligencja, jest w dużej mierze nieznany, dlatego istnieje wiele pytań badawczych w tej dziedzinie.

Istnieje również wiele pytań dotyczących potencjalnego niewłaściwego wykorzystania takich LLM. Istnieją obawy dotyczące sprawiedliwości, różnych zagrożeń demograficznych i innych, jeszcze bardziej drastycznych konsekwencji. Chociaż istnieje ogromny potencjał odkryć naukowych, istnieje również duży potencjał wyrządzenia szkody; na przykład przekonanie rodziców, aby nie szczepili swoich dzieci, aby dziecko zrobiło coś złego lub przekonanie kogoś, że świat jest płaski. Wiele wysiłków w zakresie bezpieczeństwa włożono w rozwój LLM, a otwarte pozyskiwanie może być bardzo pomocne w osiągnięciu postępu również w tej dziedzinie.

Następnie dr Kamar zadał społeczności naukowej pytania:

- Jak zmieni się nauka po zakłóceniu sztucznej inteligencji?

- Czy podejmujemy kroki, aby zmienić sposób, w jaki kształcimy i szkolimy kolejne pokolenia?

- Czy budujesz infrastrukturę technologiczną, aby skorzystać z tej przemiany fazowej?

- Czy przygotowujemy przyszłe pokolenia na nowy świat?

Na koniec dr Kamar podkreślił, że jednym z kluczowych aspektów przejścia fazowego, który jest niezwykły, jest prędkość, z jaką rozwijają się LLM. Modele te ulegają znacznej poprawie w bardzo krótkim czasie, a badacze zajmujący się informatyką mają wiele do nadrobienia.

Drugi panelista, dr Hal Daumé III (Uniwersytet Maryland), rozpoczął swoje wystąpienie od wyjaśnienia, że należy opracować modele sztucznej inteligencji, aby pomóc ludziom robić to, co chcą; usprawniać ludzką pracę, a nie automatyzować. Ta wizja automatyzacji przenika społeczeństwo od lat 60-tych. Zamiast pomagać ludziom lepiej grać w szachy, naukowcy zaprojektowali system, który sam gra w szachy.

Ta filozofia donikąd nie prowadzi; Sztuczna inteligencja jest dziś nadal warta uwagi, jeśli jest wystarczająco inteligentna, aby samodzielnie wykonać zadanie. To jest głęboko we krwi AI. Zanim poświęcimy czas i pieniądze na automatyzację systemu, powinniśmy najpierw zatrzymać się i zadać sobie pytanie, czy leży to w naszym interesie?

Dr Daumé forsował koncepcję wzmacniania: w jaki sposób można wykorzystać sztuczną inteligencję jako narzędzie? Systemy takie jak Github copilot zwiększają produktywność, ale zwiększenie produktywności nie wystarczy. Użytkownik systemu wykrzyknął, że pozwolił mu skupić się na fragmentach kodowania, które sprawiały mu przyjemność, co znacznie bardziej odpowiada sposobowi budowania sztucznej inteligencji.

Badacze sztucznej inteligencji nie powinni chcieć usuwać z pracy tych części pracy, które sprawiają przyjemność; powinni priorytetowo traktować usunięcie harówki. Powinno poprawiać jakość życia ludzi, a nie tylko poprawiać wyniki finansowe firmy.

Dr Daumé był współautorem artykułu poruszającego te kwestie i pojawił się kontrargument, że z technicznego punktu widzenia budowanie systemów wykorzystujących w szczególności technologię uczenia maszynowego jest często dużo łatwiej zautomatyzować niż rozszerzać. Dzieje się tak dlatego, że dane niezbędne do wytrenowania systemu, które będą wytrenować system, są łatwo dostępne. Dostarczamy te informacje, wykonując naszą pracę, a wyszkolenie uczenia maszynowego w taki sposób, aby naśladowało ludzkie zachowanie, jest łatwe. O wiele trudniej jest nauczyć system, aby pomagał komuś w wykonaniu zadania. Informacje te są rozproszone wśród przeglądów literatury NSF, zapisów na kartce papieru przez programistę itp. Dane niezbędne do pomocy człowiekowi w wykonywaniu zadań nie są rejestrowane.

Innym kluczowym aspektem budowania pomocnych systemów jest pytanie użytkownika, jakie systemy byłyby pomocne w jego życiu. Na przykład potrzeby osób niewidomych bardzo różnią się od potrzeb osób widzących (które różnią się także od potrzeb osób widzących myśleć potrzeby osób niewidomych). Przykładem, który podał dr Daumé, był system wizualny, który może ujawnić, że przedmiot to puszka napoju gazowanego, ale osoba niewidoma zazwyczaj jest w stanie to rozpoznać samodzielnie. Składniki sody byłyby dla nich znacznie bardziej przydatne. Istnieje ogromna przepaść pomiędzy jakością odpowiedzi systemów na proste pytania dotyczące zrozumienia a odpowiedzią na pytania dotyczące dostępności i ta przepaść się pogłębia.

Dodatkowym przykładem tego, jak ważne jest określenie potrzeb społeczności przed stworzeniem technologii, która ma im „pomóc”, jest moderowanie treści. Wielu moderatorów treści-wolontariuszy angażuje się w tę pracę, ponieważ chcą uczynić świat lepszym miejscem i pomóc w budowaniu społeczności, która ich zdaniem jest ważna. Zapytani o to, jakiego rodzaju narzędzia chcą pomóc w swojej roli, często nie chcą, aby ich praca była w pełni zautomatyzowana, chcą po prostu, aby nudne części, takie jak przeglądanie historii czatów, były łatwiejsze.

Doktor Daumé kończy tę dyskusję ostatnim przykładem swojej kochającej samochody mamy, która kocha samochody, ale nie chce jeździć samochodami z napędem automatycznym. Wybiera manualną skrzynię biegów i bardzo ważny jest dla niej wybór. Ludzie powinni mieć kontrolę nad tym, czy chcą, aby ich zadania były zautomatyzowane, czy nie.

Dr Daumé kontynuuje rozmowę, oferując alternatywy dla obecnego podejścia do technologii dostępności. Na przykład podczas tworzenia narzędzia opartego na rozpoznawaniu języka migowego zamiast przeszukiwać Internet w poszukiwaniu filmów przedstawiających osoby podpisujące się (co wiąże się z wieloma obawami dotyczącymi zgody i prywatności, a ponadto większość tych filmów jest napisana przez profesjonalistów i nie powoduje hałasu/rozpraszania uwagi, co nie jest t realistyczne), skontaktuj się ze społecznością i zainicjuj projekt, który umożliwi jej przesyłanie filmów wideo w celu szkolenia narzędzi. Takie strategie zorientowane na społeczność są bardziej etyczne i odpowiedzialne oraz dają użytkownikom większą kontrolę.

Należy opracować narzędzia LLM i inne narzędzia, tak aby priorytetowo traktować użyteczność, a nie inteligencję, podsumowuje dr Daumé. Im bardziej jest użyteczny, tym bardziej może pomóc ludziom zrobić coś, czego nie mogą lub nie chcą zrobić, zamiast automatyzować coś, co ludzie już robią dobrze i co sprawia im przyjemność.

Kolejnym prelegentem był dr Jonathan May (Instytut Nauk Informacyjnych Uniwersytetu Południowej Kalifornii), który rozpoczął swoje wystąpienie od refleksji nad tematem konferencji: „W stronę nauki bez murów”. Twierdzi, że chociaż niedawny rozwój LLM w przypadku niektórych osób burzy mury, dla wielu je buduje.

Najpierw omawia, jak Internet obniżył wiele barier w prowadzeniu badań; mając 17 lat, zastanawiał się, dlaczego „Gwiezdne Wojny” i „Władca Pierścieni” mają bardzo podobną fabułę, więc musiał pojechać do biblioteki i znaleźć książkę zawierającą odpowiedź. Do swojej pracy doktorskiej przeprowadził bardzo wymagające, ale równie żmudne badania, ale pod koniec studiów utworzono na ten temat stronę w Wikipedii, następnie przeszukano Internet i obecnie badania bez samochodu są normą.

Doktor May kontynuował, mówiąc, że czuje się zaszczycony, że znajduje się w grupie docelowej docelowych odbiorców szkół wyższych. Nie koduje często i nigdy nie nauczył się zbyt wielu umiejętności kodowania, ale kiedy potrzebuje tego do swojej pracy, może poprosić ChatGPT i radzi sobie świetnie.

Istnieje jednak wiele przeszkód utrudniających powszechność użyteczności LLM:

- Ściany językowe: modele działają lepiej, im więcej danych są trenowane. Chociaż dzisiejsze komercyjne LLM są wielojęzyczne, w dużym stopniu skupiają się na języku angielskim. Na przykład ChatGPT jest przeszkolony w 92% języka angielskiego. Co więcej, dane instrukcji, które są „tajnym sosem” LLM, są w zdecydowanej większości angielskie (na przykład 96% ChatGPT). Obecnie podejmuje się bardzo niewiele wysiłków na rzecz poprawy wydajności tych modeli w różnych językach, pomimo systemowych luk w wydajności istniejących testów, co ma sens ze względu na ogólny konsensus, że tłumaczenie maszynowe (MT) zostało „rozwiązane” i wysiłki należy skoncentrować na innych zadaniach.

- Ściany tożsamości: Jeśli zapytasz ChatGPT, co powinieneś robić w Boże Narodzenie, skupi się on na różnych działaniach i tradycjach, w które możesz się zaangażować; nie ma tam wzmianki o tym, że możesz iść do pracy. Wykazano, że osoby LLM zachowują się odmiennie, opisując różne grupy demograficzne, wyrażając bardziej negatywne nastroje, a w niektórych przypadkach nawet wręcz toksyczność. Istnieje prawdopodobieństwo, że stereotypowe zdania mogą wyrządzić krzywdę w społecznościach takich jak LGBTQ+ lub Żydzi; ogólnie rzecz biorąc, istnieje wiele stronniczości, co ma konsekwencje w podejmowaniu decyzji. Istnieją pewne wbudowane zabezpieczenia i istnieje mniejsze prawdopodobieństwo, że bardziej wyraźne pytania sondujące otrzymają toksyczne odpowiedzi, ale modele prawdopodobnie preferują stereotypowe stwierdzenia i wyniki, i właśnie tam powstają szkody, zwłaszcza gdy używa się modeli w dalszych możliwościach, gdzie nie widać produkt końcowy (tj. kwalifikowalność pożyczki). Podał przykład menedżerów LLM wykazujących stronniczość przy tworzeniu twarzy osób na podstawie ich pracy; na stanowiskach gorzej płatnych przedstawiono kobiety i mniejszości, natomiast na stanowiskach lepiej płatnych są biali mężczyźni.

- Ściany środowiskowe (oprogramowanie): LLM wymagają znacznej ilości energii do wytworzenia i działania. Nawet najbardziej „skromne” LM zużywają 3 razy więcej energii rocznie niż zużywa jedna osoba. Istnieje również znaczna luka w danych dla największych modeli językowych, takich jak ChatGPT, ale firmy będące ich właścicielami wyraźnie odmawiają dostępu do zużycia energii.

- Ściany środowiskowe (sprzęt): Do produkcji chipów, których wymagają wszystkie LLM, potrzebne są „materiały konfliktowe”, takie jak tantal (wydobywany w Kongo) i hafn (wydobywany w Senegalu i Rosji). W USA firmy mają obowiązek zgłaszać ilość wykorzystywanych przez siebie minerałów z regionów konfliktowych, lecz Stany Zjednoczone publicznie pokazują spadek wykorzystania tych materiałów, co nie może być prawdą. Poza tym istnieje wiele problemów społeczno-politycznych, takich jak ograniczenie przez Chiny germanu i galu w odwecie za amerykańskie ograniczenia eksportowe.

Dr May twierdzi, że te kategorie ujawniają niektóre z wielu dalszych problemów związanych ze szkodami powodowanymi przez LLM oraz przypadki, w których ludzie nie odnoszą korzyści. Istnieje powód do niepokoju, ale istnieją również możliwości przeprowadzenia badań i/lub zmian w zachowaniu, które złagodziłyby niektóre z tych szkód:

- Język: Poświęć więcej środków na badania wielojęzyczności (a nie tylko hegemonicznemu tłumaczeniu na i z języka angielskiego).

- Tożsamość: Badania oddolne i włączające społeczność. Modyfikacja modelu i testowanie przed wdrożeniem

- Środowisko: opracowanie algorytmu, który wykorzystuje mniej danych i zmienia mniej parametrów (np. LoRA, adaptery, PO inne niż RL). Zachowaj skrupulatność w zakresie obliczeń i nalegaj na otwartość na poziomach regulacyjnych

Dr May zakończył panel, powtarzając uwagę dr Daumé, że ludzie powinni odnosić korzyści w taki sposób, w jaki chcą, aby korzystali z nich podczas interakcji z LLM, i należy o tym pamiętać na etapie opracowywania.

Dziękuję bardzo za przeczytanie i zapraszamy jutro do zapoznania się z podsumowaniem części sesji z pytaniami i odpowiedziami.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://feeds.feedblitz.com/~/874484594/0/cccblog~CCC-AAAS-Large-Language-Models-Helpful-Assistants-Romantic-Partners-or-Con-Artists-Part-One/