Zdjęcie autora

Modele wielkojęzykowe (LLM) to nowy typ sztucznej inteligencji szkolony na ogromnych ilościach danych tekstowych. Ich główną zdolnością jest generowanie tekstu podobnego do ludzkiego w odpowiedzi na szeroki zakres podpowiedzi i żądań.

Założę się, że masz już pewne doświadczenie z popularnymi rozwiązaniami LLM, takimi jak ChatGPT lub Google Gemini.

Ale czy zastanawiałeś się kiedyś, w jaki sposób te potężne modele zapewniają tak błyskawiczną reakcję?

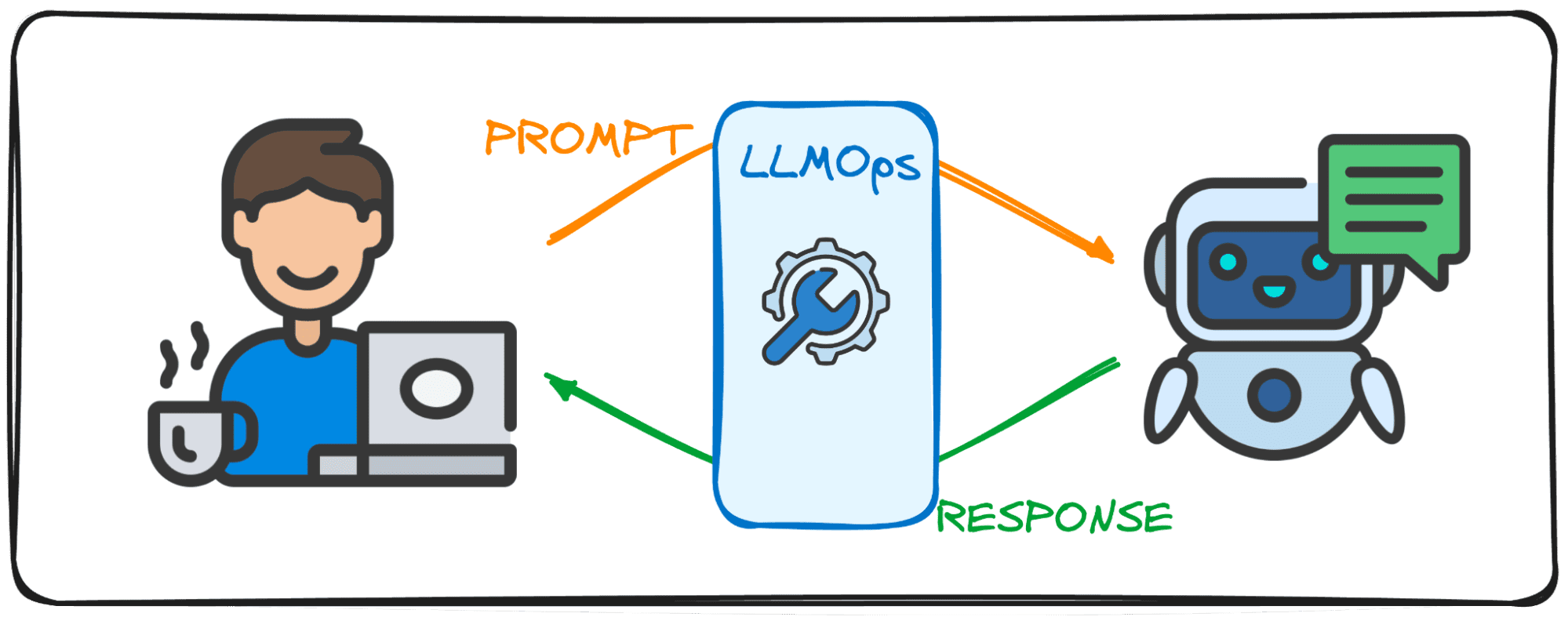

Odpowiedź leży w wyspecjalizowanej dziedzinie zwanej LLMOps.

Zanim zagłębimy się w szczegóły, spróbujmy wyobrazić sobie znaczenie tej dziedziny.

Wyobraź sobie, że rozmawiasz z przyjacielem. Normalną rzeczą, której można się spodziewać, jest to, że gdy zadajesz pytanie, natychmiast udzielają odpowiedzi, a dialog toczy się bez wysiłku.

Dobrze?

Ta płynna wymiana jest tym, czego oczekują użytkownicy podczas interakcji z modelami dużego języka (LLM). Wyobraź sobie, że rozmawiasz z ChatGPT i musisz czekać kilka minut za każdym razem, gdy wysyłamy monit, nikt by z niego nie skorzystał, przynajmniej ja nie byłbym tego pewien.

Właśnie dlatego firmy LLM dążą do osiągnięcia tego przepływu rozmów i efektywności w swoich rozwiązaniach cyfrowych za pomocą pola LLMOps. Ten przewodnik ma być Twoim towarzyszem w pierwszych krokach w tej zupełnie nowej domenie.

LLMOps, skrót od Large Language Model Operations, to zakulisowa magia, która zapewnia wydajne i niezawodne działanie LLM. Stanowi postęp w stosunku do znanych MLOps, zaprojektowanych specjalnie w celu sprostania unikalnym wyzwaniom stawianym przez LLM.

Podczas gdy MLOps koncentruje się na zarządzaniu cyklem życia ogólnych modeli uczenia maszynowego, LLMOps zajmuje się w szczególności wymaganiami specyficznymi dla LLM.

Podczas korzystania z modeli podmiotów takich jak OpenAI lub Anthropic za pośrednictwem interfejsów internetowych lub API, LLMOps działają za kulisami, udostępniając te modele jako usługi. Jednak przy wdrażaniu modelu dla specjalistycznej aplikacji odpowiedzialność LLMOps spoczywa na nas.

Pomyśl o tym jak o moderatorze dbającym o przebieg debaty. Podobnie jak moderator dba o to, aby rozmowa przebiegała sprawnie i była zgodna z tematem debaty, zawsze upewniając się, że nie ma w niej żadnych przykrych słów i starając się unikać fałszywych wiadomości, tak LLMOps dba o to, aby LLM działały z najwyższą wydajnością, zapewniając użytkownikom bezproblemową obsługę i sprawdzając bezpieczeństwo wyjście.

Tworzenie aplikacji za pomocą modeli wielkojęzycznych (LLM) wiąże się z wyzwaniami odmiennymi od tych spotykanych w przypadku konwencjonalnego uczenia maszynowego. Aby sobie z nimi poradzić, stworzono innowacyjne narzędzia i metodologie zarządzania, które dały początek platformie LLMOps.

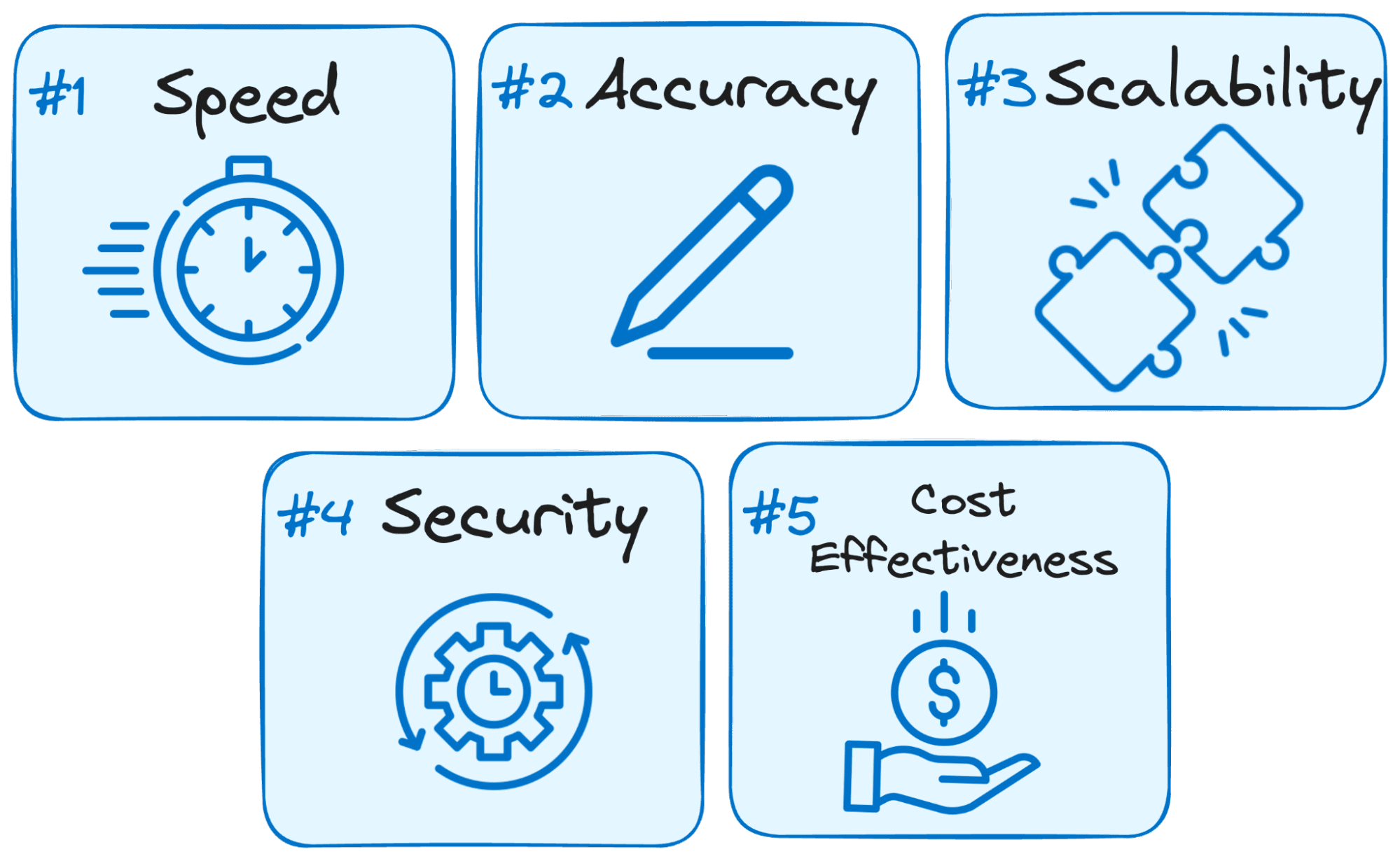

Oto dlaczego LLMOps ma kluczowe znaczenie dla powodzenia każdej aplikacji opartej na LLM:

Zdjęcie autora

- Szybkość jest kluczem: Użytkownicy oczekują natychmiastowych reakcji podczas interakcji z LLM. LLMOps optymalizuje proces, aby zminimalizować opóźnienia, zapewniając uzyskanie odpowiedzi w rozsądnym terminie.

- Dokładność ma znaczenie: LLMOps wdraża różne kontrole i kontrole, aby zagwarantować dokładność i trafność odpowiedzi LLM.

- Skalowalność na potrzeby wzrostu: W miarę jak Twoja aplikacja LLM zyskuje na popularności, LLMOps pomaga efektywnie skalować zasoby, aby obsłużyć rosnące obciążenie użytkowników.

- Bezpieczeństwo jest najważniejsze: LLMOps zabezpiecza integralność systemu LLM i chroni wrażliwe dane, egzekwując solidne środki bezpieczeństwa.

- Opłacalność: Operacyjne LLM mogą być wymagające finansowo ze względu na znaczne wymagania dotyczące zasobów. LLMOps wykorzystuje ekonomiczne metody efektywnego maksymalizacji wykorzystania zasobów, zapewniając, że maksymalna wydajność nie zostanie poświęcona.

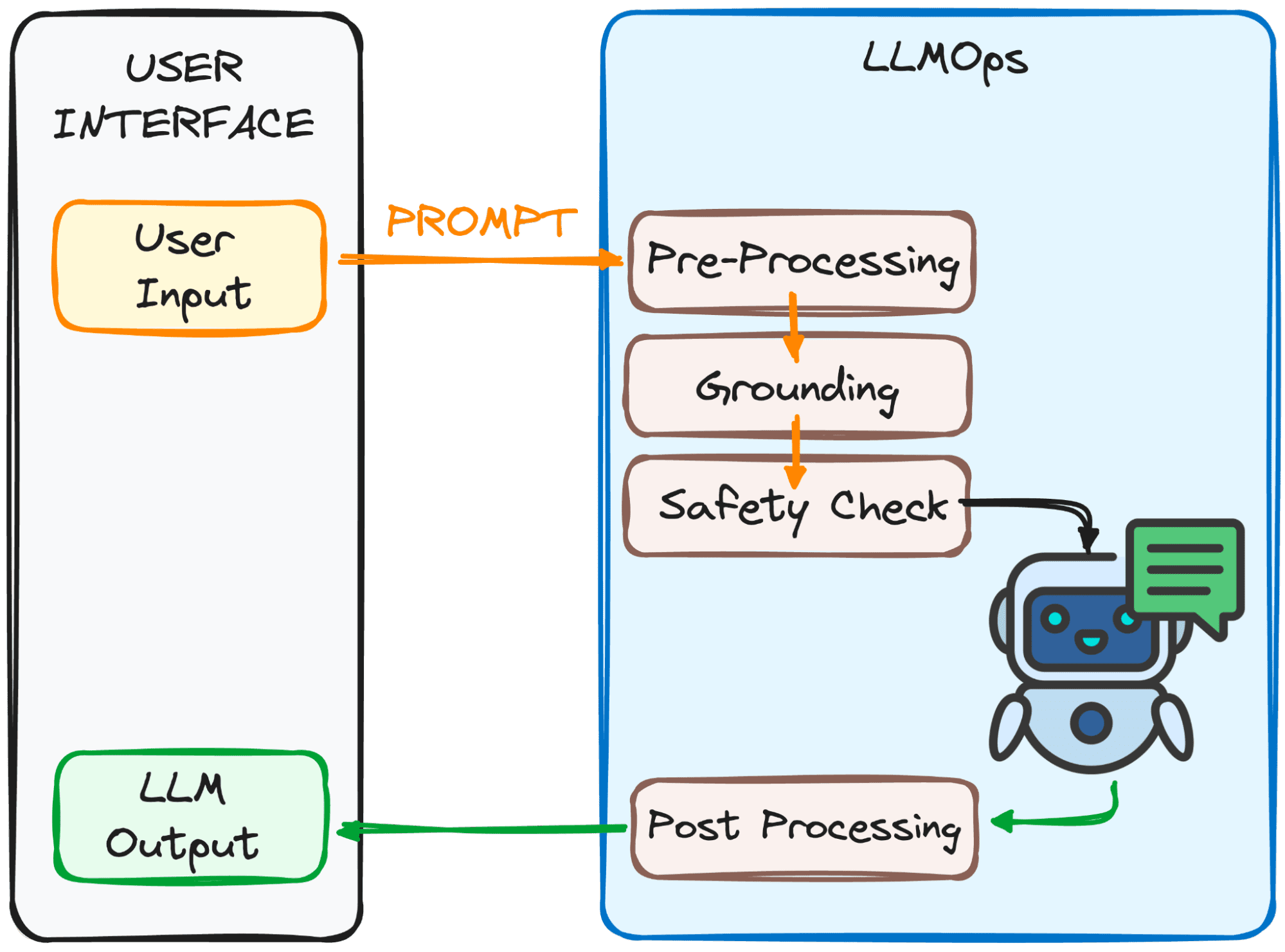

LLMOps upewnia się, że Twój monit jest gotowy na LLM, a odpowiedź wraca do Ciebie tak szybko, jak to możliwe. Jednak to wcale nie jest łatwe.

Proces ten składa się z kilku etapów, głównie 4, które można zaobserwować na poniższym obrazku.

Zdjęcie autora

Cel tych kroków?

Aby podpowiedzi były jasne i zrozumiałe dla modelu.

Oto zestawienie tych kroków:

1. Wstępne przetwarzanie

Podpowiedź przechodzi przez pierwszy etap przetwarzania. Po pierwsze, jest on dzielony na mniejsze części (żetony). Następnie wszelkie literówki i dziwne znaki są usuwane, a tekst jest spójnie sformatowany.

Na koniec tokeny są osadzone w danych liczbowych, aby LLM mógł je zrozumieć.

2. Uziemienie

Zanim model przetworzy nasz monit, musimy się upewnić, że model rozumie szerszą sytuację. Może to obejmować odwoływanie się do wcześniejszych rozmów, które odbyłeś z LLM lub wykorzystanie informacji zewnętrznych.

Dodatkowo system identyfikuje ważne rzeczy wspomniane w pytaniu (takie jak nazwy lub miejsca), dzięki czemu odpowiedź jest jeszcze bardziej trafna.

3. Kontrola bezpieczeństwa:

Podobnie jak w przypadku zasad bezpieczeństwa, LLMOps dba o to, aby monit był właściwie używany. System sprawdza takie informacje, jak informacje wrażliwe lub potencjalnie obraźliwe treści.

Dopiero po przejściu tych kontroli, zachęta jest gotowa do głównego aktu – LLM!

Teraz mamy gotowy monit do przetworzenia przez LLM. Jednak jego wyniki również wymagają analizy i przetworzenia. Zanim to zobaczysz, w czwartym kroku należy wykonać jeszcze kilka korekt:

3. Obróbka końcowa

Pamiętasz kod, na który przekonwertowano zachętę? Odpowiedź należy ponownie przetłumaczyć na tekst zrozumiały dla człowieka. Następnie system dopracowuje odpowiedź pod kątem gramatyki, stylu i przejrzystości.

Wszystkie te kroki przebiegają płynnie dzięki LLMOps, niewidzialnemu członkowi załogi zapewniającemu płynne doświadczenie LLM.

Imponujące, prawda?

Oto niektóre z podstawowych elementów dobrze zaprojektowanej konfiguracji LLMOps:

- Wybór odpowiedniego LLM: Dzięki szerokiej gamie dostępnych modeli LLM, LLMOps pomaga wybrać ten, który najlepiej odpowiada Twoim konkretnym potrzebom i zasobom.

- Dostrajanie pod kątem specyficzności: LLMOps umożliwia dostrajanie istniejących modeli lub trenowanie własnych, dostosowując je do unikalnego przypadku użycia.

- Szybka inżynieria: LLMOps wyposaża Cię w techniki tworzenia skutecznych podpowiedzi, które kierują LLM w stronę pożądanego rezultatu.

- Wdrożenie i monitorowanie: LLMOps usprawnia proces wdrażania i stale monitoruje wydajność LLM, zapewniając optymalną funkcjonalność.

- Zabezpieczenia: LLMOps priorytetowo traktuje bezpieczeństwo danych, wdrażając solidne środki ochrony wrażliwych informacji.

W miarę ewolucji technologii LLM, LLMOps będzie odgrywać kluczową rolę w nadchodzącym rozwoju technologicznym. W dużej mierze sukces najnowszych popularnych rozwiązań, takich jak ChatGPT czy Google Gemini, leży w ich zdolności nie tylko do odpowiadania na wszelkie żądania, ale także zapewniania dobrego doświadczenia użytkownika.

Właśnie dlatego, zapewniając wydajne, niezawodne i bezpieczne działanie, LLMOps utoruje drogę dla jeszcze bardziej innowacyjnych i transformacyjnych zastosowań LLM w różnych branżach, które dotrą do jeszcze większej liczby osób.

Dzięki solidnej wiedzy na temat LLMOps jesteś dobrze przygotowany do wykorzystania mocy tych LLM i tworzenia przełomowych aplikacji.

Józefa Ferrera jest inżynierem analitykiem z Barcelony. Ukończył inżynierię fizyczną, a obecnie pracuje w dziedzinie analityki danych stosowanej w mobilności człowieka. Jest twórcą treści pracującym w niepełnym wymiarze godzin i skupiającym się na nauce i technologii danych. Josep pisze o wszystkim, co związane jest ze sztuczną inteligencją, opisując zastosowanie trwającej eksplozji w terenie.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions