Co więcej, kluczową kwestią jest to, w jaki sposób technologie sztucznej inteligencji mogą dostosować się do istniejących ekosystemów w ramach infrastruktur o wysokiej wartości i na które istnieje duże zapotrzebowanie, takich jak lotniska, samoloty i różne zaawansowane systemy mobilności, oraz zrewolucjonizować je.

Wykorzystując innowacyjne technologie sztucznej inteligencji i zalety platformy Uniwersytetu Cranfield, Kurs magisterski z zakresu sztucznej inteligencji stosowanej ma na celu kultywowanie przyszłych liderów w stosowanej sztucznej inteligencji w różnych dziedzinach inżynierii. Jego głównym celem jest przyspieszenie rozwoju i wdrożenia niezawodnych technologii sztucznej inteligencji do zastosowań o krytycznym znaczeniu dla bezpieczeństwa na całym świecie.

Projekt grupowy (GDP) to moduł uczenia się oparty na problemach, a celem PKB jest umożliwienie uczniom projektowania, wdrażania, sprawdzania i testowania systemów opartych na sztucznej inteligencji w czasie rzeczywistym w celu rozwiązywania problemów w świecie rzeczywistym. Celem PKB jest także zapewnienie studentom doświadczenia w pracy nad wspólnym projektem inżynierskim, spełniającym wymagania potencjalnego klienta i dotrzymującym terminów.

W latach 2022 i 2023 studentom studiów magisterskich na kierunku sztuczna inteligencja stosowana przydzielono stymulujący i wymagający projekt grupowy. Celem było wykorzystanie wiedzy stosowanej w zakresie sztucznej inteligencji zdobytej podczas zajęć do opracowania innowacyjnych i bezpieczniejszych produktów lotniskowych. Pracując w małych sześcioosobowych zespołach, uczniowie mieli za zadanie zaprojektować rozwiązania obejmujące architekturę oprogramowania i sprzętu, rozwój i testowanie modeli sztucznej inteligencji, a także aspekty zaangażowania w świecie rzeczywistym.

Temat projektu był celowo szeroki i wymagał od uczniów współpracy w swoich grupach w celu zbadania i udoskonalenia określonych obszarów zainteresowań w oparciu o ich wspólną wiedzę i zainteresowania. Takie podejście sprzyjało kreatywności, pracy zespołowej i głębszemu zrozumieniu praktycznego zastosowania technologii sztucznej inteligencji w rzeczywistych scenariuszach.

Każda grupa została poproszona o opracowanie rozwiązań AI działających w czasie rzeczywistym dla inteligentnych lotnisk w celu osiągnięcia następujących funkcjonalności:

- System będzie w stanie wykryć użytkowników i oszacować ich pozycje i zachowania w oparciu o precyzyjne wykrywanie i śledzenie pozycji.

- System będzie w stanie sklasyfikować różne zachowania tłumu i wyjaśnić przyczyny, znaczenie i wykonalność.

- Model sztucznej inteligencji należy zweryfikować krzyżowo za pomocą różnych wskaźników dotyczących dokładności, obliczeń i wnioskowania.

- Należy umożliwić wdrożenie modelu sztucznej inteligencji w czasie rzeczywistym, aby informować o zaletach i wadach obecnych technologii sztucznej inteligencji w zastosowaniach o krytycznym znaczeniu dla bezpieczeństwa.

- System może opierać się na różnych źródłach czujników jako danych wejściowych, aby umożliwić fuzję czujników w celu uzyskania niezawodnej wydajności, jednak mile widziane są również bardzo tanie, ale wydajne rozwiązania.

Studium przypadku 1: Wykrywanie upadku w środowisku obsługi technicznej statku powietrznego.

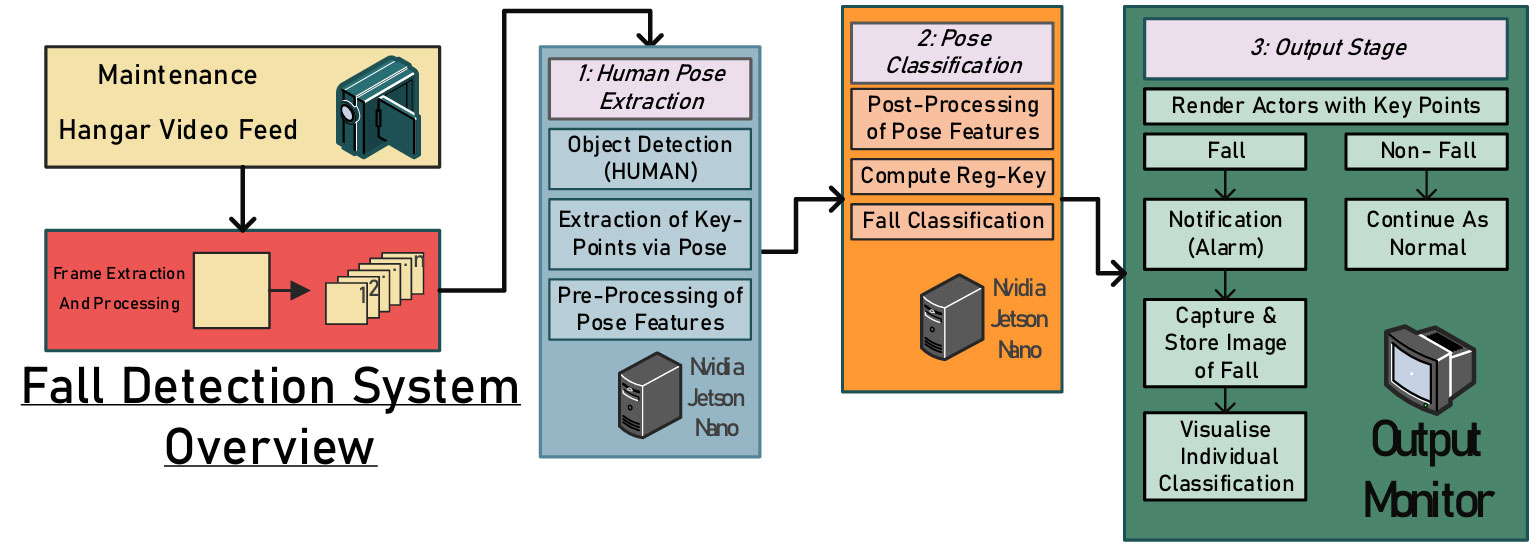

Środowiska konserwacyjne stwarzają poważne zagrożenia, w tym maszyny pozostawione bez nadzoru, nieodpowiednie ogrodzenie lub osłony fizyczne w pobliżu niebezpiecznych obszarów oraz zagracone przestrzenie robocze. Wśród tych zagrożeń alarmująco powszechne są śmiertelne urazy spowodowane upadkiem. Niezwłoczne wykrywanie i zgłaszanie incydentów innych niż śmiertelne może zapobiec dalszym szkodom lub ofiarom śmiertelnym. Dlatego w tej pracy zaproponowano zintegrowany system wizyjny do monitorowania pracowników podczas czynności związanych z obsługą techniczną statku powietrznego, zwiększający bezpieczeństwo i zapobiegający wypadkom (patrz rysunek poniżej).

.fusion-gallery-1 .fusion-gallery-image {border:0px solid #e2e2e2;}

Z wyników wstępnego szkolenia i walidacji zaprojektowanego modelu wynika, że wyraźny brak gotowego zbioru danych dotyczących konserwacji hangarów lotniskowych stwarza możliwość zafałszowania obrazów z filmów zarejestrowanych pod kątem prostym, zarejestrowanych z bliskiej odległości od obiektu. Wykorzystując zalety Cranfield, wybrano hangar konserwacyjny Uniwersytetu Cranfield i wykorzystano go do gromadzenia danych w tym projekcie.

W sumie nagrano około 50 krótkich (od dwóch do pięciu minut) filmów przedstawiających symulowane czynności konserwacyjne, niektóre z upadkami, inne bez. Przechwycone filmy podzielono na klatki i opatrzono adnotacjami przy użyciu biblioteki oprogramowania MoveNet do szacowania pozycji, a następnie wygenerowano mapy wektorowe kluczowych pozycji stawów osoby badanej. Poniższy rysunek przedstawia kilka migawek danych eksperymentalnych.

.fusion-gallery-2 .fusion-gallery-image {border:0px solid #e2e2e2;}

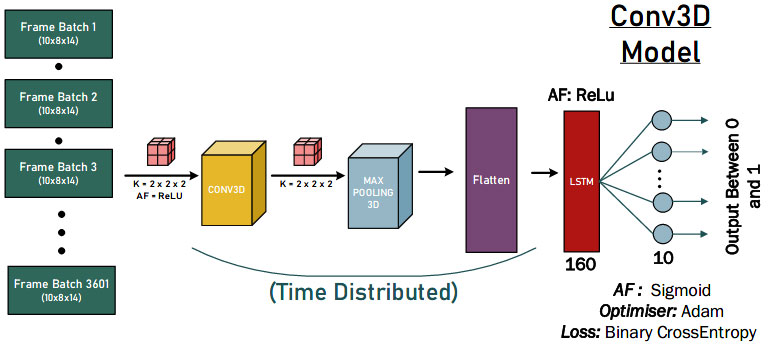

Nasi studenci przetestowali podejścia do splotowych sieci neuronowych 1-D, 2-D i 3-D, aby ilościowo ocenić projekt najpotężniejszego modelu sztucznej inteligencji. Poniższy rysunek przedstawia demonstrację rozwiązań splotu 3-D.

.fusion-gallery-3 .fusion-gallery-image {border:0px solid #e2e2e2;}

Wreszcie zaproponowane rozwiązania AI osiągnęły dobre wyniki w zakresie wykrywania upadku, jak pokazano na poniższym rysunku. Można wyciągnąć kilka wniosków. Po pierwsze, model miał klasyfikację 0 FP, co sugeruje, że model nie klasyfikuje błędnie upadku. Po drugie, dla każdego modelu istnieje 940 wyników prawdziwie negatywnych, co może prawdopodobnie wynikać z tego, że dane z każdego testu zawierają część przypadków, w których nie doszło do upadku (sklasyfikowanych jako 0), zanim aktor się przewróci.

.fusion-gallery-4 .fusion-gallery-image {border:0px solid #e2e2e2;}

Studium przypadku 2: Wykrywanie oznak życiowych zawału mięśnia sercowego za pomocą wizji komputerowej i sztucznej inteligencji

Edge AI odnosi się do wdrażania aplikacji sztucznej inteligencji na urządzeniach znajdujących się w całym środowisku fizycznym. Przystępność cenowa i łatwość użycia to kluczowe czynniki decydujące o przyjęciu algorytmów sztucznej inteligencji w sytuacjach, w których użytkownicy końcowi napotykają wyzwania w świecie rzeczywistym. W ramach tego projektu nasz student zaproponował tani i lekki model wykrywania zawału serca w celu szybkiego reagowania i ratownictwa na lotnisku. Proces składa się z czterech głównych etapów, jak pokazano na poniższym rysunku.

.fusion-gallery-5 .fusion-gallery-image {border:0px solid #e2e2e2;}

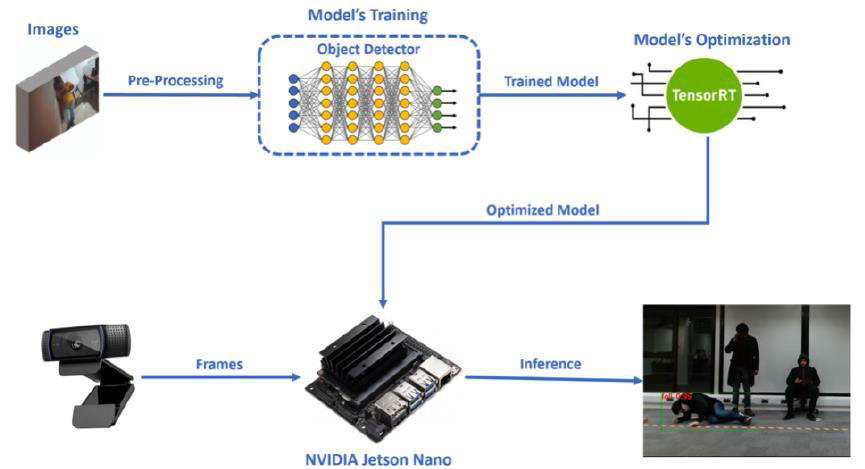

Pierwszy etap to odpowiedni dobór i przygotowanie zbioru danych obrazowych wraz z niezbędnymi adnotacjami dla obwiedni klas (ból w klatce piersiowej, upadek).

Ponadto drugim etapem jest szkolenie naszego modelu detektora obiektów poprzez uczenie się transferowe. Konkretny etap został wykonany w Google Colab, przy użyciu PyTorch. Następnie, po zakończeniu etapu szkolenia, model został wstawiony do Jetson Nano firmy NVIDIA, które było wybranym przez nas urządzeniem wbudowanym do wykorzystania w naszej aplikacji komputerowej wizyjnej Edge AI.

Trzecim etapem projektowania naszego systemu była odpowiednia konwersja i optymalizacja modelu, aby działał wydajniej na Jetson Nano. Optymalizacja naszego modelu została przeprowadzona przy użyciu silnika wnioskowania TensorRT firmy NVIDIA, a konkretny proces został wykonany w Jetson Nano (jak pokazano na rysunku poniżej).

.fusion-gallery-6 .fusion-gallery-image {border:0px solid #e2e2e2;}

Ostatnim krokiem jest wykonanie zoptymalizowanego modelu na Jetson Nano, wykorzystując jako dane wejściowe klatki otrzymane z kamery internetowej, w celu przeprowadzenia procesu wykrywania obiektów w czasie rzeczywistym i wykrywania naszych zajęć (ból w klatce piersiowej, upadek). Oprócz tego procesu w kodzie wnioskowania działającym na Jetson Nano istniały dwa konkretne scenariusze. Ostateczne wyniki wnioskowania przedstawiono na poniższym rysunku.

.fusion-gallery-7 .fusion-gallery-image {border:0px solid #e2e2e2;}

Studium przypadku 3: Monitorowanie tłumu i analiza dystansu społecznego

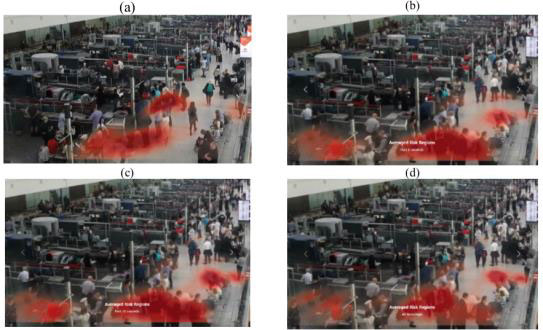

Porty lotnicze każdego dnia charakteryzują się ogromnym napływem pasażerów i podobnie jak inne zatłoczone lokalizacje i organizacje, muszą zapewniać bezpieczeństwo publiczne i wdrażać odpowiednie środki ograniczające ryzyko podczas pandemii. W ramach tego projektu nasi studenci zaproponowali zintegrowany system oparty na wizji komputerowej, który zapewnia wielofunkcyjne monitorowanie i analizę tłumu na lotniskach. Wyniki systemu mają przynieść korzyści zarówno pracownikom zarządzającym portami lotniczymi, jak i pasażerom, poprzez zapewnianie analiz i informacji opartych na danych tłumu.

System składa się ze zintegrowanej platformy (patrz rysunek poniżej) umożliwiającej analizę i monitorowanie tłumu w miejscach publicznych za pomocą sygnałów z monitoringu wideo. Nacisk położony jest w szczególności na inteligentne lotniska, ale podstawowe ramy można dostosować do każdego kontekstu publicznego, w którym przydatne jest analizowanie i monitorowanie cech tłumu.

.fusion-gallery-8 .fusion-gallery-image {border:0px solid #e2e2e2;}

Cechy ułożenia wyodrębnione ze sceny są wykorzystywane przez modele znajdujące się w dalszej części systemu do wykonywania unikalnych zadań. Obejmuje to liczenie osób, szacowanie odległości międzyludzkiej, wykrywanie obiektów-masek, klasyfikację statusu (siedzenie, stanie, chodzenie, leżenie itp.) oraz grupowanie społeczne. Wyniki są następnie łączone w celu utworzenia zintegrowanego pulpitu nawigacyjnego i systemu monitorowania. Z wyjątkiem powszechnego wykorzystania funkcji ułożenia, zadania te stanowią wyjątkowe wyzwania w przypadku różnych podejść do modelowania. Na szczęście dzięki modułowej konstrukcji systemu możliwe było wyabstrahowanie każdego zadania i zlecienie jego opracowywania różnym członkom zespołu.

.fusion-gallery-9 .fusion-gallery-image {border:0px solid #e2e2e2;}

Wreszcie, interaktywny interfejs został zaprojektowany w celu zintegrowania wszystkich dalszych wyników w jedną rzutnię (patrz rysunek poniżej). Aplikacja przesyła pliki danych utworzone przez kolejne modele do pulpitu w czasie rzeczywistym, dzięki czemu można przeprowadzić analizę bieżącego stanu sceny. W dowolnym momencie można wyświetlić oryginalny materiał filmowy z danej sceny wraz z cechami pozy wyodrębnionymi od każdej osoby na sąsiadującym z nią odtwarzaczu wideo. Osoba podejmująca decyzję może przełączać się między widokiem wykresu skrzynkowego a widokiem mapy cieplnej, a następnie zmieniać materiał, z którego dane są odbierane, z dwóch rozwijanych menu. Statystyki dotyczące sceny wyświetlane są po prawej stronie rzutni. Statystyki te obejmują stan maski całkowitej, całkowity profil ryzyka, status pozycji wszystkich osób, całkowitą liczbę osób, proporcje dystansu społecznego i wykres pudełkowy proporcji.

.fusion-gallery-10 .fusion-gallery-image {border:0px solid #e2e2e2;}

Studium przypadku 4: Wykrywanie przemocy na lotnisku

Wreszcie, jedna z naszych grup ma na celu opracowanie struktury wykrywania przemocy, która ocenia pozy ludzkie i klasyfikuje agresywne zachowania na nagraniach z monitoringu (jak pokazano na rysunku poniżej). Zamiast bezpośrednio wyodrębniać funkcje z klatek wideo, ta platforma wykorzystuje ViTPose do wykrywania ludzkich póz w każdej klatce, a następnie wstępnie przetwarza i wyodrębnia funkcje z informacji o kluczowych punktach.

.fusion-gallery-11 .fusion-gallery-image {border:0px solid #e2e2e2;}

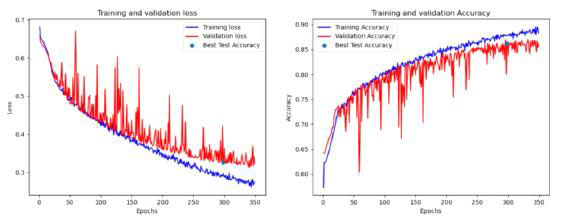

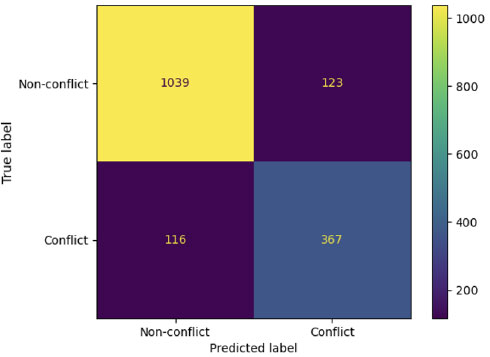

Dokonując kompleksowej analizy różnych modeli przy użyciu wielu zbiorów danych (sekwencji opartych na kącie, odległości, sekwencji 1-sekundowych i 2-sekundowych) obejmujących łącznie 162 kombinacje hiperparametrów, zespół ostatecznie zidentyfikował kilka obiecujących modeli, które spełniają określone kryteria oceny. Można stwierdzić, że modele mogą wydobywać cenne informacje na temat agresywnych zachowań, wykorzystując cechy odległości kluczowych punktów ciała, jak pokazano na poniższym rysunku.

.fusion-gallery-12 .fusion-gallery-image {border:0px solid #e2e2e2;}

Wreszcie, współpracując z Saab UK, nasi studenci mogą opracowywać i integrować swoje modele sztucznej inteligencji z platformą na poziomie przemysłowym (SAFE), potężną platformą świadomości sytuacyjnej powszechnie stosowaną na wielu brytyjskich komisariatach policji do celów inwigilacji. Brama KAFKA jest stosowana zgodnie z silnikiem AI i przekazywana do terminala klienta w celu dalszego wyświetlania i alertów. Jeśli w przechwyconym wideo z ramkami wykryty zostanie jakikolwiek akt przemocy, uruchomi się alarm, który skonfigurowaliśmy specjalnie dla naszego modelu, pokazujący przechwycone wideo w układzie klienta SAFE, a my otrzymamy komunikat ostrzegawczy ze szczegółami. Ostatecznie nasi uczniowie pomyślnie wdrożyli model sztucznej inteligencji z naszego centrum DARTeC i komunikowali się z systemem Saab SAFE w celu zwiększenia świadomości sytuacyjnej człowieka.

.fusion-gallery-13 .fusion-gallery-image {border:0px solid #e2e2e2;}

Tworzenie inżynierów stosowanych AI przyszłości

To tylko kilka wybranych przykładów ciekawych projektów PKB z kursu mgr AAI. Nasi obecni studenci podjęli ostatnio bardziej wymagające projekty PKB w możliwym do wytłumaczenia interfejsie ze sztuczną inteligencją, uzasadnieniem przyczynowym planowania ruchu autonomicznego, sztuczną inteligencją opartą na fizyce dla pojazdów autonomicznych i przyszłym zarządzaniem przestrzenią powietrzną. Wierzymy, że wkrótce nasi studenci studiów magisterskich przeprowadzą bardziej ekscytujące badania.

Sprawdź, jak ciekawe są finalne rozwiązania i wyniki, sprawdź poniższe publikacje badawcze naszych studentów podczas PKB:

- Osigbesan, Adeyemi, Solene Barrat, Harkeerat Singh, Dongzi Xia, Siddharth Singh, Yang Xing, Weisi Guo i Antonios Tsourdos. „Wizyjne wykrywanie upadków w środowisku konserwacji statków powietrznych z oceną pozycji”. W 2022 r. Międzynarodowa konferencja IEEE na temat syntezy i integracji wielu czujników na rzecz inteligentnych systemów (MFI), s. 1-6. IEEE, 2022.

- Fraser, Benjamin, Brendan Copp, Gurpreet Singh, Orhan Keyvan, Tongfei Bian, Valentin Sonntag, Yang Xing, Weisi Guo i Antonios Tsourdos. „Ograniczenie przenoszenia wirusów poprzez monitorowanie tłumu w oparciu o sztuczną inteligencję i analizę dystansu społecznego”. W 2022 r. Międzynarodowa konferencja IEEE na temat syntezy i integracji wielu czujników na rzecz inteligentnych systemów (MFI), s. 1-6. IEEE, 2022.

- Üstek, İ., Desai, J., Torrecillas, IL, Abadou, S., Wang, J., Fever, Q., Kasthuri, SR, Xing, Y., Guo, W. i Tsourdos, A., 2023, Sierpień. Dwuetapowa detekcja przemocy z wykorzystaniem modeli ViTPose i klasyfikacji na inteligentnych lotniskach. W 2023 r. Kongres IEEE Smart World (SWC) (s. 797-802). IEEE.

- Benoit, Paul, Marc Bresson, Yang Xing, Weisi Guo i Antonios Tsourdos. „Wykrywanie brutalnych działań w czasie rzeczywistym w oparciu o wizję za pomocą kamer CCTV z oceną pozycji”. W 2023 r. Kongres IEEE Smart World (SWC), s. 844-849. IEEE, 2023.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/