Introduksjon

Cohere introduserte sin neste generasjons grunnmodell, Rerank 3 for effektivt Enterprise Search og Retrieval Augmented Generation(FILLE). Rerank-modellen er kompatibel med alle slags database eller søkeindeks og kan også integreres i enhver juridisk applikasjon med native søkefunksjoner. Du vil ikke forestille deg at en enkelt kodelinje kan øke søkeytelsen eller redusere kostnadene ved å kjøre en RAG søknad med ubetydelig innvirkning på ventetiden.

La oss utforske hvordan denne grunnmodellen er satt til å fremme bedriftssøk og RAG-systemer, med forbedret nøyaktighet og effektivitet.

Mulighetene til Rerank

Rerank tilbyr de beste mulighetene for bedriftssøk, som inkluderer følgende:

- 4K kontekstlengde som forbedrer søkekvaliteten betydelig for dokumenter med lengre format.

- Den kan søke over multi-aspekt og semi-strukturerte data som tabeller, kode, JSON dokumenter, fakturaer og e-poster.

- Den kan dekke mer enn 100 språk.

- Forbedret ventetid og reduserte totale eierkostnader (TCO)

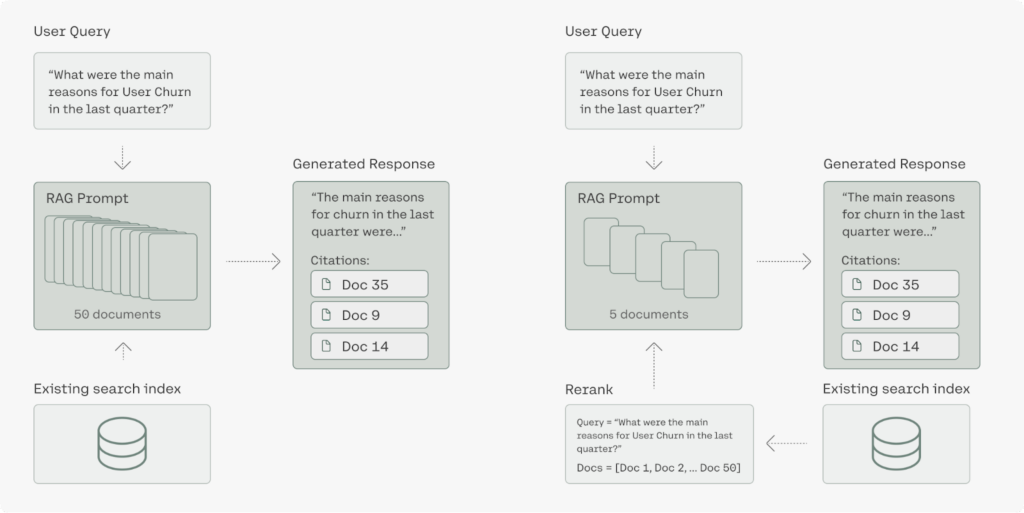

Generative AI-modeller med lange sammenhenger har potensial til å utføre en RAG. For å forbedre nøyaktighetsscore, ventetid og kostnad må RAG-løsningen kreve en kombinasjon av generering AI-modeller og selvfølgelig Rerank-modellen. Den høypresisjons semantiske omrangeringen av rerank3 sørger for at kun relevant informasjon mates til generasjonsmodellen, noe som øker responsnøyaktigheten og holder ventetiden og kostnadene svært lave, spesielt når informasjonen hentes fra millioner av dokumenter.

Forbedret Enterprise Search

Bedriftsdata er ofte svært komplekse og de nåværende systemene som er plassert i organisasjonen opplever vanskeligheter med å søke gjennom multi-aspekt og semi-strukturerte datakilder. Stort sett er de mest nyttige dataene i organisasjonen ikke i det enkle dokumentformatet, slik som JSON er veldig vanlig på tvers av bedriftsapplikasjoner. Rerank 3 er lett i stand til å rangere komplekse, multi-aspekter som e-poster basert på alle relevante metadatafelter, inkludert nylig.

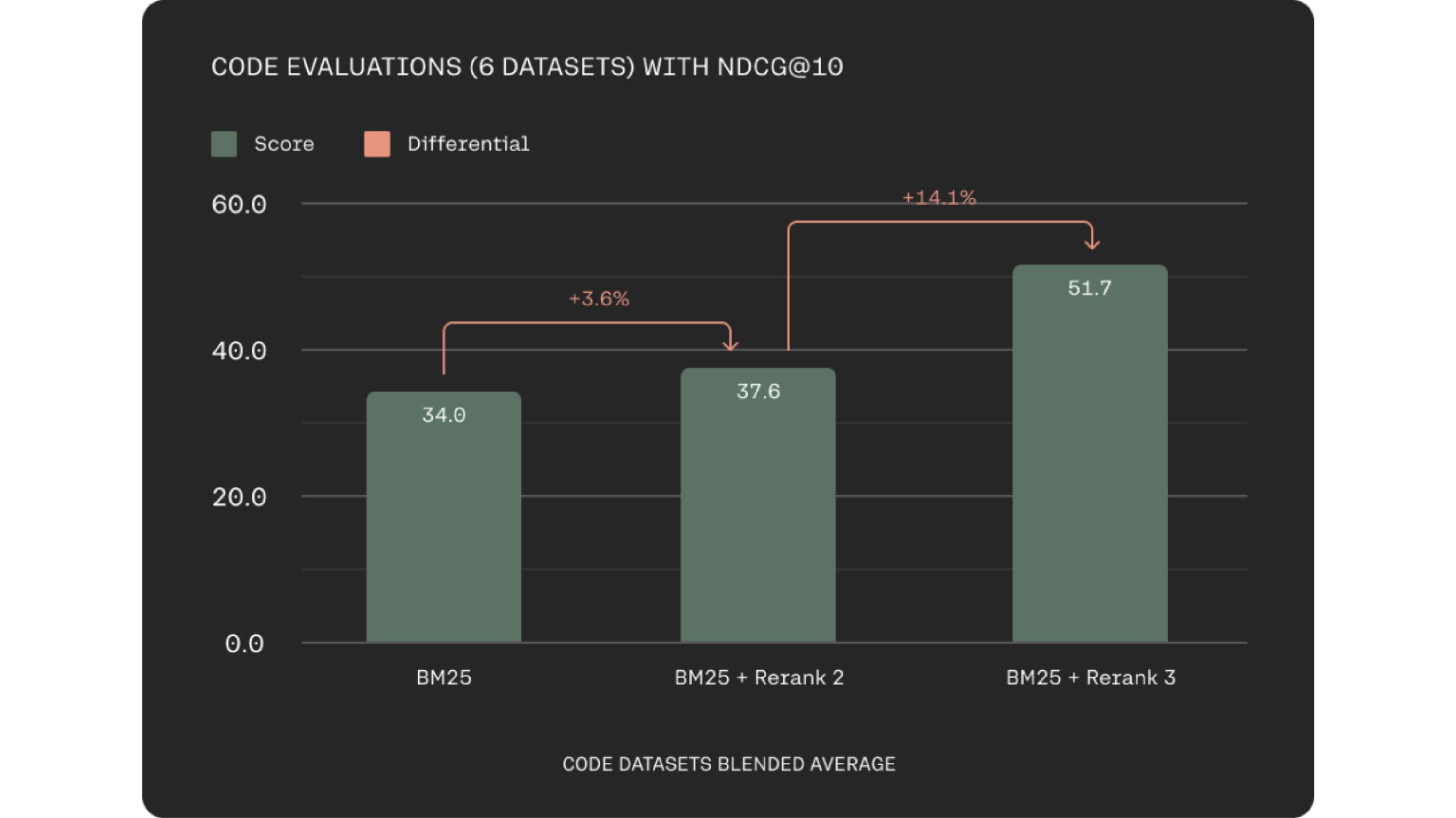

Rerank 3 forbedrer betydelig hvor godt den henter kode. Dette kan øke ingeniørens produktivitet ved å hjelpe dem med å finne de riktige kodebitene raskere, enten det er innenfor bedriftens kodebase eller på tvers av store dokumentasjonslager.

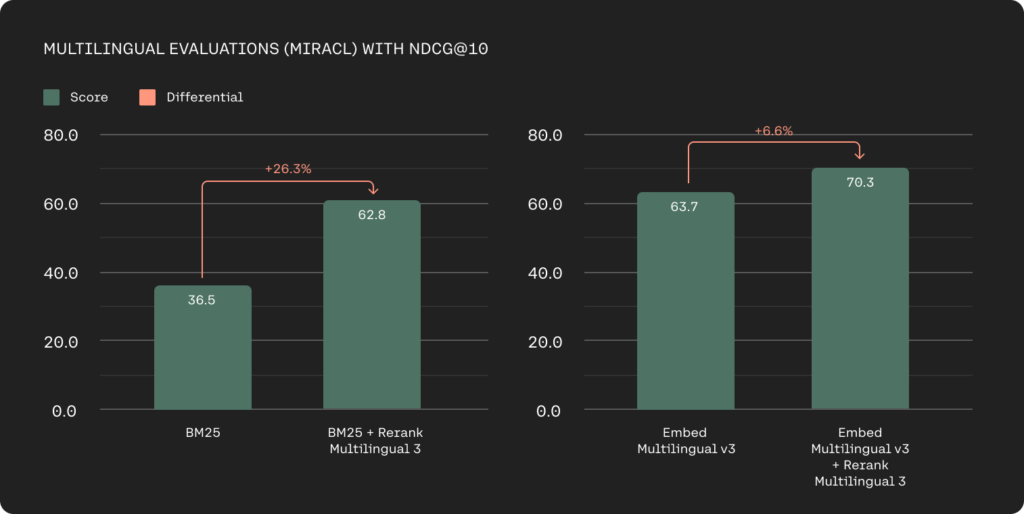

Tekniske giganter håndterer også flerspråklige datakilder, og tidligere har flerspråklig henting vært den største utfordringen med søkeordbaserte metoder. Rerank 3-modellene tilbyr en sterk flerspråklig ytelse med over 100+ språk som forenkler gjenfinningsprosessen for ikke-engelsktalende kunder.

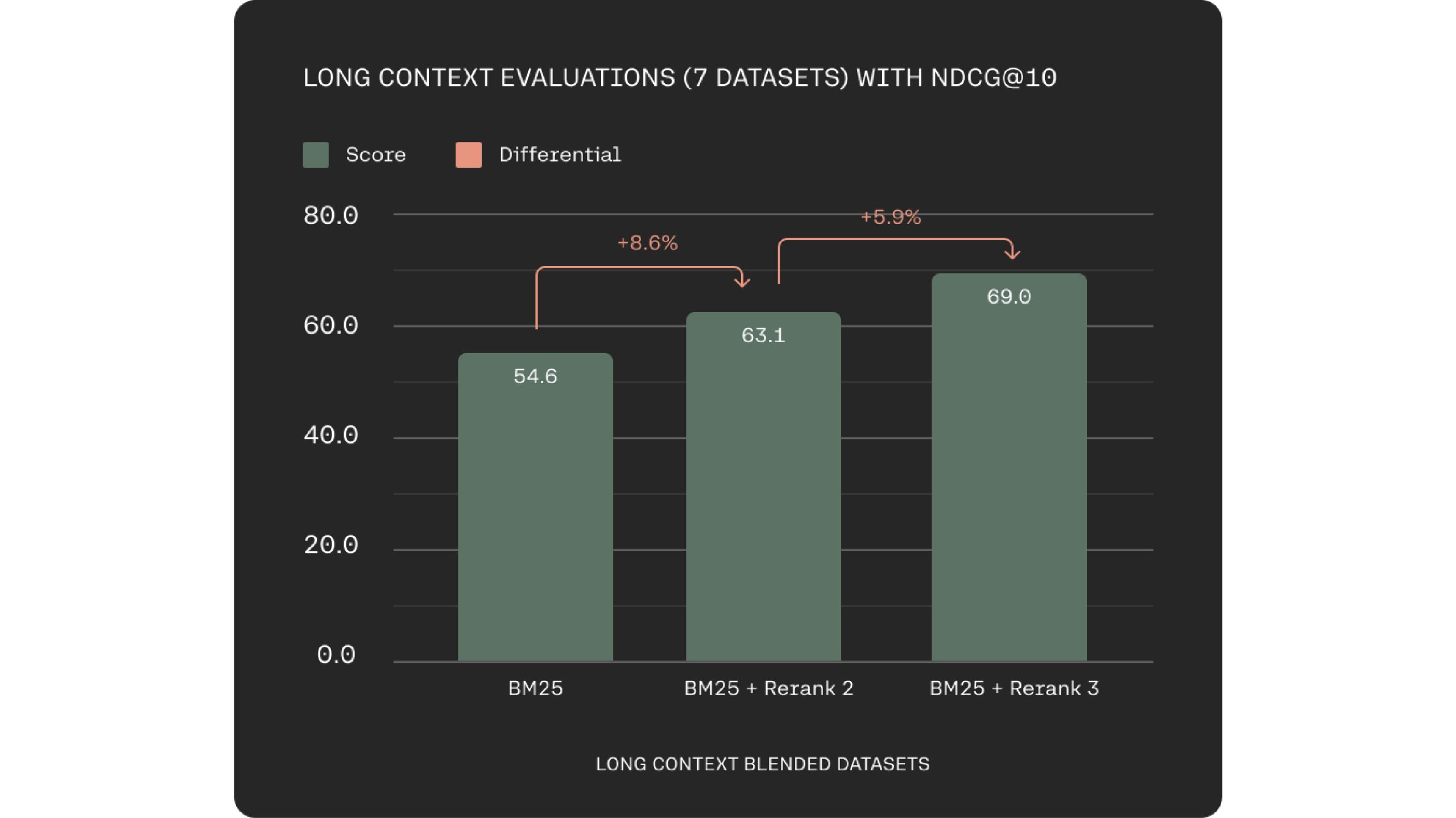

En nøkkelutfordring i semantisk søk og RAG-systemer er optimalisering av datachunking. Rerank 3 adresserer dette med et 4k kontekstvindu, som muliggjør direkte behandling av større dokumenter. Dette fører til forbedret kontekstoverveielse under relevansscoring.

Rerank 3 støttes også i Elastics Inference API. Elastisk søk har en bredt brukt søketeknologi, og søkeord- og vektorsøkefunksjonene i Elasticsearch-plattformen er bygget for å håndtere større og mer komplekse bedriftsdata effektivt.

"Vi er glade for å samarbeide med Cohere for å hjelpe bedrifter med å frigjøre potensialet til dataene deres," sa Matt Riley, GVP og GM i Elasticsearch. Coheres avanserte gjenfinningsmodeller som er Embed 3 og Rerank 3 tilbyr utmerket ytelse på komplekse og store bedriftsdata. De er din problemløser, disse blir viktige komponenter i alle bedriftssøkesystemer.

Forbedret ventetid med lengre kontekst

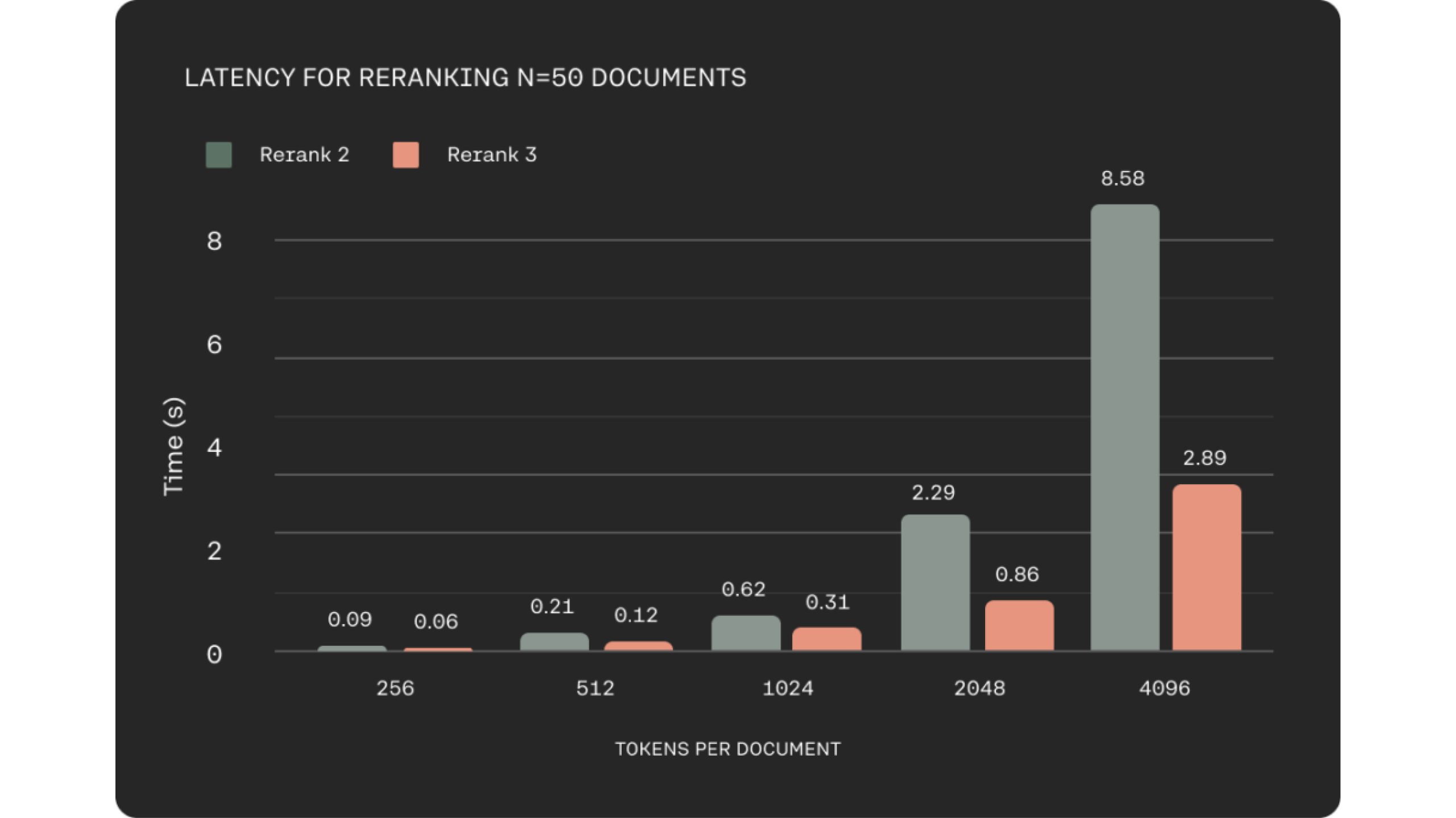

I mange forretningsdomener som e-handel eller kundeservice er lav ventetid avgjørende for å levere en kvalitetsopplevelse. De holdt dette i bakhodet mens de bygde Rerank 3, som viser opptil 2x lavere ventetid sammenlignet med Rerank 2 for kortere dokumentlengder og opptil 3x forbedringer ved lange kontekstlengder.

Bedre ytelse og effektiv RAG

I RAG-systemer (Retrieval-Augmented Generation) er dokumentinnhentingsstadiet avgjørende for den generelle ytelsen. Rerank 3 adresserer to viktige faktorer for eksepsjonell RAG-ytelse: responskvalitet og latens. Modellen utmerker seg ved å finne de mest relevante dokumentene til en brukers forespørsel gjennom sine semantiske omrangeringsmuligheter.

Denne målrettede gjenfinningsprosessen forbedrer direkte nøyaktigheten av RAG-systemets svar. Ved å muliggjøre effektiv henting av relevant informasjon fra store datasett, gir Rerank 3 store bedrifter mulighet til å låse opp verdien av deres proprietære data. Dette letter ulike forretningsfunksjoner, inkludert kundestøtte, juridisk, HR og økonomi, ved å gi dem den mest relevante informasjonen for å svare på brukerspørsmål.

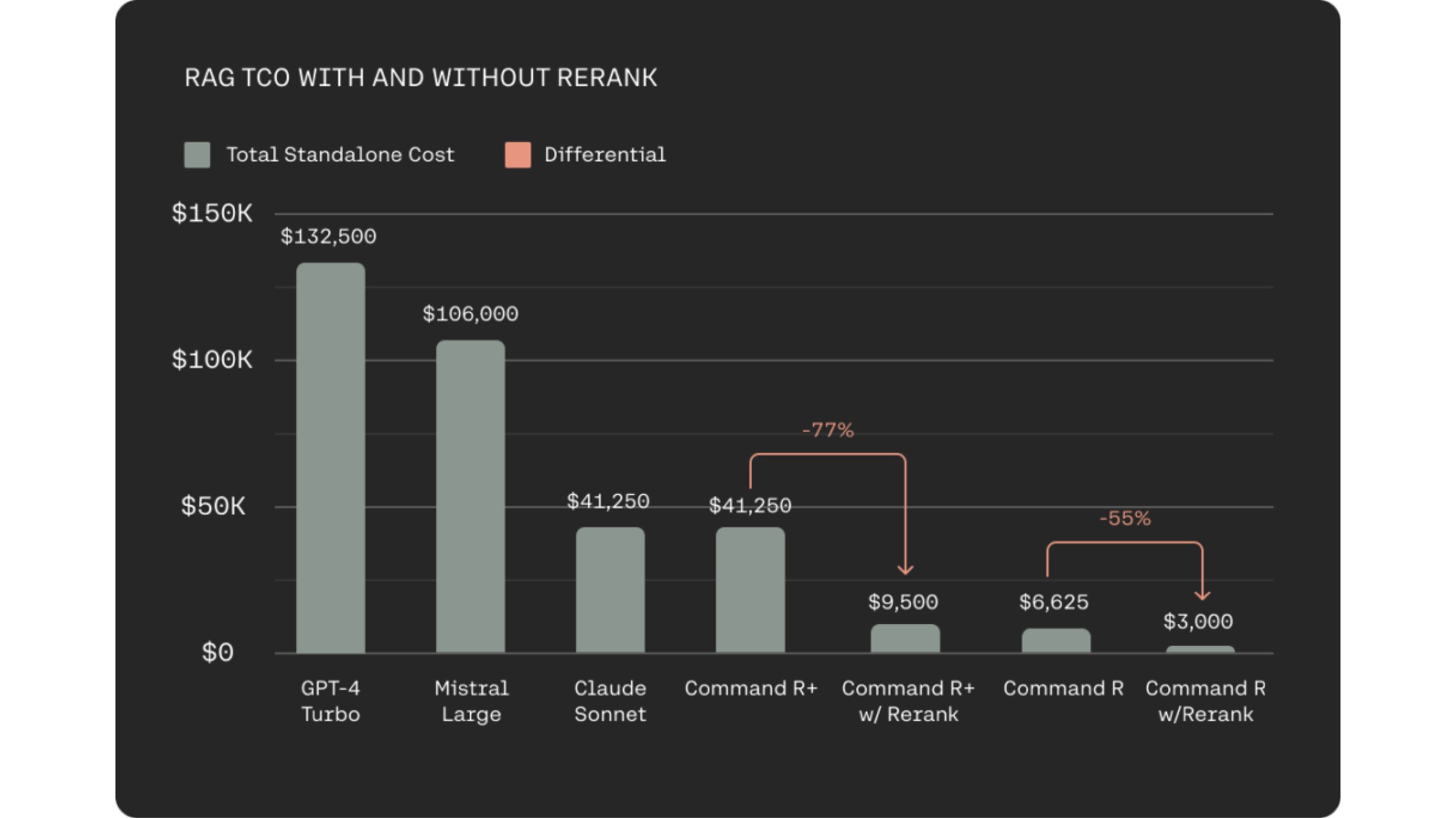

Å integrere Rerank 3 med den kostnadseffektive Command R-familien for RAG-systemer gir en betydelig reduksjon i Total Cost of Ownership (TCO) for brukere. Dette oppnås gjennom to nøkkelfaktorer. For det første letter Rerank 3 svært relevant dokumentvalg, noe som krever at LLM behandler færre dokumenter for generering av jordet svar. Dette opprettholder responsnøyaktigheten samtidig som ventetiden minimeres. For det andre fører den kombinerte effektiviteten til Rerank 3- og Command R-modeller til kostnadsreduksjoner på 80-93 % sammenlignet med alternative generative LLM-er i markedet. Faktisk, når man vurderer kostnadsbesparelsene fra både Rerank 3 og Command R, kan totale kostnadsreduksjoner overstige 98 %.

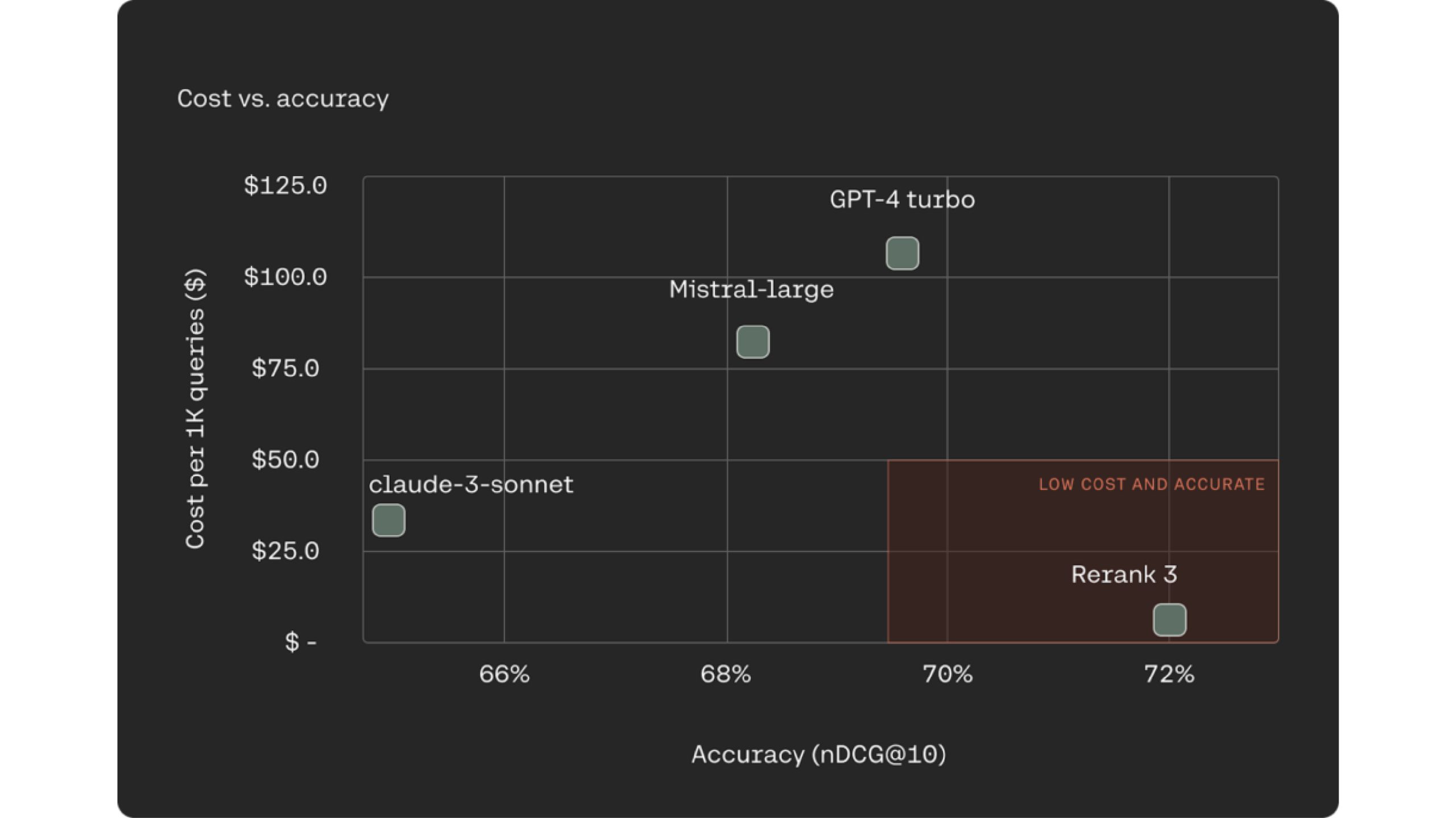

En stadig mer vanlig og kjent tilnærming for RAG-systemer er å bruke LLM-er som rerankere for dokumentinnhentingsprosessen. Rerank 3 overgår bransjeledende LLM-er som Claude -3 Sonte, GPT Turbo når det gjelder rangeringsnøyaktighet, samtidig som de er 90–98 % rimeligere.

Omrangering 3 øker nøyaktigheten og kvaliteten på LLM-responsen. Det hjelper også med å redusere ende-til-ende TCO. Rerank oppnår dette ved å luke våre mindre relevante dokumenter, og bare sortere gjennom den lille undergruppen av relevante for å trekke svar.

konklusjonen

Rerank 3 er et revolusjonerende verktøy for bedriftssøk og RAG-systemer. Det muliggjør høy nøyaktighet i håndtering av komplekse datastrukturer og flere språk. Reranger 3 minimerer datachunking, reduserer ventetid og totale eierkostnader. Dette resulterer i raskere søkeresultater og kostnadseffektive RAG-implementeringer. Den integreres med Elasticsearch for forbedret beslutningstaking og kundeopplevelser.

Du kan utforske mange flere slike AI-verktøy og deres applikasjoner her..

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.analyticsvidhya.com/blog/2024/04/rerank-3-boosting-enterprise-search-and-rag-systems/