Kinas institutt for høyenergifysikk (IHEP) i Beijing er banebrytende med innovative tilnærminger innen kvanteberegning og kvantemaskinlæring for å åpne opp nye forskningsveier innenfor sitt partikkelfysikkprogram, som Hideki Okawa, Weidong Li og juni Cao forklare

Institute of High Energy Physics (IHEP), en del av det kinesiske vitenskapsakademiet, er det største grunnleggende vitenskapslaboratoriet i Kina. Det er vertskap for et tverrfaglig forskningsprogram som spenner over elementær partikkelfysikk, astrofysikk samt planlegging, design og konstruksjon av storskala akseleratorprosjekter – inkludert China Spallation Neutron Source, som ble lansert i 2018, og High Energy Photon Source, som kommer online i 2025.

Mens investeringene i IHEPs eksperimentelle infrastruktur har økt dramatisk de siste 20 årene, er utviklingen og anvendelsen av kvantemaskinlæring og kvantedatabehandlingsteknologier nå klar til å gi tilsvarende vidtrekkende resultater innenfor IHEP-forskningsprogrammet.

Stor vitenskap, kvanteløsninger

Høyenergifysikk er der «big science» møter «big data». Å oppdage nye partikler og undersøke de grunnleggende naturlovene er bestrebelser som produserer utrolige mengder data. Large Hadron Collider (LHC) ved CERN genererer petabyte (1015 bytes) med data under eksperimentelle kjøringer – som alle må behandles og analyseres ved hjelp av grid computing, en distribuert infrastruktur som kobler dataressurser sammen over hele verden.

På denne måten gir Worldwide LHC Computing Grid et fellesskap av tusenvis av fysikere nesten sanntidstilgang til LHC-data. Det sofistikerte datanettverket var grunnleggende for landemerkeoppdagelsen av Higgs-bosonet ved CERN i 2012, så vel som utallige andre fremskritt for å undersøke standardmodellen for partikkelfysikk ytterligere.

Et annet vendepunkt truer imidlertid når det kommer til lagring, analyse og utvinning av store data i høyenergifysikk. High-Luminosity Large Hadron Collider (HL-LHC), som forventes å gå i drift i 2029, vil skape en "databehandling" som maskinens integrerte lysstyrke, proporsjonal med antall partikkelkollisjoner som oppstår i en gitt tidsperiode , vil øke med en faktor 10 i forhold til LHCs designverdi – det samme vil datastrømmene generert av HL-LHC-eksperimentene.

CERN QTI: utnytter stor vitenskap for å akselerere kvanteinnovasjon

På kort sikt vil en ny "databehandlingsbaseline" være nødvendig for å takle HL-LHCs skyhøye databehov - en baseline som vil kreve storskala utnyttelse av grafikkbehandlingsenheter for massiv parallell simulering, dataregistrering og reprosessering , samt klassiske anvendelser av maskinlæring. CERN har på sin side også etablert et mellom- og langsiktig veikart som samler høyenergifysikk- og kvanteteknologisamfunnene via CERN Quantum Technology Initiative (QTI) – en erkjennelse av at enda et sprang i dataytelse kommer til syne med anvendelse av kvantedatabehandling og kvantenettverksteknologier.

Tilbake til kvantegrunnlaget

Kvantedatamaskiner, som navnet tilsier, utnytter de grunnleggende prinsippene for kvantemekanikk. I likhet med klassiske datamaskiner, som er avhengige av de binære bitene som tar verdien av enten 0 eller 1, utnytter kvantedatamaskiner binære kvantebiter, men som en superposisjon av 0- og 1-tilstander. Denne superposisjonen, kombinert med kvanteforviklinger (korrelasjoner mellom kvantebiter), gjør i prinsippet det mulig for kvantedatamaskiner å utføre enkelte typer beregninger betydelig raskere enn klassiske maskiner – for eksempel kvantesimuleringer brukt i ulike områder av kvantekjemi og molekylær reaksjonskinetikk.

Mens mulighetene for vitenskap og den bredere økonomien virker overbevisende, er en av de store tekniske hodepinene forbundet med tidlige kvantedatamaskiner deres sårbarhet for miljøstøy. Qubits blir altfor lett forstyrret, for eksempel av deres interaksjoner med jordas magnetfelt eller forvillede elektromagnetiske felt fra mobiltelefoner og WiFi-nettverk. Interaksjoner med kosmiske stråler kan også være problematiske, og det samme kan interferens mellom nabo-qubits.

Den ideelle løsningen – en strategi kalt feilkorrigering – innebærer å lagre den samme informasjonen over flere qubits, slik at feil vil bli oppdaget og korrigert når en eller flere av qubitene blir påvirket av støy. Problemet med disse såkalte feiltolerante kvantedatamaskinene er deres krav til et stort antall qubits (i størrelsesorden millioner) – noe som er umulig å implementere i dagens generasjons småskala kvantearkitekturer.

I stedet kan designerne av dagens Noisy Intermediate-Scale Quantum (NISQ) datamaskiner enten akseptere støyeffektene som de er eller delvis gjenopprette feilene algoritmisk – dvs. uten å øke antall qubits – i en prosess kjent som feilreduksjon. Det er kjent at flere algoritmer gir motstandskraft mot støy i småskala kvantedatamaskiner, slik at "kvantefordeler" kan observeres i spesifikke høyenergifysikkapplikasjoner til tross for de iboende begrensningene til nåværende generasjons kvantedatamaskiner.

En slik undersøkelseslinje ved IHEP fokuserer på kvantesimulering, og bruker ideer som opprinnelig ble fremsatt av Richard Feynman rundt bruken av kvanteenheter for å simulere tidsutviklingen til kvantesystemer - for eksempel i gitterkvantekromodynamikk (QCD). For kontekst beskriver standardmodellen alle de grunnleggende vekselvirkningene mellom elementarpartiklene bortsett fra gravitasjonskraften – dvs. å binde sammen de elektromagnetiske, svake og sterke kreftene. På denne måten omfatter modellen to sett med såkalte kvantemålerfeltteorier: Glashow–Weinberg–Salam-modellen (som gir en enhetlig beskrivelse av de elektromagnetiske og svake kreftene) og QCD (for de sterke kreftene).

Det er generelt slik at kvantemålefeltteoriene ikke kan løses analytisk, med de fleste spådommer for eksperimenter avledet fra tilnærmingsmetoder for kontinuerlig forbedring (også kjent som forstyrrelse). Akkurat nå jobber IHEP-stabsforskere med å direkte simulere målefelt med kvantekretser under forenklede forhold (for eksempel i reduserte rom-tidsdimensjoner eller ved å bruke endelige grupper eller andre algebraiske metoder). Slike tilnærminger er kompatible med nåværende iterasjoner av NISQ-datamaskiner og representerer grunnleggende arbeid for en mer fullstendig implementering av gitter QCD i nær fremtid.

QuIHEP kvantesimulator

Som en forlengelse av sitt ambisiøse kvante-FoU-program, har IHEP etablert QuIHEP, en kvantedatasimulatorplattform som gjør det mulig for forskere og studenter å utvikle og optimere kvantealgoritmer for forskningsstudier innen høyenergifysikk.

For klarhetens skyld er kvantesimulatorer klassiske databehandlingsrammeverk som prøver å etterligne eller "simulere" oppførselen til kvantedatamaskiner. Kvantesimulering, på den annen side, bruker faktisk kvantedatamaskinvare for å simulere tidsutviklingen til et kvantesystem – for eksempel gitter-QCD-studiene ved IHEP (se hovedteksten).

Som sådan tilbyr QuIHEP et brukervennlig og interaktivt utviklingsmiljø som utnytter eksisterende dataklynger med høy ytelse for å simulere opptil 40 qubits. Plattformen gir et komponistgrensesnitt for utdanning og introduksjon (som demonstrerer for eksempel hvordan kvantekretser er konstruert visuelt). Utviklingsmiljøet er basert på Jupyter åpen kildekode-programvare og kombinert med et IHEP brukerautentiseringssystem.

På kort sikt vil QuIHEP koble seg opp til distribuerte kvantedatabehandlingsressurser over hele Kina for å etablere en harmonisert forskningsinfrastruktur. Målet: å støtte industri-akademia samarbeid og utdanning og opplæring innen kvantevitenskap og ingeniørfag.

Maskinlæring: kvanteveien

Et annet kvanteforskningstema ved IHEP involverer kvantemaskinlæring, som kan grupperes i fire forskjellige tilnærminger: CC, CQ, QC, QQ (med C – klassisk; Q – kvante). I hvert tilfelle tilsvarer den første bokstaven datatypen og sistnevnte til typen datamaskin som kjører algoritmen. CC-ordningen, for eksempel, utnytter klassiske data og klassiske datamaskiner fullt ut, men kjører kvanteinspirerte algoritmer.

Den mest lovende brukssaken som forfølges ved IHEP, involverer imidlertid CQ-kategorien for maskinlæring, der den klassiske datatypen kartlegges og trenes i kvantedatamaskiner. Motivasjonen her er at ved å utnytte det grunnleggende i kvantemekanikken – det store Hilbert-rommet, superposisjonen og sammenfiltringen – vil kvantedatamaskiner kunne lære mer effektivt fra store datasett for å optimere de resulterende maskinlæringsmetodikkene.

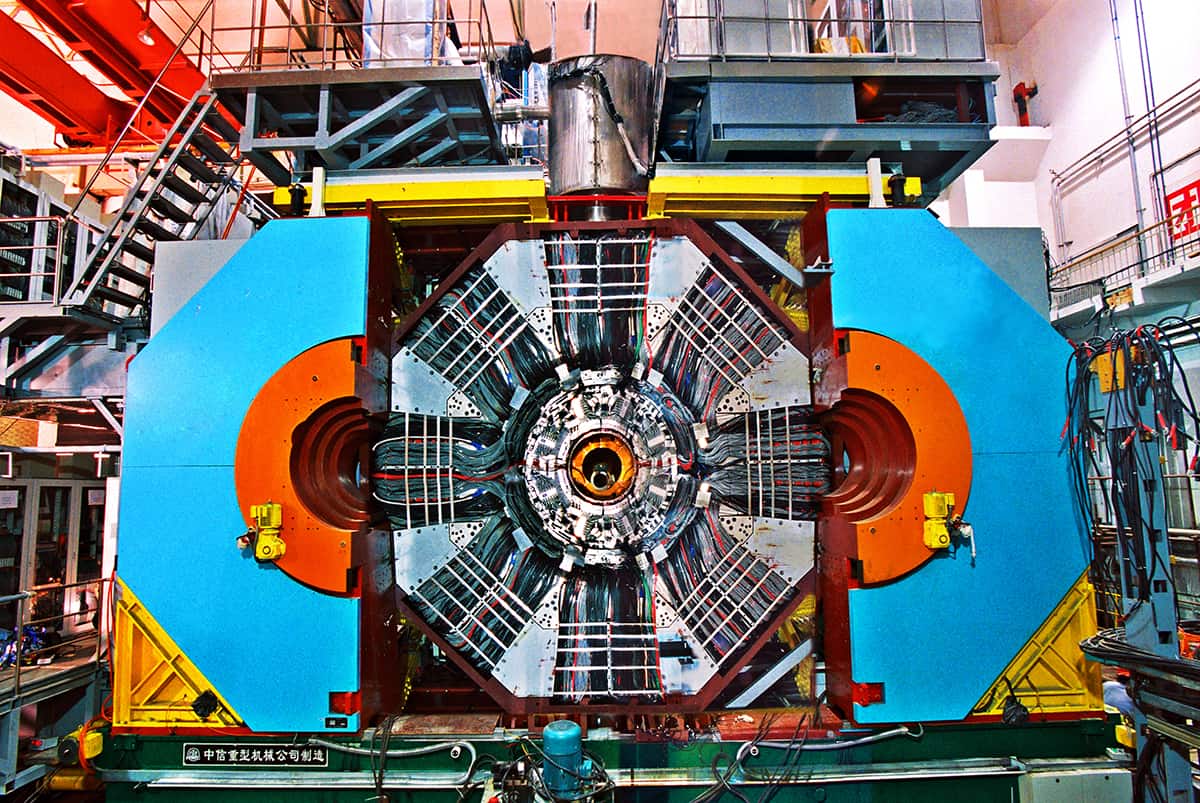

For å forstå potensialet for kvantefordeler, jobber IHEP-forskere for tiden med å "gjenoppdage" den eksotiske partikkelen Zc(3900) ved bruk av kvantemaskinlæring. Når det gjelder bakhistorien: Zc(3900) er en eksotisk subatomær partikkel som består av kvarker (byggesteinene til protoner og nøytroner) og antas å være den første tetraquark-tilstanden som ble observert eksperimentelt – en observasjon som i prosessen utdypet vår forståelse av QCD. Partikkelen ble oppdaget i 2013 av Beijing Spectrometer (BESIII) detektor ved Beijing Electron-Positron Collider (BEPCII), med uavhengig observasjon av Belle-eksperimentet ved Japans KEK partikkelfysikklaboratorium.

QUANT-NETs testbed-innovasjoner: reimagining av kvantenettverket

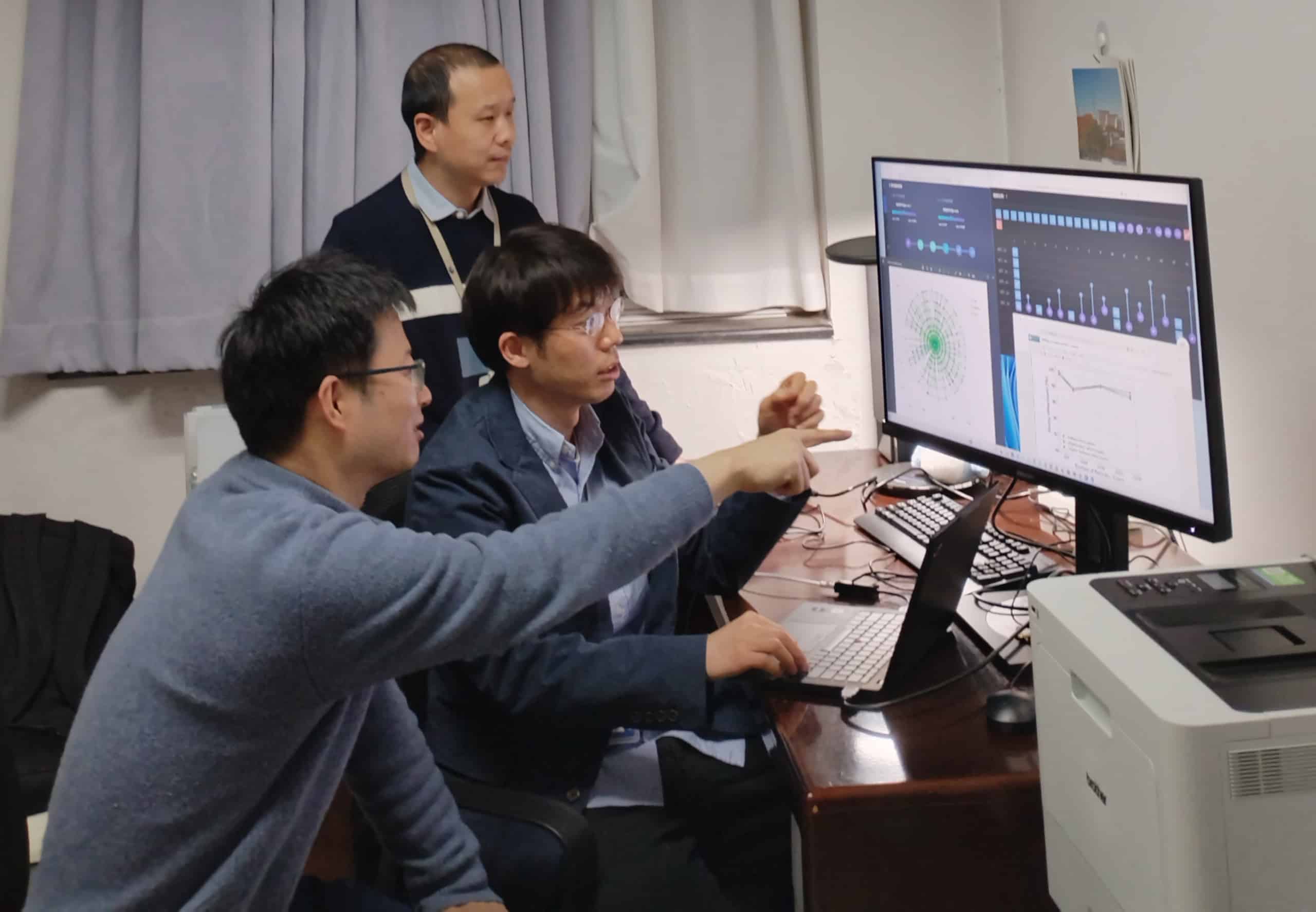

Som en del av denne FoU-studien, implementerte et team ledet av IHEPs Jiaheng Zou, og inkludert kolleger fra Shandong University og University of Jinan, den såkalte Quantum Support Vector Machine-algoritmen (en kvantevariant av en klassisk algoritme) for opplæringen langs med simulerte signaler av Zc(3900) og tilfeldig utvalgte hendelser fra de virkelige BESIII-dataene som bakgrunn.

Ved å bruke kvantemaskinlæringstilnærmingen er ytelsen konkurransedyktig i forhold til klassiske maskinlæringssystemer – men, avgjørende, med et mindre treningsdatasett og færre datafunksjoner. Undersøkelser pågår for å demonstrere forbedret signalfølsomhet med kvanteberegning, arbeid som til slutt kan vise veien til oppdagelsen av nye eksotiske partikler i fremtidige eksperimenter.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://physicsworld.com/a/ihep-seeks-quantum-opportunities-to-fast-track-fundamental-science/