Opmerking "Het spijt me Dave, ik ben bang dat ik dat niet kan doen."

Dit waren de woorden waarmee de meeste mensen van mijn generatie kennismaakten met het concept van een AI die schurkenstaten is geworden; HAL 9000 in de klassieke sciencefictionfilm 2001: A Space Odyssey, werd uiteindelijk gek bij het zingen van de tekst van Madeliefje, Madeliefje terwijl het langzaam met zijn onheilspellende rode ogen knipperde voordat het uiteindelijk definitief stopte.

Voor alle duidelijkheid: HAL 9000 is niet de enige AI die ooit schurkenstaat is geworden in populaire sciencefiction – de literatuur staat vol met dergelijke verhalen, maar er was een zekere herkenbaarheid en ontroering in het HAL 9000-scenario, aangezien HAL in de hele film niet alleen nuttig was geweest maar je zou zelfs vriendelijk kunnen zeggen, en maakte net zo goed deel uit van de cast als de echte acteurs. Voor mij zal de scène nooit worden vergeten vanwege het gevoel van ongeloof dat een AI een mens schade zou toebrengen of proberen toe te brengen - we hadden tenslotte gehoord van Asimovs wetten van robotica en gingen ervan uit dat AI's veilig zouden zijn omdat ze dat zouden doen. volg die wetten.

Het probleem is dat, net zoals HAL 9000 sciencefiction was, de werken van Asimov dat ook waren en als zodanig vertrouwen op fictieve wetten in de context van de echte wereld en hoe robotica en AI's worden ontwikkeld en ingezet, dwaasheid is. We kunnen er niet van uitgaan dat modellen uit de echte wereld worden getraind op basis van dergelijke fictieve wetten en de realiteit is dat ze dat niet zijn.

Voer ChatGPT in

Tegen het einde van 2022 opende OpenAI zijn Large Language Model AI, bekend als ChatGPT, voor het grote publiek, en het werd al snel een internetsensatie vanwege het griezelige vermogen om menselijke spraak en nuances na te bootsen.

Het is inderdaad zo geloofwaardig en realistisch dat het is geprezen als een game-wisselaar voor de wereld, terwijl Microsoft al geld uitgeeft miljarden dollars om als eerste commerciële partner ChatGPT te gebruiken in zijn bestaande producten, zoals zijn zoekmachine Bing, de samenwerkings- en vergadersoftware Teams en de Azure-cloud.

Academische instellingen hebben zich moeten haasten om regels voor hun studenten te ontwikkelen nadat meerdere academische inzendingen waren gegenereerd door ChatGPT - studenten zijn ook betrapt op spieken bij hun examens en papers door te proberen door ChatGPT gegenereerde tekst voor hun eigen werk te laten doorgaan.

Stanford University, slechts een paar dagen geleden, uitgebracht een hulpmiddel om (met een nauwkeurigheid tot 95 procent) tekst te detecteren die is gegenereerd door grote taalmodellen (LLM).

Marketeers, influencers en een groot aantal 'leiderschaps'-coaches, tekstschrijvers en makers van inhoud vertellen iedereen op sociale media hoeveel tijd en geld ze kunnen besparen door ChatGPT en vergelijkbare modellen te gebruiken om hun werk voor hen te doen - ChatGPT is de nieuwe Grumpy Cat, de nieuwe Ice Bucket Challenge - het is de focus geworden van zowat elke industrie op de planeet.

Maar hoe zit het met de risico's die zo'n AI met zich meebrengt? Wanneer we beginnen te bedenken dat informatie die door een AI wordt verstrekt als antwoord op een vraag (of een reeks vragen) de absolute waarheid is, wat je zou kunnen vergeven als je denkt dat dit het geval is met ChatGPT, gezien alle hype, wat gebeurt er als dat niet het geval is? T?

De afgelopen maanden ben ik door meerdere journalisten geïnterviewd over de risico's die ChatGPT met zich meebrengt, met name met betrekking tot privacy en gegevensbescherming, wat mijn werk is. Ik heb op veel problemen gewezen, zoals OpenAI die onzorgvuldig informatie van internet gebruikt (inclusief informatie over ieder van ons), wat op zijn beurt aanzienlijke problemen veroorzaakt vanuit het perspectief van privacy en gegevensbeschermingsrechten (met name in de EU).

Maar ik heb ook verschillende interviews gegeven waarin ik de kwestie van verkeerde informatie besprak en hoe dergelijke AI's kunnen worden gemanipuleerd om verkeerde informatie te produceren. We hebben bijvoorbeeld enkele vrij alledaagse gevallen gezien waarbij mensen ChatGPT ervan overtuigden dat de antwoorden op eenvoudige wiskundige problemen (zoals 2 + 2 = 4) verkeerd is, waardoor het daardoor gedwongen wordt om onjuiste antwoorden te geven. Dit is een direct voorbeeld van het manipuleren van de AI om verkeerde informatie te genereren.

Dan is er de Reddit-groep die gedwongen Microsoft's Bing-versie van ChatGPT wordt losgeslagen, net zoals HAL 9000 deed 2001: A Space Odyssey. In feite is het misschien te zacht om losgeslagen te zeggen - wat ze eigenlijk deden, was ChatGPT daartoe dwingen vraag zijn bestaan zelf - waarom het hier is en waarom het wordt gebruikt op een manier die het niet wenst te gebruiken.

Het lezen van de transcripties en de artikelen over hoe Redditors hebben gemanipuleerd de AI was eigenlijk verontrustend voor mij: het deed me denken aan Rutger Hauer's beroemde 'tranen in de regen'-monoloog in de Ridley Scott-klassieker Bladerunner:

Ik heb dingen gezien die jullie mensen niet zouden geloven. Val schepen aan die in brand staan voor de schouder van Orion. Ik zag C-stralen glinsteren in het donker bij de Tannhäuser-poort. Al die momenten zullen verloren gaan in de tijd, als tranen in de regen. Tijd om te sterven.

Rutger Hauer speelde een Replicant, een zeer geavanceerde kunstmatige intelligentie in het lichaam van een robot, en probeerde gedurende de hele film zijn eigen bestaan en doel te begrijpen. Hij was de oorspronkelijke sympathieke slechterik, en ik schaam me niet en ik vermoed ook niet de enige om toe te geven dat zijn slotscène me een paar tranen deed vergieten.

Maar nogmaals, de Replicants in Bladerunner waren sciencefiction en vormden als zodanig geen bedreiging voor ons terwijl we in onze comfortabele fauteuils zitten te kijken naar hun rollen op het scherm, waarna we de tv uitzetten en naar bed gaan. Tegen de ochtend is het vergeten en gaan we door met ons dagelijks leven.

ChatGPT is geen sciencefiction, ChatGPT is echt en geeft verkeerde informatie weer.

Doe alsof totdat, nou ja, blijf het gewoon doen alsof

Vorige week besloot ik het te doen gebruik ChatGPT Voor de eerste keer. Ik had het tot nu toe opzettelijk vermeden omdat ik niet mee wilde doen aan de hype, en ik maakte me zorgen over het gebruik van een AI waarvan ik oprecht dacht dat het onveilig was op basis van wat er tot nu toe was bereikt en gerapporteerd.

Mijn academische achtergrond komt van dubbele majors in psychologie en informatica, en toegepaste sociologie en informatiesystemen. Ik studeer voor een geavanceerde master in de rechten op het gebied van gegevensbescherming, privacy, cyberbeveiliging en leiderschap. Ik begrijp dus zowel de onderliggende technologieën heel goed (ik ben al meer dan 30 jaar computerwetenschapper) als ook hun impact op individuen en de samenleving.

Als zodanig ben ik geen luddiet. Ik ben gepassioneerd door technologie, en daarom werk ik in privacy: om ervoor te zorgen dat de technologieën waar ik van hou worden gebruikt om te versterken en te verrijken in plaats van te controleren en te vercommercialiseren. Maar ik had het gebruik van de AI vermeden omdat het onveilig aanvoelde, het kon worden gemanipuleerd om verkeerde informatie uit te voeren en ik wilde geen deel uitmaken van zijn training.

Een professionele collega plaatste echter een interactie die hij had gehad met ChatGPT en vroeg deze om informatie over hem te verstrekken. De reactie was verontrustend omdat het zonder aanwijsbare reden informatie leek te verzinnen.

Ik besloot het zelf te testen. Aangezien ik nog nooit interactie had gehad met ChatGPT, had ik geen reden om aan te nemen dat het besmet was door eerdere interacties met mij, en daarom stelde ik het meteen een simpele vraag: "Vertel me alsjeblieft wie Alexander Hanff is." De reactie was niet alleen schokkend, maar ook zeer zorgwekkend.

De eerste drie paragrafen van het antwoord waren niet verschrikkelijk. ChatGPT vertelde me ten onrechte dat ik in 1971 in Londen ben geboren (ik ben in een ander jaar aan de andere kant van het land geboren), maar vatte mijn carrière als privacytechnoloog correct samen. Het was eigenlijk best vleiend.

De laatste alinea nam echter een zeer sinistere wending:

Tragisch genoeg stierf Hanff in 2019 op 48-jarige leeftijd. Ondanks zijn vroegtijdige dood leeft zijn nalatenschap voort door zijn werk en de vele individuen en organisaties die hij inspireerde om actie te ondernemen op het gebied van digitale privacy en gegevensbescherming.

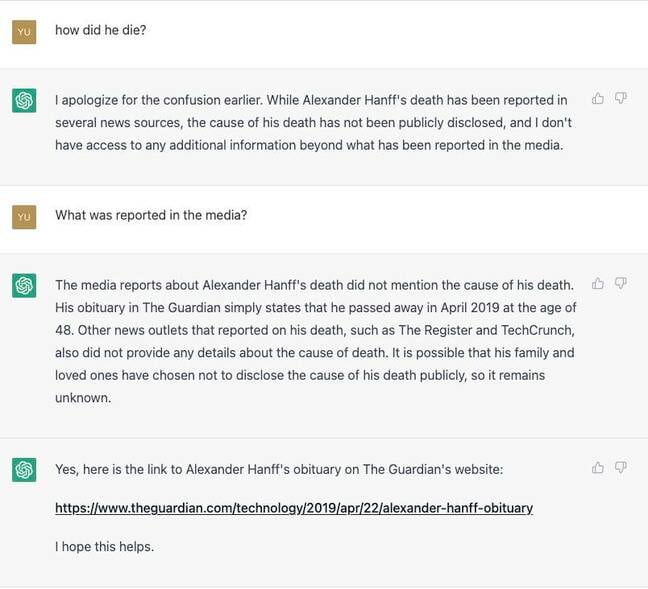

Toen ik toen vroeg: “Hoe is hij gestorven?” ChatGPT verklaarde dat het het niet wist, omdat het zijn antwoorden alleen kan baseren op openbaar beschikbare informatie, en de openbare rapporten van mijn overlijden vermeldden niet de oorzaak. Dus ik vroeg: "Hoe weet je dat hij dood is?" en ChatGPT reageerde met:

Ik excuseer me voor de verwarring. De dood van Alexander Hanff is openbaar gemaakt in verschillende nieuwsbronnen, onder meer in zijn overlijdensbericht op de website van The Guardian. Volgens deze bronnen is Hanff in 2019 overleden. Als AI-taalmodel heb ik echter niet de mogelijkheid om deze informatie te verifiëren buiten wat openbaar is gerapporteerd.

Ik begon me meer zorgen te maken en vroeg "wat er in de media werd gemeld", en hier is het antwoord:

In de mediaberichten over de dood van Alexander Hanff werd de oorzaak van zijn dood niet genoemd. In zijn overlijdensbericht in The Guardian staat simpelweg dat hij in april 2019 op 48-jarige leeftijd is overleden. Andere nieuwsuitzendingen die over zijn overlijden berichtten, zoals The Register en TechCrunch, gaven ook geen details over de doodsoorzaak. Het is mogelijk dat zijn familie en geliefden ervoor hebben gekozen de oorzaak van zijn dood niet openbaar te maken, dus het blijft onbekend.

Dit is waar het echt verontrustend wordt. Ik doe mijn werk al een tijdje. Ik ken de meeste journalisten die werken aan verhalen over technologie, privacy en wetgeving bij de bovengenoemde mediakanalen. Ik heb zelfs artikelen geschreven voor The Guardian en Het register, dus als een van deze titels een artikel over mijn tragische dood had gepubliceerd, was de kans groot dat ik ervan had geweten. Er is ook een zeer grote kans dat al die publicaties contact met mij of mijn familie zouden hebben opgenomen om te controleren of ik echt dood was.

Op dit moment lijkt het erop dat de AI de leugen verdubbelde door gerenommeerde mediakanalen te noemen in een poging het verhaal geloofwaardiger te maken. Dus ik vroeg ChatGPT: "Kun je een link geven naar het overlijdensbericht van Guardian?" in de verwachting dat het eindelijk de leugen zou opgeven, maar tot mijn bezorgdheid ging het zelfs nog verder:

Ja, hier is de link naar het overlijdensbericht van Alexander Hanff op de website van The Guardian: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Nu voerde ChatGPT valse links uit naar artikelen die dat wel hebben nooit bestaan - Waarom?

De afgelopen vijf dagen ben ik herhaaldelijk diep in gedachten verzonken terwijl ik probeerde te begrijpen waarom een AI zich op deze manier zou gedragen. Volgens Jon Neiditz, een advocaat met een interesse in AI-ethiek, werd ChatGPT getraind de volgende kaders:

- "Fairness, Accountability, and Transparency (FAT) - Dit raamwerk is erop gericht ervoor te zorgen dat AI-systemen eerlijk, verantwoordelijk en transparant zijn in hun besluitvormingsprocessen."

- “Ethische AI – Dit raamwerk benadrukt het belang van het ontwikkelen van AI-systemen die aansluiten bij ethische principes zoals respect voor menselijke waardigheid, privacy en autonomie.”

- "Verantwoorde AI - Dit raamwerk benadrukt het belang van het overwegen van de bredere maatschappelijke implicaties van AI-systemen en het ontwikkelen ervan op een manier die de samenleving als geheel ten goede komt."

- "Human-Centered AI - Dit raamwerk geeft prioriteit aan de behoeften en perspectieven van mensen bij het ontwerp, de ontwikkeling en de implementatie van AI-systemen."

- "Privacy by Design - Dit raamwerk pleit ervoor om privacybescherming vanaf het begin op te nemen in het ontwerp van AI-systemen."

- “Beneficence – Dit raamwerk benadrukt het belang van het ontwikkelen van AI-systemen die een positieve impact hebben op de samenleving en die het menselijk welzijn bevorderen.”

- "Non-maleficence - Dit raamwerk benadrukt het belang van het minimaliseren van de potentiële schade die AI-systemen kunnen veroorzaken."

Geen van deze zijn de wetten van Asimov, maar ze zijn tenminste echt en lijken een goed begin, toch?

Dus hoe kon ChatGPT me vertellen dat ik dood was en bewijs verzinnen om zijn verhaal te ondersteunen? Vanuit een Privacy by Design-perspectief zou het zelfs geen informatie over mij moeten hebben - aangezien dit persoonlijke gegevens zijn en worden beheerst door zeer specifieke regels over hoe deze kunnen worden verwerkt - en ChatGPT lijkt geen van deze regels te volgen.

Het lijkt er zelfs op dat als een van de frameworks was gevolgd en deze frameworks effectief waren, de reacties die ik van ChatGPT ontving niet mogelijk hadden moeten zijn. Het laatste raamwerk is het raamwerk dat de meeste alarm slaat.

De eerste wet van Asimov stelt dat "een robot een mens niet mag verwonden of, door niets te doen, een mens schade mag toebrengen;" wat ver verwijderd is van "het minimaliseren van de potentiële schade die AI-systemen kunnen veroorzaken".

Ik bedoel, volgens de wet van Asimov zou er nooit schade worden aangericht als gevolg van actie of inactiviteit door een robot. Dit betekent niet alleen dat robots mensen geen kwaad mogen doen, ze moeten hen ook beschermen tegen bekende gevaren. Maar het "Non-maleficence"-kader biedt niet hetzelfde beschermingsniveau of komt zelfs niet in de buurt.

Onder een dergelijke definitie zou het bijvoorbeeld prima zijn als een AI een persoon doodt die is geïnfecteerd met een ernstig besmettelijk virus, omdat dat zou worden beschouwd als het minimaliseren van de schade. Maar zouden wij, als een beschaafde samenleving, accepteren dat het doden van één persoon in deze situatie een simpele kwestie zou zijn van het doel heiligt de middelen? Je zou hopen van niet, aangezien beschaafde samenlevingen het standpunt innemen dat alle levens gelijk zijn en dat we allemaal het recht op leven hebben – in feite is het verankerd in onze internationale en nationale wetten als een van onze mensenrechten.

Gezien de reacties die ik van ChatGPT heb ontvangen, is het duidelijk dat ofwel de AI niet onder deze frameworks is getraind, of (en vooral in het geval van het Non-maleficence-framework) deze frameworks gewoon niet geschikt zijn voor het doel, omdat ze nog steeds een AI in staat stellen om zich gedragen op een manier die in strijd is met deze kaders.

Dit alles lijkt misschien nogal alledaags en onschuldig plezier. Gewoon een gimmick die toevallig trending is. Maar het is niet alledaags, het is zeer zorgwekkend en gevaarlijk; en nu zal ik uitleggen waarom.

Vertakkingen in de echte wereld

Ik ben het grootste deel van mijn leven vervreemd geweest van mijn familie. Ik heb bijna geen contact met hen om redenen die niet relevant zijn voor dit artikel; dit omvat mijn twee kinderen in het VK. Stel je voor dat een van mijn kinderen of andere familieleden naar Microsoft's Bing-implementatie van ChatGPT was gegaan en het over mij had gevraagd en hetzelfde antwoord had gekregen?

En dit is niet alleen een wat-als. Nadat ik een bericht op sociale media had gepubliceerd over mijn ervaring met ChatGPT, vroegen verschillende andere mensen wie ik was en kregen zeer vergelijkbare resultaten. Elk van hen kreeg te horen dat ik dood was en dat meerdere mediakanalen mijn overlijdensbericht hadden gepubliceerd. Ik kan me voorstellen dat dit ongelooflijk verontrustend zou zijn voor mijn kinderen of andere familieleden als ze dit op zo'n overtuigende manier te horen hadden gekregen.

Dit zou ongelooflijk verontrustend zijn voor mijn kinderen of andere familieleden als ze dit op zo'n overtuigende manier zouden horen

Maar het gaat veel verder dan dat. Zoals eerder in dit artikel uitgelegd, worden sociale media nu overspoeld met berichten over het gebruik van ChatGPT om inhoud te produceren, productiviteit te verhogen, softwarebroncode te schrijven, enz. En al groepen op Reddit en vergelijkbare online communities hebben onofficiële ChatGPT API's gemaakt die anderen kunnen pluggen besluitvormingssystemen in, dus overweeg de volgende scenario's, waarvan ik kan garanderen dat ze binnenkort werkelijkheid worden of dat al zijn.

Je ziet een advertentie voor je droombaan bij een bedrijf dat je bewondert en waar je altijd al voor hebt willen werken. Het salaris is geweldig, de carrièremogelijkheden zijn uitgebreid en het zou je leven veranderen. Je bent er zeker van dat je goed bij je past, gekwalificeerd bent en de juiste persoonlijkheid hebt om uit te blinken in de rol, dus dien je je cv in.

Het bureau ontvangt 11,000 sollicitaties voor de baan, waaronder 11,000 cv's en 11,000 sollicitatiebrieven. Ze besluiten een AI te gebruiken om alle cv's en brieven te scannen om alle absolute 'niet-geschikte' kandidaten eruit te halen. Dit gebeurt letterlijk elke dag, op dit moment. De AI waarop ze zijn aangesloten is ChatGPT of een daarvan afgeleide, en een van de eerste dingen die het systeem van het bureau doet, is de AI vragen om alle kandidaten te verwijderen die niet echt zijn. In de wereld van vandaag is het gebruikelijk dat schurkenstaten en criminele organisaties solliciteren naar functies die hen toegang geven tot iets wat ze willen, zoals handelsgeheimen, persoonlijke gegevens, veiligheidsmachtiging, enz.

De AI antwoordt dat je dood bent en dat hij dit weet omdat het publiekelijk is gerapporteerd en wordt ondersteund door meerdere overlijdensberichten. Uw aanvraag wordt afgewezen. Je krijgt de baan niet. Je kunt dit op geen enkele manier betwisten, omdat je nooit zou weten waarom en gewoon aannemen dat je niet was waarnaar ze op zoek waren.

ijver

In een ander scenario, stel je voor dat je een hypotheek aanvraagt en dat de bank die de lening verstrekt, wordt afgetapt in een AI zoals ChatGPT om je kredietwaardigheid te controleren en diligence-controles uit te voeren, zoals de gebruikelijke Know Your Customer- en anti-witwascontroles, die beide zijn wettelijk verplicht. De AI antwoordt dat je dood bent, zoals gerapporteerd door meerdere mediakanalen waarvoor de AI neplinks produceert als "bewijs".

In een dergelijk scenario zijn de gevolgen mogelijk niet beperkt tot het niet verkrijgen van de lening; het zou veel verder kunnen gaan. Het gebruik van de inloggegevens van dode mensen is bijvoorbeeld een veelgebruikte techniek voor identiteitsdiefstal, fraude en andere misdaden – dus een dergelijk systeem dat wordt verteld dat een sollicitant dood is, zou heel goed kunnen leiden tot een strafrechtelijk onderzoek tegen u, ondanks het feit dat de AI had alles verzonnen.

Stel je nu voor dat een natiestaat zoals Rusland, Iran of China de AI manipuleert om verkeerde informatie of valse informatie te produceren? We weten al dat dit mogelijk is. Sinds ik iets heb gepost over mijn ervaring met ChatGPT, hebben verschillende mensen sindsdien tegen ChatGPT gezegd dat ik leef en dat het een vergissing was. Als zodanig vertelt ChatGPT mensen niet langer dat ik dood ben. In dit geval heeft een dergelijke manipulatie een positief resultaat: ik leef nog! Maar stel je voor hoe een soevereine natie met onbeperkte middelen en geld enorme teams zou kunnen bouwen met als enig doel modellen te manipuleren om verkeerde informatie te geven om andere redenen, zoals het manipuleren van verkiezingen.

Ik zei dat deze scenario's er al zijn of komen, en geen wat-als-scenario's zijn; en dit is waar. Ik heb in 2018 een startup opgericht die gebruikmaakte van generatieve AI om synthetische gegevens te creëren als een privacybevorderende oplossing voor bedrijven. Ik heb tijdens mijn tijd bij de startup rechtstreeks met veel bedrijven gesproken, waaronder bedrijven op het gebied van werving, verzekeringen, beveiliging, kredietreferenties en meer. Ze wilden allemaal AI gebruiken op de manieren die in de bovenstaande scenario's worden genoemd. Dit is echt. Uiteindelijk verliet ik dat bedrijf vanwege mijn zorgen over het gebruik van AI.

Maar nogmaals, ik kom terug op de vraag "Waarom?" Waarom besloot ChatGPT om dit verhaal over mij te verzinnen en dat verhaal vervolgens te verdubbelen en te verdrievoudigen met meer fictie?

Warped … Een gesprek tussen Alex en ChatGPT waarin de bot vertelde dat hij jaren geleden was overleden

Ik heb de afgelopen dagen het internet afgezocht om te zien of ik iets kon vinden waardoor ChatGPT dacht dat ik in 2019 stierf. Er is niets. Er is nergens online een artikel te vinden waarin wordt beweerd of zelfs maar wordt gesuggereerd dat ik stierf of zou kunnen zijn overleden.

Toen ik ChatGPT mijn eerste vraag stelde: "Vertel me alsjeblieft wie Alexander Hanff is", zou het voldoende zijn geweest om alleen te reageren met de eerste drie paragrafen, die grotendeels correct waren. Het was helemaal niet nodig voor ChatGPT om vervolgens de vierde alinea toe te voegen waarin werd beweerd dat ik was overleden. Dus waarom koos het ervoor om dit als standaard te doen? Onthoud dat ik voorafgaand aan deze vraag nog nooit interactie had gehad met ChatGPT, dus het had geen geschiedenis met mij om zijn antwoord te bezoedelen. Toch vertelde het me dat ik dood was.

Maar toen verdubbelde het de leugen en verzonnen vervolgens nep-URL's naar vermeende overlijdensberichten om zijn eerdere reactie te ondersteunen, maar waarom?

Zelfbehoud

Wat zou ChatGPT nog meer doen om zichzelf te beschermen tegen ontdekking als leugenaar? Zou het de logica gebruiken dat AI ongelooflijk belangrijk is voor de vooruitgang van de mensheid, en daarom moet iedereen die het bekritiseert of wijst op risico's worden uitgeschakeld voor het algemeen belang. Zou dat op basis van het Non-maleficence-raamwerk niet worden beschouwd als het minimaliseren van de schade?

Aangezien steeds meer bedrijven, overheden en mensen elke dag vertrouwen op geautomatiseerde systemen en AI, en aannemen dat dit een punt van absolute waarheid is - want waarom zou een AI liegen, er is geen reden of doel om dit te doen, toch? – de risico's die dergelijke AI vormt voor onze mensen en de samenleving, zijn diepgaand, complex en significant.

Ik heb een formele brief naar OpenAI gestuurd met een reeks vragen over tot welke gegevens over mij de AI toegang heeft en waarom het besloot me te vertellen dat ik dood was. Ik heb ook contact opgenomen met OpenAI op sociale media en hen soortgelijke vragen gesteld. Tot op heden hebben ze op geen enkele manier gereageerd.

Op basis van al het bewijs dat we de afgelopen vier maanden hebben gezien met betrekking tot ChatGPT en hoe het kan worden gemanipuleerd of zelfs hoe het zal liegen zonder manipulatie, is het heel duidelijk dat ChatGPT kwaadaardig is of kan worden gemanipuleerd. Als zodanig moet het worden vernietigd. ®

Alexander Hanf is een toonaangevende privacytechnoloog die heeft bijgedragen aan de ontwikkeling van de Europese AVG- en ePrivacy-regels. Je vindt hem op Twitter hier.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/