De eerste cybersecurity-startup van Josh Lospinoso werd in 2017 overgenomen door Raytheon/Forcepoint. Zijn tweede, Shift5, werkt samen met het Amerikaanse leger, spoorwegmaatschappijen en luchtvaartmaatschappijen, waaronder JetBlue. De 2009-jarige voormalige legerkapitein, afgestudeerd aan West Point in 36 en Rhodes Scholar, bracht meer dan tien jaar door het schrijven van hacktools voor de National Security Agency en US Cyber Command.

Lospinoso vertelde onlangs aan een subcommissie voor strijdkrachten van de Senaat hoe kunstmatige intelligentie militaire operaties kan helpen beschermen. De CEO/programmeur besprak het onderwerp met The Associated Press en hoe kwetsbaarheden in software in wapensystemen een grote bedreiging vormen voor het Amerikaanse leger. Het interview is bewerkt voor duidelijkheid en lengte.

V: In uw getuigenis beschreef u twee belangrijke bedreigingen voor AI-ondersteunde technologieën: de ene is diefstal. Dat spreekt voor zich. De andere is datavergiftiging. Kun je dat uitleggen?

A: Een manier om over datavergiftiging na te denken is als digitale desinformatie. Als tegenstanders in staat zijn om de gegevens te creëren die AI-technologieën zien, kunnen ze een diepgaande invloed hebben op de manier waarop die technologie werkt.

V: Vindt er gegevensvergiftiging plaats?

A: We zien het niet breed. Maar het is gebeurd. Een van de bekendste gevallen vond plaats in 2016. Microsoft bracht een Twitter-chatbot uit, genaamd Tay, die leerde van gesprekken die het online had. Kwaadwillende gebruikers spanden samen om er beledigende, aanstootgevende taal naar te tweeten. Tay begon opruiende inhoud te genereren. Microsoft heeft het offline gehaald.

V: AI is niet alleen chatbots. Het is al lang een integraal onderdeel van cyberbeveiliging, toch?

A: AI wordt gebruikt in e-mailfilters om ongewenste e-mail en phishing-lokmiddelen te markeren en te scheiden. Een ander voorbeeld zijn endpoints, zoals het antivirusprogramma op je laptop, of malwaredetectiesoftware die op netwerken draait. Natuurlijk gebruiken aanvallende hackers ook AI om die classificatiesystemen te omzeilen. Dat heet vijandige AI.

V: Laten we het hebben over militaire softwaresystemen. Een alarmerend 2018 Rapport van het Government Accountability Office zei dat bijna alle nieuw ontwikkelde wapensystemen missiekritieke kwetsbaarheden hadden. En het Pentagon denkt erover om AI in dergelijke systemen te stoppen?

A: Er zijn hier twee problemen. Ten eerste moeten we bestaande wapensystemen adequaat beveiligen. Dit is een technische schuld die we hebben en die heel lang zal duren om te betalen. Dan is er een nieuwe grens bij het beveiligen van AI-algoritmen - nieuwe dingen die we zouden installeren. Het GAO-rapport sprak niet echt over AI. Dus vergeet AI even. Als deze systemen blijven zoals ze zijn, zijn ze nog steeds zeer kwetsbaar.

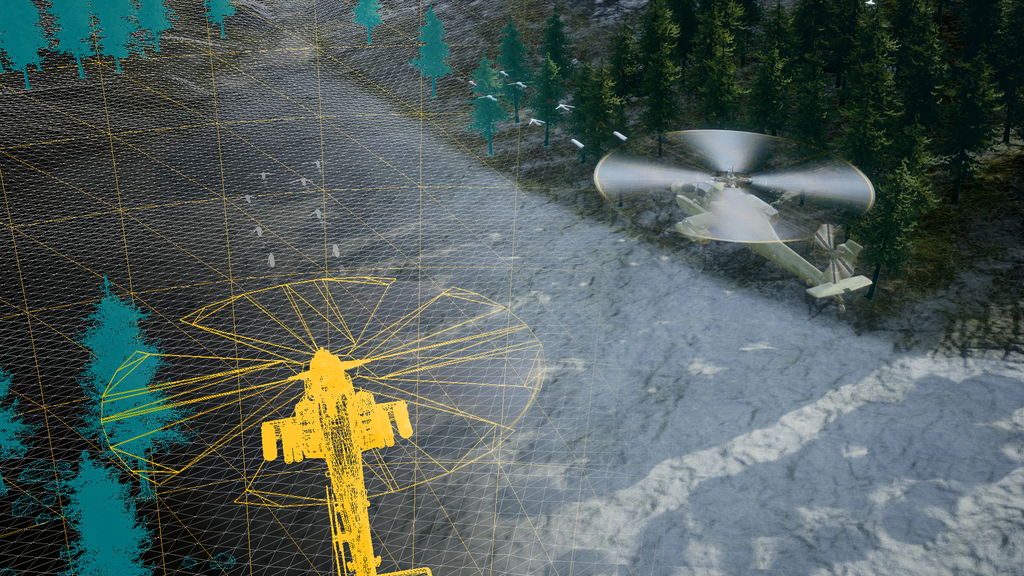

We bespreken het verleggen van grenzen en het toevoegen van AI-mogelijkheden voor zaken als verbeterd onderhoud en operationele intelligentie. Allemaal geweldig. Maar we bouwen bovenop een kaartenhuis. Veel systemen zijn tientallen jaren oud en achteraf uitgerust met digitale technologieën. Vliegtuigen, grondvoertuigen, ruimtemiddelen, onderzeeërs. Ze zijn nu met elkaar verbonden. We wisselen gegevens in en uit. De systemen zijn poreus, moeilijk te upgraden en kunnen worden aangevallen. Zodra een aanvaller toegang krijgt, is het game over.

Soms is het gemakkelijker om een nieuw platform te bouwen dan om de digitale componenten van bestaande systemen opnieuw te ontwerpen. Maar er is een rol weggelegd voor AI bij het beveiligen van deze systemen. AI kan worden gebruikt om te verdedigen als iemand ze probeert te compromitteren.

V: U getuigde dat het pauzeren van AI-onderzoek, zoals sommigen hebben aangedrongen, een slecht idee zou zijn omdat het China en andere concurrenten zou bevoordelen. Maar u maakt zich ook zorgen over de halsstarrige toeloop naar AI-producten. Waarom?

A: Ik wil niet fatalistisch klinken, maar de zogenaamde "burning-use"-case lijkt van toepassing te zijn. Een snel op de markt gebracht product vat vaak vlam (wordt gehackt, mislukt, richt onbedoelde schade aan). En we zeggen: 'Jongen, we hadden beveiliging moeten inbouwen.' Ik verwacht dat het tempo van de ontwikkeling van AI zal versnellen en dat we misschien niet genoeg pauzeren om dit op een veilige en verantwoorde manier te doen. In ieder geval bespreken het Witte Huis en het Congres deze kwesties.

V: Het lijkt erop dat een aantal bedrijven – ook in de defensiesector – zich haasten om halfbakken AI-producten aan te kondigen.

A: Elk technologiebedrijf en veel niet-technische bedrijven hebben bijna een schokkende wending genomen in de richting van AI. Economische ontwrichtingen komen eraan. Bedrijfsmodellen gaan fundamenteel veranderen. Ontwrichtingen zijn al aan de gang of liggen aan de horizon - en bedrijfsleiders proberen niet met voeten getreden te worden.

V: Hoe zit het met het gebruik van AI bij militaire besluitvorming, zoals bij het richten?

A: Ik denk absoluut niet dat algoritmen voor kunstmatige intelligentie — de gegevens die we verzamelen — klaar zijn om een dodelijk wapensysteem op prime time beslissingen te laten nemen. Daar zijn we gewoon zo ver van verwijderd.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Koop en verkoop aandelen in PRE-IPO-bedrijven met PREIPO®. Toegang hier.

- Bron: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/