Afbeelding door auteur

De Grote Taalmodellen (LLM) draaien op dit moment als een speer. Als u als organisatie echter niet over de juiste middelen beschikt, kan het een uitdaging zijn om op de grote golf van taalmodellen in te springen. Het trainen en inzetten van grote taalmodellen kan moeilijk zijn en je voelt je opeens buitengesloten. Open-source LLM's, zoals de LLaMA-serie van Meta, hebben ervoor gezorgd dat LLM-bronnen beschikbaar zijn.

En om toe te voegen aan de open-sourcecollectie is MosaicML-stichtingen' nieuwste toevoeging aan hun serie - MPT-7B.

MPT staat voor MosaicML Pretrained Transformer. MPT-modellen zijn decoder-only transformatoren in GPT-stijl die met veel verbeteringen worden geleverd:

- Prestatie-geoptimaliseerde laagimplementaties

- Grotere trainingsstabiliteit door architectuurwijzigingen

- Geen beperkingen voor de lengte van de context

MPT-7B is een transformatormodel dat helemaal opnieuw is getraind met behulp van 1T tokens aan tekst en code. Ja, 1 TRILJOEN! Het werd getraind op het MosaicML-platform, met een tijdsbestek van 9.5 dagen zonder menselijke tussenkomst. Kost MosaicML ~ $ 200.

Het is open-source, waardoor het beschikbaar is voor commercieel gebruik en de tool zal een game-wisselaar zijn voor de manier waarop bedrijven en organisaties werken met hun voorspellende analyses en besluitvormingsproces.

De belangrijkste kenmerken van MPT-7B zijn:

- Licentie voor commercieel gebruik

- Getraind op een grote hoeveelheid data (1T tokens)

- Kan extreem lange invoer aan

- Geoptimaliseerd voor snelle training en gevolgtrekking

- Zeer efficiënte open-source trainingscode.

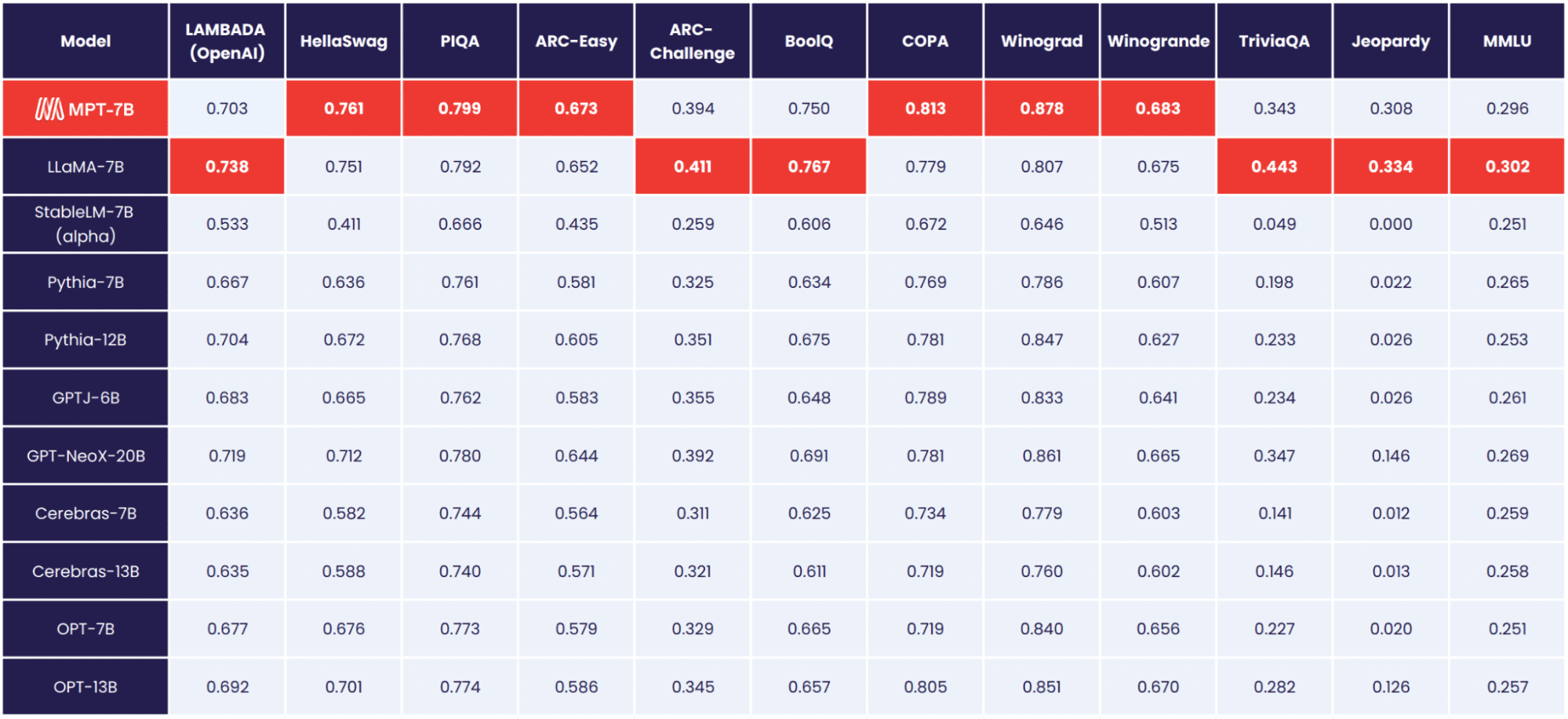

MPT-7B is het basismodel en het is aangetoond dat het beter presteert dan andere open-source 7B-20B-modellen. De kwaliteit van MPT-7B komt overeen met LLaMA-7B. Om de kwaliteit van MPT-7B te evalueren, heeft de MosaicML Foundation 11 open-source benchmarks samengesteld en geëvalueerd volgens de industriestandaard.

Afbeelding door Stichting MosaicML

MosaicML-stichtingen brengen ook drie extra verfijnde modellen uit:

- MPT-7B-Instrueren

- MPT-7B-Chat

- MPT-7B-StoryWriter-65k+

MPT-7B-Instrueren

De MPT-7B-Instrueren model is voor het volgen van instructies in korte vorm. Met 26,834 gedateerd op 14 mei, stelt MPT-7B-Instruct u in staat om snelle en korte vragen te stellen en krijgt u direct antwoord. Heeft u een vraag en wilt u gewoon een eenvoudig antwoord – gebruik dan MPT-7B-Instruct.

Waarom is dit zo geweldig? Meestal wordt aan LLM's geleerd om door te gaan met het genereren van tekst op basis van de geleverde invoer. Sommigen zijn echter op zoek naar LLM's die hun input als een instructie beschouwen. Dankzij de fijnafstemming van instructies kunnen LLM's instructie-volgende outputs uitvoeren.

MPT-7B-Chat

Ja, we hebben nog een chatbot. MPT-7B-Chat genereert dialoog. Als u bijvoorbeeld wilt dat de chatbot een toespraak genereert en deze context geeft, genereert deze een tekst op een gemoedelijke manier. Of misschien wil je een tweet schrijven die een paragraaf uit een artikel parafraseert, het kan de dialoog voor je genereren!

Waarom is dit zo geweldig? MPT-7B Chat is klaar en goed uitgerust voor een verscheidenheid aan conversatietaken en levert meer naadloze, boeiende multi-turn interacties voor gebruikers.

MPT-7B-StoryWriter-65k+

Dit is voor de verhalenschrijvers! Voor degenen die verhalen willen schrijven met een lange context, MPT-7B-StoryWriter-65k+ is een model dat precies daarvoor is ontworpen. Het model is gebouwd door MPT-7B te verfijnen met een contextlengte van 65k tokens, en het kan meer dan 65 tokens extrapoleren. MosaicML Foundation heeft 84 tokens kunnen genereren op een enkel knooppunt van A100-80GB GPU's.

Waarom is dit zo geweldig? Dit komt omdat de meeste open-source LLM's alleen reeksen met maximaal een paar duizend tokens aankunnen. Maar door slechts één node van 8xA100-80GB op het MosaicML-platform te gebruiken, kunt u MPT-7B finetunen om contextlengtes tot 65k aan te kunnen!

Het team van MosaicML bouwde deze modellen in slechts enkele weken. In slechts een paar weken tijd hebben ze de datavoorbereiding, training, finetuning en implementatie voor hun rekening genomen.

De gegevens waren afkomstig van verschillende bronnen, die allemaal een miljard tokens beschikbaar hadden in elke bron. Het aantal effectieve tokens heeft nog steeds een miljard in elke bron! Het gebruikte team van EleutherAI, GPT-NeoX en 20B tokenizer, waardoor ze kunnen trainen op een gevarieerde mix van gegevens, consistente ruimteafbakening kunnen toepassen en meer.

Alle MPT-7B-modellen zijn getraind op de MosaicML-platform, met behulp van A100-40GB en A100-80GB GPU's van Oracle Cloud.

Als u meer wilt weten over de tools en kosten van MPT-7B, lees dan de: MPT-7B-blog.

Het MosaicML-platform kan worden beschouwd als het beste startpunt voor organisaties, of het nu privé, commercieel of gemeenschapsgerelateerd is, om aangepaste LLM's te bouwen. Als deze open-sourcebron beschikbaar is, kunnen organisaties zich vrijer voelen over het gebruik van deze tools om de huidige organisatorische uitdagingen te verbeteren.

Klanten kunnen LLM's trainen op elke computerprovider of gegevensbron, met behoud van efficiëntie, privacy en kostentransparantie.

Waar denk je dat je MPT-7B voor gaat gebruiken? Laat het ons weten in de reacties hieronder

Nisha Arja is een datawetenschapper, freelance technisch schrijver en communitymanager bij KDnuggets. Ze is met name geïnteresseerd in het geven van loopbaanadvies of tutorials over Data Science en op theorie gebaseerde kennis rond Data Science. Ze wil ook de verschillende manieren onderzoeken waarop kunstmatige intelligentie de levensduur van de mens ten goede komt/kan komen. Een enthousiaste leerling, die haar technische kennis en schrijfvaardigheid wil verbreden, terwijl ze anderen helpt te begeleiden.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Koop en verkoop aandelen in PRE-IPO-bedrijven met PREIPO®. Toegang hier.

- Bron: https://www.kdnuggets.com/2023/05/introducing-mpt7b-new-opensource-llm.html?utm_source=rss&utm_medium=rss&utm_campaign=introducing-mpt-7b-a-new-open-source-llm