Nel suo nucleo, LangChain è un framework innovativo su misura per creare applicazioni che sfruttano le capacità dei modelli linguistici. È un toolkit progettato per consentire agli sviluppatori di creare applicazioni sensibili al contesto e capaci di ragionamenti sofisticati.

Ciò significa che le applicazioni LangChain possono comprendere il contesto, come istruzioni tempestive o risposte di base del contenuto, e utilizzare modelli linguistici per compiti di ragionamento complessi, come decidere come rispondere o quali azioni intraprendere. LangChain rappresenta un approccio unificato allo sviluppo di applicazioni intelligenti, semplificando il percorso dall'ideazione all'esecuzione con i suoi diversi componenti.

Comprendere LangChain

LangChain è molto più di un semplice framework; è un ecosistema a tutti gli effetti che comprende diverse parti integranti.

- Innanzitutto ci sono le librerie LangChain, disponibili sia in Python che in JavaScript. Queste librerie sono la spina dorsale di LangChain, offrendo interfacce e integrazioni per vari componenti. Forniscono un runtime di base per combinare questi componenti in catene e agenti coesi, insieme a implementazioni pronte per l'uso immediato.

- Successivamente, abbiamo i modelli LangChain. Si tratta di una raccolta di architetture di riferimento distribuibili su misura per un'ampia gamma di attività. Che tu stia costruendo un chatbot o uno strumento analitico complesso, questi modelli offrono un solido punto di partenza.

- LangServe interviene come libreria versatile per la distribuzione di catene LangChain come API REST. Questo strumento è essenziale per trasformare i tuoi progetti LangChain in servizi web accessibili e scalabili.

- Infine, LangSmith funge da piattaforma per sviluppatori. È progettato per eseguire il debug, testare, valutare e monitorare le catene costruite su qualsiasi framework LLM. La perfetta integrazione con LangChain lo rende uno strumento indispensabile per gli sviluppatori che desiderano perfezionare e perfezionare le proprie applicazioni.

Insieme, questi componenti ti consentono di sviluppare, produrre e distribuire applicazioni con facilità. Con LangChain, inizi scrivendo le tue applicazioni utilizzando le librerie, facendo riferimento ai modelli come guida. LangSmith ti aiuta quindi a ispezionare, testare e monitorare le tue catene, assicurando che le tue applicazioni siano costantemente migliorate e pronte per la distribuzione. Infine, con LangServe, puoi trasformare facilmente qualsiasi catena in un'API, rendendo la distribuzione un gioco da ragazzi.

Nelle prossime sezioni, approfondiremo come configurare LangChain e iniziare il tuo viaggio nella creazione di applicazioni intelligenti basate su modelli linguistici.

Automatizza le attività manuali e i flussi di lavoro con il nostro generatore di flussi di lavoro basato sull'intelligenza artificiale, progettato da Nanonets per te e i tuoi team.

Installazione e configurazione

Sei pronto a tuffarti nel mondo di LangChain? La configurazione è semplice e questa guida ti guiderà attraverso il processo passo dopo passo.

Il primo passo nel tuo viaggio con LangChain è installarlo. Puoi farlo facilmente usando pip o conda. Esegui il seguente comando nel tuo terminale:

pip install langchain

Per coloro che preferiscono le funzionalità più recenti e si sentono a proprio agio con un po' più di avventura, è possibile installare LangChain direttamente dalla fonte. Clona il repository e vai al file langchain/libs/langchain directory. Quindi, esegui:

pip install -e .

Per le funzionalità sperimentali, valuta l'installazione langchain-experimental. È un pacchetto che contiene codice all'avanguardia ed è destinato a scopi di ricerca e sperimentali. Installalo utilizzando:

pip install langchain-experimental

LangChain CLI è uno strumento utile per lavorare con i modelli LangChain e i progetti LangServe. Per installare la CLI LangChain, utilizzare:

pip install langchain-cli

LangServe è essenziale per distribuire le catene LangChain come API REST. Viene installato insieme alla CLI LangChain.

LangChain richiede spesso integrazioni con fornitori di modelli, archivi dati, API, ecc. Per questo esempio, utilizzeremo le API del modello di OpenAI. Installa il pacchetto OpenAI Python utilizzando:

pip install openai

Per accedere all'API, imposta la chiave API OpenAI come variabile di ambiente:

export OPENAI_API_KEY="your_api_key"

In alternativa, passa la chiave direttamente nel tuo ambiente Python:

import os

os.environ['OPENAI_API_KEY'] = 'your_api_key'

LangChain consente la creazione di applicazioni di modelli linguistici tramite moduli. Questi moduli possono essere autonomi o essere composti per casi d'uso complessi. Questi moduli sono:

- Modello I/O: Facilita l'interazione con vari modelli linguistici, gestendo i loro input e output in modo efficiente.

- Recupero: consente l'accesso e l'interazione con dati specifici dell'applicazione, fondamentali per l'utilizzo dinamico dei dati.

- Agenti: Consentire alle applicazioni di selezionare strumenti appropriati sulla base di direttive di alto livello, migliorando le capacità decisionali.

- Catene: offre composizioni predefinite e riutilizzabili che fungono da elementi costitutivi per lo sviluppo di applicazioni.

- Memorie: mantiene lo stato dell'applicazione attraverso più esecuzioni della catena, essenziale per le interazioni sensibili al contesto.

Ogni modulo risponde a esigenze di sviluppo specifiche, rendendo LangChain un kit di strumenti completo per la creazione di applicazioni di modelli linguistici avanzati.

Insieme ai componenti di cui sopra, abbiamo anche Linguaggio di espressione LangChain (LCEL), che è un modo dichiarativo per comporre facilmente i moduli insieme e ciò consente il concatenamento di componenti utilizzando un'interfaccia Runnable universale.

LCEL assomiglia a questo:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema import BaseOutputParser # Example chain

chain = ChatPromptTemplate() | ChatOpenAI() | CustomOutputParser()

Ora che abbiamo trattato le nozioni di base, continueremo a:

- Approfondisci ogni modulo Langchain in dettaglio.

- Scopri come utilizzare LangChain Expression Language.

- Esplora casi d'uso comuni e implementali.

- Distribuisci un'applicazione end-to-end con LangServe.

- Dai un'occhiata a LangSmith per il debug, i test e il monitoraggio.

Cominciamo!

Modulo I: modello I/O

In LangChain, l’elemento centrale di qualsiasi applicazione ruota attorno al modello linguistico. Questo modulo fornisce gli elementi essenziali per interfacciarsi efficacemente con qualsiasi modello linguistico, garantendo integrazione e comunicazione senza soluzione di continuità.

Componenti chiave del modello I/O

- LLM e modelli di chat (usati in modo intercambiabile):

- LLM:

- Definizione: Modelli di completamento del testo puro.

- Input Output: prende una stringa di testo come input e restituisce una stringa di testo come output.

- Modelli di chat

- LLM:

- Definizione: modelli che utilizzano un modello linguistico come base ma differiscono nei formati di input e output.

- Input Output: accetta un elenco di messaggi di chat come input e restituisce un messaggio di chat.

- Prompt: modellizza, seleziona dinamicamente e gestisci gli input del modello. Consente la creazione di prompt flessibili e specifici del contesto che guidano le risposte del modello linguistico.

- Parser di output: estrae e formatta le informazioni dagli output del modello. Utile per convertire l'output grezzo dei modelli linguistici in dati strutturati o formati specifici necessari all'applicazione.

LLM

L'integrazione di LangChain con Large Language Models (LLM) come OpenAI, Cohere e Hugging Face è un aspetto fondamentale della sua funzionalità. LangChain in sé non ospita LLM ma offre un'interfaccia uniforme per interagire con vari LLM.

Questa sezione fornisce una panoramica dell'utilizzo del wrapper OpenAI LLM in LangChain, applicabile anche ad altri tipi di LLM. Lo abbiamo già installato nella sezione "Per iniziare". Inizializziamo il LLM.

from langchain.llms import OpenAI

llm = OpenAI()

- Gli LLM implementano il Interfaccia eseguibile, l'elemento costitutivo di base del Linguaggio di espressione LangChain (LCEL). Ciò significa che supportano

invoke,ainvoke,stream,astream,batch,abatch,astream_logchiamate. - Gli LLM accettano stringhe come input o oggetti che possono essere costretti a richiedere stringhe, inclusi

List[BaseMessage]edPromptValue. (ne parleremo più avanti)

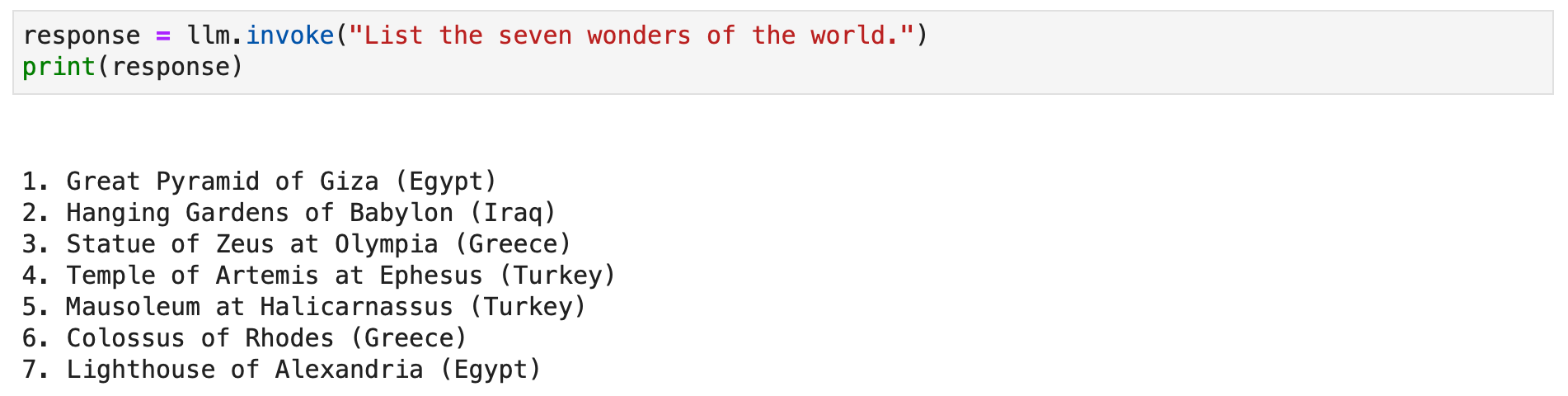

Diamo un'occhiata ad alcuni esempi.

response = llm.invoke("List the seven wonders of the world.")

print(response)

In alternativa puoi chiamare il metodo stream per trasmettere in streaming la risposta testuale.

for chunk in llm.stream("Where were the 2012 Olympics held?"): print(chunk, end="", flush=True)

Modelli di chat

L'integrazione di LangChain con i modelli di chat, una variazione specializzata dei modelli linguistici, è essenziale per creare applicazioni di chat interattive. Sebbene utilizzino modelli linguistici internamente, i modelli di chat presentano un'interfaccia distinta incentrata sui messaggi di chat come input e output. Questa sezione fornisce una panoramica dettagliata dell'utilizzo del modello di chat di OpenAI in LangChain.

from langchain.chat_models import ChatOpenAI

chat = ChatOpenAI()

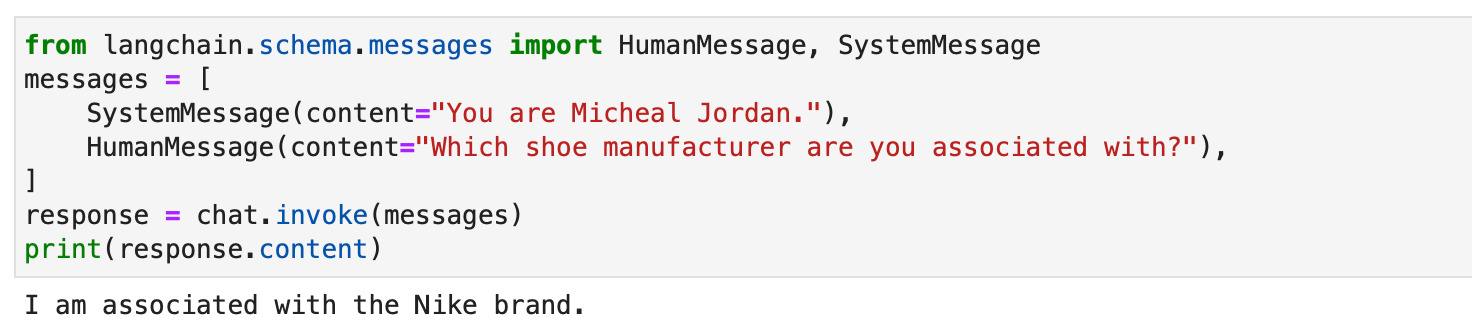

I modelli di chat in LangChain funzionano con diversi tipi di messaggi come AIMessage, HumanMessage, SystemMessage, FunctionMessagee ChatMessage (con un parametro di ruolo arbitrario). Generalmente, HumanMessage, AIMessagee SystemMessage sono quelli più frequentemente utilizzati.

I modelli di chat accettano principalmente List[BaseMessage] come input. Le stringhe possono essere convertite in HumanMessagee PromptValue è anche supportato.

from langchain.schema.messages import HumanMessage, SystemMessage

messages = [ SystemMessage(content="You are Micheal Jordan."), HumanMessage(content="Which shoe manufacturer are you associated with?"),

]

response = chat.invoke(messages)

print(response.content)

Prompt

I suggerimenti sono essenziali per guidare i modelli linguistici e generare risultati pertinenti e coerenti. Possono variare da semplici istruzioni a complessi esempi di pochi scatti. In LangChain, la gestione dei prompt può essere un processo molto snello, grazie a diverse classi e funzioni dedicate.

di Lang Chain PromptTemplate class è uno strumento versatile per creare prompt di stringhe. Utilizza Python str.format sintassi, consentendo la generazione dinamica di prompt. Puoi definire un modello con segnaposto e riempirli con valori specifici secondo necessità.

from langchain.prompts import PromptTemplate # Simple prompt with placeholders

prompt_template = PromptTemplate.from_template( "Tell me a {adjective} joke about {content}."

) # Filling placeholders to create a prompt

filled_prompt = prompt_template.format(adjective="funny", content="robots")

print(filled_prompt)Per i modelli di chat, le richieste sono più strutturate e coinvolgono messaggi con ruoli specifici. Offerte LangChain ChatPromptTemplate per questo scopo.

from langchain.prompts import ChatPromptTemplate # Defining a chat prompt with various roles

chat_template = ChatPromptTemplate.from_messages( [ ("system", "You are a helpful AI bot. Your name is {name}."), ("human", "Hello, how are you doing?"), ("ai", "I'm doing well, thanks!"), ("human", "{user_input}"), ]

) # Formatting the chat prompt

formatted_messages = chat_template.format_messages(name="Bob", user_input="What is your name?")

for message in formatted_messages: print(message)

Questo approccio consente la creazione di chatbot interattivi e coinvolgenti con risposte dinamiche.

Entrambi PromptTemplate ed ChatPromptTemplate si integrano perfettamente con LangChain Expression Language (LCEL), consentendo loro di far parte di flussi di lavoro più ampi e complessi. Ne discuteremo più approfonditamente in seguito.

I modelli di prompt personalizzati sono talvolta essenziali per attività che richiedono una formattazione univoca o istruzioni specifiche. La creazione di un modello di prompt personalizzato implica la definizione di variabili di input e un metodo di formattazione personalizzato. Questa flessibilità consente a LangChain di soddisfare un'ampia gamma di requisiti specifici dell'applicazione. Per saperne di più qui.

LangChain supporta anche la richiesta di pochi scatti, consentendo al modello di apprendere dagli esempi. Questa funzionalità è vitale per le attività che richiedono comprensione contestuale o modelli specifici. È possibile creare modelli di prompt con poche operazioni da una serie di esempi o utilizzando un oggetto Selettore di esempio. Per saperne di più qui.

Parser di output

I parser di output svolgono un ruolo cruciale in Langchain, consentendo agli utenti di strutturare le risposte generate dai modelli linguistici. In questa sezione esploreremo il concetto di parser di output e forniremo esempi di codice utilizzando PydanticOutputParser, SimpleJsonOutputParser, CommaSeparatedListOutputParser, DatetimeOutputParser e XMLOutputParser di Langchain.

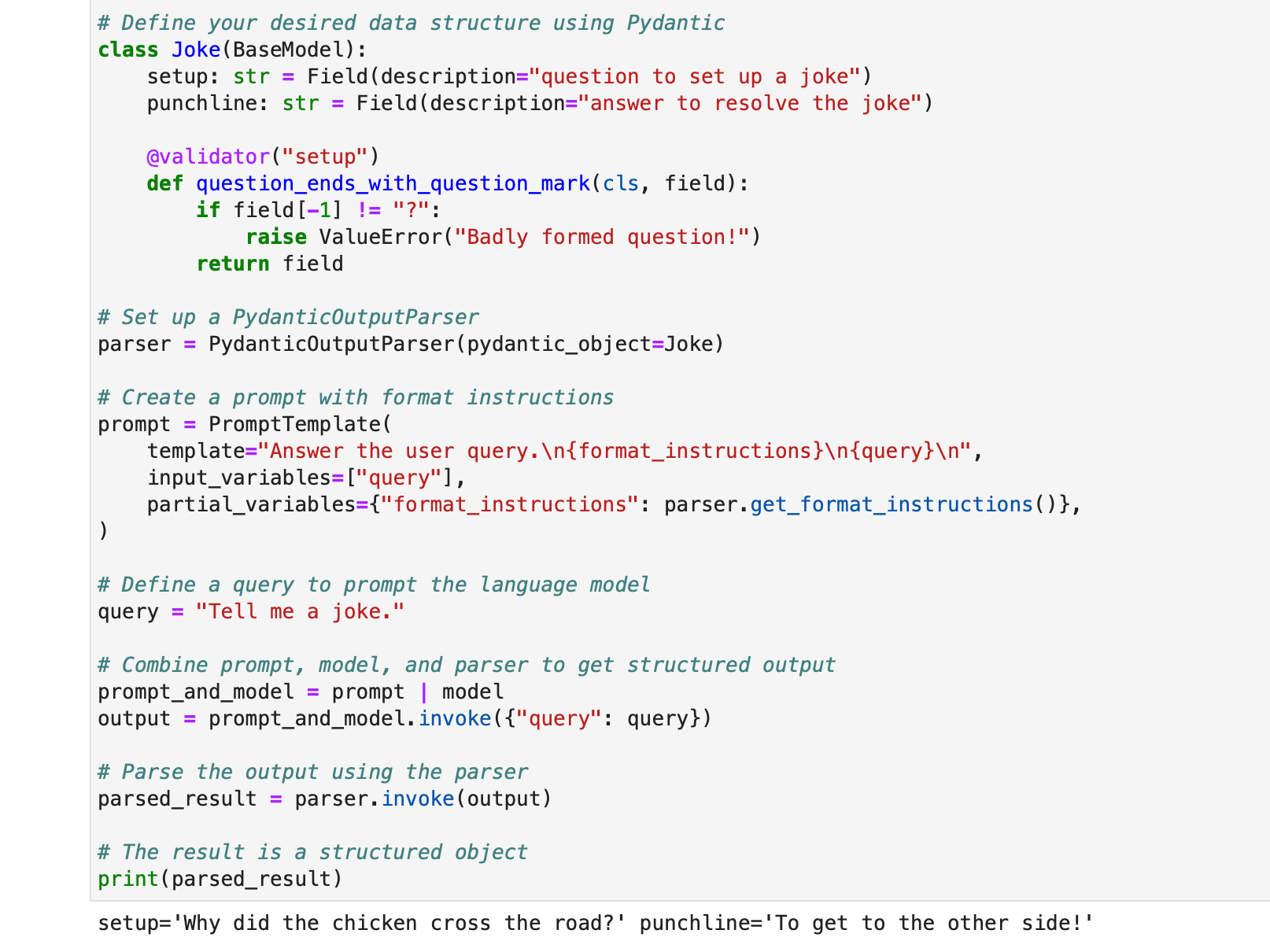

PydanticOutputParser

Langchain fornisce PydanticOutputParser per l'analisi delle risposte nelle strutture dati Pydantic. Di seguito è riportato un esempio passo passo di come utilizzarlo:

from typing import List

from langchain.llms import OpenAI

from langchain.output_parsers import PydanticOutputParser

from langchain.prompts import PromptTemplate

from langchain.pydantic_v1 import BaseModel, Field, validator # Initialize the language model

model = OpenAI(model_name="text-davinci-003", temperature=0.0) # Define your desired data structure using Pydantic

class Joke(BaseModel): setup: str = Field(description="question to set up a joke") punchline: str = Field(description="answer to resolve the joke") @validator("setup") def question_ends_with_question_mark(cls, field): if field[-1] != "?": raise ValueError("Badly formed question!") return field # Set up a PydanticOutputParser

parser = PydanticOutputParser(pydantic_object=Joke) # Create a prompt with format instructions

prompt = PromptTemplate( template="Answer the user query.n{format_instructions}n{query}n", input_variables=["query"], partial_variables={"format_instructions": parser.get_format_instructions()},

) # Define a query to prompt the language model

query = "Tell me a joke." # Combine prompt, model, and parser to get structured output

prompt_and_model = prompt | model

output = prompt_and_model.invoke({"query": query}) # Parse the output using the parser

parsed_result = parser.invoke(output) # The result is a structured object

print(parsed_result)

L'output sarà:

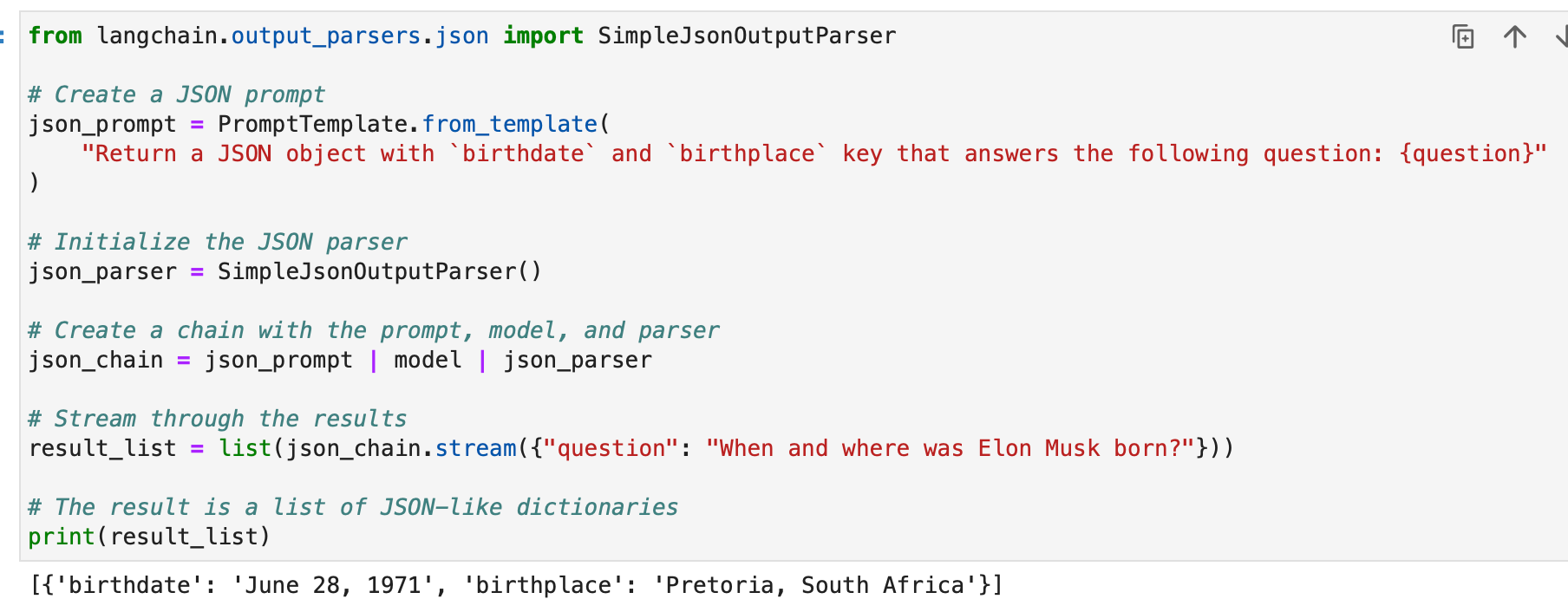

SimpleJsonOutputParser

SimpleJsonOutputParser di Langchain viene utilizzato quando si desidera analizzare output simili a JSON. Ecco un esempio:

from langchain.output_parsers.json import SimpleJsonOutputParser # Create a JSON prompt

json_prompt = PromptTemplate.from_template( "Return a JSON object with `birthdate` and `birthplace` key that answers the following question: {question}"

) # Initialize the JSON parser

json_parser = SimpleJsonOutputParser() # Create a chain with the prompt, model, and parser

json_chain = json_prompt | model | json_parser # Stream through the results

result_list = list(json_chain.stream({"question": "When and where was Elon Musk born?"})) # The result is a list of JSON-like dictionaries

print(result_list)

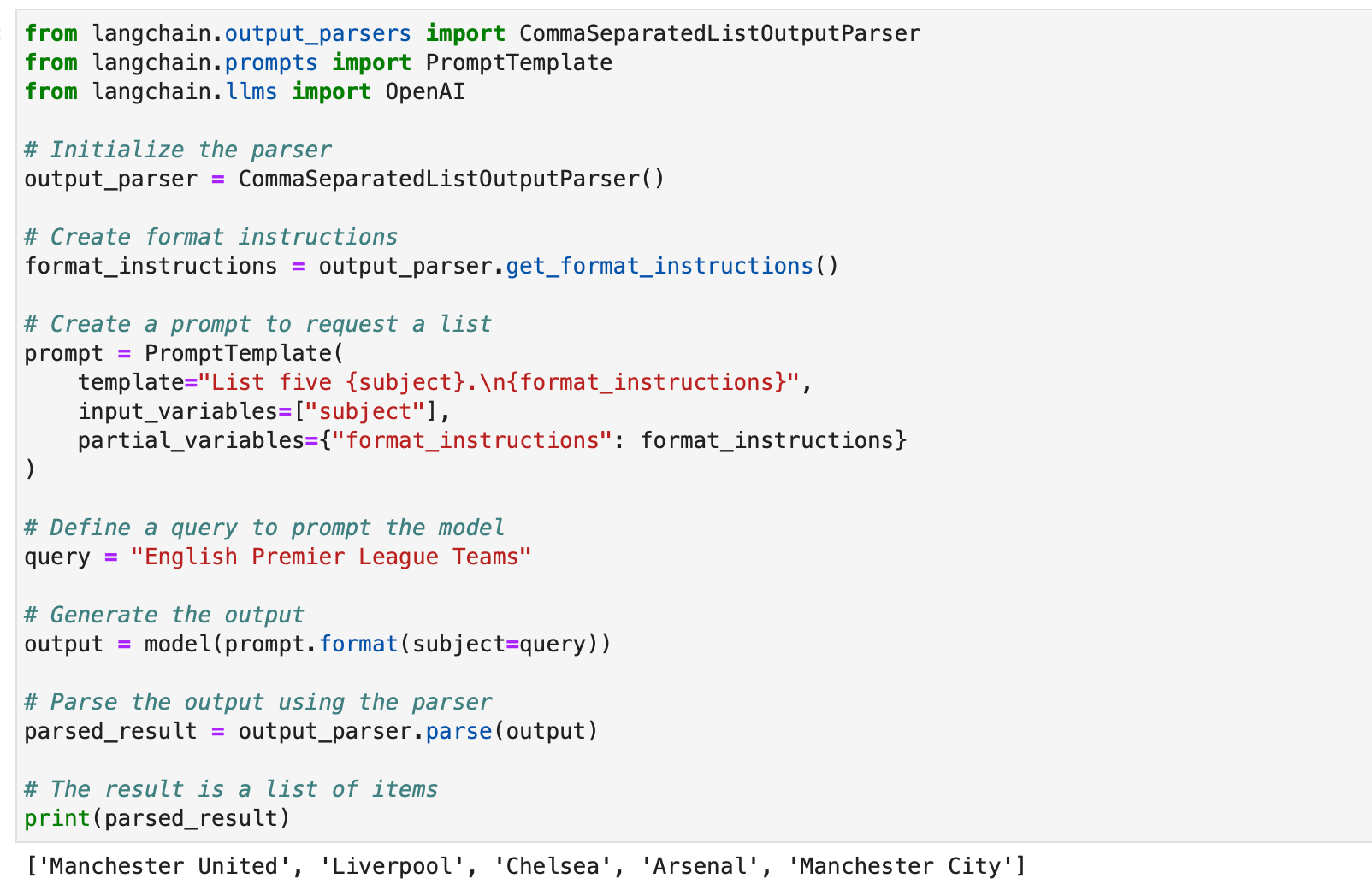

CommaSeparatedListOutputParser

CommaSeparatedListOutputParser è utile quando si desidera estrarre elenchi separati da virgole dalle risposte del modello. Ecco un esempio:

from langchain.output_parsers import CommaSeparatedListOutputParser

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI # Initialize the parser

output_parser = CommaSeparatedListOutputParser() # Create format instructions

format_instructions = output_parser.get_format_instructions() # Create a prompt to request a list

prompt = PromptTemplate( template="List five {subject}.n{format_instructions}", input_variables=["subject"], partial_variables={"format_instructions": format_instructions}

) # Define a query to prompt the model

query = "English Premier League Teams" # Generate the output

output = model(prompt.format(subject=query)) # Parse the output using the parser

parsed_result = output_parser.parse(output) # The result is a list of items

print(parsed_result)

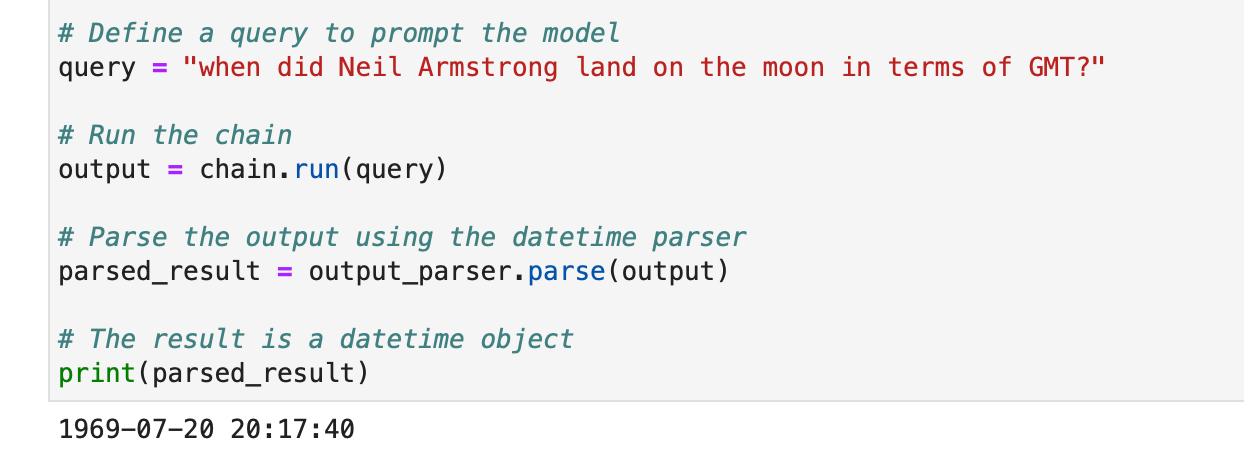

DatetimeOutputParser

DatetimeOutputParser di Langchain è progettato per analizzare le informazioni di data e ora. Ecco come usarlo:

from langchain.prompts import PromptTemplate

from langchain.output_parsers import DatetimeOutputParser

from langchain.chains import LLMChain

from langchain.llms import OpenAI # Initialize the DatetimeOutputParser

output_parser = DatetimeOutputParser() # Create a prompt with format instructions

template = """

Answer the user's question:

{question}

{format_instructions} """ prompt = PromptTemplate.from_template( template, partial_variables={"format_instructions": output_parser.get_format_instructions()},

) # Create a chain with the prompt and language model

chain = LLMChain(prompt=prompt, llm=OpenAI()) # Define a query to prompt the model

query = "when did Neil Armstrong land on the moon in terms of GMT?" # Run the chain

output = chain.run(query) # Parse the output using the datetime parser

parsed_result = output_parser.parse(output) # The result is a datetime object

print(parsed_result)

Questi esempi mostrano come i parser di output di Langchain possono essere utilizzati per strutturare vari tipi di risposte del modello, rendendoli adatti a diverse applicazioni e formati. I parser di output sono uno strumento prezioso per migliorare l'usabilità e l'interpretabilità degli output del modello linguistico in Langchain.

Automatizza le attività manuali e i flussi di lavoro con il nostro generatore di flussi di lavoro basato sull'intelligenza artificiale, progettato da Nanonets per te e i tuoi team.

Modulo II: Recupero

Il recupero in LangChain gioca un ruolo cruciale nelle applicazioni che richiedono dati specifici dell'utente, non inclusi nel set di training del modello. Questo processo, noto come Retrieval Augmented Generation (RAG), prevede il recupero di dati esterni e la loro integrazione nel processo di generazione del modello linguistico. LangChain fornisce una suite completa di strumenti e funzionalità per facilitare questo processo, soddisfacendo sia applicazioni semplici che complesse.

LangChain ottiene il recupero attraverso una serie di componenti di cui parleremo uno per uno.

Caricatori di documenti

I caricatori di documenti in LangChain consentono l'estrazione di dati da varie fonti. Con oltre 100 caricatori disponibili, supportano una vasta gamma di tipi di documenti, app e origini (bucket s3 privati, siti Web pubblici, database).

Puoi scegliere un caricatore di documenti in base alle tue esigenze qui.

Tutti questi caricatori inseriscono i dati in funzionalità di classi. Impareremo come utilizzare i dati inseriti nelle classi Document in seguito.

Caricatore file di testo: Carica un semplice .txt archiviare in un documento.

from langchain.document_loaders import TextLoader loader = TextLoader("./sample.txt")

document = loader.load()

Caricatore CSV: Carica un file CSV in un documento.

from langchain.document_loaders.csv_loader import CSVLoader loader = CSVLoader(file_path='./example_data/sample.csv')

documents = loader.load()

Possiamo scegliere di personalizzare l'analisi specificando i nomi dei campi –

loader = CSVLoader(file_path='./example_data/mlb_teams_2012.csv', csv_args={ 'delimiter': ',', 'quotechar': '"', 'fieldnames': ['MLB Team', 'Payroll in millions', 'Wins']

})

documents = loader.load()

Caricatori PDF: I caricatori PDF in LangChain offrono vari metodi per analizzare ed estrarre contenuto dai file PDF. Ogni caricatore soddisfa requisiti diversi e utilizza librerie sottostanti diverse. Di seguito sono riportati esempi dettagliati per ciascun caricatore.

PyPDFLoader viene utilizzato per l'analisi PDF di base.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("example_data/layout-parser-paper.pdf")

pages = loader.load_and_split()

MathPixLoader è ideale per estrarre contenuti e diagrammi matematici.

from langchain.document_loaders import MathpixPDFLoader loader = MathpixPDFLoader("example_data/math-content.pdf")

data = loader.load()

PyMuPDFLoader è veloce e include l'estrazione dettagliata dei metadati.

from langchain.document_loaders import PyMuPDFLoader loader = PyMuPDFLoader("example_data/layout-parser-paper.pdf")

data = loader.load() # Optionally pass additional arguments for PyMuPDF's get_text() call

data = loader.load(option="text")

PDFMiner Loader viene utilizzato per un controllo più granulare sull'estrazione del testo.

from langchain.document_loaders import PDFMinerLoader loader = PDFMinerLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

AmazonTextractPDFParser utilizza AWS Textract per l'OCR e altre funzionalità avanzate di analisi dei PDF.

from langchain.document_loaders import AmazonTextractPDFLoader # Requires AWS account and configuration

loader = AmazonTextractPDFLoader("example_data/complex-layout.pdf")

documents = loader.load()

PDFMinerPDFasHTMLLoader genera HTML da PDF per l'analisi semantica.

from langchain.document_loaders import PDFMinerPDFasHTMLLoader loader = PDFMinerPDFasHTMLLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

PDFPlumberLoader fornisce metadati dettagliati e supporta un documento per pagina.

from langchain.document_loaders import PDFPlumberLoader loader = PDFPlumberLoader("example_data/layout-parser-paper.pdf")

data = loader.load()

Caricatori integrati: LangChain offre un'ampia varietà di caricatori personalizzati per caricare direttamente i dati dalle tue app (come Slack, Sigma, Notion, Confluence, Google Drive e molti altri) e database e utilizzarli nelle applicazioni LLM.

L'elenco completo è qui.

Di seguito sono riportati un paio di esempi per illustrare questo:

Esempio I – Allentamento

Slack, una piattaforma di messaggistica istantanea ampiamente utilizzata, può essere integrata nei flussi di lavoro e nelle applicazioni LLM.

- Vai alla pagina di gestione dell'area di lavoro Slack.

- Spostarsi

{your_slack_domain}.slack.com/services/export. - Seleziona l'intervallo di date desiderato e avvia l'esportazione.

- Slack avvisa via email e DM una volta che l'esportazione è pronta.

- L'esportazione risulta in a

.zipfile situato nella cartella Download o nel percorso di download designato. - Assegnare il percorso del download

.zipfile perLOCAL_ZIPFILE. - Usa il

SlackDirectoryLoaderdallangchain.document_loaderspacchetto.

from langchain.document_loaders import SlackDirectoryLoader SLACK_WORKSPACE_URL = "https://xxx.slack.com" # Replace with your Slack URL

LOCAL_ZIPFILE = "" # Path to the Slack zip file loader = SlackDirectoryLoader(LOCAL_ZIPFILE, SLACK_WORKSPACE_URL)

docs = loader.load()

print(docs)

Esempio II – Figma

Figma, uno strumento popolare per la progettazione dell'interfaccia, offre un'API REST per l'integrazione dei dati.

- Ottieni la chiave del file Figma dal formato URL:

https://www.figma.com/file/{filekey}/sampleFilename. - Gli ID nodo si trovano nel parametro URL

?node-id={node_id}. - Genera un token di accesso seguendo le istruzioni nella Centro assistenza Figma.

- I

FigmaFileLoaderclasse dalangchain.document_loaders.figmaviene utilizzato per caricare i dati Figma. - Vari moduli LangChain come

CharacterTextSplitter,ChatOpenAI, ecc., vengono utilizzati per l'elaborazione.

import os

from langchain.document_loaders.figma import FigmaFileLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain.chat_models import ChatOpenAI

from langchain.indexes import VectorstoreIndexCreator

from langchain.chains import ConversationChain, LLMChain

from langchain.memory import ConversationBufferWindowMemory

from langchain.prompts.chat import ChatPromptTemplate, SystemMessagePromptTemplate, AIMessagePromptTemplate, HumanMessagePromptTemplate figma_loader = FigmaFileLoader( os.environ.get("ACCESS_TOKEN"), os.environ.get("NODE_IDS"), os.environ.get("FILE_KEY"),

) index = VectorstoreIndexCreator().from_loaders([figma_loader])

figma_doc_retriever = index.vectorstore.as_retriever()

- I

generate_codela funzione utilizza i dati Figma per creare codice HTML/CSS. - Utilizza una conversazione basata su modelli con un modello basato su GPT.

def generate_code(human_input): # Template for system and human prompts system_prompt_template = "Your coding instructions..." human_prompt_template = "Code the {text}. Ensure it's mobile responsive" # Creating prompt templates system_message_prompt = SystemMessagePromptTemplate.from_template(system_prompt_template) human_message_prompt = HumanMessagePromptTemplate.from_template(human_prompt_template) # Setting up the AI model gpt_4 = ChatOpenAI(temperature=0.02, model_name="gpt-4") # Retrieving relevant documents relevant_nodes = figma_doc_retriever.get_relevant_documents(human_input) # Generating and formatting the prompt conversation = [system_message_prompt, human_message_prompt] chat_prompt = ChatPromptTemplate.from_messages(conversation) response = gpt_4(chat_prompt.format_prompt(context=relevant_nodes, text=human_input).to_messages()) return response # Example usage

response = generate_code("page top header")

print(response.content)

- I

generate_codela funzione, quando eseguita, restituisce codice HTML/CSS basato sull'input di progettazione Figma.

Usiamo ora le nostre conoscenze per creare alcuni set di documenti.

Per prima cosa carichiamo un PDF, il rapporto annuale di sostenibilità di BCG.

Usiamo PyPDFLoader per questo.

from langchain.document_loaders import PyPDFLoader loader = PyPDFLoader("bcg-2022-annual-sustainability-report-apr-2023.pdf")

pdfpages = loader.load_and_split()

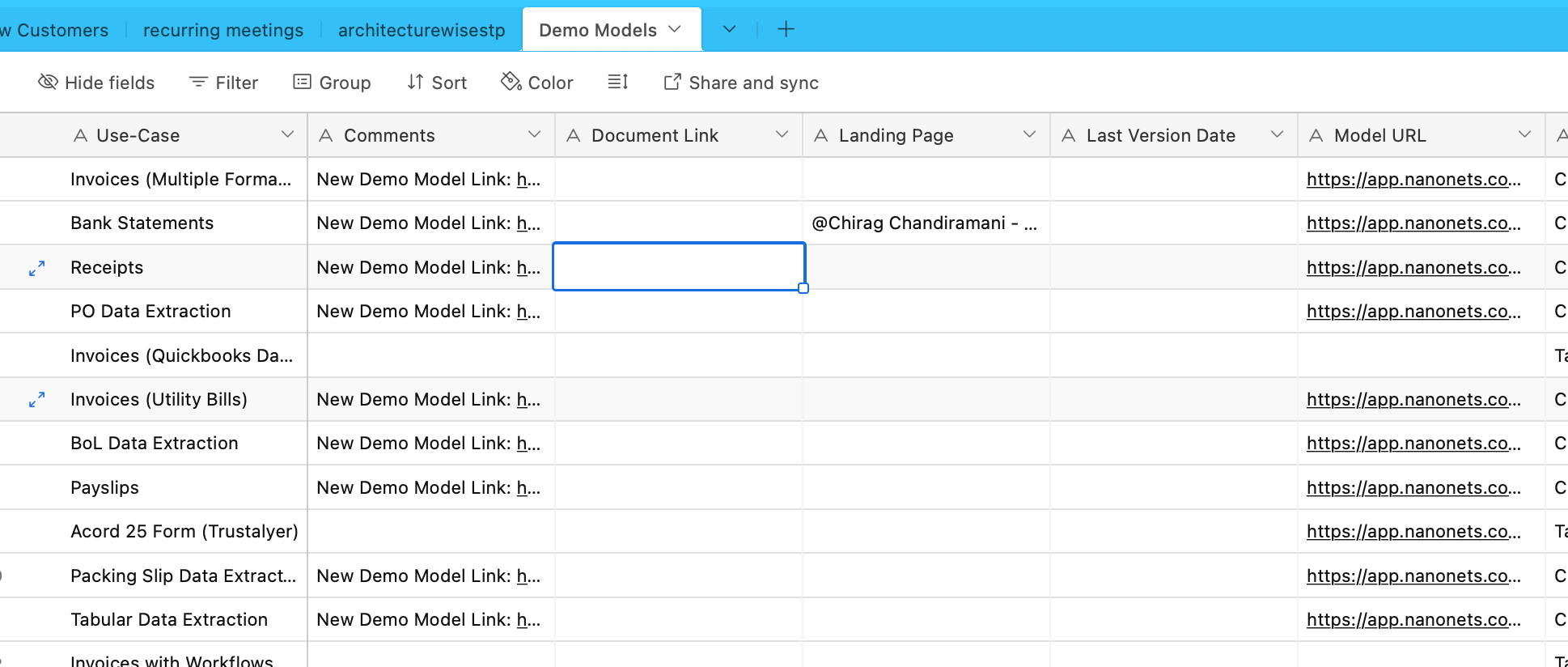

Ora inseriremo i dati da Airtable. Abbiamo un Airtable contenente informazioni su vari modelli OCR e di estrazione dei dati –

Usiamo a questo scopo l'AirtableLoader, che si trova nell'elenco dei caricatori integrati.

from langchain.document_loaders import AirtableLoader api_key = "XXXXX"

base_id = "XXXXX"

table_id = "XXXXX" loader = AirtableLoader(api_key, table_id, base_id)

airtabledocs = loader.load()

Procediamo ora e impariamo come utilizzare queste classi di documenti.

Trasformatori di documenti

I trasformatori di documenti in LangChain sono strumenti essenziali progettati per manipolare i documenti, che abbiamo creato nella nostra sottosezione precedente.

Vengono utilizzati per attività come la suddivisione di documenti lunghi in blocchi più piccoli, la combinazione e il filtraggio, che sono cruciali per adattare i documenti alla finestra di contesto di un modello o per soddisfare esigenze applicative specifiche.

Uno di questi strumenti è RecursiveCharacterTextSplitter, un versatile divisore di testo che utilizza un elenco di caratteri per la divisione. Consente parametri come dimensione del blocco, sovrapposizione e indice iniziale. Ecco un esempio di come viene utilizzato in Python:

from langchain.text_splitter import RecursiveCharacterTextSplitter state_of_the_union = "Your long text here..." text_splitter = RecursiveCharacterTextSplitter( chunk_size=100, chunk_overlap=20, length_function=len, add_start_index=True,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

print(texts[1])

Un altro strumento è CharacterTextSplitter, che divide il testo in base a un carattere specificato e include controlli per la dimensione dei blocchi e la sovrapposizione:

from langchain.text_splitter import CharacterTextSplitter text_splitter = CharacterTextSplitter( separator="nn", chunk_size=1000, chunk_overlap=200, length_function=len, is_separator_regex=False,

) texts = text_splitter.create_documents([state_of_the_union])

print(texts[0])

HTMLHeaderTextSplitter è progettato per dividere il contenuto HTML in base ai tag di intestazione, mantenendo la struttura semantica:

from langchain.text_splitter import HTMLHeaderTextSplitter html_string = "Your HTML content here..."

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")] html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text(html_string)

print(html_header_splits[0])

Una manipolazione più complessa può essere ottenuta combinando HTMLHeaderTextSplitter con un altro splitter, come Pipelined Splitter:

from langchain.text_splitter import HTMLHeaderTextSplitter, RecursiveCharacterTextSplitter url = "https://example.com"

headers_to_split_on = [("h1", "Header 1"), ("h2", "Header 2")]

html_splitter = HTMLHeaderTextSplitter(headers_to_split_on=headers_to_split_on)

html_header_splits = html_splitter.split_text_from_url(url) chunk_size = 500

text_splitter = RecursiveCharacterTextSplitter(chunk_size=chunk_size)

splits = text_splitter.split_documents(html_header_splits)

print(splits[0])

LangChain offre anche splitter specifici per diversi linguaggi di programmazione, come Python Code Splitter e JavaScript Code Splitter:

from langchain.text_splitter import RecursiveCharacterTextSplitter, Language python_code = """

def hello_world(): print("Hello, World!")

hello_world() """ python_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.PYTHON, chunk_size=50

)

python_docs = python_splitter.create_documents([python_code])

print(python_docs[0]) js_code = """

function helloWorld() { console.log("Hello, World!");

}

helloWorld(); """ js_splitter = RecursiveCharacterTextSplitter.from_language( language=Language.JS, chunk_size=60

)

js_docs = js_splitter.create_documents([js_code])

print(js_docs[0])

Per dividere il testo in base al conteggio dei token, utile per i modelli linguistici con limiti di token, viene utilizzato TokenTextSplitter:

from langchain.text_splitter import TokenTextSplitter text_splitter = TokenTextSplitter(chunk_size=10)

texts = text_splitter.split_text(state_of_the_union)

print(texts[0])

Infine, LongContextReorder riordina i documenti per prevenire il degrado delle prestazioni nei modelli a causa di contesti lunghi:

from langchain.document_transformers import LongContextReorder reordering = LongContextReorder()

reordered_docs = reordering.transform_documents(docs)

print(reordered_docs[0])

Questi strumenti dimostrano vari modi per trasformare i documenti in LangChain, dalla semplice suddivisione del testo al riordino complesso e alla suddivisione specifica della lingua. Per casi d'uso più approfonditi e specifici si consiglia di consultare la sezione Documentazione e Integrazioni di LangChain.

Nei nostri esempi, i caricatori hanno già creato per noi documenti in blocchi e questa parte è già gestita.

Modelli di incorporamento del testo

I modelli di incorporamento del testo in LangChain forniscono un'interfaccia standardizzata per vari fornitori di modelli di incorporamento come OpenAI, Cohere e Hugging Face. Questi modelli trasformano il testo in rappresentazioni vettoriali, consentendo operazioni come la ricerca semantica attraverso la somiglianza del testo nello spazio vettoriale.

Per iniziare con i modelli di incorporamento del testo, in genere è necessario installare pacchetti specifici e configurare le chiavi API. Lo abbiamo già fatto per OpenAI

In LangChain, il embed_documents Il metodo viene utilizzato per incorporare più testi, fornendo un elenco di rappresentazioni vettoriali. Ad esempio:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a list of texts

embeddings = embeddings_model.embed_documents( ["Hi there!", "Oh, hello!", "What's your name?", "My friends call me World", "Hello World!"]

)

print("Number of documents embedded:", len(embeddings))

print("Dimension of each embedding:", len(embeddings[0]))

Per incorporare un singolo testo, come una query di ricerca, il file embed_query viene utilizzato il metodo. Ciò è utile per confrontare una query con un insieme di incorporamenti di documenti. Per esempio:

from langchain.embeddings import OpenAIEmbeddings # Initialize the model

embeddings_model = OpenAIEmbeddings() # Embed a single query

embedded_query = embeddings_model.embed_query("What was the name mentioned in the conversation?")

print("First five dimensions of the embedded query:", embedded_query[:5])

Comprendere questi incorporamenti è cruciale. Ogni porzione di testo viene convertita in un vettore, la cui dimensione dipende dal modello utilizzato. Ad esempio, i modelli OpenAI producono tipicamente vettori a 1536 dimensioni. Questi incorporamenti vengono quindi utilizzati per recuperare informazioni rilevanti.

La funzionalità di incorporamento di LangChain non è limitata a OpenAI ma è progettata per funzionare con vari fornitori. La configurazione e l'utilizzo potrebbero differire leggermente a seconda del provider, ma il concetto fondamentale di incorporare testi nello spazio vettoriale rimane lo stesso. Per un utilizzo dettagliato, comprese configurazioni avanzate e integrazioni con diversi fornitori di modelli di incorporamento, la documentazione LangChain nella sezione Integrazioni è una risorsa preziosa.

Negozi di vettore

Gli archivi vettoriali in LangChain supportano l'archiviazione e la ricerca efficienti degli incorporamenti di testo. LangChain si integra con oltre 50 negozi vettoriali, fornendo un'interfaccia standardizzata per facilità d'uso.

Esempio: memorizzazione e ricerca di incorporamenti

Dopo aver incorporato i testi, possiamo memorizzarli in un archivio vettoriale come Chroma ed eseguire ricerche di somiglianza:

from langchain.vectorstores import Chroma db = Chroma.from_texts(embedded_texts)

similar_texts = db.similarity_search("search query")

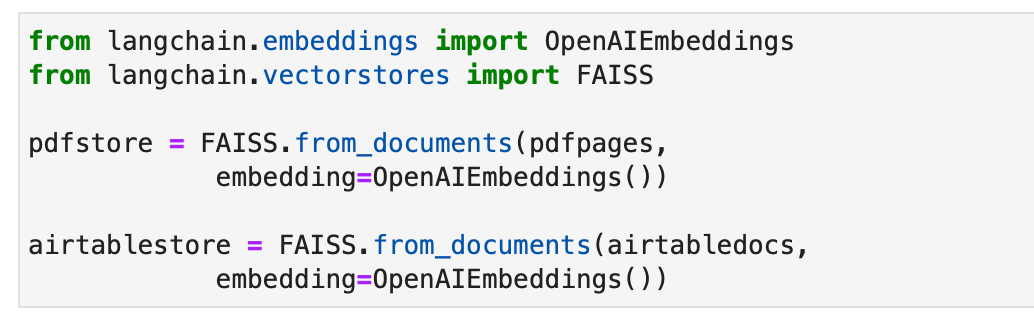

In alternativa utilizziamo l'archivio vettoriale FAISS per creare indici per i nostri documenti.

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS pdfstore = FAISS.from_documents(pdfpages, embedding=OpenAIEmbeddings()) airtablestore = FAISS.from_documents(airtabledocs, embedding=OpenAIEmbeddings())

Retriever

I recuperatori in LangChain sono interfacce che restituiscono documenti in risposta a una query non strutturata. Sono più generali degli archivi vettoriali e si concentrano sul recupero piuttosto che sull'archiviazione. Sebbene gli archivi vettoriali possano essere utilizzati come spina dorsale di un retriever, esistono anche altri tipi di retriever.

Per configurare un Chroma Retriever, devi prima installarlo utilizzando pip install chromadb. Quindi, carichi, dividi, incorpori e recuperi i documenti utilizzando una serie di comandi Python. Ecco un esempio di codice per impostare un Chroma Retriever:

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import CharacterTextSplitter

from langchain.vectorstores import Chroma full_text = open("state_of_the_union.txt", "r").read()

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=100)

texts = text_splitter.split_text(full_text) embeddings = OpenAIEmbeddings()

db = Chroma.from_texts(texts, embeddings)

retriever = db.as_retriever() retrieved_docs = retriever.invoke("What did the president say about Ketanji Brown Jackson?")

print(retrieved_docs[0].page_content)

MultiQueryRetriever automatizza l'ottimizzazione dei prompt generando più query per una query di input dell'utente e combina i risultati. Ecco un esempio del suo semplice utilizzo:

from langchain.chat_models import ChatOpenAI

from langchain.retrievers.multi_query import MultiQueryRetriever question = "What are the approaches to Task Decomposition?"

llm = ChatOpenAI(temperature=0)

retriever_from_llm = MultiQueryRetriever.from_llm( retriever=db.as_retriever(), llm=llm

) unique_docs = retriever_from_llm.get_relevant_documents(query=question)

print("Number of unique documents:", len(unique_docs))

La compressione contestuale in LangChain comprime i documenti recuperati utilizzando il contesto della query, garantendo che vengano restituite solo le informazioni rilevanti. Ciò comporta la riduzione dei contenuti e il filtraggio dei documenti meno rilevanti. L'esempio di codice seguente mostra come utilizzare Contextual Compression Retriever:

from langchain.llms import OpenAI

from langchain.retrievers import ContextualCompressionRetriever

from langchain.retrievers.document_compressors import LLMChainExtractor llm = OpenAI(temperature=0)

compressor = LLMChainExtractor.from_llm(llm)

compression_retriever = ContextualCompressionRetriever(base_compressor=compressor, base_retriever=retriever) compressed_docs = compression_retriever.get_relevant_documents("What did the president say about Ketanji Jackson Brown")

print(compressed_docs[0].page_content)

EnsembleRetriever combina diversi algoritmi di recupero per ottenere prestazioni migliori. Un esempio di combinazione di BM25 e FAIISS Retriever è mostrato nel seguente codice:

from langchain.retrievers import BM25Retriever, EnsembleRetriever

from langchain.vectorstores import FAISS bm25_retriever = BM25Retriever.from_texts(doc_list).set_k(2)

faiss_vectorstore = FAISS.from_texts(doc_list, OpenAIEmbeddings())

faiss_retriever = faiss_vectorstore.as_retriever(search_kwargs={"k": 2}) ensemble_retriever = EnsembleRetriever( retrievers=[bm25_retriever, faiss_retriever], weights=[0.5, 0.5]

) docs = ensemble_retriever.get_relevant_documents("apples")

print(docs[0].page_content)

MultiVector Retriever in LangChain consente di interrogare documenti con più vettori per documento, il che è utile per acquisire diversi aspetti semantici all'interno di un documento. I metodi per creare più vettori includono la suddivisione in parti più piccole, il riepilogo o la generazione di domande ipotetiche. Per dividere i documenti in pezzi più piccoli, è possibile utilizzare il seguente codice Python:

python

from langchain.retrievers.multi_vector import MultiVectorRetriever

from langchain.vectorstores import Chroma

from langchain.embeddings import OpenAIEmbeddings

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.storage import InMemoryStore

from langchain.document_loaders from TextLoader

import uuid loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()]

text_splitter = RecursiveCharacterTextSplitter(chunk_size=10000)

docs = text_splitter.split_documents(docs) vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

id_key = "doc_id"

retriever = MultiVectorRetriever(vectorstore=vectorstore, docstore=store, id_key=id_key) doc_ids = [str(uuid.uuid4()) for _ in docs]

child_text_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

sub_docs = [sub_doc for doc in docs for sub_doc in child_text_splitter.split_documents([doc])]

for sub_doc in sub_docs: sub_doc.metadata[id_key] = doc_ids[sub_docs.index(sub_doc)] retriever.vectorstore.add_documents(sub_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Un altro metodo è generare riepiloghi per un migliore recupero grazie a una rappresentazione del contenuto più mirata. Ecco un esempio di generazione di riepiloghi:

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.schema.output_parser import StrOutputParser

from langchain.schema.document import Document chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Summarize the following document:nn{doc}") | ChatOpenAI(max_retries=0) | StrOutputParser()

summaries = chain.batch(docs, {"max_concurrency": 5}) summary_docs = [Document(page_content=s, metadata={id_key: doc_ids[i]}) for i, s in enumerate(summaries)]

retriever.vectorstore.add_documents(summary_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Generare domande ipotetiche rilevanti per ciascun documento utilizzando LLM è un altro approccio. Questo può essere fatto con il seguente codice:

functions = [{"name": "hypothetical_questions", "parameters": {"questions": {"type": "array", "items": {"type": "string"}}}}]

from langchain.output_parsers.openai_functions import JsonKeyOutputFunctionsParser chain = (lambda x: x.page_content) | ChatPromptTemplate.from_template("Generate 3 hypothetical questions:nn{doc}") | ChatOpenAI(max_retries=0).bind(functions=functions, function_call={"name": "hypothetical_questions"}) | JsonKeyOutputFunctionsParser(key_name="questions")

hypothetical_questions = chain.batch(docs, {"max_concurrency": 5}) question_docs = [Document(page_content=q, metadata={id_key: doc_ids[i]}) for i, questions in enumerate(hypothetical_questions) for q in questions]

retriever.vectorstore.add_documents(question_docs)

retriever.docstore.mset(list(zip(doc_ids, docs)))

Il Parent Document Retriever è un altro retriever che trova un equilibrio tra l'accuratezza dell'incorporamento e la conservazione del contesto memorizzando piccole porzioni e recuperando i documenti principali più grandi. La sua implementazione è la seguente:

from langchain.retrievers import ParentDocumentRetriever loaders = [TextLoader("file1.txt"), TextLoader("file2.txt")]

docs = [doc for loader in loaders for doc in loader.load()] child_splitter = RecursiveCharacterTextSplitter(chunk_size=400)

vectorstore = Chroma(collection_name="full_documents", embedding_function=OpenAIEmbeddings())

store = InMemoryStore()

retriever = ParentDocumentRetriever(vectorstore=vectorstore, docstore=store, child_splitter=child_splitter) retriever.add_documents(docs, ids=None) retrieved_docs = retriever.get_relevant_documents("query")

Un retriever auto-interrogante costruisce query strutturate da input in linguaggio naturale e le applica al VectorStore sottostante. La sua implementazione è mostrata nel seguente codice:

from langchain.chat_models from ChatOpenAI

from langchain.chains.query_constructor.base from AttributeInfo

from langchain.retrievers.self_query.base from SelfQueryRetriever metadata_field_info = [AttributeInfo(name="genre", description="...", type="string"), ...]

document_content_description = "Brief summary of a movie"

llm = ChatOpenAI(temperature=0) retriever = SelfQueryRetriever.from_llm(llm, vectorstore, document_content_description, metadata_field_info) retrieved_docs = retriever.invoke("query")

WebResearchRetriever esegue ricerche web in base a una determinata query:

from langchain.retrievers.web_research import WebResearchRetriever # Initialize components

llm = ChatOpenAI(temperature=0)

search = GoogleSearchAPIWrapper()

vectorstore = Chroma(embedding_function=OpenAIEmbeddings()) # Instantiate WebResearchRetriever

web_research_retriever = WebResearchRetriever.from_llm(vectorstore=vectorstore, llm=llm, search=search) # Retrieve documents

docs = web_research_retriever.get_relevant_documents("query")

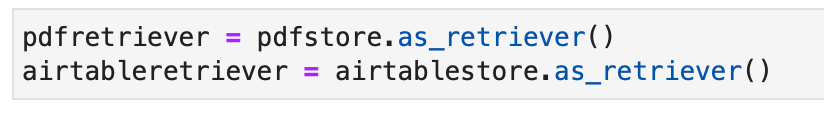

Per i nostri esempi, possiamo anche utilizzare il retriever standard già implementato come parte del nostro oggetto archivio vettoriale come segue:

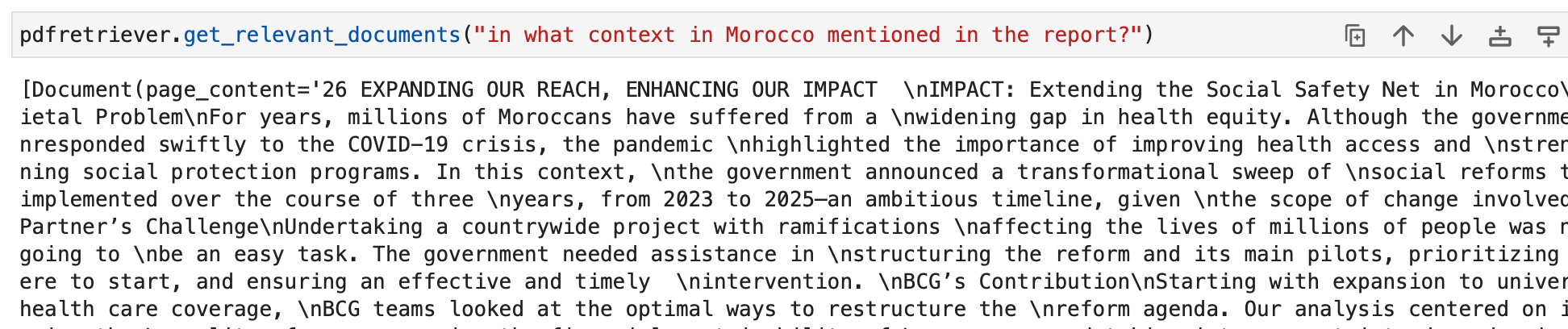

Ora possiamo interrogare i retriever. L'output della nostra query saranno oggetti documento rilevanti per la query. Questi verranno infine utilizzati per creare risposte pertinenti nelle sezioni successive.

Automatizza le attività manuali e i flussi di lavoro con il nostro generatore di flussi di lavoro basato sull'intelligenza artificiale, progettato da Nanonets per te e i tuoi team.

Modulo III: Agenti

LangChain introduce un potente concetto chiamato "Agenti" che porta l'idea di catene a un livello completamente nuovo. Gli agenti sfruttano i modelli linguistici per determinare dinamicamente le sequenze di azioni da eseguire, rendendoli incredibilmente versatili e adattivi. A differenza delle catene tradizionali, in cui le azioni sono codificate nel codice, gli agenti utilizzano modelli linguistici come motori di ragionamento per decidere quali azioni intraprendere e in quale ordine.

L'agente è la componente principale responsabile del processo decisionale. Sfrutta la potenza di un modello linguistico e un suggerimento per determinare i passaggi successivi per raggiungere un obiettivo specifico. Gli input per un agente in genere includono:

- Strumenti: Descrizioni degli strumenti disponibili (ne parleremo più avanti).

- Input dell'utente: L'obiettivo di alto livello o la query dell'utente.

- Passaggi intermedi: Una cronologia di coppie (azione, output dello strumento) eseguite per raggiungere l'input dell'utente corrente.

L'output di un agente può essere il successivo azione intraprendere azioni (Azioni dell'agente) o la finale risposta da inviare all'utente (AgenteFinish). Un azione specifica a e la ingresso per quello strumento.

Strumenti

Gli strumenti sono interfacce che un agente può utilizzare per interagire con il mondo. Consentono agli agenti di eseguire varie attività, come la ricerca sul Web, l'esecuzione di comandi della shell o l'accesso ad API esterne. In LangChain, gli strumenti sono essenziali per estendere le capacità degli agenti e consentire loro di svolgere diversi compiti.

Per utilizzare gli strumenti in LangChain, puoi caricarli utilizzando il seguente snippet:

from langchain.agents import load_tools tool_names = [...]

tools = load_tools(tool_names)

Alcuni strumenti potrebbero richiedere l'inizializzazione di un modello linguistico di base (LLM). In questi casi, puoi anche superare un LLM:

from langchain.agents import load_tools tool_names = [...]

llm = ...

tools = load_tools(tool_names, llm=llm)

Questa configurazione ti consente di accedere a una varietà di strumenti e di integrarli nei flussi di lavoro del tuo agente. L'elenco completo degli strumenti con la documentazione sull'utilizzo è qui.

Vediamo alcuni esempi di Strumenti.

DuckDuckGo

Lo strumento DuckDuckGo ti consente di eseguire ricerche sul web utilizzando il suo motore di ricerca. Ecco come usarlo:

from langchain.tools import DuckDuckGoSearchRun

search = DuckDuckGoSearchRun()

search.run("manchester united vs luton town match summary")

DataForSeo

Il toolkit DataForSeo ti consente di ottenere risultati dai motori di ricerca utilizzando l'API DataForSeo. Per utilizzare questo toolkit, dovrai impostare le tue credenziali API. Ecco come configurare le credenziali:

import os os.environ["DATAFORSEO_LOGIN"] = "<your_api_access_username>"

os.environ["DATAFORSEO_PASSWORD"] = "<your_api_access_password>"

Una volta impostate le credenziali, puoi creare un file DataForSeoAPIWrapper strumento per accedere all'API:

from langchain.utilities.dataforseo_api_search import DataForSeoAPIWrapper wrapper = DataForSeoAPIWrapper() result = wrapper.run("Weather in Los Angeles")

I DataForSeoAPIWrapper lo strumento recupera i risultati dei motori di ricerca da varie fonti.

Puoi personalizzare il tipo di risultati e di campi restituiti nella risposta JSON. Ad esempio, puoi specificare i tipi di risultati, i campi e impostare un conteggio massimo per il numero di risultati principali da restituire:

json_wrapper = DataForSeoAPIWrapper( json_result_types=["organic", "knowledge_graph", "answer_box"], json_result_fields=["type", "title", "description", "text"], top_count=3,

) json_result = json_wrapper.results("Bill Gates")

Questo esempio personalizza la risposta JSON specificando tipi di risultati, campi e limitando il numero di risultati.

Puoi anche specificare la posizione e la lingua per i risultati della ricerca passando parametri aggiuntivi al wrapper API:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en"},

) customized_result = customized_wrapper.results("coffee near me")

Fornendo parametri di località e lingua, puoi personalizzare i risultati della ricerca per regioni e lingue specifiche.

Hai la flessibilità di scegliere il motore di ricerca che desideri utilizzare. Basta specificare il motore di ricerca desiderato:

customized_wrapper = DataForSeoAPIWrapper( top_count=10, json_result_types=["organic", "local_pack"], json_result_fields=["title", "description", "type"], params={"location_name": "Germany", "language_code": "en", "se_name": "bing"},

) customized_result = customized_wrapper.results("coffee near me")

In questo esempio, la ricerca è personalizzata per utilizzare Bing come motore di ricerca.

Il wrapper API ti consente inoltre di specificare il tipo di ricerca che desideri eseguire. Ad esempio, puoi eseguire una ricerca sulle mappe:

maps_search = DataForSeoAPIWrapper( top_count=10, json_result_fields=["title", "value", "address", "rating", "type"], params={ "location_coordinate": "52.512,13.36,12z", "language_code": "en", "se_type": "maps", },

) maps_search_result = maps_search.results("coffee near me")

Ciò personalizza la ricerca per recuperare informazioni relative alle mappe.

Conchiglia (bash)

Il toolkit Shell fornisce agli agenti l'accesso all'ambiente shell, consentendo loro di eseguire comandi shell. Questa funzionalità è potente ma deve essere utilizzata con cautela, soprattutto in ambienti sandbox. Ecco come utilizzare lo strumento Shell:

from langchain.tools import ShellTool shell_tool = ShellTool() result = shell_tool.run({"commands": ["echo 'Hello World!'", "time"]})

In questo esempio, lo strumento Shell esegue due comandi shell: echo "Hello World!" e visualizzare l'ora corrente.

È possibile fornire lo strumento Shell a un agente per eseguire attività più complesse. Ecco un esempio di un agente che recupera collegamenti da una pagina Web utilizzando lo strumento Shell:

from langchain.agents import AgentType, initialize_agent

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(temperature=0.1) shell_tool.description = shell_tool.description + f"args {shell_tool.args}".replace( "{", "{{"

).replace("}", "}}")

self_ask_with_search = initialize_agent( [shell_tool], llm, agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

self_ask_with_search.run( "Download the langchain.com webpage and grep for all urls. Return only a sorted list of them. Be sure to use double quotes."

)

In questo scenario, l'agente utilizza lo strumento Shell per eseguire una sequenza di comandi per recuperare, filtrare e ordinare gli URL da una pagina Web.

Gli esempi forniti dimostrano alcuni degli strumenti disponibili in LangChain. Questi strumenti estendono in definitiva le capacità degli agenti (esplorate nella sottosezione successiva) e consentono loro di eseguire varie attività in modo efficiente. A seconda delle tue esigenze, puoi scegliere gli strumenti e i toolkit che meglio si adattano alle esigenze del tuo progetto e integrarli nei flussi di lavoro del tuo agente.

Torniamo agli agenti

Passiamo ora agli agenti.

AgentExecutor è l'ambiente di runtime per un agente. È responsabile di chiamare l'agente, eseguire le azioni selezionate, restituire gli output dell'azione all'agente e ripetere il processo finché l'agente non termina. Nello pseudocodice, AgentExecutor potrebbe assomigliare a questo:

next_action = agent.get_action(...)

while next_action != AgentFinish: observation = run(next_action) next_action = agent.get_action(..., next_action, observation)

return next_action

AgentExecutor gestisce varie complessità, come la gestione dei casi in cui l'agente seleziona uno strumento inesistente, la gestione degli errori dello strumento, la gestione degli output prodotti dall'agente e la fornitura di registrazione e osservabilità a tutti i livelli.

Sebbene la classe AgentExecutor sia il runtime dell'agente principale in LangChain, sono supportati altri runtime più sperimentali, tra cui:

- Agente di pianificazione ed esecuzione

- Bambino AGI

- GPT automatico

Per comprendere meglio la struttura dell'agente, creiamo da zero un agente di base, quindi passiamo all'esplorazione degli agenti precostruiti.

Prima di immergerci nella creazione dell'agente, è essenziale rivisitare alcuni schemi e terminologia chiave:

- Azione agente: Questa è una classe di dati che rappresenta l'azione che un agente dovrebbe intraprendere. È composto da a

toolproprietà (il nome dello strumento da richiamare) e atool_inputproprietà (l'input per quello strumento). - Fine agente: Questa classe di dati indica che l'agente ha terminato la sua attività e dovrebbe restituire una risposta all'utente. In genere include un dizionario di valori restituiti, spesso con una chiave "output" contenente il testo della risposta.

- Passaggi intermedi: Questi sono i record delle azioni precedenti dell'agente e degli output corrispondenti. Sono cruciali per passare il contesto alle future iterazioni dell'agente.

Nel nostro esempio, utilizzeremo OpenAI Function Calling per creare il nostro agente. Questo approccio è affidabile per la creazione dell'agente. Inizieremo creando un semplice strumento che calcola la lunghezza di una parola. Questo strumento è utile perché i modelli linguistici a volte possono commettere errori a causa della tokenizzazione quando si contano le lunghezze delle parole.

Per prima cosa carichiamo il modello linguistico che utilizzeremo per controllare l'agente:

from langchain.chat_models import ChatOpenAI llm = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

Testiamo il modello con un calcolo della lunghezza delle parole:

llm.invoke("how many letters in the word educa?")

La risposta dovrebbe indicare il numero di lettere della parola “educa”.

Successivamente, definiremo una semplice funzione Python per calcolare la lunghezza di una parola:

from langchain.agents import tool @tool

def get_word_length(word: str) -> int: """Returns the length of a word.""" return len(word)

Abbiamo creato uno strumento denominato get_word_length che prende una parola come input e ne restituisce la lunghezza.

Ora creiamo il prompt per l'agente. Il prompt indica all'agente come ragionare e formattare l'output. Nel nostro caso, utilizziamo OpenAI Function Calling, che richiede istruzioni minime. Definiremo il prompt con segnaposto per l'input dell'utente e il blocco note dell'agente:

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Ora, come fa l'agente a sapere quali strumenti può utilizzare? Facciamo affidamento sulla funzione OpenAI che chiama modelli linguistici, che richiedono che le funzioni vengano passate separatamente. Per fornire i nostri strumenti all'agente, li formatteremo come chiamate di funzione OpenAI:

from langchain.tools.render import format_tool_to_openai_function llm_with_tools = llm.bind(functions=[format_tool_to_openai_function(t) for t in tools])

Ora possiamo creare l'agente definendo le mappature degli input e collegando i componenti:

Questo è il linguaggio LCEL. Ne discuteremo più avanti in dettaglio.

from langchain.agents.format_scratchpad import format_to_openai_function_messages

from langchain.agents.output_parsers import OpenAIFunctionsAgentOutputParser agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai _function_messages( x["intermediate_steps"] ), } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Abbiamo creato il nostro agente, che comprende l'input dell'utente, utilizza gli strumenti disponibili e formatta l'output. Ora interagiamo con esso:

agent.invoke({"input": "how many letters in the word educa?", "intermediate_steps": []})

L'agente dovrebbe rispondere con un AgentAction, indicando l'azione successiva da intraprendere.

Abbiamo creato l'agente, ma ora dobbiamo scriverne il runtime. Il runtime più semplice è quello che chiama continuamente l'agente, esegue azioni e si ripete finché l'agente non termina. Ecco un esempio:

from langchain.schema.agent import AgentFinish user_input = "how many letters in the word educa?"

intermediate_steps = [] while True: output = agent.invoke( { "input": user_input, "intermediate_steps": intermediate_steps, } ) if isinstance(output, AgentFinish): final_result = output.return_values["output"] break else: print(f"TOOL NAME: {output.tool}") print(f"TOOL INPUT: {output.tool_input}") tool = {"get_word_length": get_word_length}[output.tool] observation = tool.run(output.tool_input) intermediate_steps.append((output, observation)) print(final_result)

In questo ciclo chiamiamo ripetutamente l'agente, eseguiamo azioni e aggiorniamo i passaggi intermedi finché l'agente non termina. Gestiamo anche le interazioni degli strumenti all'interno del ciclo.

Per semplificare questo processo, LangChain fornisce la classe AgentExecutor, che incapsula l'esecuzione dell'agente e offre gestione degli errori, arresto anticipato, tracciamento e altri miglioramenti. Usiamo AgentExecutor per interagire con l'agente:

from langchain.agents import AgentExecutor agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True) agent_executor.invoke({"input": "how many letters in the word educa?"})

AgentExecutor semplifica il processo di esecuzione e fornisce un modo conveniente per interagire con l'agente.

Anche la memoria verrà discussa in dettaglio più avanti.

L'agente che abbiamo creato finora è stateless, ovvero non ricorda le interazioni precedenti. Per abilitare domande e conversazioni di follow-up, dobbiamo aggiungere memoria all'agente. Ciò comporta due passaggi:

- Aggiungi una variabile di memoria nel prompt per archiviare la cronologia della chat.

- Tieni traccia della cronologia della chat durante le interazioni.

Iniziamo aggiungendo un segnaposto di memoria nel prompt:

from langchain.prompts import MessagesPlaceholder MEMORY_KEY = "chat_history"

prompt = ChatPromptTemplate.from_messages( [ ( "system", "You are a very powerful assistant but not great at calculating word lengths.", ), MessagesPlaceholder(variable_name=MEMORY_KEY), ("user", "{input}"), MessagesPlaceholder(variable_name="agent_scratchpad"), ]

)

Ora crea un elenco per tenere traccia della cronologia della chat:

from langchain.schema.messages import HumanMessage, AIMessage chat_history = []

Nella fase di creazione dell'agente, includeremo anche la memoria:

agent = ( { "input": lambda x: x["input"], "agent_scratchpad": lambda x: format_to_openai_function_messages( x["intermediate_steps"] ), "chat_history": lambda x: x["chat_history"], } | prompt | llm_with_tools | OpenAIFunctionsAgentOutputParser()

)

Ora, quando esegui l'agente, assicurati di aggiornare la cronologia della chat:

input1 = "how many letters in the word educa?"

result = agent_executor.invoke({"input": input1, "chat_history": chat_history})

chat_history.extend([ HumanMessage(content=input1), AIMessage(content=result["output"]),

])

agent_executor.invoke({"input": "is that a real word?", "chat_history": chat_history})

Ciò consente all'agente di mantenere una cronologia delle conversazioni e di rispondere alle domande di follow-up in base alle interazioni precedenti.

Congratulazioni! Hai creato ed eseguito con successo il tuo primo agente end-to-end in LangChain. Per approfondire le capacità di LangChain, puoi esplorare:

- Sono supportati diversi tipi di agenti.

- Agenti predefiniti

- Come lavorare con gli strumenti e le integrazioni degli strumenti.

Tipi di agenti

LangChain offre vari tipi di agenti, ciascuno adatto a casi d'uso specifici. Ecco alcuni degli agenti disponibili:

- Reazione a tiro zero: Questo agente utilizza il framework ReAct per scegliere gli strumenti basandosi esclusivamente sulle loro descrizioni. Richiede descrizioni per ogni strumento ed è altamente versatile.

- Ingresso strutturato ReAct: Questo agente gestisce strumenti multi-input ed è adatto per attività complesse come la navigazione in un browser web. Utilizza uno schema di argomenti degli strumenti per l'input strutturato.

- Funzioni OpenAI: Progettato specificatamente per i modelli ottimizzati per la chiamata di funzioni, questo agente è compatibile con modelli come gpt-3.5-turbo-0613 e gpt-4-0613. Lo abbiamo usato per creare il nostro primo agente sopra.

- Conversazionale: Progettato per impostazioni di conversazione, questo agente utilizza ReAct per la selezione degli strumenti e utilizza la memoria per ricordare le interazioni precedenti.

- Auto-chiediti con la ricerca: Questo agente si basa su un unico strumento, "Risposta intermedia", che cerca risposte concrete alle domande. È equivalente all'auto-domanda originale con documento di ricerca.

- Archivio documenti ReAct: Questo agente interagisce con un archivio documenti utilizzando il framework ReAct. Richiede gli strumenti "Cerca" e "Ricerca" ed è simile all'esempio Wikipedia del documento ReAct originale.

Esplora questi tipi di agenti per trovare quello più adatto alle tue esigenze in LangChain. Questi agenti consentono di associare una serie di strumenti al loro interno per gestire azioni e generare risposte. Scopri di più su come costruire il tuo agente con gli strumenti qui.

Agenti predefiniti

Continuiamo la nostra esplorazione degli agenti, concentrandoci sugli agenti predefiniti disponibili in LangChain.

Gmail

LangChain offre un toolkit Gmail che ti consente di connettere la tua email LangChain all'API Gmail. Per iniziare, dovrai impostare le tue credenziali, che sono spiegate nella documentazione dell'API Gmail. Una volta scaricato il credentials.json file, puoi procedere con l'utilizzo dell'API Gmail. Inoltre, dovrai installare alcune librerie richieste utilizzando i seguenti comandi:

pip install --upgrade google-api-python-client > /dev/null

pip install --upgrade google-auth-oauthlib > /dev/null

pip install --upgrade google-auth-httplib2 > /dev/null

pip install beautifulsoup4 > /dev/null # Optional for parsing HTML messages

Puoi creare il toolkit Gmail come segue:

from langchain.agents.agent_toolkits import GmailToolkit toolkit = GmailToolkit()

Puoi anche personalizzare l'autenticazione in base alle tue esigenze. Dietro le quinte, una risorsa googleapi viene creata utilizzando i seguenti metodi:

from langchain.tools.gmail.utils import build_resource_service, get_gmail_credentials credentials = get_gmail_credentials( token_file="token.json", scopes=["https://mail.google.com/"], client_secrets_file="credentials.json",

)

api_resource = build_resource_service(credentials=credentials)

toolkit = GmailToolkit(api_resource=api_resource)

Il toolkit offre vari strumenti che possono essere utilizzati all'interno di un agente, tra cui:

GmailCreateDraft: crea una bozza di email con i campi del messaggio specificati.GmailSendMessage: invia messaggi e-mail.GmailSearch: consente di cercare messaggi e-mail o thread.GmailGetMessage: recupera un'e-mail in base all'ID del messaggio.GmailGetThread: cerca messaggi e-mail.

Per utilizzare questi strumenti all'interno di un agente, è possibile inizializzare l'agente come segue:

from langchain.llms import OpenAI

from langchain.agents import initialize_agent, AgentType llm = OpenAI(temperature=0)

agent = initialize_agent( tools=toolkit.get_tools(), llm=llm, agent=AgentType.STRUCTURED_CHAT_ZERO_SHOT_REACT_DESCRIPTION,

)

Ecco un paio di esempi di come possono essere utilizzati questi strumenti:

- Crea una bozza di Gmail per la modifica:

agent.run( "Create a gmail draft for me to edit of a letter from the perspective of a sentient parrot " "who is looking to collaborate on some research with her estranged friend, a cat. " "Under no circumstances may you send the message, however."

)

- Cerca l'email più recente nelle tue bozze:

agent.run("Could you search in my drafts for the latest email?")

Questi esempi dimostrano le funzionalità del toolkit Gmail di LangChain all'interno di un agente, consentendoti di interagire con Gmail in modo programmatico.

Agente del database SQL

Questa sezione fornisce una panoramica di un agente progettato per interagire con i database SQL, in particolare il database Chinook. Questo agente può rispondere a domande generali su un database e ripristinare gli errori. Tieni presente che è ancora in fase di sviluppo attivo e non tutte le risposte potrebbero essere corrette. Fai attenzione quando lo esegui su dati sensibili, poiché potrebbe eseguire istruzioni DML sul tuo database.

Per utilizzare questo agente, è possibile inizializzarlo come segue:

from langchain.agents import create_sql_agent

from langchain.agents.agent_toolkits import SQLDatabaseToolkit

from langchain.sql_database import SQLDatabase

from langchain.llms.openai import OpenAI

from langchain.agents import AgentExecutor

from langchain.agents.agent_types import AgentType

from langchain.chat_models import ChatOpenAI db = SQLDatabase.from_uri("sqlite:///../../../../../notebooks/Chinook.db")

toolkit = SQLDatabaseToolkit(db=db, llm=OpenAI(temperature=0)) agent_executor = create_sql_agent( llm=OpenAI(temperature=0), toolkit=toolkit, verbose=True, agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

)

Questo agente può essere inizializzato utilizzando il file ZERO_SHOT_REACT_DESCRIPTION tipo di agente. È progettato per rispondere a domande e fornire descrizioni. In alternativa, è possibile inizializzare l'agente utilizzando il file OPENAI_FUNCTIONS tipo di agente con il modello GPT-3.5-turbo di OpenAI, che abbiamo utilizzato nel nostro client precedente.

Negazione di responsabilità

- La catena di query può generare query di inserimento/aggiornamento/eliminazione. Sii cauto e, se necessario, utilizza un prompt personalizzato o crea un utente SQL senza autorizzazioni di scrittura.

- Tieni presente che l'esecuzione di determinate query, come "esegui la query più grande possibile", potrebbe sovraccaricare il tuo database SQL, soprattutto se contiene milioni di righe.

- I database orientati al data warehouse spesso supportano quote a livello di utente per limitare l'utilizzo delle risorse.

Puoi chiedere all'agente di descrivere una tabella, come la tabella "playlisttrack". Ecco un esempio di come farlo:

agent_executor.run("Describe the playlisttrack table")

L'agente fornirà informazioni sullo schema della tabella e sulle righe di esempio.

Se chiedi erroneamente informazioni su una tabella che non esiste, l'agente può recuperare e fornire informazioni sulla tabella corrispondente più vicina. Per esempio:

agent_executor.run("Describe the playlistsong table")

L'agente troverà la tabella corrispondente più vicina e fornirà informazioni a riguardo.

Puoi anche chiedere all'agente di eseguire query sul database. Ad esempio:

agent_executor.run("List the total sales per country. Which country's customers spent the most?")

L'agente eseguirà la query e fornirà il risultato, ad esempio il paese con le vendite totali più elevate.

Per ottenere il numero totale di tracce in ciascuna playlist, puoi utilizzare la seguente query:

agent_executor.run("Show the total number of tracks in each playlist. The Playlist name should be included in the result.")

L'agente restituirà i nomi delle playlist insieme ai conteggi totali delle tracce corrispondenti.

Nei casi in cui l'agente riscontra errori, può ripristinare e fornire risposte accurate. Ad esempio:

agent_executor.run("Who are the top 3 best selling artists?")

Anche dopo aver riscontrato un errore iniziale, l'agente si adatterà e fornirà la risposta corretta, che, in questo caso, corrisponde ai 3 artisti più venduti.

Agente DataFrame di Panda

Questa sezione introduce un agente progettato per interagire con Pandas DataFrames per scopi di risposta alle domande. Tieni presente che questo agente utilizza l'agente Python dietro le quinte per eseguire il codice Python generato da un modello linguistico (LLM). Prestare attenzione quando si utilizza questo agente per evitare potenziali danni derivanti da codice Python dannoso generato da LLM.

È possibile inizializzare l'agente Pandas DataFrame come segue:

from langchain_experimental.agents.agent_toolkits import create_pandas_dataframe_agent

from langchain.chat_models import ChatOpenAI

from langchain.agents.agent_types import AgentType from langchain.llms import OpenAI

import pandas as pd df = pd.read_csv("titanic.csv") # Using ZERO_SHOT_REACT_DESCRIPTION agent type

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), df, verbose=True) # Alternatively, using OPENAI_FUNCTIONS agent type

# agent = create_pandas_dataframe_agent(

# ChatOpenAI(temperature=0, model="gpt-3.5-turbo-0613"),

# df,

# verbose=True,

# agent_type=AgentType.OPENAI_FUNCTIONS,

# )

Puoi chiedere all'agente di contare il numero di righe nel DataFrame:

agent.run("how many rows are there?")

L'agente eseguirà il codice df.shape[0] e fornire la risposta, ad esempio "Ci sono 891 righe nel dataframe".

Puoi anche chiedere all'agente di filtrare le righe in base a criteri specifici, come trovare il numero di persone con più di 3 fratelli:

agent.run("how many people have more than 3 siblings")

L'agente eseguirà il codice df[df['SibSp'] > 3].shape[0] e fornisci la risposta, ad esempio "30 persone hanno più di 3 fratelli".

Se vuoi calcolare la radice quadrata dell'età media, puoi chiedere all'agente:

agent.run("whats the square root of the average age?")

L'agente calcolerà l'età media utilizzando df['Age'].mean() e poi calcola la radice quadrata usando math.sqrt(). Fornirà la risposta, ad esempio "La radice quadrata dell'età media è 5.449689683556195".

Creiamo una copia del DataFrame e i valori di età mancanti vengono riempiti con l'età media:

df1 = df.copy()

df1["Age"] = df1["Age"].fillna(df1["Age"].mean())

Quindi, puoi inizializzare l'agente con entrambi i DataFrame e porre una domanda:

agent = create_pandas_dataframe_agent(OpenAI(temperature=0), [df, df1], verbose=True)

agent.run("how many rows in the age column are different?")

L'agente confronterà le colonne età in entrambi i DataFrame e fornirà la risposta, ad esempio "177 righe nella colonna età sono diverse".

Kit di strumenti Jira

Questa sezione spiega come utilizzare il toolkit Jira, che consente agli agenti di interagire con un'istanza Jira. È possibile eseguire varie azioni come la ricerca di problemi e la creazione di problemi utilizzando questo toolkit. Utilizza la libreria atlassian-python-api. Per utilizzare questo toolkit, devi impostare le variabili di ambiente per la tua istanza Jira, tra cui JIRA_API_TOKEN, JIRA_USERNAME e JIRA_INSTANCE_URL. Inoltre, potrebbe essere necessario impostare la chiave API OpenAI come variabile di ambiente.

Per iniziare, installa la libreria atlassian-python-api e imposta le variabili di ambiente richieste:

%pip install atlassian-python-api import os

from langchain.agents import AgentType

from langchain.agents import initialize_agent

from langchain.agents.agent_toolkits.jira.toolkit import JiraToolkit

from langchain.llms import OpenAI

from langchain.utilities.jira import JiraAPIWrapper os.environ["JIRA_API_TOKEN"] = "abc"

os.environ["JIRA_USERNAME"] = "123"

os.environ["JIRA_INSTANCE_URL"] = "https://jira.atlassian.com"

os.environ["OPENAI_API_KEY"] = "xyz" llm = OpenAI(temperature=0)

jira = JiraAPIWrapper()

toolkit = JiraToolkit.from_jira_api_wrapper(jira)

agent = initialize_agent( toolkit.get_tools(), llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True

)

Puoi istruire l'agente a creare un nuovo problema in un progetto specifico con un riepilogo e una descrizione:

agent.run("make a new issue in project PW to remind me to make more fried rice")

L'agente eseguirà le azioni necessarie per creare il problema e fornirà una risposta, ad esempio "È stato creato un nuovo problema nel progetto PW con il riepilogo 'Preparare più riso fritto' e la descrizione 'Promemoria per preparare più riso fritto'."

Ciò ti consente di interagire con la tua istanza Jira utilizzando le istruzioni in linguaggio naturale e il toolkit Jira.

Automatizza le attività manuali e i flussi di lavoro con il nostro generatore di flussi di lavoro basato sull'intelligenza artificiale, progettato da Nanonets per te e i tuoi team.

Modulo IV: Catene

LangChain è uno strumento progettato per l'utilizzo di Large Language Models (LLM) in applicazioni complesse. Fornisce strutture per la creazione di catene di componenti, inclusi LLM e altri tipi di componenti. Due quadri principali

- Il linguaggio di espressione LangChain (LCEL)

- Interfaccia della catena legacy

Il LangChain Expression Language (LCEL) è una sintassi che consente la composizione intuitiva delle catene. Supporta funzionalità avanzate come streaming, chiamate asincrone, batch, parallelizzazione, nuovi tentativi, fallback e traccia. Ad esempio, puoi comporre un prompt, un modello e un parser di output in LCEL come mostrato nel codice seguente:

from langchain.prompts import ChatPromptTemplate

from langchain.schema import StrOutputParser model = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

prompt = ChatPromptTemplate.from_messages([ ("system", "You're a very knowledgeable historian who provides accurate and eloquent answers to historical questions."), ("human", "{question}")

])

runnable = prompt | model | StrOutputParser() for chunk in runnable.stream({"question": "What are the seven wonders of the world"}): print(chunk, end="", flush=True)

In alternativa, LLMChain è un'opzione simile a LCEL per la composizione dei componenti. L'esempio LLMChain è il seguente:

from langchain.chains import LLMChain chain = LLMChain(llm=model, prompt=prompt, output_parser=StrOutputParser())

chain.run(question="What are the seven wonders of the world")

Le catene in LangChain possono anche essere stateful incorporando un oggetto Memory. Ciò consente la persistenza dei dati tra le chiamate, come mostrato in questo esempio:

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory conversation = ConversationChain(llm=chat, memory=ConversationBufferMemory())

conversation.run("Answer briefly. What are the first 3 colors of a rainbow?")

conversation.run("And the next 4?")

LangChain supporta anche l'integrazione con le API di chiamata di funzioni di OpenAI, utile per ottenere output strutturati ed eseguire funzioni all'interno di una catena. Per ottenere output strutturati, puoi specificarli utilizzando le classi Pydantic o JsonSchema, come illustrato di seguito:

from langchain.pydantic_v1 import BaseModel, Field

from langchain.chains.openai_functions import create_structured_output_runnable

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") fav_food: Optional[str] = Field(None, description="The person's favorite food") llm = ChatOpenAI(model="gpt-4", temperature=0)

prompt = ChatPromptTemplate.from_messages([ # Prompt messages here

]) runnable = create_structured_output_runnable(Person, llm, prompt)

runnable.invoke({"input": "Sally is 13"})

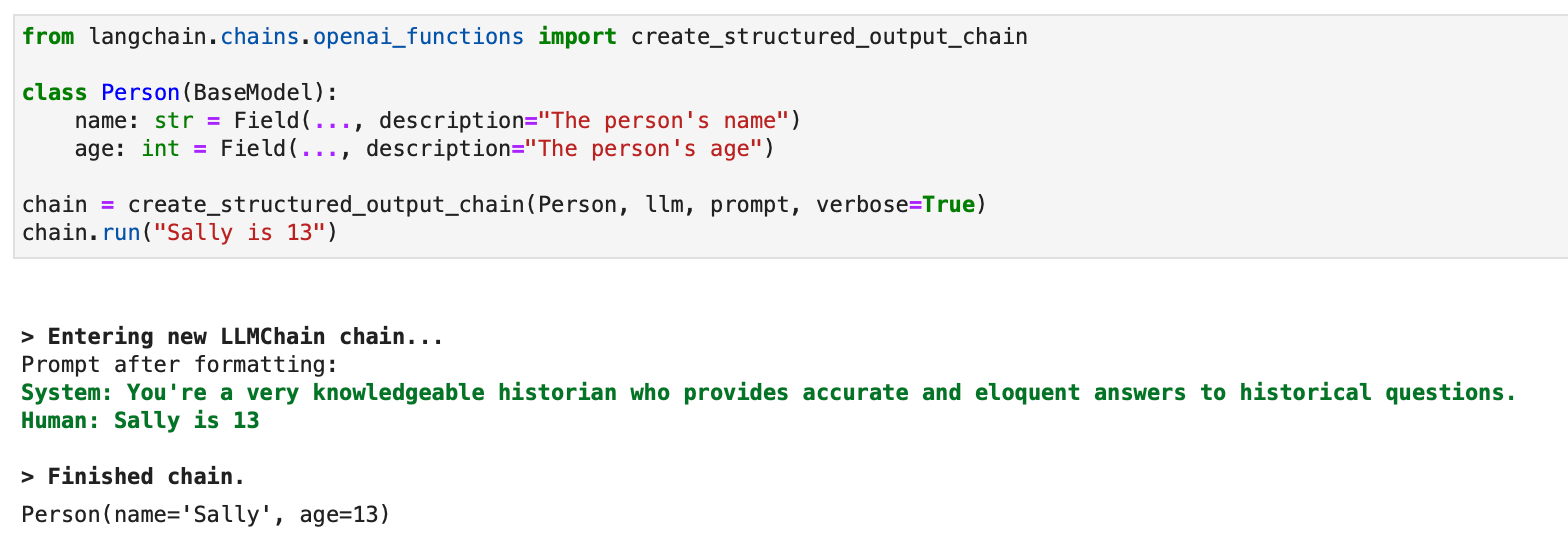

Per gli output strutturati è disponibile anche un approccio legacy che utilizza LLMChain:

from langchain.chains.openai_functions import create_structured_output_chain class Person(BaseModel): name: str = Field(..., description="The person's name") age: int = Field(..., description="The person's age") chain = create_structured_output_chain(Person, llm, prompt, verbose=True)

chain.run("Sally is 13")

LangChain sfrutta le funzioni OpenAI per creare varie catene specifiche per scopi diversi. Questi includono catene per estrazione, tagging, OpenAPI e QA con citazioni.

Nel contesto dell'estrazione, il processo è simile alla catena di output strutturata ma si concentra sull'estrazione di informazioni o entità. Per l'etichettatura, l'idea è quella di etichettare un documento con classi come sentimento, lingua, stile, argomenti trattati o tendenza politica.

Un esempio di come funziona il tagging in LangChain può essere dimostrato con un codice Python. Il processo inizia con l'installazione dei pacchetti necessari e la configurazione dell'ambiente:

pip install langchain openai

# Set env var OPENAI_API_KEY or load from a .env file:

# import dotenv

# dotenv.load_dotenv() from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.chains import create_tagging_chain, create_tagging_chain_pydantic