Immagine dell'autore

I Large Language Models (LLM) sono un nuovo tipo di intelligenza artificiale addestrata su enormi quantità di dati di testo. La loro capacità principale è generare testo simile a quello umano in risposta a un'ampia gamma di suggerimenti e richieste.

Scommetto che hai già avuto una certa esperienza con le soluzioni LLM più diffuse come ChatGPT o Google Gemini.

Ma vi siete mai chiesti come questi potenti modelli forniscano risposte così fulminee?

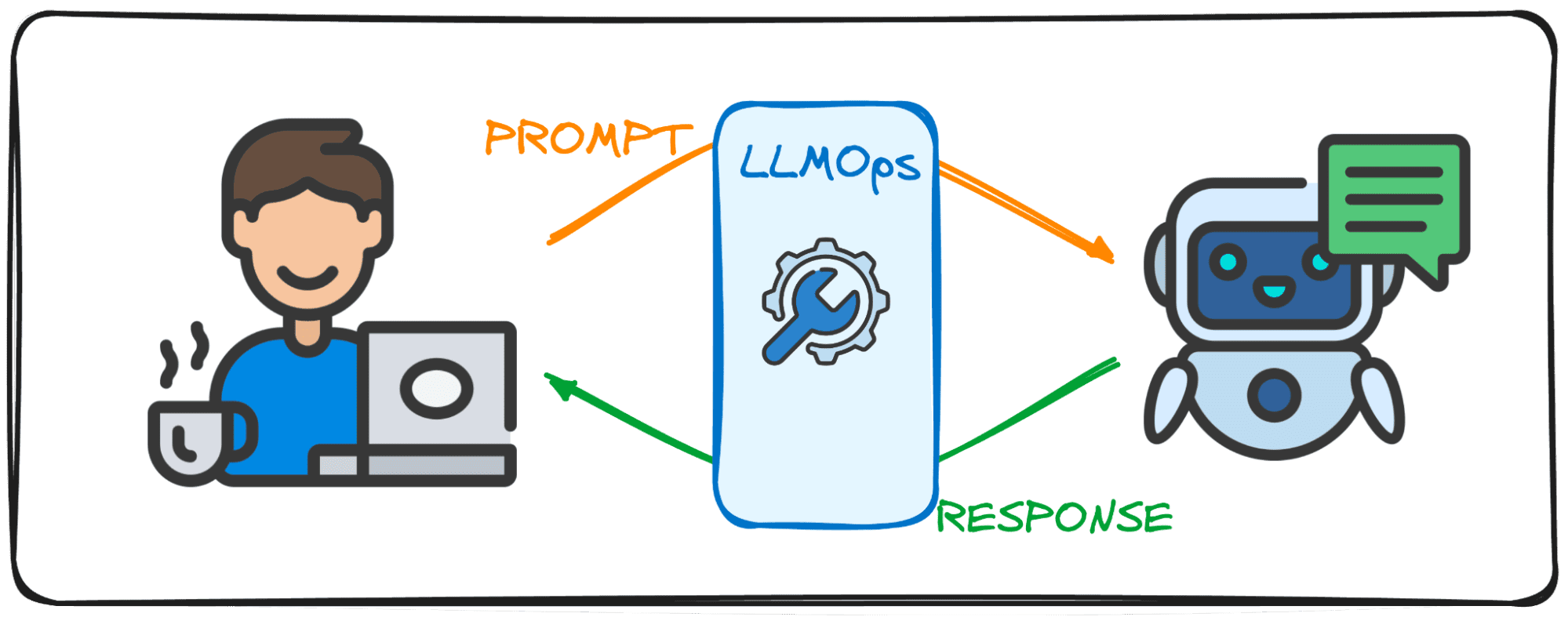

La risposta si trova in un campo specializzato chiamato LLMOps.

Prima di approfondire, proviamo a visualizzare l'importanza di questo campo.

Immagina di avere una conversazione con un amico. La cosa normale che ti aspetteresti è che quando fai una domanda, ti danno subito una risposta e il dialogo scorre senza sforzo.

Destra?

Questo scambio fluido è ciò che gli utenti si aspettano anche quando interagiscono con i Large Language Models (LLM). Immagina di chattare con ChatGPT e dover aspettare un paio di minuti ogni volta che inviamo un messaggio, nessuno lo userebbe affatto, almeno non lo farei di sicuro.

Questo è il motivo per cui gli LLM mirano a raggiungere questo flusso di conversazione ed efficacia nelle loro soluzioni digitali con il campo LLMOps. Questa guida vuole essere la tua compagna nei tuoi primi passi in questo nuovissimo dominio.

LLMOps, abbreviazione di Large Language Model Operations, è la magia dietro le quinte che garantisce il funzionamento efficiente e affidabile dei LLM. Rappresenta un progresso rispetto al familiare MLOps, progettato specificamente per affrontare le sfide uniche poste dai LLM.

Mentre MLOps si concentra sulla gestione del ciclo di vita dei modelli generali di machine learning, LLMOps si occupa specificamente dei requisiti specifici di LLM.

Quando si utilizzano modelli di entità come OpenAI o Anthropic tramite interfacce web o API, LLMOps lavora dietro le quinte, rendendo questi modelli accessibili come servizi. Tuttavia, quando si distribuisce un modello per un'applicazione specializzata, la responsabilità di LLMOps si affida a noi.

Quindi consideralo come un moderatore che si prende cura del flusso di un dibattito. Proprio come il moderatore mantiene la conversazione fluida e allineata all'argomento del dibattito, assicurandosi sempre che non ci siano parolacce e cercando di evitare notizie false, LLMOps garantisce che i LLM operino al massimo delle prestazioni, offrendo esperienze utente fluide e controllando la sicurezza del produzione.

La creazione di applicazioni con Large Language Models (LLM) introduce sfide diverse da quelle riscontrate con l'apprendimento automatico convenzionale. Per orientarsi tra questi, sono stati creati strumenti e metodologie di gestione innovativi, dando origine al quadro LLMOps.

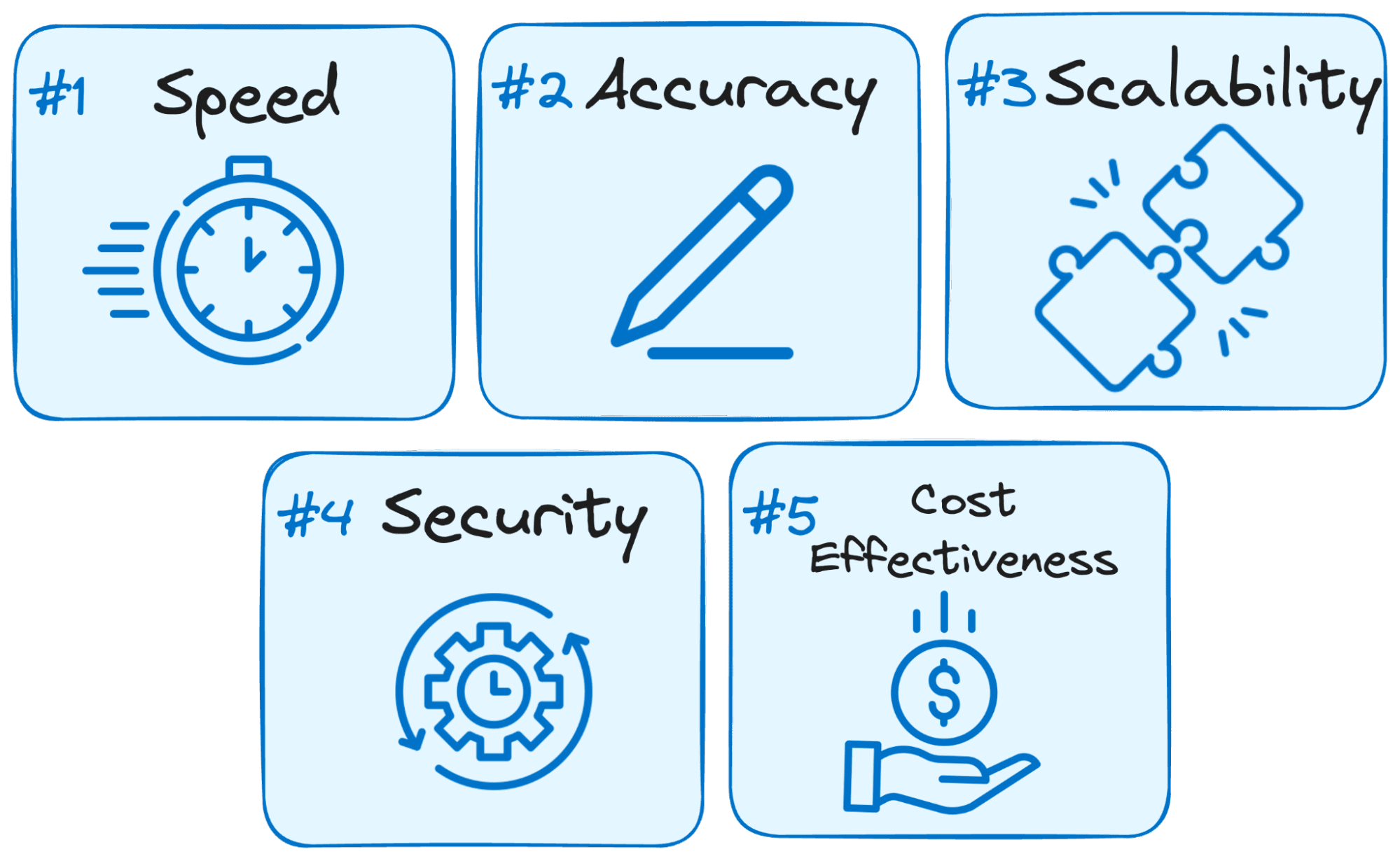

Ecco perché LLMOps è fondamentale per il successo di qualsiasi applicazione basata su LLM:

Immagine dell'autore

- La velocità è fondamentale: Gli utenti si aspettano risposte immediate quando interagiscono con i LLM. LLMops ottimizza il processo per ridurre al minimo la latenza, assicurandoti di ottenere risposte entro un periodo di tempo ragionevole.

- La precisione è importante: LLMOps implementa vari controlli e verifiche per garantire l'accuratezza e la pertinenza delle risposte del LLM.

- Scalabilità per la crescita: Man mano che la tua applicazione LLM guadagna terreno, LLMOps ti aiuta a ridimensionare le risorse in modo efficiente per gestire i crescenti carichi di utenti.

- La sicurezza è fondamentale: LLMOps salvaguarda l'integrità del sistema LLM e protegge i dati sensibili applicando solide misure di sicurezza.

- Efficacia dei costi: I LLM operativi possono essere finanziariamente impegnativi a causa dei loro significativi requisiti di risorse. LLMops mette in gioco metodi economici per massimizzare l'utilizzo efficiente delle risorse, garantendo che le massime prestazioni non vengano sacrificate.

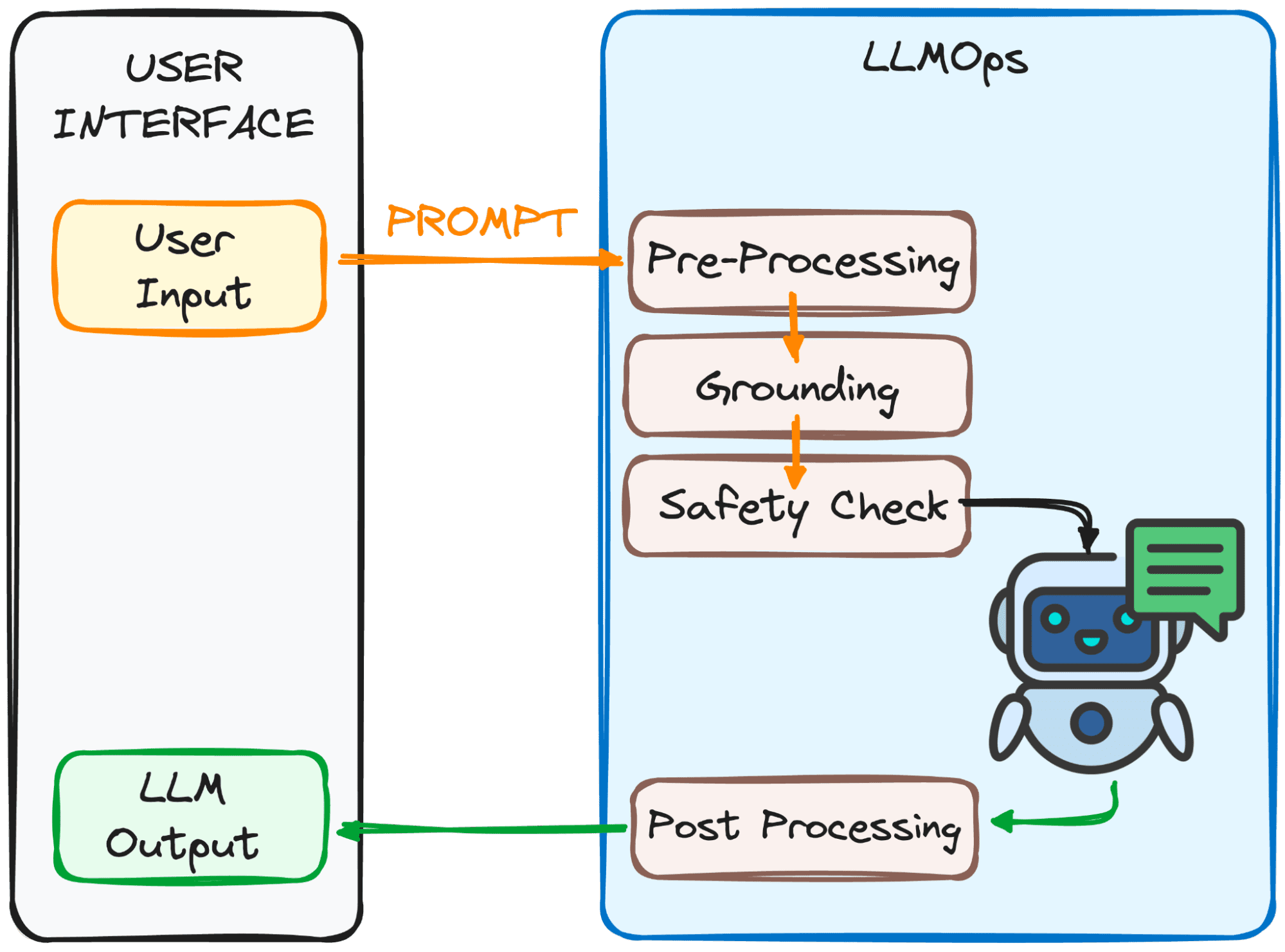

LLMOps si assicura che il tuo prompt sia pronto per LLM e che la sua risposta ti arrivi il più velocemente possibile. Tuttavia, questo non è affatto facile.

Questo processo prevede diversi passaggi, principalmente 4, che possono essere osservati nell'immagine sottostante.

Immagine dell'autore

Lo scopo di questi passaggi?

Rendere il prompt chiaro e comprensibile per il modello.

Ecco una ripartizione di questi passaggi:

1. Pre-elaborazione

Il prompt attraversa una prima fase di elaborazione. Innanzitutto, viene scomposto in pezzi più piccoli (token). Quindi, eventuali errori di battitura o caratteri strani vengono ripuliti e il testo viene formattato in modo coerente.

Infine, i token sono incorporati in dati numerici in modo che LLM possa comprenderli.

2. messa a terra

Prima che il modello elabori la nostra richiesta, dobbiamo assicurarci che comprenda il quadro più ampio. Ciò potrebbe comportare il riferimento a conversazioni passate che hai avuto con LLM o l'utilizzo di informazioni esterne.

Inoltre, il sistema identifica le cose importanti menzionate nel prompt (come nomi o luoghi) per rendere la risposta ancora più pertinente.

3. Controllo di sicurezza:

Proprio come nel caso delle regole di sicurezza sul set, LLMOps garantisce che il prompt venga utilizzato in modo appropriato. Il sistema verifica elementi come informazioni sensibili o contenuti potenzialmente offensivi.

Solo dopo aver superato questi controlli il prompt è pronto per l'atto principale: il LLM!

Ora abbiamo il nostro prompt pronto per essere elaborato da LLM. Tuttavia, anche i suoi risultati devono essere analizzati ed elaborati. Quindi, prima che tu lo veda, ci sono alcune altre modifiche eseguite nel quarto passaggio:

3. Post-elaborazione

Ricordi il codice in cui è stato convertito il prompt? La risposta deve essere ritradotta in un testo leggibile dall'uomo. Successivamente, il sistema perfeziona la risposta per grammatica, stile e chiarezza.

Tutti questi passaggi avvengono senza problemi grazie a LLMOps, il membro dell'equipaggio invisibile che garantisce un'esperienza LLM fluida.

Impressionante, giusto?

Ecco alcuni degli elementi costitutivi essenziali di una configurazione LLMOps ben progettata:

- Scegliere il LLM giusto: Con una vasta gamma di modelli LLM disponibili, LLMOps ti aiuta a selezionare quello che meglio si allinea alle tue esigenze e risorse specifiche.

- Messa a punto per la specificità: LLMOps ti consente di perfezionare i modelli esistenti o di addestrarne di nuovi, personalizzandoli per il tuo caso d'uso unico.

- Ingegneria rapida: LLMOps ti fornisce tecniche per creare suggerimenti efficaci che guidano il LLM verso il risultato desiderato.

- Distribuzione e monitoraggio: LLMOps semplifica il processo di distribuzione e monitora continuamente le prestazioni di LLM, garantendo una funzionalità ottimale.

- Garanzie di sicurezza: LLMOps dà priorità alla sicurezza dei dati implementando misure solide per proteggere le informazioni sensibili.

Poiché la tecnologia LLM continua ad evolversi, LLMOps svolgerà un ruolo fondamentale nei prossimi sviluppi tecnologici. Gran parte del successo delle ultime soluzioni popolari come ChatGPT o Google Gemini è la loro capacità non solo di rispondere a qualsiasi richiesta ma anche di fornire una buona esperienza utente.

Questo è il motivo per cui, garantendo un funzionamento efficiente, affidabile e sicuro, LLMOps aprirà la strada ad applicazioni LLM ancora più innovative e trasformative in vari settori che arriveranno a un numero ancora maggiore di persone.

Con una solida conoscenza di LLMOps, sei ben attrezzato per sfruttare la potenza di questi LLM e creare applicazioni rivoluzionarie.

Giuseppe Ferrer è un ingegnere analitico di Barcellona. È laureato in ingegneria fisica e attualmente lavora nel campo della scienza dei dati applicata alla mobilità umana. È un creatore di contenuti part-time specializzato in scienza e tecnologia dei dati. Josep scrive di tutto ciò che riguarda l'intelligenza artificiale, coprendo l'applicazione dell'esplosione in corso sul campo.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions